Что должна решать централизованная отчетность по SLA

Централизованная отчетность по SLA нужна потому, что доказательства SLA редко живут в одном месте. Uptime может быть в инструменте мониторинга, инциденты — на статусной странице, тикеты — в сервис‑деске, а заметки по эскалации — в почте или чате. Когда у каждого клиента немного другой стек (или разные наименования), месячная отчётность превращается в ручную работу в таблицах — и споры о «что же реально произошло» становятся обычным делом.

Кто пользуется и что им нужно

Хорошее веб‑приложение для отчетности по SLA обслуживает несколько аудиторий с разными задачами:

- Аккаунт‑менеджеры нуждаются в быстрых, клиент‑готовых сводках, которым можно доверять, плюс в экспортируемых отчётах для QBR.

- Руководители саппорта и owner‑ы сервисов хотят детальные данные, чтобы проверить расчёты и найти корень проблемы.

- Заинтересованные лица клиента хотят понятные метрики с однозначными определениями и способ проверить, какие инциденты и тикеты были включены.

Приложение должно показывать одну и ту же базовую правду на разных уровнях детализации в зависимости от роли.

Основные результаты, к которым стоит стремиться

Централизованная панель SLA должна давать:

- Единый источник правды для метрик SLA, инцидентов и подтверждающих доказательств.

- Более быструю отчётность (минуты, а не дни) через согласованные расчёты и переиспользуемые шаблоны.

- Меньше споров за счёт показа точного способа вычисления каждой метрики и событий, которые в неё вошли.

На практике каждое значение SLA должно быть прослеживаемо до сырых событий (алерты, тикеты, таймлайны инцидентов) с таймштампами и ответсвенными.

Установите границы: что считается «SLA» здесь

Прежде чем что‑то строить, определите, что в рамках и вне рамок. Например:

- Исключает ли «доступность» плановое обслуживание?

- Учитываются ли сбои третьих сторон или сообщаются отдельно?

- Какой официальный часовой пояс: локальное время клиента, UTC или контрактная зона?

Чёткие границы предотвратят споры позже и сохранят консистентность отчётности между клиентами.

Основные рабочие потоки, которые должно поддерживать приложение

Минимально централизованная отчетность по SLA должна поддерживать пять рабочих потоков:

- Просмотр производительности SLA клиента за выбранный период.

- Фильтрация по клиенту, сервису, региону, контракту или серьезности.

- Экспорт (PDF/CSV) для обмена и архивации.

- Планирование автоматизированных отчётов для стейкхолдеров.

- Аудит любой метрики до событий и правил, которые за ней стоят.

Проектируйте систему вокруг этих потоков с первого дня — и остальная архитектура (модель данных, интеграции и UX) останется выровненной с реальными потребностями отчётности.

Определите метрики SLA, правила и отчетные периоды

Прежде чем делать интерфейсы или пайплайны, решите, что будет измерять приложение и как эти числа интерпретируются. Цель — согласованность: двое людей, глядя на один отчёт, должны прийти к одному выводу.

Выберите метрики SLA, которые будете поддерживать

Начните с небольшого набора, который узнают большинство клиентов:

- Uptime / доступность (например, 99.9% в месяц)

- Время ответа (время до первого человеческого ответа или первого значимого обновления)

- Время решения (время до решения и подтверждения)

Будьте явными в том, что каждая метрика измеряет и чего она не измеряет. Небольшая панель определений в UI (и ссылка на /help/sla-definitions) предотвратит недоразумения позже.

Опишите правила расчётов простым языком

Именно здесь чаще всего ломается отчётность по SLA. Документируйте правила предложениями, которые клиент сможет подтвердить, а затем переводите их в логику.

Охватите базовые моменты:

- Рабочие часы vs 24/7: какой календарь применяется к каждому сервису/клиенту?

- Праздники: чей календарь праздников применяется и как он поддерживается?

- Исключения: плановое обслуживание, задержки по вине клиента, ожидание ответа от клиента, сбои третьих сторон

- События старта/остановки: какой таймштамп запускает счётчик; какое событие останавливает

Решите отчетные периоды и пороги нарушений

Выберите дефолтные периоды (месяц и квартал — обычны) и решите, будете ли вы поддерживать пользовательские диапазоны. Уточните часовой пояс для границ.

Для нарушений определите:

- Пороги по сервису (например, цель по доступности различается по уровням)

- Переопределения по клиенту (индивидуальные контракты)

- Срабатывает ли нарушение по одному инциденту, агрегату или по обоим

Документируйте источники данных для каждой метрики

Для каждой метрики перечислите входные данные (события мониторинга, записи инцидентов, таймштампы тикетов, окна обслуживания). Это станет чертежом для интеграций и проверок качества данных.

Просканируйте источники данных и варианты интеграций

Прежде чем проектировать дашборды или KPI, выясните, где вообще живут доказательства SLA. Большинство команд обнаруживают, что «данные SLA» разбросаны по инструментам, принадлежат разным владельцам и имеют слегка разные значения.

Распространённые системы‑источники для инвентаризации

Начните с простого списка по каждому клиенту (и по каждому сервису):

- Мониторинг/observability (ping‑чекы, синтетические мониторы, APM): сигналы доступности и таймштампы

- Управление инцидентами (аналог PagerDuty/Opsgenie): жизненный цикл инцидента, серьёзность, подтверждения

- Тикеты/служба поддержки (Jira Service Management, Zendesk, ServiceNow): времена ответа/решения, поля влияния на клиента

- Страницы статуса (публичные или внутренние): объявленные инциденты и запланированные окна обслуживания

- Логи провайдера / облака (опционально): здоровье балансировщиков, аудит‑трейлы по сбоям

Для каждой системы указывайте владельца, период хранения, лимиты API, разрешение времени (секунды vs минуты) и является ли данные специфичными для клиента или общими.

Выберите методы интеграции (и комбинируйте их)

Большинство приложений для SLA‑отчётности используют комбинацию:

- API‑pulls для исторического бэкфилла и ночных сверок

- Webhooks/стримы событий для почти реального времени и быстрой детекции нарушений

- CSV‑импорты для мелких клиентов, устаревших инструментов или одноразовых миграций

Практическое правило: используйте webhooks там, где важна свежесть, и API‑pulls там, где важна полнота.

Раннее определите канонический формат событий

Разные инструменты описывают одно и то же по‑разному. Нормализуйте в небольшой набор событий, на которые можно опираться, например:

incident_opened / incident_closeddowntime_started / downtime_endedticket_created / first_response / resolved

Включайте согласованные поля: client_id (или tenant_id), service_id, source_system, external_id, severity и таймштампы.

Часовые пояса и неполное покрытие

Храните все таймштампы в UTC, и при отображении конвертируйте по предпочитаемой часовой зоне клиента (особенно для месячных границ).

Планируйте и на пробелы: у некоторых клиентов не будет статусной страницы, у некоторых сервисов не будет круглосуточного мониторинга, и некоторые инструменты могут терять события. Делайте «частичное покрытие» видимым в отчётах (например, «данные мониторинга недоступны в течение 3 часов»), чтобы результаты SLA не вводили в заблуждение.

Проектирование мультиленантной архитектуры

Если ваше приложение делает отчёты по SLA для нескольких заказчиков, архитектурные решения определяют, сможете ли вы масштабироваться безопасно без утечек данных между клиентами.

Что означает «клиент» в вашей системе

Определите слои, которые нужно поддерживать. «Клиент» может быть:

- Арендатор (tenant/аккаунт): основной граница клиента

- Суб‑аккаунты: департаменты или бренды под одним арендатором

- Окружения: prod/stage/регионы

- Сервисы: API, web‑приложение, база данных, очередь поддержки

Занесите это в документацию рано — это повлияет на права доступа, фильтры и хранение конфигурации.

Выберите модель многоарендности

Большинство приложений SLA выбирают одно из:

- Общая база + tenant_id: одна схема таблиц, каждая строка помечена

tenant_id. Это экономично и проще в эксплуатации, но требует дисциплины запросов.

- Отдельные БД на арендатора: сильная изоляция и удобные per‑tenant правила хранения, но большие операционные затраты (миграции, мониторинг, бэкапы) и сложнее агрегировать админ‑виды.

Частый компромисс — общая БД для большинства арендаторов и выделенные БД для enterprise‑клиентов.

Обеспечьте строгую изоляцию данных повсеместно

Изоляция должна соблюдаться в:

- Запросах и дашбордах: всегда скоупьте по арендатору, а не только по UI‑фильтрам

- Экспортах и запланированных письмах: задачи экспорта должны выполняться в контексте арендатора

- Фоновых джобах: ретраев и очередей должны нести

tenant_id, чтобы результаты не попали в чужой тенант

Используйте ограничители: row‑level security, обязательный scoping запросов и автоматические тесты на границы арендаторства.

Поддержка клиент‑специфичных SLA‑настроек

У разных клиентов будут разные цели и определения. Планируйте per‑tenant настройки, например:

- Цели SLA (например, 99.9% uptime, 1‑часовой ответ)

- Включённые сервисы и эндпоинты

- Рабочие часы, праздники и часовые пояса

- Маппинги серьезностей и правила исключений (окна обслуживания)

Безопасное переключение клиента для внутренних пользователей

Внутренним пользователям часто нужно «имперсонализировать» вид клиента. Реализуйте осознанное переключение (не просто свободный фильтр), показывайте активного арендатора явно, логируйте переключения для аудита и предотвращайте ссылки, обходящие проверки арендатора.

Постройте модель данных для сырых событий и результатов SLA

Веб‑приложение для централизованной отчетности по SLA живёт или умирает от своей модели данных. Если моделировать только «% SLA за месяц», будет трудно объяснить результаты, разбирать споры или обновлять расчёты. Если моделировать только сырые события — отчёты будут медленными и дорогими. Цель — поддерживать оба сценария: прослеживаемые доказательства и быстрые агрегаты.

Основные сущности

Разделяйте кого вы считаете, что измеряете и как это вычисляете:

- Клиент: организация, получающая отчёты.

- Сервис: система или компонент (API, сайт, очередь поддержки).

- Определение SLA: правила типа целевой доступности, время ответа, рабочие часы, исключения и метод измерения.

- Инцидент / тикет: ручные записи из ITSM, поясняющие простои или задержки.

- Измерение / событие: машинные события (проверки мониторинга, изменения статуса, сигналы из логов).

Храните сырые события и производные результаты

Спроектируйте коллекции/таблицы для:

- Сырьевых событий: неизменяемые записи из источников (алерты мониторинга, инциденты со статус‑страниц, транзиции тикетов). Храните оригинальные ID и снимки payload, если возможно.

- Нормализованных фактов: ваша стандартизированная репрезентация (например, «service_down started_at/ended_at").

- Результатов SLA: вычисленные значения на разных гранах — по инциденту, дню, неделе, месяцу.

- Роллапов: предагрегированные дневные/месячные итоги, чтобы дашборд был быстрым (например, минуты простоя, валидные минуты, исключённые минуты).

Версионируйте расчёты

Логика SLA меняется: рабочие часы обновляются, исключения уточняются, правила округления меняются. Добавляйте calculation_version (и ссылку на набор правил) к каждому вычисленному результату. Тогда старые отчёты можно будет воспроизвести точно после улучшений.

Добавьте поля аудита для доверия и отладки

Включайте поля аудита там, где это важно:

- source_system, source_record_id, import_job_id

- Таймштампы: ingested_at, normalized_at, calculated_at

- created_by/updated_by для ручных правок (с логом изменений для переопределений)

Доказательства и вложения

Клиенты часто просят «покажите, почему». Планируйте схему для доказательств:

- Ссылки на постмортемы, страницы статуса или треды тикетов

- Метаданные вложений (имя, тип, ключ хранения)

- Связывание доказательств с инцидентами и конкретными отчетными периодами

Такая структура делает приложение объяснимым, воспроизводимым и быстрым — без потери исходного подтверждения.

Постройте надёжный пайплайн данных и слой нормализации

Если входы грязные, ваш дашборд SLA будет тоже. Надёжный пайплайн превращает инциденты и тикеты из разных источников в согласованные, проверяемые результаты SLA — без двойного счёта, пробелов или тихих ошибок.

Разделите пайплайн на ясные этапы

Обрабатывайте ingestion, normalization и rollups как отдельные стадии. Выполняйте их через фоновые джобы, чтобы UI оставался быстрым и вы могли безопасно делать ретраи.

- Ingestion‑джобы тянут сырые события и сохраняют их без изменений.

- Normalization‑джобы стандартизируют поля и сопоставляют их с вашим SLA‑словарём.

- Rollup‑джобы вычисляют дневные/недельные/месячные метрики SLA и кэшируют результаты для дашбордов и экспортов.

Это разделение также полезно, когда источник одного клиента падает: инжест может провалиться, не разрушив существующие расчёты.

Сделайте ретраи безопасными с идемпотентностью

API тайм‑ауты и повторные доставки webhooks — обычны. Пайплайн должен быть идемпотентным: повторная обработка того же входа не должна менять результат.

Распространённые подходы:

- Используйте ID события источника (или хеш ключевых полей) как уникальный ключ.

- Ведите ledger обработки (event_id + client + source + timestamp) для детекции дубликатов.

- Делайте роллапы перестраиваемыми за временное окно (например, «пересчитать последние 14 дней») вместо слепого инкрементирования счётчиков.

Нормализуйте имена, чтобы метрики значили одно и то же

У разных клиентов «P1», «Critical» и «Urgent» могут означать одно и то же — или нет. Постройте слой нормализации, который стандартизирует:

- Имена сервисов (например, «Payments API» vs «Payments»)

- Приоритеты / серьёзности

- Статусы тикетов (например, «Resolved» vs «Done» vs «Closed»)

Храните и оригинальное значение, и нормализованное для прослеживаемости.

Валидируйте входы и помещайте подозрительные записи в карантин

Добавьте проверки (отсутствие таймштампов, отрицательные длительности, невозможные переходы статусов). Не удаляйте плохие данные молча — отправляйте их в очередь карантина с причиной и workflow «исправить или сопоставить».

Показатель свежести данных

Для каждого клиента и источника вычисляйте «последняя успешная синхронизация», «самое старое необработанное событие» и «роллапы актуальны по» и отображайте их как индикатор свежести данных, чтобы клиенты доверяли цифрам, а команда замечала проблемы рано.

Аутентификация, роли и контроль доступа

Если клиенты используют портал для просмотра SLA, аутентификация и права должны проектироваться так же тщательно, как и SLA‑математика. Цель — просто: каждый пользователь видит только то, что должен — и вы можете это доказать позже.

Роли, соответствующие реальным задачам

Начните с малого, понятного набора ролей и расширяйте только при веских основаниях:

- Admin: управляет арендаторами/клиентами, интеграциями, пользователями и глобальными настройками.

- Внутренний аналитик: видит все данные клиентов, исследует инциденты, строит отчёты, но не меняет настройки безопасности.

- Клиент‑просмотрщик: только чтение для своего клиента — дашборды и экспорты.

- Клиент‑редактор: может управлять пользователями своей организации, настройками уведомлений и (опционально) шаблонами отчётов.

Соблюдайте принцип наименьших привилегий: новые аккаунты по умолчанию — в роли viewer, если не повышены явно.

SSO в приоритете, пароли — как резерв

Для внутренних команд SSO снижает спред аккаунтов и риски отзыва доступа. Поддерживайте OIDC (Google Workspace/Azure AD/Okta) и, где нужно, SAML.

Для клиентов предлагайте SSO как опцию, но оставляйте email/password с MFA для небольших организаций.

Изоляция по клиенту и тонкие разрешения

Применяйте ограничения на всех уровнях:

- Каждый запрос и экспорт скоупьте по client ID.

- Добавьте права на уровне проекта/сервиса, если у клиента несколько бизнес‑единиц.

- Ограничьте доступ к чувствительным артефактам (сырые тикеты, заметки, вложения) отдельно от сводных результатов SLA.

Логи аудита и безопасный onboarding

Логируйте доступ к чувствительным страницам и загрузкам: кто что открыл, когда и откуда. Это помогает с соответствием и доверием клиентов.

Сделайте onboarding так, чтобы админы или client‑editors могли приглашать пользователей, назначать роли, требовать подтверждение email и мгновенно отзывать доступ.

UX дашборда: фильтры, drill‑down и однозначные определения

Централизованная панель SLA успешна, когда клиент может ответить на три вопроса за минуту: Соблюдаем ли мы SLA? Что изменилось? Что вызвало промахи? UX должен вести от общего взгляда к доказательствам, не заставляя учить вашу внутреннюю модель данных.

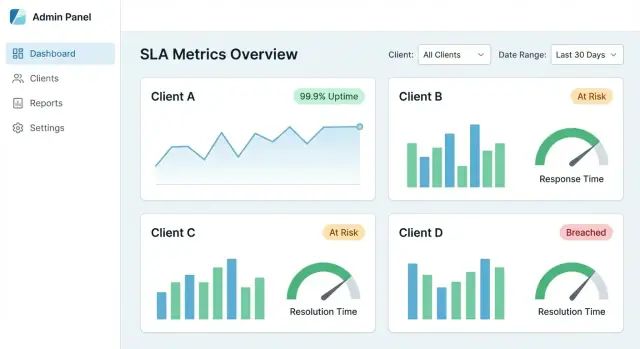

«Главный вид», который вызывает доверие

Начните с небольшого набора карточек и графиков, соответствующих типичным обсуждениям SLA:

- Соблюдение SLA (%) за выбранный период (текущий vs предыдущий)

- Тренд‑линия (по дням/неделям) для показа улучшений или деградации

- Топ‑нарушений ранжированные по влиянию (минуты сверх SLO, штрафы или затронутые пользователи)

Сделайте каждую карточку кликабельной — это дверь в детали, а не мёртвая метка.

Фильтры, которые ощущаются предсказуемо

Фильтры должны быть консистентны на всех страницах и «запоминаться» при навигации.

Рекомендуемые дефолты:

- Клиент → Сервис → Окружение (prod/stage)

- Диапазон дат с быстрыми подборками (Последние 7/30/90 дней, Текущий месяц)

- Серьёзность / приоритет (важно при смешении инцидентов и тикетов)

Показывайте активные фильтры как «чипы» сверху, чтобы пользователи всегда знали, что смотрят.

Путь от сводки к доказательствам

Каждая метрика должна иметь путь к «почему». Хороший drill‑down:

- График соблюдения → клик по провалу

- Список инцидентов/тикетов, внесших вклад за этот срез

- Страница деталей с таймштампами, изменениями статусов, ссылками на исходные записи и заметками

Если цифра не может быть объяснена доказательствами, ей не поверят — особенно на QBR.

Ясные определения (никакой двусмысленности)

Добавляйте тултипы или панель «инфо» для каждого KPI: как считается, какие исключения, часовой пояс и свежесть данных. Включайте примеры типа «Окна обслуживания исключены» или «Доступность измеряется на уровне API‑гейта».

Поделенные виды с устойчивыми ссылками

Делайте отфильтрованные представления делимыми через стабильные URL (например, /reports/sla?client=acme&service=api&range=30d). Это превращает панель в клиент‑готовый портал отчётности, поддерживающий регулярные проверки и следы аудита.

Автоматические отчёты, экспорты и клиент‑готовые сводки

Дашборд полезен ежедневно, но клиенты часто хотят форвардимый артефакт: PDF для руководства, CSV для аналитиков и ссылку‑в закладки.

Поддерживайте нужные форматы отчётов

Поддерживайте три формата из одних и тех же результатов SLA:

- PDF: чистая брендированная сводка для стейкхолдеров

- CSV: построчные данные (по сервису, региону или контракту) для глубокого анализа

- Живая ссылка: защищённый URL на то же представление в портале, всегда актуальный

Для ссылочных отчётов делайте фильтры явными (диапазон дат, сервис, серьёзность), чтобы клиент точно понимал, что означают числа.

Плановая доставка по клиенту и по расписанию

Добавьте расписание, чтобы каждый клиент мог получать отчёты автоматически — еженедельно, ежемесячно, ежеквартально — на клиент‑специфичный список или общий почтовый ящик. Храните расписания в контексте арендатора и делайте их аудируемыми (кто создал, когда последний раз отправлено, следующий запуск).

Если нужен простой старт, запустите с «месячной сводкой» плюс однокликовый экспорт с /reports.

Шаблоны, готовые для QBR/MBR

Постройте шаблоны, которые читаются как слайды QBR/MBR в письменном виде:

- Highlights (доступность, топ‑улучшения)

- Нарушения (что случилось, длительность, влияние)

- Заметки (плановое обслуживание, дальнейшие действия)

Замечания по соответствию, исключения и утверждения

Реальные SLA включают исключения (окна обслуживания, сбои третьих сторон). Позвольте пользователям добавлять заметки по соответствию и помечать исключения, требующие утверждения, с маршрутом утверждения.

Изоляция экспортов и права

Экспорты должны уважать изоляцию арендатора и роли. Пользователь должен экспортировать только те клиенты, сервисы и периоды, которые ему разрешены — и экспорт должен точно соответствовать виду портала (без утечек скрытых колонок).

Оповещения и уведомления о нарушениях SLA

Оповещения — это то место, где приложение превращается из «интересного дашборда» в оперативный инструмент. Цель не в том, чтобы отправлять больше сообщений, а в том, чтобы помочь нужным людям реагировать рано, документировать, что произошло, и держать клиентов в курсе.

Выбирайте типы оповещений, соответствующие способу сбоев SLA

Начните с трёх категорий:

- Предстоящее нарушение: тренд указывает на то, что вы можете не уложиться в цель (например, burn‑rate показывает, что uptime упадёт ниже 99.9% к концу периода)

- Подтверждённое нарушение: SLA однозначно не соблюдён за определённый период

- Ошибка пайплайна данных: пропущенные данные, задержки импорта или ошибки интеграций, которые могут дискредитировать отчёт

Привязывайте каждое оповещение к чётким определениям (метрика, временное окно, порог, область клиента), чтобы получатели могли ему доверять.

Выбирайте каналы и делайте их осознанными для клиента

Предлагайте несколько каналов доставки, чтобы команды могли работать там, где уже работают их клиенты:

- Email для руководства и клиент‑фейсных команд

- Slack / MS Teams для on‑call и операций

- Webhook для триггера внутренних систем (PagerDuty, ServiceNow, кастомные инструменты)

Для мультиклиентских сценариев маршрутизируйте уведомления по правилам арендатора (например, «нарушения Client A → Channel A; внутренние нарушения → on‑call»). Избегайте отправки клиент‑специфичных деталей в общие каналы.

Снижайте шум: дедупликация, тихие часы и эскалация

Alert‑fatigue убьёт принятие. Внедрите:

- Дедупликацию (складывать повторные триггеры в одно активное оповещение)

- Тихие часы (откладывать не‑критичные нотификации за пределами рабочих часов)

- Эскалацию (если не подтверждено в X минут, уведомлять более широкую группу)

Делайте оповещения действенными с подтверждением и заметками

Каждое оповещение должно поддерживать:

- Acknowledgment (кто взял на себя ответственность)

- Resolution notes (что случилось, ссылка на инцидент/тикет, резюме коммуникаций с клиентом)

Это создаёт лёгкий аудиторский след, который можно переиспользовать в клиент‑готовых сводках.

Простой редактор правил на клиента

Дайте базовый редактор правил для порогов и маршрутизации по клиенту (без открытия сложной логики запросов). Ограждения полезны: дефолты, валидация и предпросмотр («это правило сработало бы 3 раза в прошлом месяце»).

Производительность, безопасность и основы комплаенса

Централизованное приложение SLA быстро становится критичным, потому что клиенты используют его для оценки качества сервиса. Это делает скорость, безопасность и доказательность (для аудита) такими же важными, как и графики.

Производительность, масштабируемая по клиентам

Крупные клиенты могут генерировать миллионы тикетов, инцидентов и событий мониторинга. Чтобы страницы оставались отзывчивыми:

- Пагинация повсеместно (таблицы, списки событий, drill‑down). Не загружайте все результаты по умолчанию.

- Кеширование часто запрашиваемых запросов (например, «последние 30 дней uptime по сервису»). Тайм‑банд кеша 5–15 минут обычно сохраняет свежесть и снижает нагрузку.

- Предагрегация результатов SLA для тяжёлых представлений (месячные сводки, uptime по сервису, счётчик нарушений). Считайте их по расписанию или после инжеста, чтобы дашборды не пересчитывали всё из сырья на каждой странице.

Хранение данных и архивирование

Сырые события важны для расследований, но хранить всё вечно дорого и рискованно.

Установите правила, например:

- Хранить нормализованные сырые события короче (например, 90–180 дней).

- Хранить результаты и сводки SLA дольше (например, 2–7 лет) для трендов и контрактов.

- Архивировать старые сырые события в дешёвое хранилище (object storage, cold tiers) с документированным процессом восстановления.

Базовая безопасность, ожидаемая клиентами

Предполагается чувствительное содержимое: имена клиентов, таймштампы, заметки к тикетам и иногда PII.

- Шифрование в транзите (HTTPS/TLS) и в покое (БД и бэкапы). Токены API и креды интеграций храните в хранилище секретов.

- Добавьте rate limiting и валидацию вводимых данных на публичных точках (логин, экспорты, API). Это снижает риск злоупотреблений и типичных уязвимостей.

Комплаенс и готовность к аудиту

Даже если вы не целитесь в конкретный стандарт, хорошая операционная доказательная база вызывает доверие.

Поддерживайте:

- Неизменяемые логи аудита (логины, экспорты, изменения прав, интеграции)

- Бэкапы с тестированием восстановления (не просто «делаем бэкап»). Проводите периодические drills и фиксируйте результаты.

- Базовые политики доступа к данным: кто может видеть что, как долго данные хранятся и как обрабатываются запросы на удаление.

План запуска, мониторинг и дорожная карта итераций

Запуск приложения для SLA — это не громкая релиз‑свертка, а подтверждение точности и повторяемость масштабирования. Сильный план запуска снижает споры, делая результаты простыми для проверки и воспроизведения.

1) Начните с пилотного клиента (и валидируйте точность)

Выберите одного клиента с управляемым набором сервисов и источников данных. Запускайте расчёты параллельно их существующей ручной отчётности (таблицы, экспорты тикетов или отчёты вендоров).

Сосредоточьтесь на типичных местах расхождений:

- Часовые пояса и границы периодов (концы месяцев)

- Что считается простоем vs деградацией

- Как обрабатываются окна обслуживания

Документируйте различия и решите, будет ли приложение соответствовать текущему клиентскому подходу или заменит его на более ясный стандарт.

2) Операционализируйте онбординг чек‑листом

Создайте повторяемый чек‑лист, чтобы опыт подключения каждого нового клиента был предсказуем:

- Доступ к источникам данных (API‑ключи, scope, IP‑whitelists)

- Правила маппинга (имена сервисов, категории тикетов, серьёзности)

- Подтверждение определения SLA (цели, исключения, правила округления)

- Тестовый прогон + sign‑off (образцовый период, известные инциденты)

- Назначение владельца (кто утверждает изменения)

Чек‑лист поможет оценивать усилия и обосновывать /pricing.

3) Добавьте мониторинг для доверия и поддержки

Дашборды SLA доверительны только если они свежие и полные. Следите за:

- Сбоями запланированных джобов и ретраями

- Ошибками лимитов API и авторизации

- Застарелыми данными (нет инжеста X часов)

- Неожиданными падениями/скачками объёма инцидентов

Сначала отправляйте внутренние алерты; когда система устойчива, можно добавить заметки для клиентов.

4) Итерации на базе понятности, а не только фич

Собирайте обратную связь о местах путаницы: определения, споры («почему это нарушение?») и «что изменилось» с прошлого месяца. Приоритизируйте небольшие UX‑улучшения: тултипы, логи изменений и ясные сноски об исключениях.

5) Швидче разрабатывать с современным workflow

Если нужно быстро выпустить внутренний MVP (модель тенантов, интеграции, дашборды, экспорты) без недель на рутину, подход vibe‑кодинга может помочь. Например, Koder.ai позволяет командам набросать и итеративно проработать многоарендное веб‑приложение через чат — затем экспортировать исходники и задеплоить. Это практично для продуктов SLA, где основная сложность — доменные правила и нормализация данных, а не UI‑боилерплейт.

Вы можете использовать режим планирования Koder.ai для описания сущностей (тенанты, сервисы, определения SLA, события, роллапы), а затем сгенерировать React UI и бэкенд на Go/PostgreSQL, которые можно расширить конкретными интеграциями и логикой расчётов.

6) Опубликуйте короткую дорожную карту

Ведите живой документ с дальнейшими шагами: новые интеграции, форматы экспорта и следы аудита. Ссылайтесь на сопутствующие руководства в /blog, чтобы клиенты и коллеги могли самостоятельно получить детали.