Почему Паттерсон и RISC всё ещё важны

Дэвид Паттерсон обычно представляют как «пионера RISC», но его долговременное влияние шире любой отдельной реализации процессора. Он помог популяризировать практичный способ мышления о компьютерах: воспринимать производительность как то, что можно измерить, упростить и улучшить в энд‑ту‑энд смысле — от набора инструкций в чипе до инструментов программной разработки, которые эти инструкции генерируют.

«RISC‑мышление» простыми словами

RISC (Reduced Instruction Set Computing) — это идея о том, что процессор может работать быстрее и предсказуемей, если сосредоточиться на небольшом наборе простых инструкций. Вместо того чтобы встраивать в аппарат множество сложных операций, делают частые операции быстрыми, регулярными и удобными для конвейеризации. Выигрыш не в «меньшей способности», а в том, что простые строительные блоки, исполненные эффективно, часто выигрывают в реальных нагрузках.

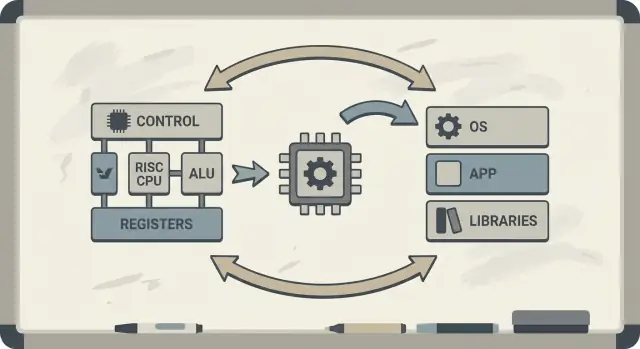

Co‑design: чипы и код, улучшающие друг друга

Паттерсон также пропагандировал совместное проектирование аппаратуры и ПО: цикличный процесс, где архитекторы чипов, разработчики компиляторов и системные инженеры итеративно работают вместе.

Если процессор хорошо выполняет простые шаблоны, компиляторы стабильно их порождают. Если компиляторы показывают, что реальные программы тратят время на определённые операции (например, доступ к памяти), аппаратную часть можно настроить так, чтобы лучше обрабатывать эти случаи. Поэтому обсуждение архитектуры набора команд (ISA) естественно связывается с оптимизациями компилятора, кэшированием и конвейеризацией.

Что вы получите из этой статьи

Вы поймёте, почему идеи RISC связаны с производительностью на ватт (а не только с сырым быстродействием), как «предсказуемость» делает современные CPU и мобильные чипы эффективнее, и как эти принципы проявляются в устройствах сегодня — от ноутбуков до облачных серверов.

Если хотите карту ключевых концепций перед тем, как углубляться, переходите к /blog/key-takeaways-and-next-steps.

Проблема, на которую отвечал RISC

Ранние микропроцессоры создавали в условиях жёстких ограничений: на чипе было мало места для логики, память была дорога, а хранилища медленны. Дизайнеры пытались выпустить доступные и «достаточно быстрые» компьютеры, часто с небольшими кешами (или без них), умеренными тактовыми частотами и очень ограниченной основной памятью по сравнению с потребностями ПО.

Старая ставка: сложные инструкции = быстрая программа

Популярная идея была в том, что если CPU предложит более мощные, высокоуровневые инструкции — способные выполнять несколько шагов за раз — то программы будут выполняться быстрее и их проще писать. Если одна инструкция может «сделать работу нескольких», думали тогда, то потребуется меньше инструкций, экономя время и память.

Это интуиция многих CISC‑дизайнов: давать программистам и компиляторам большой набор «крутых» операций.

Несоответствие: что CPU предлагали и что реально использовалось

Проблема в том, что реальные программы (и компиляторы) редко по-настоящему использовали эту сложность. Многие из самых замысловатых инструкций использовались редко, тогда как небольшой набор простых операций — загрузка, сохранение, сложение, сравнение, переход — встречался снова и снова.

Поддержка огромного меню сложных инструкций делала CPU труднее в реализации и медленнее в оптимизации. Сложность съедала площадь кристалла и усилия на проектирование, которые могли быть потрачены на ускорение распространённых, повседневных путей исполнения.

RISC ответил на этот разрыв: сосредоточьте CPU на том, что ПО делает чаще всего, сделайте эти пути быстрыми — а оркестровку пусть выполняют компиляторы системно.

RISC против CISC: идея простыми словами

Простой способ думать о CISC vs RISC — сравнить наборы инструментов.

CISC (Complex Instruction Set Computing) — как мастерская, полная множества специализированных, «фешенебельных» инструментов: каждый может многое сделать за один ход. Одна «инструкция» может загрузить данные, сделать вычисление и сохранить результат — всё в одном.

RISC (Reduced Instruction Set Computing) — как взять с собой небольшой набор надёжных инструментов, которыми пользуешься постоянно — молоток, отвёртка, рулетка — и строить всё из повторяемых шагов. Каждая инструкция делает одну небольшую, чёткую задачу.

Почему «проще» может быть быстрее

Когда инструкции проще и более однородны, CPU может выполнять их с более чистой «сборочной линией» (конвейером). Эту линию проще проектировать, её легче запускать на более высокой частоте и легче поддерживать загруженной.

С CISC‑стилем «сделай‑много» CPU часто приходится декодировать и разбивать сложную инструкцию на внутренние шаги. Это добавляет сложности и мешает держать конвейер заполненным.

Предсказуемость имеет значение

RISC стремится к предсказуемому времени выполнения инструкций — многие инструкции занимают примерно одинаковое количество тактов. Предсказуемость помогает CPU эффективно планировать работу и помогает компиляторам генерировать код, который не будет простаивать.

Компромиссы (и почему они часто оправданы)

RISC обычно требует больше инструкций для выполнения той же задачи. Это может означать:

- немного больший размер программы (больше байт кода);

- больше обращений за инструкциями в память.

Но это может всё равно быть выгодно, если каждая инструкция быстрая, конвейер остаётся гладким, а общая архитектура проще. На практике хорошо оптимизированные компиляторы и эффективные кэши компенсируют недостаток «большего числа инструкций» — и CPU тратит больше времени на полезную работу, а не на распутывание сложных инструкций.

Berkeley RISC и подход «измеряй, затем проектируй»

Berkeley RISC был не только новой ISA. Это было исследовательское отношение: не начинай с того, что красиво на бумаге — начни с того, что реально делают программы, и потом строй CPU вокруг этой реальности.

Маленькое быстрое ядро + умный компилятор

Команда из Беркли стремилась к ядру процессора, достаточно простому, чтобы работать очень быстро и предсказуемо. Вместо того чтобы наполнять аппарат множеством хитрых «трюков», они полагались на компилятор: выбирать простые инструкции, грамотно их планировать и держать данные в регистрах как можно дольше.

Это разделение ролей имело значение. Простое чистое ядро легче конвейеризуется, проще для анализа и зачастую быстрее на транзистор. Компилятор, видя всю программу целиком, может планировать на опережение там, где аппарат трудно сделать это в реальном времени.

Измеряйте реальные рабочие нагрузки, а не предположения

Паттерсон подчёркивал измерения потому, что проектирование компьютеров полно соблазнительных мифов — функций, которые звучат полезно, но редко встречаются в реальном коде. Berkeley RISC настаивал на использовании бенчмарков и трасс рабочей нагрузки, чтобы найти «горячие» пути: петли, вызовы функций и обращения в память, которые доминируют по времени выполнения.

Это напрямую связано с принципом «делай быстрым обычный случай». Если большинство инструкций — простые операции и загрузки/сохранения, оптимизация этих частых случаев приносит больше выгоды, чем ускорение редких сложных инструкций.

RISC как способ мышления

Вывод в том, что RISC был и архитектурой, и мышлением: упростить частое, подтвердить данными и рассматривать аппарат и программное обеспечение как единое целое, которое можно совместно настраивать.

Что значит hardware–software co‑design

Это идея о том, что CPU не проектируется в изоляции. Проектируют чип и компилятор (а иногда и операционную систему) вместе, чтобы реальные программы работали быстро и эффективно — а не только синтетические «лучшие случаи» последовательностей инструкций.

Простой цикл обратной связи

Co‑design работает как инженерный цикл:

-

Выбор ISA: архитектура набора команд (ISA) определяет, что CPU может выражать легко (например, модель «load/store», много регистров, простые режимы адресации).

-

Стратегии компилятора: компилятор адаптируется — держит горячие переменные в регистрах, переставляет инструкции, чтобы избежать простоев, и выбирает соглашения о вызовах, снижающие накладные расходы.

-

Результаты по нагрузке: измеряете реальные программы (компиляторы, базы данных, графику, код ОС) и видите, куда уходит время и энергия.

-

Следующий дизайн: вы корректируете ISA и микроархитектуру (глубина конвейера, число регистров, размеры кэшей) на основе этих измерений.

Вот небольшой цикл (C), который подчёркивает связь:

for (int i = 0; i < n; i++)

sum += a[i];

На RISC‑подобной ISA компилятор обычно держит sum и i в регистрах, использует простые инструкции load для a[i] и выполняет планирование инструкций, чтобы CPU оставался загруженным, пока загрузка выполняется.

Почему игнорирование компилятора тратит кремний и энергию

Если в чип добавляют сложные инструкции или специальный аппарат, которыми компиляторы редко пользуются, эта область всё равно потребляет мощность и ресурсы проектирования. Тем временем «скучные» вещи, на которые полагаются компиляторы — достаточное число регистров, предсказуемые конвейеры, эффективные соглашения о вызовах — могут оказаться недофинансированы.

RISC‑мышление Паттерсона подчёркивало тратить кремний там, где реальное ПО действительно получает выгоду.

Конвейеры, предсказуемость и помощь компилятора

Разверните для реальных измерений

Разверните и хостьте приложение, чтобы быстрее получить реальные сквозные метрики.

Ключевая идея RISC — сделать «сборочную линию» CPU легче для загрузки. Эта линия — конвейер: вместо полного завершения одной инструкции перед началом следующей процессор разбивает работу на стадии (fetch, decode, execute, write‑back) и перекрывает их. Когда всё течёт гладко, вы завершаеете близко к одной инструкции за цикл — как автомобили, проходящие через многостанционную фабрику.

Почему более простые инструкции держат линию в движении

Конвейеры лучше работают, когда каждый элемент линии похож. RISC‑инструкции сделали акцент на однородности и предсказуемости (часто фиксированная длина, простая адресация). Это уменьшает «особые случаи», когда одной инструкции требуется больше времени или необычные ресурсы.

Когда конвейер приходится останавливать: hazards и stalls

Реальные программы не идеально гладкие. Иногда инструкция зависит от результата предыдущей (нельзя использовать значение, пока оно не вычислено). Иногда CPU ждёт данных из памяти, или ещё не известно, какой путь возьмёт переход.

Эти ситуации вызывают stalls — короткие паузы, когда часть конвейера простаивает. Интуиция проста: stalls происходят, когда следующая стадия не может делать полезную работу, потому что чего‑то не хватает.

Компилятор как регулировщик движения

Здесь ясно проявляется hardware–software co‑design. Если аппарат предсказуем, компилятор может помочь, переставляя порядок инструкций (без изменения смысла программы), чтобы заполнить «провалы». Например, в ожидании значения компилятор может запланировать независимую инструкцию, которая не зависит от этого значения.

Выгода — общая ответственность: CPU остаётся проще и быстрее в обычном случае, а компилятор делает больше планирования. Вместе они уменьшают паузы и повышают пропускную способность — часто улучшая реальную производительность без необходимости усложнять ISA.

Кэши и «стена памяти»: где co‑design окупается

CPU может выполнять простые операции за несколько тактов, но получение данных из основной памяти (DRAM) может занимать сотни тактов. Этот разрыв существует потому, что DRAM физически дальше, оптимизирована под ёмкость и стоимость и ограничена как по задержке, так и по пропускной способности.

По мере того как CPU ускорялись, память не поспевает в тех же темпах — этот растущий разрыв часто называют «memory wall».

Кэши и локальность

Кэши — это маленькие быстрые памяти рядом с CPU, чтобы не платить штраф DRAM на каждом доступе. Они работают потому, что реальные программы обладают локальностью:

- Временная локальность: если вы недавно использовали значение или инструкцию, вероятно, вы снова воспользуетесь ими;

- Пространственная локальность: если вы обратились к одному адресу, вероятно, скоро будете обращаться к соседним адресам.

Современные чипы наращивают уровни кэшей (L1, L2, L3), пытаясь держать «рабочий набор» кода и данных близко к ядру.

Где ISA и компиляторы влияют на поведение кэша

Здесь co‑design показывает свои преимущества. ISA и компилятор вместе формируют, какое давление на кэш создаёт программа.

- Размер кода имеет значение. Большие бинарники и «тяжёлые» последовательности инструкций могут переполнять инструкционный кэш, вызывая паузы. Выбор ISA, улучшающий плотность кода (например, опциональные сжатые инструкции), повышает вероятность попадания в инструкционный кэш.

- Шаблоны доступа важны. Дизайн в стиле RISC с моделью «load/store» делает обращения в память явными. Компиляторы могут ранжировать загрузки, дольше держать горячие значения в регистрах и сокращать ненужный трафик в память.

- Расположение и блокирование. Оптимизации компилятора вроде loop tiling (blocking), переупорядочивания структур данных и подсказок prefetch направлены на превращение «случайных походов в DRAM» в предсказуемые попадания в кэш.

Стена памяти в реальной производительности

Проще говоря, memory wall объясняет, почему CPU с высокой частотой всё ещё может казаться вялым: открытие тяжёлого приложения, выполнение запроса в базе данных, прокрутка ленты или обработка большого набора данных часто упираются в промахи кэша и пропускную способность памяти — а не в арифметическую скорость.

Эффективность: производительность на ватт, а не только сырая скорость

Ускоряйте разработку с помощью планирования

Создайте веб-приложение на React и быстро итеративно улучшайте его в режиме планирования в Koder.ai.

Долгое время обсуждения CPU походили на гонку: чей чип быстрее — тот и победил. Но реальные компьютеры живут в физических ограничениях — батарея, тепло, шум вентиляторов и счета за электроэнергию.

Поэтому performance per watt стал ключевым показателем: сколько полезной работы вы получаете на потраченную энергию.

Думайте об этом как об эффективности, а не о пике силы. Два процессора могут ощущаться примерно одинаково быстрыми, но один делает это, потребляя меньше энергии, оставаясь холоднее и работая дольше от той же батареи.

В ноутбуках и телефонах это напрямую влияет на время работы и комфорт. В дата‑центрах — на стоимость питания и охлаждения тысяч машин и плотность размещения серверов.

Почему простые ядра часто тратят меньше энергии

RISC‑мышление сдвинуло дизайн CPU в сторону меньшего объёма аппаратной логики и большей предсказуемости. Простое ядро может снижать энергопотребление несколькими путями:

- Менее сложная логика управления означает меньше внутренних «переключений» на каждый такт;

- Более предсказуемое исполнение упрощает поддержание заполненного конвейера без дорогого отката;

- Дружелюбный к компилятору дизайн даёт ПО возможность планировать работу эффективно, избегая того, чтобы аппарат тратил ресурсы на угадывание.

Смысл не в том, что «простое всегда лучше». Сложность имеет ценник в энергии, и правильно выбранная ISA и микроархитектура могут обменять немного хитрости на большую эффективность.

Мобильные устройства и серверы сходятся к одной цели

Телефоны заботятся о батарее и тепле; серверы — о подаче питания и охлаждении. Разные среды — тот же вывод: самый быстрый чип не всегда лучший компьютер. Побеждают проекты, которые дают стабильную пропускную способность при контролируемом энергопотреблении.

Что RISC угадал — и что было сложнее

RISC часто сводят к «проще инструкции побеждают», но более глубокая мысль такова: ISA важна, но многие реальные выигрыши пришли от того, как чипы были реализованы, а не только от внешнего вида ISA.

Дебаты о значении ISA

Ранние аргументы RISC намекали, что чистая, небольшая ISA автоматически ускорит компьютеры. На практике наибольшие приросты часто давали реализации, которые RISC делал проще: простая декодировка, глубокая конвейеризация, более высокие частоты и компиляторы, умеющие планировать работу предсказуемо.

Вот почему два CPU с разными ISA могут по скорости оказаться рядом, если их микроархитектура, размеры кэша, предсказание переходов и технологический процесс различаются. ISA задаёт правила; микроархитектура играет по ним.

Измерения лучше списков возможностей

Ключевой сдвиг эпохи Паттерсона — проектирование по данным, а не по предположениям. Вместо добавления инструкций потому, что они «кажутся» полезными, команды измеряли, что реально делают программы, и оптимизировали частые случаи.

Такой подход часто выигрывал у «feature‑driven» дизайна, где сложность растёт быстрее, чем выгода. Он также проясняет компромиссы: инструкция, экономящая несколько строк кода, может стоить дополнительных тактов, энергии или площади кристалла — и эти издержки проявляются повсюду.

Это не история «один победил всех»

RISC‑мышление не привело только к «RISC‑чипам». Со временем многие CISC‑CPU приняли RISC‑подобные внутренние приёмы (например, разбиение сложных инструкций на простые внутренние операции), сохранив при этом совместимость ISA.

Итог не в «RISC поборол CISC». Итог — эволюция в сторону подходов, которые ценят измерения, предсказуемость и тесную координацию аппарат–ПО — независимо от ярлыка ISA.

От MIPS к RISC‑V: непрерывная нить

RISC не остался в лаборатории. Чёткая нить от ранних исследований к современной практике проходит через MIPS и RISC‑V — ISA, которые сделали простоту и ясность преимуществом, а не ограничением.

MIPS: чистая ISA, которую можно реализовать (и учить)

MIPS часто вспоминают как образовательную ISA, и не случайно: правила легко объяснить, форматы инструкций согласованы, а модель load/store не мешает компилятору. Эта ясность была не только академической. Процессоры MIPS выпускались в реальных продуктах годами (от рабочих станций до встроенных систем), отчасти потому что простая ISA облегчает создание быстрых конвейеров, предсказуемых компиляторов и эффективных инструментов. Когда поведение железа регулярно, ПО может планировать вокруг него.

RISC‑V: открытость, практичность и дружелюбие к co‑design

RISC‑V возродил интерес к RISC‑мышлению, сделав важный шаг, которого MIPS не сделал: он — открытая ISA. Это меняет стимулы. Университеты, стартапы и крупные компании могут экспериментировать, выпускать кремний и делиться инструментами без переговоров о доступе к набору команд.

Для совместного проектирования эта открытость важна, потому что «сторонa ПО» (компиляторы, ОС, рантаймы) могут развиваться публично рядом с «стороной железа», со значительно меньшими искусственными барьерами.

Модульные расширения: добавляй, что нужно — только когда нужно

Ещё одна причина, по которой RISC‑V хорошо подходит для co‑design — модульный подход. Вы начинаете с маленькой базовой ISA, затем добавляете расширения под конкретные нужды — векторную математику, ограничения для встроенных систем или функции безопасности.

Это поощряет более здоровый компромисс: вместо того чтобы набивать все возможные функции в одну монолитную реализацию, команды выравнивают аппаратные возможности под то ПО, которое они действительно запускают.

Если хотите углубиться, смотрите /blog/what-is-risc-v.

Как co‑design проявляется в современной вычислительной технике

Выпустите бэкенд, который можно тестировать

Разверните бэкенд на Go с PostgreSQL по простому запросу и доработайте по замерам.

Co‑design — это не историческая заметка эпохи RISC. Это способ, которым современная вычислительная техника становится быстрее и эффективнее. Ключевая идея остаётся паттерсоновской: нельзя «победить» только аппаратурой или только ПО. Побеждают, когда они дополняют сильные и слабые стороны друг друга.

RISC‑мышление в устройствах, которые вы используете каждый день

Смартфоны и многие встроенные устройства во многом опираются на принципы RISC (часто на базе ARM): простые инструкции, предсказуемое исполнение и сильный акцент на энергопотребление.

Эта предсказуемость помогает компиляторам генерировать эффективный код и позволяет строителям ядер создавать блоки, которые «пьют» мало энергии при скролле, но умеют резко ускоряться для обработки камеры или игр.

Ноутбуки и серверы тоже всё больше идут по тем же путям — особенно по показателю «производительность на ватт». Даже если ISA не выглядит традиционно «RISC», многие внутренние решения стремятся к RISC‑подобной эффективности: глубокая конвейеризация, широкое исполнение и агрессивное управление питанием, настроенное под реальное поведение ПО.

Ускорители — это co‑design в действии

GPU, AI‑ускорители (TPU/ NPU) и медиадекодеры — практическая форма co‑design: вместо того чтобы прогонять всё через универсальный CPU, платформа предоставляет аппарат, соответствующий типичным шаблонам вычислений.

Что делает это настоящим co‑design, а не просто «добавленным железом», — окружающий стек ПО:

- GPU получают скорость через модели программирования вроде CUDA и API типа Vulkan/Metal;

- AI‑ускорители зависят от компиляторов и оптимизаторов графа, которые переводят модель в предпочтительные для чипа операции;

- кодеки выгодны только если ОС, браузеры и приложения действительно ими пользуются.

Если ПО не целится в ускоритель, теоретическая скорость остаётся теоретической.

Стек ПО — часть производительности

Две платформы с близкими спеками могут ощущаться по‑разному, потому что «реальный продукт» включает компиляторы, библиотеки и фреймворки. Хорошо оптимизированная библиотека математики (BLAS), качественный JIT или более умный компилятор могут дать большой выигрыш без смены железа.

Поэтому дизайн современных CPU часто ориентирован на бенчмарки: аппаратные команды смотрят, что делают компиляторы и рабочие нагрузки, и корректируют функции (кэши, предсказание переходов, векторные инструкции, prefetching), чтобы ускорить общий случай.

Короткий чек‑лист: на что обращать внимание

При оценке платформы (телефон, ноутбук, сервер или встраиваемая плата) ищите признаки co‑design:

- Соответствие рабочей нагрузке: ваши приложения CPU‑bound, GPU‑bound, ограничены памятью или дружелюбны к ускорителям?

- Наличие ускорителей: есть ли NPU/GPU/медиадвижок — и используют ли ваши инструменты их на практике?

- Зрелость компиляторов/инструментов: есть ли оптимизированные сборки, хорошие инструменты профилирования и активная поддержка?

- Экосистема библиотек: настроены ли ключевые библиотеки (математика, компьютерное зрение, крипто) под это железо?

- Поведение питания: получаете ли вы устойчивую производительность в рамках тепловых/энергетических ограничений?

Прогресс в вычислениях сегодня — это реже «один более быстрый CPU» и чаще «вся система аппарат–ПО, измеренная и затем спроектированная под реальные нагрузки».

Важные выводы и практические следующие шаги

RISC‑мышление и более широкое послание Паттерсона сводятся к нескольким устойчивым урокам: упростите то, что должно быть быстрым; измеряйте то, что реально происходит; рассматривайте аппарат и ПО как единую систему — потому что пользователь испытывает целое, а не отдельные компоненты.

Уроки, которые стоит сохранить

Во‑первых, простота — это стратегия, а не эстетика. Чистая ISA и предсказуемое исполнение облегчают компиляторам генерацию качественного кода и CPU — его эффективное выполнение.

Во‑вторых, измерения побеждают интуицию. Бенчмаркуйте репрезентативные рабочие нагрузки, собирайте профили и пусть реальные узкие места направляют решения — будь то настройка оптимизаций компилятора, выбор SKU процессора или переработка критичного «горячего» участка.

В‑третьих, co‑design — это где складываются выгоды. Код, дружественный конвейеру, структуры данных, учитывающие кэш, и реалистичные цели по производительности на ватт часто дают больше практической скорости, чем погоня за пиковым теоретическим пропуском.

Практические следующие шаги для продуктовых команд

Если вы выбираете платформу (x86, ARM или системы на базе RISC‑V), оценивайте её так, как это сделают ваши пользователи:

- Бенчмаркуйте end‑to‑end сценарии (время старта, устойчивый throughput, хвостовые задержки), а не только микробенчмарки;

- Отслеживайте метрики эффективности (ватты, тепловые показатели, влияние на батарею) вместе с производительностью;

- Итеративно: профилируйте → изменяйте что‑то одно → измеряйте снова. Малые, верифицированные шаги складываются.

Если часть вашей работы — превращать эти измерения в поставляемое ПО, полезно сократить цикл «сборка–измерение». Например, команды используют Koder.ai для прототипирования и эволюции реальных приложений через чат‑ориентированный рабочий процесс (веб, бэкенд и мобильные), а затем перезапускают те же end‑to‑end бенчмарки после каждого изменения. Фичи вроде планирования, снимков и отката поддерживают ту же дисциплину «измеряй, затем проектируй», которую продвигал Паттерсон — применённую к современным продуктам.

Для более глубокого введения в эффективность смотрите /blog/performance-per-watt-basics. Если сравниваете окружения и нужна простая оценка соотношения цена/производительность, /pricing может помочь.

Вывод остаётся прежним: идеи — простота, измерения и совместное проектирование — продолжают приносить дивиденды, даже когда реализации эволюционируют от конвейеров эпохи MIPS до современных гетерогенных ядер и новых ISA вроде RISC‑V.