14 мая 2025 г.·8 мин

Intel, доминирование x86 и почему смена платформы так сложна

Чёткая история о том, как x86 от Intel накопил десятилетия совместимости, почему экосистемы блокируются и почему смена платформы так трудна для индустрии.

Чёткая история о том, как x86 от Intel накопил десятилетия совместимости, почему экосистемы блокируются и почему смена платформы так трудна для индустрии.

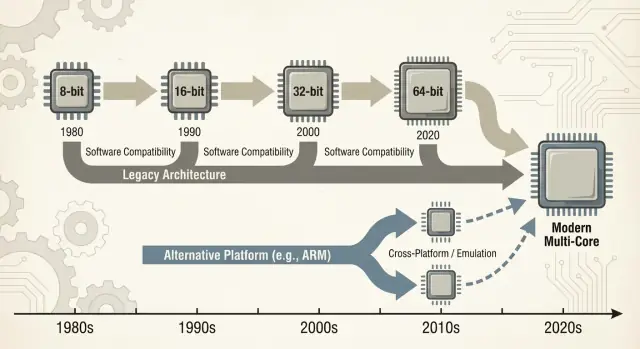

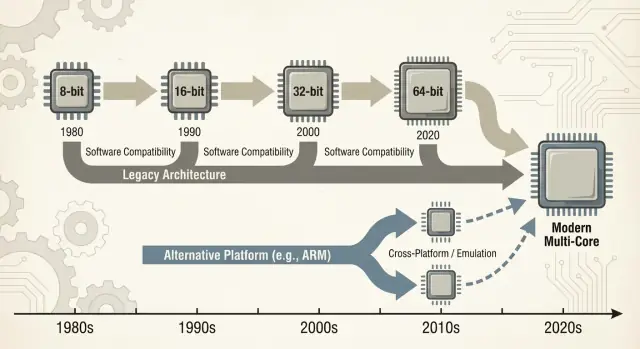

Когда говорят «x86», обычно имеют в виду семейство инструкций CPU, начавшееся с чипа Intel 8086 и развивавшееся десятилетиями. Эти инструкции — базовые глаголы, которые понимает процессор: сложение, сравнение, перемещение данных и т.д. Такой набор инструкций называется ISA (архитектура набора команд). Можно думать об ISA как о «языке», на котором в конце концов должно разговаривать ПО, чтобы работать на данном типе процессора.

x86: самая распространённая ISA, используемая в ПК большую часть последних 40 лет, реализованная прежде всего Intel и также AMD.

Обратная совместимость: способность новых компьютеров продолжать запускать старое ПО (иногда десятилетней давности) без крупных переписок. Это не всегда идеально, но стало руководящим обещанием в мире ПК: «Ваше программное обеспечение должно по‑прежнему работать».

Здесь «доминирование» — это не просто тщеславное утверждение о производительности. Это практическое, накапливающееся преимущество по нескольким измерениям:

Эти слои усиливают друг друга: больше машин → больше ПО; больше ПО → больше машин.

Отказ от доминирующей ISA — не просто замена компонента. Это может сломать или усложнить приложения, драйверы (принтеры, GPU, аудио, нишевые устройства), инструменты разработчика и даже повседневные привычки (образные образы дисков, скрипты IT, агенты безопасности, пайплайны деплоя). Многие зависимости невидимы, пока что‑то не перестаёт работать.

Статья в основном сосредоточена на ПК и серверах, где x86 долгое время был по умолчанию. Мы также обратимся к недавним переходам — особенно к ARM — потому что они дают современные и удобные для сравнения уроки о том, что меняется плавно, а что — нет, и почему «просто пересобрать» редко закрывает всю проблему.

Рынок ранних ПК не стартовал с грандиозного архитектурного плана — он рождался из практических ограничений. Бизнес хотел недорогие машины, доступные в объёмах и простые в обслуживании. Это подтолкнуло вендоров к CPU и комплектующим, которые можно было надёжно закупать, сочетать со стандартными перифериями и собирать системы без глубоких инженерных доработок.

Оригинальная конструкция IBM PC опиралась на готовые компоненты и относительно недорогой процессор Intel 8088‑класса. Этот выбор сделал «ПК» больше похожим на рецепт: семейство CPU, набор слотов расширения, подход к клавиатуре/дисплею и стек ПО, который можно воспроизвести.

Когда IBM PC доказал спрос, рынок расширился за счёт клонов. Компании вроде Compaq показали, что можно строить совместимые машины, запускать те же программы и продавать по другим ценам.

Не менее важным был второй источник производства: несколько поставщиков могли поставлять совместимые процессоры или компоненты. Для покупателей это снижало риск, а для OEM увеличивало предложение и конкуренцию, что ускоряло принятие стандарта.

В такой среде совместимость стала функцией, понятной и ценной для покупателей. Им не обязательно было знать, что такое набор инструкций — достаточно было узнать, запустится ли Lotus 1‑2‑3 (а позже приложения Windows).

Наличие ПО быстро превратилось в простой эвристический критерий покупки: если машина запускает те же программы, что и другие ПК, её можно считать безопасным выбором.

Аппаратные и прошивочные соглашения проделали много невидимой работы. Общие шины и подходы к расширениям — вместе с ожиданиями BIOS/прошивки и единообразным поведением системы — упростили разработчикам и производителям цель «ПК» как стабильной платформы.

Эта стабильность помогла закрепить x86 в роли базиса для растущей экосистемы.

x86 победил не только благодаря тактовой частоте или хорошим чипам. Он выиграл потому, что ПО последовало за пользователями, а пользователи — за ПО: экономический «сетевой эффект», усиливающийся со временем.

Когда платформа получает раннее преимущество, разработчики видят большую аудиторию и более понятный путь к доходу. Это рождает больше приложений, лучшую поддержку и больше сторонних дополнений. Это делает платформу ещё более привлекательной для новых покупателей.

Повторяй этот цикл год за годом — и «платформа по умолчанию» становится крайне трудновыводимой, даже если альтернативы технически привлекательны.

Вот почему переходы платформ — это не только про создание CPU; это про воспроизводство всей экосистемы: приложений, инсталляторов, каналов обновлений, периферии, процессов IT и коллективного опыта миллионов пользователей.

Компании часто долго поддерживают критические приложения: собственные базы данных, внутренние инструменты, надстройки ERP, отраслевое ПО и макросы, которые «просто работают». Стабильная цель x86 означала:

Даже если новая платформа обещала экономию или лучшую производительность, риск сломать выручку приносивший рабочий процесс часто перевешивал выгоду.

Разработчики редко оптимизируют исключительно под «лучшую» платформу. Они оптимизируют под ту, которая минимизирует бремя поддержки и максимизирует охват.

Если 90% ваших клиентов на x86/Windows, вы тестируете и выпускаете туда первыми и исправляете там баги быстрее. Поддержка второй архитектуры означает дополнительные конвейеры сборки, матрицы QA, «на моей машине работает»‑ошибки и больше обращений в поддержку.

Результат: ведущая платформа получает лучшее ПО быстрее.

Представьте малый бизнес. Их бухгалтерский пакет только для x86, с десятилетием шаблонов и плагином для расчёта зарплат. Также им нужен конкретный принтер этикеток и сканер с капризными драйверами.

Теперь предложите смену платформы. Даже если основное ПО существует, важны периферийные части: драйвер принтера, утилита сканера, PDF‑плагин, модуль импорта банковских выписок. Эти «скучные» зависимости становятся критичными — и если их нет или они ненадёжны, миграция останавливается.

Именно маховик экосистемы накапливает длинный хвост совместимости, на который все тихо опираются.

Обратная совместимость была не просто приятной особенностью x86 — она превратилась в сознательную стратегию продукта. Intel удерживал ISA x86 достаточно стабильной, чтобы ПО, написанное годами раньше, по‑прежнему запускалось, одновременно меняя почти всё внутри.

Ключевое различие в том, что именно сохранялось совместимым. ISA определяет машинные инструкции, на которые опираются программы; микроархитектура — это способ их выполнения.

Intel мог переходить от простых конвейеров к out‑of‑order исполнению, добавлять большие кэши, улучшать предсказание ветвлений или внедрять новые техпроцессы — без требования к переписыванию приложений.

Это создавало ожидание: новые ПК должны запускать старое ПО на «первый день».

x86 накапливал новые возможности слоями. Расширения набора инструкций вроде MMX, SSE, AVX и последующих были аддитивными: старые бинарники продолжали работать, а новее программы могли обнаруживать и использовать новые инструкции.

Крупные переходы сглаживались механизмами совместимости:

Обратная сторона — сложность. Поддержка десятилетий поведения означает больше режимов CPU, больше краевых случаев и большую нагрузку на валидацию. Каждое новое поколение должно доказывать, что оно всё ещё запускает приложение прошлого дня, драйвер или инсталлятор.

Со временем «не ломать существующие приложения» перестаёт быть рекомендацией и становится стратегическим ограничением: это защищает установленную базу, но делает радикальные архитектурные изменения — новые ISA, новые системные дизайны, новые допущения — гораздо сложнее обосновать.

«Wintel» — это не просто ярлык для Windows и Intel. Это самоподдерживающаяся петля, где каждая часть индустрии ПК выигрывает от ориентации на один и тот же дефолт: Windows на x86.

Для большинства потребительских и корпоративных поставщиков ПО практический вопрос был не «какая архитектура лучше?», а «где клиенты и какие будут обращения в поддержку?».

Windows на x86 был широко распространён в домах, офисах и школах. Выпуск для этой комбинации максимизировал охват и минимизировал сюрпризы.

Когда критическая масса приложений предполагала Windows + x86, у новых покупателей появлялась ещё одна причина выбирать её: их обязательные программы уже работали там. Это делало платформу ещё более привлекательной для следующего поколения разработчиков.

Производителям ПК выгодно быстро собирать множество моделей, закупая компоненты у разных поставщиков и поставляя машины, которые «просто работают». Общая база Windows + x86 упрощала это.

Производители периферии следовали объёмам. Если большинство покупателей использовали Windows ПК, принтеры, сканеры, аудиоинтерфейсы, Wi‑Fi‑чипы и другие устройства в первую очередь делали драйверы для Windows. Лучшая доступность драйверов улучшала опыт на Windows ПК, что помогало OEM продавать больше машин и поддерживать объёмы.

Корпоративные и государственные закупки склонны вознаграждать предсказуемость: совместимость с имеющимся ПО, управляемые расходы на поддержку, гарантии и проверенные инструменты развертывания.

Даже если альтернативы заманчивы, выбор с наименьшим риском часто побеждает, потому что он уменьшает обучение, избегает краевых ошибок и вписывается в устоявшиеся IT‑процессы.

Результат — не заговор, а набор выровненных стимулов: каждый участник выбирает путь меньшего трения, создавая инерцию, из‑за которой смена платформы становится необычно трудной.

«Переход платформы» — это не просто смена CPU. Это пакетное перемещение: ISA процессора, операционная система, компилятор/инструменты сборки и стек драйверов. Изменение любой из этих частей обычно нарушает другие.

Большинство сбоев не выглядят как громкие «приложение не запускается». Это «смерть от тысячи мелких порезов»:

Даже если основное приложение имеет новую сборку, его «клей» может не идти в ногу.

Принтеры, сканеры, этикеточные принтеры, специализированные PCIe/USB‑карты, медицинские приборы, POS‑оборудование и USB‑донглы живут и умирают вместе с драйверами. Если вендор отсутствует или не заинтересован — драйвера для новой ОС/архитектуры может не быть.

В многих компаниях одно устройство за $200 может заморозить парк ПК стоимостью $2000 за штуку.

Главный блокиратор — это часто «маленькие» внутренние инструменты: самописная база Access, рабочая книга Excel с макросами, VB‑приложение 2009 года, нишевый производственный утилитный софт, используемый тремя людьми.

Они не в дорожной карте, но критичны для бизнеса. Переходы проваливаются, когда за этот длинный хвост никто не отвечает и его не мигрируют и не тестируют.

Переход платформы оценивают не только по бенчмаркам. Считается, останется ли общий счёт — деньги, время, риск и потеря темпа — ниже воспринимаемой выгоды. Для большинства людей и организаций этот счёт выше, чем кажется со стороны.

Для пользователей стоимость переключения начинается с очевидного (новое железо, периферия, гарантии) и быстро переходит в запутанные вещи: переобучение, перенастройка рабочих процессов и перепроверка ежедневных инструментов.

Даже если приложение «запускается», детали могут измениться: плагин не загружается, драйвер принтера отсутствует, макрос ведёт себя иначе, анти‑чит у игры реагирует, или нишевый аксессуар перестаёт работать. По‑отдельности мелочи, вместе они могут уравнять ценность апгрейда в ноль.

Производители платят за переходы платформ разрастанием матрицы тестирования. Это не только «запускается ли». Это:

Каждая дополнительная комбинация добавляет время QA, документооборот и тикеты в поддержку. Переход может превратить предсказуемый цикл релизов в постоянный режим реагирования на инциденты.

Разработчики несут расходы на перенос библиотек, переписывание критичных по производительности участков (часто вручную оптимизированных под ISA) и восстановление тестов. Сложнее всего вернуть уверенность: доказать, что новая сборка корректна, достаточно быстра и стабильна в реальных нагрузках.

Миграционная работа конкурирует с новыми фичами. Если команда тратит два квартала на то, чтобы «всё снова заработало», это два квартала без улучшений продукта.

Многие организации переключатся только тогда, когда старая платформа их блокирует — или когда новая настолько выгодна, что это оправдывает компромисс.

Когда появляется новая CPU‑архитектура, пользователи не спрашивают про ISA — они спрашивают, откроются ли их приложения. Поэтому «мосты» важны: они позволяют новым машинам запускать старое ПО, пока экосистема подтягивается.

Эмуляция имитирует целый процессор программно. Это наиболее совместимый вариант, но обычно самый медленный, потому что каждая инструкция «разыгрывается» в коде.

Бинарная трансляция (часто динамическая) переписывает куски x86‑кода в нативные инструкции новой архитектуры во время выполнения. Именно так многие современные переходы дают «историю рабочего дня»: установите старые приложения, и слой совместимости тихо переводит их на лету.

Ценность проста: вы можете купить новое железо, не дожидаясь, пока каждый вендор перекомпилирует ПО.

Слои совместимости лучше всего работают для массовых, «хорошо себя ведущих» приложений и испытывают сложности на краях:

Аппаратная поддержка часто оказывается реальным блокиратором.

Виртуализация помогает, когда нужен целый унаследованный стек (конкретная версия Windows, старый Java‑стек, корпоративное приложение). Это удобно в операционном плане — снимки, изоляция, откат — но зависит от того, что именно виртуализируется.

VM на той же архитектуре может работать почти нативно; кросс‑архитектурные VM чаще падают в эмуляцию и замедляются.

Мост обычно подходит для офисных приложений, браузеров и повседневной продуктивности — где «достаточно быстро» работает. Риски выше для:

На практике мосты покупают время, но редко полностью исключают работы по миграции.

Аргументы про CPU часто звучат как единый зачёт: «быстрее — значит лучше». На деле платформы выигрывают, когда они соответствуют ограничениям устройств и нагрузок, которые реально запускают пользователи.

x86 стал дефолтом для ПК отчасти потому, что давал сильную пиковую производительность при наличии «стены» питания, и потому что индустрия выстраивала всё остальное под это допущение.

Покупатели настольных ПК и ноутов исторически ценили отзывчивость: запуск приложений, компиляция, игры, тяжёлые таблицы. Это тянет в сторону высоких тактовых частот, широких ядер и агрессивного турбо — отлично при наличии свободных ватт.

Энергоэффективность — другая история. Если продукт ограничен батареей, теплом или тонким корпусом, лучший CPU — тот, кто делает «достаточно» работы на ватт, стабильно, без троттлинга.

Эффективность — не только про экономию энергии: это про поддержание производительности в пределах тепловых лимитов.

Телефоны и планшеты существуют в жёстких энергетических пределах и всегда были чувствительны к стоимости на масштабах. Это вознаградило дизайны, оптимизированные под эффективность, интеграцию компонентов и предсказуемое тепловое поведение.

Это также создало экосистему, где ОС, приложения и кремний развивались вместе под мобильные допущения.

В дата‑центрах выбор CPU редко сводится к чистым бенчмаркам. Операторы ценят функции надёжности, длительные окна поддержки, стабильную прошивку, мониторинг и зрелую экосистему драйверов, гипервизоров и инструментов управления.

Даже когда новая архитектура выглядит привлекательно по perf/watt, риск операционных сюрпризов может перевесить выгоду.

Современные серверные нагрузки разнообразны: веб‑сервы выигрывают от высокой пропускной способности и эффективного масштабирования; базы данных ценят пропускную способность памяти и согласованную задержку; AI сдвигает ценности в сторону ускорителей и стеков ПО.

Когда микс меняется, выигрывающая платформа тоже может измениться — но только если экосистема успевает за этим.

Новая CPU‑архитектура может быть технически великолепна и всё равно провалиться, если инструменты повседневной разработки не делают легко процесс сборки, доставки и поддержки ПО. Для большинства команд «платформа» — это не только набор инструкций, но и весь конвейер поставки.

Компиляторы, отладчики, профайлеры и базовые библиотеки формируют поведение разработчиков. Если лучшие флаги компилятора, трассы стека, санитайзеры или инструменты профилирования приходят поздно (или ведут себя по‑другому), команды колеблются.

Даже мелкие пробелы важны: отсутствующая библиотека, нестабильный плагин отладчика или более медленная CI‑сборка могут превратить «можно портировать» в «не будем в этом квартале». Когда тулчейн x86 по‑умолчанию в IDE, системах сборки и CI, путь наименьшего сопротивления продолжает тянуть разработчиков назад.

ПО доходит до пользователей через конвенции упаковки: инсталляторы, обновления, репозитории, магазины приложений, контейнеры и подписанные бинарники. Переход платформы ставит неудобные вопросы:

Если доставка усложняется, расходы поддержки растут — и многие вендоры избегают этого.

Компании покупают платформы, которыми можно управлять в масштабе: имиджинг, регистрация устройств, политики, агенты безопасности, EDR, VPN‑клиенты и отчётность по соответствию. Если какие‑то из этих инструментов отстают на новой архитектуре, пилоты останавливаются.

«На моей машине работает» неважно, если IT не может развернуть и обезопасить устройство.

Разработчики и IT сходятся в одном практическом вопросе: как быстро мы можем поставлять и поддерживать? Инструменты и доставка часто отвечают на него сильнее любых бенчмарков.

Один из практических способов снизить трение миграции — сократить время от идеи до проверяемой сборки, особенно при валидации одного приложения в разных окружениях (x86 vs ARM, разные образы ОС или таргеты деплоя).

Платформы вроде Koder.ai вписываются в этот рабочий процесс, позволяя командам генерировать и итерационно дорабатывать реальные приложения через чат‑интерфейс — обычно создавая React‑фронтенды, Go‑бэкенды и PostgreSQL‑базы (плюс Flutter для мобильных). Для работ по переходу платформ особенно важны две возможности:

Поскольку Koder.ai поддерживает экспорт исходного кода, он может служить мостом между экспериментом и обычным инженерным пайплайном — полезно, когда нужно быстро двигаться, но в итоге получить поддерживаемый код под вашим контролем.

Продвижение ARM в ноутбуках и настольных системах — полезная проверка того, насколько сложны реальные переходы платформ. На бумаге аргумент прост: лучшее соотношение производительности и энергопотребления, тише, дольше работает батарея.

На практике успех зависит не от ядра CPU, а от всего, что вокруг: приложений, драйверов, доставки и того, кто имеет власть выровнять стимулы.

Переход Apple с Intel на Apple Silicon прошёл во многом потому, что Apple контролирует полный стек: дизайн железа, прошивку, ОС, инструменты разработчика и основные каналы дистрибуции приложений.

Это позволило компании сделать чистый разрыв, не дожидаясь, пока десятки независимых партнёров синхронно двинутся.

Компания также организовала координированный период «моста»: разработчики получили чёткие цели, пользователи — пути совместимости, а Apple могла оказывать давление на ключевых вендоров, чтобы те выпускали нативные сборки. Даже когда некоторые приложения не были нативными, пользовательский опыт оставался приемлемым, потому что план перехода был задуман как продукт, а не просто смена процессора.

Windows‑на‑ARM показывает обратную сторону. Microsoft не полностью контролирует экосистему железа, а Windows‑ПК сильно зависят от выборов OEM и длинного хвоста драйверов устройств.

Это создаёт обычные точки отказа:

Недавние успехи ARM подтверждают главный урок: контроль над большим количеством слоёв стека делает переходы быстрее и менее фрагментированными.

Когда вы полагаетесь на партнёров, требуется необычайно сильная координация, чёткие пути обновления и причина для каждого участника — чип‑вендора, OEM, разработчика и покупателя IT — двигаться одновременно.

Переходы проваливаются по скучным причинам: старая платформа всё ещё работает, все уже «заплатили» за неё деньгами и привычками, а «краевые случаи» — вот где живут реальные бизнесы.

Новая платформа выигрывает, когда совпадают три фактора:

Во‑первых, выгода очевидна для обычных покупателей, а не только для инженеров: заметно лучшее время автономной работы, значительно ниже стоимость, новые форм‑факторы или скачок производительности для обычных задач.

Во‑вторых, существует правдоподобный план совместимости: отличная эмуляция/трансляция, простые «универсальные" сборки и понятные пути для драйверов, периферии и корпоративных инструментов.

В‑третьих, стимулы выровнены по цепочке: вендор ОС, производитель процессора, OEM и разработчики приложений видят выгоду и имеют причину приоритизировать миграцию.

Успешные переходы выглядят не как щелчок выключателя, а как контролируемое перекрытие. Фазовые развёртки (сначала пилотные группы), двойные сборки (старые + новые) и телеметрия (уровни падений, производительность, использование функций) позволяют командам ловить проблемы рано.

Не менее важно: объявленные сроки поддержки старой платформы, понятные внутренние дедлайны и план для тех, кто «не может перейти пока".

x86 сохраняет огромную инерцию: десятилетия совместимости, укоренённые корпоративные рабочие процессы и широкий выбор железа.

Но давление растёт: потребности в энергоэффективности, более плотной интеграции, вычислениях для AI и упрощённых флотах устройств. Сложнейшие сражения — не о сырой скорости, а о том, как сделать переход безопасным, предсказуемым и окупаемым.

x86 — это архитектура набора команд (ISA): набор машинных инструкций, на которых в итоге выполняется программное обеспечение.

«Доминирование» в этой статье означает накапливающееся преимущество: огромный объем поставок, самая большая база программ, и стандартное представление о платформе — то есть не только лидерство в бенчмарках, но и практическое, экономическое преимущество.

ISA — это «язык», который понимает CPU.

Если приложение скомпилировано для x86, оно будет выполняться нативно на x86‑процессоре. При переходе на другую ISA (например, ARM) обычно требуется нативная сборка, либо приходится полагаться на трансляцию/эмуляцию, чтобы запустить старый бинарник.

Обратная совместимость позволяет новым машинам запускать старое ПО с минимальными изменениями.

В мире ПК это стало ожиданием продукта: обновление не должно заставлять переписывать приложения, менять отлаженные рабочие процессы или отказываться от «того самого» устаревшего инструмента, который всё ещё нужен.

Чипы могут менять то, как выполняются инструкции (микроархитектура), сохраняя при этом сам набор инструкций (ISA) стабильным.

Именно поэтому можно улучшать производительность, кэши и энергопотребление, не ломая старые бинарники.

Типичные точки отказа:

Часто «главное приложение» работает, но окружающая его связка — нет.

Потому что именно отсутствующий драйвер или неподдерживаемое периферийное устройство чаще всего блокируют переход.

Совместимость на уровне приложений можно попытаться обеспечить переводом бинарников, но это не решает проблему отсутствия стабильного драйвера для узкоспециализированного сканера, POS‑терминала или USB‑ключа, если производитель его не выпустил.

Установленная база определяет приоритеты разработчиков.

Если большинство клиентов работают на Windows/x86, в первую очередь тестируют и выпускают для этой комбинации. Поддержка другой архитектуры добавляет сборки в CI, матрицы QA, документацию и нагрузку на службу поддержки, поэтому многие команды ждут явного спроса.

Не стоит на это полагаться как на единственное решение.

Пересборка — лишь часть работы. Часто также нужны:

Сложнее всего доказать, что новая сборка корректна и поддерживаема в реальных средах.

Это мосты, а не панацея:

Они дают время экосистеме на адаптацию, но драйверы и низкоуровневые компоненты остаются единственными жесткими пределами.

Используйте пилот с чек‑листом:

Рассматривайте переход как контролируемый rollout с возможностью отката, а не как «большой взрыв».