17 апр. 2025 г.·7 мин

Как JavaScript захватил веб, бэкенд и целые компании

От скриптов в браузере до серверов на Node.js — рост JavaScript изменил инструменты, найм и выпуск продуктов, сделав один язык основой для целых компаний.

От скриптов в браузере до серверов на Node.js — рост JavaScript изменил инструменты, найм и выпуск продуктов, сделав один язык основой для целых компаний.

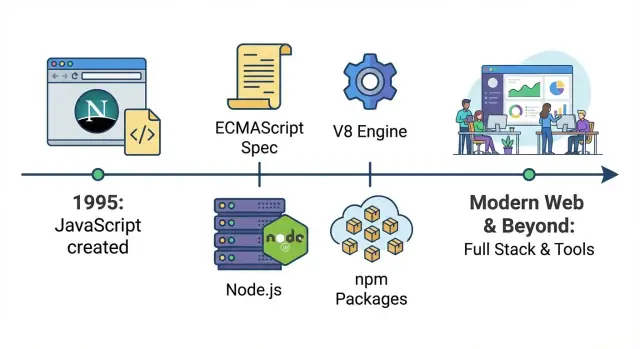

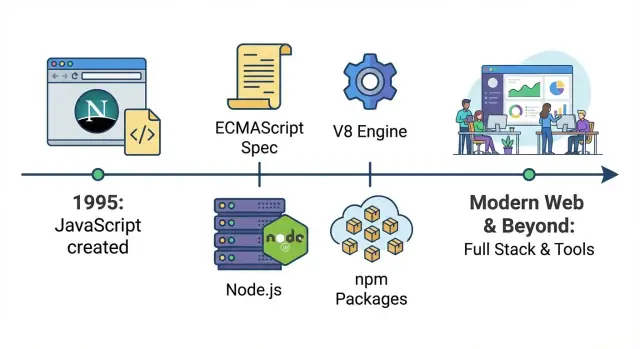

JavaScript изначально появился как способ добавить немного интерактивности на страницы — небольшие скрипты для валидации форм, смены картинки или показа выпадающего меню. Это руководство показывает, как «маленький язык‑помощник» трансформировался в платформу на уровне всей компании: та же базовая технология теперь запускает интерфейсы, серверы, билды, автоматизацию и внутренние инструменты.

Практически это означает: JavaScript — тот язык, который может выполнить любой мейнстримный браузер напрямую. Если вы поставляете код пользователю без необходимости устанавливать что‑то, JavaScript — универсальный вариант. Другие языки могут участвовать, но чаще компилируются в JavaScript или работают на сервере, тогда как JavaScript по умолчанию выполняется на месте.

Первая — эра браузера, где JavaScript стал стандартом для управления страницей: реакция на клики, манипуляции DOM и позже — богатые интерфейсы по мере того, как веб ушёл от статичных документов.

Вторая — эра бэкенда, когда быстрые движки и Node.js сделали запуск JavaScript на серверах практичным. Это открыло общий язык для фронтенда и бэкенда и пакетный экосистему, которая ускорила повторное использование кода.

Третья — эра операционной деятельности бизнеса, когда JavaScript‑инструменты превратились в «клей»: сборочные пайплайны, тестирование, дизайн‑системы, дашборды, скрипты автоматизации и интеграции. Даже команды, которые не считают себя «JavaScript‑командами», часто ежедневно зависят от JS‑инструментов.

Мы сосредоточимся на ключевых поворотных моментах — стандартизации, рывках производительности, Node.js, npm и переходе к фреймворк‑ориентированным приложениям — вместо полного каталога библиотек и трендов.

JavaScript был создан в 1995 году в Netscape как простой способ добавить интерактивность на страницы без обращения к серверу или установки софта. Brendan Eich быстро написал первую версию; первоначальная цель была скромной: давать авторам возможность валидировать формы, реагировать на клики и делать страницы менее статичными.

Ранние ограничения веба определяли рамки JavaScript. Компьютеры были медленнее, браузеры примитивными, и большинство сайтов состояли в основном из текста и нескольких изображений. Скрипты должны были быть лёгкими и терпимыми к ошибкам — маленькие фрагменты, выполнявшиеся без зависания страницы.

Поскольку страницы были простыми, ранний JavaScript часто выглядел как «немного логики», вписанной прямо в HTML: проверка, есть ли в поле email @, показ alert, замена изображения при наведении.

До этого страница в основном отображала контент. С встраиванием JavaScript она могла немедленно реагировать на действия пользователя. Даже маленький скрипт мог:

Это было началом превращения браузера в среду выполнения приложений, а не просто в просмотрщик документов.

Минус — непредсказуемость. Браузеры по‑разному интерпретировали JavaScript, а API для работы со страницей (ранние поведения DOM, модели событий, методы элементов) сильно отличались. Разработчикам приходилось писать разные пути для разных браузеров, постоянно тестировать и мириться с тем, что на одной машине что‑то работало, а на другой — нет.

В конце 1990‑х — начале 2000‑х браузеры активно конкурировали, выпуская новые фичи как можно быстрее. Netscape и Internet Explorer соревновались не только в скорости — они добавляли собственные расширения JavaScript, DOM‑API и проприетарные возможности.

Для разработчиков это значит, что один и тот же скрипт мог работать в одном браузере и ломаться в другом: разная модель событий, отсутствующие методы, несовпадающие пограничные случаи. Выпуск сайта часто требовал двух версий логики и хитрых хаков для определения браузера.

Чтобы уменьшить хаос, нужен был общий стандарт, не контролируемый одним вендором. Таким стандартом стал ECMAScript — спецификация, описывающая ядро языка (синтаксис, типы, функции, объекты и т.д.).

Полезная модель мышления:

Когда вендоры согласовали версии ECMAScript, язык стал предсказуемее между браузерами. Несовместимости не исчезли мгновенно — API вне ядра языка (например, части DOM) всё ещё отличались — но фундамент стабилизировался. Со временем лучшие тест‑наборы и общие ожидания сделали фразу «работает в моём браузере» менее приемлемой.

Даже по мере развития ECMAScript обратная совместимость стала обязательной: старые сайты должны продолжать работать. Поэтому устаревшие паттерны — var, странные правила сравнения и обходы до появления модулей — остались в экосистеме. Веб не мог позволить себе радикальную перезагрузку, поэтому JavaScript рос, добавляя новые возможности, а не удаляя старые.

До Ajax большинство сайтов вело себя как бумажные формы: клик — перезагрузка страницы и ожидание сервера, пока он вернёт новый HTML. Ajax (Asynchronous JavaScript and XML, хотя на практике победил JSON) изменил этот паттерн. С помощью JavaScript страница могла запрашивать данные в фоне и обновлять только нужную часть интерфейса — без полной перезагрузки.

Ajax сделал веб более похожим на интерактивную программу. Поле поиска могло показывать подсказки во время набора, сумма в корзине обновлялась мгновенно, комментарии появлялись после отправки без возвращения на верх страницы.

Это не просто красивое поведение — это уменьшение трения. Люди перестали терпеть «клик → ждать → перезагрузка» для каждой мелочи.

Продукты типа Gmail показали, что браузер способен на поведение приложения: быстрые обновления, плавная навигация и меньше прерываний. Когда пользователи испытали такую отзывчивость, это стало базовым ожиданием и для других сайтов.

Ajax подтолкнул команды отделять «данные» от «страницы». Вместо отправки полного HTML серверы всё чаще отдавали структурированные данные (JSON), а браузер — при помощи JavaScript — становился настоящим клиентом, отвечающим за рендеринг, взаимодействие и состояние.

Минус — возросшая сложность. В браузер переместилось больше логики: валидация, состояние UI, кэширование, обработка ошибок и вопросы производительности. Это подготовило почву для более тяжёлых инструментов фронтенда и, в конце концов, для одностраничных приложений, где сервер в основном предоставляет API, а фронтенд ведёт себя как полноценное приложение.

Ранний JavaScript был сложен не из‑за самого языка, а из‑за хаоса среды выполнения. Скрипты, работающие с DOM, означали бороться с разными моделями событий, несовместимыми API элементов и примочками верстки, которые менялись в зависимости от браузера. Даже простая задача «найти элемент и скрыть его по клику» могла превратиться в гору условных операторов и обходных путей.

Разработчики много времени тратили на борьбу с совместимостью вместо создания фич. Выбор элементов отличался в разных браузерах, привязка событий была непоследовательной, а манипуляция стилями — непредсказуемой. В результате многие команды избегали тяжелого клиентского кода или использовали плагины вроде Flash для более богатых интерфейсов.

Фишка jQuery была проста: он предложил небольшой, читабельный API и скрывал кросс‑браузерные различия за кулисами. Один синтаксис селектора работал повсеместно, обработка событий стала предсказуемой, а распространённые эффекты — доступны в один вызов функции. Вместо того, чтобы учить десять браузерных правил, люди учились «по‑jQuery» и быстро выпускали работающие результаты.

Это имело культурное значение: JavaScript стал первым языком, который многие веб‑разработчики осваивали, потому что он давал видимый результат. Тут же пошли туториалы, сниппеты и плагины: пару строк — и интерфейс выглядел современно.

По мере улучшения браузеров и падения приемлемости плагинов (проблемы безопасности, отсутствие поддержки на мобильных, вопросы производительности) команды стали выбирать нативные веб‑технологии. jQuery помог перейти: он снизил порог вхождения в DOM‑программирование, и поколение разработчиков уже знало JavaScript достаточно, чтобы строить следующий виток веба.

Долгое время главное ограничение JavaScript было не в синтаксисе, а в скорости. Ранние страницы терпели медленное исполнение, потому что скрипты были малы: валидация форм, переключение меню, немного интерактивности. Но когда разработчики попытались строить полнофункциональные приложения в браузере, производительность стала критичной.

V8 — движок JavaScript от Google для Chrome. Движок — часть браузера, которая читает JavaScript и выполняет его. Прорыв V8 в том, что он стал рассматривать JavaScript как код, пригодный для агрессивной оптимизации во время выполнения.

Проще говоря: V8 значительно лучше превращал JavaScript в машинные инструкции быстро, а затем реоптимизировал «горячие» участки кода по мере того, как узнавал поведение программы. Это снизило лаги, сгладило анимации и сократило время между кликом пользователя и реакцией на экране.

Когда JavaScript ускорился, команды могли переносить больше логики в браузер, не жертвуя UX. Это изменило представление о том, что разумно строить:

Производительность не только улучшила существующие сайты — она расширила категорию ПО, которое можно было разместить в вебе.

Ключевая динамика была такова:

Лучшие движки → разработчики писали больше JavaScript → пользователи дольше работали в JS‑тяжёлых приложениях → браузеры инвестировали ещё больше в движки.

Компании, борясь за долю рынка браузеров, делали ставку на скорость. Реальные веб‑приложения служили бенчмарками, и каждое улучшение поощряло разработчиков идти дальше.

V8 не был единственным. SpiderMonkey (Mozilla) и JavaScriptCore (Apple) тоже быстро прогрессировали, у каждого свои стратегии оптимизации. Важный момент не в том, какой движок «выиграл», а в том, что конкуренция сделала быстрый JavaScript базовым ожиданием.

Как только выполнение стало достаточно быстрым для требовательных интерфейсов, JavaScript перестал быть «просто языком скриптов в браузере» и стал платформой, на которую команды могли ставить свои проекты.

Node.js — это рантайм, который позволяет запускать JavaScript вне браузера. Вместо кода только для кнопок и взаимодействий на странице, разработчики получили возможность писать серверы, CLI‑утилиты и фоновые задачи на том же языке.

Node.js построен вокруг цикла событий: способа обработки большого количества ожиданий (сетевые запросы, запросы к БД, чтение файлов) без создания отдельного потока на каждое соединение.

Для многих веб‑нагрузок серверы проводят больше времени в ожидании, чем в вычислениях. Модель event loop делает возможным обслуживать много одновременных пользователей с относительно простым кодом, особенно для приложений с «живым» обновлением, где изменения нужно быстро отправлять клиентам.

Node.js сначала прижился там, где важна была отзывчивость:

Даже если ядро инфраструктуры работало на других языках, Node.js часто становился «склейкой»: обрабатывал запросы, оркестровал вызовы сервисов или поддерживал внутренние утилиты.

Большое изменение было не только техническим, но и культурным. Когда фронтенд и бэкенд используют JavaScript, команды могут делиться правилами валидации, моделями данных и даже частью бизнес‑логики. Разработчики меньше переключаются между экосистемами, что помогает малым командам двигаться быстрее и даёт крупным командам стандарты для разработки и ревью кода.

npm — это «магазин приложений» для JavaScript. Вместо написания всего с нуля — обработка дат, маршрутизация, тесты, UI‑виджеты — команды ставили пакет и двигались дальше. Этот рабочий поток («install, import, ship») ускорил разработку и превратил JavaScript в общий набор инструментов.

После того как Node.js сделал JavaScript полезным вне браузера, npm дал стандартный способ публиковать и переиспользовать модули. Небольшая библиотека для одного проекта могла внезапно помочь тысячам других. Возник эффект нарастающей отдачи: каждый новый пакет ускорял создание следующего проекта.

Open source также снизил цену экспериментов. Стартап мог собрать жизнеспособный продукт небольшой командой, опираясь на пакеты для логирования, авторизации, сборки и прочего.

Большинство npm‑пакетов следуют semantic versioning (semver), трёхчастной нумерации вроде 2.4.1:

2) — изменения, ломающие совместимость.4) — добавление совместимых фич.1) — исправления багов.Lockfile (например, package-lock.json) фиксирует точные версии установленных пакетов, чтобы у всей команды и CI была одинаковая совокупность зависимостей и не возникало сюрпризов «на моей машине работает».

Минус лёгкости установки — лёгкость чрезмерного использования. Проекты могут накопить сотни косвенных зависимостей, что увеличивает работу по обновлению и риски цепочки поставок. Некоторые пакеты остаются без поддержки, и команды вынуждены фиксировать старые версии, заменять библиотеки или брать поддержку на себя. Экосистема дала скорость — но сделала гигиену зависимостей частью поставки ПО.

Ранние сайты собирались на сервере. Затем Single‑Page Applications (SPA) перевернули модель: браузер стал средой выполнения приложения, получая данные и рендеря UI без перезагрузок.

Это изменило не только код — изменились ответственности. Фронтенд взял на себя маршрутизацию, состояние, кэширование, доступность и бюджеты производительности. Дизайнеры, бэкенд‑инженеры и продуктовые команды начали сотрудничать вокруг компонентов и пользовательских потоков, а не только шаблонов.

По мере роста SPA произвольный JavaScript становился трудным для сопровождения. React, Angular и Vue помогли, задав паттерны для организации UI:

Разные экосистемы делали разные компромиссы, но главное — появились общие соглашения. Новый инженер мог быстро понять модель мышления по экранам и фичам.

SPA иногда страдали от медленной первой загрузки и проблем с SEO, потому что браузеру приходилось скачивать и выполнить много JS перед показом контента.

Server‑Side Rendering (SSR) и универсальные приложения решают это: сервер рендерит первый вид быстро и для поисковиков, а затем «гидрирует» в браузере для интерактивности. Такой подход стал распространён с фреймворками типа Next.js (React) и Nuxt (Vue), особенно для контентных страниц и e‑commerce.

Когда фронтенд и бэкенд стали дружелюбны к JavaScript, команды стали делиться логикой по стеку:

Результат: меньше дублирования, быстрее доставляемые фичи и усиление мышления «одна кодовая база продукта» между командами.

Когда JavaScript перешёл от «кусочка кода в браузере» к критичным приложениям, команды стали понимать «JavaScript» как целый набор инструментов: современные возможности ECMAScript, сборку и часто TypeScript.

TypeScript остаётся JavaScript в основе — он просто добавляет систему типов и шаг компиляции. Это позволяет вводить его постепенно: можно начать с типизации пару файлов, оставить остальные как .js и всё равно собрать один финальный бандл.

Поэтому многие команды говорят, что «пишут JavaScript», хотя кодовая база в основном на .ts: рантайм — JavaScript, экосистема — JavaScript (npm, браузерные API, Node.js), а результат TypeScript — тоже JavaScript.

Когда кодовая база растёт, сложнее не написать фичу, а безопасно изменить старую. Типы работают как лёгкие контракты:

Ключевое преимущество — уверенность: команды рефакторят и выпускают изменения с меньшим числом регрессий.

Современный JavaScript развивается быстро, но не все среды сразу поддерживают новые фичи. Транспиляция — это:

Так команды используют новые синтаксисы, не дожидаясь, пока все устройства обновятся.

Многие фичи, которые сделали «современный JavaScript» зрелым:

import/export) для чистого, переиспользуемого кодаВместе TypeScript и современные возможности ECMAScript сделали проекты на JS масштабируемыми: проще сопровождать, быстрее вводить новых сотрудников и ниже риск ошибок при изменениях.

JavaScript стал повсеместным не только потому, что он выполняется в браузерах и на серверах, но и потому, что многие команды стали использовать его для выполнения самой работы: сборки, тестов, релизов и автоматизации. Тогда JS перестал быть просто языком приложений и стал внутренним слоем операций.

Сложные фронтенды потребовали повторяемых сборок и надёжных проверок. JavaScript‑инструменты стали естественными, потому что они живут в том же репозитории и используют ту же экосистему пакетов.

Типичный набор включает:

Поскольку эти инструменты запускаются и на локальной машине, и в CI, они уменьшают проблему «работает у меня на ноутбуке».

На практике такой стек «JavaScript везде» делает возможными современные workflow‑подходы: когда UI, сборка и деплой стандартизованы, можно быстро генерировать и итеративно развивать приложения. Платформы вроде Koder.ai учитывают эту реальность — позволяя описать приложение в чате и получить production‑уровневый проект (часто React на фронтенде) с экспортом кода, деплоем, кастомными доменами и снимками/откатами для безопасной итерации.

Растущие компании часто переходят на монорепозитории, чтобы несколько приложений могли делить зависимости, конфиги и соглашения. Это упрощает сопровождение общих библиотек компонентов, внутренних SDK и дизайн‑систем — без копипасты между проектами.

Когда кнопке в дизайн‑системе поправят доступность, все продукты получают фикс через обновление версии или общий пакет. JavaScript (и всё чаще TypeScript) делает такое совместное использование практичным, потому что одни и те же компоненты могут питать прототипы, продакшен и документацию.

Когда линты, тесты и сборки стандартизованы, они становятся ворота качества в CI/CD: мерджи блокируются при падении проверок, релизы автоматизируются, и передача работы между командами упрощается. В результате меньше «племенных знаний», меньше одноразовых процессов и более быстрый путь от идеи до фичи в проде.

JavaScript теперь работает почти везде — в контейнерах на Kubernetes, как serverless‑функции и всё чаще на edge‑рантаймах CDN. Эта гибкость — причина, по которой команды стандартизируются на нём: один язык, много опций деплоя.

JavaScript хорош для I/O‑интенсивных задач (API, веб‑серверы, обработка событий), но слабеет при «тяжёлых вычислениях»:

JavaScript — это язык, который вы пишете и который выполняют движки. ECMAScript — стандартизированная спецификация, определяющая ядро языка (синтаксис, типы, объекты, функции).

На практике: браузеры и Node.js реализуют ECMAScript плюс дополнительные API (DOM в браузерах, файловые/сетевые API в Node.js).

Потому что веб зависит от обратной совместимости старых страниц. Если обновление браузера ломало бы сайты вчерашнего дня, пользователи винили бы браузер.

Вот почему новые возможности обычно добавляют в виде добавочных фич (новый синтаксис и API), а старое поведение (например, var и некоторые странные сопоставления типов) остаётся, даже если в современном коде их избегают.

Ajax позволяет странице запрашивать данные в фоне и обновлять только часть интерфейса — без полной перезагрузки.

Практический эффект:

jQuery дал единый, читаемый API, который скрывал различия между браузерами в выборе элементов, событиях и эффектах.

Если вы модернизируете старый код, распространённый подход такой:

V8 (движок Chrome) сделал JavaScript намного быстрее за счёт агрессивной оптимизации во время выполнения (JIT-компиляция и реоптимизация "горячих" участков кода).

Для команд это означало: стали возможны большие и богатые интерфейсы без зависаний — браузер стал реальной средой исполнения приложений, а не просто просмотрщиком документов.

Node.js запускает JavaScript вне браузера и использует event loop (цикл событий), который эффективно обрабатывает множество операций ввода-вывода (сеть, диск, БД) без создания отдельного потока на каждое соединение.

Это хорошо подходит, когда сервис в основном ждёт I/O:

npm упростил публикацию и повторное использование модулей JavaScript, что ускорило разработку и стандартизировало рабочие процессы.

Чтобы держать зависимости под контролем:

package-lock.json или эквивалент) в репозиторииSPA перемещает маршрутизацию, рендеринг и состояние UI в браузер, получая данные через API вместо полной перезагрузки страницы.

SSR («универсальные» приложения) рендерят первый вид на сервере для быстрой загрузки и лучшей индексируемости, а затем "гидратируют" в браузере для интерактивности.

Простое правило:

TypeScript добавляет типы и шаг компиляции, но в рантайме всё равно выполняется JavaScript.

Команды используют его потому, что это повышает безопасность изменений и качество инструментов:

TypeScript можно вводить постепенно — файл за файлом — без переписывания всего проекта.

JavaScript отлично подходит для задач с интенсивным I/O, но ему трудно даваться в длительных CPU‑нагрузках; возможны паузы из-за GC и рост потребления памяти.

Практические меры: