Что должен уметь менеджер экспериментов по ценам

Эксперименты по ценам — это структурированные тесты, в которых разным группам клиентов показывают разные цены (или упаковки) и измеряют, что меняется: конверсия, апсейлы, отток, доход на посетителя и т.д. Это версия A/B‑теста для цены, но с повышенным риском: ошибка может запутать клиентов, породить тикеты в поддержку или нарушить внутренние правила.

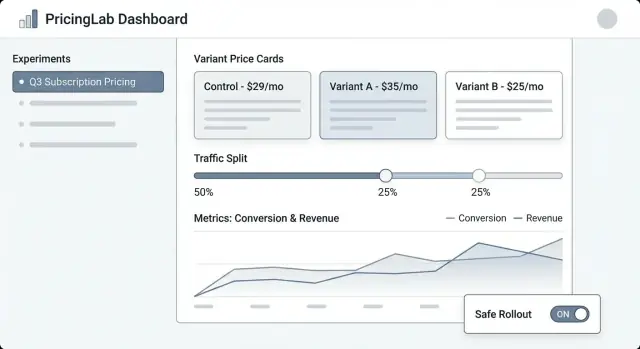

Менеджер экспериментов по ценам — система, которая делает эти тесты контролируемыми, наблюдаемыми и обратимыми.

Проблемы, которые должен решать этот инструмент

Контроль: командам нужно одно место, где можно определить, что тестируется, где и для кого. «Мы поменяли цену» — это не план: эксперимент требует чёткой гипотезы, дат, правил таргетинга и аварийной кнопки.

Трекинг: без стабильных идентификаторов (ключ эксперимента, ключ варианта, метка времени назначения) анализ превращается в домыслы. Менеджер должен обеспечивать, что каждое показание и покупка атрибутируются к правильному тесту.

Согласованность: клиента не должно вести на страницу с одной ценой и списывать с него другую. Менеджер координирует применение вариантов по всем поверхностям, чтобы опыт был цельным.

Безопасность: ошибки в ценах дорого обходятся. Нужны защитные механизмы: лимиты трафика, правила допустимости (например, только новые клиенты), шаги утверждения и аудитируемость.

Кто им пользуется

- Продукт — планирует эксперименты, задаёт метрики успеха и решает, что выкатывать.

- Growth/Маркетинг — итерации по офферам и сообщениям, связанным с ценой.

- Финансы — контроль правил доходности, политик скидок и отчётности.

- Поддержка — понимание того, что видел клиент, и быстрое разрешение споров.

- Инженеры — безопасная и предсказуемая интеграция изменений цен.

Что мы строим (и что нет)

В этом материале речь о внутреннем веб‑приложении, которое управляет экспериментами: создание, назначение вариантов, сбор событий и отчёты.

Это не полнофункциональный ценовой двигатель (расчёт налогов, выставление счетов, мультивалютный каталог, прогоны и т.п.). Это панель управления и слой трекинга, который делает тесты цен достаточно безопасными для регулярного запуска.

Объём, требования и исключения

Менеджер полезен только при чётком понимании того, что он будет и не будет делать. Точный объём упрощает эксплуатацию и снижает риск при запуске, особенно когда на кону реальные доходы.

Минимальные требования (обязательные возможности)

Минимально ваше веб‑приложение должно позволять нетехническому оператору провести эксперимент от начала до конца:

- Создавать эксперименты с названием, гипотезой, целевым продуктом(ами), сегментом(ами) и запланированной длительностью.

- Определять варианты (например, «Контроль: $29», «Лечение: $35»), включая валюту, период биллинга и правила допустимости.

- Запускать / приостанавливать / останавливать эксперимент со статусом и точными временными метками.

- Просматривать результаты на базовом уровне: конверсия, доход на посетителя, средний чек, плюс индикаторы доверия/неопределённости.

Если вы ничего не сделаете дальше — сделайте эти вещи хорошо, с понятными дефолтами и защитами.

Поддерживаемые типы экспериментов (держите выбор осознанным)

Решите заранее, какие форматы экспериментов вы будете поддерживать, чтобы UI, модель данных и логика назначения оставались последовательными:

- A/B тесты (один контроль против одного лечения) — основной путь.

- Мультивариантные / многорукие тесты (несколько ценовых точек) для команд, которым нужно больше двух опций.

- Холдауны (например, 5% видят базовую цену) для измерения долгосрочных или кросс‑системных эффектов.

- Постепенный выкатыв (ramp) для уменьшения риска при обучении.

Что не является целью (что вы сознательно не строите)

Чтобы избежать «ползучего раздувания» функциональности, явно пропишите, что не входит в продукт:

- Не заменяем систему биллинга (инвойсинг, налоги, прогоны, возвраты).

- Не полноценная BI‑платформа (произвольный анализ данных, кастомный SQL, моделирование в хранилище данных).

- Не сложная ML‑оптимизация (динамическое ценообразование, reinforcement learning, авто‑тюнинг).

Критерии успеха

Определяйте успех в операционных терминах, не только в статистических:

- Готовность к решению: PM может уверенно выбрать «выпустить / откатить / итерация».

- Низкий операционный риск: безопасные дефолты, простой откат, контролируемое воздействие.

- Аудируемость: кто что и когда изменял — достаточно для проверок финансов и комплаенса.

Модель данных: эксперименты, варианты и назначения

Приложение для экспериментов по ценам живёт или умирает благодаря модели данных. Если вы не сможете надёжно ответить «какую цену видел этот клиент и когда?», метрики будут шумными, и команда потеряет доверие.

Ключевые сущности

Начните с небольшого набора объектов, отражающих реальную модель продаж:

Идентификаторы и временные поля, которые пригодятся

Используйте стабильные идентификаторы между системами (product_id, plan_id, customer_id). Не используйте «красивые имена» как ключи — они меняются.

Временные поля так же важны:

- created_at для всего.

- starts_at / ends_at у эксперимента для временных окон отчётности.

- decision_date (или decided_at) чтобы пометить, когда результат был принят.

Также подумайте об effective_from / effective_to у записей Price, чтобы можно было реконструировать цену в любой момент времени.

Связи, которые позволяют атрибуцию

Определите связи явно:

- Experiment → Variants (one‑to‑many).

- Customer → Assignments (one‑to‑many, но обычно один активный assignment на эксперимент).

- Event → Customer + Experiment + Variant.

Практически это значит: Event должен нести (или позволять соединиться по) customer_id, experiment_id и variant_id. Если хранить только customer_id и «подгружать назначение позже», вы рискуете ошибочными джойнами при изменении назначений.

Неизменяемость: храните историю, не перезаписывайте

Эксперименты по ценам требуют аудиторной истории. Сделайте ключевые записи append‑only:

- Prices версионируйте, не изменяйте на месте.

- Assignments не редактируйте, чтобы «починить» данные; если нужно изменить экспозицию, создавайте новую запись и закрывайте старую.

- Решения (победитель, обоснование, decision_date) сохраняйте даже если позже будете повторять похожий тест.

Такой подход делает отчёты консистентными и упрощает функционал аудита позже.

Рабочий процесс эксперимента и жизненный цикл

Нужен чёткий жизненный цикл, чтобы было понятно, что редактируемо, что заблокировано и что происходит с пользователями при смене статуса эксперимента.

Рекомендуемый жизненный цикл

Draft → Scheduled → Running → Stopped → Analyzed → Archived

- Draft: создаётся эксперимент, варианты, аудитория и метрики. Ничего не показывается клиентам.

- Scheduled: выставлено время старта (и опционально конца). Система валидирует готовность и может уведомлять заинтересованных лиц.

- Running: назначение и доставка цен живы. Большинство полей блокируются, чтобы избежать случайных изменений в ходе теста.

Обязательные поля и валидация по состояниям

Чтобы снизить риск проблем при запуске, требуйте заполнения полей по мере продвижения эксперимента:

- Перед Scheduled: владелец, область (продукты/регионы/планы), варианты и ценовые точки, распределение трафика, start/end.

- Перед Running: гипотеза, первичная(ые) метрика(и), защитные метрики (например, churn, возвраты, тикеты в поддержку), минимальная выборка или правило минимального времени, план отката и подтверждение схемы трекинга.

- Перед Analyzed: момент съёмки финального снэпшота данных, заметки анализа и решение (ship/iterate/reject).

Шлюзы утверждения и оверрайды

Для цен добавьте опциональные шлюзы для Финансов и Юридического/Комплаенса. Только утверждённые лица могут переводить Scheduled → Running. Если поддерживаются оверрайды (например, срочный откат), записывайте, кто сделал оверрайд, почему и когда в журнале аудита.

Что означает «Stop» операционно

Когда эксперимент Stopped, определите два явных поведения:

- Freeze assignments: прекращать назначать новых пользователей; закреплять существующих на их последнем варианте.

- Serving policy: либо продолжать показывать последнюю увиденную цену (стабильность для клиента), либо возвращаться к baseline (быстрый откат).

Сделайте это обязательным выбором при остановке, чтобы команда не могла остановить тест без понимания влияния на клиентов.

Назначение вариантов и распределение трафика

Корректное назначение — разница между надёжным тестом и шумом. Приложение должно упростить определение «кому» показывать цену и обеспечить консистентное повторное показание.

Согласованное назначение (правило «липкости»)

Клиент должен видеть один и тот же вариант между сессиями, устройствами (если возможно) и обновлениями страницы. Это значит, что назначение должно быть детерминированным: при тех же входных данных и эксперименте результат всегда один и тот же.

Распространённые подходы:

- Hash‑based assignment: вычислять хэш от

(experiment_id + assignment_key) и сопоставлять с вариантом.

- Stored assignment: записывать назначенный вариант в таблицу для последующего получения (полезно для аудита или сложных оверрайдов).

Многие команды используют hash‑based по умолчанию и сохраняют назначения только при необходимости (для поддержки или управления).

Выбор ключа назначения

Поддерживайте несколько ключей, потому что цена может быть на уровне пользователя или аккаунта:

- user_id: лучше для индивидуального ценообразования при надёжном логине.

- account_id / org_id: лучше для B2B, чтобы все в компании видели одну цену.

- анонимный cookie/device ID: полезно до логина, с явным правилом апгрейда в user_id после регистрации/логина.

Путь апгрейда важен: если пользователь сначала анонимно и затем создаёт аккаунт, решите, сохранять ли первоначальный вариант (непрерывность) или переназначать (чистота данных). Сделайте это явной настройкой.

Распределение трафика и постепенные выкаты

Поддерживайте гибкое распределение:

- 50/50 для простых A/B

- Взвешенные сплиты (например, 90/10) для контроля риска

- Планы раппа (например, 1% → 5% → 25% → 50%) с датами/временем

При увеличении охвата сохраняйте липкость: добавление трафика должно подключать новых пользователей, а не перетасовывать уже назначенных.

Граничные случаи, которые нужно обработать

Одновременные тесты могут конфликтовать. Сделайте защиту для:

- Взаимоисключающих групп (только один ценовой эксперимент на пользователя/аккаунт)

- Правил приоритета (если два эксперимента таргетируют одного клиента, кто выигрывает?)

- Исключений (внутренний персонал, тест‑аккаунты, регионы, контракты)

Экран «Предпросмотр назначения» (на примере пользователя/аккаунта) помогает нетехническим командам проверить правила перед запуском.

Безопасная интеграция цен в продукт

Большинство провалов тестов цен происходит на уровне интеграции — не потому что логика эксперимента неверна, а потому что продукт показывает одну цену, а списывает другую. В веб‑приложении должно быть явно, как «какая цена» определяется и как продукт её использует.

Разделяйте определение цены и доставку цены

Считайте определение цены источником правды (правила варианта, даты действия, валюта, налоги и т.д.). Рассматривайте доставку цены как механизм получения выбранной цены через API или SDK.

Такое разделение позволяет не техническим командам редактировать определения, а инженерам интегрировать стабильный контракт доставки типа GET /pricing?sku=....

Решите, где считается цена

Два распространённых паттерна:

- Серверная расчётная сумма в чекауте (рекомендовано для списания): вычислять итоговую сумму на сервере, чтобы избежать несоответствий и подделок.

- Клиентская для отображения: допустима для оценки цены, но итог при покупке должен подтверждаться/пересчитываться на сервере.

Практический подход: «отображаем на клиенте, подтверждаем и считаем на сервере», используя то же назначение эксперимента.

Строго относитесь к валютам, налогам и округлениям

Варианты должны следовать одинаковым правилам для:

- выбора валюты (локаль пользователя vs страна биллинга)

- включения налогов (НДС включён vs добавлен сверху)

- правил округления (за товар vs за счёт)

Храните эти правила рядом с ценой, чтобы каждый вариант был сопоставим и удобен для финансовой отчётности.

Планируйте безопасные падения

Если сервис экспериментов медленный или упал, продукт должен вернуть безопасную дефолт‑цену (обычно текущий baseline). Задайте таймауты, кэширование и чёткую политику «fail closed», чтобы чекаут не ломался — и логируйте фолбэки, чтобы измерить их влияние.

Метрики, события и основы атрибуции

Эксперименты по ценам живут и умирают от измерений. Веб‑приложение должно затруднять «выпустили и надеялись», требуя чётких метрик успеха, чистых событий и согласованной атрибуции до старта эксперимента.

Выберите первичные метрики (метрика решения)

Начните с одной–двух метрик, по которым будете принимать решение. Часто в ценообразовании это:

- Конверсия (например, посетитель → чекаут, триал → платный)

- Доход на посетителя (RPV) (учитывает цену и конверсию вместе)

- ARPA/ARPU (полезно для подписочных пакетов)

- Отток / удержание (если измеримо в разумном окне)

Правило: если команды спорят о результате после теста — значит, вы недостаточно явно определили метрику решения.

Добавьте защитные метрики (чтобы не сломать бизнес)

Защитные метрики ловят ущерб, который может причинить более высокая цена, даже если краткосрочный доход вырос:

- Уровень возвратов и chargeback'ов

- Тикеты в поддержку (по биллингу, путанице, жалобам)

- Ошибки платежей (отклонения карт, 3DS проблемы)

- Падение триал→платного

Приложение может внедрять guardrails, требуя порогов (например, «refund rate не должен вырасти более чем на 0.3%») и подчёркивать превышения на странице эксперимента.

Определите схему событий, которой можно доверять

Минимум: трекинг должен включать стабильные идентификаторы эксперимента и варианта на каждом релевантном событии.

{

Сделайте эти свойства обязательными на этапе инжестирования, а не «желательно». Если событие приходит без experiment_id/variant_id, направляйте его в «unattributed» корзину и помечайте проблему качества данных.

Выберите окна атрибуции (и обработайте отложенные результаты)

Исходы по цене часто задержаны (реневалы, апгрейды, отток). Определите:

- Окно атрибуции: например, «учитывать покупки в течение 7 дней с момента первой экспозиции»

- Правило экспозиции: первая экспозиция vs последняя (для цен чаще безопаснее первая)

- Отложенные метрики: показывайте «предварительный» результат быстро, но храните «финальный», который обновится, когда окно закроется

Это выравнивает ожидания команд относительно того, когда результат становится надёжным, и предотвращает преждевременные решения.

UX и экраны для нетехнических команд

Инструмент для экспериментов по ценам работает только если PM, маркетинг и финансы могут им управлять без каждого раза звать инженера. UI должен быстро отвечать на три вопроса: Что запущено? Что поменяется для клиентов? Что произошло и почему?

Ключевые экраны

Список экспериментов должен ощущаться как операционный дашборд. Показывайте: имя, статус (Draft/Scheduled/Running/Paused/Ended), даты, сплит трафика, первичную метрику и владельца. Добавьте видимый «последнее обновление кем» и временную метку.

Детали эксперимента — домашняя страница. Компактная сводка вверху (статус, даты, аудитория, сплит, первичная метрика). Ниже — вкладки: Variants, Targeting, Metrics, Change log, Results.

Редактор варианта должен быть простым и прагматичным. В каждой строке варианта показывайте цену (или правило цены), валюту, период биллинга и простое описание («Annual: $120 → $108»). Заставляйте подтверждать изменения живых вариантов.

Просмотр результатов должен начинаться с решения, а не только графиков: «Вариант B повысил конверсию чекаута на 2.1% (95% CI …)». Затем — подробности и фильтры для дрила.

Дизайн для ясности (и уверенности)

Используйте согласованные бейджи статусов и показывайте таймлайн ключевых дат. Отображайте сплит трафика как процент и в виде маленькой шкалы. Включите панель «Кто что менял» с правками вариантов, таргетинга и метрик.

Защитные проверки и валидация

Перед разрешением Start требуйте: минимум одна первичная метрика, как минимум два варианта с валидными ценами, определённый план раппа (опционально) и план отката/фолбэк‑цена. Если чего‑то нет — показывайте понятные ошибки («Добавьте первичную метрику, чтобы включить результаты»).

Быстрые действия, экономящие время

Добавьте безопасные, заметные действия: Pause, Stop, Ramp up (например, 10% → 25% → 50%) и Duplicate (копировать настройки в новый Draft). Для рискованных операций используйте подтверждения с кратким описанием воздействия («Пауза замораживает назначения и останавливает экспозицию»).

Быстрое создание прототипа внутреннего инструмента

Если хотите проверить рабочие процессы (Draft → Scheduled → Running) до полной разработки, платформы vibe‑coding вроде Koder.ai помогут быстро поднять внутреннее веб‑приложение из спецификации в чат — затем итеративно дорабатывать с роль‑базированными экранами, журналами аудита и простыми дашбордами. Это удобно для ранних прототипов, когда нужен рабочий React‑UI и бэкенд на Go/PostgreSQL, который затем можно экспортировать и упрочнить.

Дашборды и отчётность, ведущие к решению

Дашборд эксперимента по ценам должен быстро отвечать на вопрос: «Оставляем цену, откатываем или продолжаем изучать?» Лучший отчёт не самый навороченный — а самый надёжный и понятный.

Что положить «above the fold»

Начните с пары трендовых графиков, которые обновляются автоматически:

- Конверсия во времени (с маркером «эксперимент стартовал»)

- Доход на посетителя (или средний чек)

- Возвраты/отказы, если цена влияет на удержание

Под графиками — таблица сравнения вариантов: имя варианта, доля трафика, посетители, покупки, конверсия, доход на посетителя и дельта относительно контроля.

Для индикаторов доверия избегайте академического языка. Используйте простые подписи:

- «Раннее чтение» (недостаточно данных)

- «Наклон в лучшую/худшую сторону» (направленное)\

- «Высокая уверенность» (готово к решению)

Короткая подсказка объяснит, что доверие растёт с объёмом выборки и временем.

Разрезы по сегментам, которые предотвращают плохие выкаты

Цена часто «выигрывает» в целом, но терпит поражение в ключевых группах. Сделайте переключение сегментов простым:

- Новые vs возвращающиеся

- Регион (страна/штат)

- Устройство (мобильный/десктоп)

- Тариф (или категория продукта)

Сохраняйте одинаковые метрики везде, чтобы сравнение было корректным.

Предупреждения об аномалиях, на которые можно отреагировать

Добавьте лёгкие алерты прямо на дашборд:

- Внезапное падение конверсии после изменения цены

- Всплеск дохода, вызванный багом трекинга или одноразовым событием

- Пробелы в данных (события прекратили поступать, низкий трафик, задержки инжеста)

При появлении алерта покажите подозреваемый интервал и ссылку на сырые события.

Экспорт и шаринг для быстрой синхронизации

Сделайте отчёты портируемыми: CSV‑скачивание текущего вида (включая сегменты) и шаримая внутренняя ссылка на отчёт эксперимента. При необходимости дайте ссылку на краткое объяснение /blog/metric-guide, чтобы стейкхолдеры понимали, что видят, без новой встречи.

Права доступа, журналы аудита и управление

Эксперименты по ценам касаются доходов, доверия клиентов и часто регламентированной отчётности. Простая модель прав и прозрачный аудит уменьшают случайные запуски, споры «кто что изменил?» и помогают выпускать быстрее с меньшим количеством откатов.

Роли, соответствующие реальной работе команд

Делайте роли простыми:

- Viewer: только чтение конфигурации эксперимента, статуса и отчётов.

- Editor: может создавать draft‑эксперименты (варианты, текст, правила), но не может запускать/останавливать или менять сплит в проде.

- Approver: может просмотреть и утвердить draft, выполнять продовые действия (start/stop/ramp) в пределах защитных правил.

- Admin: управляет ролями, глобальными настройками и аварийными контролями.

Если у вас несколько продуктов или регионов, ограничьте роли по рабочей области (например, «EU Pricing»), чтобы редактор в одной области не влиял на другую.

Надёжные журналы аудита

Логируйте каждое изменение с кто, что, когда, лучше с diff до/после. Минимум фиксируйте:

- Определения вариантов (цена, валюта, период), распределения трафика, старт/стоп и правила таргетинга.

- Действия утверждений (запрошено, одобрено, отклонено) и откаты.

- Изменения источников данных (какой поток дохода/событий используется).

Сделайте логи доступными для поиска и экспорта (CSV/JSON) и свяжите их со страницей эксперимента — ревьюерам не придётся ничего искать. Отдельный вид /audit-log полезен для команд комплаенса.

Защита чувствительной информации

Обращайтесь с идентификаторами клиентов и доходами как с чувствительными по умолчанию:

- Маскируйте сырые идентификаторы (хэширование, токенизация) и ограничивайте доступ к разбивкам по доходам.

- Ограничивайте правила сегментации, которые могут раскрыть защищённые атрибуты.

- Храните секреты (API‑ключи, креды в хранилище данных) вне основной БД.

Комментарии и заметки о решении

Добавьте лёгкие заметки к каждому эксперименту: гипотеза, ожидаемое влияние, обоснование одобрения и «почему остановили» после завершения. Через полгода эти заметки предотвращают повторный запуск провальных идей и делают отчётность гораздо убедительнее.

Тестирование и проверки качества перед запуском

Эксперименты по ценам ломаются тонко: сплит 50/50 смещается в 62/38, одна когорта видит неправильную валюту или события не попадают в отчёт. Перед тем как реальные клиенты увидят цену, относитесь к системе экспериментов как к фиче платежей — проверьте поведение, данные и отказоустойчивость.

Согласованность назначения и точность сплитов

Начните с детерминированных тестов, чтобы доказать стабильность логики назначения между сервисами и релизами. Используйте фиксированные входы (customer IDs, ключ эксперимента, salt) и утверждайте, что вариант возвращается одинаково.

customer_id=123, experiment=pro_annual_price_v2 -> variant=B

customer_id=124, experiment=pro_annual_price_v2 -> variant=A

Затем протестируйте распределение в масштабе: сгенерируйте, например, 1M синтетических customer_id и проверьте, что наблюдаемый сплит лежит в узкой допуске (например, 50% ± 0.5%). Также проверьте граничные случаи: лимиты трафика (только 10% вовлечены) и холдауны.

Проверка сбора событий end‑to‑end

Не останавливайтесь на «событие вызвано». Автоматизируйте поток: создайте тестовое назначение, сгенерируйте покупку или событие чекаута и проверьте:

- событие принято коллектором

- событие сохранено с правильными полями experiment/variant

- оно появляется в отчётном запросе с верными временными метками и дедупом

Запускайте это в стейджинге и в проде с тестовым экспериментом, ограниченным внутренними пользователями.

QA‑инструменты для нетехнических проверок

Дайте QA и PM простой «preview» инструмент: введите customer ID (или session ID) и увидьте назначенный вариант и точную цену, которая бы отобразилась. Это ловит рассинхроны по округлению, валюте, налогам и «не тому плану» до запуска.

Рассмотрите безопасный внутренний маршрут типа /experiments/preview, который никогда не меняет реальные назначения.

Симуляция отказов и неверных конфигураций

Отрепетируйте плохие сценарии:

- Пайплайн событий упал: UI доступен; на дашборде баннер «неполные данные».

- Сервис экспериментов недоступен: продукт переходит к baseline‑цене (и логирует фолбэк).

- Неправильная конфигурация (перекрывающиеся эксперименты, невалидная цена): блокируйте публикацию с понятной валидацией.

Если вы не можете уверенно ответить «что произойдёт, когда X сломается?», вы не готовы к релизу.

План запуска, мониторинга и итераций

Запуск менеджера экспериментов по ценам — это не только «поставить экран», но и убедиться, что вы можете контролировать радиус поражения, быстро наблюдать поведение и безопасно восстанавливаться.

Подход к деплою: снижаем риск в день релиза

Начните со стратегии, соответствующей вашей уверенности и продуктовым ограничениям:

- Постепенный выкатыв: включайте эксперименты для небольшой доли трафика, затем расширяйте (1% → 10% → 50%).

- Feature flag: зажмите систему экспериментов за флагом, чтобы можно было выключить без деплоя. Полезно в период стабилизации интеграций.

- Внутренний бета: ограничьте эксперименты сотрудниками или тест‑аккаунтами для валидации назначения, рендера цен и чекаута до показа реальным клиентам.

Мониторинг: что смотреть в первые часы

Считайте мониторинг требованием релиза, а не «полезной функцией». Настройте алерты для:

- Ошибок: сбои API, ошибки чекаута, исключения сервиса цен.

- Латентности: p95/p99 для получения цены, назначения и загрузки страницы чекаута.

- Объёма событий: резкие падения или всплески ключевых событий (view price, add to cart, purchase).

- Потери атрибуции: покупки без experiment/variant ID или variant_id, не совпадающие с логом назначений.

Runbooks: быстрый пауз и откат

Напишите пошаговые инструкции для операций и on‑call:

- Глобальная аварийная кнопка для паузы всех экспериментов.

- Путь отката к baseline‑ценам (кэшированные baseline‑цены, безопасные дефолты).

- Ясное распределение ответственности: кто утверждает паузу, кто коммуницирует и как фиксируется инцидент.

Итерации после MVP

После стабилизации базового workflow приоритетными станут улучшения, которые дают лучшие решения: дополнительные правила таргетинга (гео, тариф, тип клиента), усиленные статистики и защитные механизмы, интеграции (DWH, биллинг, CRM). Если у вас разные тарифы или упаковки, подумайте об отражении возможностей экспериментов на /pricing, чтобы команды понимали поддерживаемые сценарии.