Определите проблему: расходы, использование и кто ждёт ответов

Прежде чем строить экраны или пайплайны, конкретизируйте вопросы, на которые приложение должно отвечать. «Облачные расходы» могут означать итог по счёту, месячные траты команды, unit-экономику отдельного сервиса или стоимость фичи для клиента. Если вы не определите проблему заранее, получите эффектные дашборды, которые не решают споров.

Полезная точка зрения: ваша первая доставляемая вещь — не «дашборд», а общее определение правды (что означают числа, как они считаются и кто отвечает за действия по ним).

Кто будет пользоваться приложением?

Начните с перечисления основных пользователей и что им нужно решать:

- Finance / FinOps: закрыть месяц, объяснить отклонения, задать политики и обеспечивать ответственность по бюджетам.

- Инженеры: находить траты-«воду», сравнивать окружения (prod vs dev) и связывать расход с деплоем или сервисом.

- Тимлиды / продукт-овнеры: понять свой «счёт», обосновать инвестиции и планировать ёмкость.

- Руководство (обычно только просмотр): видимость трендов и сигналы риска.

Разные пользователи требуют разного уровня детализации. Финансы могут хотеть стабильные, аудируемые месячные числа; инженеры — дневную детализацию и подробный drill-down.

Определяйте результаты (а не фичи)

Будьте явными в том, что вы доставляете в первую очередь:

- Showback: видимость по команде/сервису без внутреннего биллинга.

- Chargeback: внутренние начисления и распределения, которые попадают на бюджеты.

- Прогнозирование: ожидаемые расходы к концу месяца и сценарное планирование.

- Контроль бюджета: бюджеты, пороговые уведомления и потоки утверждений.

Практический подход для сдерживания объёма — выбрать один «приоритетный результат» и считать остальные как последующие. Большинство команд стартуют с showback и базового обнаружения аномалий, затем переходят к chargeback.

Определите облачный охват

Перечислите облака и биллинговые сущности, которые нужно поддерживать в «день 1»: AWS payer account, подписки и management groups в Azure, billing accounts/projects в GCP, а также общие shared services (логирование, сеть, безопасность). Решите, будете ли вы включать маркетплейс-чаржи и сторонние SaaS-расходы.

Частота обновлений и хранение

Выберите целевой цикл обновления: ежедневно достаточно для финансов и большинства команд; near-real-time помогает при инцидентах и в быстрых организациях, но повышает сложность и стоимость. Также задайте срок хранения (например, 13–24 месяца) и нужно ли вам неизменяемые снимки «month-close» для аудита.

Решите, что измерять: модель данных и ключевые измерения

Прежде чем импортировать CSV или вызывать биллинговое API, решите, как выглядит «правда» в вашем приложении. Чёткая модель измерений предотвращает бесконечные споры («почему это не совпадает с инвойсом?») и делает мультиоблачную отчётность предсказуемой.

Начните с обязательных метрик

Как минимум, рассматривайте каждую строку биллинга как запись с согласованным набором измерений:

- Стоимость: до налогов, эффективная стоимость (после скидок) и выставленная сумма (итог по счёту).

- Использование: количество + единица (часы, GB-месяц, запросы). Держите единицу как данные, а не как текст UI.

- Кредиты и скидки: резервы, промокредиты, корпоративные скидки.

- Возвраты и корректировки: отрицательные строки — полноценные сущности.

- Налоги и сборы: часто идут отдельно; моделируйте их явно для сверки с финансами.

Практическое правило: если значение может изменить, что платит финансы или что начисляют команде, оно заслуживает отдельной метрики.

Определите основные измерения (поля для группировки)

Измерения делают расходы исследуемыми и распределяемыми. Общие:\n

- Account / subscription / billing entity

- Project / application

- Team / cost center / owner

- Environment (prod, staging, dev)

- Service / SKU / meter

- Region / zone

Держите измерения гибкими: позже вы добавите ещё (например, «cluster», «namespace», «vendor").

Выберите временные ключи для отчётности

Обычно нужно несколько временных понятий:

- Период инвойса (для сверки с финансами)

- День (для трендов и обнаружения аномалий)

- Месяц (для отчетности руководству и бюджетов)

«Allocated» vs «unallocated» должно быть однозначным

Зафиксируйте строгие определения:

- Allocated cost: стоимость, назначенная владельцу/команде через теги или правила распределения.

- Unallocated cost: стоимость с отсутствующим/некорректным владельцем, которая должна оставаться видимой (не отбрасываться молча).

Это одно определение будет формировать дашборды, оповещения и доверие к числам.

Сбор биллинга: экспорты, API и поток инжеста

Инжест биллинга — фундамент приложения: если исходные данные неполные или трудно воспроизвести, каждый дашборд и правило распределения превращаются в предмет спора.

Планируйте коннекторы (и примите их различия)

Начните с поддержки «нативной правды» для каждого облака:

- AWS: Cost and Usage Report (CUR) в S3 (обычно почасово или ежедневно), плюс опциональные API для метаданных.

- Azure: Cost Management exports в Storage Account (как правило ежедневно), с разными endpoint-ами для разных scope (subscription, management group).

- GCP: Billing export в BigQuery (удобнее всего), либо файлы экспорта, если предпочитаете file-based pipeline.

Проектируйте каждый коннектор так, чтобы он выдавал одинаковые основные выходы: набор сырых файлов/строк и журнал инжеста (что и когда было получено и сколько записей).

Pull vs push инжест

Часто выбирают один из двух паттернов:

- Pull (плановый импорт): приложение опрашивает S3/Blob/BigQuery по расписанию. Проще для ретраев и отладки, но может быть медленнее.

- Push (event-driven): события хранения (например, «new object created") запускают инжест. Быстрее и дешевле в масштабе, но требует аккуратной дедупликации, так как события могут приходить дважды.

Многие команды используют гибрид: push для свежести и ежедневный pull-свипер для пропущенных файлов.

Время, валюта и границы биллинга

Инжест должен сохранять оригинальную валюту, часовой пояс и семантику периода биллинга. Пока не «чините» данные — захватите то, что говорит провайдер, и храните начало/конец провайдерского периода, чтобы поздние корректировки попадали в нужный месяц.

Держите неизменяемую staging-зону

Сохраняйте сырые экспорты в неизменяемом, версионируемом staging bucket/container/dataset. Это даёт аудитабилити, позволяет перепроцессить при смене парсинга и делает споры разрешимыми: можно указать точный исходный файл, породивший число.

Нормализация и валидация: сделать разные облака сопоставимыми

Если вы будете хранить AWS CUR, Azure экспорты и GCP биллинг «как есть», интерфейс будет выглядеть несогласованно: одно и то же называется «service» в одном месте, «meter» — в другом, «SKU" в третьем. Нормализация — это превращение провайдер-специфичных терминов в предсказуемую схему, чтобы каждый график, фильтр и правило работали одинаково.

Проектируйте единый schema

Начните с сопоставления полей провайдеров в общий набор измерений, на которые можно опираться везде:

- Service (например «Compute», «Object Storage")

- SKU (биллабельный элемент, часто самый детализированный идентификатор)

- Usage type (часы, GB-месяц, запросы и т.д.)

Сохраняйте нативные идентификаторы провайдеров (например AWS ProductCode или GCP SKU ID), чтобы можно было отследить до исходной записи при споре.

Устраняйте общие проблемы с данными

Нормализация — это не только переименование колонок, но и «гигиена» данных.

Обрабатывайте пропущенные или испорченные теги, разделяя «unknown» и «unallocated», чтобы не скрывать проблемы. Дедуплицируйте строки по стабильному ключу (ID строки + дата + стоимость) чтобы избегать двойного счёта при ретраях. Следите за частичными днями (особенно рядом с «сегодня») и помечайте их как provisional, чтобы дашборды не скакали неожиданно.

Отслеживайте lineage и версии

Каждая нормализованная строка должна нести метаданные lineage: исходный файл/экспорт, время импорта и версия трансформации (например norm_v3). При изменении правил маппинга вы сможете перепроцессить данные уверенно и объяснить разницы.

Валидируйте и публикуйте сводки для пользователей

Соберите автоматические проверки: суммы по дню, правила с отрицательной стоимостью, согласованность валют и «стоимость по account/subscription/project». Потом публикуйте в UI сводку импорта: сколько строк импортировано, сколько отклонено, временное покрытие и дельта против итогов провайдера. Доверие растёт, когда пользователи видят не только число, но и что произошло с данными.

Теги и владение: превращаем сырые расходы в подотчётные

Данные о затратах полезны, когда есть однозначный ответ на вопрос «кто это владеет?». Теги (AWS), labels (GCP) и resource tags (Azure) — самый простой способ связать расходы с командами, приложениями и окружениями, но только если относиться к ним как к продуктовым данным, а не к «постарайтесь, если получится».

Задайте правила: обязательные ключи и допустимые значения

Опубликуйте небольшой набор обязательных ключей, на которые будет опираться движок распределения и дашборды:

teamappcost-centerenv (prod/stage/dev)

Сделайте правила явными: какие ресурсы обязаны иметь теги, какие форматы допустимы (например, lowercase kebab-case) и что происходит при отсутствии тега (например бакет «Unassigned" + оповещение). Держите политику видимой в приложении и ссылку на подробные рекомендации, например /blog/tagging-best-practices.

Сделайте UI для маппинга «грязной» реальности

Даже при политике будет дрейф: TeamA, team-a, team_a или переименование команды. Добавьте лёгкий слой «маппинга», чтобы финансы и владельцы платформы могли нормализовать значения без переписывания истории:

- Маппинг множества raw-значений в одно каноническое (например

TeamA, team-a → team-a)

- Поддержка временных маппингов (старое имя действительно до cutover-даты)

- Запись, кто и зачем сделал изменение (заметки аудита)

Этот UI маппинга также место для обогащения тегов: если app=checkout есть, а cost-center отсутствует, его можно вывести из реестра приложений.

Обрабатывайте исключения, не ломая ответственность

Некоторые затраты сложно промаркировать напрямую:

- Shared resources (Kubernetes-кластеры, shared VPC, NAT gateways)

- Платформенные расходы (CI, наблюдаемость, внутренние инструменты)

- Инструменты безопасности (централизованные сканеры, SIEM)

Моделируйте их как принадлежащие «shared services" с явными правилами распределения (по headcount, метрикам использования или пропорционально расходу). Цель — не идеальная атрибуция, а последовательная ответственность, чтобы каждый доллар имел «дом» и человека, который может его объяснить.

Движок распределения: правила, сплиты и стратегии раздела общих расходов

Движок распределения превращает нормализованные строки биллинга в ответ на вопрос «кто владеет этой стоимостью и почему». Цель — не только математика, а выдача результатов, которые стейкхолдеры могут понять, оспорить и улучшить.

Основные методы распределения

Большинству команд нужен микс подходов, потому что не все расходы приходят с чистым владельцем:

- Прямые теги/лейблы: если строка уже имеет тег владельца — назначаем напрямую.

- Сплит по драйверам использования: распределяем shared services по измеряемому потреблению (CPU-часы, GB хранения, запросы, объём логов, node-hours).

- Фиксированные проценты: удобно для стабильных соглашений (например платформа покрывает 30% сетевых расходов), но это нужно регулярно пересматривать.

Правила как политика

Моделируйте правила распределения как упорядоченные по приоритету с датами вхождения в силу. Так можно ответить: «Какое правило применялось 10 марта?» и безопасно обновлять политику без переписывания истории.

Практическая схема правила часто включает:

- Условия совпадения (облако, account/subscription, сервис, SKU, наличие тега, проект, регион)

- Цель распределения (team/product/environment)

- Метод распределения (direct, usage-based, percent)

- Окно действия (start/end date) и приоритет

Работа с общими расходами (сложная часть)

Общие расходы — кластеры Kubernetes, сеть, data platforms — редко маппятся 1:1 на одну команду. Сначала рассматривайте их как «пулы», затем распределяйте.

Примеры:

- Kubernetes: объеденить расходы по кластеру, затем распределить по namespace по использованию (pod CPU/memory requests или реальное использование).

- Сеть: распределять NAT gateways и egress по байтам, переданным по VPC/project.

- Data platform: распределять склады/стримы по времени запросов, кредитам или обработанным GB.

Делайте результаты объяснимыми

Предоставляйте виды до/после: исходные строки провайдера vs распределённые результаты по владельцам. Для каждой распределённой строки храните «объяснение" (rule ID, поля совпадения, значения драйвера, процент сплита). Такой аудиторный след уменьшает споры и повышает доверие — особенно при chargeback/showback.

Хранение и производительность: таблицы в хранилище, которые остаются быстрыми

Экспорты облачных биллингов быстро растут: строки по ресурсам, по часам, по множеству аккаунтов и провайдеров. Если приложение тормозит, пользователи перестанут ему доверять — поэтому дизайн хранения это и есть дизайн продукта.

Выбирайте warehouse + OLAP-дружественные представления

Типичная схема: реляционный warehouse для правды и простых джойнов (Postgres для небольших установок; BigQuery или Snowflake при росте объёмов), плюс OLAP-представления/материализации для аналитики.

Храните сырые строки биллинга ровно как получены (плюс поля инжеста: время импорта, исходный файл). Затем стройте кураторные таблицы для запросов приложения. Это отделяет «что мы получили» от «как мы отчётируемся», что делает аудиты и перепроцессы безопаснее.

Если вы строите это с нуля, подумайте об ускорении первой итерации через платформу, которая быстро создаст каркас. Например, Koder.ai (vibe-coding платформа) может помочь сгенерировать рабочее веб-приложение через чат — обычно с React-фронтендом, Go-бэкендом и PostgreSQL — чтобы вы могли тратить время на валидацию модели данных и логики распределения (те части, которые определяют доверие), а не на повторное написание boilerplate.

Партиционируйте под вопросы, которые люди задают

Большинство запросов фильтруют по времени и границам (account/subscription/project). Партиционируйте и индексируйте соответственно:

- Партиционировать по дате использования (ежедневные партиции хорошо подходят для биллинга)

- Кластер/индекс по account и провайдеру

- Держите поля с высокой кардинальностью (resource IDs) вне основных путей дашборда

Это позволяет «последние 30 дней для Team A» оставаться быстрым, даже если вся история огромна.

Предагрегируйте для дашбордов

Дашборды не должны сканировать сырые строки. Создавайте агрегированные таблицы на тех сечениях, которые исследуют пользователи:

- Дневные затраты по команде, сервису и окружению

- Дневное использование по сервису/SKU там, где это важно

- Месячные сводки для финансов

Материализуйте эти таблицы по расписанию (или инкрементально), чтобы графики грузились за секунды.

Планируйте backfills и перерасчёт

Правила распределения, маппинги тегов и определения владельцев будут меняться. Проектируйте систему для перерасчёта истории:

- Версионируйте выходы распределения (ID набора правил + время запуска)

- Поддерживайте таргетные backfills (определённые диапазоны дат/аккаунты)

- Храните raw + curated данные неизменяемыми, чтобы можно было перезапустить без потери provenance

Эта гибкость превращает дашборд затрат в систему, которой люди могут доверять.

UX и дашборды: делайте затраты простыми для исследования и объяснения

Приложение для распределения затрат успешно, когда люди за секунды отвечают на вопросы: «Почему выросли траты?», «Кто владеет этой строкой?» и «Что мы можем сделать?». UI должен рассказывать понятную историю от общих сумм до деталей, не заставляя пользователей разбираться в биллинговом жаргоне.

Основные страницы, которые действительно нужны пользователям

Начните с небольшого набора предсказуемых видов:

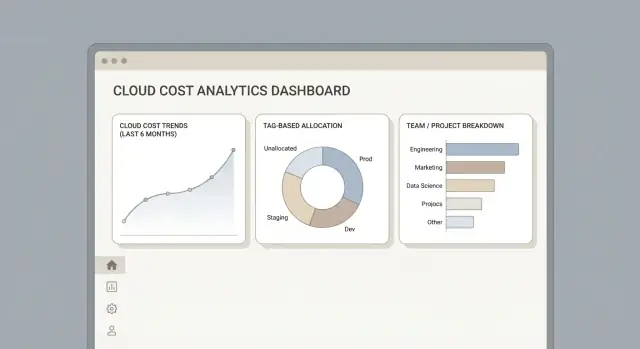

- Overview: общие траты, тренд vs предыдущий период, топ драйверов затрат и панель «что изменилось».

- Team view: расходы по владельцу (team/cost center), включая распределённые и нераспределённые элементы.

- Service breakdown: траты по продуктам облака (например compute, storage) с возможностью поворота по региону или аккаунту/subscription.

- Anomalies: приоритетный список необычных всплесков с простыми объяснениями и ссылками на исходные строки.

Последовательные фильтры и стабильная модель мышления

Используйте одну и ту же панель фильтров везде: диапазон дат, облако, команда, проект и окружение (prod/stage/dev). Делайте поведение фильтров последовательным (одни и те же дефолты, «применяется ко всем графикам») и показывайте активные фильтры, чтобы скриншоты и ссылки были самодостаточными.

Drill-down без «dead ends"

Спроектируйте преднамеренный путь:

Итог счёта → распределённый итог → сервис/категория → account/project → SKU/строки биллинга.

На каждом шаге показывайте «почему» рядом с числом: применённые правила распределения, использованные теги и допущения. При выборе строки давайте быстрые действия: «просмотреть маппинг владельца» (ссылка на /settings/ownership) или «сообщить о пропущенных тегах» (ссылка на /governance/tagging).

Экспорт и шаринг с учётом прав

Добавьте CSV-экспорт из любой таблицы и поддержите shareable links, которые сохраняют фильтры. Обращайтесь с ссылками как с отчётами: они должны уважать ролевой доступ, иметь аудиторный след и опционально истекать. Это упрощает сотрудничество и сохраняет контроль над чувствительными данными о тратах.

Бюджеты, оповещения и аномалии: заставьте систему приводить к действиям

Дашборды объясняют, что произошло. Бюджеты и оповещения меняют поведение.

Если приложение не может сказать команде «вы вот-вот превысите месячный бюджет» (и уведомить нужного человека), оно останется просто инструментом отчётности, а не операционным.

Бюджеты, которыми можно владеть

Начните с бюджетов на том же уровне, что и распределение затрат: команда, проект, окружение или продукт. Каждый бюджет должен иметь:

- Чёткого владельца (человек или on-call ротация) и опциональных наблюдателей

- Период (месячный проще всего; можно добавить недельные для быстро движущихся команд)

- Пороги (например 50/80/100% бюджета) с разной срочностью уведомлений

- Правила охвата, согласованные с вашей моделью распределения (теги, аккаунты/subscriptions, cost centers)

Держите UI простым: один экран для установки суммы + охвата + владельца и превью «прошлый месяц в этом scope» для проверки здравого смысла.

Оповещения, которые больше, чем «траты высоки»

Бюджеты ловят медленный дрейф, но командам нужны немедленные сигналы:

- Всплески расходов (сегодня vs недавнее среднее)

- Пропущенные теги (новые ресурсы без нужных меток)

- Необычные изменения использования (например egress удвоился, CPU-часы подскочили)

Делайте оповещения действенными: включайте топовые драйверы (сервис, регион, проект), краткое объяснение и ссылку в explorer (например /costs?scope=team-a&window=7d).

Простейшая логика аномалий до ML

Прежде чем внедрять ML, реализуйте базовые сравнения, которые просто отлаживать:

- Выберите baseline окно (например trailing 14 days excluding last 1 day)

- Сравните текущее окно (например последние 24ч) с baseline mean/median

- Триггерьте при одновременном превышении относительного изменения (например +60%) и абсолютного дельта (например +$200)

Это уменьшает шум по крошечным категориям трат.

Замыкание цикла: логируйте результаты

Храните каждое событие оповещения со статусом: acknowledged, muted, false positive, fixed или expected. Отслеживайте кто действовал и сколько времени заняло решение.

Со временем используйте эту историю, чтобы уменьшать шум: авто-подавление повторяющихся оповещений, улучшение порогов по scope и выявление команд с «всегда не промаркированными» ресурсами, которым нужны workflow-исправления, а не ещё больше уведомлений.

Безопасность, доступ и аудит

Данные о затратах чувствительны: они могут раскрыть прайсинг вендоров, внутренние проекты и даже обязательства перед клиентами. Обращайтесь с приложением как с финансовой системой — потому что для многих оно ею и является.

Роли и права, соответствующие реальным процессам

Начните с небольшого набора ролей и делайте их понятными:

- Admin: управляет коннекторами облаков, глобальными настройками и доступом.

- Finance: может править правила распределения и утверждать экспорты chargeback/showback.

- Team lead: видит расходы своей команды, управляет тегами/владением на уровне команды и предлагает изменения правил.

- Viewer: только чтение дашбордов и drill-down.

Применяйте права на уровне API (не только UI) и добавьте скопирование по ресурсам (например тимлид не должен видеть проекты других команд).

Безопасные коннекторы и ротация секретов

Экспорт биллинга и API требуют кредов. Храните секреты в dedicated secret manager (или зашифрованными at rest с KMS), никогда — в открытом виде в полях БД. Поддерживайте безопасную ротацию, позволяя несколько активных кредов на коннектор с «effective date», чтобы инжест не падал при смене ключей.

Практичные UI-детали помогают: показывайте время последней успешной синхронизации, предупреждения об объёме прав и понятный поток «re-authenticate».

Надёжные audit logs

Добавьте append-only аудитные логи для:

- изменений правил распределения (до/после, кто, когда)

- импортов/экспортов и скачанных отчётов

- изменений коннекторов и обновлений кредов

Делайте логи поисковыми и экспортируемыми (CSV/JSON) и связывайте каждую запись лога с затронутым объектом.

Обращение с данными и сроки хранения в продукте

Документируйте retention и privacy-настройки в UI: как долго хранятся сырые файлы биллинга, когда агрегированные таблицы заменяют сырые данные и кто может удалять данные. Простая страница «Data Handling» (например /settings/data-handling) уменьшает число тикетов в поддержку и укрепляет доверие финансов и security-команд.

Интеграции и API: интегрируйтесь с инструментами, которыми люди уже пользуются

Приложение по затратам начинает менять поведение, когда появляется там, где люди уже работают. Интеграции снижают «отчётную нагрузку» и превращают данные о расходах в общий оперативный контекст — финансы, инженерия и руководство видят одни и те же числа в своих ежедневных инструментах.

Чат-уведомления (Slack / Microsoft Teams)

Начните с уведомлений — они стимулируют быстрые действия. Отправляйте короткие сообщения с владельцем, сервисом, дельтой и ссылкой обратно на точный вид в приложении (с фильтром по команде/проекту и временному окну).

Типичные оповещения:

- Достигнут порог бюджета (80%, 100%)

- Необычный всплеск расходов vs неделя назад

- Пропущенные теги на ресурсах с большой стоимостью

SSO и идентификация (Okta, Azure AD, Google Workspace)

Если доступ неудобен — люди не примут систему. Поддерживайте SAML/OIDC SSO и маппьте группы идентичности на «владельцев» затрат (команды, cost centers). Это упрощает offboarding и держит права в соответствии с орг-изменениями.

Внутренний Cost API (для порталов и автоматизации)

Предоставьте стабильное API, чтобы внутренние системы могли получать «cost by team/project» без скрейпинга UI.

Практический формат:

GET /api/v1/costs?team=payments&start=2025-12-01&end=2025-12-31&granularity=day- Включайте: allocated cost, unallocated cost, usage units и версию/ID набора правил, использованных при расчёте

Документируйте rate limits, caching headers и идемпотентность запросов, чтобы потребители могли строить надёжные пайплайны.

Webhooks для событий

Webhooks делают приложение реактивным. Генерируйте события типа budget.exceeded, import.failed, anomaly.detected и tags.missing для запуска рабочих процессов в других системах.

Частые назначения: создание тикетов в Jira/ServiceNow, инструменты инцидентов или кастомные runbooks.

BI-экспорты (Looker, Power BI, Tableau)

Некоторые команды настаивают на собственных дашбордах. Предлагайте управляемый экспорт (или read-only схему в хранилище), чтобы BI-отчёты использовали ту же логику распределения — а не переосмысляли формулы.

Если вы упакуете интеграции как аддоны, дайте ссылку на /pricing для деталей планов.

Тестирование, мониторинг и вывод в прод: сохраняйте доверие к числам

Приложение по затратам работает только если люди ему верят. Это доверие зарабатывается повторяемыми тестами, видимыми проверками качества данных и развёртыванием, позволяющим командам сравнить ваши числа с тем, что они уже знают.

Тестируйте на реальных биллинговых примерах (включая «грязные")

Постройте библиотеку экспортов и инвойсов провайдеров, представляющих типичные edge-case: кредиты, возвраты, налоги/VAT, сборы реселлеров, бесплатные уровни, скидки по обязательствам и поддержке. Храните версии этих примеров, чтобы пере-прогонять тесты при изменении парсинга или логики распределения.

Фокусируйтесь на исходах, а не только на парсинге:

- «Известный месяц», где можно предсказать суммы по сервисам/аккаунтам

- Изменения правил распределения (например 60/40), которые должны влиять только на конкретные выходы

- Поведение округления на дневных vs месячных уровнях

Тесты качества данных, сравнимые с итогами провайдера

Добавьте автоматические проверки, сверяющие ваши вычисленные итоги с итогами провайдера в допустимой толерантности (например из-за округлений или временных расхождений). Отслеживайте эти проверки во времени, чтобы ответить на вопрос «Когда начался дрейф?".

Полезные утверждения:

- Общая стоимость по периоду биллинга совпадает с инвойсом/экспортом

- Нет отрицательных стоимостей, если они явно не ожидаются (refunds/credits)

- Консистентность валюты и обработки курсов

Мониторинг: инжест, свежесть и здоровье запросов

Настройте оповещения об ошибках инжеста, stalled pipelines и порогах «данные не обновлялись с...» Следите за медленными запросами и временем загрузки дашбордов, логируйте, какие отчёты вызывают тяжёлые сканы, чтобы оптимизировать нужные таблицы.

План вывода: пилот, обучение и обратная связь

Проведите пилот с несколькими командами. Дайте им вид сопоставления с их существующими таблицами/спreadsheets, согласуйте определения, затем раскатывайте шире с коротким обучением и ясным каналом обратной связи. Публикуйте changelog (даже простой /blog/changelog), чтобы заинтересованные видели, что и зачем менялось.

Если вы быстро итеративно меняете требования во время пилота, инструменты вроде Koder.ai могут помочь прототипировать UI-потоки (фильтры, drill-down-пути, редакторы правил распределения) и генерировать рабочие версии по мере эволюции определений — при этом давая контроль над экспортом кода, деплоем и откатом по мере взросления приложения.