02 окт. 2025 г.·8 мин

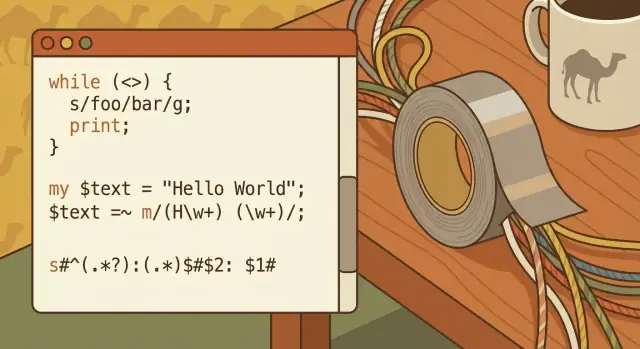

Ларри Уолл, Perl и менталитет «скотча» для работы с текстом

Как философия «скотча» Ларри Уолла сделала Perl рабочей лошадкой веб‑автоматизации — и чему это учит о практической обработке текста сегодня.

Как философия «скотча» Ларри Уолла сделала Perl рабочей лошадкой веб‑автоматизации — и чему это учит о практической обработке текста сегодня.

«Программирование скотчем» — это идея, что лучший инструмент часто тот, который быстро решает вашу реальную задачу — даже если решение не красиво, не навсегда и не задумано как большая архитектура.

Речь не о халтуре. Это про ценность импульса, когда вы сталкиваетесь с грязными входами, незавершёнными спецификациями и дедлайном, которому всё равно на изящность вашей архитектурной схемы.

Менталитет скотча начинается с простого вопроса: какое минимальное изменение убирает боль? Это может быть короткий скрипт для переименования 10 000 файлов, быстрый фильтр для извлечения ошибок из логов или одноразовая трансформация, которая превращает хаотичный экспорт в то, что можно открыть в таблице.

Эта статья использует Ларри Уолла и Perl как исторический пример такого подхода — но цель не в ностальгии. Она в том, чтобы извлечь практические уроки, которые актуальны, когда вы работаете с текстом, логами, CSV, фрагментами HTML или «данными», которые на деле представляют собой груду несогласованных строк.

Если вы не профессиональный разработчик, но регулярно сталкиваетесь с:

…вы — целевая аудитория.

К концу вы получите четыре ясных вывода:

Ларри Уолл не ставил цель изобрести «хитрый» язык. Он был инженер и системный админ, который тратил дни на укрощение неуправляемого текста: логи, отчёты, фрагменты конфигураций, заголовки писем и ad‑hoc дампы, которые никогда не соответствовали обещанному форматом в мануале.

К середине 1980‑х Unix уже имел отличные инструменты — sh, grep, sed, awk, пайпы и фильтры. Но реальные задачи редко укладывались в одну аккуратную команду. Начинаешь с пайплайна, а затем обнаруживаешь, что нужна простая машина состояний, лучшее управление строками, повторно используемый скрипт и способ держать всё читаемым, чтобы можно было поправить это на следующей неделе.

Мотивация Ларри была практичной: снизить трение «склейочной работы» — неприметной, но постоянной задачи по соединению инструментов и трансформации текста, пока не появится что‑то полезное.

Оригинальная цель Perl не была в том, чтобы заменить Unix‑утилиты — она была в том, чтобы упростить их оркестрацию, когда односложный конвейер превращается в мини‑программу. Вместо постоянного переключения между утилитами (каждая со своими правилами экранирования и тонкостями), Perl предлагал одно место для:

Вот что такое менталитет скотча: не совершенство, а быстрое долговечное исправление, которое держит систему вместе.

Культура Perl приняла ценности, соответствующие реальности: прагматизм вместо чистоты, выразительность вместо церемонии и знаменитое «There’s more than one way to do it». Это были не просто слоганы — это давало право решать задачу минимальным болевым способом.

Ранняя популярность Perl может казаться мистической в ретроспективе. Это не так. Он просто соответствовал тому, что командам было нужно в то время: язык, который переживёт грязный ввод, интегрируется с существующими системами и позволит усталому человеку выпустить рабочий скрипт до следующего тревожного сигнала.

Ранние сайты не использовали фреймворки и управляемые сервисы. Во многих случаях это был веб‑сервер плюс каталог CGI‑скриптов, пара плоских файлов и, может быть, простая база данных. Операции генерировали логи: access, error, папки с загрузками, почтовые ящики с результатами форм и текстовые файлы, которые тихо превращались в базы.

Когда что‑то ломалось, часто диагноз ставили, прождав grep по вчерашним логам и подправив скрипт.

Автоматизация — это повторяемая задача, которая выполняется без ручного вмешательства.

Она могла срабатывать по веб‑запросу (кто‑то отправил форму, нажал «поиск», скачал отчёт) или по расписанию (cron каждые N минут вращает логи, перестраивает страницы, отправляет сводки).

Даже маленьким сайтам нужно было:

Ручное выполнение не только тратило время — оно вносило ошибки и задержки.

Perl отлично располагался между тем, что уже существовало:

grep, sed, awk, sort) для отдельных шагов,Perl мог прочитать запрос, вызвать системные команды, трансформировать грязный текст и вывести HTML или обновить файл — всё в одном скрипте. Роль «glue‑языка» сделала раннюю веб‑автоматизацию практичной: он соединял отдельные полезные, но неловко сцепляемые куски.

Perl заработал репутацию «скотча», потому что легко сидел между классическими Unix‑командами и новым миром веб‑скриптов. Если ваши данные начинались как логи, письма, CSV‑экспорты или фрагменты HTML, Perl мог захватить их, преобразовать и передать дальше — не заставляя вас полностью переходить в новую среду.

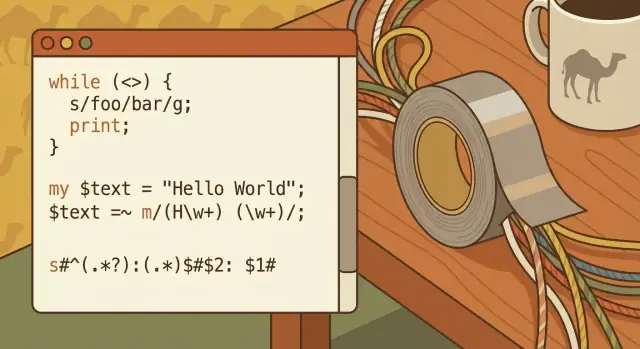

Из коробки Perl делал манипуляции с текстом необычно прямыми:

split, join, замены),Эта комбинация означала, что для повседневного парсинга и редактирования не требовалась длинная цепочка инструментов.

Unix поощряет небольшие фокусированные программы, соединённые вместе. Perl мог быть одним из таких звеньев: читать из стандартного ввода, трансформировать текст и печатать результат для следующего инструмента.

Распространённая модель мышления была:

read → transform → write

Например: читать логи сервера, нормализовать формат даты, убрать шум, затем записать очищенный файл — возможно с последующим sort, uniq или grep. Perl не заменял Unix‑утилиты; он склеивал их, когда связка awk + sed + shell становилась неудобной.

Подход «скрипт‑сначала» перешёл и в раннюю веб‑разработку. Perl‑скрипт мог принимать данные формы, обрабатывать их как любой другой текстовый поток и печатать HTML — делая его практичным мостом между утилитами системы и веб‑страницами.

Так как Perl работал на многих Unix‑подобных системах, команды могли переносить один и тот же скрипт между машинами с минимальными изменениями — ценно, когда деплой был простым, ручным и частым.

Регулярные выражения (regex) — способ описать шаблоны текста: как инструмент «найти и заменить», но с правилами вместо точных слов. Вместо поиска [email protected], regex позволяет сказать «найди всё, что похоже на email». Этот переход — от точного совпадения к шаблону — и сделал раннюю автоматизацию возможной.

Думайте о regex как о мини‑языке для ответов на вопросы вроде:

Если вы когда‑то копировали текст в таблицу и мечтали, чтобы он автоматически разбивался на колонки — вы хотели regex.

Ранние веб‑скрипты жили на грязных входах: поля форм от людей, логи от серверов и файлы, сшитые из разных систем. Regex позволял быстро делать три ценные вещи:

Поддержка regex в Perl была не просто наличествующей — она была рассчитана на постоянное использование. Это идеально ложилось на менталитет скотча: берём несогласованный текст, применяем пару правил и получаем что‑то достаточно надёжное для релиза.

Regex хорош на «почти структурированном» тексте, с которым люди сталкиваются ежедневно:

12/26/25 в 2025-12-26 или распознать несколько форматов.Regex достаточно мощны, чтобы стать криптичными. Короткий умный паттерн бывает трудно проверить, отладить и легко сломать, когда формат входа изменится.

Поддерживаемый подход: держать паттерны маленькими, добавлять комментарии (где язык это поддерживает) и предпочитать два понятных шага одному «гениальному» выражению, если другой человек будет править код через месяц.

Однострочники Perl — это по сути крошечные скрипты: однозначные команды в терминале для трансформации текста. Они особенно хороши для быстрой чистки, одноразовой миграции или быстрой проверки перед тем, как написать полноценную программу.

Они обычно читают из stdin, делают изменение и печатают результат. Например, удаление пустых строк из файла:

perl -ne 'print if /\S/' input.txt > output.txt

Или извлечение конкретных «столбцов» из разделённого пробелами текста:

perl -lane 'print "$F[0]\t$F[2]"' data.txt

А для пакетного переименования Perl даёт чуть больше контроля, чем простая утилита rename:

perl -e 'for (@ARGV){(my $n=$_)=~s/\s+/_/g; rename $_,$n}' *

(Этот пример заменяет пробелы на подчёркивания.)

Однострочники подходят, когда:

Пишите полноценный скрипт, когда:

«Быстро» не должно означать «неотслеживаемо». Сохраните строку в истории shell (или вставьте её в заметку в репозитории), приложите пример до/после и запишите, что и почему вы изменили.

Если вы запускаете один и тот же однострочник дважды — это сигнал упаковать его в небольшой скрипт с именем файла, комментариями и предсказуемыми путями ввода/вывода.

CPAN (Comprehensive Perl Archive Network) — это общая библиотека для Perl: публичная коллекция модулей, которые можно скачать и использовать.

Вместо того чтобы писать всё с нуля, небольшие команды могли взять проверенный модуль и сосредоточиться на реальной задаче — выпустить скрипт, который работает сегодня.

Многие повседневные веб‑задачи стали доступнее одному разработчику, потому что CPAN предлагал блоки, которые иначе заняли бы дни или недели:

Это важно, потому что ранняя веб‑автоматизация часто была «ещё одним скриптом» в загруженной системе. CPAN позволял собирать этот скрипт быстро и зачастую безопаснее, опираясь на проверенный код.

Компромисс реальный: зависимости — это форма обязательства.

Подключение модулей экономит время сейчас, но значит, что нужно думать о совместимости версий, исправлениях безопасности и о том, что будет, если модуль оставят без поддержки.

Перед использованием модуля с CPAN отдавайте предпочтение тем, которые явно поддерживаются:

При продуманном использовании CPAN — одна из лучших реализаций менталитета скотча: переиспользуй рабочее, двигайся дальше и не строй инфраструктуру, которая не нужна.

CGI (Common Gateway Interface) — это этап «просто запусти программу» в вебе. Запрос поступал на сервер, сервер запускал ваш Perl‑скрипт, скрипт читал вход (часто из переменных окружения и STDIN) и печатал ответ — обычно заголовок HTTP и кусок HTML.

В простейшем виде скрипт:

name=Sam&age=42),Content-Type: text/html) и затем HTML.Эта модель позволяла быстро выпустить полезное решение. Она также позволяла быстро выпустить рискованное решение.

Perl CGI стал коротким путём для практической веб‑автоматизации:

Часто это были победы малых команд: один скрипт, один URL, мгновенная ценность.

Поскольку CGI‑скрипты выполнялись на каждый запрос, мелкие ошибки множились:

Скорость — это преимущество, но только вкупе с границами. Даже быстрые скрипты нуждаются в ясной валидации, аккуратном экранировании и предсказуемых правилах вывода — привычки, которые окупаются везде: от крошечного админ‑инструмента до современного веб‑эндпоинта.

Perl заработал репутацию трудночитаемого языка, потому что позволял делать хитрые решения просто. Плотный синтаксис с кучей знаков препинания, контекстно‑зависимое поведение и культура «есть больше одного пути» поощряли короткий впечатляющий код. Это отлично работает для быстрой fix в 2 ночи — но шесть месяцев спустя даже автор может не помнить, что делала та однострочка.

Проблема поддерживаемости не в том, что Perl уникально нечитаем — а в том, что Perl позволяет сжимать намерение до исчезновения. Частые виновники: сложные регулярки без комментариев, активное использование неявных переменных вроде $_, и трюки, которые экономят строки, но усложняют понимание.

Несколько привычек значительно повышают читаемость, не замедляя работу:

Сообщество Perl нормализовало простые ограждения, которые многие языки позже приняли: включайте use strict; и use warnings;, пишите базовые тесты (даже пару sanity‑чеков) и документируйте предположения комментарием или POD.

Эти практики не делают код «корпоративным» — они делают его живучим.

Широкая мысль применима к любому языку: пиши для своего будущего себя и для коллег. Самый быстрый скрипт — тот, который можно безопасно изменить, когда требования непременно изменятся.

Работа с текстом не стала чище — она просто переместилась. Возможно, вы не поддерживаете CGI‑скрипты, но вы ещё сталкиваетесь с CSV‑экспортами, webhooks SaaS, логами и «временными» фидами интеграций, которые становятся постоянными. Те же практические навыки, что делали Perl полезным, по‑прежнему экономят время и предотвращают тихую порчу данных.

Большинство проблем — не «сложный парсинг», а непоследовательный ввод:

1,234 vs 1.234, даты вроде 03/04/05, названия месяцев на разных языках.Относитесь к любому входу как к непроверенному, даже если он от «нашей системы». Нормализуйте рано: выберите кодировку (обычно UTF‑8), стандартизируйте окончания строк, отрежьте явный шум и приведите к единой схеме.

Затем явно валидируйте предположения: «в этом файле 7 колонок», «ID — числовые», «временные метки — ISO‑8601». Когда что‑то ломается — падайте громко и записывайте, что увидели (пример строки, номер строки, исходный файл).

Когда возможно, предпочитайте явные форматы и настоящие парсеры вместо хитрых сплитов. Если у вас JSON — парсите JSON. Если CSV — используйте CSV‑парсер, который понимает кавычки. Гадание работает до тех пор, пока в имени клиента вдруг не появится запятая.

Эти навыки окупаются при повседневных задачах: фильтрация лога приложения при инциденте, чистка финансовых экспортов, трансформация импортов CRM, связывание API‑интеграций и одноразовые миграции данных, где «почти правильно» — всё ещё неправильно.

Репутация Perl как «скотча» — не про халтуру, а про полезность. Это наследие проявляется каждый раз, когда команде нужен маленький скрипт, чтобы сверстать экспорты, нормализовать логи или превратить груду полуструктурированных строк в то, что можно положить в таблицу или БД.

Сегодня часто выбирают Python, Ruby или JavaScript (Node.js). Их роли пересекаются: быстрая автоматизация, интеграция и glue‑код. Классические сильные стороны Perl были (и остаются) — прямой доступ к ОС, выразительная работа с текстом и культура «просто сделать задачу». Python подчёркивает читаемость и богатую стандартную библиотеку; Ruby — удобство для разработчика и веб‑ориентированные конвенции; JavaScript — вездесущность и простота развёртывания там, где работает Node.

Сегодня многое устроено фреймворками, стабильными API, облачными сервисами и лучшими инструментами. Задачи, требовавшие кастомных скриптов, часто решаются управляемыми сервисами, очередями и готовыми коннекторами.

Деплой теперь другой: контейнеры, CI‑пайплайны и фиксирование зависимостей — ожидания, а не опция.

Реальный текст по‑прежнему грязный. Логи преподносят сюрпризы, экспорты содержат «креативное» форматирование, а данные всё ещё требуют аккуратной трансформации, чтобы стать надёжными.

Вот вечный урок от Perl: 80% автоматизации — это парсинг, чистка, валидация и производство предсказуемого вывода.

Лучший выбор — тот, который ваша команда сможет поддерживать: комфорт с языком, здоровая экосистема и реалистичные ограничения деплоя (что установлено, что разрешено, что ops может поддержать). Наследие Perl — не «всегда Perl», а «выбирайте инструмент, который подходит к беспорядку, с которым вы реально сталкиваетесь».

Также стоит отметить, что инстинкт «скотча» проявляется и в современных AI‑подходах. Платформа типа Koder.ai может быть полезна, когда нужно быстро сделать внутренний инструмент (просмотр логов, нормализатор CSV или небольшой админ‑UI) и вы предпочитаете итерации через чат вместо ручного скелетирования всего. Применяется то же предупреждение: выпускайте быстро, но делайте результат читаемым, тестируемым и с возможностью отката, если сегодняшнее "временное" решение станет завязано на критическом пути.

Главный подарок Perl — не синтаксис, а рабочее отношение к грязным текстовым задачам. Когда вы собираетесь автоматизировать что‑то (переименование, чистку логов, импорт данных), используйте этот чеклист, чтобы остаться прагматичным и не создать будущую проблему.

Начните с малого:

^ / $), группы, символьные классы и жадность/нежадность.Включите: входы, выходы, пару примеров до/после, предположения (кодировка, разделители) и план отката («восстановить из бэкапа X» или «перезапустить старой версией»).

Perl — исторический столп текстовой работы в веб‑эре и постоянный учитель: будьте прагматичны, аккуратны и оставляйте скрипт, которому другой человек сможет доверять.

Это прагматичный подход: использовать минимальное эффективное изменение, которое быстро решает реальную проблему, особенно когда входные данные грязные, спецификация неполная, а срок поджимает.

Это не разрешение творить халтуру. «Менталитет скотча» — про доставку рабочего результата, а затем добавление ровно тех мер безопасности (тесты, бэкапы, заметки), чтобы быстрое исправление не превратилось в ловушку позже.

Используйте правило «ещё раз»: если вы выполняете ту же ручную правку дважды — автоматизируйте.

Хорошие кандидаты:

Если задача влияет на продовые данные, добавьте предохранители (dry-run, резервные копии, валидация) перед выполнением.

Рассматривайте однострочники как маленькие скрипты:

Если команда растёт, требуется обработка ошибок или нужно повторное использование — превратите её в полноценный скрипт с аргументами и понятными входами/выходами.

Регулярные выражения полезны, когда текст «почти структурирован» (логи, письма, идентификаторы, нестабильные разделители) и нужно валидировать, извлечь или переписать куски.

Чтобы сохранить читаемость:

Быстрая правка становится «навсегда», когда её используют повторно, на неё завязаны другие процессы или она встроена в рабочий поток (cron, пайплайны, документация).

Сигналы, что пора укреплять решение:

Тогда: добавьте валидацию, логирование, тесты и README с описанием предположений.

CPAN экономит дни, но любая зависимость — это обязательство.

Практический чеклист выбора модуля:

Также продумайте развертывание: фиксируйте версии, опишите шаги установки и отслеживайте обновления безопасности.

Главный урок CGI-эры: скорость без ограничений порождает уязвимости.

Если вы принимаете внешние данные:

Эти привычки актуальны для современных скриптов, serverless-функций и веб-эндпоинтов.

Типичные проблемы:

Нормализуйте как можно раньше (кодировка, окончания строк), валидируйте предположения (количество колонок, обязательные поля) и при ошибках сообщайте громко с примером проблемной строки.

Правило: если это реальный формат — парсить его «по-настоящему».

Регулярки и ad-hoc split хороши для извлечения паттернов и лёгкой чистки — до тех пор, пока крайний случай (например, запятая в имени) не начнёт тихо портить результаты.

Выбирайте инструмент, которым команда сможет поддерживать в реальных условиях:

Наследие Perl — не «всегда используйте Perl», а принцип: выбирайте инструмент, который подходит к беспорядку, с которым вы реально сталкиваетесь.