03 нояб. 2025 г.·8 мин

Лесли Лэмпорт и распределённые системы: время, порядок, корректность

Изучите ключевые идеи Лэмпорта для распределённых систем — логические часы, порядок событий, консенсус и корректность — и почему они до сих пор определяют архитектуру инфраструктуры.

Почему Лэмпорт до сих пор важен для современных распределённых систем

Лесли Лэмпорт — один из тех редких исследователей, чьи «теоретические» идеи постоянно встречаются в реальных продуктах. Если вы когда‑нибудь эксплуатировали кластер баз данных, очередь сообщений, движок рабочих процессов или любую систему, которая делает повторные попытки и выживает при сбоях, вы уже решаете задачи, которые Лэмпорт помог назвать и частично решить.

То, что делает его идеи долговечными, — это то, что они не привязаны к конкретной технологии. Они описывают неудобные истины, которые появляются всякий раз, когда несколько машин пытаются вести себя как одна система: часы расходятся, сеть задерживает и теряет сообщения, а сбои — нормальное состояние, а не исключение.

Три темы, которые будут сквозными

Время: в распределённой системе вопрос «который сейчас час?» — не такой простой. Физические часы дрейфуют, и порядок наблюдаемых событий может отличаться на разных машинах.

Порядок: если нельзя доверять одному общему часу, нужны другие способы говорить о том, какие события произошли раньше — и когда необходимо заставить всех следовать одной и той же последовательности.

Корректность: «обычно работает» — это не проектирование. Лэмпорт подталкивал область к чётким определениям (безопасность против живости) и спецификациям, о которых можно рассуждать, а не только тестировать.

Чего ожидать (без тяжёлой математики)

Мы сфокусируемся на понятиях и интуиции: на проблемах, минимальных инструментах для ясного мышления и на том, как эти инструменты формируют практические решения.

Вот карта:

- Почему отсутствие общего часа означает отсутствие единой истории событий

- Как причинность ("произошло-до") приводит к логическим часам и меткам Лэмпорта

- Когда частичного порядка недостаточно и нужен один временной ряд

- Как консенсус и Paxos связаны с согласием по порядку

- Почему репликация машин состояний работает, когда порядок общий

- Как говорить о корректности в спецификациях — и как такие инструменты, как TLA+, помогают

Основная проблема: нет общего часа — нет единой реальности

Система называется «распределённой», когда она состоит из нескольких машин, которые координируются по сети, чтобы выполнять одну задачу. Звучит просто, пока вы не примете два факта: машины могут выходить из строя по‑отдельности (частичные отказы), а сеть может задерживать, терять, дублировать или переупорядочивать сообщения.

В одной программе на одном компьютере вы обычно можете указать, «что произошло первым». В распределённой системе разные машины могут наблюдать разные последовательности событий — и обе могут быть корректны с их локальной точки зрения.

Почему нельзя полагаться на единый глобальный час

Соблазн решить проблему координации путём проставления временных меток велик. Но нет единого часового источника, на который можно опереться между машинами:

- Аппаратные часы каждого сервера дрейфуют с собственной скоростью.

- Синхронизация часов (например, NTP) даёт лишь best‑effort, а не гарантию.

- Виртуализация, загрузка CPU или паузы могут вызывать скачки или остановки времени.

Поэтому «событие A произошло в 10:01:05.123» на одном хосте не сопоставимо надёжно с «10:01:05.120» на другом.

Как задержки перемешивают реальность

Сетевые задержки могут инвертировать то, что вы думаете, что видели. Запись может быть отправлена первой, но прибыть второй. Повторная попытка может прибыть позже оригинала. Два дата‑центра могут обработать «один и тот же» запрос в противоположных порядках.

Это делает отладку особенно запутанной: логи с разных машин могут не совпадать, а «сортировка по временной метке» может создать историю, которой никогда не было.

Реальные последствия

Если вы предполагаете единый временной ряд, которого нет, это приводит к конкретным сбоям:

- Двойная обработка (платёж списан дважды из‑за повторных попыток)

- Несогласованности (две разные учётные записи одновременно «успешно» получили последний товар)

- Кажущееся потерей данных (позднее пришедшее обновление перезаписывает более новое)

Ключевая мысль Лэмпорта начинается здесь: если нельзя поделиться временем, нужно иначе рассуждать об порядке.

Причинность и отношение «произошло-до»

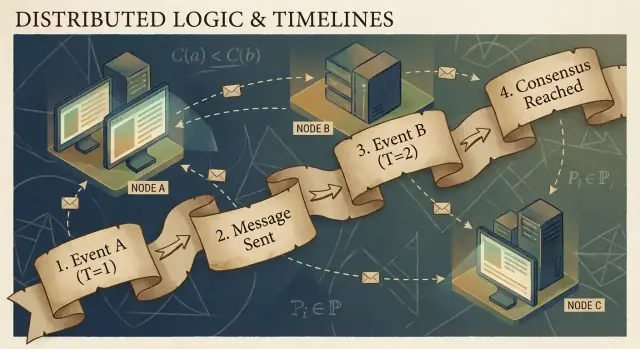

Распределённые программы состоят из событий: того, что случается на конкретном узле (процесс, сервер или поток). Примеры: «получен запрос», «записана строка», «отправлено сообщение». Сообщение — это связующее звено между узлами: одно событие — это отправка, другое — приём.

Ключевая идея Лэмпорта в том, что в системе без надёжного общего часа самое надёжное, что можно отслеживать, — это причинность: какие события могли повлиять на другие.

Отношение "произошло-до" (→)

Лэмпорт определил простое правило, называемое произошло-до, обозначаемое A → B (событие A произошло до события B):

- Порядок в том же процессе: если A и B происходят в одном процессе/на одной машине, и A наблюдается раньше B, то A → B.

- Порядок сообщений: если A — «отправка сообщения m», а B — «приём сообщения m», то A → B.

- Транзитивность: если A → B и B → C, то A → C.

Это отношение задаёт частичный порядок: оно говорит вам, какие пары упорядочены, но не обо всех.

Конкретная история: пользователь → запрос → БД → кэш

Пользователь нажимает «Купить». Клиент инициирует запрос к API‑серверу (событие A). Сервер пишет строку заказа в базу (событие B). После завершения записи сервер публикует сообщение «заказ создан» (событие C), и сервис кэша получает его и обновляет запись (событие D).

Здесь A → B → C → D. Даже если часы расходятся, сообщения и структура программы создают реальные причинные связи.

Что на самом деле значит «конкурирующие/параллельные» события

Два события конкурируют (concurrent), когда ни одно не могло повлиять на другое: не (A → B) и не (B → A). Конкурентность не означает «в одно и то же время» — это значит «нет причинной связи между ними». Поэтому два сервиса могут каждый утверждать, что они «поступили первыми», и оба могут быть правы, если не вводить правило порядка.

Логические часы: метки Лэмпорта простыми словами

Если вы когда‑нибудь пытались восстановить «что произошло раньше» между машинами, вы столкнулись с базовой проблемой: компьютеры не имеют идеально синхронизированных часов. Хитрость Лэмпорта в том, чтобы бросить погоню за точным временем и вместо этого отслеживать порядок.

Идея: счётчик, прикреплённый к каждому событию

Метка Лэмпорта — это просто число, которое вы прикрепляете к каждому значимому событию в процессе (инстансе сервиса, узле, потоке — как вы решите). Думайте о нём как о «счётчике событий», который даёт согласованный способ сказать «это событие произошло раньше того», даже когда системное время ненадёжно.

Два правила (и они действительно такие простые)

-

Инкремент локально: перед регистрацией события (например, «запись в БД», «отправка запроса», «добавление в лог») увеличьте локальный счётчик.

-

При приёме — взять max + 1: когда вы получаете сообщение с меткой отправителя, установите свой счётчик как:

max(local_counter, received_counter) + 1

Затем пометьте событие приёма этим значением.

Эти правила обеспечивают, что метки уважают причинность: если событие A могло повлиять на событие B (потому что информация прошла через сообщения), то метка A будет меньше метки B.

Что метки Лэмпорта могут и чего не могут сказать

Они могут рассказать о причинно‑следственном порядке:

- Если

TS(A) < TS(B), A возможно произошло до B. - Если A действительно вызвало B (напрямую или косвенно), то обязательно

TS(A) < TS(B).

Они не могут сказать о реальном времени:

- Меньшая метка не означает «раньше в секундах».

- Два конкурентных события (никакая причинная связь) всё равно могут получить разные метки из‑за шаблонов обмена сообщениями.

Итак, метки Лэмпорта хороши для упорядочивания, но не для измерения задержек или ответа на вопрос «который сейчас час?».

Практический пример: упорядочивание логов между сервисами

Представьте, что Сервис A вызывает Сервис B, и оба пишут аудиторные логи. Вы хотите единый вид логов, который сохраняет причинно‑следственные связи.

- Сервис A увеличивает счётчик, логирует «начинаю платёж», отправляет запрос B с меткой 42.

- Сервис B получает запрос с 42, устанавливает счётчик в

max(local, 42) + 1, скажем 43, и логирует «проверил карту». - B отвечает с 44; A получает, обновляет до 45 и логирует «платёж завершён».

Теперь, собирая логи с обоих сервисов и сортируя по (lamport_timestamp, service_id), вы получите стабильную объяснимую временную шкалу, которая соответствует реальной цепочке влияния — даже если системные часы дрейфовали или сеть задерживала сообщения.

От частичного порядка к полному: когда нужен один временной ряд

Причинность даёт вам частичный порядок: некоторые события явно «до» других (потому что связаны сообщениями или зависимостями), но многие события просто конкурентны. Это не ошибка — это естественная форма распределённой реальности.

Частичный порядок: достаточно для многих задач

Если вы отлаживаете «что могло повлиять на это?» или соблюдаете правила типа «ответ должен следовать за запросом», частичный порядок — именно то, что нужно. Достаточно уважать ребра отношения «произошло-до»; всё остальное можно считать независимым.

Полный порядок: необходим, когда система должна выбрать одну историю

Некоторым системам «любой порядок подойдёт» не подходит. Им нужна одна последовательность операций, особенно для:

- Записей в общий объект («установить баланс», «обновить профиль», «добавить в лог»)

- Команд, которые должны применяться одинаково везде (репликация машин состояний)

- Разрешения конфликтов, где «последняя запись побеждает» должна означать одно и то же для всех узлов

Без полного порядка две реплики могут быть «правильными» локально, но расходиться глобально: одна применит A затем B, другая — B затем A, и получатся разные результаты.

Как получить одну временную линию?

Вводят механизм, который создает порядок:

- Секвенсор/лидер, назначающий монотонно возрастающую позицию каждой команде.

- Или консенсус (подходы типа Paxos), чтобы кластер договорился о следующей позиции в логе, несмотря на задержки и отказы.

Невыносимые компромиссы

Полный порядок даёт много, но за что‑то рассчитываться придётся:

- Задержка: возможно, придётся ждать координации перед фиксацией.

- Пропускная способность: единый упорядоченный лог может стать узким местом.

- Доступность при отказах: если нельзя связаться с достаточным числом узлов для согласия, прогресс может остановиться ради защиты корректности.

Выбор дизайна прост: когда корректность требует единой истории, вы платите стоимость координации, чтобы её получить.

Консенсус: согласие при задержках и отказах

Добавьте панель управления

Создайте админ‑клиент на Flutter для просмотра логов, трассировок и состояния реплик отовсюду.

Консенсус — это задача заставить несколько машин согласиться на одном решении — одном значении, которое нужно зафиксировать, одном лидере для следования, одной конфигурации для активации — несмотря на то, что каждая машина видит только свои локальные события и те сообщения, что до неё дошли.

Звучит просто, пока вы не вспомните, чем является распределённая система: сообщения могут задерживаться, дублироваться, переупорядочиваться или теряться; машины могут падать и перезапускаться; и редко бывает ясный сигнал «этот узел точно мёртв». Консенсус — это про обеспечение безопасности соглашения в таких условиях.

Почему соглашение сложно

Если два узла временно не общаются (сетевой разрыв), каждая сторона может попытаться «идти вперёд» самостоятельно. Если обе стороны примут разные решения, можно получить split‑brain: двух лидеров, две конфигурации или две конкурирующие истории.

Даже без разделений одна задержка создаёт проблемы. К тому времени, когда узел узнаёт о предложении, другие узлы могли уже продвинуться дальше. Без общего часа нельзя уверенно сказать «предложение A было раньше предложения B», потому что физическое время здесь не авторитет.

Где вы встречаете консенсус в реальности

Вы можете не называть это «консенсусом» в повседневной работе, но он проявляется в инфраструктурных задачах:

- Выбор лидера (кто сейчас главный?)

- Реплицируемые логи (какая следующая запись в общей истории?)

- Изменения конфигурации (какой набор узлов теперь участвует в голосовании/фиксации?)

В каждом случае системе нужен единый результат, к которому все сойдутся, или по крайней мере правило, предотвращающее признание двух конфликтующих исходов корректными.

Paxos как ответ Лэмпорта

Paxos Лэмпорта — фундаментальное решение проблемы «безопасного согласия». Главная идея — не в магическом таймауте или идеальном лидере, а в наборе правил, гарантирующих, что может быть выбран только один вариант, даже когда сообщения запаздывают и узлы падают.

Paxos разделяет безопасность («никогда не выбрать два разных значения») и прогресс («в конце концов выбрать что‑то»), что делает его практичным ориентиром: можно настраивать производительность в реальном мире, сохраняя базовое свойство.

Paxos без головной боли: ключевая интуиция безопасности

Paxos имеет репутацию трудноусвояемого, но многое от этого — из‑за того, что «Paxos» — не одна однострочная процедура. Это семейство близких паттернов для достижения согласия в группе, даже когда сообщения задерживаются, дублируются или узлы временно выходят из строя.

Роли: предлагающие, принимающие и кворумы

Полезная мыслеформа — разделить «кто предлагает» и «кто валидирует».

- Предлагающие пытаются добиться выбора значения (например: «следующая запись в логе — X»).

- Принимающие голосуют за предложения.

- Кворум — это «достаточное количество принимающих» для продвижения — обычно большинство.

Структурная идея: любые два большинства пересекаются. Именно в этом пересечении живёт безопасность.

Цель безопасности: никогда не выбрать два разных значения

Безопасность Paxos проста в формулировке: как только система выбрала значение, она не должна выбрать другое — никакого split‑brain.

Ключевая интуиция в том, что предложения носят номера (думаем: идентификаторы баллов). Принимающие обещают игнорировать предложения с более старыми номерами, если видели более новые. А когда предлагающий пытается с новым номером, он сначала спрашивает кворум, что они уже приняли.

Поскольку кворумы пересекаются, новый предлагающий обязательно услышит от хотя бы одного принимающего то, что «помнит» наиболее недавно принятое значение. Правило гласит: если кто‑то в кворуме уже принял значение, вы должны предложить это значение (или самое свежее из услышанных). Это ограничение и не даёт выбрать два разных значения.

Живость, в общих чертах

Живость означает, что система в конечном итоге что‑то выбирает при разумных условиях (например, появляется стабильный лидер и сеть начинает доставлять сообщения). Paxos не гарантирует быстроту в хаосе; он гарантирует корректность и прогресс, когда вещи успокаиваются.

Репликация машин состояний: корректность через общий порядок

Сначала спецификация, затем выпуск

Используйте режим планирования, чтобы записать требования по безопасности и живучести, затем реализуйте по спецификации.

Репликация машин состояний (SMR) — рабочая лошадка многих систем «высокой доступности»: вместо того чтобы одна машина принимала решения, вы запускаете несколько реплик, которые все обрабатывают одну и ту же последовательность команд.

Идея реплицируемого лога

В основе — реплицируемый лог: упорядоченный список команд типа «put key=K value=V» или «перевести $10 с A на B». Клиенты не шлют команды всем репликам и не полагаются на лучшее — они отправляют команду в группу, а система договаривается о порядке для этих команд, затем каждая реплика применяет их локально.

Почему порядок даёт корректность

Если каждая реплика стартует из одинакового начального состояния и выполняет одни и те же команды в одном и том же порядке, они придут к одинаковому состоянию. Это основная интуиция безопасности: вы не пытаетесь синхронизировать машины временем; вы делаете их идентичными через детерминированность и общий порядок.

Именно поэтому консенсус (Paxos/Raft‑подобные протоколы) часто сочетают с SMR: консенсус решает следующую запись лога, а SMR превращает это решение в согласованное состояние на репликах.

Где это встречается в реальности

- Службы координации (например, для конфигурации и выбора лидера)

- Базы данных с реплицируемыми журналами предварительной записи (write‑ahead logs)

- Системы сообщений, требующие строгого порядка в партициях

Практические вопросы, которые инженеры не должны игнорировать

Лог растёт бесконечно, если с ним не обращаться:

- Снепшоты: периодически сохраняйте текущее состояние, чтобы новые узлы могли догонять без воспроизведения всей истории.

- Сжатие лога: безопасно отбрасывайте старые записи, когда они учтены в снепшоте и больше не нужны.

- Изменения состава группы: добавление/удаление реплик тоже должно быть упорядочено, иначе узлы могут расходиться во мнениях о том, кто в группе, что приведёт к split‑brain.

SMR — не магия; это дисциплинированный способ превратить «согласие по порядку» в «согласие по состоянию».

Корректность: безопасность, живость и написание понятной спецификации

Распределённые системы ломаются необычно: сообщения приходят поздно, узлы перезапускаются, часы расходятся, сети дробятся. «Корректность» — это не настроение, а набор обещаний, которые можно точно сформулировать и затем проверить для всех ситуаций, включая отказы.

Безопасность против живости (с конкретными примерами)

Безопасность означает «ничего плохого никогда не происходит». Пример: в реплицируемом key‑value хранилище для одного и того же индекса лога не может быть зафиксировано два разных значения. Другой пример: служба блокировок никогда не должна выдать один и тот же лок двум клиентам одновременно.

Живость означает «что‑то хорошее в конце концов происходит». Пример: если большинство реплик доступно и сеть в итоге доставляет сообщения, запрос на запись в конце концов завершается. Запрос на блокировку в итоге получает ответ (не бесконечное ожидание).

Безопасность — про предотвращение противоречий; живость — про избегание вечных застопориваний.

Инварианты: ваши неприкосновенные условия

Инвариант — это условие, которое должно всегда выполняться в любом достижимом состоянии. Например:

- «У каждого индекса лога не более одного зафиксированного значения».

- «Номер срока (term) лидера никогда не уменьшается».

Если инвариант может быть нарушен при крахе, таймауте, повторе или разделении сети, значит он не был реально обеспечен.

Что означает «доказательство» здесь

Доказательство — это аргумент, покрывающий все возможные исполнения, а не только «нормальный путь». Вы разбираете каждый случай: потерю, дублирование и переупорядочивание сообщений; крахи и перезапуски узлов; конкурирующих лидеров; повторные попытки клиентов.

Спецификации предотвращают неожиданные поведения

Понятная спецификация определяет состояние, допустимые действия и требуемые свойства. Это предотвращает размытые требования вроде «система должна быть согласованной», которые превращаются в противоречивые ожидания. Спецификации заставляют сказать, что происходит при разделениях, что значит «зафиксировано», и на что клиенты могут опираться — заранее, а не после инцидентов.

От теории к практике: моделирование с TLA+

Одна из самых практичных идей Лэмпорта — проектировать распределённый протокол на уровне выше кода. Прежде чем волноваться о потоках, RPC и циклах повторных попыток, можно выписать правила системы: какие действия разрешены, какое состояние может меняться и что никогда не должно происходить.

Для чего служит TLA+

TLA+ — это язык спецификаций и набор инструментов model‑checking для описания параллельных и распределённых систем. Вы пишете простую, математически похожую модель системы — состояния и переходы — и свойства, которые вам важны (например, «не больше одного лидера» или «зафиксированная запись никогда не теряется»).

Затем model checker исследует возможные интерливинги, задержки сообщений и отказы, чтобы найти контрпример: конкретную последовательность шагов, нарушающую свойство. Вместо бесконечных споров вы получаете исполняемый аргумент.

Баг, который модель может поймать

Возьмём шаг «commit» в реплицируемом логе. В коде легко случайно допустить, что два разных узла пометят два разных значения зафиксированными в одном индексе при редком тайминге.

Модель TLA+ может выдать трассу типа:

- Узел A фиксирует запись X на индексе 10 после получения кворума.

- Узел B (со старыми данными) тоже собирает кворум и фиксирует Y на индексе 10.

Это нарушение безопасности — дублированная фиксация, которая в бою может появляться раз в месяц, но в модели проявляется быстро при исчерпывающем поиске. Аналогично модели часто ловят потерянные обновления, двойное применение или «подтвердил, но не надежно записал» ситуации.

Когда стоит моделировать

TLA+ особенно ценен для критичной логики координации: выбор лидера, изменения состава группы, протоколы типа консенсус, и в любых местах, где порядок и обработка отказов пересекаются. Если баг испортит данные или потребует ручного восстановления, небольшая модель обычно дешевле отладки потом.

Если вы проектируете внутренние инструменты вокруг этих идей, полезный рабочий поток — написать лёгкую спецификацию (даже неформальную), затем реализовать систему и генерировать тесты из инвариантов спецификации. Платформы вроде Koder.ai могут ускорить цикл: описывая нужное поведение упорядочивания/консенсуса простым языком, вы быстро получаете каркас сервиса (React‑фронтенды, Go‑бэкенды с PostgreSQL или Flutter‑клиенты) и сохраняете «что никогда не должно происходить» видимым в процессе разработки.

Практические выводы для построения и эксплуатации надёжных систем

Сохраняйте полный контроль

Отправьте сгенерированный исходный код в ваш репозиторий, когда дизайн будет готов.

Большой подарок Лэмпорта практикам — это образ мышления: рассматривайте время и порядок как данные, которые вы моделируете, а не как предположения от системных часов. Эта парадигма превращается в набор привычек, которые можно применить сразу.

Перевод теории в повседневные инженерные практики

Если сообщения могут задерживаться, дублироваться или прийти в неверном порядке, проектируйте каждое взаимодействие так, чтобы оно было безопасным в таких условиях.

- Идемпотентность по умолчанию: сделайте «повторить нельзя навредить». Используйте idempotency‑ключи для платёжных операций, провижининга или любых записей, которые могут повторно отправляться.

- Повторы с дедупликацией: повторы необходимы, но без дедупликации вы получите двойные записи. Отслеживайте ID запросов и храните маркеры «уже обработано».

- Доставка «как минимум один раз» + эффекты «ровно один раз»: примите, что сеть может доставить сообщение дважды; гарантируйте, чтобы изменение состояния было эквивалентно однократному применению.

Будьте осторожны с таймаутами и часами

Таймауты — не истина; это политика. Таймаут лишь говорит «я не услышал ответ вовремя», а не «другая сторона не действовала». Две конкретные импликации:

- Не считайте таймаут окончательным отказом. Проектируйте компенсации и пути примирения.

- Избегайте использования локального системного времени для упорядочивания событий между узлами. Применяйте номер последовательности, монотонные счётчики или явные причинные метаданные (например: «это обновление заменяет версию X").

Наблюдаемость, уважающая причинность

Хорошие инструменты отладки кодируют порядок, а не только временные метки.

- Trace ID везде: прокидывайте корреляционный/трейс‑ID через все этапы и в каждую строку лога.

- Причинные подсказки в логах: логируйте ID сообщений, родительские ID запросов и «какую версию я считал актуальной», принимая решение.

- Детерминированные воспроизведения: записывайте входы (команды), чтобы воспроизвести поведение и понять, зависел ли баг от тайминга или логики.

Вопросы для прояснения перед запуском

Перед тем как добавлять распределённую функциональность, добейтесь ясности, задав несколько вопросов:

- Что случится, если один и тот же запрос обработают дважды?

- Какой порядок нам нужен (если нужен), и где он обеспечивается?

- Какие отказы являются «безопасными» (не приводят к плохому состоянию), «шумными» (видны пользователю) и «тихими» (скрытая порча)?

- Каков путь восстановления после частичного сбоя или сетевого разрыва?

- Что мы будем логировать, чтобы восстановить историю «произошло-до» в продакшене?

Эти вопросы не требуют кандидата наук — просто дисциплины рассматривать порядок и корректность как первоклассные продуктовые требования.

Заключение и предложенные следующие шаги

Долговечный вклад Лэмпорта — это способ ясно мыслить, когда системы не делят часы и по‑умолчанию не согласны в том, «что произошло». Вместо погони за идеальным временем вы отслеживаете причинность (что могло повлиять на что), представляете её через логическое время (метки Лэмпорта) и — когда продукт требует единой истории — строите согласие (консенсус), чтобы все реплики применяли одну и ту же последовательность решений.

Эта нить ведёт к практическому инженерному мышлению:

Сначала специфицируйте, потом стройте

Запишите правила: что никогда не должно случиться (безопасность) и что в конце концов должно произойти (живость). Затем реализуйте согласно спецификации и протестируйте систему при задержках, разрывах, повторах, дублировании сообщений и перезапусках узлов. Многие «загадочные простои» — это просто отсутствие заявлений вроде «запрос может быть обработан дважды» или «лидеры могут меняться в любой момент».

Учиться дальше — по шагам

Если хотите углубиться, но без утопления в формализме:

- Прочитайте «Time, Clocks, and the Ordering of Events in a Distributed System» Лэмпорта, чтобы вжиться в отношение «произошло-до».

- Просмотрите «Paxos Made Simple» для интуиции безопасности: как только значение выбрано, будущий прогресс не может ему противоречить.

- Посмотрите вводный доклад по TLA+, затем смоделируйте крошечный протокол (службу блокировок или регистр из двух реплик) и проверьте его.

Попробуйте одно практическое упражнение

Выберите компонент, за который вы отвечаете, и напишите одностраничный «контракт отказов»: что вы предполагаете о сети и хранилище, какие операции идемпотентны и какие гарантии порядка вы выдаёте.

Если хотите сделать упражнение конкретнее, соберите небольшой «демо‑сервис упорядочивания»: API, добавляющий команды в лог, фоновый воркер, применяющий их, и админ‑вид, показывающий причинные метаданные и повторы. Сделать это на Koder.ai может быть быстрым способом итерации — особенно если вам нужна быстрая заготовка, деплой, снапшоты/откат для экспериментов и экспорт исходников по завершении.

Хорошо сделанные, эти идеи уменьшают число инцидентов, потому что меньшее количество поведения остаётся неявным. Они также упрощают рассуждения: вы перестаёте спорить о времени и начинаете доказывать, что порядок, согласие и корректность на самом деле значат для вашей системы.