07 авг. 2025 г.·8 мин

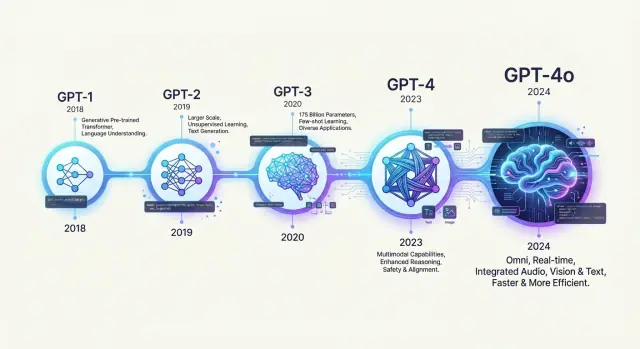

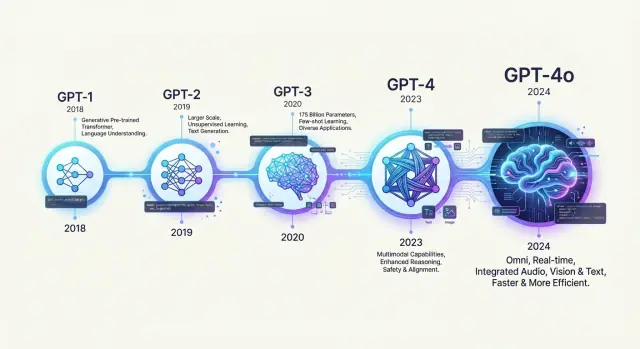

От GPT‑1 до GPT‑4: история моделей GPT от OpenAI

Изучите историю моделей GPT от OpenAI — от GPT‑1 до GPT‑4o — и узнайте, как каждое поколение улучшало понимание языка, удобство использования и безопасность.

Изучите историю моделей GPT от OpenAI — от GPT‑1 до GPT‑4o — и узнайте, как каждое поколение улучшало понимание языка, удобство использования и безопасность.

Модели GPT — это семейство больших языковых моделей, созданных для предсказания следующего слова в последовательности текста. Они «читают» огромные объёмы текста, усваивают шаблоны использования языка, а затем применяют эти шаблоны для генерации нового текста, ответов на вопросы, написания кода, суммаризации документов и многого другого.

Абревиатура отражает основную идею:

Понимание эволюции этих моделей помогает осознать, что они умеют и чего не умеют, и почему каждое поколение ощущается как качественный скачок. Каждая версия отражает конкретные технические решения и компромиссы по размеру модели, данным для обучения, задачам и работе по безопасности.

Эта статья даёт хронологический, обзорный рассказ: от ранних языковых моделей и GPT‑1 до GPT‑2 и GPT‑3, через инструкционный тюнинг и ChatGPT, и наконец — до GPT‑3.5, GPT‑4 и семейства GPT‑4o. По пути мы рассмотрим главные технические тренды, как менялись сценарии использования и что эти сдвиги могут значить для будущего больших языковых моделей.

До появления GPT языковые модели уже были ключевой частью исследований в NLP. Ранние системы представляли собой n‑gram модели, которые предсказывали следующее слово по ограниченному окну предыдущих слов, используя простые счетчики. Они работали для проверки орфографии и базовой автодополнения, но испытывали трудности с долговременным контекстом и разреженностью данных.

Следующим шагом стали нейронные языковые модели. Полносвязные сети, а затем рекуррентные нейронные сети (RNN) — особенно LSTM и GRU — научились распределённым представлениям слов и могли в принципе обрабатывать более длинные последовательности. Параллельно модели вроде word2vec и GloVe популяризировали векторные представления слов, показав, что обучение без надзора на неразмеченном тексте может захватывать богатую семантику.

Однако RNN были медленны в обучении, сложно распараллеливались и всё ещё испытывали трудности с очень длинным контекстом. Прорыв произошёл с публикацией 2017 года «Attention Is All You Need», где была представлена архитектура трансформера. Трансформеры заменили рекурренцию механизмом self‑attention, что позволило напрямую связывать любые позиции в последовательности и существенно упростило параллельное обучение.

Это открыло дорогу к масштабированию языковых моделей далеко за пределы возможностей RNN. Исследователи стали замечать, что большой трансформер, обученный предсказывать следующий токен на гигантских корпусах текста, может изучать синтаксис, семантику и даже некоторые навыки рассуждения без специальной разметки.

Ключевая идея OpenAI заключалась в формализации этого как генеративного предобучения: сначала обучить большой decoder‑only трансформер на масштабном корпусе, а затем адаптировать ту же модель к прикладным задачам с минимальным допобучением. Такой подход обещал единый универсальный механизм вместо множества узкоспециализированных моделей.

Этот концептуальный сдвиг — от маленьких задачно‑специфичных систем к большому предобученному трансформеру — заложил основу для первой модели GPT и всей серии, которая последовала.

GPT‑1 стал первым шагом OpenAI в серии GPT. Выпущенный в 2018 году, он имел 117 миллионов параметров и был построен на архитектуре трансформера, предложенной Васвани с соавторами в 2017 году. Хотя по современным меркам это мало, GPT‑1 закрепил основной рецепт, которому следовали все последующие GPT.

GPT‑1 обучали по простой, но мощной схеме:

Для предобучения GPT‑1 научили предсказывать следующий токен в тексте из таких источников, как BooksCorpus и вики‑подобные наборы. Эта цель — предсказание следующего слова — не требовала людской разметки, что позволяло модели поглощать широкий пласт знаний о языке, стиле и фактах.

После предобучения ту же модель дообучали (fine‑tune) с помощью супервизии на классических NLP‑бенчмарках: анализ тональности, вопросы‑ответы, распознавание логических связей и др. Сверху добавлялась небольшая классификационная голова, и модель тренировали end‑to‑end на каждом размеченном наборе.

Ключевой методологической мыслью было то, что одна предобученная модель может легко адаптироваться к множеству задач, вместо того чтобы для каждой задачи тренировать отдельную модель с нуля.

Несмотря на сравнительно небольшой размер, GPT‑1 дал несколько важных наблюдений:

GPT‑1 уже показывал ранние признаки нулевого и малообразцового обобщения, хотя тогда это ещё не было центральной темой. Большая часть оценки всё ещё проводилась через дообучение моделей под конкретные задачи.

GPT‑1 не был ориентирован на массовое развёртывание или API‑продукт по нескольким причинам:

Тем не менее GPT‑1 установил шаблон: генеративное предобучение на больших корпусах, затем простое дообучение под задачи. Все последующие GPT можно считать масштабированными, усовершенствованными и более способными потомками этого первого трансформера.

GPT‑2, вышедший в 2019 году, стал первой моделью GPT, привлёкшей глобальное внимание. Архитектура GPT‑2 во многом повторяла GPT‑1, но масштаб вырос с 117 миллионов до 1.5 миллиарда параметров, что продемонстрировало, насколько сильно можно улучшить модель простым масштабированием.

Архитектурно GPT‑2 был близок к GPT‑1: декодер‑только трансформер, обученный на задаче предсказания следующего токена на большом веб‑корпусе. Главное отличие — масштаб:

Такой скачок заметно улучшил беглость речи, связность на больших отрезках текста и способность следовать подсказкам без специального дообучения.

GPT‑2 заставил многих пересмотреть, на что способна «просто» задача предсказания следующего токена.

Без дообучения модель могла выполнять нулевые (zero‑shot) задачи вроде:

Если добавить пару примеров в подсказку (few‑shot), производительность часто улучшалась. Это намекнуло, что большие языковые модели могут внутренне представлять широкий спектр задач, используя примеры в контексте как неявный интерфейс программирования.

Качество генерации вызвало первые серьёзные публичные дебаты. OpenAI первоначально не выпускала веса полной модели 1.5B, ссылаясь на риски:

Вместо этого OpenAI провела поэтапный релиз:

Этот подход стал одним из первых примеров явно выраженной политики развёртывания ИИ, основанной на оценке рисков и мониторинге.

Даже меньшие контрольные точки GPT‑2 дали толчок волне открытых проектов. Разработчики дообучали модели для творческой генерации, автодополнения кода и экспериментальных чат‑ботов. Исследователи изучали смещения, фактические ошибки и режимы сбоев.

Эти эксперименты изменили восприятие: большие языковые модели перестали быть нишевыми исследовательскими артефактами и стали рассматриваться как универсальные текстовые движки. Влияние GPT‑2 сформировало ожидания — и усилило обеспокоенность — которые повлияли на восприятие GPT‑3, ChatGPT и более поздних моделей семейства GPT.

GPT‑3 появился в 2020 году с впечатляющими 175 миллиардами параметров — более чем в 100 раз больше, чем GPT‑2. Это число привлекло внимание: оно сулило огромную мощь «запоминания», а главное — позволило раскрыться поведению, невиданному ранее на таком масштабе.

Ключевым открытием с GPT‑3 стало in‑context learning. Вместо дообучения модели для новой задачи можно просто вставить в подсказку несколько примеров:

Модель не меняет веса; она использует подсказку как временный тренировочный набор. Это породило понятия «zero‑shot», «one‑shot» и «few‑shot» и первую волну prompt engineering: аккуратное составление инструкций, примеров и формата для достижения лучшего поведения без изменения самой модели.

В отличие от GPT‑2, веса GPT‑3 не распространялись свободно; модель стала доступна главным образом через коммерческий API. OpenAI запустила приватное бета‑тестирование OpenAI API в 2020 году, позиционируя GPT‑3 как универсальный текстовый движок, к которому разработчики могли обращаться по HTTP.

Это сдвинуло большие языковые модели из ниши исследований в платформу общего назначения. Вместо тренировки собственных моделей стартапы и компании могли прототипировать идеи с одним API‑ключом, оплачивая использование по токенам.

Ранние пользователи быстро нашли шаблоны, которые стали стандартными:

GPT‑3 доказал, что одна универсальная модель, доступная через API, может питать широкий спектр приложений и положил основу для ChatGPT и последующих GPT‑3.5 и GPT‑4 систем.

Базовый GPT‑3 обучался только предсказанию следующего токена на веб‑тексте. Эта цель делала его хорошим в продолжении паттернов, но не обязательно в выполнении конкретных человеческих запросов. Пользователи часто приходилось тщательно формулировать подсказки, и модель могла:

Исследователи назвали этот разрыв проблемой выравнивания (alignment): поведение модели не всегда было согласовано с человеческими намерениями, ценностями или ожиданиями безопасности.

OpenAI с проектом InstructGPT (2021–2022) сделал важный шаг. Вместо обучения только на сыром тексте добавили два ключевых этапа поверх GPT‑3:

Это привело к моделям, которые:

В исследованиях меньшие модели InstructGPT предпочиталися большим базовым GPT‑3, что показало: выравнивание и качество интерфейса могут быть важнее сырой мощности.

ChatGPT (конец 2022) расширил подход InstructGPT на многоходовые диалоги. По сути это была модель класса GPT‑3.5, дообученная SFT и RLHF на диалоговых данных, а не только на одиночных инструкциях.

Вместо API‑инструмента для разработчиков OpenAI запустила простой чат‑интерфейс:

Это снизило порог входа для не‑технических пользователей: не требовалось знание prompt‑engineering, кода или настройки — просто вводите текст и получаете ответы.

Результат — мейнстрим‑прорыв: технология, основанная на годах исследований в трансформерах и выравнивании, стала доступна любому с браузером. Инструкция‑тюнинг и RLHF сделали систему достаточно «сотрудничающей» и безопасной для широкого релиза, а чат‑интерфейс превратил исследовательскую модель в глобальный продукт и повседневный инструмент.

GPT‑3.5 обозначил момент, когда большие языковые модели перестали быть главным образом исследовательским любопытством и стали ощущаться как повседневные утилиты. Он находился между GPT‑3 и GPT‑4 по способностям, но его важность в том, насколько доступным и практичным он стал.

Технически GPT‑3.5 уточнил ядро архитектуры GPT‑3 за счёт лучших данных обучения, обновлённой оптимизации и широкого инструкционного тюнинга. Модели серии (включая text‑davinci‑003 и позже gpt‑3.5‑turbo) были обучены лучше следовать инструкциям, отвечать безопаснее и поддерживать связный многоходовой диалог.

Это сделало GPT‑3.5 естественным переходом к GPT‑4: он предвосхитил сильнее умозаключение для повседневных задач, лучшее управление длинным контекстом и более стабильное поведение в диалогах, не требуя резкого роста стоимости и сложности GPT‑4.

Публичный выпуск ChatGPT в конце 2022 года работал на модели класса GPT‑3.5, дообученной RLHF. Это значительно улучшило способность модели:

Для многих людей ChatGPT стал первым практическим опытом взаимодействия с большой языковой моделью и задал стандарт ожиданий «как должен ощущаться чат с ИИ».

gpt‑3.5‑turbo и почему он стал по умолчаниюКогда OpenAI выпустила gpt‑3.5‑turbo через API, он предложил удачное сочетание цены, скорости и возможностей. Модель была дешевле и быстрее предыдущих GPT‑3 вариантов, при этом лучше следовала инструкциям и вела диалог.

Такое соотношение сделало gpt‑3.5‑turbo выбором по умолчанию для многих приложений:

GPT‑3.5 сыграл ключевую переходную роль: достаточная мощность для реальных продуктов, экономичность для широкого развёртывания и близкое выравнивание по человеческим инструкциям.

GPT‑4, выпущенный OpenAI в 2023 году, ознаменовал сдвиг от «большой текстовой модели» к универсальному помощнику с усиленными навыками рассуждения и мультимодальным вводом.

По сравнению с GPT‑3 и GPT‑3.5 GPT‑4 сделал упор не столько на число параметров, сколько на:

Флагманская ветка включала gpt‑4 и позже gpt‑4‑turbo, которые стремились дать сопоставимое или лучшее качество при меньшей стоимости и задержке.

Важной функцией GPT‑4 стала мультимодальность: помимо текста модель могла принимать изображения. Пользователи могли:

Это сделало GPT‑4 менее узконаправленным «только‑текст» и ближе к универсальному движку рассуждения, общающемуся естественным языком.

GPT‑4 также обучали и настраивали с усиленным акцентом на безопасность и выравнивание:

Модели семейства GPT‑4 стали выбором для серьёзных производственных применений: автоматизации поддержки, помощников по программированию, образовательных инструментов и поиска по знаниям. GPT‑4 подготовил почву для вариантов вроде GPT‑4o и GPT‑4o mini, которые фокусируются на эффективности и взаимодействии в реальном времени, унаследовав многие успехи GPT‑4 в умозаключении и безопасности.

GPT‑4o ("omni") обозначает сдвиг от «максимальной мощности любой ценой» к модели «быстрой, недорогой и постоянно доступной». Она спроектирована так, чтобы давать качество уровня GPT‑4, оставаясь при этом гораздо дешевле в эксплуатации и достаточно быстрой для живых интерактивных сценариев.

GPT‑4o объединяет текст, зрение и аудио в одной модели. Вместо того чтобы склеивать разные компоненты, она нативно обрабатывает:

Такая интеграция снижает задержку и сложность. GPT‑4o может отвечать почти в реальном времени, стримить ответы по мере генерации и плавно переключаться между модальностями в рамках одного диалога.

Ключевая цель GPT‑4o — эффективность: лучшее соотношение производительности и стоимости, более низкая задержка на запрос. Это позволяет разрабатывать сервисы и продукты:

В итоге возможности, которые раньше были доступны только через дорогие API, становятся доступными студентам, хоббистам, небольшим стартапам и экспериментирующим командам.

GPT‑4o mini идёт ещё дальше, жертвуя частью пиковых возможностей ради скорости и минимальных затрат. Она подходит для:

Поскольку 4o mini экономична, разработчики могут встраивать её повсюду — в приложения, клиентские порталы, внутренние инструменты или даже в сервисы с ограниченным бюджетом — без больших расходов на использование.

Вместе GPT‑4o и GPT‑4o mini расширяют возможности современных GPT для реального времени, разговорных и мультимодальных сценариев, одновременно увеличивая круг тех, кто практически может строить и пользоваться передовыми моделями.

Несколько технических потоков проходят через каждое поколение GPT: масштабирование, обратная связь, безопасность и специализация. Вместе они объясняют, почему каждый релиз ощущается качественно иначе, а не просто «больше».

Ключевое открытие за прогрессом GPT — это законы масштабирования: при сбалансированном увеличении числа параметров, объёма данных и вычислений производительность, как правило, плавно улучшается по множеству задач.

Ранние модели показали, что:

Это породило системный подход:

Сырые GPT‑модели мощны, но индифферентны к ожиданиям пользователей. RLHF формирует их в полезных ассистентов:

Со временем это перерасло в комбинацию инструкционного тюнинга + RLHF: сначала дообучение на множестве пар «инструкция—ответ», затем RLHF для дальнейшей шлифовки поведения. Эта связка лежит в основе взаимодействия в стиле ChatGPT.

С ростом возможностей возросла и потребность в системных оценках безопасности и политиках применения.

Технические практики включают:

Эти механизмы итеративно совершенствуются: новые оценки выявляют режимы сбоев, которые возвращаются в данные обучения, reward‑модели и фильтры.

Ранние релизы сосредотачивались вокруг одной «флагманской» модели с несколькими более мелкими вариантами. Со временем тренд сместился в сторону семейств моделей, оптимизированных под разные ограничения и кейсы:

Под капотом это отражает зрелую инфраструктуру: общие базовые архитектуры и пайплайны обучения, а затем целенаправленный дообучение и слои безопасности, формирующие портфель вместо единого монолита. Многомодельная стратегия стала определяющим техническим и продуктовым трендом в развитии GPT.

GPT‑модели превратили языковой ИИ из нишевого инструмента исследования в инфраструктуру, на которой теперь строят многие люди и организации.

Для разработчиков GPT выступают как гибкий «языковой движок». Вместо ручного написания правил отправляют естественноязыковую подсказку и получают текст, код или структурированные выходы.

Это изменило подход к проектированию ПО:

В результате GPT часто становится ядром продукта, а не дополнительной функцией.

Организации используют GPT как внутри, так и внешне.\n Внутри команды автоматизируют триаж поддержки, наброски писем и отчётов, помощь в программировании и анализ документов и логов. Во внешних продуктах GPT питает чат‑ботов, AI‑копилотов в офисных пакетах, ассистентов по коду, инструменты для контента и нишевые копилоты для финансов, права, здравоохранения и др.

API и хостинг‑продукты позволяют добавлять продвинутые языковые функции без управления инфраструктурой или обучения собственных больших моделей, снижая порог входа для малого и среднего бизнеса.

Исследователи применяют GPT для генерации идей, создания кода для экспериментов, черновиков статей и вербализации гипотез. Преподаватели и студенты используют модели для объяснений, практических вопросов, репетиторства и языковой поддержки.

Писатели и дизайнеры пользуются GPT для структуры, генерации идей, world‑building и шлифовки текстов. Модель скорее ускоряет творческий процесс, чем полностью его заменяет.

Широкое распространение GPT вызывает серьёзные опасения. Автоматизация может сменить или сместить рабочие места, создавая спрос на новые навыки.\n Поскольку GPT обучены на данных людей, они могут отражать и усиливать социальные предубеждения при недостаточной фильтрации. Модель может генерировать правдоподобную, но неверную информацию или быть использована для массовой генерации спама и пропаганды.

Эти риски подтолкнули развитие техник выравнивания, политик использования, мониторинга и инструментов для выявления происхождения контента. Балансирование мощных новых приложений с безопасностью, справедливостью и доверием остаётся открытой задачей по мере продвижения GPT.

По мере роста возможностей моделей GPT ключевые вопросы смещаются от «можем ли мы их построить?» к «как нам их строить, разворачивать и регулировать?»

Эффективность и доступность. GPT‑4o и GPT‑4o mini намекают на будущее, в котором модели высокого качества работают дешево, на меньших серверах и, возможно, на персональных устройствах. Вопросы:

Персонализация без переобучения. Пользователи хотят, чтобы модели запоминали предпочтения и стиль, не раскрывая данные и не сдвигая модель в сторону предвзятости. Открытые вопросы:

Надёжность и рассуждение. Даже лучшие модели всё ещё галлюцинируют или ведут себя непредсказуемо при сдвиге распределения. Исследования направлены на:

Безопасность и выравнивание в масштабе. По мере роста автономии моделей выравнивание с человеческими ценностями и поддержание этого выравнивания при постоянных обновлениях остаются открытой проблемой. Это включает культурную плюрализм: чьи ценности закладываются и как обрабатывать разногласия?

Регулирование и стандарты. Государства и отраслевые группы разрабатывают правила для прозрачности, использования данных, маркировки и отчётности об инцидентах. Вопросы:

Скорее всего будущие GPT‑системы будут более эффективны, более персонализированы и глубже интегрированы в инструменты и организации. Вместе с новыми возможностями ожидаются более формальные практики безопасности, независимая оценка и понятные пользовательские настройки. История от GPT‑1 до GPT‑4 показывает устойчивый прогресс, но также подчёркивает, что технические достижения должны сопровождаться управлением, общественным диалогом и тщательной оценкой влияния в реальном мире.

GPT (Generative Pre-trained Transformer) — это большие нейронные сети, обученные предсказывать следующее слово в последовательности. Делая это в масштабе на гигантских корпусах текста, они усваивают грамматику, стиль, факты и схемы рассуждений. После обучения они могут:

Понимание истории проясняет:

Это также помогает установить реалистичные ожидания: GPT — мощные модели распознавания паттернов, но не безошибочные оракулы.

Ключевые вехи включают:

Инструкция‑тюнинг и RLHF делают поведение моделей ближе к тому, чего хотят люди.

Вместе они:

GPT-4 отличается от ранних моделей по нескольким параметрам:

Эти изменения переводят GPT-4 из роли «генератора текста» в роль универсального помощника.

GPT-4o и GPT-4o mini оптимизированы прежде всего для скорости, стоимости и реального времени, а не только для пиковых возможностей.

Они делают продвинутые возможности GPT экономически доступными для более широкого круга задач и пользователей.

Разработчики обычно используют GPT для:

Поскольку доступ идёт через API, команды интегрируют возможности без обучения и хостинга собственных больших моделей.

У современных GPT‑моделей есть важные ограничения:

Для критических применений результаты следует проверять, ограничивать с помощью инструментов (поиск, валидаторы) и сопровождать человеческим контролем.

Несколько направлений, которые, вероятно, будут формировать будущее GPT:

Направление — в сторону более способных, но одновременно более контролируемых и подотчётных систем.

Рекомендации практического характера:

Эффективное использование GPT значит сочетать их сильные стороны с механизмами защиты и грамотным дизайном продукта.