Определите цели, вопросы и метрики успеха

Прежде чем отслеживать что‑то, решите, что именно «принятие функции» означает для вашего продукта. Если вы пропустите этот шаг, то соберёте много данных — и всё равно будете спорить на митингах о том, что они «означают».

Определите «принятие» простыми словами

Принятие обычно не сводится к одному моменту. Выберите одно или несколько определений, которые соответствуют тому, как доставляется ценность:

- Использование: пользователь попробовал функцию хотя бы раз (полезно при новых запусках).

- Повторное использование: пользователь использовал её снова в заданном интервале (полезно для вырабатывания привычки).

- Достижение ценности: пользователь достиг результата, ради которого предназначена функция (часто лучший сигнал).

Пример: для «Сохранённых поисков» принятие может быть создал сохранённый поиск (использование), запустил его 3+ раза за 14 дней (повтор) и получил оповещение и кликнул по нему (достижение ценности).

Перечислите решения, которые должно поддерживать отслеживание

Ваше отслеживание должно отвечать на вопросы, приводящие к действию, например:

- Что нам следует улучшить, если оно используется, но не даёт ценности?

- Что нам следует удалить, если это усложняет продукт и имеет низкое принятие?

- Что нам следует продвигать, если это повышает удержание или приводит к апсейлу?

Пишите эти вопросы как решения (например: «Если активация падает после релиза X, откатываем изменения в онбординге.»).

Определите заинтересованные стороны и как они будут использовать отчёты

Разные команды нуждаются в разных представлениях:

- Product (PM): принятие по сегментам, влияние после релиза, вехи достижения ценности.

- Growth/Marketing: эффект кампаний, конверсии воронок, реактивация.

- Support/Success: какие функции коррелируют с меньшим количеством тикетов или более высокими продлениями.

- Engineering: здоровье инструментации, изменения в объёме событий, метки релизов.

Установите метрики успеха и ритм обзора

Выберите небольшой набор метрик для еженедельного обзора и лёгкую проверку после релиза. Определите пороги (например, «Уровень принятия ≥ 25% среди активных пользователей за 30 дней»), чтобы отчёты приводили к решениям, а не к спорам.

Спланируйте данные, которые нужны: пользователи, функции, события, результаты

Прежде чем внедрять инструментирование, решите, какие «сущности» будет описывать система аналитики. Если вы правильно определите эти сущности, отчёты останутся понятными по мере развития продукта.

Начните с основных сущностей

Опишите каждую сущность простыми словами, затем переведите их в ID, которые будете хранить:

- User: человек, использующий приложение (может быть анонимным, затем аутентифицированным).

- Account / workspace: платящий клиент или команда, к которой принадлежат несколько пользователей.

- Session: визит в рамках времени (полезно для анализа вовлечённости и отладки; опционально).

- Feature: именованная способность, для которой хотите измерять принятие (часто группа событий, а не одно кликовое действие).

- Event: действие или системное событие, которое можно записать (например,

project_created, invite_sent).

- Outcome: веха ценности, которой должны достигнуть пользователи/аккаунты (например, «первый отчёт отправлен», «подписка активирована»).

Запишите минимальные свойства для каждого события: user_id (или anonymous ID), account_id, метка времени и несколько релевантных атрибутов (план, роль, устройство, feature flag и т. п.). Избегайте «слишком много всего» «на всякий случай».

Выберите виды представлений принятия, которые будете поддерживать

Подберите углы отчётности, соответствующие целям продукта:

- Воронки (пошаговая активация)

- Когорты (группы по дате регистрации, плану, каналу)

- Удержание (возвращаются ли и повторяют ключевые действия?)

- Пути (распространённые последовательности до/после вехи)

- Время до первой ценности (как долго до первого значимого результата)

Дизайн событий должен упростить вычисление этих показателей.

Решите платформы и целевые показатели производительности

Чётко определите область: сначала только веб, или сразу веб + мобильные. Кросс‑платформенное отслеживание проще, если рано стандартизировать названия событий и свойства.

Наконец, задайте неотменяемые цели: допустимое влияние на производительность страницы, задержку при приёме событий (насколько свежими должны быть панели) и время загрузки дашборда. Эти ограничения будут направлять выборы по трекингу, хранению и запросам.

Спроектируйте схему трекинга событий, которая останется последовательной

Хорошая схема трекинга — это не «отслеживать всё», а сделать события предсказуемыми. Если имена событий и свойства начинают расходиться, дашборды ломаются, аналитики перестают доверять данным, а инженеры боятся добавлять новое инструментирование.

Начните с понятного соглашения об именах

Выберите простой, повторяемый шаблон и придерживайтесь его. Частый выбор — verb_noun:

viewed_pricing_pagestarted_trialenabled_featureexported_report

Используйте одно и то же время (прошедшее или настоящее) и избегайте синонимов (clicked, pressed, tapped), если они не означают разные вещи.

Определите обязательные свойства («контракт»)

Каждое событие должно нести небольшой набор обязательных свойств, чтобы потом можно было сегментировать, фильтровать и соединять данные надежно. Минимум:

user_id (nullable для анонимных пользователей, но присутствует, когда известен)account_id (если продукт B2B/мультиситочный)timestamp (по возможности генерировать на сервере)feature_key (стабильный идентификатор, например "bulk_upload")plan (например, free, pro, enterprise)

Эти свойства делают отслеживание принятия функций и анализ поведения гораздо проще, потому что не придётся гадать, чего не хватает в каждом событии.

Разрешите опциональные свойства — но аккуратно

Опциональные поля добавляют контекст, но их легко переусердствовать. Типичные опции:

device, os, browserpage, referrerexperiment_variant (или ab_variant)

Держите опциональные свойства последовательными между событиями (одинаковые ключи, одинаковые форматы значений) и документируйте «допустимые значения», где возможно.

Версионируйте схему и напишите спецификацию инструментирования

Предположите, что схема будет эволюционировать. Добавьте event_version (например, 1, 2) и обновляйте её при изменении смысла или обязательных полей.

Наконец, напишите спецификацию инструментирования, где перечислено каждое событие, когда оно отправляется, обязательные/опциональные свойства и примеры. Держите этот документ в системе контроля версий рядом с кодом, чтобы изменения схемы ревьюились как код.

Решите вопрос идентичности: анонимные, залогиненные и представления на уровне аккаунта

Если модель идентичности ненадёжна, метрики принятия будут шумными: воронки не будут сходиться, удержание ухудшится, а «активные пользователи» завышены из‑за дубликатов. Цель — поддерживать три представления одновременно: анонимные посетители, залогиненные пользователи и активность по аккаунту/рабочему пространству.

Анонимные vs идентифицированные пользователи (когда связывать)

Каждое устройство/сессию начинайте с anonymous_id (cookie/localStorage). В момент аутентификации связывайте анонимную историю с user_id.

Связывайте идентичности, когда пользователь доказал владение аккаунтом (успешный логин, подтверждённая magic link, SSO). Избегайте связывания по слабым сигналам (введённый в форме email), если вы явно не отмечаете это как «pre-auth».

Логин, логаут и переключение аккаунтов без поломки метрик

Обрабатывайте переходы аутентификации как события:

login_success (включает user_id, account_id и текущий anonymous_id)logoutaccount_switched (из account_id → account_id)

Важно: не меняйте анонимный cookie при логауте. Если вы его ротируете, сессии фрагментируются и уникальные пользователи завышаются. Вместо этого сохраняйте стабильный anonymous_id, но переставайте прикреплять user_id после выхода.

Правила слияния идентичностей (и как избежать двойного учёта)

Определите правила слияния явно:

- Слияние пользователей: отдавайте предпочтение стабильному внутреннему

user_id. Если нужно сливать по email, делайте это на сервере и только для верифицированных email. Храните аудит-трейл.

- Слияние аккаунтов: используйте стабильный

account_id/workspace_id, сгенерированный вашей системой, а не изменяемое имя.

При слиянии формируйте таблицу соответствий (old → new) и применяйте её последовательно при запросах или через задачу демпофона (backfill). Это предотвращает появление «двух пользователей» в когортных отчётах.

Храните стабильные ключи

Храните и отправляйте:

anonymous_id (стабильный для браузера/устройства)user_id (стабильный для человека)account_id (стабильный для рабочего пространства)

С этими тремя ключами можно измерять поведение до логина, принятие по пользователю и принятие по аккаунту без двойного учёта.

Выберите клиентское vs серверное отслеживание (и смешайте их)

Где вы отслеживаете события, влияет на их надёжность. События в браузере показывают, что пользователь пытался сделать; серверные события показывают, что действие действительно завершилось.

Клиентское отслеживание (браузер)

Используйте клиентское отслеживание для UI‑взаимодействий и контекста, доступного только в браузере. Типичные примеры:

- Просмотры страниц/экранов, клики по кнопкам, переключения вкладок, открытие/закрытие модальных окон

- «Просмотр функции» (например, открыта страница настроек)

- Клиентский контекст: URL, referrer, UTM‑метки, устройство, размер вьюпорта, язык

Пакуйте события в батчи, чтобы снизить сетевой шум: храните в памяти, шлите каждые N секунд или при достижении N событий, а также при visibilitychange/page hide.

Серверное отслеживание (API и фоновые задания)

Используйте серверное отслеживание для событий, которые представляют завершённый результат или чувствительны к биллингу/безопасности:

- Функция успешно включена/сохранена

- Приглашение принято, платёж успешен, экспорт сгенерирован

- Фоновые джобы: синхронизация завершена, отчёт доставлен, письмо отправлено

Серверное отслеживание обычно точнее: на него не влияют блокировщики рекламы, перезагрузки страницы или плохая связь.

Рекомендуемый подход: гибрид по умолчанию

Практичный паттерн: отслеживать намерение в клиенте и успех на сервере.

Например, отправляйте feature_x_clicked_enable (клиент) и feature_x_enabled (сервер). Обогащайте серверные события клиентским контекстом, передавая лёгкий context_id (или request ID) от браузера к API.

Надёжность: ретраи, backoff, офлайн‑буферизация

Добавьте устойчивость там, где события чаще всего теряются:

- Клиент: храните очередь в

localStorage/IndexedDB, пробуйте повторно с экспоненциальным бэкоффом, ограничьте попытки и дедуплицируйте по event_id.

- Сервер: ретрайте на транзиентных ошибках, используйте внутреннюю очередь и обеспечьте идемпотентность, чтобы повторный запрос не давал двойного учёта.

Такая смесь даёт богатый поведенческий контекст и надёжные метрики принятия.

Спланируйте архитектуру системы: приём, хранение и запросы

От спецификации до развёртывания

Быстро разверните и разместите ваше аналитическое веб‑приложение, затем итеративно улучшайте его по мере использования командами.

Приложение для аналитики принятия функций — это, в основном, конвейер: надёжно захватывать события, дешево хранить их и быстро запрашивать, чтобы люди доверяли результатам.

Основные компоненты (и зачем они нужны)

Начните с простого набора отдельных сервисов:

- Collector endpoint: небольшой HTTP‑сервис, принимающий события (из браузера, мобильных клиентов, бэкенда). Держите его лёгким — валидируйте базу, добавляйте серверные таймстампы и отвечайте быстро.

- Queue/stream: буферизует пики трафика и декуплирует приём и обработку (Kafka, Kinesis, Pub/Sub, SQS).

- Workers: потребляют стрим, обогащают, дедуплицируют, соблюдают схему и маршрутизируют данные в хранилище.

- Analytics store: оптимизирован для большого объёма append‑only событий (ClickHouse, BigQuery, Snowflake, Redshift).

- API: предоставляет согласованные эндпоинты для дашбордов (воронки, когорты, удержание) и проверки прав.

- UI: дашборды и инструменты исследования; держите их отдельно, чтобы менять логику хранения/запросов без переписывания фронта.

Если нужно быстро прототипировать внутреннее аналитическое веб‑приложение, платформа vibe‑coding вроде Koder.ai может помочь поднять UI дашборда (React) и бэкенд (Go + PostgreSQL) из спецификации в чате — полезно для получения рабочего среза до того, как вы укрепите конвейер.

Хранение: raw events vs агрегаты

Используйте два уровня:

- Append‑only raw events для аудита и репроцессинга. Рассматривайте это как источник правды.

- Агрегаты/материализованные представления для скорости (DAU по фиче, шаги воронки, таблицы когорт). Материализованные представления полезны, когда одни и те же запросы выполняются постоянно.

Реальное время vs батч (выбирайте по нуждам)

Выберите свежесть данных, которая реально нужна команде:

- Near real‑time (секунды/минуты) для мониторинга релизов, падений онбординга или инцидентов.

- Ежедневный батч для трендов, недельных отчётов и сводок для руководства — дешевле и проще.

Часто берут оба подхода: real‑time счётчики для «что происходит сейчас» и ночные джобы для пересчёта канонических метрик.

План масштабирования: партиционирование и рост

Проектируйте для роста заранее:

- По времени (день/месяц), чтобы держать запросы ограниченными и упростить политику хранения.

- По аккаунту/тенанту для B2B‑прав и производительности.

- Опционально по типу события, если несколько событий составляют основной объём.

Также спланируйте хранение (например, 13 месяцев raw, дольше для агрегатов) и путь для реплея, чтобы исправлять ошибки репроцессингом, а не заплатками в дашбордах.

Моделирование данных для событий и быстрых аналитических запросов

Хорошая аналитика начинается с модели, которая быстро отвечает на типовые вопросы (воронки, удержание, использование фич), без превращения каждого запроса в инженерную задачу.

Выберите двухуровневую стратегию баз данных

Большинству команд подходит два хранилища:

- Реляционная БД (Postgres/MySQL) для «стабильной» метадаты: пользователи, аккаунты, каталог фич, права доступа, конфигурация.

- Колоннарное/складское хранилище (ClickHouse/BigQuery/Snowflake) для высокообъёмных событий, где нужны быстрые сканы и агрегации.

Такое разделение держит продуктовую БД лёгкой и делает аналитические запросы быстрее и дешевле.

Определите основные таблицы (и держите их простыми)

Практический минимум:

- raw_events: одна строка на событие (event_name, timestamp, user_id/anonymous_id, session_id, account_id, properties JSON, source).

- users: профиль пользователя + текущие идентификаторы.

- accounts: сущность компании/организации для B2B‑сводок.

- feature_catalog: канонический список фич (key, display_name, category, lifecycle status).

- sessions: границы сессий (start/end, device, referrer) для анализа поведения.

- aggregates: предвычисленные ежедневные/недельные метрики (DAU, feature_active_users, счёты шагов воронки).

В хранилище денормализуйте часто запрашиваемые поля (например, скопируйте account_id в события), чтобы избегать дорогих join‑ов.

Контролируйте стоимость и скорость через хранение + партиционирование

Партиционируйте raw_events по времени (день — часто) и опционально по workspace/app. Применяйте политику хранения по типу события:

- Сохраняйте важные продуктовые события дольше (месяцы/годы).

- Быстро удаляйте шумные debug‑события.

Это предотвращает «бесконечный рост», ставший вашей главной проблемой аналитики.

Встроенные проверки качества данных в модель

Рассматривайте проверки качества как часть моделирования, а не как позднюю чистку:

- Отсутствие обязательных свойств (например, feature_key).

- Плохие метки времени (даты в будущем, проблемы с таймзонами).

- Дубли событий (повторы, двойное инструментирование).

Храните результаты валидации (или таблицу rejected_events), чтобы отслеживать здоровье инструментирования и исправлять проблемы до того, как дашборды начнут врать.

Вычисление метрик принятия: воронки, когорты, удержание и пути

Сохраняйте полный контроль над кодом

Генерируйте, проверяйте и экспортируйте исходный код, чтобы команда долгосрочно владела конвейером.

Когда события текут, следующий шаг — превращать клики в метрики, отвечающие на вопрос: «Действительно ли эта функция принимается и кем?» Фокусируйтесь на четырёх взаимодополняющих видах: воронках, когортах, удержании и путях.

Воронки: принятие как последовательность (а не единичный клик)

Определяйте воронку на каждую функцию, чтобы видеть, где пользователи отваливаются. Практический шаблон:

- Discovery → пользователь увидел точку входа функции (кнопка, пункт меню, баннер)

- First use → первое значимое взаимодействие (

feature_used)

- Repeat use → второе использование в разумном окне (например, 7 дней)

- Value action → действие, подтверждающее ценность (создан экспорт, включена автоматизация, отчёт отправлен)

Привязывайте шаги воронки к доверенным событиям и давайте шагам OR‑условия, если «первое использование» может происходить разными путями (например, import_started OR integration_connected).

Когорты: сравнивайте похожее с похожим

Когорты помогают оценивать улучшения во времени без смешения старых и новых пользователей. Частые когорты:

- Новые пользователи по неделям (неделя регистрации)

- Активированные пользователи (достигли activation event)

- Удержанные пользователи (вернулись и сделали что‑то значимое)

- Power users (высокая частота или продвинутые действия)

Отслеживайте тарифы принятия внутри когорты, чтобы видеть, помогают ли изменения онбординга или UI.

Удержание: «возвращаются ли и продолжают ли пользоваться?»

Удержание полезно, когда привязано к фиче, а не просто к «запуску приложения». Определяйте его как повторное выполнение ключевого события фичи (или value action) на День 7/30. Также следите за «временем до второго использования» — часто это более чувствительный индикатор, чем сырое удержание.

Сегментация и пути: кто принимает, и как они к этому приходят

Разбивайте метрики по измерениям, которые объясняют поведение: plan, role, industry, device, acquisition channel. Сегменты часто показывают, что в одной группе принятие высоко, а в другой почти нулевое.

Добавьте анализ путей, чтобы найти типичные последовательности до и после принятия (например, пользователи, которые принимают, часто посещают pricing, затем docs, затем подключают интеграцию). Используйте это для улучшения онбординга и удаления «мертвых концов».

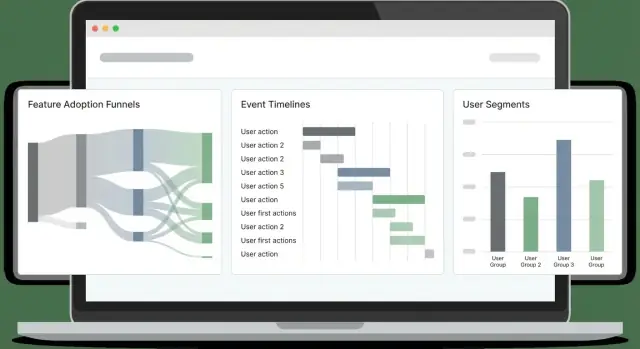

Делайте дашборды, которыми люди будут реально пользоваться

Дашборды проваливаются, когда пытаются обслужить всех одной «мастер‑страницей». Вместо этого проектируйте несколько узко направленных страниц под конкретные решения и делайте каждую страницу ответом на простой вопрос.

Начните со страниц по аудитории

Обзор для руководства — быстрый чек здоровья: тренд принятия, активные пользователи, топ‑фичи и заметные изменения после релиза. Страница глубокого анализа фичи — для PM и инженеров: откуда приходят пользователи, где они отваливаются и какие сегменты ведут себя иначе.

Простейшая структура, которая работает:

- Overview: тренд принятия, тренд удержания и несколько ключевых KPI

- Feature page: воронка, удержание по когортам, частота использования для одной фичи

- Segment explorer: сравнение планов, регионов или размеров рабочих пространств

Облегчите исследование (без хаоса)

Давайте графики трендов для «что происходит», сегментированные разрезы для «кто», и drill‑down для «почему». Drill‑down должен позволять кликнуть по столбцу/точке и увидеть примеры пользователей или рабочих пространств (с учётом прав), чтобы команды могли валидировать паттерны и смотреть реальные сессии.

Держите фильтры одинаковыми на всех страницах, чтобы не заставлять пользователей переучиваться. Самые полезные фильтры для трекинга принятия:

- Диапазон дат

- План / tier

- Атрибуты workspace/account (размер, индустрия)

- Регион

- Версия приложения (или канал релиза)

Шеринг, экспорт и сохранённые представления

Дашборды становятся частью работы, когда люди могут поделиться точным видом. Добавьте:

- Export в CSV для быстрого анализа в таблицах

- Share с линком на saved view (фильтры + состояние графиков + выбранный сегмент)

- Опциональные расписания email/Slack‑сводок, которые ведут к сохранённому виду

Если вы строите это в продуктовую аналитику, подумайте о странице /dashboards с «Pinned» сохранёнными видами, чтобы стейкхолдеры всегда попадали на важные отчёты.

Добавьте алерты, аномалии и метки релизов

Дашборды хороши для исследования, но команды обычно узнают о проблемах по жалобам клиентов. Алерты меняют это: вы узнаёте о поломке через минуты и видите, что изменилось.

Настройте правила алертов под реальные сценарии сбоев

Начните с нескольких сигналов высокой важности для защиты потока принятия:

- Резкое падение first use (например, события «Feature X: first_use» в час упали на 40% относительно базовой линии). Часто это UI‑регрессия, изменение прав или баг в трекинге.

- Всплеск ошибок (ошибки клиента, API 4xx/5xx или

feature_failed события). Включайте абсолютные пороги и относительные (ошибок на 1000 сессий).

- Отсутствие событий после релиза (количество событий почти нулевое). Это ловит сломанное инструментирование после рефакторинга.

Держите определения алертов читаемыми и под версионным контролем (например, YAML в репо), чтобы они не стали тайным знанием.

Детекция аномалий: начните просто

Простая детекция аномалий часто эффективна без сложного ML:

- Сравнивайте текущее значение с скользящим средним (последние 7 дней, тот же час дня)

- Учитывайте сезонность там, где важно (будние/выходные, рабочее время/ночь)

- Добавьте правило минимального объёма, чтобы метрики с низким трафиком не спамили

Метки релизов: таймлайн «что изменилось»

Встраивайте поток релиз‑маркетов прямо в графики: деплои, rollout‑флаги, изменения цен, корректировки онбординга. Каждая метка должна включать штамп времени, владельца и короткую заметку. Когда метрики смещаются, вы сразу увидите возможные причины.

Маршрутизация, «тихие часы» и ответственность

Шлите алерты в email и Slack‑каналы, но поддерживайте quiet hours и эскалацию (warn → page) для серьёзных инцидентов. Каждый алерт должен иметь владельца и ссылку на runbook (даже короткую, например /docs/alerts), описывающую первые шаги проверки.

Конфиденциальность, согласие и контроль доступа

Прототипируйте приём данных за считанные часы

Создайте сервис-коллектор и базовый UI конвейера по спецификации из чата с Koder.ai.

Данные аналитики быстро превращаются в персональные, если не следить. Рассматривайте приватность как часть дизайна трекинга: это снижает риск, повышает доверие и избавляет от дорогостоящей переделки.

Согласие: собирайте только то, на что согласился пользователь

Уважайте требования по согласию и дайте пользователям опцию отключиться. Практически это значит: слой трекинга должен проверять флаг согласия перед отправкой событий и иметь возможность прекратить трекинг в середине сессии, если пользователь изменил решение.

Для регионов с жёсткими правилами рассмотрите «consent‑gated» функции:

- Загружайте библиотеки аналитики только после согласия (а не просто «переставайте слать»)

- Храните решение о согласии с таймстампом и версией, чтобы доказать, что принималось

- Предоставьте простой UI настроек в приложении

Минимизируйте чувствительные данные (и не кладите их в события)

Минимизируйте сбор чувствительных данных: не отправляйте сырые email в события; используйте хеши/opaque ID. Полезно описывать в полезащих полях только поведение (что произошло), а не личность. Если нужно связать событие с аккаунтом, шлите внутренний user_id/account_id и храните мэппинг в вашей БД с надлежащими контролями доступа.

Также избегайте сбора:

- Текстовых полей (часто содержат случайную персональную информацию)

- Полных URL с токенами или query‑параметрами

- Всего, что вы не хотели бы увидеть на скриншоте

Будьте прозрачны: документация и понятная страница приватности

Документируйте, что собираете и зачем; давайте ссылку на понятную страницу приватности. Создайте лёгкий «словарь трекинга», объясняющий каждое событие, его цель и период хранения. В UI продукта добавьте ссылку на /privacy и сделайте текст читаемым: что вы собираете, чего не собираете и как отключиться.

Контроль доступа: ограничьте, кто видит данные на уровне пользователя

Реализуйте ролевой доступ, чтобы только уполномоченные команды видели пользовательские данные. Большинству нужен только агрегированный доступ; raw events оставьте небольшой группе (data/product ops). Добавьте аудит‑логи для экспортов и lookup‑ов пользователей и установите автоматическое истечение старых данных.

При правильном подходе приватность не замедлит аналитику — она сделает систему безопаснее, понятнее и проще в поддержке.

План релиза, QA и долгосрочное сопровождение

Доставка аналитики похожа на фичу: небольшой верифицируемый релиз сначала, затем постепенная итерация. Обращайтесь с работой по трекингу как с продакшен‑кодом: владельцы, ревью, тесты.

Начните с малого: «golden events»

Начните с узкого набора golden events для одной области фич (например: Feature Viewed, Feature Started, Feature Completed, Feature Error). Они должны напрямую отвечать на вопросы, которые команда будет задавать еженедельно.

Ограничение объёма намеренно: меньше событий — быстрее проверить качество, и вы поймёте, какие свойства действительно нужны (plan, role, source, feature variant) перед масштабом.

Валидируйте трекинг в staging и production

Используйте чек‑лист перед тем, как считать работу завершённой:

- Событие срабатывает один раз (нет двойного трекинга при refresh, retry или SPA‑смене маршрута)

- Обязательные свойства присутствуют и имеют корректные типы

- PII исключено или замаскировано

- События приходят в ожидаемую задержку

- Идентичности связываются корректно (anonymous → logged‑in)

Добавьте примерные запросы, которые можно запускать в staging и prod. Примеры:

- «Count events by name in the last 30 minutes» (ловит отсутствие/лишние события)

- «Top 20 property values for

feature_name» (ловит опечатки типа Search vs search)

- «Completion rate = Completed / Started by app version» (ловит регрессии после релиза)

Workflow QA инструментирования для каждого релиза

Включайте инструментирование в процесс релиза:

- Изменение трекинга в том же PR, что и UI/API‑изменение

- Ревьювер проверяет имена событий/свойства по схеме

- QA проверяет события в staging на тестовом аккаунте

- В заметках к релизу указываются изменения в трекинге (новые события, переименованные поля)

Долгосрочное сопровождение (схема, backfills, документация)

Планируйте изменения: не удаляйте события, а помечайте deprecated, версионируйте свойства при смене смысла и проводите периодические аудиты.

Когда вы добавляете обязательное свойство или чините баг, решайте, нужен ли backfill (и документируйте периоды с частичными данными).

Наконец, держите лёгкое руководство по трекингу в документации и добавьте ссылку на него в шаблоны PR и дашборды. Хорошая отправная точка — короткий чек‑лист по /blog/event-tracking-checklist.