Что объясняет эта история (и почему это важно)

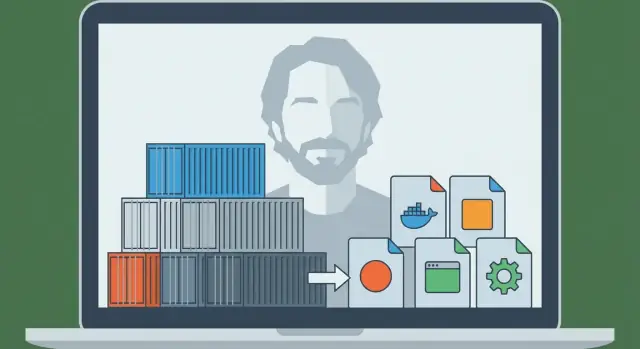

Соломон Хайкс — инженер, который помог превратить давнюю идею — изоляцию ПО, чтобы оно работало одинаково везде — в то, чем команды могли бы пользоваться в повседневной работе. В 2013 году проект, который он представил миру, стал Docker, и это быстро изменило способ доставки приложений компаниями.

В то время боль была простой и знакомой: приложение работало на ноутбуке разработчика, затем вело себя иначе на машине коллеги, а потом ломалось на стейджинге или в проде. Эти «неконсистентные среды» были не просто раздражающими — они замедляли релизы, усложняли воспроизведение ошибок и порождали бесконечные передачи ответственности между разработкой и эксплуатацией.

Проблема, которую решил Docker (простыми словами)

Docker дал командам повторяемый способ упаковать приложение вместе с зависимостями, которых оно ожидает, так что приложение может запускаться одинаково на ноутбуке, тестовом сервере или в облаке.

Именно поэтому говорят, что контейнеры стали «единицей упаковки и развёртывания по умолчанию». Проще говоря:

- Единица упаковки: то, что вы собираете и храните (образ контейнера)

- Единица развёртывания: то, что вы запускаете в среде (контейнер)

Вместо развёртывания «ZIP-файла плюс страница в вики с шагами настройки» многие команды стали разворачивать образ, который уже включает всё необходимое приложению. Результат — меньше сюрпризов и более быстрые, предсказуемые релизы.

Что вы получите из этой истории

Эта статья сочетает историю и практические концепции. Вы узнаете, кем был Соломон Хайкс в этом контексте, что Docker ввёл в нужный момент и базовые механики — без предположения глубокой инфраструктурной подготовки.

Вы также увидите, где контейнеры вписываются сегодня: как они связаны с CI/CD и практиками DevOps, почему позже понадобились оркестраторы вроде Kubernetes и что контейнеры не решают автоматически (особенно в вопросах безопасности и доверия).

К концу вы должны уметь ясно и уверенно объяснить, почему «отправлять как контейнер» стало общепринятым предположением для современного развёртывания приложений.

До Docker: почему доставлять приложения было так сложно

До того как контейнеры стали мейнстримом, перенос приложения с ноутбука разработчика на сервер часто был сложнее, чем само написание приложения. Командам не хватало таланта — им не хватало надёжного способа перемещать «то, что работает» между средами.

«Работает у меня» — реальная проблема

Разработчик мог запускать приложение идеально на своём компьютере, а потом наблюдать, как оно падает на стейджинге или в проде. Не потому что код изменился, а потому что изменилась среда. Разные версии ОС, отсутствующие библиотеки, немного другие конфигурационные файлы или база данных с отличающимися настройками могли всё сломать.

Конфликты зависимостей и длинные инструкции по настройке

Многие проекты опирались на длинные и хрупкие инструкции по установке:

- установить runtime-окружение языка

- скомпилировать системный пакет

- зафиксировать конкретную версию библиотеки

- задать переменные окружения в нужном месте

Даже аккуратно написанные инструкции быстро устаревали. Один коллега, обновив зависимость, мог случайно сломать онбординг для всех остальных.

Хуже того, два приложения на одном сервере могли требовать несовместимых версий одного и того же рантайма или библиотеки, что вынуждало команды прибегать к костылям или заводить отдельные машины.

Упаковка и развёртывание были раздельными и не совпадали

«Упаковка» часто означала производство ZIP-архива, tarball или инсталлятора. «Развёртывание» — другой набор скриптов и шагов: подготовить машину, сконфигурировать её, скопировать файлы, перезапустить сервисы и надеяться, что ничего другое на сервере не пострадало.

Эти два аспекта редко сходились: пакет не полностью описывал нужную среду, а процесс деплоя сильно зависел от того, что целевой сервер был подготовлен «как надо».

Недостающее звено: портативная единица

Командам нужна была единая портативная единица, которая может путешествовать со своими зависимостями и запускаться одинаково на ноутбуке, тестовом сервере и в проде. Это давление — повторяемая настройка, меньше конфликтов и предсказуемое развёртывание — подготовило почву для того, чтобы контейнеры стали стандартным способом доставки приложений.

Соломон Хайкс и рождение Docker (высокоуровневый таймлайн)

Docker не начался как грандиозный план «изменить софт навсегда». Он вырос из практической инженерной работы под руководством Соломона Хайкса при создании платформы как услуги. Команде нужен был повторяемый способ паковать и запускать приложения на разных машинах без привычных «работает на моём ноутбуке» сюрпризов.

От платформенной проблемы к переиспользуемому инструменту

До того как Docker стал известен, потребность была проста: доставлять приложение с зависимостями, запускать его надёжно и делать это снова и снова для многих клиентов.

Проект, который стал Docker, возник как внутренняя решение — то, что делало деплои предсказуемыми и среды согласованными. Как только команда поняла, что механизм упаковки и запуска полезен шире их собственного продукта, они выпустили его публично.

Этот релиз имел значение, потому что превратил частный подход к деплою в общий набор инструментов, который индустрия могла принять, улучшить и стандартизировать.

«Docker» и «контейнеры» — не одно и то же

Их легко смешивать, но это разные вещи:

- Контейнеры — концепция: изолированные процессы, использующие возможности ОС (namespaces, cgroups и т.д.).

- Docker (проект и потом компания) — продуктовый опыт, который сделал контейнеры доступными обычным разработчикам.

Контейнеры существовали до Docker в разных формах. Изменилось то, что Docker упаковал рабочий процесс в удобный набор команд и соглашений — собрать образ, запустить контейнер, поделиться ним с кем-то ещё.

Вехи, изменившие повседневную работу разработчиков

Несколько известных шагов перевели Docker из «интересного» в «де-факто стандарт»:

- Простой формат сборки (Dockerfile) — упаковка приложения стала похожа на запись рецепта, а не поддержку хрупких инструкций.

- Стандартный артефакт (образ) — команды наконец могли относиться к средам как к версионируемым поставкам.

- Простота обмена через реестры — рабочий цикл «pull and run» стал возможен на ноутбуках, CI и в проде.

- Экосистема и усилия по стандартизации — образы и рантаймы стали менее завязанными на одного вендора и больше похожими на общий интерфейс индустрии.

Практический результат: разработчики перестали спорить, как воспроизвести среду, и начали отправлять один и тот же исполняемый блок везде.

Контейнеры 101: что это такое (и что нет)

Контейнеры — способ упаковать и запустить приложение так, чтобы оно вело себя одинаково на вашем ноутбуке, машине коллеги и в проде. Главная идея — изоляция без полноценной новой машины.

Контейнеры против виртуальных машин (простая модель)

Виртуальная машина (VM) — как аренда целой квартиры: у вас собственная дверь, собственные коммуникации и своя копия ОС. Поэтому ВМ могут запускать разные типы ОС рядом, но они тяжелее и дольше стартуют.

Контейнер — как аренда запертой комнаты в общем здании: вы приносите мебель (код приложения + библиотеки), но коммуникации здания (ядро хоста) общие. Вы получаете отделение от других комнат, но не запускаете полноценную ОС каждый раз.

Как контейнеры изолируют приложения (концептуально)

В Linux контейнеры опираются на встроенные механизмы изоляции, которые:

- дают процессам собственный «вид» системы (так приложение A не видит файлы и процессы приложения B)

- ограничивают и учитывают ресурсы как CPU и память (чтобы «шумное» приложение не заглушало остальные)

Не нужно знать все детали ядра, чтобы пользоваться контейнерами, но полезно понимать, что они используют возможности ОС — а не волшебство.

Почему люди их полюбили

Контейнеры стали популярны, потому что они:

- Лёгкие: меньше, чем образы ВМ, поскольку не включают полный ОС

- Быстро стартуют: часто за секунды (или быстрее), что хорошо для масштабирования и тестирования

- Предсказуемые: одинаковая упакованная среда уменьшает проблемы «работает у меня»

Что контейнеры не делают

Контейнеры по умолчанию не являются границей безопасности. Поскольку контейнеры делят ядро хоста, уязвимость на уровне ядра может повлиять на несколько контейнеров. Также это означает, что нельзя запускать Windows-контейнер на Linux-ядре (и наоборот) без дополнительной виртуализации.

Итак: контейнеры улучшают упаковку и согласованность, но всё ещё требуют продуманной безопасности, патчей и практик конфигурации.

Модель Docker: Dockerfile, образ, контейнер

Docker во многом преуспел, потому что дал командам простую мысленную модель с понятными «частями»: Dockerfile (инструкции), image (собранный артефакт) и container (запущенная инстанция). Как только вы понимаете эту цепочку, остальная экосистема Docker начинает становиться понятной.

Dockerfile: повторяемый рецепт

Dockerfile — это текстовый файл, который описывает как собрать окружение приложения пошагово. Думайте о нём как о рецепте: сам по себе он никого не накормит, но он точно подсказывает, как получить один и тот же результат каждый раз.

Типичные шаги в Dockerfile: выбрать базу (например runtime языка), скопировать код приложения, установить зависимости и указать команду для запуска.

Образ против контейнера: чертёж и запущенное приложение

Образ — это результат сборки Dockerfile. Это упакованный снимок всего необходимого для запуска: код, зависимости и настройки по умолчанию. Образ «не живой» — это как запечатанная коробка, которую можно отправить.

Контейнер — это то, что вы получаете при запуске образа. Это живой процесс с собственной изолированной файловой системой и настройками. Можно запускать, останавливать, перезапускать и создавать несколько контейнеров из одного образа.

Слои и кеширование: почему сборки могут быть быстрыми

Образы строятся в слоях. Каждая инструкция в Dockerfile обычно создаёт новый слой, и Docker старается переиспользовать (кешировать) слои, которые не изменились.

Проще говоря: если вы меняете только код приложения, Docker часто может переиспользовать слои, которые устанавливали системные пакеты и зависимости, что делает пересборки гораздо быстрее. Это также поощряет повторное использование между проектами — многие образы делят общие базовые слои.

Минимальный end-to-end поток

Вот как выглядит поток «рецепт → артефакт → запущенная инстанция":

FROM node:20-alpine

WORKDIR /app

COPY package*.json ./

RUN npm ci

COPY . .

CMD ["node", "server.js"]

- Dockerfile: инструкции выше

- Собрать образ:

docker build -t myapp:1.0 .

- Запустить контейнер:

docker run --rm -p 3000:3000 myapp:1.0

Это основное обещание, которое популяризовал Docker: если вы можете собрать образ, вы сможете запустить одно и то же надёжно — на ноутбуке, в CI или на сервере — без переписывания шагов установки каждый раз.

С ноутбука в команду: реестры и обмен образами

Сохраняйте полный контроль над исходниками

Экспортируйте полный исходный код, чтобы команда могла запускать его в собственном пайплайне.

Запуск контейнера на своём ноутбуке полезен, но настоящий перелом произошёл, когда команды могли поделиться точной сборкой и запустить её везде, без спора «у меня работает». Docker сделал обмен образами таким же привычным, как обмен кодом.

Что такое реестр (простыми словами)

Реестр контейнеров — это хранилище для образов. Если образ — это упакованное приложение, то реестр — место, где вы храните версии, чтобы другие люди и системы могли их подтянуть.

Реестры поддерживают простой рабочий цикл:

- Push: загрузить собранный образ

- Pull: скачать образ, собранный кем-то другим

- Version: хранить несколько именованных релизов, чтобы можно было откатиться или продвинуться вперёд

Публичные реестры (как Docker Hub) упростили старт. Но большинству команд быстро понадобился реестр, соответствующий их правилам доступа и требованиям комплаенса.

Теги: небольшая привычка, предотвращающая большие проблемы

Образы обычно идентифицируются как name:tag — например myapp:1.4.2. Тег — это больше чем метка: это способ согласовать, какую именно сборку запускать.

Распространённая ошибка — полагаться на latest. Это удобно на слух, но неясно: «latest» может поменяться без предупреждения, из‑за чего среды начинают расходиться. Одна и та же команда может подтянуть более новую сборку, чем предыдущая — даже если никто не планировал апгрейд.

Лучшие практики:

- Использовать явные версии (например

1.4.2) для релизов

- Тегировать также коммит-хеш для трассируемости

- Рассматривать теги как часть процесса релиза, а не как мелочь

Почему приватные реестры важны для реальных команд

Как только вы делитесь внутренними сервисами, платными зависимостями или корпоративным кодом, обычно нужен приватный реестр. Он позволяет контролировать, кто может подтягивать и загружать образы, интегрироваться с единой авторизацией и держать проприетарный софт вне публичных индексов.

Это «прыжок от ноутбука к команде»: как только образы живут в реестре, ваш CI, коллеги и продовые сервера могут подтянуть один и тот же артефакт — и развёртывание становится повторяемым, а не импровизацией.

Почему контейнеры хорошо подходят для CI/CD

CI/CD работает лучше, когда может обращаться с приложением как с единицей, которая последовательно перемещается по стадиям. Контейнеры дают именно это: один упакованный артефакт (образ), который можно собрать один раз и запускать много раз с меньшим количеством сюрпризов.

Стандартизированная локальная разработка

До контейнеров команды пытались выровнять среды через длинные инструкции и общие скрипты. Docker изменил рабочий процесс по умолчанию: склонировал репозиторий, собрал образ, запустил приложение. Те же команды обычно работают на macOS, Windows и Linux, потому что приложение запускается внутри контейнера.

Такая стандартизация ускоряет онбординг: новые коллеги тратят меньше времени на установку зависимостей и больше — на понимание продукта.

«Собрать один раз, запустить везде» на практике

Сильная CI/CD-настройка стремится к единому выходу конвейера. С контейнерами выход — это образ с тегом версии (часто связанный с SHA коммита). Тот же самый образ продвигается: dev → test → staging → production.

Вместо пересборки под каждую среду вы меняете конфигурацию (переменные окружения) при сохранении идентичности артефакта. Это уменьшает дрейф и облегчает отладку релизов.

Естественная интеграция в CI-пайплайны

Контейнеры хорошо мапятся на шаги пайплайна:

- Build: создать образ из Dockerfile

- Test: запуск юнит/интеграционных тестов внутри контейнера

- Scan: проверка образа на известные уязвимости

- Deploy: запушить в реестр, затем подтянуть и запустить в следующей среде

Поскольку каждый шаг работает с тем же самым упакованным приложением, падения более информативны: тест, прошедший в CI, с высокой вероятностью будет вести себя так же после деплоя.

Если вы улучшаете процесс, стоит установить простые правила (соглашения по тегам, подпись образов, базовое сканирование), чтобы пайплайн оставался предсказуемым. Можно расширять практики по мере роста команды (см. /blog/common-mistakes-and-how-to-avoid-them).

Где это пересекается с современными «vibe-coding» рабочими процессами: платформы вроде Koder.ai могут генерировать и итеративно развивать full-stack приложения (React на фронтенде, Go + PostgreSQL на бэке, Flutter для мобильных) через чат-интерфейс — но для перехода от «запускается» к «поставляется» всё равно нужна надёжная единица упаковки. Отнесение каждой сборки как версионированного образа контейнера помогает и при ускоренной разработке с AI: воспроизводимые сборки, предсказуемые деплои и готовность к откату.

Запуск в масштабе: зачем появился Kubernetes

Снизьте стресс при откатах

Делайте снимки перед изменениями — тогда откаты будут простыми при сбоях.

Docker сделал практичным собрать приложение один раз и запускать везде. Следующая проблема появилась быстро: команды запускали не один контейнер на ноутбуке, а десятки (затем сотни) контейнеров на множестве машин, версии постоянно менялись.

В этот момент «запустить контейнер» перестаёт быть сложной задачей. Сложность переходит в управление флотом: где запускать каждый контейнер, как поддерживать нужное количество копий онлайн и как автоматически восстанавливаться при сбоях.

Почему появились оркестраторы

Когда у вас много контейнеров на множестве серверов, нужен механизм координации. Это то, что делают оркестраторы: они рассматривают инфраструктуру как пул ресурсов и постоянно поддерживают приложения в желаемом состоянии.

Kubernetes стал самым распространённым ответом на эту потребность (хотя не единственным). Он предоставляет набор концепций и API, которые стандартизировали подход для многих команд и платформ.

Docker и оркестрация: разные задачи

Полезно разделять ответственности:

- Docker (и похожие инструменты) фокусируются на сборке образов и запуске контейнеров на одной машине.

- Kubernetes фокусируется на операбельности контейнеров в масштабе: на множестве машин, в зонах доступности, с rolling updates.

Основные идеи, которые привнёс Kubernetes

Kubernetes ввёл (и популяризовал) несколько практических возможностей, которые стали необходимы, когда контейнеры вышли за пределы одного хоста:

- Планирование (scheduling): размещение контейнеров на подходящих машинах в соответствии с ресурсами и ограничениями

- Масштабирование: увеличение или уменьшение числа копий в соответствии со спросом

- Service discovery и балансировка нагрузки: стабильные способы находить сервисы, даже когда IP и инстансы меняются

- Самовосстановление: перезапуск упавших контейнеров, замена нездоровых инстансов и перераспределение при отказе машины

Короче: Docker сделал единицу переносимой; Kubernetes сделал её управляемой и предсказуемой в движении большого количества таких единиц.

Как контейнеры изменили архитектуру приложений

Контейнеры изменили не только способ развёртывания — они подтолкнули команды по‑новому проектировать ПО.

«Микросервисы стало легче выпускать» (без запрета монолитов)

До контейнеров разделение приложения на множество мелких сервисов часто означало умножение операционной боли: разные рантаймы, конфликты зависимостей, сложные скрипты деплоя. Контейнеры снизили это трение. Если каждый сервис поставляется как образ и запускается одинаково, создание нового сервиса кажется менее рискованным.

Тем не менее контейнеры отлично подходят и для монолитов. Монолит в контейнере может быть проще, чем недоделанная миграция на микросервисы: одна единица деплоя, один набор логов, один рычаг масштабирования. Контейнеры не навязывают стиль — они делают возможными разные подходы.

Стандартные интерфейсы стали нормой

Платформы контейнеров поощряли приложения вести себя как «чёрные ящики» с предсказуемыми входами и выходами. Распространённые соглашения включают:

- Порты: приложение слушает на известном порту, платформа маршрутизирует трафик

- Переменные окружения: конфигурация передаётся при запуске, а не запекается в код

- Томa (volumes): персистентные данные монтируются, что упрощает заменяемость контейнера

Эти интерфейсы упростили замену версий, откаты и запуск одного и того же приложения на ноутбуке, в CI и в проде.

Новые паттерны (и новые искушения)

Контейнеры популяризировали повторяемые строительные блоки, например sidecar (вспомогательный контейнер рядом с основным для логирования, прокси или сертификатов). Они также усилили рекомендацию «один процесс на контейнер» — не жёсткое правило, но полезный дефолт для ясности, масштабирования и отладки.

Главная ловушка — чрезмерное дробление. Просто потому что можно выделить всё в сервисы, не значит, что нужно. Если «микросервис» добавляет больше координации, задержек и накладных расходов на деплой, чем даёт, оставьте его в составе монолита до тех пор, пока не появится чёткая граница: разные потребности в масштабировании, владение или изоляция отказов.

Безопасность и доверие: что контейнеры не решают автоматически

Контейнеры упрощают доставку, но не делают ПО автоматически безопасным. Контейнер — это код плюс зависимости, и он может быть неправильно сконфигурирован, устаревшим или намеренно вредоносным — особенно если образы подтягиваются из интернета без тщательной проверки.

Доверие начинается с происхождения образа

Если вы не можете ответить на вопрос «Откуда этот образ?», вы уже рискуете. Команды обычно выстраивают цепочку ответственности: собирать образы в контролируемом CI, подписывать или фиксировать, что было собрано, и хранить запись о том, что входит в образ (зависимости, версия базового образа, шаги сборки).

Здесь же полезны SBOM (Software Bill of Materials): они делают содержимое контейнера видимым и аудируемым.

Сканирование — следующий практический шаг. Регулярно сканируйте образы на известные уязвимости, но рассматривайте результаты как входные данные для решений — а не как гарантию безопасности.

Минимальные права и секреты: распространённые ошибки

Частая ошибка — запуск контейнеров с чрезмерными правами: по‑умолчанию от root, с лишними Linux‑capabilities, в host‑network или в privileged‑режиме «потому что так работает». Всё это расширяет радиус поражения при проблемах.

Секреты — ещё одна ловушка. Переменные окружения, запечённые конфигурационные файлы или закоммиченные .env могут протекать. Лучше использовать хранилища секретов или механизмы оркестратора и регулярно вращать секреты, предполагать вероятность утечки.

Риски в рантайме, которые часто игнорируют

Даже «чистые» образы опасны при выполнении. Следите за открытым Docker socket, чересчур широкими монтированиями томов и контейнерами, которые могут достучаться до внутренних сервисов без необходимости.

Также помните: патчи хоста и ядра всё ещё важны — контейнеры делят ядро.

Простая чек‑листовая модель

Думайте в четырёх фазах:

- Build: контролируемые сборки, SBOM, сканирование, минимизация базовых образов

- Store: приватные реестры, контроль доступа, политики неизменяемости

- Run: принцип наименьших привилегий, сетевые лимиты, лимиты ресурсов, отсутствие сполза секретов

- Monitor: логи, алерты, обнаружение аномалий, быстрая пересборка и деплой

Контейнеры снижают трение — но доверие нужно заслужить, проверить и поддерживать постоянно.

Частые ошибки и как их избегать

Разверните то, что вы только что создали

Публикуйте приложение на хостинге Koder.ai и внедряйте более безопасные практики релизов.

Docker делает упаковку предсказуемой, но только если использовать его дисциплинированно. Многие команды натыкаются на одни и те же ловушки — а затем винят «контейнеры» за то, что по сути является проблемой рабочего процесса.

Антипаттерны, которые тормозят всех

Классическая ошибка — строить огромные образы: брать полные базовые ОС, устанавливать инструменты сборки, которые не нужны в рантайме, копировать весь репозиторий (включая тесты, доки, node_modules). В результате — медленные загрузки, медленный CI и большая поверхность для атак.

Ещё одна проблема — медленные сборки, ломающие кеш. Если вы копируете весь исходный код до установки зависимостей, каждое небольшое изменение кода заставляет переустанавливать зависимости.

Наконец, команды часто используют неясные или плавающие теги вроде latest или prod. Это делает откаты болезненными и превращает деплои в угадайку.

«Работает локально, но не в проде»: реальные причины

Чаще всего это различия в конфигурации (отсутствующие env vars или секреты), сетях (другие хостнеймы, порты, прокси, DNS) или хранилище (данные пишутся в файловую систему контейнера вместо тома, или права доступа отличаются между средами).

Практические исправления, которые можно применить сегодня

Используйте тонкие базовые образы (slim) когда возможно (или distroless, если команда готова). Зафиксируйте версии для базовых образов и ключевых зависимостей, чтобы сборки были повторяемыми.

Применяйте multi-stage builds, чтобы оставить компиляторы и инструменты сборки вне финального образа:

FROM node:20 AS build

WORKDIR /app

COPY package*.json ./

RUN npm ci

COPY . .

RUN npm run build

FROM node:20-slim

WORKDIR /app

COPY --from=build /app/dist ./dist

CMD ["node","dist/server.js"]

Также тегируйте образы чем‑то трассируемым, например git SHA (и опционально удобным для человека тегом релиза).

Когда не стоит контейнеризовать

Если приложение действительно простое (один статический бинарник, редкий запуск, нет потребности в масштабировании), контейнеры могут добавить лишнюю сложность. Наследованные системы с сильной привязкой к ОС или специализированным драйверам тоже могут плохо подходить — иногда VM или управляемый сервис проще.

Что значит «единица по умолчанию» сегодня — и что делать дальше

Контейнеры стали единицей по умолчанию потому, что решили очень конкретную повторяемую проблему: заставить одно и то же приложение работать одинаково на ноутбуках, тестовых серверах и в проде. Упаковка приложения и зависимостей вместе ускорила релизы, сделала откаты безопаснее и упростила передачи между командами.

Не менее важно, что контейнеры стандартизировали рабочий процесс: собрать один раз, отправить, запустить.

Что значит «по умолчанию» на практике

«По умолчанию» не означает, что всё везде обязательно запускается в Docker. Это означает, что большинство современных delivery‑пайплайнов рассматривают образ контейнера как главный артефакт — больше, чем ZIP, снимок ВМ или набор ручных шагов.

Этот подход обычно включает три компонента, работающие вместе:

- Образы: неизменяемые выходы сборки, помеченные версиями (и желательно SHA коммита)

- Реестры: место для хранения и получения образов (приватные или публичные), позволяющее командам использовать один и тот же артефакт в разных средах

- Оркестрация: планировщик (часто Kubernetes), который надёжно запускает контейнеры, заменяет упавшие и масштабирует

Следующие шаги, которые можно сделать на этой неделе

Начните с малого и сосредоточьтесь на повторяемости.

- Изучите основы Dockerfile: держите образы минимальными, фиксируйте версии базовых образов и стройте слои так, чтобы пересборки были быстрыми. Добавьте

.dockerignore как можно раньше.

- Используйте реестр осознанно: публикуйте образы с понятными тегами (например,

1.4.2, main, sha-…) и определите, кто может push/pull.

- Применяйте правила сборки в CI: собирайте образы в CI, запускайте тесты в контексте контейнера и продвигайте тот же образ через staging в production (не пересобирайте для каждой среды).

Если вы экспериментируете с ускорением разработки (включая AI‑помощь), сохраняйте ту же дисциплину: версионируйте образ, храните его в реестре и делайте деплой продвижением одного артефакта. Именно поэтому команды, использующие Koder.ai, выигрывают от контейнерно‑ориентированной доставки — быстрая итерация полезна, но воспроизводимость и возможность отката делают её безопасной.

Сохраняйте взвешенный взгляд

Контейнеры уменьшают проблемы «работает на моём компьютере», но они не заменяют хорошие операционные практики. Вам всё ещё нужны мониторинг, инцидент‑менеджмент, управление секретами, патчи, контроль доступа и чёткое владение.

Относитесь к контейнерам как к мощному стандарту упаковки — а не как к способу избежать инженерной дисциплины.