Почему идеи Шеннона всё ещё важны в повседневной технике

Вы используете идеи Клода Шеннона каждый раз, когда отправляете сообщение, смотрите видео или подключаетесь к Wi‑Fi. Не потому что ваш телефон «знает Шеннона», а потому что современные цифровые системы построены вокруг простой догадки: мы можем превратить шумные реальные сообщения в биты, передать эти биты по несовершенным каналам и всё равно восстановить исходный контент с высокой надёжностью.

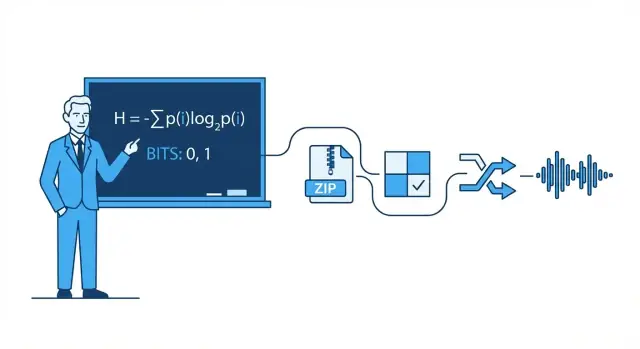

Теория информации простыми словами

Теория информации — это математика сообщений: сколько в сообщении выбора (неопределённости), насколько эффективно его можно представить и насколько надёжно передать, когда мешают шум, помехи и перегрузка.

За этим стоят формулы, но практической интуиции не нужно быть математиком. Мы будем использовать повседневные примеры — почему некоторые фото сжимаются лучше, почему звонок может звучать нормально при слабом сигнале — чтобы объяснить идеи без тяжёлых выкладок.

Четыре столпа, которые встречаются повсюду

Эта статья вращается вокруг четырёх идей, вдохновлённых Шенноном, которые встречаются в современной технике:

- Сжатие: уменьшение объёма данных (аудио, видео, файлы) без потери важного.

- Исправление ошибок: добавление ровно столько лишних бит, чтобы ошибки можно было обнаружить и исправить.

- Надёжность сетей: работа с потерянными пакетами через повторы, упорядочивание и компромиссы пропускной способности.

- Конечная цифровая коммуникация: взгляд на всю цепочку от источника (ваше сообщение) до канала (Wi‑Fi, сотовая сеть, оптика) и обратно.

Что вы сможете анализировать после прочтения

К концу вы сможете ясно рассуждать о реальных компромиссах: почему для более высокого качества видео нужно больше полосы, почему «больше полосок сигнала» не всегда означает более быстрый интернет, почему одни приложения кажутся мгновенными, а другие буферизуют, и почему каждая система упирается в пределы — особенно в знаменитый предел Шеннона по максимально надёжной передаче данных.

Клод Шеннон в одной странице: главная мысль

В 1948 году математик и инженер Клод Шеннон опубликовал работу с невзрачным заголовком — A Mathematical Theory of Communication — которая незаметно изменила наш подход к передаче данных. Вместо того чтобы считать коммуникацию искусством, он рассматривал её как инженерную задачу: источник порождает сообщения, канал их переносит, шум исказит, а приёмник пытается восстановить отправленное.

Информация — это «снижение неопределённости», а не «смысл»

Ключевой шаг Шеннона — определить информацию так, чтобы её можно было измерить и использовать машинами. В его рамке информация не про важность или правдивость сообщения. Она про то, насколько удивительным оказывается исход — сколько неопределённости исчезает, когда вы узнаёте результат.

Если вы заранее знаете, что произойдёт, сообщение практически не несёт информации. Если вы искренне не уверены, узнать результат — значит получить больше информации.

Бит: простейшая единица измерения

Для измерения информации Шеннон ввёл понятие бита (binary digit). Бит — это количество информации, нужное, чтобы разрешить простую да/нет неопределённость.

Пример: если я спрашиваю «Включён ли свет?» и вы не знаете ответа заранее, ответ (да или нет) даёт 1 бит информации. Многие реальные сообщения можно разбить на длинные последовательности таких бинарных выборов, поэтому текст, фото и аудио можно хранить и передавать как биты.

Что даст и чего не даст эта статья

Статья сосредоточена на практической интуиции за идеями Шеннона и почему они повсюду: сжатие (делать файлы меньше), исправление ошибок (восстанавливать порчу), надёжность сетей (повторы и пропускная способность) и пропускная способность канала (насколько быстро можно передавать данные по шумному каналу).

Она не будет проводить через тяжёлые доказательства. Вам не нужна продвинутая математика, чтобы понять суть: как только можно измерить информацию, можно проектировать системы, которые подходят к теоретической эффективности — часто удивительно близко к пределам, которые описал Шеннон.

Биты, символы и коды: практический словарь

Прежде чем говорить об энтропии, сжатии и исправлении ошибок, полезно зафиксировать несколько повседневных терминов. Идеи Шеннона проще, когда можно назвать части системы.

Символы, алфавиты и сообщения

Символ — это один «токен» из набора, на котором вы договорились. Этот набор — алфавит. В английском тексте алфавитом могут быть буквы (плюс пробел и пунктуация). В файле компьютера алфавит — это значения байта 0–255.

Сообщение — последовательность символов из этого алфавита: слово, предложение, файл изображения или поток звуковых сэмплов.

Чтобы сделать конкретнее, представьте маленький алфавит: {A, B, C}. Сообщение может выглядеть так:

A A B C A B A ...

Биты и коды

Бит — это бинарная цифра: 0 или 1. Компьютеры хранят и передают биты, потому что аппаратно можно надёжно различать два состояния.

Код — правило представления символов при помощи бит (или других символов). Например, для алфавита {A, B, C} одним возможным двоичным кодом может быть:

Теперь любое сообщение из A/B/C можно превратить в поток бит.

Кодирование vs. сжатие vs. шифрование

Эти термины часто путают:

- Кодирование: перевод данных в выбранный формат, чтобы их можно было хранить/передавать/обрабатывать (например, отображение A/B/C в биты или преобразование текста в UTF‑8).

- Сжатие: кодирование, которое использует меньше бит в среднем, эксплуатируя паттерны и неравные частоты.

- Шифрование: запутывание данных с ключом, чтобы посторонние не могли их прочитать; это про секретность, а не про размер.

Быстрая интуиция вероятностей

Реальные сообщения не случайны: одни символы появляются чаще других. Допустим, A встечается 70% времени, B — 20%, C — 10%. Хорошая схема сжатия будет давать короткие коды частым символам (A) и длинные — редким (C). Эта неравномерность — то, что позже мы поймём как энтропию.

Энтропия: измеряем удивление (и почему она предсказывает сжимаемость)

Самая известная идея Шеннона — энтропия: способ измерить, сколько «удивления» в источнике информации. Не удивления как эмоции — а как непредсказуемости. Чем менее предсказуем следующий символ, тем больше информации он принесёт, когда появится.

Энтропия как «среднее удивление»

Представьте, что наблюдаете подбрасывания монеты.

- Честная монета (50/50): каждое подбрасывание трудно предсказать. Орёл так же вероятен, как решка, поэтому вы регулярно «удивляетесь» в обе стороны. Это высокая непредсказуемость — высокая энтропия.

- Подгруженная монета (скажем, 95% орёл, 5% решка): большинство бросков — орёл. Через пару бросков вы ждёте орла, поэтому увидеть орла приносит мало новой информации. Только редкая решка удивляет. В среднем такая последовательность — низкая энтропия.

Это «среднее удивление» совпадает с повседневными паттернами: текст с повторяющимися пробелами и частыми словами легче предсказывать, чем файл случайных символов.

Почему предсказуемость — это сжимаемость

Сжатие работает, назначая короткие коды частым символам и длинные — редким. Если источник предсказуем (низкая энтропия), вы чаще используете короткие коды и экономите место. Если он почти случайный (высокая энтропия), сжать его почти невозможно, потому что ничего не повторяется достаточно часто.

Энтропия и лучший возможный средний размер кода

Шеннон показал, что энтропия задаёт ориентир: это теоретическая нижняя граница для среднего числа бит на символ, которого можно достичь при кодировании данных этого источника.

Важно: энтропия — не алгоритм сжатия. Она не говорит, как именно сжать файл. Она говорит, что возможно в теории — и как понять, близко ли вы к пределу.

Сжатие: превращаем энтропию в меньшие файлы

Сжатие — это когда вы берёте сообщение, которое можно описать меньшим числом бит, и действительно делаете это. Главная мысль Шеннона: данные с низкой энтропией (больше предсказуемости) имеют запас для уменьшения, а данные с высокой энтропией (почти случайные) — нет.

Почему шаблоны и неравномерные частоты хорошо сжимаются

Повторы очевидно выигрывают: если файл содержит одни и те же последовательности снова и снова, можно сохранить последовательность один раз и ссылаться на неё. Но даже без явных повторов скошенные частоты символов помогают.

Если буква «e» встречается гораздо чаще, чем «z», вам не нужно тратить одинаковое число битов на каждую букву. Чем более неравномерны частоты, тем предсказуемее источник и тем лучше его можно сжать.

Кодирование с переменной длиной (основная идея)

Практический способ использовать неравные частоты — кодирование переменной длины:

- частые символы получают короткие коды

- редкие — длинные коды

Если делать это аккуратно, среднее число бит на символ уменьшается без потери информации.

В реальности без потерь компрессоры часто смешивают идеи, но распространённые семейства:

- Код Хаффмана: строит эффективную таблицу «коротко для частых»;

- Арифметическое кодирование: упаковка символов в дробный диапазон, часто приближает к энтропийному пределу;

- Методы LZ (Lempel–Ziv): ищут повторяющиеся подстроки и заменяют их ссылками (используется в ZIP‑подобных форматах).

Без потерь vs. с потерями (ZIP vs. JPEG/MP3)

Сжатие без потерь восстанавливает исходный файл точно (например, ZIP, PNG). Нужна там, где важен каждый бит — для программ, документов и всего, где одна ошибка критична.

С потерями сознательно отбрасывает детали, которые люди обычно не замечают (JPEG, MP3/AAC). Цель — не восстановить те же биты, а сохранить тот же опыт; это часто даёт гораздо меньшие файлы, удаляя перцептуально несущественное.

Ошибки случаются: почему полезна избыточность

Проверьте скорость и надёжность

Разверните фронтенд на React и бэкенд на Go, чтобы проверить реальные пределы пропускной способности и задержек.

Вся цифровая система полагается на ненадёжное предположение: 0 остаётся 0, а 1 — 1. На практике биты могут переворачиваться.

Откуда берутся ошибки

При передаче электрические помехи, слабый Wi‑Fi или радиошум могут сдвинуть сигнал так, что приёмник неправильно интерпретирует его. При хранении мелкие физические эффекты — износ флеш‑памяти, царапины на оптических носителях, даже космическая радиация — могут поменять заряд или магнитное состояние.

Поскольку ошибки неизбежны, инженеры сознательно добавляют избыточность: лишние биты, которые не несут «новой» информации, но помогают обнаруживать или исправлять повреждения.

Простая избыточность, с которой вы уже сталкивались

Бит паритета (быстрое обнаружение). Добавляют один бит так, чтобы общее количество единиц было чётным (чётный паритет) или нечётным (нечётный). Если один бит перевернётся, проверка паритета даст сбой.

- Сильная сторона: дешёво и быстро.

- Ограничение: обычно не указывает, какой именно бит ошибочен; две ошибки могут скомпенсировать друг друга и остаться незамеченными.

Контрольная сумма (лучшее обнаружение по блокам). Вместо одного бита вычисляют небольшое контрольное число по пакету или файлу (например, сложение, CRC). Приёмник пересчитывает и сравнивает.

- Сильная сторона: ловит многие многобитовые ошибки в блоке.

- Ограничение: только обнаруживает; при отказе обычно нужен повторный запрос или резервная копия.

Код повторения (простое исправление). Отправляют каждый бит три раза: 0→000, 1→111. Приёмник использует большинство голосов.

- Сильная сторона: может исправить одну перевёрнутую биту в каждой тройке.

- Ограничение: крайне неэффективен — утроение объёма данных.

Обнаружение vs. исправление (и когда что применяют)

Обнаружение ошибок отвечает на вопрос: «Что‑то пошло не так?» Это удобно, когда повторы дешёвы — например, сетевые пакеты можно переслать.

Исправление ошибок отвечает: «Какими были исходные биты?» Это нужно, когда повторы дороги или невозможны — стриминг по шумной линии, глубокая космическая связь, или чтение данных из носителя, где повторное считывание может тоже дать ошибку.

Избыточность кажется расточительной, но именно она позволяет современным системам быть быстрыми и надёжными несмотря на несовершенное железо и шумные каналы.

Пропускная способность канала и предел Шеннона (без тяжёлой математики)

Когда вы передаёте данные по реальному каналу — Wi‑Fi, сотовая связь, USB‑кабель или жёсткий диск — шум и помехи могут переворачивать биты или размывать символы. Большое обещание Шеннона было неожиданным: надёжная связь возможна, даже через шумные каналы, если не пытаться втиснуть слишком много информации.

Пропускная способность канала простыми словами

Пропускная способность канала — это «скоростной лимит» канала: максимальная скорость (бит/с), с которой вы можете передавать данные с ошибками, стремящимися к нулю, учитывая шум и ограничения вроде полосы пропускания и мощности.

Это не то же самое, что сырая скорость переключения символов. Речь о том, сколько смысловой информации вы можете сохранить после шума — с учётом умного кодирования, избыточности и декодирования.

Предел Шеннона: рубеж, к которому стремятся инженеры

Предел Шеннона — практическая интерпретация этой границы:

- если вы работаете ниже него, теоретически можно сделать связь столь надёжной, насколько захотите;

- если выше — ошибки останутся вне зависимости от хитростей.

Инженеры тратят много усилий, чтобы приблизиться к этому пределу с помощью лучшей модуляции и кодов исправления ошибок. Современные системы вроде LTE/5G и Wi‑Fi используют продвинутые коды, чтобы работать рядом с этой границей, не расходуя сверхмерно мощность или полосу.

Ключевой компромисс (скорость vs. вероятность ошибки)

Подумайте о погрузке предметов в грузовик по ухабистой дороге:

- если загрузить слишком плотно (скорость выше пропускной способности), некоторые вещи всё равно сломаются (ненулевая вероятность ошибок).

- если загрузить с запасом и амортизацией (скорость ниже пропускной способности), ломкость можно сделать сколь угодно малой — ценой меньшей пропускной способности или большего объёма избыточных данных.

Шеннон не дал «лучший код», но доказал, что предел существует — и что стоит к нему стремиться.

Коды исправления ошибок в реальных системах

Владейте кодовой базой

Экспортируйте исходники, когда хотите полный контроль над кодеками, протоколами или инфраструктурой.

Теорема Шеннона о шумном канале часто резюмируется так: если вы отправляете данные ниже пропускной способности канала, существуют коды, делающие ошибки сколь угодно редкими. Инженерия превращает это «существует» в практические схемы, подходящие для микросхем, батарей и жёстких временных ограничений.

Практический набор инструментов: блоки, интерливинг и более информированные решения

Большинство систем использует блочные коды (защищают кусок бит за раз) или потоковые коды (защищают непрерывную последовательность).

С блочными кодами вы добавляете продуманную избыточность к каждому блоку, чтобы приёмник мог находить и исправлять ошибки. С интерливингом вы перемешиваете порядок битов/символов так, чтобы импульсный шум (множество ошибок подряд) превратился в отдельные небольшие ошибки по разным блокам — критично для беспроводных каналов и систем хранения.

Другой важный делитель — как приёмник «решает», что он принял:

- Жёсткие решения: каждый принятый сигнал сразу превращается в 0 или 1.

- Мягкие решения: приёмник хранит также меру уверенности (например: «скорее всего 1, но не уверен»).

Мягкие решения дают декодеру больше информации и заметно повышают надёжность, особенно в Wi‑Fi и сотовых сетях.

Коды, с которыми вы уже сталкивались

- Коды Рида–Соломона: работают на символах, а не на отдельных битах, отлично против всплесков ошибок. Используются в QR‑кодах, CD/DVD и некоторых системах вещания/хранения.

- Сверточные коды: классический выбор для непрерывных потоков; исторически применялись в спутниковой связи.

- Турбо‑коды: большой прорыв в 1990‑х, широко использовались в 3G/4G.

- LDPC (Low‑Density Parity‑Check): очень эффективные современные блочные коды, применяются в Wi‑Fi, 5G и в системах с высокой пропускной способностью.

Где это важно

От глубокого космоса (где повторные передачи дорогие или невозможны) до спутников, Wi‑Fi и 5G — коды исправления ошибок — это практический мост между теорией Шеннона и реальным миром шумных каналов: лишние биты и вычисления дают меньше падений вызовов, более быстрые загрузки и более надёжные соединения.

Надёжность в сетях: пакеты, повторы и пропускная способность

Интернет работает, несмотря на то, что отдельные каналы несовершенны. Wi‑Fi гаснет, сигналы мобильной связи блокируются, а медь и оптика всё равно подвержены шуму и случайным сбоям. Главная мысль Шеннона — шум неизбежен, но надёжность достижима — проявляется в сетях как сочетание обнаружения/исправления ошибок и повторов.

Пакеты: маленькие ставки вместо одной большой

Данные разбивают на пакеты, чтобы сеть могла объезжать проблемные участки и восстанавливаться от потерь без пересылки всего. Каждый пакет несёт лишние биты (заголовки и проверки), которые помогают приёму решить, можно ли доверять пришедшим данным.

Один распространённый шаблон — ARQ (Automatic Repeat reQuest):

- приёмник проверяет пакет (обычно checksum/CRC);

- если всё в порядке, отправляет подтверждение (ACK);

- если пакет потерян или повреждён, отправитель повторяет после таймаута (или по NACK).

Исправлять или пересылать: компромисс задержки

Когда пакет неверен, есть два основных пути:

- Исправить сразу с помощью FEC: добавить достаточную избыточность, чтобы приёмник мог исправить ошибки без запроса.

- Переслать с помощью ARQ: заранее отправлять меньше избыточности, но тратить время на повторную отправку при ошибках.

FEC уменьшает задержки на каналах с дорогими повторами (большая латентность, прерывания). ARQ эффективен, когда потери редки, потому что вы не «нагружаете» каждый пакет тяжёлой избыточностью.

Пропускная способность, перегрузка и почему надёжность стоит денег

Механизмы надёжности потребляют ресурсы: лишние биты, дополнительные пакеты и ожидание. Повторы увеличивают нагрузку, что может усилить перегрузку; перегрузка в свою очередь повышает задержку и потери, вызывая ещё больше повторов.

Хороший сетевой дизайн ищет баланс: достаточно надёжности, чтобы доставить корректные данные, и при этом минимально возможные накладные расходы, чтобы сеть держала здоровую пропускную способность в меняющихся условиях.

Цифровая коммуникация «от конца до конца»: от источника до канала

Полезно представлять современные цифровые системы как конвейер с двумя задачами: уменьшить сообщение и сделать его устойчивым в пути. Ключевая идея Шеннона — что часто имеет смысл думать о них как о независимых слоях, хотя в реальных продуктах границы порой размыты.

Шаг 1: кодирование источника (сжатие)

Вы начинаете с «источника»: текст, аудио, видео, показания датчиков. Кодирование источника убирает предсказуемую структуру, чтобы не тратить на неё биты. Это может быть ZIP для файлов, AAC/Opus для аудио или H.264/AV1 для видео.

Сжатие — то место, где энтропия проявляется на практике: чем предсказуемее контент, тем меньше бит в среднем требуется.

Шаг 2: кодирование канала (исправление ошибок)

Потом сжатые биты должны пересечь шумный канал: Wi‑Fi, сотовую сеть, оптику, USB‑кабель. Кодирование канала добавляет спроектированную избыточность, чтобы приёмник мог обнаруживать и исправлять ошибки. Это мир CRC, Рида–Соломона, LDPC и других методов FEC.

Идея «разделения» Шеннона (полезная мысленная модель)

Шеннон показал, что теоретически можно проектировать кодирование источника, чтобы приближаться к лучшему сжатию, и кодирование канала, чтобы приближаться к надёжности до пропускной способности — независимо друг от друга.

На практике это разделение остаётся полезным для отладки: если что‑то работает плохо, можно спросить, теряете ли вы эффективность в сжатии (кодирование источника), теряете ли надёжность на канале (кодирование канала) или платите слишком большой задержкой за повторы и буферизацию.

Конкретный пример: потоковое видео по Wi‑Fi

При стриминге приложение использует кодек для сжатия кадров. В Wi‑Fi пакеты могут теряться или повреждаться, поэтому система добавляет обнаружение ошибок, иногда FEC, и применяет повторы (ARQ) при необходимости. Если соединение ухудшается, плеер может перейти на поток с более низким битрейтом.

Реальные системы размывают разделение, потому что время важно: ожидание повторов вызывает буферизацию, а беспроводные условия меняются быстро. Поэтому стеки стриминга комбинируют выборы кодирования, избыточность и адаптацию — не идеально разделённо, но всё ещё под управлением модели Шеннона.

Распространённые заблуждения и практические компромиссы

Быстро создайте прототип

Превратите эти компромиссы Shannon в рабочее приложение, создавая его по спецификации чата в Koder.ai.

Теория информации часто цитируется, и несколько идей упрощают слишком сильно. Вот распространённые недоразумения и реальные компромиссы, которые инженеры делают при проектировании сжатия, хранения и сетей.

Заблуждение 1: «Энтропия — это то же самое, что случайность»

В обыденной речи «случайный» может значить «хаотичный» или «непредсказуемый». Энтропия Шеннона уже точнее: она измеряет удивление при заданной вероятностной модели.

- Совершенно предсказуемый поток (всё нули) имеет низкую энтропию.

- Поток, который трудно предсказать с учётом того, что вы знаете, имеет высокую энтропию.

Энтропия — не впечатление, а число, завязанное на предположения о поведении источника.

Заблуждение 2: «Больше сжатия всегда лучше»

Сжатие убирает избыточность. Исправление ошибок часто добавляет избыточность, чтобы приёмник смог восстановиться.

Это создаёт практическое напряжение:

- Если вы сильно сжали данные, а потом отправляете по шумному каналу, у вас может остаться меньше «запаса» для восстановления повреждений.

- Хорошо спроектированные системы обычно сначала сжимают (убирают предсказуемость), затем добавляют структурированную избыточность (коды исправления) для канала.

Заблуждение 3: «Мы можем быть абсолютно надёжными на любой скорости»

Предел Шеннона говорит, что каждый канал имеет максимум надёжной пропускной способности при заданном шуме. Ниже этого предела ошибки можно сделать очень редкими с правильным кодом; выше — ошибки неизбежны.

Поэтому «абсолютно надёжно на любой скорости» — невозможно: увеличение скорости обычно означает более высокую вероятность ошибки, большую задержку (из‑за повторов) или более сильную избыточность (меньше полезной нагрузки).

Простой чек‑лист для реальных систем

При оценке продукта или архитектуры спросите:

- Статистика источника: данные предсказуемы (текст, логи) или уже близки к случайным (зашифрованы, уже сжаты)?

- Шум: что может их повредить — беспроводные помехи, битовый износ, потеря пакетов?

- Бюджет задержки: можно ли позволить повторы и буферизацию, или нужно реальное время?

- Выбор накладных расходов: тратите ли вы биты на экономию сжатия, исправление ошибок, повторы или их сочетание?

Попадание в эти четыре момента важнее, чем зубрёжка формул.

Основные выводы и куда двигаться дальше

Суть Шеннона в том, что информацию можно измерить, передавать, защищать и сжимать с помощью небольшого набора идей.

- Бит — общая валюта, которая позволяет рассматривать текст, аудио, видео и показания датчиков одинаково после кодирования.

- Энтропия измеряет непредсказуемость источника и предсказывает, насколько данные можно сжать.

- Шум и потери неизбежны, поэтому надёжные системы добавляют избыточность через обнаружение и коды исправления ошибок.

- Пропускная способность канала задаёт реальный потолок: выше него нельзя «побороть» ошибки никакими ухищрениями — нужно снижать скорость, улучшать канал или менять коды.

Современные сети и системы хранения — это постоянные компромиссы между скоростью, надёжностью, задержкой и вычислительными затратами.

Практическая заметка для разработчиков

Если вы строите реальные продукты — API, стриминговые фичи, мобильные приложения, телеметрию — рамка Шеннона даёт удобный чек‑лист проектирования: сжимайте то, что можно, защищайте то, что нужно, и явно фиксируйте бюджет задержки/пропускной способности. Один момент, где это сразу видно при прототипировании end‑to‑end: на платформе вроде Koder.ai команды могут быстро поднять React фронтенд, Go бэкенд с PostgreSQL и даже Flutter мобильный клиент по спецификации из чата, а затем тестировать реальные компромиссы (размер полезной нагрузки, повторы, поведение буфера) рано. Функции типа planning mode, snapshots и rollback упрощают эксперименты с «сильной надёжностью vs. низкие накладные расходы» без потери темпа работы.

Кому стоит углубиться

Углублённое чтение полезно для:

- Студентов, которые хотят стройную ментальную модель, связывающую вероятность с сжатием и кодированием канала;

- Продакт‑менеджеров, принимающих решения о качестве, задержке, полосе и стоимости;

- Инженеров, работающих с сетями, медиакодеками, хранением, телеметрией или конвейерами данных для ML.

Чтобы продолжить, просмотрите связанные объяснения в /blog, затем загляните в /docs, где описаны настройки и API, связанные с коммуникацией и сжатием. Если сравниваете планы или пределы пропускной способности, следующий пункт — /pricing.