26 авг. 2025 г.·8 мин

Guillermo Rauch, Vercel и Next.js: как упростить деплой

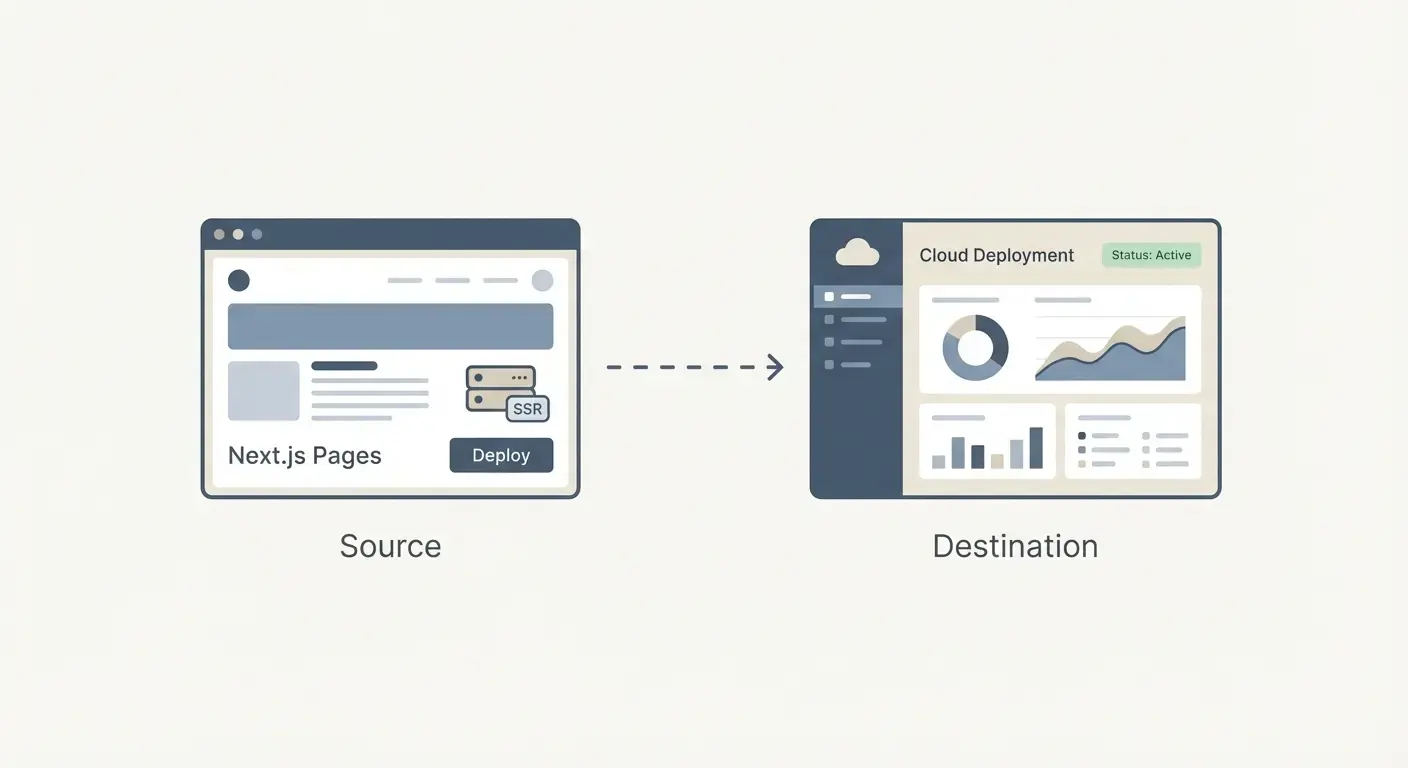

Узнайте, как Guillermo Rauch, Vercel и Next.js превратили деплой, SSR и фронтенд‑инфраструктуру в простые продуктовые решения для широкого круга разработчиков.

Почему деплой и SSR стали продуктами

Не так давно доставка веб-приложения обычно означала: собрать, найти хост, настроить и поддерживать в рабочем состоянии. Даже при простом коде публикация часто требовала решений по серверам, кэшированию, пайплайнам сборки, TLS‑сертификатам и мониторингу. Ничего из этого не было гламурным, но было неизбежно — и постоянно отнимало у команд время, которое они могли бы потратить на сам продукт.

От «хостинга» к повторяемому процессу

Ключевое изменение в том, что деплой перестал быть разовым техническим проектом и превратился в рабочий процесс, который повторяется каждый день. Командам нужны были превью-URL для каждого pull request, откаты без детективной работы и предсказуемый путь от локального кода к продакшену.

Когда эти потребности стали общими для стартапов, агентств и корпораций, деплой начал выглядеть не как кастомная инженерия, а как продукт: с понятными дефолтами, интерфейсом, автоматизацией и предсказуемым результатом.

Почему деплой и SSR казались специализированными

Server-side rendering (SSR) добавил ещё один уровень сложности. Это не просто «отдавать файлы» — это «запускать код на сервере, чтобы сгенерировать HTML, безопасно его кэшировать и обновлять, не ломая пользователей». Чтобы делать SSR хорошо, нужно разбираться в:

- рантайм-средах (Node, serverless-функции)

- правилах кэширования и инвалидации

- компромиссах по производительности и cold starts

- маршрутизации, переписываниях и заголовках

Для специалистов это было управляемо, но легко получались ошибки настроек, и с ростом проекта это было трудно поддерживать.

Основной вопрос, на который отвечает эта статья

Что значит «продуктизировать инфраструктуру фронтенда»?

Это означает превратить грязные, подверженные ошибкам части доставки фронтенда — сборки, деплои, превью, обработку SSR/SSG, кэширование и edge‑доставку — в стандартизованную, в основном автоматическую систему, которая работает одинаково в разных проектах.

Цель следующих разделов практическая: понять, что упрощается, что вы получаете и какие компромиссы принимаете — без необходимости становиться опс‑экспертом.

Роль Guillermo Rauch в современном фронтенд‑стеке

Guillermo Rauch сегодня известен прежде всего как CEO Vercel и как один из лидирующих голосов вокруг Next.js. Его вклад — не одна изобретённая фича, а постоянная одержимость: сделать веб‑разработку «очевидной» для людей, которые строят продукты.

Создатель и лидер open‑source (факты)

Rauch большую часть карьеры выпускал инструменты для разработчиков публично. До Vercel он создавал и поддерживал популярные open‑source‑проекты (включая Socket.IO) и помогал сформировать культуру, где документация, примеры и разумные дефолты — часть продукта, а не запоздалое мышление.

Позже он основал ZEIT (переименованную в Vercel), компанию, ориентированную на превращение деплоя в отлаженный рабочий процесс. Next.js, изначально разработанный в этой экосистеме, стал флагманским фреймворком, который сочетал современный фронтенд‑опыт с продакшен‑дружелюбными возможностями.

Опыт разработчика как продуктовое решение

Полезно понимать влияние Rauch через многократно повторяющиеся решения:

- Уменьшать число шагов «только для экспертов» между кодом и живым URL.

- Делать опции производительности и рендеринга доступными через соглашения.

- Предпочитать сквозные рабочие процессы (фреймворк + хостинг), когда это снимает трение.

Этот фокус сформировал и фреймворк, и платформу: Next.js поощрял команды использовать SSR и статическую генерацию без изучения целого нового операционного набора, а Vercel смещал деплой в сторону предсказуемого, повторяемого дефолта.

Факты vs интерпретация (без мифов про героя)

Легко свести эту историю к личной заслуге. Точнее сказать, что Rauch помог синхронизировать более широкий сдвиг: команды фронтенда хотели быстрее итераций, меньше передач и инфраструктуру, которая не требует отдельного опс‑специалиста для каждого изменения.

Vercel и Next.js работают как кейс продуктового мышления, потому что они упаковали эти желания в дефолты, которыми могли пользоваться массовые команды.

Next.js простыми словами: что он решает

Next.js — это фреймворк поверх React, который даёт «стартовый набор для полноценного веб‑приложения». Вы по‑прежнему строите компоненты так же, но Next.js добавляет недостающие части, которые большинство команд в итоге собирают сами: страницы, маршрутизацию, способы загрузки данных и продакшен‑дружелюбные настройки производительности.

Проблемы, которые он решает

Маршруты и страницы: В простом React‑приложении обычно добавляют библиотеку роутинга, решают соглашения по URL и всё это скрепляют. Next.js делает URL и страницы первоклассной сущностью, так что структура проекта естественно отображается в маршрутах.

Загрузка данных: Реальные приложения нуждаются в данных — списки товаров, аккаунты пользователей, контент из CMS. Next.js предоставляет распространённые шаблоны для загрузки данных на сервере, во время сборки или в браузере, не заставляя каждую команду изобретать собственную схему.

Дефолты производительности: Next.js сразу включает практические оптимизации — разбивку кода, продуманную обработку ассетов и варианты рендеринга — чтобы вы получали хорошую скорость без поиска длинного списка плагинов.

Чем он отличается от «чистого» React‑приложения

Чистое React‑приложение часто — это «React + куча решений»: библиотека роутинга, конфигурация сборки, инструменты для SSR/SSG (если нужны) и соглашения, существующие только в вашем репозитории.

Next.js более мненийный: он стандартизирует распространённые решения, чтобы новый разработчик быстрее понял проект, а команда тратила меньше времени на обслуживание инфраструктурной «свистелки».

Когда Next.js не нужен

Next.js может быть избыточен, если вы строите маленький преимущественно статический сайт с парой страниц или простой внутренний инструмент, где SEO и время первого отображения не важны.

Если вам не нужны несколько режимов рендеринга, структурированная маршрутизация или серверная загрузка данных, более лёгкий набор инструментов (или даже отсутствие React) может быть проще и дешевле.

SSR, SSG и клиентский рендеринг: практические различия

Современные веб‑приложения кажутся таинственными, потому что «где строится страница» меняется в зависимости от подхода. Проще думать так: когда и где создаётся HTML?

SSR (Server‑Side Rendering)

С SSR сервер генерирует HTML для каждого запроса (или для многих запросов, если используется кэширование). Это помогает с SEO и делает первый экран видимым быстрее — особенно на медленных устройствах — потому что браузер получает реальный контент сразу.

Распространённое заблуждение: SSR не автоматически быстрее. Если каждый запрос вызывает медленные DB‑запросы, SSR будет медленным. Реальная скорость часто приходит от кэширования (на сервере, CDN или edge), чтобы повторные визиты не повторяли всю работу.

SSG (Static Site Generation)

Со SSG страницы предварительно собираются заранее (во время сборки) и отдаются как статические файлы. Это надёжно и дешево, часто даёт отличный TTFB, потому что страница уже «готова» до прихода пользователя.

SSG отлично подходит для маркетинговых страниц, документации и контента, который редко меняется. Компромисс — свежесть: обновление контента может требовать перекомпиляции или стратегии инкрементального обновления.

CSR (Client‑Side Rendering)

При CSR браузер скачивает JavaScript и собирает UI на устройстве пользователя. Это идеально для сильно интерактивных персонализированных частей (дашборды, редакторы), но может затормозить первый значимый рендер и осложнить SEO, если контент не доступен в виде HTML заранее.

Почему команды смешивают подходы

Большинство реальных продуктов комбинируют режимы: SSG для лендингов (SEO и скорость), SSR для динамических, но индексируемых страниц (страницы товаров, листинги) и CSR для страниц под логином.

Правильный выбор напрямую влияет на: SEO (находимость), скорость (конверсии) и надёжность (меньше инцидентов, стабильнее доход).

До продуктизации: как выглядел деплой веб‑приложений

До появления платформ, делающих деплой похожим на нажатие кнопки, выпуск приложения часто превращался в мини‑проект по инфраструктуре. Даже простой маркетинговый сайт с динамической формой мог превратиться в цепочку серверов, скриптов и сервисов, которые должны были оставаться в синхронизации.

Типичный рабочий процесс

Обычная схема выглядела так: вы выделяли один или несколько серверов (VM), ставили веб‑сервер и настраивали CI, который собирал приложение и копировал артефакты по SSH.

Добавлялся reverse proxy (Nginx) для маршрутизации, терминации TLS и сжатия. Затем кэширование: HTTP‑кэш, конфигурация CDN и правила о том, какие страницы можно кэшировать и как долго.

Если нужен был SSR, вы запускали Node‑процесс, который нужно было запускать, мониторить, перезапускать и масштабировать.

Боли, которые замедляли команды

Проблемы были реальные и видимые при каждом релизе:

- Дрейф конфигураций: staging «приблизительно как» production, пока вдруг не перестаёт быть. Мелкая разница в пакете ОС могла ломать сборки или рантайм.

- Медленные релизы: каждый деплой требовал координации CI‑скриптов, состояния серверов, переменных окружения и инвалидации кэша.

- Сложные откаты: откат означал повторный деплой старого билда и надежду, что состояние сервера и зависимости совпадают.

Почему «у меня работает» было так распространено

Локальная разработка скрывает грязные части: тёплый кэш, другая версия Node, другие env‑переменные и никакой реальной нагрузки. В продакшене эти различия вылезают сразу — как тонкие несоответствия SSR, пропавшие секреты или правила маршрутизации, которые ведут себя по‑другому за прокси.

Скрытый налог для маленьких команд

Продвинутые настройки (SSR, мульти‑региональная производительность, безопасные превью) были возможны, но требовали операционного времени. Для многих маленьких команд это означало выбирать более простую архитектуру — не потому что она лучше, а потому что накладные расходы на деплой были слишком велики.

Основная идея Vercel: деплой как рабочий дефолт

Vercel не просто автоматизировал деплой — он упаковал его в дефолтный рабочий процесс, который ощущается частью написания кода. Идея проста: деплой не должен быть отдельной «ops‑задачей», которую планируют в календаре; он должен быть нормальным результатом повседневной разработки.

«Git push — и деплой» как продукт

«Git push → deploy» часто звучит как аккуратный скрипт. Vercel рассматривает это как обещание: если код в Git, он деплойбл — стабильно, повторяемо и без контрольного списка ручных шагов.

Это важно, потому что меняет, кто чувствует уверенность в публикации. Специалист не нужен, чтобы каждый раз интерпретировать настройки сервера, правила кэша или шаги сборки. Платформа превращает эти решения в дефолты и ограждения.

Превью‑деплои меняют сотрудничество

Превью‑деплои — большая часть того, почему это ощущается как рабочий процесс, а не инструмент. Каждый pull request может генерировать шаряемый URL, близкий к поведению продакшена.

Дизайнеры проверяют отступы и взаимодействия в реальной среде. QA тестирует именно тот билд, который уйдёт. PM кликает фичу и оставляет конкретный фидбек — без ожидания «запуска в стейджинг» или просьбы запустить ветку локально.

Откаты и паритет окружений как инструменты безопасности

Когда деплой становится частым, безопасность нужна постоянно. Быстрый откат превращает плохой релиз в неудобство, а не в инцидент.

Паритет окружений — поддерживать превью, стейджинг и прод ведут себя похоже — уменьшает проблему «у меня работает», которая замедляет команды.

Простой сценарий: маркетинг + апдейт приложения

Представьте, что вы выкатываете новую страницу цен и маленькое изменение в флоу регистрации. С превью‑деплоем маркетинг проверяет страницу, QA тестирует флоу, команда мержит с уверенностью.

Если аналитика покажет проблему после релиза, вы откатываетесь за минуты и фиксите причину — без заморозки всей работы.

От CDN до edge: инфраструктура фронтенда без опс‑команды

CDN (Content Delivery Network) — это сеть серверов по миру, которые хранят и отдают копии файлов сайта — изображения, CSS, JS и иногда HTML — чтобы пользователи скачивали их с ближайшего узла.

Кэширование — это свод правил о том, как долго эти копии можно переиспользовать. Хорошее кэширование даёт быструю отдачу и меньше обращений к origin. Плохое кэширование — пользователи видят устаревший контент или команда опасается кешировать вообще.

Edge — следующий шаг: вместо того, чтобы только отдавать файлы из глобальных точек, вы можете запускать небольшие кусочки кода близко к пользователю, уже во время запроса.

Вот где «инфраструктура фронтенда без опс‑команды» становится реальностью: многие команды получают глобальное распределение и умную обработку запросов без управления серверами в нескольких регионах.

Для чего полезны edge‑функции

Edge‑функции хороши, когда нужны быстрые решения перед отдачей страницы:

- Персонализация: выбирать контент по локации, устройству или сегменту пользователя.

- Проверки авторизации: перенаправлять неаутентифицированных, валидировать сессии, ставить заголовки.

- A/B‑тесты: направлять пользователей в эксперименты последовательно без лишних кругов.

Когда edge — это перекос

Если сайт в основном статический, трафик низкий или есть строгие требования о том, где именно может исполняться код (правовые или требования по резидентности данных), edge может добавить сложности без явной пользы.

Компромиссы

Запуск кода по многим локациям усложняет наблюдаемость и отладку: логи и трассировки распределены, а воспроизвести «ошибка только в одном регионе» бывает тяжело.

Есть ещё поведение, завязанное на провайдере (API, лимиты, отличия рантайма), что влияет на переносимость.

При вдумчивом использовании возможности edge дают «глобальность по умолчанию» — без найма опс‑команды для склейки этого вручную.

Интеграция фреймворка и платформы: плюсы и минусы

Фреймворк и хост «подходят друг к другу», когда платформа понимает, что фреймворк генерирует во время сборки и что ему нужно во время запроса.

Это позволяет хосту интерпретировать артефакты сборки (статические файлы против серверных функций), применять правильные правила маршрутизации (динамические маршруты, переписывания) и задавать разумное поведение кэширования (что можно хранить на edge, а что должно быть свежим).

Что упрощает интеграция

Когда платформа знает соглашения фреймворка, многое исчезает:

- Оптимизация изображений может работать автоматически: фреймворк выдаёт предсказуемый конвейер, платформа выполняет его близко к пользователю, кеширует результаты и обрабатывает форматы.

- Заголовки и редиректы становятся конфигурацией вместо пользовательского серверного кода. Вы декларируете намерение (security headers, кэш‑правила, канонические редиректы), а платформа применяет это стабильно.

- Превью‑деплои и настройки окружений «просто работают», потому что платформа умеет сопоставлять ветки, сборки и рантайм‑настройки с ожиданиями фреймворка.

В результате — меньше кастомных скриптов и меньше сюрпризов «работает у меня» при деплое.

Компромиссы тесной интеграции

Минус — привязка удобством. Если приложение опирается на фичи провайдера (API edge‑функций, проприетарные правила кэша, плагины сборки), переход позже может потребовать переписывания маршрутизации, middleware или пайплайна деплоя.

Чтобы сохранить переносимость, разделяйте ответственности: держите бизнес‑логику фреймворк‑нативной, документируйте зависимое от хоста поведение и предпочитайте стандарты (HTTP‑заголовки, редиректы, env‑переменные).

Как оценивать альтернативы

Не думайте, что есть единственный лучший выбор. Сравнивайте платформы по: потоку деплоя, поддерживаемым режимам рендеринга, контролю кэша, поддержке edge, наблюдаемости, предсказуемости ценообразования и лёгкости выхода.

Небольшой proof‑of‑concept — деплой одного репозитория на двух провайдеров — часто быстрее показывает реальные различия, чем месяцы чтения документации.

Производительность как функция: быстро для пользователей и для команд

Производительность — это не просто хвастовство в тестах скорости. Это функция продукта: быстрые страницы снижают отказы и повышают конверсии, а быстрые сборки позволяют командам чаще выпускать без ожиданий.

Два вида «быстро», которые важны

Для пользователей «быстро» означает, что страница становится пригодной к использованию быстро — особенно на средних телефонах и медленных сетях. Для команд «быстро» — это когда деплои занимают минуты (или секунды), и изменения можно выпускать с уверенностью.

Vercel популяризовал идею, что можно оптимизировать и то, и другое, делая производительность частью рабочего процесса по умолчанию, а не отдельным проектом.

Инкрементальные сборки и кэширование (простыми словами)

Традиционная сборка часто перестраивает всё, даже если вы изменили одну строчку на одной странице. Инкрементальные сборки стремятся перестроить только то, что изменилось — как обновить одну главу книги вместо перевыпуска всей печати.

Кэширование помогает переиспользовать ранее вычисленные результаты:

- Кэш сборки переиспользует части предыдущих сборок, чтобы следующий деплой был быстрее.

- Кэш рендеринга держит предвычисленные страницы близко к пользователям, чтобы повторные посещения не запускали одну и ту же работу.

В Next.js шаблоны вроде incremental static regeneration (ISR) соответствуют этой логике: отдавать быструю предсобранную страницу и обновлять её в фоне при изменении контента.

Бюджеты производительности: ограничители, а не идеал

Бюджет производительности — это простое соглашение, например «держать homepage < 200KB JavaScript» или «Largest Contentful Paint < 2.5s на типичном мобильном». Цель не идеальность, а не допустить, чтобы производительность тихо деградировала.

Простые проверки в вашем workflow

Держите их лёгкими и последовательными:

- Запускайте Lighthouse в CI для ключевых страниц и фейлите билд при нарушении бюджета.

- Собирайте реальные метрики пользователей (RUM), чтобы смотреть на реальный опыт, а не только лабораторные результаты.

- Проверяйте изменения размера бандла в PR, чтобы ловить «ещё одну библиотеку» на раннем этапе.

Когда скорость — это фича, вы получаете лучшее UX и более быструю командную итерацию без перманентных пожаров на релизах.

Делать массовым: дефолты, шаблоны и кривая обучения

Инструменты становятся массовыми не потому, что они максимально гибкие, а потому, что новый пользователь может быстро добиться успеха.

Как выбирают массовые билдеры

Малые команды, агентства и продуктовые девелоперы без глубокой инфры обычно задают простые вопросы:

- Смогу ли мы запустить реальный сайт за неделю?

- Будет ли он быстр по умолчанию?

- Сможем ли мы безопасно менять его позже?

Здесь шаблоны, понятная документация и «счастливый путь» важнее длинного списка опций. Шаблон, деплойный за минуты и демонстрирующий маршрутизацию, загрузку данных и авторизацию, убедительнее матрицы фич.

Документация, показывающая один рекомендуемый подход (и объясняющая, когда отклоняться), сокращает время догадок.

Почему разумные дефолты лучше бесконечных настроек

Длинный список переключателей выглядит мощно, но заставляет каждую команду становиться экспертом, чтобы принять базовые решения. Разумные дефолты снижают когнитивную нагрузку:

- хорошее поведение кэша из коробки

- рекомендованный способ рендеринга для каждого типа страницы

- безопасная работа с переменными окружения

- стандартные шаги сборки/деплоя, которые редко требуют кастома

Когда дефолты правильные, команды тратят время на продукт, а не на конфигурацию.

Что должны покрывать шаблоны

Реальные проекты чаще всего стартуют с проверенных паттернов:

- E‑commerce: страницы товара, поиск, интеграции чекаута, SEO

- Контент: страницы из CMS, превью, оптимизация изображений

- Дашборды: авторизация, ролевой доступ, быстрая навигация, API‑интенсивные страницы

Лучшие шаблоны не только красиво выглядят — они кодируют проверенную структуру.

Подводные камни для новичков

Два типичных ошибки:

- Переинжиниринг на старте: добавление edge‑логики, сложного кэширования или нескольких слоёв данных до появления трафика.

- Путаница в режимах рендеринга: смешивание SSR/SSG/CSR без ясной причины, что ведёт к медленным страницам или хрупким сборкам.

Хорошая кривая обучения подталкивает команды к одному понятному старту и делает продвинутые опции осознанными апгрейдами.

Продуктизация дальше деплоя: от идеи к рабочему приложению

Платформы деплоя продуктизировали путь от Git к проду. Параллельный тренд идёт выше: продуктизировать путь от идеи к рабочей кодовой базе.

Koder.ai — пример «vibe‑coding»: вы описываете желаемое через чат, а платформа с агентными LLM‑воркфлоу генерирует и итеративно улучшает реальное приложение. Поддерживается веб/сервер/мобильные проекты (React фронтенд, Go + PostgreSQL бекенд, Flutter для мобайл), с практичными фичами экспорта исходников, деплоя/хостинга, кастомных доменов, снапшотов и откатов.

На практике это естественно сочетается с рабочим процессом из этой статьи: сократите цикл от намерения → реализации → превью URL → прод, сохраняя запасной выход (экспорт кода), когда вы перерастёте дефолты.

На что смотреть при выборе фронтенд‑платформы

Выбирать платформу — это не просто выбрать «где хостить». Это выбрать дефолтный рабочий поток вашей команды: как код превращается в URL, как проходят ревью изменений и как решаются простои.

1) Модель затрат: за что вы реально платите

Платформы похожи на главной странице, но расходятся в биллинге. Сравнивайте единицы, которые соответствуют вашему реальному использованию:

- Модель ценообразования: фикс vs. usage‑based, и что включено в каждый уровень.

- Минуты сборки: как считается CI/CD‑время, потребляют ли превью те же ресурсы, и что происходит при превышении лимитов.

- Трафик и запросы: как учитывается egress, включён ли CDN‑трафик и как платформа обрабатывает всплески.

- Командные места: кто считается платным пользователем (разработчики, дизайнеры, подрядчики) и есть ли роли только для чтения.

Практический совет: смоделируйте расходы для обычного месяца и для «недели запуска». Если не можете симулировать оба сценария, рискуете получить сюрприз в худший момент.

2) Надёжность, регионы и масштабирование

Вам не нужно быть экспертом по инфре, но задайте прямые вопросы:

- Где можно разворачивать (регионы/локации edge) и можно ли это контролировать?

- Что происходит при всплесках трафика — троттлинг, очередь или отказ?

- Как освещаются инциденты, есть ли публичная страница статуса?

- Как устроен откат: в один клик, автоматический или ручной?

Если у вас глобальные клиенты, покрытие регионов и поведение кэша могут быть столь же важны, как сырая производительность.

3) Базовые требования безопасности

Ищите ежедневные гарантии, а не расплывчатые обещания:

- Управление секретами: как хранятся, вращаются и ограничиваются env‑переменные (prod vs preview).

- Контроль доступа: RBAC, поддержка SSO, разделение проектов.

- Аудит: видимость деплоев, изменений конфигурации и кто что делал.

4) Лёгкий чек‑лист отбора

Используйте его как быстрый фильтр перед глубокой оценкой:

- Можно ли создать превью‑деплои для каждого PR с минимальной настройкой?

- Поддерживает ли платформа наши потребности в рендеринге (статическое, серверное, edge) без доп‑склейки?

- Логи, метрики и трассировки легко найти при инциденте?

- Можно ли экспортировать/мигрировать позже без переписывания приложения?

Выберите платформу, которая уменьшает количество «решений по деплою», которые команда принимает каждую неделю — но оставляет контроль там, где он действительно важен.

Выводы: простой плейбук для команд, которые выпускают веб

Продуктизация превращает решения по деплою и рендерингу из кастомной инженерной работы в повторяемые дефолты. Это снижает трение в двух ключевых местах: доставка изменений и предсказуемость производительности.

Когда путь commit → preview → production стандартизирован, итерации ускоряются, потому что меньше релизов зависят от специалиста (или удачного полудня дебага).

Практический путь миграции (начните с малого, измеряйте, расширяйте)

Начните с минимальной области, дающей обратную связь:

- Сначала добавьте превью‑деплои. Относитесь к каждому PR как к кликабельному ревью.

- Перенесите одну страницу или маршрут на дефолт фреймворка (например, маркетинговую страницу на статическую генерацию или страницу под аккаунтом на серверный рендер) и сравните результаты.

- Измеряйте важное: время сборки, частоту деплоев, время отката, Core Web Vitals и «время на ревью» для стейкхолдеров.

Когда это заработает, расширяйте постепенно:

- Сведите окружения (preview/staging/prod) и определите, кто может продвигать изменения.

- Вводите edge или serverless‑функции только там, где выигрыш по латентности или персонализации оправдан.

- Стандартизируйте шаблоны, чтобы новые проекты стартовали с рабочей авторизацией, аналитикой и кэш‑паттернами.

Поддерживайте лёгкие пути обучения

Если хотите углубиться, не теряя направления, просмотрите паттерны и кейсы на /blog, а затем проверьте стоимость и лимиты на /pricing.

Если вы экспериментируете с быстрыми способами перейти от требования к рабочей базе (особенно для маленьких команд), Koder.ai может быть полезным компаньоном: сгенерировать первую версию через чат, быстро итератировать с заинтересованными и затем сохранить тот же продуктизированный путь к превью, откатам и продакшену.

Удобство vs контроль: как принимать решение

Интегрированные платформы оптимизируют скорость релизов и снижают операционные решения. Компромисс — меньше низкоуровневого контроля (кастомная инфра, уникальные требования соответствия, специализированные сети).

Выбирайте «наиболее продуктизированную» конфигурацию, которая всё ещё соответствует вашим ограничениям — и держите план выхода (портируемая архитектура, чёткие шаги сборки), чтобы выбор был силой, а не уловкой.

FAQ

Что значит «продуктизировать инфраструктуру фронтенда»?

Это значит упаковать все хаотичные части процесса доставки фронтенда — сборки, деплои, превью, обработку SSR/SSG, кэширование и глобальную доставку — в повторяемый рабочий процесс с продуманными настройками по умолчанию.

На практике это уменьшает количество кастомных скриптов и «сценариев из головы» нужных, чтобы превратить коммит в надёжный продакшен-URL.

Почему деплой эволюционировал из «хостинга» в продукт?

Потому что деплой перестал быть редкой задачей и стал ежедневным рабочим процессом. Команды начали нуждаться в:

- превью-URL для каждого пулл-реквеста

- безопасных и быстрых откатах

- согласованных окружениях (preview/staging/prod)

- минимуме ручных шагов между кодом и продакшеном

Когда такие потребности стали массовыми, их можно было стандартизировать в продуктовый опыт вместо того, чтобы каждый проект решал всё заново.

Почему SSR сложнее в эксплуатации, чем статический хостинг?

SSR — это не просто отдача файлов; это исполнение серверного кода для генерации HTML и затем обеспечение его быстрого и безопасного кэширования и маршрутизации.

Типичные источники сложности: настройка рантайма (Node/функции без сервера), инвалидация кэша, cold starts, заголовки/переписывания маршрутов и обеспечение того, чтобы поведение в продакшене соответствовало локальной разработке.

В практическом плане, чем отличаются SSR, SSG и CSR?

Думайте о том, когда создаётся HTML:

- SSR: HTML создаётся при запросе (часто с кэшированием для скорости).

- SSG: HTML создаётся во время сборки и отдаётся как статические файлы.

- CSR: HTML в основном собирается в браузере после загрузки JavaScript.

Многие приложения комбинируют подходы: SSG для лендингов/доков, SSR для индексируемых динамических страниц и CSR для сильно интерактивных частей под авторизацией.

Что добавляет Next.js по сравнению с обычным React-приложением?

Обычное React-приложение часто превращается в «React + набор решений» (роутер, сборка, стратегия рендеринга, внутренние соглашения). Next.js стандартизирует типичные потребности:

- встроенные соглашения по маршрутам

- несколько шаблонов загрузки данных (на сервере/во время сборки/в браузере)

- поведенчески продуманные настройки для производительности

Особенно ценен, когда нужны SEO, разные режимы рендеринга или согласованная структура приложения.

Когда Next.js избыточен?

Если вы создаёте небольшой преимущественно статический сайт, простой внутренний инструмент или что-то, где SEO и время первого рендера не критичны, Next.js может быть избыточен.

В таких случаях лёгкий статический набор инструментов (или простое SPA) может быть дешевле в эксплуатации и проще в понимании.

Как превью-деплои меняют командную работу?

Превью-деплои дают шаряемый URL для каждого пулл-реквеста, который близок к поведению продакшена.

Это улучшает сотрудничество, потому что:

- QA тестирует тот самый билд, который уйдёт в прод

- дизайнеры проверяют реальные взаимодействия и отступы

- PM и стейкхолдеры кликают и комментируют без локальной настройки

Это также уменьшает неожиданные «только в стейджинге» сюрпризы в последний момент.

SSR автоматически быстрее для пользователей?

Не обязательно. SSR может быть медленным, если каждый запрос инициирует тяжёлую работу (долгие обращения к БД, медленные API).

SSR даёт выигрыш по скорости, когда его сопровождает разумная стратегия кэширования:

- кэшировать отрендеренный HTML на сервере/CDN/edge, когда это безопасно

- задавать чёткие правила свежести, чтобы не перерасходовать запросы

- избегать работы на каждый запрос, которую можно предварительно вычислить или закэшировать

Часто выигрыш приходит из стратегии кэширования, а не только из SSR.

Для чего полезны edge-функции — и когда они не стоят того?

Edge выполняет небольшие куски кода близко к пользователю, что полезно для:

- быстрых редиректов и проверок авторизации

- маршрутизации для A/B-тестов

- лёгкой персонализации

Это избыточно, если сайт в основном статический, трафик низкий, или есть строгие требования к месту выполнения кода (региональная юрисдикция/соответствие). Также отладка сложнее: логи и ошибки распределены по регионам.

В чём плюсы и риски плотной интеграции Next.js с платформой?

Интеграция упрощает вещи вроде маршрутизации, превью и кэширования, потому что хост понимает, что фреймворк генерирует во время сборки. Минус — удобство ведёт к привязке к платформе.

Чтобы сохранить путь назад:

- держите бизнес-логику фреймворк-нативной

- используйте стандарты (HTTP-заголовки, редиректы, переменные окружения)

- документируйте платформо-специфичное поведение

Практический тест — задеплойте один репозиторий на двух провайдерах и сравните трение.