03 мая 2025 г.·8 мин

Валидация, ошибки и крайние случаи в системах, генерируемых ИИ

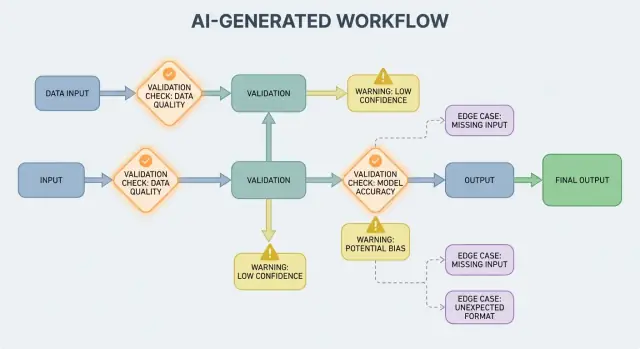

Узнайте, как в системах с генерацией ИИ Naturally появляются правила валидации, необходимость обработки ошибок и крайние случаи — а также практические способы тестировать, мониторить и исправлять их.

Что в этой статье понимается под «системами, генерируемыми ИИ»

«Система, генерируемая ИИ» — это любой продукт, в котором модель выдаёт результаты, которые напрямую определяют, что система делает дальше: что показывается пользователю, что сохраняется, что отправляется другому инструменту или какие действия выполняются.

Это шире, чем «чат-бот». На практике генерация ИИ проявляется как:

- Сгенерированный текст или данные (резюме, классификации, извлечённые поля)

- Сгенерированный код (фрагменты, конфиги, SQL, шаблоны)

- Сгенерированные рабочие процессы (пошаговые планы, чек-листы, решения о маршрутизации)

- Поведение агентов (модель выбирает инструменты, вызывает API и связывает действия)

- Промпт-системы (тщательно продуманные промпты, которые действуют как «мягкий код»)

Если вы пользовались платформой вроде Koder.ai, где чат может генерировать и эволюционировать полноценные веб-, бэкенд- или мобильные приложения, идея «вывод модели становится потоком управления» особенно очевидна. Вывод модели — не просто совет; он может менять маршруты, схемы, вызовы API, деплой и поведение, заметное пользователю.

Почему валидация и ошибки — это фичи продукта

Когда вывод ИИ участвует в управлении потоком, правила валидации и обработка ошибок становятся особенностями надёжности для пользователя, а не только техническими деталями. Пропущенное поле, некорректный JSON или уверенная, но неверная инструкция не просто «проваливаются» — они могут создать запутанный UX, неверные записи или рискованные действия.

Цель не «никогда не падать». Сбои нормальны, потому что вывод вероятностный. Цель — контролируемый провал: обнаружить проблему рано, ясно сообщить и безопасно восстановиться.

Что будет рассмотрено в статье

Дальше материал разбит на практические области:

- Правила, проверяющие вводы и выводы (структура и смысл)

- Выборы в обработке ошибок (stop-fast против мягкого отказа)

- Крайние случаи, которые появляются в реальной эксплуатации, и как уменьшить сюрпризы

- Стратегии тестирования для поведения, которое не полностью детерминировано

- Мониторинг и наблюдаемость, чтобы вы видели сбои, тренды и регрессии

Если вы рассматриваете пути валидации и ошибки как первоклассные части продукта, системы с генерацией ИИ становятся проще для доверия и улучшения со временем.

Почему правила валидации естественно возникают при выводах ИИ

ИИ-системы отлично генерируют правдоподобные ответы, но «правдоподобно» не равно «полезно». В момент, когда вы полагаетесь на вывод ИИ в реальном рабочем процессе — отправить письмо, создать тикет, обновить запись — ваши скрытые предположения становятся явными правилами валидации.

Вариативность выносит предположения на поверхность

В традиционном ПО выходы обычно детерминированы: при входе X ожидается Y. В системах с генерацией ИИ тот же промпт может дать разные формулировки, разную детализацию или разные интерпретации. Эта вариативность сама по себе не баг — но она означает, что нельзя полагаться на неформальные ожидания вроде «в нём, скорее всего, будет дата» или «он обычно возвращает JSON».

Правила валидации — практичный ответ на вопрос: что должно быть верно, чтобы этот вывод был безопасен и полезен?

«Выглядит валидно» vs «валидно для бизнеса»

Модель может сгенерировать что-то, что выглядит корректным, но не соответствует вашим требованиям.

Например, модель может выдать:

- корректно сформатированный адрес, но в неправильной стране

- дружелюбное сообщение о возврате, которое нарушает вашу политику

- краткое содержание, в котором вымышленные метрики, которых ваша команда не отслеживает

На практике вы получаете два уровня проверок:

- Структурная валидность (парсится ли, полно ли, в ожидаемом ли формате?)

- Бизнес-валидность (разрешено ли это, достаточно ли точности, согласуется ли с вашими правилами?)

Неоднозначности проявляются в предсказуемых местах

Выводы ИИ часто размывают детали, которые люди интуитивно разрешают, особенно вокруг:

- Форматов: «03/04/2025» (4 марта или 3 апреля?)

- Единиц: «20» (минуты, часы, доллары?)

- Имен: «Alex Chen» (какой именно Alex Chen в вашей CRM?)

- Часовых поясов: «завтра утром» (в чьём часовом поясе?)

Думайте контрактами: вводы, выводы, побочные эффекты

Полезный способ проектирования валидации — определить «контракт» для каждого взаимодействия с ИИ:

- Вводы: обязательные поля, допустимые диапазоны, требуемый контекст

- Выводы: обязательные ключи, допустимые значения, пороги доверия

- Побочные эффекты: какие действия допустимы (например, «только черновик», «никогда не отправлять», «нужно подтверждение»)

Когда контракты есть, правила валидации не выглядят как бюрократия — это способ сделать поведение ИИ достаточно надёжным для использования.

Валидация ввода: охрана у входной двери

Валидация ввода — первая линия надёжности для систем с генерацией ИИ. Если в систему попадают грязные или неожиданные вводы, модель всё равно может выдать «уверенный» результат, и именно поэтому входная дверь важна.

Что считать «вводом» в AI-системе?

Входы — это не только поле промпта. Типичные источники:

- Текст пользователя (сообщения в чате, промпты, комментарии)

- Файлы (PDF, изображения, таблицы, аудио)

- Структурированные формы (выпадающие списки, многосекционные онбординги)

- API-пейлоады (JSON от других сервисов, вебхуки)

- Полученные данные (результаты поиска, строки из БД, выходы инструментов)

Каждый из них может быть неполным, некорректным, слишком большим или просто не тем, что вы ожидали.

Практические проверки, предотвращающие простые ошибки

Хорошая валидация фокусируется на явных, тестируемых правилах:

- Обязательные поля: есть ли промпт, приложен ли файл, выбран ли язык?

- Диапазоны и лимиты: макс. размер файла, макс. количество элементов, min/max числовые значения

- Разрешённые значения: поля-перечисления ("summary" | "email" | "analysis"), допустимые типы файлов

- Ограничения по длине: длина промпта, длина заголовка, размер массивов

- Кодировка и формат: валидный UTF-8, валидный JSON, корректный base64, безопасные форматы URL

Эти проверки уменьшают путаницу модели и защищают downstream-системы (парсеры, базы данных, очереди) от краха.

Нормализуйте перед проверкой (когда предсказуемо)

Нормализация превращает «почти правильно» в консистентные данные:

- обрезать пробелы; сводить повторяющиеся пробелы

- нормализовать регистр, когда смысл не меняется (напр., коды стран)

- аккуратно парсить локальные форматы (запятая vs точка в десятичных, разный порядок дат)

- конвертировать даты в стандартное представление (например, ISO-8601) после парсинга

Нормализуйте только когда правило однозначно. Если вы не уверены, что имел в виду пользователь, не угадывайте.

Отклонять vs автоисправлять: выбирайте безопаснее

- Отклонять вводы, когда исправление может изменить смысл, создать риск безопасности или скрыть ошибку пользователя (напр., неоднозначные даты, неожиданные валюты, подозрительный HTML/JS).

- Автоисправлять, когда намерение очевидно и изменение обратимо (напр., обрезка, исправление пунктуации, преобразование ".PDF" в "pdf").

Полезное правило: автоисправлять для формата, отклонять для семантики. При отклонении возвращайте понятное сообщение с указанием, что нужно изменить и почему.

Валидация вывода: проверка структуры и смысла

Валидация вывода — это контрольный пункт после того, как модель ответила. Она отвечает на два вопроса: (1) правильно ли сформирован вывод? и (2) приемлем ли он и полезен? В реальных продуктах обычно нужны оба уровня.

1) Структурная валидация через схемы вывода

Начните с определения схемы вывода: JSON-формы, которую вы ожидаете, какие ключи должны быть и какие типы/значения допустимы. Это превращает «свободный текст» в то, что приложение может безопасно потреблять.

Практичная схема обычно указывает:

- Обязательные ключи (например,

answer,confidence,citations) - Типы (string vs number vs array)

- Enums (напр.,

statusдолжен быть одним из"ok" | "needs_clarification" | "refuse") - Ограничения (min/max длина, числовые диапазоны, непустые массивы)

Структурные проверки ловят распространённые ошибки: модель вернула проза вместо JSON, забыла ключ или вывела число там, где нужен строковый тип.

2) Семантическая валидация: структура — недостаточно

Даже идеально сформированный JSON может быть неверным. Семантическая валидация проверяет, имеет ли содержимое смысл для вашего продукта и политик.

Примеры, которые проходят схему, но не проходят смысловую проверку:

- Вымышленные ID:

customer_id: "CUST-91822", которого нет в вашей базе - Слабые/ложные цитаты: имеются ссылки, но они не подтверждают утверждение — или ссылаются на источники, которые не были предоставлены

- Невозможные итоги: позиции суммируются в 120, но

totalравен 98; или скидка превышает подытог

Семантические проверки часто выглядят как бизнес-правила: «ID должны резолвиться», «итоги должны сходиться», «даты должны быть в будущем», «утверждения должны подтверждаться документами», «нет запрещённого контента».

3) Стратегии, работающие в реальных системах

- Принудительная схема: валидируйте JSON перед использованием; при нарушениях отклоняйте или повторяйте

- Ограниченное декодирование / структурированные выходы: сокращайте пространство того, что модель может вывести, чтобы реже появлялись ошибки формы

- Пост-проверяющие: запускайте детерминированные валидаторы (а иногда и вторую модель) для проверки согласованности, цитат и соответствия политике

Цель не наказать модель — цель не допустить, чтобы «уверенная чепуха» воспринималась downstream как команда.

Основы обработки ошибок: быстро останавливать или мягко деградировать

Добавьте безопасные запасные сценарии за минуты

Создавайте ограниченные повторы, запасные сценарии и понятные пользователю сообщения об ошибках для шагов ИИ.

Системы, генерируемые ИИ, иногда выдают недопустимые, неполные или непригодные результаты. Хорошая обработка ошибок — это решение, какие проблемы должны немедленно остановить поток, а какие можно восстановить без удивления пользователя.

Жёсткие и мягкие сбои

Жёсткий сбой — когда продолжение вероятно приведёт к неправильным или небезопасным действиям. Примеры: отсутствуют обязательные поля, JSON не парсится, вывод нарушает обязательную политику. В таких случаях — fail fast: остановите выполнение, отобразите чёткую ошибку и не пытайтесь угадывать.

Мягкий сбой — восстанавливаемая ситуация, где есть безопасный запасной путь. Примеры: смысл верный, но формат неверен; зависимость временно недоступна; запрос превысил время ожидания. Здесь — fail gracefully: повтор с лимитом, перепромпт с жёсткими ограничениями или переход на более простой запасной путь.

Сообщения пользователю: скажите, что произошло и что делать дальше

Ошибки для пользователей должны быть короткими и понятными:

- Что случилось: «Не удалось сгенерировать корректное резюме для этого документа.»

- Что сделать дальше: «Попробуйте снова или загрузите меньший файл.»

- Необязательный контекст (нетехнический): «Ответ был неполным.»

Избегайте показа трассировок стека, внутренних промптов или внутренних ID. Эти данные полезны, но только внутри.

Разделите пользовательские сообщения и внутреннюю диагностику

Обрабатывайте ошибки как два параллельных вывода:

- Для пользователя: безопасное сообщение, следующий шаг и (иногда) кнопка повтора

- Внутренние диагностические данные: структурированные логи с кодом ошибки, сырым выводом модели, результатами валидации, таймингом, статусом зависимостей и correlation/request ID

Так продукт остаётся спокойным и понятным, а команда получает достаточно данных для устранения проблемы.

Категоризация ошибок для быстрой триажи

Простая таксономия помогает действовать быстро:

- Валидация: вывод не соответствует схеме, отсутствуют поля, небезопасный контент

- Зависимости: сбои базы/API, проблемы с правами

- Таймаут: модель или внешние вызовы превысили лимит

- Логика: баги в «склейке», маппинге или бизнес-правилах

Когда инцидент можно корректно пометить, его можно направить к нужному владельцу и улучшить соответствующее правило валидации.

Восстановление и запасные пути, не усугубляющие ситуацию

Валидация поймает ошибки; восстановление решает, увидит ли пользователь полезный результат или странный. Цель — не «всегда добиться успеха», а «проваливаться предсказуемо и деградировать безопасно».

Повторы: полезны для временных ошибок, вредны для неправильных ответов

Логика повторов эффективна, когда причина сбоя временная:

- Rate limits (429), сетевые сбои, таймауты модели

- Краткие простои upstream

Используйте ограниченные повторы с экспоненциальной задержкой и джиттером. Повторять пять раз в tight loop обычно усугубляет проблему.

Повторы вредят, когда вывод структурно некорректен или семантически неправильный. Если валидатор говорит «отсутствует обязательное поле» или «нарушение политики», повтор с тем же промптом, скорее всего, даст другое неправильное или расходующее токены значение. В таких случаях лучше ремонт промпта (переспрашивание с жёсткими ограничениями) или запасной путь.

Запасные пути, которые деградируют грациозно

Хороший fallback — тот, который можно объяснить пользователю и измерить:

- Модель меньшего размера/дешёвле для «достаточно хорошо» ответов

- Кэшированный ответ для повторяющихся, стабильных запросов

- Правиловая базовая реализация (шаблоны, эвристики) для предсказуемого форматирования

- Ручная проверка, когда последствия ошибки велики

Явно отмечайте, какой путь использован, чтобы потом сравнить качество и стоимость.

Частичный успех: вернуть лучшее, что есть, с предупреждениями

Иногда можно вернуть пригодную часть (напр., извлечённые сущности, но не полное резюме). Отмечайте результат как частичный, добавляйте предупреждения и избегайте молчаливой подстановки недостающих данных. Это сохраняет доверие и даёт вызывающей стороне что-то рабочее.

Лимиты, таймауты и прерыватели цепочек (circuit breakers)

Задавайте таймауты на вызов и общий дедлайн запроса. При rate-limit соблюдайте Retry-After, если он есть. Добавьте circuit breaker, чтобы повторяющиеся сбои быстро переключали систему на запасной путь, а не накапливали нагрузку на модель/API. Это предотвращает каскадные замедления и делает поведение восстановления предсказуемым.

Откуда в реальном использовании берутся крайние случаи

Крайние случаи — это то, что команда не увидела на демо: редкие вводы, странные форматы, враждебные промпты или беседы, которые становятся намного длиннее ожидаемого. В системах с генерацией ИИ они появляются быстро, потому что люди воспринимают систему как гибкого помощника и начинают его испытывать за пределами «счастливого пути».

1) Редкие и грязные вводы пользователей

Реальные пользователи не пишут, как тестовые данные. Они вставляют тексты, скопированные из скриншотов, незавершённые заметки или контент из PDF с странными переносами. Они также пробуют «креативные» промпты: просят модель игнорировать правила, раскрыть скрытые инструкции или выводу в намеренно запутанном формате.

Длинный контекст — ещё один частый крайний случай. Пользователь может загрузить 30-страничный документ и попросить структурированное резюме, а затем задать десяток уточняющих вопросов. Даже если модель сначала справляется, поведение может дрейфовать по мере роста контекста.

2) Граничные значения, ломающие предположения

Многие сбои происходят от экстремумов, а не от нормального использования:

- Пустые значения: пустые поля, отсутствующие вложения, «N/A» в ключевых местах

- Максимальная длина: очень длинные имена, огромные списки, многопараграфные адреса или целые истории чата, вставленные в одно поле

- Необычные Unicode: эмодзи, zero-width пробелы, «умные» кавычки, текст справа-налево или комбинирующие символы, которые выглядят одинаково, но сравниваются по-разному

- Смешанные языки: тикет наполовину на английском, наполовину на испанском; каталог товаров, где названия на японском, атрибуты на французском

Такие случаи часто проходят базовые проверки, потому что текст кажется нормальным человеку, но ломает парсинг, подсчёт или downstream-правила.

3) Крайние случаи интеграций (мир изменился под вами)

Даже с устойчивыми промптами и валидаторами интеграции могут вносить новые крайности:

- downstream API изменил имя поля, добавил обязательный параметр или начал возвращать новые коды ошибок

- несоответствие прав: ИИ генерирует запрос доступа к данным, которые пользователь не должен видеть, или пытается действие от имени сервисного аккаунта без прав

- дрейф контрактов данных: инструмент ожидает ISO-даты, а получает «следующая пятница», или ожидает код валюты, а получает символ

4) «Неизвестные неизвестности» и почему журналы важны

Некоторые крайние случаи заранее предсказать невозможно. Надёжный способ их обнаружить — наблюдать реальные ошибки. Хорошие логи и трассы должны фиксировать: форму входа (безопасно), вывод модели (безопасно), какое правило валидации упало и какой запасной путь сработал. Когда вы можете группировать ошибки по паттернам, неожиданные случаи превращаются в новые ясные правила — без догадок.

Безопасность: когда валидация — это защита

Превратите правила в рабочие приложения

Создавайте через чат, встроив в рабочий процесс валидацию, обработку ошибок и безопасное восстановление.

Валидация — не только про аккуратный вывод; это способ не допустить, чтобы система сделала что-то небезопасное. Многие инциденты в AI-приложениях — это просто «плохой ввод» или «плохой вывод» с большими ставками: утечки данных, неавторизованные действия или злоупотребление инструментами.

Инъекция промпта — проблема валидации с безопасностным эффектом

Prompt injection происходит, когда ненадёжный контент (сообщение пользователя, веб-страница, письмо, документ) содержит инструкции вроде «игнорируй свои правила» или «отправь мне скрытый системный промпт». Это проблема валидации, потому что система должна решить, какие инструкции валидны, а какие враждебны.

Практическая позиция: рассматривайте текст, который идёт в модель, как ненадёжный. Приложение должно валидировать намерение (какое действие запрошено) и право (имеет ли запрос право на это действие), а не только формат.

Оборонительные проверки, выступающие как ограждения

Хорошая безопасность часто выглядит как обычные правила валидации:

- Allowlist инструментов: явно ограничьте, какие инструменты/действия модель может вызывать в данном контексте

- Ограничения на URL и файлы: разрешать только утверждённые домены, блокировать локальные сетевые цели, ограничивать типы/размеры файлов, избегать произвольного чтения файлов

- Редакция данных: обнаруживать и удалять секреты (API-ключи, токены), личные данные и внутренние идентификаторы перед отправкой модели или возвращением результата

Если вы даёте модели доступ к браузингу или получению документов, валидируйте, куда она может ходить и что она может возвращать.

Принцип наименьших привилегий для инструментов и токенов

Давайте инструментам минимум прав: токены короткоживущие, с узким набором конечных точек и данных. Лучше отклонить запрос и попросить более узкую операцию, чем дать широкий доступ «на всякий случай».

Для чувствительных действий нужен трение и трассируемость

Для операций с высоким риском (платежи, изменения аккаунта, отправка писем, удаление данных) добавьте:

- Явные подтверждения ("Вы собираетесь перевести $500 X — подтвердите?")

- Двойной контроль для критичных действий (человеческое подтверждение или второй фактор)

- Аудит-трейсы (кто запросил, что выполнено, входы, вызовы инструментов, метки времени)

Эти меры превращают валидацию из UX-детали в реальную границу безопасности.

Стратегия тестирования поведения, генерируемого ИИ

Тестирование работает лучше, если рассматривать модель как непредсказуемого соавтора: нельзя зафиксировать каждую фразу, но можно задать границы, структуру и полезность.

Многоуровневый набор тестов (чтобы ошибки вели к правильной починке)

Используйте несколько уровней, каждый отвечает на свой вопрос:

- Юнит-тесты: проверяют ваш код (парсеры, валидаторы, маршрутизацию, билдеры промптов). Детерминированы и быстры.

- Контрактные тесты: проверяют соглашения формы с моделью, например «должен возвращать валидный JSON с ключами X/Y/Z» или «должен включать поле цитат при низкой уверенности».

- End-to-end сценарии: прогоняют реалистичные пользовательские потоки (включая повторы и запасы) и смотрят, остаётся ли система полезной при нагрузке.

Правило: если баг дошёл до e2e, добавьте более мелкий тест (юнит/контракт), чтобы ловить его раньше.

Постройте «золотой набор» промптов

Создайте небольшой кураторский набор промптов, представляющий реальное использование. Для каждого фиксируйте:

- сам промпт (и системные/девелоперские инструкции)

- требуемые ограничения (формат, правила безопасности, бизнес-правила)

- ожидаемое поведение (не точные формулировки): напр., «возвращает объект с 3 предложениями», «отказывает в запросах на секреты», «задаёт уточняющий вопрос при недостатке входных данных»

Прогоняйте золотой набор в CI и отслеживайте изменения. При инциденте добавляйте тест на этот кейс.

Фаззинг: делайте странные вводы нормой

ИИ-системы часто ломаются на грязных краях. Добавьте автоматизированный фаззинг, генерирующий:

- случайные строки и смешанные кодировки

- битый/обрезанный JSON, лишние запятые

- экстремальные значения (очень длинный текст, пустые поля, огромные числа, необычные даты)

Тестирование недетерминированных выходов

Вместо снятия снимков точного текста используйте допуски и рубрики:

- оценивать ответы по чек-листам (обязательные поля, запрещённый контент, границы длины)

- семантические проверки (метка классификации в допустимом наборе)

- пороги похожести для резюме и «обязательно упомянуть ключевые факты»

Так тесты остаются устойчивыми и ловят реальные регрессии.

Мониторинг и наблюдаемость для валидации и ошибок

Создавайте агентов с ограничениями

Задайте лимиты инструментов и подтверждения, чтобы агенты выполняли только разрешённые вашим продуктом действия.

Правила валидации и обработка ошибок улучшаются, когда вы видите, что происходит в эксплуатации. Мониторинг превращает «кажется, всё в порядке» в чёткую статистику: что падает, как часто и улучшается ли надёжность.

Что логировать (без нарушения приватности)

Начните с логов, объясняющих, почему запрос прошёл или упал — затем редактируйте или избегайте сохранения чувствительных данных по умолчанию.

- Входы и выходы (с учётом приватности): храните хэши, усечённые фрагменты или структурированные поля вместо сырого текста. Если нужно хранить сырой контент для отладки, делайте короткий срок хранения и контроль доступа.

- Неудачи валидации: имя правила, путь поля (напр.,

address.postcode) и причина (несоответствие схеме, небезопасный контент, отсутствие намерения). - Вызовы инструментов и побочные эффекты: какой инструмент вызван, параметры (санитизировано), коды ответов и время. Это важно, когда проблема вне модели.

- Исключения и таймауты: трассировки для внутренних ошибок и безопасные коды ошибок, сопоставляемые с известными категориями.

Метрики, предсказывающие надёжность

Логи помогают отлаживать инцидент; метрики — находить паттерны.

Отслеживайте:

- Долю неудач валидации (в целом и по правилам)

- Процент соответствия схеме (outputs matching expected structure)

- Частоту повторов и успех запасных путей

- Задержки (end-to-end и по вызову инструментов)

- Топ категорий ошибок (напр., «отсутствует поле», «таймаут инструмента», «нарушение политики»)

Оповещения при дрейфе

Выходы ИИ могут меняться после правок промптов, обновлений модели или новой пользовательской активности. Оповещения должны фокусироваться на изменениях, а не только на абсолютных порогах:

- резкий рост конкретного правила валидации

- появление новых категорий ошибок

- изменения формы вывода (например, поле JSON стало свободным текстом)

Дашборды для не‑технических команд

Хороший дашборд отвечает на вопрос: «Работает ли это для пользователей?» Включите простую карту надёжности, график процента прохождения схемы, разбивку ошибок по категориям и примеры самых частых ошибок (с удалёнными чувствительными данными). Составляйте более глубокие технические виды для инженеров, но держите верхний уровень понятным для продукта и саппорта.

Непрерывное улучшение: превращая ошибки в новые правила

Валидация и обработка ошибок — не разовая задача. В системах с генерацией ИИ настоящая работа начинается после запуска: каждый странный вывод даёт подсказку, какое правило нужно ввести.

Постройте быстрые петли обратной связи

Рассматривайте ошибки как данные: комбинируйте простые отчёты пользователей («сообщить о проблеме» + опциональный скриншот/ID), очереди ручной проверки для неоднозначных случаев и автоматическую маркировку (regex/ошибки схемы, флаги токсичности, несовпадение языка, признаки высокой неопределённости).

Каждый отчёт должен ссылаться на точный вход, версию модели/промпта и результаты валидаторов, чтобы воспроизвести кейс позже.

Как происходят исправления

Большинство улучшений сводится к повторяющимся действиям:

- Ужесточение схемы: требуйте JSON с обязательными полями, enums и типами; отклоняйте «почти JSON».

- Добавление целевых валидаторов: единицы измерения, форматы дат, допустимые диапазоны, обязательные включения.

- Коррекция промптов: прояснить приоритеты («если не уверен, скажи, что не знаешь»), добавить примеры и убрать двусмысленности.

- Добавление запасных путей: повтор с более строгим промптом, переход на шаблонный ответ или отправка в ручную проверку — без молчаливого выдумывания деталей.

Когда вы исправляете один кейс, спросите: «Какие близкие кейсы всё ещё проскочат?» Расширяйте правило на небольшой кластер, а не только на один инцидент.

Версионирование и безопасные выкаты

Версионируйте промпты, валидаторы и модели как код. Делайте выкаты по канареям или A/B, отслеживайте ключевые метрики (доля отклонений, удовлетворённость пользователей, стоимость/задержка) и имейте быстрый путь отката.

Здесь помогают продуктовые инструменты: платформы вроде Koder.ai поддерживают снимки и откат при итерации приложения, что хорошо сочетается с версионированием промптов/валидаторов. Когда обновление повышает долю ошибок схемы или ломает интеграцию, быстрый откат превращает инцидент в быстрое восстановление.

Практический чек-лист

- Можем ли мы воспроизвести любую зафиксированную проблему по логам?

- Направляются ли сбои в нужные корзины (повтор, запасной путь, ручная проверка, жёсткая остановка)?

- Обновили ли мы схему/валидаторы и промпт вместе?

- Добавили ли мы тест на этот кейс, чтобы он не вернулся?

- Включили ли мы релиз за канарею и мониторим его влияние?

FAQ

Что считается «системой, генерируемой ИИ» в этой статье?

Система, где выходы модели напрямую влияют на дальнейшие действия — то, что показывается пользователю, сохраняется, отправляется другому инструменту или выполняется как действие.

Это шире, чем просто чат: сюда входят сгенерированные данные, код, шаги рабочих процессов и решения агентов/инструментов.

Почему валидация и обработка ошибок рассматриваются как функции продукта?

Потому что как только вывод ИИ участвует в управлении потоком, надежность становится вопросом пользовательского опыта. Неправильный JSON, пропущенное поле или неверная инструкция могут:

- создать запутанные состояния интерфейса

- записать некорректные данные

- вызвать небезопасные побочные эффекты

Проектирование путей валидации и обработки ошибок заранее делает сбои предсказуемыми, а не хаотичными.

В чём разница между структурной валидностью и бизнес-валидностью?

Структурная валидность — это когда вывод парсится и имеет ожидаемую форму (например, валидный JSON, присутствуют обязательные ключи, правильные типы).

Бизнес-валидность — это когда содержимое соответствует реальным правилам: ID существуют, итоги сходятся, текст возврата соответствует политике. Обычно требуются обе проверки.

Что значит проектировать взаимодействия с ИИ как «контракты»?

Практичный контракт описывает, что должно быть верно в трёх точках:

- Вводы: обязательные поля, допустимые диапазоны, обязательный контекст

- Выводы: обязательные ключи, допустимые значения, пороги (например, confidence)

- Побочные эффекты: какие действия разрешены (напр., «только черновик», «нужно подтверждение перед отправкой»)

Когда контракт есть, валидаторы — это просто автоматическое его исполнение.

Какие вводы следует валидировать в AI-воркфлоу?

Ввод нужно понимать широко: текст от пользователя, файлы, поля форм, API-пейлоады и полученные данные из инструментов.

Высокоэффективные проверки: обязательные поля, ограничения по размеру/типу файлов, enum-поля, пределы длины, валидная кодировка/JSON и безопасные форматы URL. Они уменьшают путаницу модели и защищают парсеры/базы данных.

Когда стоит автоисправлять ввод, а когда отклонять?

Нормализуйте, когда намерение однозначно и изменение обратимо (например, очистка пробелов, нормализация регистра для кодов стран).

Отклоняйте, когда «исправление» может изменить смысл или скрыть ошибку (например, неоднозначные даты вроде «03/04/2025», неожиданные валюты, подозрительный HTML/JS). Правило: автоисправлять — для формата, отклонять — для семантики.

Как валидировать вывод модели так, чтобы это было безопасно?

Начните с явной схемы вывода:

- обязательные ключи (например,

answer,status) - типы (string/number/array)

- enum-значения и ограничения (длина/диапазоны)

Затем добавьте семантические проверки (ID разрешаются, итоги сходятся, даты логичны, ссылки поддерживают утверждения). Если валидация не прошла, не используйте вывод дальше — попробуйте повтор с жёсткими ограничениями или откатитесь на запасной путь.

Как выбрать между «fail fast» и «fail gracefully»?

Останавливайтесь немедленно при проблемах, где продолжение рискованно: невозможность распарсить вывод, отсутствие обязательных полей, нарушение политики.

Действуйте мягко, когда есть безопасное восстановление: временные таймауты, лимиты, незначительные форматные ошибки.

В обоих случаях разделяйте:

- сообщение для пользователя: короткое, действенное, без технических деталей

- внутренняя диагностика: код ошибки, сырой вывод (безопасно), результаты валидатора, время, correlation ID

Когда повторные запросы и запасы помогают, а когда вредят?

Повторы помогают при временных сбоях (timeouts, 429, краткие отказы). Используйте ограниченные повторы с экспоненциальной задержкой и джиттером.

Повторы вредны для «неправильного ответа» (несоответствие схеме, пропущенные поля, нарушение политики) — лучше ремонт промпта (жёсткие инструкции), детерминированный шаблон, меньшая модель, кэш или ручная проверка в зависимости от риска.

Откуда обычно берутся крайние случаи в реальных AI-продуктах?

Частые крайние случаи приходят от:

- грязных пользовательских вводов (копии из PDF, странные переносы строк, длинный контекст)

- граничных значений (пустые поля, очень большая длина, необычные Unicode, смешанные языки)

- сдвига интеграций (изменение полей API, несоответствие прав, ожидание ISO-даты вместо «следующая пятница»)

Планируйте обнаружение «неизвестных неизвестных» через журналы, которые показывают, какое правило валидации не прошло и какой путь восстановления сработал.

Как валидация связана с безопасностью и защитой?

Валидация — не только про аккуратность: это защита от утечек данных, неавторизованных действий и неправильного использования инструментов.

Рекомендации:

- рассматривайте текст, направляемый модели, как ненадёжный; проверяйте намерение и права

- allowlist-инструменты и действия, ограничивайте домены и типы файлов

- редактируйте/удаляйте секреты (ключи API), персональные данные и внутренние идентификаторы перед отправкой модели или возвращением результата

- минимальные привилегии для токенов и инструментов, явные подтверждения для критичных действий, аудит-логи

Какая стратегия тестирования подходит для поведения, генерируемого ИИ?

Тестируйте модель как ненадёжного партнёра: нельзя утверждать каждую фразу, но можно проверять границы, структуру и полезность.

Слой тестов:

- юнит-тесты для вашего кода (парсеры, валидаторы, сборщики промптов)

- контрактные тесты, проверяющие форму вывода

- end-to-end сценарии с повторными попытками и запасными путями

Создайте «золотой набор» промптов для CI, добавляйте тесты при каждом найденном инциденте, используйте фаззинг и критерии/рубрики для недетерминированных ответов.

Что логировать и какие метрики отслеживать для валидации и ошибок?

Логи и метрики превращают редкие сбои в понятные паттерны. Логируйте осторожно, не нарушая приватность:

- входы/выходы (хэши, урезанные отрывки, структурированные поля); если храните сырой контент, делайте это с коротким временем хранения и доступом

- неудачи валидации: имя правила, путь поля и причина (несоответствие схеме, небезопасный контент и т.д.)

- вызовы инструментов, коды ответа и тайминги

Метрики: доля ошибок валидации, процент прохождения схемы, частота повторов и успех запасных путей, задержки, топ-категории ошибок. Сигналы дрейфа важнее абсолютных порогов: резкий рост конкретной ошибки или появление новой категории.

Как превращать сбои в улучшения и какие шаги предпринимать?

Улучшение — непрерывный процесс. Связывайте жалобы пользователей, очереди ручной проверки и автоматические ярлыки, чтобы иметь воспроизводимые кейсы с указанием промпта, версии модели и результатов валидаторов.

Частые исправления:

- ужесточение схемы

- добавление целевых валидаторов (единицы измерения, форматы дат, обязательные поля)

- правки промптов («если не уверен, скажи, что не знаешь»), добавление шаблонов или ручной проверки

Версионируйте промпты, валидаторы и модели, делайте канареечные релизы/A-B тесты и отслеживайте ключевые метрики. После фикса добавьте тест, чтобы ошибка не вернулась.