17 มิ.ย. 2568·1 นาที

AI ทดแทนอะไรในงานนักพัฒนา (และอะไรที่ไม่ใช่)

สรุปเชิงปฏิบัติของความรับผิดชอบที่ AI สามารถทดแทนได้ จุดที่ AI ช่วยเสริมมนุษย์ และงานไหนที่ทีมยังต้องรับผิดชอบเต็มตัวในสภาพทีมจริง

สรุปเชิงปฏิบัติของความรับผิดชอบที่ AI สามารถทดแทนได้ จุดที่ AI ช่วยเสริมมนุษย์ และงานไหนที่ทีมยังต้องรับผิดชอบเต็มตัวในสภาพทีมจริง

การคุยกันว่า “AI จะทำอะไรกับนักพัฒนา” มักจะสับสนเร็วเพราะเรามักจะผสมระหว่าง เครื่องมือ กับ ความรับผิดชอบ เครื่องมืออาจสร้างโค้ด สรุปตั๋ว หรือแนะนำเทสได้ แต่ความรับผิดชอบคือสิ่งที่ทีมยังต้องรับผิดชอบเมื่อคำแนะนำผิดพลาด

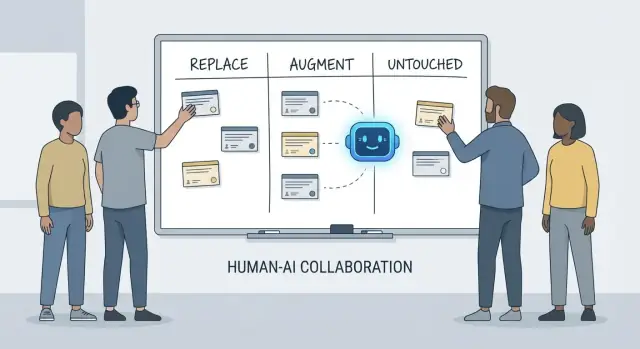

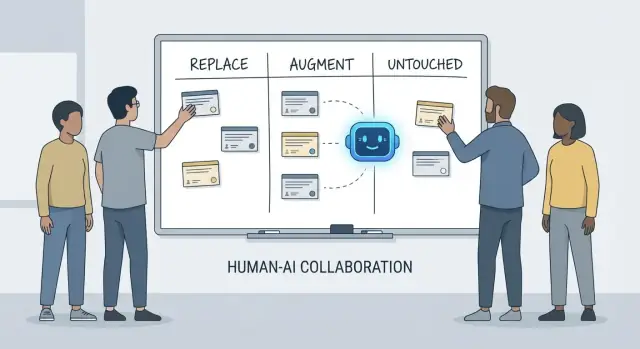

บทความนี้ใช้กรอบง่าย ๆ — ทดแทน, เสริม, ไม่แตะต้อง — เพื่ออธิบายงานประจำวันในทีมจริงที่มีเดดไลน์ โค้ดมรดก เหตุการณ์ในโปรดักชัน และผู้เกี่ยวข้องที่คาดหวังผลลัพธ์ที่เชื่อถือได้

ทดแทน หมายความว่า AI สามารถทำงานนั้นให้เสร็จแบบ end-to-end ส่วนใหญ่เวลา โดยมีกรอบการควบคุมชัดเจน และบทบาทของมนุษย์ย้ายไปเป็นการคอยดูแลและตรวจเป็นจุด ๆ

ตัวอย่างมักเป็นงานที่มีขอบเขตจำกัด: สร้าง boilerplate, แปลงโค้ดระหว่างภาษา, ร่างเทสซ้ำ ๆ, หรือผลิตเอกสารรอบแรก

การทดแทนไม่ได้หมายความว่า “ไม่มีความรับผิดชอบของมนุษย์” หากเอาต์พุตทำให้โปรดักชันพัง รั่วไหลข้อมูล หรือละเมิดมาตรฐาน ทีมยังต้องรับผิดชอบ

เสริม หมายความว่า AI ทำให้นักพัฒนาทำงานได้เร็วขึ้นหรือละเอียดขึ้น แต่ไม่เสมอไปที่จะทำงานเสร็จโดยไม่มีการตัดสินของมนุษย์

นี่คือกรณีปกติในการวิศวกรรมมืออาชีพ: คุณจะได้ร่างที่มีประโยชน์ ทางเลือกต่าง ๆ คำอธิบายที่เร็วขึ้น หรือรายการบักที่น่าจะเป็น — แต่ผู้พัฒนายังเป็นคนตัดสินว่าอะไรถูกต้อง ปลอดภัย และเหมาะสมกับผลิตภัณฑ์

ไม่แตะต้อง หมายความว่าความรับผิดชอบหลักยังต้องนำโดยมนุษย์เพราะต้องใช้บริบท การประนีประนอม และความรับผิดชอบที่ไม่สามารถบีบให้มาอยู่ใน prompt ได้ง่าย ๆ

คิดถึง: การต่อรองความต้องการ การเลือกข้อจำกัดระดับระบบ การจัดการเหตุการณ์ การตั้งมาตรฐานคุณภาพ และการตัดสินใจในกรณีที่ไม่มีคำตอบเดียวที่ “ถูก”

เครื่องมือเปลี่ยนเร็ว ความรับผิดชอบเปลี่ยนช้า

ดังนั้นแทนที่จะถามว่า “AI เขียนโค้ดนี้ได้ไหม?” ให้ถามว่า “ใครเป็นเจ้าของผลลัพธ์?” การตั้งกรอบแบบนี้ทำให้ความคาดหวังอยู่บนพื้นฐานของความถูกต้อง ความน่าเชื่อถือ และความรับผิดชอบ — สิ่งที่สำคัญกว่าการสาธิตที่น่าตื่นตา

เมื่อคนถามว่า AI จะ “ทดแทน” อะไรในการพัฒนา พวกเขามักหมายถึง งาน: เขียนฟังก์ชัน สร้างเทส ร่างเอกสาร ทีมอย่างไรก็ดีไม่ได้ส่งมอบงานเดี่ยว ๆ — พวกเขาส่งมอบผลลัพธ์ นั่นคือที่มาของ ความรับผิดชอบของนักพัฒนา

งานของนักพัฒนามักครอบคลุมมากกว่าชั่วโมงเขียนโค้ด:

ความรับผิดชอบเหล่านี้แผ่ข้ามวงจรชีวิตทั้งหมด — จาก “เราควรสร้างอะไร?” ถึง “ปลอดภัยไหม?” และ “จะเกิดอะไรขึ้นเวลา 3 นาฬิกาเช้าเมื่อมันพัง?”

แต่ละความรับผิดชอบจริง ๆ แล้วเป็น การตัดสินใจย่อยหลาย ๆ เรื่อง: ขอบกรณีพิเศษไหนสำคัญ, เมตริกไหนบ่งชี้สุขภาพ, เมื่อไหร่ควรตัด scope, ว่าการแก้ไขปลอดภัยที่จะปล่อยหรือไม่, วิธีอธิบายการประนีประนอมต่อผู้เกี่ยวข้อง AI ช่วย ดำเนินงาน ส่วนหนึ่งของงานนี้ (ร่างโค้ด เสนอเทส สรุป logs) แต่ความรับผิดชอบคือการ เป็นเจ้าของผลลัพธ์

การล้มเหลวมักเกิดที่ขอบเขตการส่งต่อ:

เมื่อความเป็นเจ้าของไม่ชัด งานจะตกลงไปในช่องว่าง

วิธีมีประโยชน์ในการพูดเรื่องความรับผิดชอบคือ สิทธิ์การตัดสินใจ:

AI สามารถเร่งการลงมือทำได้ แต่สิทธิ์การตัดสินใจ — และความรับผิดชอบต่อผลลัพธ์ — ยังคงต้องมีชื่อมนุษย์อยู่ข้าง ๆ

ผู้ช่วยเขียนโค้ดด้วย AI มีประโยชน์จริงเมื่องานคาดการณ์ได้ ความเสี่ยงต่ำ และง่ายต่อการยืนยัน คิดว่าเป็นเพื่อนร่วมทีมระดับจูเนียร์ที่เร็ว: เก่งในการผลิตร่างแรก แต่ยังต้องการคำสั่งชัดเจนและการตรวจสอบอย่างระมัดระวัง

จริงๆ แล้ว บางทีมเริ่มใช้แพลตฟอร์ม “vibe-coding” อย่าง Koder.ai เพื่อเร่งชิ้นงานที่ทดแทนได้: สร้างสเกฟโฟลด์ เชื่อม CRUD flows และผลิตร่างแรกของ UI และ backend จากการแชท ข้อสำคัญคือเหมือนเดิม: มีกรอบควบคุม การรีวิว และความเป็นเจ้าของที่ชัดเจน

เวลานักพัฒนาหลายส่วนไปกับการสร้างโครงโปรเจกต์และเชื่อมชั้นต่าง ๆ AI มักจะสร้างได้:

กรอบควบคุมที่นี่คือความสอดคล้อง: ตรวจให้แน่ใจว่ามันตรงกับคอนเวนชันเดิมของคุณและไม่คิดค้น pattern หรือ dependency ใหม่ๆ

เมื่อการเปลี่ยนเป็นเชิงกลไก—เช่น เปลี่ยนชื่อสัญลักษณ์ทั่วฐานโค้ด จัดรูปแบบใหม่ หรืออัพเดตการใช้งาน API แบบตรงไปตรงมา—AI สามารถเร่งงานที่น่าเบื่อได้

อย่างไรก็ตาม ให้ปฏิบัติเหมือนเป็นการแก้ชุดใหญ่: รันเทสทั้งชุด ตรวจ diff หาการเปลี่ยนแปลงพฤติกรรมที่ไม่ตั้งใจ และหลีกเลี่ยงให้มัน “ปรับปรุง” สิ่งที่เกินความต้องการของการรีแฟกเตอร์ที่ร้องขอ

AI สามารถร่าง README, คอมเมนต์ในโค้ด, และบันทึกการเปลี่ยนแปลงจากโค้ดและ commit note ได้ ซึ่งช่วยเร่งความชัดเจน แต่มันอาจสร้างความไม่ถูกต้องที่พูดด้วยน้ำเสียงมั่นใจ

แนวปฏิบัติที่ดี: ใช้ AI สำหรับโครงสร้างและสำนวน จากนั้นยืนยันทุกข้ออ้าง—โดยเฉพาะขั้นตอนการตั้งค่า ค่าเริ่มต้นการกำหนดค่า และขอบกรณีพิเศษ

สำหรับฟังก์ชันที่ระบุชัดเจนและบริสุทธิ์ เทส unit ที่สร้างโดย AI สามารถให้ความครอบคลุมเบื้องต้นและเตือนเรื่องขอบกรณีพิเศษได้ กรอบควบคุมคือความเป็นเจ้าของ: คุณยังเป็นคนเลือกว่าอะไรสำคัญ เพิ่ม assertion ที่สะท้อนความต้องการจริง และตรวจให้เทสล้มเหลวด้วยเหตุผลที่ถูกต้อง

เมื่อมี thread ยาวใน Slack ตั๋วยาว หรือ logs เหตุการณ์ AI สามารถสรุปเป็นโน้ตสั้นและรายการงานที่ต้องทำได้ ให้ยึดกับข้อเท็จจริงโดยส่งบริบทเต็มแล้วตรวจสอบข้อเท็จจริงสำคัญ เวลา และการตัดสินใจก่อนแชร์

แยกความแตกต่างระหว่าง งาน (สิ่งที่เครื่องมือช่วยทำได้) กับ ความรับผิดชอบ (ผลลัพธ์ที่ทีมต้องรับผิดชอบ)

เพราะทีมไม่ได้ปล่อย "งาน" เดี่ยวๆ แต่ปล่อยผลลัพธ์

แม้ผู้ช่วยจะร่างโค้ดหรือเทสให้ แต่ทีมของคุณยังรับผิดชอบต่อ:

“ทดแทน” คือ งานที่มีขอบเขตชัด เจตนาเปิดเผยความผิดพลาดได้ง่าย และความเสี่ยงต่ำ

ตัวอย่างที่เหมาะสมได้แก่:

ใช้มาตรการที่ทำให้ความผิดพลาดเห็นได้ชัดและค่าทำให้ถูกแก้ถูกต่ำ:

เพราะงานเชิงอาชีพมักมีข้อจำกัดที่โมเดลไม่สามารถสรุปได้อย่างน่าเชื่อถือ:

จัดให้ผลลัพธ์จาก AI เป็น ร่าง ที่คุณต้องปรับให้เข้ากับระบบ อย่าใช้เป็นคำตอบสุดท้าย

ใช้ AI เพื่อสร้าง สมมติฐานและแผนการหาหลักฐาน ไม่ใช่ข้อสรุป

วงจรปฏิบัติที่เป็นประโยชน์:

ถ้าไม่สามารถยืนยันคำแนะนำได้ ให้ถือว่าอาจผิดจนกว่าจะพิสูจน์ได้

AI ช่วยให้คุณเห็นปัญหาได้เร็วขึ้น แต่คนต้องตัดสินใจว่าอะไรยอมให้ปล่อย

คำถาม AI ที่มีประโยชน์สำหรับรีวิว:

จากนั้นให้คนทำการตรวจสอบเรื่องเจตนา การดูแลรักษา และความเสี่ยงการปล่อย (อะไรเป็นบล็อกการปล่อย vs งานตามมา)

AI สามารถร่างเทสได้จำนวนมาก แต่ไม่สามารถเลือกได้ว่า coverage แบบไหนสำคัญจริง

ให้มนุษย์รับผิดชอบต่อ:

ใช้ AI สำหรับสเกฟโฟลด์และระดมความคิดขอบกรณีพิเศษ ไม่ใช่เป็นเจ้าของคุณภาพ

เพราะการตัดสินใจเหล่านี้ขึ้นกับบริบทธุรกิจและความรับผิดชอบระยะยาว

AI สามารถ:

แต่คนยังต้องตัดสินใจ:

อย่าแปะความลับหรือข้อมูลลูกค้าที่ละเอียดอ่อนไว้ใน prompt

กฎปฏิบัติที่ใช้ได้จริง: