02 ต.ค. 2568·3 นาที

Brendan Burns และ Kubernetes: แนวคิดที่หล่อหลอมการออร์เคสตรา

มุมมองเชิงปฏิบัติเกี่ยวกับแนวคิดยุค Kubernetes ของ Brendan Burns—สภาวะเชิงประกาศ, controllers, การสเกล และการปฏิบัติการบริการ—และเหตุใดแนวคิดเหล่านี้จึงกลายเป็นมาตรฐาน

มุมมองเชิงปฏิบัติเกี่ยวกับแนวคิดยุค Kubernetes ของ Brendan Burns—สภาวะเชิงประกาศ, controllers, การสเกล และการปฏิบัติการบริการ—และเหตุใดแนวคิดเหล่านี้จึงกลายเป็นมาตรฐาน

Kubernetes ไม่ได้แค่เสนอเครื่องมือใหม่—มันเปลี่ยนภาพของ “งานปฏิบัติการประจำวัน” เมื่อคุณรันบริการเป็นสิบหรือเป็นร้อย ก่อนยุค orchestration ทีมมักต่อต่อสคริปต์ runbook ด้วยความรู้แบบเฉพาะกลุ่มเพื่อตอบคำถามซ้ำๆ: บริการนี้ควรไปรันที่ไหน? เราจะปล่อยการเปลี่ยนแปลงอย่างปลอดภัยได้อย่างไร? จะเกิดอะไรขึ้นถ้าโหนดพังตอนตีสอง?

โดยแก่นแท้แล้ว orchestration คือชั้นประสานระหว่างความตั้งใจของคุณ ("รันบริการนี้แบบ นี้") กับความวุ่นวายของความเป็นจริง—เครื่องล้ม, ทราฟฟิกเปลี่ยน, และการปรับใช้ต่อเนื่อง แทนที่จะมองเซิร์ฟเวอร์แต่ละเครื่องเป็นเอกเทศ orchestration มองการประมวลผลเป็นพูลและ workloads เป็นหน่วยที่ตั้งเวลาได้และย้ายได้

Kubernetes ทำให้แบบจำลองที่ทีมอธิบายสิ่งที่ต้องการ แล้วระบบพยายามทำให้ความจริงตรงกับคำอธิบายนั้นเป็นที่นิยม การเปลี่ยนแปลงนี้สำคัญเพราะทำให้งานปฏิบัติการน้อยลงเรื่อง “ฮีโร่” และมากขึ้นเรื่องกระบวนการที่ทำซ้ำได้

Kubernetes ทำให้ผลลัพธ์การปฏิบัติการที่ทีมส่วนใหญ่ต้องการเป็นมาตรฐาน:

บทความนี้เน้นแนวคิดและรูปแบบที่เกี่ยวกับ Kubernetes (และผู้นำความคิดอย่าง Brendan Burns) มากกว่าจะเป็นชีวประวัติส่วนบุคคล และเมื่อเราพูดว่า “มันเริ่มอย่างไร” หรือ “ทำไมออกแบบแบบนี้” ข้อกล่าวอ้างควรตั้งอยู่บนแหล่งสาธารณะ—เช่น การบรรยายในงาน, เอกสารออกแบบ, และเอกสารอัปสตรีม—เพื่อให้เรื่องราวตรวจสอบได้แทนที่จะเป็นตำนาน

Brendan Burns ถูกยอมรับอย่างกว้างขวางว่าเป็นหนึ่งในสามผู้ก่อตั้งดั้งเดิมของ Kubernetes ร่วมกับ Joe Beda และ Craig McLuckie ในงานเริ่มแรกของ Kubernetes ที่ Google Burns ช่วยกำหนดทิศทางทางเทคนิคและวิธีอธิบายโครงการให้ผู้ใช้—โดยเฉพาะด้าน “การดำเนินงานซอฟต์แวร์” มากกว่าแค่ “การรันคอนเทนเนอร์” (แหล่งที่มา: Kubernetes: Up & Running, O’Reilly; รายการ AUTHORS/maintainers ในที่เก็บโครงการ Kubernetes)

Kubernetes ไม่ได้ถูกปล่อยออกมาเป็นระบบภายในที่เสร็จแล้ว; มันถูกสร้างแบบเปิดด้วยผู้ร่วมพัฒนาที่เพิ่มขึ้น กรณีการใช้งาน และข้อจำกัด ความเป็นสาธารณะนั้นผลักดันโครงการให้มุ่งสู่ส่วนติดต่อ (API) ที่ยั่งยืนในสภาพแวดล้อมต่างๆ:

แรงกดดันจากการร่วมมือแบบนี้สำคัญเพราะมันมีอิทธิพลต่อสิ่งที่ Kubernetes ปรับให้เหมาะสม: พรีมิติฟร่วมกันและรูปแบบที่ทำซ้ำได้ที่หลายทีมเห็นด้วย แม้จะไม่เห็นด้วยในเครื่องมือก็ตาม

เมื่อคนพูดว่า Kubernetes “ทำให้เป็นมาตรฐาน” ทางปฏิบัติ พวกเขาไม่ได้หมายความว่ามันทำให้ทุกระบบเหมือนกัน พวกเขาหมายถึงมันให้คำศัพท์ร่วมและเวิร์กโฟลว์ที่ทำซ้ำได้ระหว่างทีม:

แบบจำลองร่วมนี้ทำให้เอกสาร เครื่องมือ และแนวปฏิบัติของทีมถ่ายโอนกันได้ง่ายขึ้นระหว่างบริษัท

ควรแยก Kubernetes (โครงการโอเพนซอร์ส) ออกจาก ระบบนิเวศ Kubernetes

โครงการคือ API คอร์และส่วนควบคุมที่ทำงานเป็นแพลตฟอร์ม ส่วนระบบนิเวศคือทุกอย่างที่เติบโตรอบๆ มัน—การแจกจ่าย บริการที่จัดการ add-ons และโครงการ CNCF ที่เกี่ยวข้อง คุณสมบัติหลายอย่างที่ทีมพึ่งพาในโลกจริง (เช่น สแตกการสังเกต, เอนจินนโยบาย, เครื่องมือ GitOps) มักจะอยู่ในระบบนิเวศ ไม่ได้อยู่ในคอร์โปรเจกต์เอง

การตั้งค่าเชิงประกาศเป็นการเปลี่ยนวิธีอธิบายระบบ: แทนการเขียนลำดับขั้นตอน ให้ระบุสิ่งที่คุณต้องการเป็นผลลัพธ์สุดท้าย

ในคำศัพท์ของ Kubernetes คุณไม่บอกแพลตฟอร์มว่า “สตาร์ทคอนเทนเนอร์แล้วเปิดพอร์ตแล้วรีสตาร์ทถ้ามันแครช” คุณประกาศว่า "ควรมีสำเนาแอป 3 ตัว รันบนพอร์ตนี้ โดยใช้อิมเมจคอนเทนเนอร์นี้" Kubernetes รับผิดชอบทำให้ความเป็นจริงตรงกับคำอธิบายนั้น

ปฏิบัติการเชิงคำสั่งเหมือน runbook: ลำดับคำสั่งที่ใช้ได้ผลครั้งก่อนและรันซ้ำเมื่อมีการเปลี่ยน

สภาวะที่ต้องการใกล้เคียงกับข้อตกลง คุณบันทึกผลลัพธ์ที่ตั้งใจไว้ในไฟล์คอนฟิก และระบบจะพยายามทำให้ผลลัพธ์นั้นเป็นจริงอย่างต่อเนื่อง หากบางอย่างเบี้ยว—อินสแตนซ์ตาย, โหนดหาย, หรือมีการเปลี่ยนแปลงด้วยมือ—แพลตฟอร์มจะตรวจจับและแก้ไขให้

ก่อน (แนวคิด runbook แบบเชิงคำสั่ง):

แนวทางนี้ใช้ได้ แต่ทำให้เกิดเซิร์ฟเวอร์แบบ “snowflake” และรายการตรวจสอบยาวที่มีคนจำนวนน้อยเท่านั้นเชื่อใจได้

หลัง (สภาวะเชิงประกาศ):

apiVersion: apps/v1

kind: Deployment

metadata:

name: checkout

spec:

replicas: 3

selector:

matchLabels:

app: checkout

template:

metadata:

labels:

app: checkout

spec:

containers:

- name: app

image: example/checkout:1.2.3

ports:

- containerPort: 8080

คุณแก้ไฟล์ (เช่น อัปเดต image หรือ replicas) แล้ว apply มัน controllers ของ Kubernetes จะพยายาม reconcile สิ่งที่รันกับสิ่งที่ประกาศ

สภาวะเชิงประกาศลดงานซ้ำด้วยการเปลี่ยนจาก “ทำ 17 ขั้นตอนนี้” เป็น “รักษาให้เป็นแบบนี้” และลดการเบี้ยวของคอนฟิกเพราะแหล่งความจริงชัดเจนและตรวจทานได้—มักเก็บในระบบควบคุมเวอร์ชัน ทำให้การเซอร์ไพรซ์ตรวจเจอได้ง่ายและย้อนกลับได้อย่างสม่ำเสมอ

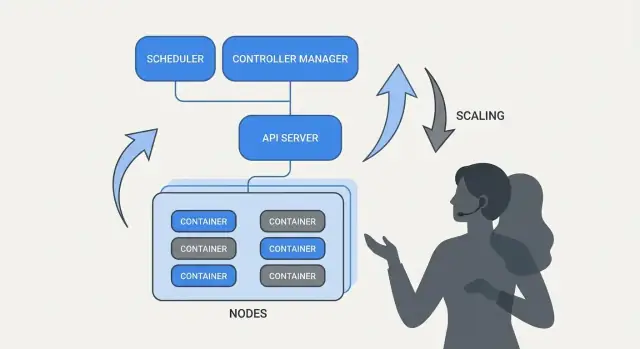

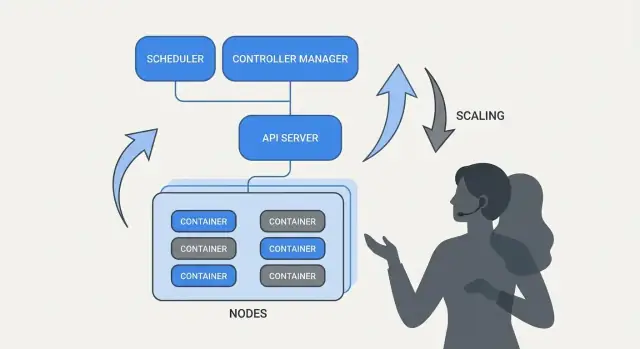

Kubernetes ดูเหมือน “จัดการตัวเอง” เพราะมันสร้างบนรูปแบบง่ายๆ: คุณประกาศสิ่งที่ต้องการ แล้วระบบทำงานต่อเนื่องเพื่อให้ความจริงตรงกับคำประกาศ เครื่องยนต์ของรูปแบบนี้คือ controller

Controller เป็นลูปที่เฝ้าดูสถานะปัจจุบันของคลัสเตอร์และเทียบกับสถานะที่คุณประกาศใน YAML (หรือผ่าน API) เมื่อมันพบความต่าง มันจะทำการเพื่อลดความต่างนั้น

มันไม่ใช่สคริปต์รันครั้งเดียวและไม่รอมนุษย์กดปุ่ม มันรันซ้ำๆ—สังเกต ตัดสินใจ ปฏิบัติ—เพื่อจะตอบสนองต่อการเปลี่ยนแปลงได้ทุกเมื่อ

พฤติกรรมเปรียบเทียบและแก้ไขซ้ำๆ นี้เรียกว่า reconciliation มันคือกลไกเบื้องหลังคำสัญญาทั่วไปเรื่อง “self-healing” ระบบไม่ได้ป้องกันความล้มเหลวได้วิเศษ แต่มันสังเกตการเบี้ยวและแก้ไข

การเบี้ยวเกิดจากเหตุผลธรรมดาๆ:

Reconciliation ทำให้ Kubernetes มองเหตุการณ์เหล่านี้เป็นสัญญาณเพื่อเช็กเจตนาและคืนสภาพตามที่ต้องการ

Controllers แปลเป็นผลลัพธ์การปฏิบัติการที่คุ้นเคย:

จุดสำคัญคือคุณไม่ตามอาการด้วยมืออีกต่อไป คุณประกาศเป้าหมายและ control loops ทำงานต่อเนื่องให้เป็นอย่างนั้น

แนวทางนี้ไม่ได้จำกัดแค่ชนิดทรัพยากรเดียว Kubernetes ใช้แนวคิด controller-and-reconciliation กับหลายออบเจ็กต์—Deployments, ReplicaSets, Jobs, Nodes, endpoints และอื่นๆ ความสอดคล้องนี้เป็นเหตุผลสำคัญที่ Kubernetes กลายเป็นแพลตฟอร์ม: เมื่อคุณเข้าใจรูปแบบ คุณทำนายพฤติกรรมของระบบได้เมื่อเพิ่มความสามารถใหม่ๆ (รวมถึง custom resources ที่ทำตามลูปเดียวกัน)

ถ้า Kubernetes ทำได้แค่ “รันคอนเทนเนอร์” มันก็ยังปล่อยทีมให้ต้องตัดสินใจว่า ที่ไหน ควรให้ workload แต่ละตัวรัน การจัดตารางคือระบบในตัวที่วาง Pods บนโหนดที่เหมาะสมโดยอัตโนมัติตามความต้องการทรัพยากรและกฎที่คุณกำหนด

สิ่งนี้สำคัญเพราะการตัดสินใจเรื่องที่วางส่งผลโดยตรงต่อ uptime และต้นทุน Web API ที่อยู่บนโหนดแออัดอาจช้า หรือแครช งานแบทช์ที่อยู่ใกล้บริการที่ต้องตอบสนองเร็วอาจสร้างปัญหา noisy-neighbor Kubernetes เปลี่ยนสิ่งนี้เป็นความสามารถผลิตภัณฑ์ที่ทำซ้ำได้แทนการทำสเปรดชีตและ SSH

ในระดับพื้นฐาน scheduler มองหาโหนดที่สามารถตอบสนองคำขอของ Pod ได้

นิสัยเดียวนี้—การตั้ง requests ที่สมจริง—มักลดความไม่เสถียรแบบสุ่มเพราะบริการสำคัญหยุดแข่งขันกับทุกอย่างอื่น

นอกจากทรัพยากร คลัสเตอร์โปรดักชันส่วนใหญ่พึ่งพากฎปฏิบัติไม่กี่อย่าง:

ฟีเจอร์การจัดตารางช่วยทีมเข้ารหัสเจตนาการปฏิบัติการ:

ข้อสรุปทางปฏิบัติ: ปฏิบัติต่อกฎการจัดตารางเหมือนความต้องการผลิตภัณฑ์—จดบันทึก ทบทวน และใช้สม่ำเสมอ—เพื่อให้ความน่าเชื่อถือไม่ขึ้นกับใครคนหนึ่งที่จำตำแหน่งโหนดได้ในตีสอง

หนึ่งในไอเดียที่ใช้งานได้จริงของ Kubernetes คือการสเกลไม่ควรต้องเปลี่ยนโค้ดแอปหรือคิดวิธีปรับใช้ใหม่ หากแอปรันเป็นคอนเทนเนอร์หนึ่งตัว นิยาม workload เดียวกันมักขยายได้เป็นร้อยหรือพันสำเนา

Kubernetes แยกการสเกลเป็นสองการตัดสินใจที่เกี่ยวข้อง:

การแยกนี้สำคัญ: คุณอาจขอ 200 pods แต่ถ้าคลัสเตอร์มีที่ว่างแค่ 50 การ “สเกล” จะกลายเป็นคิวงานที่รอการจัดตาราง

Kubernetes มักใช้สามตัวช่วย autoscale ที่มุ่งไปที่คันโยกต่างกัน:

ใช้ร่วมกัน สิ่งนี้ทำให้การสเกลกลายเป็นนโยบาย: “รักษา latency ให้คงที่” หรือ “รักษา CPU ที่ประมาณ X%” แทนการโทรปลุกด้วยมือ

การสเกลทำงานได้เท่าที่อินพุตจะดี:

สองความผิดพลาดที่ปรากฏบ่อย: สเกลบนเมตริกที่ผิด (CPU ต่ำแต่การร้องขอล้มเหลว) และ ขาด requests (autoscaler คาดการณ์ความจุไม่ได้ พ็อดถูกยัดรวมกันมากเกินไป และประสิทธิภาพไม่สม่ำเสมอ)

การเปลี่ยนแปลงใหญ่ที่ Kubernetes ทำให้เป็นที่นิยมคือการมองการ “deploy” เป็นปัญหาการควบคุมอย่างต่อเนื่อง ไม่ใช่สคริปต์ครั้งเดียวที่รันวันศุกร์เวลา 5 โมง โรลเอาท์และการย้อนกลับเป็นพฤติกรรมระดับหนึ่ง: คุณประกาศเวอร์ชันที่ต้องการ และ Kubernetes ค่อยๆ ย้ายระบบไปทางนั้นพร้อมตรวจสอบความปลอดภัยของการเปลี่ยน

ด้วย Deployment การโรลเอาท์คือการแทนที่ Pods เก่าแบบค่อยเป็นค่อยไป แทนที่จะหยุดทุกอย่างแล้วเริ่มใหม่ Kubernetes สามารถอัปเดตเป็นขั้นตอน—รักษาความสามารถให้บริการในขณะที่เวอร์ชันใหม่พิสูจน์ตัวเองกับทราฟฟิกจริง

ถ้าเวอร์ชันใหม่เริ่มล้ม การย้อนกลับไม่ใช่ขั้นตอนฉุกเฉิน แต่เป็นการปฏิบัติการปกติ: คุณสามารถย้อนกลับไปยัง ReplicaSet ก่อนหน้า (เวอร์ชันที่รู้ว่าดีล่าสุด) แล้วให้ controller คืนสภาพเก่า

เช็กสุขภาพทำให้โรลเอาท์จากการหวังผลเป็นการวัดผลจริง

ใช้ probes ดีๆ จะลดความสำเร็จเทียม—deploy ที่ ดู ว่าดีเพราะ Pods สตาร์ท แต่จริงๆ ล้มเหลวเมื่อรับคำขอ

Kubernetes รองรับ rolling update โดยพื้นฐาน แต่ทีมมักวางรูปแบบเพิ่มเติม:

การปรับใช้ที่ปลอดภัยขึ้นกับสัญญาณ: อัตราข้อผิดพลาด, ความหน่วง, ความอิ่มตัว และผลกระทบต่อลูกค้า ทีมจำนวนมากเชื่อมการตัดสินใจโรลเอาท์เข้ากับ SLOs และ error budgets—ถ้า canary เบิร์นงบเกิน ระบบจะหยุดการโปรโมต

เป้าหมายคือทริกเกอร์การย้อนกลับอัตโนมัติบนตัวชี้วัดจริง (readiness ล้มเหลว, 5xx เพิ่มขึ้น, latency พุ่ง) เพื่อให้การย้อนกลับเป็นการตอบสนองของระบบที่คาดเดาได้ ไม่ใช่ภารกิจฮีโร่ยามดึก

แพลตฟอร์มคอนเทนเนอร์จะรู้สึกว่า “อัตโนมัติ” ก็ต่อเมื่อส่วนอื่นของระบบยังหาบริการคุณได้หลังจากมันย้าย ในคลัสเตอร์โปรดักชันจริง พ็อดถูกสร้าง ลบ ย้าย และสเกลตลอดเวลา ถ้าทุกการเปลี่ยนแปลงต้องแก้ IP ในคอนฟิก การปฏิบัติการจะกลายเป็นงานไม่หยุดและการหยุดให้บริการจะเกิดขึ้นบ่อย

Service discovery ให้ไคลเอนต์วิธีที่เชื่อถือได้ในการเข้าถึงชุด backend ที่เปลี่ยนแปลง ใน Kubernetes จุดเปลี่ยนคือคุณหยุดเป้าหมายอินสแตนซ์เฉพาะ ("เรียก 10.2.3.4") และแทนที่ด้วยชื่อที่คงที่ ("เรียก checkout") แพลตฟอร์มดูแลว่าพ็อดไหนให้บริการชื่อนั้นอยู่

Service เป็นหน้าประตูที่คงที่สำหรับกลุ่มพ็อด มีชื่อและที่อยู่เสมอภายในคลัสเตอร์ แม้พ็อดข้างใต้จะเปลี่ยน

Selector คือวิธีที่ Kubernetes ตัดสินใจว่าพ็อดไหนอยู่ “ข้างหลัง” หน้าประตูนั้น โดยทั่วไปใช้ labels เช่น app=checkout

Endpoints (หรือ EndpointSlices) คือรายการไอพีพ็อดปัจจุบันที่ตรงกับ selector เมื่อพ็อดสเกลขึ้น โรลเอาท์ หรือย้าย รายการนี้จะอัพเดตอัตโนมัติ—ไคลเอนต์ยังคงใช้ชื่อ Service เดิม

เชิงปฏิบัติ สิ่งนี้ให้:

สำหรับทราฟฟิกนอกคลัสเตอร์ (north–south) Kubernetes มักใช้ Ingress หรือแนวทางใหม่กว่าอย่าง Gateway ทั้งสองให้จุดเข้าออกที่ควบคุมได้เพื่อกำหนดเส้นทางตามชื่อโฮสต์หรือพาธ และมักรวมการสิ้นสุด TLS ไว้ที่เดียว แนวคิดสำคัญยังคงเดิม: รักษาการเข้าถึงภายนอกให้คงที่ในขณะที่ backend เปลี่ยนไป

“Self-healing” ใน Kubernetes ไม่ใช่เวทมนตร์ มันคือชุดการตอบสนองอัตโนมัติเมื่อเกิดความล้มเหลว: รีสตาร์ท, ย้ายใหม่, และ ทดแทน แพลตฟอร์มเฝ้าดูสิ่งที่คุณประกาศ (desired state) และคอยผลักดันความจริงกลับไปทางนั้น

ถ้ากระบวนการออกหรือคอนเทนเนอร์ไม่สุขภาพ Kubernetes สามารถรีสตาร์ทมันบนโหนดเดิมได้ มักขับเคลื่อนโดย:

รูปแบบโปรดักชันที่พบบ่อย: คอนเทนเนอร์แครช → Kubernetes รีสตาร์ทมัน → Service ยังคงส่งทราฟฟิกเฉพาะไปยังพ็อดที่พร้อม

ถ้าโหนดทั้งตัวล้ม (ฮาร์ดแวร์, kernel panic, เสียการเชื่อมต่อ) Kubernetes ตรวจจับว่าโหนดไม่พร้อมและเริ่มย้ายงานไปที่อื่น ในภาพรวม:

นี่คือการฟื้นตัวในระดับคลัสเตอร์: ระบบทดแทนความจุมากกว่ารอให้มนุษย์ SSH เข้าไป

การฟื้นตัวมีประโยชน์เมื่อคุณตรวจสอบได้ ทีมมักดู:

แม้ใช้ Kubernetes การ "ฟื้น" อาจล้มเหลวหากการ์ดการ์ดล้ม:

เมื่อการฟื้นถูกตั้งค่าอย่างดี การหยุดให้บริการจะสั้นลงและวัดผลได้มากขึ้น

Kubernetes ไม่ได้ชนะเพราะรันคอนเทนเนอร์ได้เพียงอย่างเดียว แต่เพราะมันเสนอ API มาตรฐาน สำหรับความต้องการการปฏิบัติการทั่วไป—การปรับใช้ การสเกล เครือข่าย และการสังเกต เมื่อทีมยอมรับรูปแบบวัตถุเดียวกัน (เช่น Deployments, Services, Jobs) เครื่องมือสามารถแชร์ข้ามองค์กร การฝึกอบรมง่ายขึ้น และการส่งมอบระหว่าง dev กับ ops ไม่ต้องพึ่งความรู้แบบกลุ่ม

API ที่สม่ำเสมอหมายความว่า pipeline การปรับใช้ของคุณไม่ต้องรู้ quirks ของแต่ละแอป มันสามารถทำการเดียวกัน—create, update, rollback, และเช็กสุขภาพ—โดยใช้แนวคิด Kubernetes เดียวกัน

นอกจากนี้ยังปรับปรุงการประสานงาน: ทีมความปลอดภัยสามารถกำหนด guardrails เป็นนโยบาย; SRE สามารถมาตรฐาน runbook รอบสัญญาณสุขภาพทั่วไป; นักพัฒนาสามารถคิดเรื่องการปล่อยด้วยคำศัพท์ร่วมกัน

การเปลี่ยนเป็นแพลตฟอร์มชัดเจนด้วย Custom Resource Definitions (CRDs) CRD ให้คุณเพิ่มชนิดออบเจ็กต์ใหม่ในคลัสเตอร์ (เช่น Database, Cache, หรือ Queue) และจัดการมันด้วยรูปแบบ API เดียวกับทรัพยากรในตัว

Operator จับวัตถุแบบกำหนดเองเหล่านั้นกับ controller ที่ reconcile ความเป็นจริงตามสภาวะที่ต้องการ—จัดการงานที่เคยทำด้วยมือ เช่น สำรองข้อมูล, failover, หรืการอัปเกรด เวลาประโยชน์ไม่ใช่เวทมนตร์อัตโนมัติ แต่มาจาก การใช้ลูปควบคุมแบบเดียวกัน ที่ Kubernetes ใช้กับทุกอย่าง

เพราะ Kubernetes ขับเคลื่อนด้วย API มันรวมเข้ากับเวิร์กโฟลว์สมัยใหม่ได้ดี:

ถ้าคุณต้องการคำแนะนำการปรับใช้และการปฏิบัติการที่เป็นประโยชน์มากขึ้นบนแนวคิดเหล่านี้ ลองเรียกดู /blog

ไอเดียใหญ่จาก Kubernetes—หลายอย่างเกี่ยวข้องกับการวางกรอบตอนต้นโดย Brendan Burns—สามารถแปลใช้ได้ดีแม้คุณรันบน VM, serverless, หรือคอนเทนเนอร์ที่เล็กกว่า

จงจด "สถานะที่ต้องการ" และให้ระบบอัตโนมัติบังคับใช้มัน. ไม่ว่าจะเป็น Terraform, Ansible, หรือ pipeline CI ให้จัดการคอนฟิกเป็นแหล่งความจริง ผลลัพธ์คือขั้นตอนปรับใช้ด้วยมือที่น้อยลงและความประหลาดใจก้อน้อยลง

ใช้ reconciliation แทนสคริปต์ครั้งเดียว. แทนสคริปต์รันครั้งเดียวและหวังผล สร้างลูปที่ตรวจสอบคุณสมบัติเชิงสำคัญอย่างต่อเนื่อง (เวอร์ชัน, คอนฟิก, จำนวนอินสแตนซ์, สุขภาพ) นี่คือวิธีที่คุณได้ปฏิบัติการที่ทำซ้ำได้และการกู้คืนที่คาดเดาได้

ทำให้การจัดตารางและการสเกลเป็นฟีเจอร์ผลิตภัณฑ์. นิยามเมื่อไหร่และทำไมคุณเพิ่มความจุ (CPU, ความลึกคิว, SLO ความหน่วง) แม้ไม่มี autoscaling ของ Kubernetes ทีมสามารถมาตรฐานกฎการสเกลเพื่อให้การเติบโตไม่ต้องเขียนแอปใหม่หรือปลุกใคร

มาตรฐานการโรลเอาท์. การอัปเดตทีละน้อย เช็กสุขภาพ และขั้นตอนย้อนกลับอย่างรวดเร็วลดความเสี่ยงของการเปลี่ยน คุณสามารถทำสิ่งนี้ด้วย load balancers, feature flags, และ pipeline ที่กั้นการปล่อยบนสัญญาณจริง

รูปแบบเหล่านี้จะไม่แก้ การออกแบบแอปที่แย่, การย้ายข้อมูลที่ไม่ปลอดภัย, หรือ การควบคุมต้นทุน คุณยังต้องมี API ที่มีเวอร์ชัน, แผนการมิเกรชัน, งบประมาณ/ข้อจำกัด, และการสังเกตที่เชื่อมการปล่อยเข้ากับผลกระทบต่อลูกค้า

เลือกบริการที่หันหน้าเข้าลูกค้าหนึ่งชิ้นและทำเช็คลิสต์แบบ end-to-end แล้วขยายต่อ

ถ้าคุณกำลังสร้างบริการใหม่และต้องการไปสู่ "สิ่งที่ปรับใช้ได้" ได้เร็วขึ้น Koder.ai ช่วยคุณสร้างเว็บ/แบ็กเอนด์/มือถือจากสเปคแบบแชท—โดยทั่วไปเป็น React หน้า frontend, Go กับ PostgreSQL เป็นแบ็กเอนด์, และ Flutter สำหรับมือถือ—แล้วส่งออกรหัสต้นฉบับเพื่อให้คุณนำแนวทาง Kubernetes ที่กล่าวถึงที่นี่ไปใช้ (คอนฟิกเชิงประกาศ, โรลเอาท์ที่ทำซ้ำได้, และการปฏิบัติการที่รองรับ rollback) สำหรับทีมที่ประเมินต้นทุนและการกำกับดูแล คุณยังสามารถดู /pricing.

Orchestration ประสานเจตนารมณ์ของคุณ (สิ่งที่ควรจะรัน) กับความเปลี่ยนแปลงในโลกจริง (โหนดล้มเหลว, การโรลเอาท์แบบหมุนเวียน, เหตุการณ์การสเกล) แทนที่จะจัดการเซิร์ฟเวอร์ทีละเครื่อง คุณจะจัดการ workloads และปล่อยให้แพลตฟอร์มวาง ติดตั้งใหม่ และทดแทนให้โดยอัตโนมัติ

เชิงปฏิบัติ มันลด:

การตั้งค่าแบบเชิงประกาศ (declarative) ระบุ ผลลัพธ์สุดท้าย ที่คุณต้องการ (เช่น “มีสำเนาแอป 3 ตัว ฟังพอร์ตนี้ ใช้อิมเมจนี้”) แทนการระบุลำดับขั้นตอน

ประโยชน์ที่ใช้ได้ทันที:

Controller เป็นลูปที่รันต่อเนื่องซึ่งเปรียบเทียบ สถานะปัจจุบัน กับ สถานะที่ต้องการ และทำการเพื่อปิดช่องว่างนั้น

นี่คือเหตุผลที่ Kubernetes ดูเหมือนจะ “จัดการตัวเอง” ในผลลัพธ์ทั่วไป:

ตัวจัดตาราง (scheduler) ตัดสินใจ ที่ไหน ให้แต่ละ Pod รัน โดยพิจารณาจากข้อจำกัดและความจุที่มี หากไม่ควบคุม อาจเกิดปัญหา noisy neighbor, hotspot หรือสำเนาไปอยู่ด้วยกันบนโหนดเดียว

กฎทั่วไปที่ควรเข้ารหัสเป็นนโยบายการปฏิบัติการ:

Requests แจ้งให้ scheduler รู้ว่า Pod ต้องการอะไร; limits จำกัดสิ่งที่ Pod ใช้ได้จริง หากไม่มี requests ที่สมเหตุสมผล การวางตำแหน่งจะกลายเป็นการคาดเดาและเสถียรภาพมักจะทรุด

จุดเริ่มต้นเชิงปฏิบัติ:

การโรลเอาท์ด้วย Deployment คือการแทนที่ Pods เก่าเป็นทีละขั้นเพื่อรักษาความสามารถให้บริการระหว่างการอัพเดต

เพื่อให้โรลเอาท์ปลอดภัย:

รูปแบบที่ใช้ขึ้นกับความเสี่ยงและรูปแบบทราฟฟิก:

เลือกตามความยอมรับความเสี่ยง รูปแบบทราฟฟิก และความเร็วในการตรวจจับรีเกรสชั่น (อัตราข้อผิดพลาด/ความหน่วง/การเบิร์น SLO)

A Service ให้หน้าประตูที่คงที่สำหรับกลุ่ม Pods ชุดหนึ่ง มีชื่อและที่อยู่เสมอภายในคลัสเตอร์ แม้ว่าพ็อดจะเปลี่ยนไป

Labels/selectors ระบุว่าพ็อดไหน “อยู่หลัง” หน้าประตูนั้น และ EndpointSlices เก็บรายการ IP ของพ็อดที่ตรงกับ selector ปัจจุบัน

เชิงปฏิบัติ:

service-name แทนการตามหา IP ของ Podการสเกลทำงานดีที่สุดเมื่อแต่ละชั้นมีสัญญาณชัดเจน:

ข้อผิดพลาดทั่วไป:

CRDs ช่วยให้คุณนิยามวัตถุ API ใหม่ (เช่น Database, Cache) เพื่อจัดการระบบระดับสูงผ่าน API ของ Kubernetes

Operators จับคู่ CRDs กับ controller ที่คอย reconcile สถานะจริงให้ตรงกับที่ต้องการ อัตโนมัติงานเช่น:

ปฏิบัติเหมือนซอฟต์แวร์โปรดักชัน: ประเมินความพร้อมใช้งาน, การสังเกตเหตุการณ์, และโหมดล้มเหลวก่อนจะพึ่งพา