12 พ.ย. 2568·4 นาที

จากแล็บไม่แสวงหากำไรสู่ผู้นำ AI: ประวัติของ OpenAI

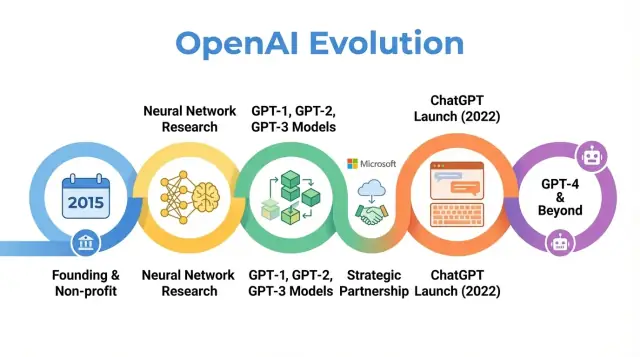

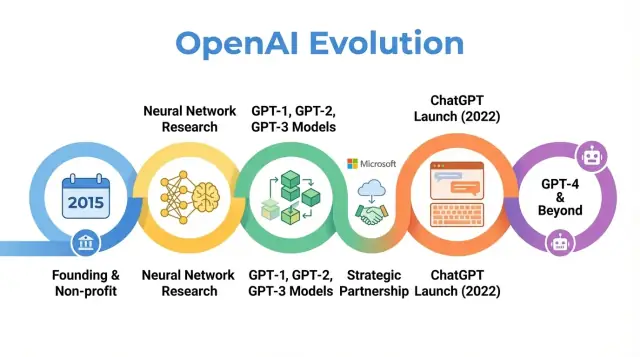

สำรวจประวัติของ OpenAI ตั้งแต่จุดเริ่มต้นแบบไม่แสวงหากำไร เหตุการณ์วิจัยสำคัญ จนถึงการเปิดตัว ChatGPT, GPT‑4 และการพัฒนาภารกิจขององค์กร

สำรวจประวัติของ OpenAI ตั้งแต่จุดเริ่มต้นแบบไม่แสวงหากำไร เหตุการณ์วิจัยสำคัญ จนถึงการเปิดตัว ChatGPT, GPT‑4 และการพัฒนาภารกิจขององค์กร

OpenAI เป็นบริษัทวิจัยและปรับใช้ AI ที่งานของมันมีอิทธิพลต่อวิธีที่ผู้คนนึกถึงปัญญาประดิษฐ์ ตั้งแต่บทความวิจัยช่วงแรกจนถึงผลิตภัณฑ์อย่าง ChatGPT การเข้าใจว่า OpenAI พัฒนาอย่างไร — จากแล็บไม่แสวงหากำไรเล็ก ๆ ในปี 2015 ไปจนถึงผู้เล่นสำคัญในวงการ AI — ช่วยอธิบายว่า AI สมัยใหม่มีลักษณะอย่างไรในวันนี้

เรื่องราวของ OpenAI ไม่ใช่แค่ลำดับของการปล่อยโมเดล แต่เป็นกรณีศึกษาของการที่ภารกิจ แรงจูงใจ ความก้าวหน้าทางเทคนิค และแรงกดดันสาธารณะมีปฏิสัมพันธ์กัน องค์กรเริ่มด้วยการเน้นงานวิจัยที่เปิดกว้างและประโยชน์โดยรวม จากนั้นปรับโครงสร้างเพื่อดึงทุน สร้างความร่วมมือลึกซึ้งกับ Microsoft และเปิดตัวผลิตภัณฑ์ที่ผู้คนนับร้อยล้านใช้

การตามรอยประวัติของ OpenAI ทำให้เห็นแนวโน้มกว้าง ๆ ใน AI:

บทความนี้ติดตามการเดินทางของ OpenAI ตั้งแต่ปี 2015 จนถึงพัฒนาการล่าสุด แสดงให้เห็นแต่ละช่วงสะท้อนการเปลี่ยนแปลงในงานวิจัย เศรษฐศาสตร์ และธรรมาภิบาลของ AI — และสิ่งที่อาจหมายถึงอนาคตของสาขานี้

OpenAI ก่อตั้งในเดือนธันวาคม 2015 ขณะที่การเรียนรู้ของเครื่อง โดยเฉพาะ deep learning กำลังพัฒนาอย่างรวดเร็ว แต่ยังห่างไกลจากความฉลาดทั่วไป การทดสอบด้านการรู้จำภาพดีขึ้น ระบบพูดดีขึ้น และบริษัทใหญ่เช่น Google, Facebook และ Baidu ลงทุนอย่างมากใน AI

นักวิจัยและผู้บริหารเทคหลายคนกังวลว่า AI ขั้นสูงอาจถูกควบคุมโดยบริษัทหรือรัฐบาลไม่กี่แห่ง OpenAI ถูกตั้งขึ้นเป็นสมดุล: องค์กรวิจัยที่มุ่งเน้นความปลอดภัยระยะยาวและการกระจายประโยชน์ของ AI มากกว่าการได้เปรียบเชิงพาณิชย์แบบแคบ

ตั้งแต่วันแรก OpenAI นิยามภารกิจในแง่ของ AGI ไม่ใช่เพียงความก้าวหน้าเชิงเครื่องมือเฉพาะ ภารกิจหลักคือทำงานเพื่อให้แน่ใจว่า AGI ถ้าถูกสร้างขึ้น จะ "เป็นประโยชน์ต่อมนุษยชาติทั้งหมด"

ภารกิจนี้มีนัยสำคัญดังนี้:

โพสต์บล็อกช่วงแรกและข้อบังคับการก่อตั้งเน้นทั้งความเปิดกว้างและความระมัดระวัง: OpenAI จะเผยแพรงานส่วนใหญ่ แต่ก็พิจารณาผลกระทบทางสังคมก่อนปล่อยความสามารถที่ทรงพลัง

OpenAI เริ่มต้นเป็นแล็บวิจัยไม่แสวงหากำไร การระดมทุนเริ่มต้นประกาศประมาณ 1 พันล้านดอลลาร์เป็นการให้คำมั่นระยะยาว แทนเงินสดล่วงหน้าจำนวนมาก ผู้สนับสนุนสำคัญในช่วงแรกได้แก่ Elon Musk, Sam Altman, Reid Hoffman, Peter Thiel, Jessica Livingston, และ YC Research พร้อมการสนับสนุนจากบริษัทอย่าง Amazon Web Services และ Infosys

ทีมผู้นำเริ่มแรกรวมประสบการณ์ด้านสตาร์ทอัพ การวิจัย และการปฏิบัติการ:

การผสมผสานระหว่างผู้ประกอบการใน Silicon Valley และนักวิจัยชั้นยอดนี้หล่อหลอมวัฒนธรรมเริ่มต้นของ OpenAI: มุ่งผลักดันพรมแดนความสามารถของ AI อย่างทะเยอทะยาน แต่จัดตั้งเป็นแล็บไม่แสวงหากำไรที่มุ่งผลกระทบระยะยาวแทนการพาณิชย์ระยะสั้น

เมื่อ OpenAI เปิดตัวในฐานะแล็บไม่แสวงหากำไรในปี 2015 คำมั่นสาธารณะเป็นเรื่องเรียบง่ายแต่ทะเยอทะยาน: พัฒนา AI ในขณะเดียวกันก็แชร์สิ่งที่เป็นไปได้กับชุมชนกว้าง

ช่วงแรกถูกนิยามด้วยปรัชญา "เปิดโดยค่าเริ่มต้น" งานวิจัยถูกเผยแพร่เร็ว โค้ดมักถูกปล่อย และเครื่องมือภายในถูกแปลงเป็นโปรเจกต์สาธารณะ แนวคิดคือการเร่งการก้าวหน้าทางวิทยาศาสตร์อย่างกว้างขวาง — และการตรวจสอบจากสาธารณะ — จะปลอดภัยและเป็นประโยชน์มากกว่าการรวบรวมความสามารถไว้ในบริษัทเดียว

ในขณะเดียวกัน ความปลอดภัยก็เป็นส่วนหนึ่งของการสนทนา ทีมงานเริ่มพูดถึงเวลาที่ความเปิดเผยอาจเพิ่มความเสี่ยงการใช้งานในทางที่ผิด และเริ่มร่างแนวคิดการปล่อยเป็นขั้น และการทบทวนนโยบาย แม้ว่าคิดเหล่านี้ยังเป็นรูปแบบกว้างเมื่อเทียบกับกระบวนการธรรมาภิบาลในภายหลัง

งานวิทยาศาสตร์เริ่มแรกของ OpenAI ครอบคลุมหลายด้านหลัก:

โปรเจกต์เหล่านี้เน้นการทดสอบความเป็นไปได้กับ deep learning การใช้คอมพิวต์ และการออกแบบการฝึก มากกว่าจะเป็นผลิตภัณฑ์ที่ขัดเกลาแล้ว

สองผลงานที่มีอิทธิพลคือ OpenAI Gym และ Universe

ทั้งสองโปรเจกต์สะท้อนความมุ่งมั่นต่อโครงสร้างพื้นฐานที่ใช้ร่วมกันมากกว่าข้อได้เปรียบแบบกรรมสิทธิ์

ในยุคองค์กรไม่แสวงหากำไร OpenAI มักถูกมองว่าเป็นสมดุลเชิงภารกิจต่อห้องปฏิบัติการ AI ของบริษัทใหญ่ เพื่อนร่วมงานให้ความสำคัญกับคุณภาพงานวิจัย การมีโค้ดและสภาพแวดล้อมให้ใช้ และความเต็มใจในการพูดคุยเรื่องความปลอดภัย

สื่อเน้นการรวมกันที่ไม่ปกติของผู้สนับสนุนชื่อดัง รูปแบบไม่เน้นพาณิชย์ และคำมั่นว่าจะเผยแพร่แบบเปิด ความชื่อนี้ในฐานะแล็บวิจัยที่ทรงอิทธิพลและกังวลผลระยะยาว กำหนดความคาดหวังซึ่งมีผลต่อการตอบสนองต่อการเปลี่ยนแปลงเชิงกลยุทธ์ต่อไป

จุดเปลี่ยนสำคัญคือการตัดสินใจของ OpenAI ที่จะมุ่งโมเดลภาษาขนาดใหญ่แบบทรานส์ฟอร์มเมอร์ การเปลี่ยนนี้เปลี่ยน OpenAI จากแล็บวิจัยเป็นบริษัทที่เป็นที่รู้จักในฐานะผู้สร้างโมเดลพื้นฐานที่ผู้อื่นต่อยอด

GPT-1 เทียบกับมาตรฐานปัจจุบันถือว่าน้อย — มีพารามิเตอร์ 117 ล้านตัว ฝึกบน BookCorpus — แต่เป็นการพิสูจน์แนวคิดสำคัญ

แทนที่จะฝึกโมเดลแยกสำหรับแต่ละงาน NLP GPT-1 แสดงให้เห็นว่าโมเดลทรานส์ฟอร์มเมอร์เดียวที่ฝึกด้วยเป้าหมายเรียบง่าย (ทำนายคำถัดไป) สามารถปรับด้วย fine-tuning เพียงเล็กน้อยให้ทำงานเช่น question answering, sentiment analysis, textual entailment

สำหรับโรดแมปของ OpenAI GPT-1 ยืนยันแนวคิดสามอย่าง:

GPT-2 ขยายสูตรเดิมมากขึ้น: 1.5 พันล้านพารามิเตอร์และชุดข้อมูลจากเว็บขนาดใหญ่ ผลลัพธ์มักต่อเนื่องอย่างน่าประหลาดใจ: บทความหลายย่อหน้า เรื่องสั้น และสรุปที่ดูเหมือนเขียนโดยมนุษย์

ความสามารถเหล่านี้ก่อให้เกิดความกังวลเกี่ยวกับการใช้งานในทางที่ผิด: โฆษณาชวนเชื่ออัตโนมัติ สแปม การคุกคาม และข่าวปลอมในระดับใหญ่ แทนที่จะปล่อยโมเดลเต็มรูปแบบทันที OpenAI ใช้นโยบายปล่อยเป็นขั้น:

นี่เป็นหนึ่งในตัวอย่างสาธารณะแรก ๆ ที่ OpenAI ผูกการตัดสินใจปล่อยเข้ากับความปลอดภัยและผลกระทบทางสังคม และส่งผลต่อแนวคิดเรื่องการเปิดเผย ความรับผิดชอบ และความโปร่งใสขององค์กร

GPT-3 ขยายขึ้นอีกครั้ง—ครั้งนี้มี 175 พันล้านพารามิเตอร์ แทนการพึ่งพาการ fine-tune สำหรับแต่ละงานเป็นหลัก GPT-3 แสดงความสามารถแบบ “few‑shot” และแม้แต่ “zero‑shot”: โมเดลมักทำงานใหม่ได้เพียงจากคำสั่งและตัวอย่างไม่กี่ตัวในพรอมต์

ความเป็นสากลนี้เปลี่ยนวิธีคิดของ OpenAI และอุตสาหกรรม: แทนที่จะสร้างโมเดลแคบหลายตัว โมเดลใหญ่ตัวเดียวสามารถเป็นเครื่องยนต์ทั่วไปสำหรับ:

สำคัญคือ OpenAI ตัดสินใจไม่เปิดซอร์ส GPT-3 ให้ดาวน์โหลด แต่ให้เข้าถึงผ่าน API เชิงพาณิชย์ การตัดสินใจนี้เป็นการเปลี่ยนยุทธศาสตร์:

GPT-1 ถึง GPT-3 แสดงเส้นทางชัดเจนของ OpenAI: ขยายทรานส์ฟอร์มเมอร์ ค้นพบความสามารถที่เกิดขึ้นเอง ต่อสู้กับความเสี่ยง และปูพื้นฐานเชิงพาณิชย์ที่ต่อยอดสู่ผลิตภัณฑ์อย่าง ChatGPT และการพัฒนา GPT‑4 ต่อไป

ภายในปี 2018 ผู้นำ OpenAI เชื่อว่าการเป็นแล็บเล็ก ๆ ที่พึ่งพาการบริจาคไม่เพียงพอสำหรับการสร้างและควบคุมระบบ AI ขนาดใหญ่ การฝึกโมเดลแนวหน้าต้องการเงินคอมพิวต์และบุคลากรจำนวนมาก เพื่อแข่งขันดึงนักวิจัยชั้นนำ ทำการทดลองขนาดและเข้าถึงโครงสร้างพื้นฐานคลาวด์ระยะยาว OpenAI จึงต้องการโครงสร้างที่ดึงทุนได้โดยไม่ทิ้งภารกิจเดิม

ในปี 2019 OpenAI เปิดตัว OpenAI LP เป็นองค์กรแบบ "capped‑profit" จุดประสงค์เพื่อปลดล็อกการลงทุนภายนอกขนาดใหญ่ ในขณะที่ยังคงให้คำมั่นถึงภารกิจขององค์กรไม่แสวงหากำไร—ให้ AGI เป็นประโยชน์ต่อมนุษยชาติ—อยู่เหนือการตัดสินใจ

บริษัทสตาร์ทอัพทั่วไปต้องรับผิดชอบต่อผู้ถือหุ้นที่ต้องการผลตอบแทนแบบไม่จำกัด ผู้ก่อตั้ง OpenAI กังวลว่าสิ่งนั้นจะกดดันให้ให้ความสำคัญกับกำไรมากกว่าความปลอดภัยหรือการเผยแพร่ OpenAI LP เป็นข้อประนีประนอม: สามารถออกสิทธิ์คล้ายหุ้นและระดมทุนได้ในระดับใหญ่ แต่ภายใต้กฎที่ต่างไป

ในโมเดลกำไรจำกัด นักลงทุนและพนักงานสามารถรับผลตอบแทนจากการถือหุ้นใน OpenAI LP แต่มีเพดานการคืนทุนที่กำหนดไว้ (สำหรับนักลงทุนเริ่มแรกมักอ้างถึงเป็นสูงสุด 100x โดย trancheLater ต่ำกว่า) เมื่อตั้งค่าพ้นเพดานนั้น มูลค่าเพิ่มเติมจะถูกส่งกลับไปยังองค์กรไม่แสวงหากำไรเพื่อใช้ตามภารกิจ

ต่างจากสตาร์ทอัพทั่วไปที่มูลค่าหุ้นสามารถเติบโตแบบไม่จำกัดและการเพิ่มมูลค่าผู้ถือหุ้นเป็นค่าเริ่มต้นทางกฎหมายและวัฒนธรรม

OpenAI Nonprofit ยังคงเป็นหน่วยควบคุม คณะกรรมการขององค์กรไม่แสวงหากำไรกำกับ OpenAI LP และถูกนิยามให้ให้ความสำคัญกับผลประโยชน์ของมนุษยชาติเหนือกลุ่มนักลงทุนหรือพนักงานใด ๆ

โดยเป็นทางการ:

การออกแบบธรรมาภิบาลนี้มีเป้าหมายให้ OpenAI มีความยืดหยุ่นในการระดมทุนและการจ้างงานแบบองค์กรพาณิชย์ในขณะที่ยังคงการควบคุมที่มุ่งภารกิจ

การปรับโครงสร้างก่อให้เกิดการถกเถียงทั้งภายในและภายนอก ผู้สนับสนุนมองว่าเป็นหนทางเดียวที่จะระดมทุนพันล้านที่จำเป็นสำหรับการวิจัยขั้นแนวหน้าโดยยังคงจำกัดแรงจูงใจด้านกำไร ผู้วิจารณ์ถามว่าโครงสร้างใดที่ให้ผลตอบแทนสูงจะต้านแรงกดดันทางการค้าจริงหรือไม่ และเพดานที่ตั้งไว้นั้นเพียงพอหรือถูกบังคับใช้แค่ไหน

ในเชิงปฏิบัติ OpenAI LP เปิดทางให้การลงทุนเชิงกลยุทธ์ขนาดใหญ่ ได้แก่ การลงทุนจาก Microsoft และอนุญาตให้บริษัทเสนอแพ็กเกจค่าตอบแทนที่แข่งขันได้ ซึ่งช่วยให้ OpenAI ขยายทีมวิจัย ขยายการรันการฝึกโมเดลอย่าง GPT-3 และ GPT-4 และสร้างโครงสร้างพื้นฐานที่จำเป็นสำหรับการปรับใช้ระบบเช่น ChatGPT ในระดับโลก ขณะเดียวกันก็ยังคงความเชื่อมโยงธรรมาภิบาลกลับสู่รากฐานไม่แสวงหากำไร

ในปี 2019 OpenAI และ Microsoft ประกาศความร่วมมือหลายปีที่เปลี่ยนบทบาทของทั้งสองฝ่าย Microsoft ลงทุนประมาณ 1 พันล้านดอลลาร์ รวมเงินสดและเครดิต Azure แลกกับการเป็นพันธมิตรเชิงพาณิชย์ที่เป็นที่ต้องการของ OpenAI

ข้อตกลงสอดคล้องกับความต้องการของ OpenAI ในการเข้าถึงทรัพยากรคอมพิวต์ขนาดใหญ่ เพื่อฝึกโมเดลที่ใหญ่ขึ้น ขณะที่ Microsoft ได้เข้าถึง AI ขั้นแนวหน้าเพื่อสร้างความแตกต่างให้ผลิตภัณฑ์และแพลตฟอร์มคลาวด์ของตน ความสัมพันธ์ลึกซึ้งขึ้นในปีต่อมา ผ่านการลงทุนและความร่วมมือเชิงเทคนิคเพิ่มเติม

OpenAI เลือก Microsoft Azure เป็นแพลตฟอร์มคลาวด์หลักด้วยเหตุผลหลายประการ:

สิ่งนี้ทำให้ Azure เป็นสภาพแวดล้อมเริ่มต้นสำหรับการฝึกและให้บริการโมเดลเช่น GPT‑3, Codex, และต่อมา GPT‑4

ความร่วมมือนำไปสู่การสร้างหนึ่งในระบบซุปเปอร์คอมพิวติ้งด้าน AI ที่ใหญ่ที่สุดในโลก บน Azure สำหรับงานของ OpenAI Microsoft นำเสนอคลัสเตอร์เหล่านี้เป็นตัวอย่างธงของความสามารถ AI บน Azure ขณะที่ OpenAI พึ่งพาพวกมันเพื่อผลักดันขนาดโมเดล ข้อมูลฝึก และความเร็วทดลอง

ความร่วมมือนี้ทำให้เส้นแบ่งระหว่าง “ลูกค้า” และ “พันธมิตร” เลือนราง: OpenAI มีอิทธิพลต่อแผนถนนของ Azure และ Azure ถูกปรับให้เหมาะกับความต้องการของ OpenAI

Microsoft ได้รับ สิทธิ์การใช้งานเฉพาะเชิงพาณิชย์ สำหรับเทคโนโลยีบางอย่างของ OpenAI โดยเฉพาะ GPT‑3 ซึ่งอนุญาตให้ Microsoft ผนวกโมเดล OpenAI ลงในผลิตภัณฑ์ของตน—รวมถึง Bing, Office, GitHub Copilot, Azure OpenAI Service—ในขณะที่บริษัทอื่นเข้าถึงผ่าน API ของ OpenAI เอง

สิทธิพิเศษนี้กระตุ้นการถกเถียง: ผู้สนับสนุนว่าเป็นแหล่งทุนและช่องทางการกระจายที่จำเป็นต่อการปรับขนาด AI อย่างปลอดภัย ผู้วิจารณ์กลัวว่ามันจะรวมอำนาจต่อโมเดลแนวหน้าไว้กับบริษัทเทคใหญ่เพียงรายเดียว

พร้อม ๆ กัน ความร่วมมือช่วยให้ OpenAI เป็นที่รู้จักในวงกว้าง การติดแบรนด์ การผนวกผลิตภัณฑ์ และช่องทางขายของ Microsoft ช่วยย้ายระบบของ OpenAI จากเดโมวิจัยสู่เครื่องมือที่ใช้ในชีวิตประจำวันโดยล้าน ๆ คน กำหนดภาพลักษณ์ว่า OpenAI เป็นทั้งแล็บอิสระและพันธมิตร AI สำคัญของ Microsoft

เมื่อโมเดลของ OpenAI ดีขึ้นในการเข้าใจและสร้างภาษา ทีมงานขยายสู่โมดัลอื่น ๆ: ภาพและโค้ด การเปลี่ยนนี้ขยายงานของ OpenAI จากการเขียนและบทสนทนาไปสู่ความคิดสร้างสรรค์เชิงภาพและการพัฒนาซอฟต์แวร์

CLIP (Contrastive Language–Image Pretraining) ประกาศต้นปี 2021 เป็นก้าวสำคัญสู่โมเดลที่เข้าใจโลกใกล้เคียงกับมนุษย์

แทนการฝึกบนรูปที่มีป้ายกำกับเท่านั้น CLIP เรียนรู้จากคู่รูป‑คำบรรยายหลายร้อยล้านคู่ที่ขูดจากเว็บสาธารณะ ฝึกให้จับคู่รูปภาพกับคำอธิบายที่เป็นไปได้มากที่สุดและแยกจากคำอธิบายที่ไม่ถูกต้อง

นี่ทำให้ CLIP มีความสามารถทั่วไปที่น่าประหลาดใจ:

CLIP กลายเป็นฐานสำหรับงานสร้างภาพเชิงผลผลิตในภายหลังของ OpenAI

DALL·E (2021) นำสถาปัตยกรรมสไตล์ GPT มาสู่ภาพ สร้างรูปจากพรอมต์ข้อความ เช่น “เก้าอี้รูปอโวคาโด” หรือ “ป้ายร้านที่เขียนว่า ‘openai’” แสดงให้เห็นว่าโมเดลภาษาสามารถขยายไปสร้างภาพที่สอดคล้องและมักมีความขบขันหรือสร้างสรรค์ได้

DALL·E 2 (2022) ปรับปรุงความละเอียด ความสมจริง และการควบคุมอย่างมาก มีฟีเจอร์เช่น:

ระบบเหล่านี้เปลี่ยนวิธีที่นักออกแบบ นักการตลาด ศิลปิน และผู้ใช้ทั่วไปทำต้นแบบไอเดีย จากงานร่างด้วยมือไปสู่การสำรวจแบบวนลูปด้วยพรอมต์

Codex (2021) ปรับ GPT‑3 ให้เข้ากับซอร์สโค้ด โดยฝึกบนฐานโค้ดสาธารณะขนาดใหญ่ มันสามารถแปลภาษาธรรมชาติเป็นโค้ดที่ทำงานได้ในภาษาอย่าง Python, JavaScript และภาษาอื่น ๆ

GitHub Copilot ที่สร้างบน Codex นำสิ่งนี้เข้าสู่เครื่องมือพัฒนาทุกวัน โปรแกรมเมอร์เริ่มได้รับฟังก์ชัน ทดสอบ และโค้ด boilerplate เป็นคำแนะนำ โดยใช้คอมเมนต์ภาษาธรรมชาติเป็นแนวทาง

สำหรับการพัฒนาซอฟต์แวร์ Codex บ่งชี้การเปลี่ยนแปลงทีละน้อย:

ร่วมกัน CLIP, DALL·E และ Codex แสดงให้เห็นว่าวิธีของ OpenAI ขยายไปเกินข้อความสู่ภาพและโค้ด กระจายผลกระทบไปยังงานศิลป์ การออกแบบ และวิศวกรรม

OpenAI เปิดตัว ChatGPT เป็น "research preview" ฟรีเมื่อวันที่ 30 พฤศจิกายน 2022 ประกาศผ่านบล็อกสั้น ๆ และทวีตมากกว่าการทำแคมเปญผลิตภัณฑ์ใหญ่ โมเดลนี้อิงจาก GPT‑3.5 ปรับแต่งสำหรับบทสนทนา พร้อมกลไกป้องกันให้ปฏิเสธคำขออันตรายบางอย่าง

การใช้งานพุ่งขึ้นทันที ผู้คนนับล้านสมัครภายในไม่กี่วัน และ ChatGPT กลายเป็นหนึ่งในแอปผู้บริโภคที่เติบโตเร็วที่สุด ภาพหน้าจอของการสนทนากระจายบนโซเชียลมีเดีย ขณะที่ผู้ใช้ทดสอบความสามารถในการเขียนเรียงความ แก้บั๊กโค้ด ร่างอีเมล และอธิบายหัวข้อซับซ้อนเป็นภาษาง่าย ๆ

เสน่ห์ของ ChatGPT มาจากความหลากหลายมากกว่ากรณีใช้งานเดียว

ในการศึกษา นักเรียนใช้มันสรุปการอ่าน สร้างคำถามฝึกหัด แปลหรือทำให้งานวิชาการง่ายขึ้น และขอคำอธิบายขั้นตอนในปัญหาคณิตศาสตร์หรือวิทยาศาสตร์ ครูทดลองใช้เพื่อออกแบบหลักสูตร ร่างเกณฑ์การให้คะแนน และสร้างสื่อการเรียนรู้ที่ปรับระดับได้ ขณะที่โรงเรียนถกเถียงว่าจะอนุญาตหรือควบคุมอย่างไร

ที่ทำงาน ผู้เชี่ยวชาญใช้ ChatGPT ร่างอีเมล ข้อความการตลาด รายงาน สร้างโครงร่างการนำเสนอ โค้ดตัวอย่าง และทดสอบกรณี ท่ามกลางการระดมไอเดียสำหรับผลิตภัณฑ์และกลยุทธ์ กลุ่มฟรีแลนซ์และธุรกิจขนาดเล็กใช้มันเป็นผู้ช่วยต้นทุนต่ำสำหรับเนื้อหาและการวิเคราะห์

ในชีวิตประจำวัน ผู้คนใช้ ChatGPT วางแผนการเดินทาง หาไอเดียทำอาหารจากวัตถุดิบในตู้ แสดงคำอธิบายกฎหมายหรือการแพทย์พื้นฐาน (มักมีคำเตือนให้ขอคำปรึกษามืออาชีพ) และช่วยเรียนรู้ทักษะหรือภาษาใหม่

พรีวิววิจัยฟรีช่วยลดอุปสรรคและเก็บข้อเสนอแนะเกี่ยวกับความล้มเหลว การใช้งานในทางที่ผิด และความสามารถที่ขาด ในขณะที่การใช้งานเติบโต OpenAI เผชิญต้นทุนโครงสร้างพื้นฐานสูงและความต้องการการเข้าถึงที่เสถียร

ในกุมภาพันธ์ 2023 OpenAI เปิดตัว ChatGPT Plus แผนสมัครสมาชิกที่ให้การตอบสนองเร็วขึ้น การเข้าถึงลำดับความสำคัญในช่วงที่มีผู้ใช้มาก และการเข้าถึงฟีเจอร์และโมเดลใหม่ก่อน เช่น GPT‑4 สร้างกระแสรายได้ประจำขณะที่ยังคงมีชั้นฟรีเพื่อการเข้าถึงกว้าง

เวลาผ่านไป OpenAI เพิ่มตัวเลือกสำหรับองค์กร: การเข้าถึง API ของโมเดลสนทนา เครื่องมือผนวกเข้ากับผลิตภัณฑ์ และข้อเสนออย่าง ChatGPT Enterprise และแผนทีมที่มุ่งองค์กรที่ต้องการความปลอดภัย การควบคุมผู้ดูแล และการปฏิบัติตามกฎข้อบังคับ

การมองเห็นอย่างกะทันหันของ ChatGPT ทำให้ข้อถกเถียงเรื่อง AI รุนแรงขึ้น

ผู้กำกับดูแลและผู้ร่างนโยบายกังวลเรื่องความเป็นส่วนตัว การคุ้มครองข้อมูล และความสอดคล้องกับกฎหมายที่มีอยู่ โดยเฉพาะในเขตเช่นสหภาพยุโรป บางหน่วยงานจำกัดหรือสอบสวน ChatGPT ชั่วคราวขณะที่ประเมินการเก็บรวมและการประมวลผลข้อมูล

การศึกษาเผชิญความกังวลเรื่องการลอกงานและความซื่อสัตย์ทางวิชาการ เมื่อนักเรียนสามารถสร้างเรียงความและคำตอบที่ยากจะตรวจจับ โรงเรียนบางแห่งห้ามหรือกำหนดนโยบายเข้มงวด ขณะที่บางแห่งปรับแนวการสอนให้เน้นกระบวนการ การสอบปากเปล่า หรืองานในห้องเรียน

นักจริยธรรมและนักวิจัยเตือนเกี่ยวกับข้อมูลผิดพลาด การพึ่งพา AI ในการตัดสินใจสำคัญ อคติในคำตอบ และผลกระทบต่องานสร้างสรรค์และงานความรู้ ยังมีคำถามเกี่ยวกับข้อมูลฝึก ลิขสิทธิ์ และสิทธิของศิลปินและนักเขียนที่อาจมีส่วนต่อพฤติกรรมของโมเดล

สำหรับ OpenAI ChatGPT เป็นจุดเปลี่ยน: มันแปลงองค์กรจากแล็บที่มุ่งวิจัยเป็นบริษัทที่อยู่ตรงกลางการสนทนาระดับโลกเกี่ยวกับการปรับใช้ การกำกับดูแล และการผนวกโมเดลภาษาอันทรงพลังเข้ากับชีวิตประจำวัน

OpenAI ปล่อย GPT-4 ในเดือนมีนาคม 2023 เป็นก้าวสำคัญเหนือ GPT‑3.5 โมเดลนี้ปรับปรุงการให้เหตุผล การปฏิบัติตามคำสั่งซับซ้อน และรักษาความต่อเนื่องในบทสนทนายาว ๆ ได้ดีขึ้น มันยังรับมือพรอมต์ละเอียด เช่น การอธิบายข้อกำหนดทางกฎหมาย สรุปบทความเชิงเทคนิค หรือร่างโค้ดจากข้อกำหนดไม่ชัดเจนได้ดีขึ้น

เมื่อเทียบกับ GPT‑3.5 GPT‑4 ลดรูปแบบความล้มเหลวที่ชัดเจนหลายอย่าง: มีแนวโน้มสร้างแหล่งอ้างอิงเท็จน้อยลง เมื่อต้องการคำอ้างอิง มีความแม่นยำในกรณีคณิตศาสตร์และตรรกะมากขึ้น และให้ผลลัพธ์ที่สอดคล้องข้ามคำถามซ้ำได้ดีขึ้น

GPT-4 นำความสามารถมัลติโมดัลเข้ามา: นอกเหนือจากข้อความ มันสามารถรับภาพเป็นอินพุตในการตั้งค่าบางแบบ ซึ่งเปิดกรณีการใช้งานเช่น อธิบายชาร์ต อ่านบันทึกมือถืิอ วิเคราะห์ภาพหน้าจอ UI หรือแยกข้อมูลจากรูปภาพ

ในการทดสอบมาตรฐาน GPT‑4 ทำคะแนนเหนือโมเดลก่อนหน้าอย่างมีนัยสำคัญ ได้คะแนนในระดับท็อปเปอร์เซ็นไทล์บนการทดสอบวิชาชีพจำลอง เช่น สอบบาร์ SAT และการทดสอบขั้นสูงบางรายการ รวมถึงปรับปรุงด้านการเขียนโค้ดและการให้เหตุผล แสดงถึงความสามารถที่แข็งแกร่งขึ้นทั้งในการเข้าใจภาษาและแก้ปัญหา

GPT‑4 กลายเป็นแกนกลางของ API ของ OpenAI และขับเคลื่อนคลื่นผลิตภัณฑ์ใหม่: ผู้ช่วย AI ในชุดผลิตภาพ เครื่องมือช่วยเขียนโค้ด ฝ่ายบริการลูกค้า แพลตฟอร์มการศึกษา และแอปเฉพาะด้านในกฎหมาย การเงิน และสุขภาพ

แม้จะก้าวหน้า GPT‑4 ยังมีปัญหาเรื่อง hallucination สามารถถูกชี้นำให้ให้ผลลัพธ์ไม่ปลอดภัยหรือมีอคติ และไม่เข้าใจอย่างแท้จริงหรือมีความรู้ที่เป็นปัจจุบัน OpenAI ให้ความสำคัญกับงานวิจัยด้านการปรับแนวสำหรับ GPT‑4—ใช้เทคนิคอย่าง RLHF, red‑teaming และนโยบายระดับระบบ—แต่เน้นว่าการปรับใช้ ระวัง และวิจัยอย่างต่อเนื่องยังจำเป็นในการจัดการความเสี่ยงและการใช้งานในทางที่ผิด

ตั้งแต่ปีแรก OpenAI ให้ความสำคัญกับความปลอดภัยและการปรับแนวเป็นส่วนหนึ่งของภารกิจ องค์กรระบุว่าตั้งใจสร้างระบบที่มีความสามารถสูงซึ่งสอดคล้องกับค่านิยมมนุษย์และปรับใช้ในทางที่เป็นประโยชน์ต่อทุกคน ไม่ใช่แค่ผู้ถือหุ้นหรือพันธมิตรกลุ่มแรก

ในปี 2018 OpenAI เผยแพร่ OpenAI Charter ซึ่งทำให้ลำดับความสำคัญชัดเจน:

Charter ทำหน้าที่เป็นเข็มทิศธรรมาภิบาล กำหนดการตัดสินใจเรื่องทิศทางวิจัย ความเร็วการปรับใช้ และความร่วมมือภายนอก

เมื่อโมเดลทรงพลังขึ้น OpenAI สร้างฟังก์ชันด้านความปลอดภัยและธรรมาภิบาลควบคู่กับทีมวิจัยหลัก:

กลุ่มเหล่านี้ส่งผลต่อการตัดสินใจปล่อย ระดับการเข้าถึง และนโยบายการใช้งานของโมเดลอย่าง GPT‑4 และ DALL·E

แนวทางเทคนิคสำคัญคือ reinforcement learning from human feedback (RLHF) ผู้จัดการมนุษย์ประเมินผลลัพธ์ของโมเดล จัดอันดับ และฝึกแบบจำลองรางวัล โมเดลหลักถูกปรับให้ผลิตการตอบสนองใกล้เคียงพฤติกรรมที่มนุษย์ชอบ ลดผลลัพธ์ที่เป็นพิษหรือลำเอียง

เมื่อเวลาผ่านไป OpenAI ผสมผสาน RLHF กับเทคนิคอื่น ๆ: นโยบายความปลอดภัยระดับระบบ ตัวกรองเนื้อหา การปรับจูนสำหรับโดเมนเฉพาะ และเครื่องมือมอนิเตอริ่งที่จำกัดหรือแจ้งเตือนการใช้งานที่มีความเสี่ยงสูง

OpenAI มีส่วนร่วมในกรอบงานความปลอดภัยสาธารณะ เช่น ความมุ่งมั่นสมัครใจต่อรัฐบาล แนวปฏิบัติการรายงานโมเดล และมาตรฐานความปลอดภัยสำหรับโมเดลแนวหน้า ร่วมมือกับนักวิชาการ องค์กรภาคประชาสังคม และนักวิจัยด้านความปลอดภัยในการประเมิน การ red‑teaming และการตรวจสอบ

ความร่วมมือเหล่านี้ ร่วมกับเอกสารทางการอย่าง Charter และนโยบายการใช้งานที่พัฒนาแล้ว เป็นแกนหลักของแนวทาง OpenAI ในการกำกับโมเดล AI ที่ทรงพลังขึ้น

การเติบโตอย่างรวดเร็วของ OpenAI ถูกบดบังด้วยคำวิจารณ์และความตึงเครียดภายใน ส่วนใหญ่เกี่ยวกับความสอดคล้องขององค์กรกับภารกิจดั้งเดิมในการให้ประโยชน์อย่างกว้างขวางและปลอดภัย

ช่วงแรก OpenAI เน้นการเผยแพร่และการแบ่งปัน แต่เมื่อโมเดลอย่าง GPT‑2, GPT‑3, GPT‑4 ทรงพลังขึ้น บริษัทหันไปสู่การปล่อยแบบจำกัด การเข้าถึงผ่าน API และรายละเอียดทางเทคนิคน้อยลง

ผู้วิจารณ์มองว่าการเปลี่ยนนี้ขัดกับคำสัญญาที่ชื่อ "OpenAI" สื่อออกมา ฝ่ายสนับสนุนภายในบอกว่าการเก็บน้ำหนักโมเดลไว้ไม่เผยแพร่ทั้งหมดเป็นสิ่งจำเป็นเพื่อจัดการความเสี่ยงและความปลอดภัย OpenAI ตอบโต้ด้วยการเผยแพร่การประเมินความปลอดภัย ใบระบบ (system cards) และเอกสารนโยบาย ขณะเดียวกันเก็บน้ำหนักแกนกลางไว้เป็นกรรมสิทธิ์ มันถูกนำเสนอเป็นสมดุลระหว่างความเปิด ความปลอดภัย และแรงกดดันเชิงการแข่งขัน

เมื่อ OpenAI ขยายพันธมิตรกับ Microsoft — ผนวกโมเดลเข้ากับ Azure และผลิตภัณฑ์อย่าง Copilot — ผู้สังเกตการณ์ตั้งคำถามเรื่องการรวมอำนาจของคอมพิวต์ ข้อมูล และการตัดสินใจ

ผู้วิจารณ์กังวลว่าบริษัทจำนวนน้อยกำลังควบคุมโมเดลทั่วไปขั้นสูงและโครงสร้างพื้นฐานเบื้องหลัง ในขณะที่บางคนเห็นว่าการพาณิชย์ที่รุกเร้าจะเบี่ยงเบนจากภารกิจดั้งเดิม OpenAI ให้เหตุผลว่ารายได้จำเป็นสำหรับการวิจัยราคาแพง และยืนยันโครงสร้างกำไรจำกัดและ Charter ที่ให้ความสำคัญกับผลประโยชน์มนุษย์ นอกจากนี้ยังมีโปรแกรมเช่นชั้นการเข้าถึงฟรี ความร่วมมือด้านการวิจัย และเครื่องมือโอเพนซอร์สบางส่วนเพื่อแสดงประโยชน์สาธารณะ

ความขัดแย้งภายในเรื่องความเร็วในการเคลื่อนไหว ความเปิดเผย และลำดับความสำคัญของความปลอดภัยปรากฏขึ้นหลายครั้ง

Dario Amodei และผู้อื่นลาในปี 2020 เพื่อก่อตั้ง Anthropic โดยอ้างความเห็นต่างเรื่องความปลอดภัยและธรรมาภิบาล การลาออกของนักวิจัยด้านความปลอดภัยคนสำคัญในปี 2024 เช่น Jan Leike เน้นความกังวลว่าจุดมุ่งหมายระยะสั้นอาจมาก่อนงานความปลอดภัยระยะยาว

การแตกหักที่มองเห็นได้ชัดคือเหตุการณ์ในเดือนพฤศจิกายน 2023 ที่บอร์ดถอด Sam Altman ออกจากตำแหน่ง CEO ชั่วคราว เนื่องจากการสูญเสียความไว้วางใจ หลังจากแรงต้านของพนักงานและการเจรจารวมถึง Microsoft และฝ่ายอื่น ๆ Altman กลับมารับตำแหน่ง บอร์ดได้รับการปรับโครงสร้าง และ OpenAI สัญญาการปฏิรูปธรรมาภิบาล รวมถึงคณะกรรมการด้านความปลอดภัยและความมั่นคงใหม่

เหตุการณ์เหล่านี้ย้ำว่าองค์กรยังคงพยายามประสานการปรับใช้ที่รวดเร็ว ความสำเร็จเชิงพาณิชย์ และความรับผิดชอบต่อความปลอดภัยและประโยชน์กว้าง

OpenAI เปลี่ยนจากแล็บวิจัยเล็ก ๆ สู่ผู้ให้บริการโครงสร้างพื้นฐานกลางสำหรับ AI มีอิทธิพลต่อวิธีการสร้าง กำกับ และเข้าใจเครื่องมือใหม่ ๆ

แทนการเผยแพร่โมเดล OpenAI ปัจจุบันดำเนินแพลตฟอร์มเต็มรูปแบบที่สตาร์ทอัพ องค์กร และนักพัฒนาคนเดียวใช้ ผ่าน API ของโมเดลอย่าง GPT‑4, DALL·E และระบบในอนาคต มันกลายเป็น:

บทบาทแพลตฟอร์มนี้หมายความว่า OpenAI ไม่เพียงแต่ผลักดันงานวิจัย แต่ยังกำหนดค่าดีฟอลต์ว่าผู้คนนับล้านจะพบเทคโนโลยี AI ทรงพลังครั้งแรกอย่างไร

งานของ OpenAI กระตุ้นให้คู่แข่งและชุมชนโอเพนซอร์สตอบโต้ด้วยโมเดลใหม่ วิธีการฝึก และแนวทางความปลอดภัย การแข่งขันดังกล่าวเร่งความก้าวหน้าและขับให้เกิดการถกเถียงเรื่องความเปิด การรวมศูนย์ และการพาณิชย์ของ AI

รัฐบาลและผู้กำกับดูแลมองแนวปฏิบัติ รายงานความโปร่งใส และงานวิจัยการปรับแนวของ OpenAI เมื่อเขียนกฎสำหรับการปรับใช้ AI การประเมินความปลอดภัย และการใช้ที่รับผิดชอบ การสนทนาสาธารณะเกี่ยวกับ ChatGPT, GPT‑4 และระบบในอนาคตส่งผลต่อวิธีที่สังคมจินตนาการถึงความเสี่ยงและประโยชน์ของ AI

ขณะที่โมเดลมีความสามารถมากขึ้น ประเด็นที่ยังไม่คลี่คลายเกี่ยวกับบทบาทของ OpenAI ยิ่งสำคัญ:

คำถามเหล่านี้จะกำหนดว่า AI ในอนาคตจะขยายความไม่เท่าเทียมหรือช่วยลดช่องว่างได้อย่างไร

นักพัฒนาและธุรกิจสามารถ:

บุคคลทั่วไปสามารถ:

อิทธิพลในอนาคตของ OpenAI จะขึ้นกับการตัดสินใจภายในองค์กร และการที่รัฐบาล คู่แข่ง ภาคประชาสังคม และผู้ใช้ทั่วไปเลือกมีส่วนร่วม วิพากษ์ และเรียกร้องความรับผิดชอบจากระบบที่มันสร้าง

OpenAI ก่อตั้งในปี 2015 ในฐานะแล็บวิจัยแบบไม่แสวงหากำไร โดยมีภารกิจเพื่อให้แน่ใจว่า artificial general intelligence (AGI) หากถูกสร้างขึ้น จะเป็นประโยชน์ต่อมนุษยชาติทั้งหมด

ปัจจัยหลายอย่างมีส่วนทำให้เกิดการก่อตั้งนี้:

เรื่องราวการเริ่มต้นนี้ยังคงมีอิทธิพลต่อโครงสร้าง ความร่วมมือ และคำมั่นสัญญาสาธารณะของ OpenAI ในปัจจุบัน

AGI (artificial general intelligence) คือระบบ AI ที่สามารถทำงานทางปัญญาได้หลากหลายงานในระดับเทียบเท่าหรือเหนือกว่ามนุษย์ แทนที่จะเป็นเครื่องมือแค่งานเดียวที่จำกัด

ภารกิจของ OpenAI คือ:

ภารกิจนี้ถูกระบุอย่างเป็นทางการใน OpenAI Charter และนำทางการตัดสินใจด้านการวิจัยและการเปิดตัว

OpenAI เปลี่ยนจากองค์กรไม่แสวงหากำไรเป็นโครงสร้างแบบ "capped‑profit" (OpenAI LP) เพื่อระดมทุนจำนวนมากที่จำเป็นสำหรับการวิจัย AI ระดับแนวหน้า ในขณะเดียวกันก็พยายามรักษาภารกิจเป็นลำดับต้น

ประเด็นสำคัญ:

นี่คือการทดลองด้านธรรมาภิบาล และประสิทธิภาพของโครงสร้างนี้ยังเป็นที่ถกเถียง

Microsoft ให้ OpenAI กับทรัพยากรคลาวด์ขนาดใหญ่ผ่าน Azure และลงทุนเป็นเงินหลายพันล้านดอลลาร์

ความร่วมมือนี้รวมถึง:

ในทางกลับกัน OpenAI ได้ทรัพยากรที่จำเป็นสำหรับการฝึกและปรับใช้โมเดลระดับแนวหน้า ส่วน Microsoft ได้ความสามารถ AI ที่แตกต่างเพื่อเสริมผลิตภัณฑ์และบริการของตน

ชุด GPT แสดงการเติบโตทั้งในด้านขนาด ความสามารถ และกลยุทธ์การเปิดตัว:

ในช่วงแรก OpenAI ยึดหลัก “เปิดโดยค่าเริ่มต้น”—เผยแพร่เอกสาร โค้ด และเครื่องมืออย่าง OpenAI Gym แต่เมื่อโมเดลทรงพลังขึ้น องค์กรหันไปทางการจำกัดการปล่อย เช่น:

OpenAI อ้างว่านโยบายนี้จำเป็นเพื่อลดความเสี่ยงจากการใช้งานในทางที่ผิดและปัญหาด้านความปลอดภัย แต่ผู้วิจารณ์เห็นว่าแนวปฏิบัตินี้ขัดแย้งกับคำมั่นเดิมที่ชื่อองค์กรสื่อถึงความ "เปิด"

OpenAI ใช้ชุดวิธีการทั้งเชิงองค์กรและเชิงเทคนิคเพื่อลดความเสี่ยงและพยายามทำให้ระบบสอดคล้องกับเจตนาผู้ใช้:

มาตรการเหล่านี้ช่วยลดความเสี่ยงได้แต่ยังไม่สามารถขจัดปัญหาเช่น hallucination อคติ หรือการถูกนำไปใช้ในทางที่ผิด ซึ่งยังคงเป็นความท้าทายด้านการวิจัยและธรรมาภิบาล

การเปิดตัว ChatGPT ในปลายปี 2022 ทำให้โมเดลภาษาในระดับนี้เข้าถึงคนทั่วไปผ่านอินเทอร์เฟซแชทที่เข้าใจง่าย

มันเปลี่ยนการยอมรับ AI โดย:

การมองเห็นในวงกว้างนี้ยังเพิ่มการตรวจสอบการดำเนินงาน รูปแบบธุรกิจ และแนวทางด้านความปลอดภัยของ OpenAI

เทคโนโลยีของ OpenAI โดยเฉพาะ Codex และ GPT‑4 กำลังเปลี่ยนแปลงบางส่วนของงานความรู้และงานสร้างสรรค์

ประโยชน์ที่เป็นไปได้:

ความเสี่ยงและข้อกังวล:

คุณสามารถมีส่วนร่วมกับระบบนิเวศของ OpenAI ได้หลายวิธี:

ในทุกกรณี ควรติดตามว่าระบบถูกฝึกและบริหารจัดการอย่างไร และเรียกร้องความโปร่งใส ความรับผิดชอบ และการเข้าถึงที่เป็นธรรมขณะที่ความสามารถของระบบเพิ่มขึ้น

การตั้งค่าองค์กรและแรงกดดันจากการพาณิชย์นำไปสู่การถกเถียงและความตึงเครียดภายใน OpenAI:

ประเด็นเหล่านี้ยังคงเป็นหัวข้อการถกเถียงทั้งภายในและสาธารณะ

OpenAI ใช้วิธีหลายอย่างในการตรวจสอบและทดสอบโมเดลก่อนปล่อย:

อย่างไรก็ตาม ไม่มีระบบใดสมบูรณ์ และความเสี่ยงอย่าง hallucination, อคติ และการใช้งานที่ไม่เหมาะสมยังคงต้องติดตามและวิจัยต่อเนื่อง

OpenAI LP ถูกออกแบบให้สามารถดึงเงินทุนและเสนอผลตอบแทนได้ในระดับจำกัด แต่โครงสร้างยังมีคำถามเกี่ยวกับการควบคุมอำนาจและแรงจูงใจ:

สรุปคือ นี่เป็นการทดลองด้านธรรมาภิบาลที่ถูกจับตามองอย่างใกล้ชิด

การเน้นที่โมเดลพื้นฐานขนาดใหญ่และการให้บริการผ่านแพลตฟอร์มส่งผลให้ OpenAI กลายเป็นผู้ให้ฐานเทคโนโลยีสำหรับหลายแวดวง:

บทบาทนี้ทำให้ OpenAI ไม่เพียงแค่ผลักดันงานวิจัย แต่ยังกำหนดวิธีที่ผู้คนนับล้านพบและใช้งาน AI ขั้นสูงเป็นครั้งแรก

คำถามสำคัญที่ยังเปิดกว้างคือ:

คำถามเหล่านี้จะเป็นตัวกำหนดว่าเทคโนโลยีอนาคตจะขยายความไม่เท่าเทียมหรือช่วยลดช่องว่างอย่างไร

แต่ละก้าวผลักดันขอบเขตทางเทคนิคและบีบให้ต้องตัดสินใจใหม่เรื่องความปลอดภัย การเข้าถึง และการพาณิชย์

ผลสุทธิจะขึ้นกับนโยบาย ทางเลือกขององค์กร และวิธีที่บุคคลและบริษัทผนวก AI เข้ากับการทำงาน