สิ่งที่จะพังเมื่อคุณเริ่มขายให้กับองค์กร

การขายให้ทีมเล็กๆ ส่วนใหญ่เกี่ยวกับฟีเจอร์และความเร็ว การขายให้กับองค์กรเปลี่ยนความหมายของคำว่า “ดี” ได้อย่างมาก เกิดการสูญเสียความเชื่อถือได้จากเพียงการล่มครั้งเดียว บั๊กสิทธิ์ที่สับสน หรือการไม่มีบันทึกการตรวจสอบแค่ครั้งเดียว

ความน่าเชื่อถือ พูดง่ายๆ คือหมายถึงสามอย่าง: แอปยังใช้งานได้ ข้อมูลปลอดภัย และพฤติกรรมคาดเดาได้ ส่วนสุดท้ายนั้นสำคัญกว่าที่คิด ผู้ใช้ในองค์กรวางแผนงานรอบระบบของคุณ พวกเขาคาดหวังผลลัพธ์เดิมในวันนี้ สัปดาห์หน้า และหลังอัปเดตครั้งถัดไป

สิ่งที่มักพังก่อนไม่ใช่เซิร์ฟเวอร์ตัวเดียว แต่มักเป็นช่องว่างระหว่างสิ่งที่คุณสร้างไว้สำหรับผู้ใช้จำนวนน้อยกับสิ่งที่ลูกค้ารายใหญ่คาดว่าจะมีอยู่แล้ว พวกเขานำทราฟิกมากขึ้น บทบาทมากขึ้น การผสานรวมมากขึ้น และการตรวจสอบจากความปลอดภัยและการปฏิบัติตามข้อกำหนดมากขึ้น

จุดตึงเครียดช่วงแรกคาดเดาได้ ความคาดหวัง uptime เปลี่ยนจาก “โดยรวมโอเค” เป็น “ต้องเสถียรจนไม่น่าสนใจ” พร้อมกระบวนการจัดการเหตุการณ์ที่ชัดเจน ความปลอดภัยของข้อมูลกลายเป็นเรื่องระดับบอร์ด: แบ็กอัพ การกู้คืน บันทึกการเข้าถึง และความเป็นเจ้าของ สิทธิ์ซับซ้อนขึ้นอย่างรวดเร็ว: แผนก ผู้รับเหมา และการเข้าถึงแบบ least-privilege การเปลี่ยนแปลงกลายเป็นความเสี่ยง: การปล่อยแต่ละครั้งต้องมีการย้อนกลับและวิธีป้องกันพฤติกรรมที่ไม่คาดคิด ฝ่ายสนับสนุนหยุดเป็นแค่ “ความช่วยเหลือ” และกลายเป็นส่วนหนึ่งของผลิตภัณฑ์ โดยมีเวลาตอบสนองและเส้นทางการยกระดับชัดเจน

ลูกค้าแบบสตาร์ทอัพอาจยอมรับการล่มสองชั่วโมงและคำขอโทษอย่างรวดเร็ว ลูกค้าองค์กรอาจต้องการบทสรุปสาเหตุรากเหง้า หลักฐานว่าจะไม่เกิดซ้ำ และแผนป้องกันความล้มเหลวคล้ายกัน

เช็คลิสต์ความพร้อมสำหรับองค์กรไม่ใช่เรื่องของ “ซอฟต์แวร์สมบูรณ์แบบ” แต่มันคือการขยายโดยไม่ทำลายความเชื่อถือ โดยอัปเกรดการออกแบบผลิตภัณฑ์ นิสัยของทีม และการปฏิบัติงานในชีวิตประจำวันพร้อมกัน

Diane Greene และแนวคิดของ VMware ในหน้าเดียว

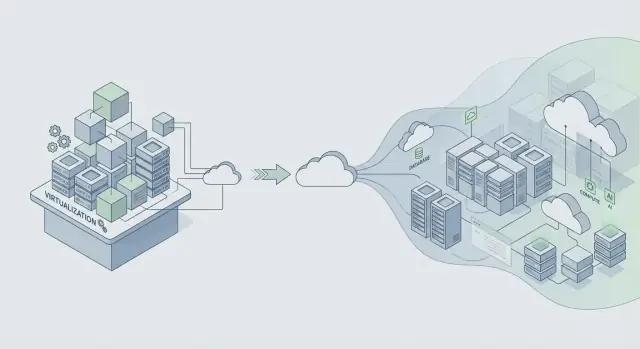

Diane Greene ร่วมก่อตั้ง VMware ในช่วงที่ไอทีองค์กรต้องแลกเปลี่ยนที่เจ็บปวด: เร่งไปข้างหน้าแลกกับความเสี่ยงการล่ม หรือต้องนิ่งและยอมรับการเปลี่ยนแปลงช้า VMware สำคัญเพราะทำให้เซิร์ฟเวอร์ทำงานเหมือนบล็อกก่อสร้างที่เชื่อถือได้ นั่นเปิดทางให้การรวมระบบ การอัปเกรดที่ปลอดภัย และการกู้คืนที่เร็วขึ้น โดยไม่ต้องให้ทีมแอปทุกทีมเขียนใหม่ทั้งหมด

สัญญาหลักขององค์กรนั้นเรียบง่าย: เสถียรภาพมาก่อน ฟีเจอร์ทีหลัง องค์กรต้องการความสามารถใหม่ แต่พวกเขาต้องการบนระบบที่ยังทำงานระหว่างการแพตช์ การปรับขนาด และความผิดพลาดตามปกติ เมื่อผลิตภัณฑ์กลายเป็นสิ่งสำคัญทางธุรกิจ “เราจะแก้สัปดาห์หน้า” กลายเป็นรายได้ที่สูญเสีย เส้นตายที่พลาด และปัญหาการปฏิบัติตามข้อกำหนด

การจำลองเสมือนคือเครื่องมือความน่าเชื่อถือเชิงปฏิบัติ ไม่ใช่แค่ประหยัดค่าใช้จ่าย มันสร้างขอบเขตการแยก หากงานหนึ่งล้มได้โดยไม่ทำให้เครื่องทั้งเครื่องลง มันยังทำให้อินฟราสตรัคเจอร์ทำซ้ำได้: ถ้าคุณสามารถสแนปช็อต โคลน และย้ายงานได้ คุณก็สามารถทดสอบการเปลี่ยนแปลงและกู้คืนได้เร็วกว่าตอนที่มีปัญหา

แนวคิดนี้ยังใช้ได้: ออกแบบเพื่อเปลี่ยนแปลงโดยไม่ต้องดาวน์สมมติว่าส่วนประกอบจะล้ม ความต้องการจะเปลี่ยน และการอัปเกรดจะเกิดขึ้นภายใต้โหลดจริง แล้วสร้างนิสัยที่ทำให้การเปลี่ยนแปลงปลอดภัย

วิธีอธิบายแนวคิดของ VMware แบบย่อคือ แยกความล้มเหลวเพื่อไม่ให้ปัญหาหนึ่งแพร่กระจาย มองการอัปเกรดเป็นเรื่องปกติ ทำให้การย้อนกลับเร็ว และเลือกพฤติกรรมที่คาดเดาได้มากกว่าทริคฉลาดๆ ความเชื่อมั่นถูกสร้างจากความน่าเชื่อถือที่น่าเบื่อ วันแล้ววันเล่า

ถ้าคุณกำลังสร้างบนแพลตฟอร์มสมัยใหม่ (หรือสร้างแอปด้วยเครื่องมืออย่าง Koder.ai) บทเรียนยังคงอยู่: ปล่อยฟีเจอร์เฉพาะวิธีที่คุณสามารถปรับใช้ มอนิเตอร์ และย้อนกลับได้โดยไม่ทำให้การดำเนินงานของลูกค้าพัง

จาก VMware สู่แพลตฟอร์มคลาวด์: สิ่งที่ยังคงเหมือนเดิม

VMware เติบโตในโลกซอฟต์แวร์แบบแพ็กเกจที่ “การปล่อย” เป็นเหตุการณ์ใหญ่ แพลตฟอร์มคลาวด์เปลี่ยนจังหวะเป็นการเปลี่ยนแปลงเล็กบ่อยครั้งซึ่งปลอดภัยขึ้นได้ แต่ก็ต่อเมื่อคุณควบคุมการเปลี่ยนแปลงได้

สิ่งคงที่: การเปลี่ยนแปลงคือความเสี่ยงความน่าเชื่อถืออันดับหนึ่ง

ไม่ว่าคุณจะปล่อยตัวติดตั้งกล่องหรือดีพลอยบนคลาวด์ ส่วนใหญ่เหตุการณ์ล่มเริ่มแบบเดียวกัน: การเปลี่ยนแปลงถูกนำลง ระบบสมมติที่ซ่อนอยู่พัง และรัศมีความเสียหายกว้างกว่าที่คาด การปล่อยบ่อยขึ้นไม่ลดความเสี่ยง มันเพิ่มโอกาสเมื่อไม่มีราวจับ

ทีมที่ขยายได้อย่างเชื่อถือได้สมมติว่าการปล่อยทุกครั้งอาจล้ม และสร้างระบบให้ล้มได้อย่างปลอดภัย

ตัวอย่างง่ายๆ: การเปลี่ยนดัชนีฐานข้อมูลที่ดู “ไม่เป็นไร” ในสเตจจิ้ง อาจเพิ่มความหน่วงการเขียนใน production ทำให้คิวขอทำงาน และทำให้ timeout ดูเหมือนข้อผิดพลาดเครือข่ายแบบสุ่ม การปล่อยบ่อยให้โอกาสคุณแนะนำความประหลาดใจแบบนี้ได้มากขึ้น

โครงสร้างพื้นฐานที่แชร์เปลี่ยนโหมดความล้มเหลว

แอปยุคคลาวด์มักให้บริการลูกค้าหลายรายบนระบบที่แชร์ การตั้งค่ามัลติเทนแนนต์นำปัญหาใหม่ที่ยังคงสอดคล้องกับหลักการเดียวกัน: แยกข้อผิดพลาด

ปัญหา noisy neighbor (การสไปกของลูกค้าหนึ่งชะลอคนอื่น) และการล้มแบบแชร์ (ดีพลอยไม่ดีกระทบทุกคน) เป็นเวอร์ชันสมัยใหม่ของ “บั๊กเดียวลากทั้งคลัสเตอร์ลง” การควบคุมคุ้นเคยกันดี แต่อยู่ในรูปแบบต่อเนื่อง: การปล่อยแบบค่อยเป็นค่อยไป การควบคุมต่อเทนแนนต์ ขอบเขตทรัพยากร (โควต้า, ขีดจำกัดการเรียก, timeout) และการออกแบบที่รับมือการล้มบางส่วนได้

การสังเกตการณ์ (observability) คือสิ่งคงที่อีกอย่าง คุณปกป้องความน่าเชื่อถือไม่ได้ถ้าคุณมองไม่เห็นสิ่งที่เกิดขึ้น บันทึก เมตริก และแทรซที่ดีช่วยให้คุณพบความถดถอยได้เร็ว โดยเฉพาะตอนปล่อย

การย้อนกลับก็ไม่ใช่การเคลื่อนไหวฉุกเฉินหายากอีกต่อไป แต่มันเป็นเครื่องมือปกติ ทีมหลายทีมจับคู่การย้อนกลับกับสแนปช็อตและขั้นตอนดีพลอยที่ปลอดภัย แพลตฟอร์มอย่าง Koder.ai รวมสแนปช็อตและการย้อนกลับ ซึ่งช่วยทีมยกเลิกการเปลี่ยนแปลงเสี่ยงได้เร็วขึ้น แต่ประเด็นสำคัญคือวัฒนธรรม: การย้อนกลับควรได้รับการฝึกฝน ไม่ใช่คิดขึ้นในเวลาวิกฤต

ตั้งเป้าความน่าเชื่อถือก่อนคุณจะขยาย

ถ้าคุณรอกำหนดความน่าเชื่อถือจนดีลองค์กรมา คุณจะโต้แย้งด้วยความรู้สึก: “ดูเหมือนจะโอเค” ลูกค้ารายใหญ่ต้องการคำสัญญาชัดเจนที่พวกเขาสามารถทำซ้ำภายในองค์กรได้ เช่น “แอปใช้งานได้” และ “หน้าเว็บโหลดเร็วพอตอนชั่วโมงพีค”

เริ่มด้วยชุดเป้าหมายสั้นๆ เขียนเป็นภาษาง่าย ทีมเล็กๆ สองทีมมักเห็นพ้องกันได้เร็วคือ ความพร้อมใช้งาน (บริการใช้งานได้บ่อยแค่ไหน) และเวลาในการตอบสนอง (การกระทำหลักรู้สึกเร็วแค่ไหน) ผูกเป้าหมายกับสิ่งที่ผู้ใช้ทำ ไม่ใช่เมตริกเซิร์ฟเวอร์ตัวเดียว

งบประมาณความผิดพลาดทำให้เป้าหมายใช้งานได้ในชีวิตประจำวัน มันคือปริมาณความล้มเหลวที่คุณ "ใช้จ่าย" ได้ในช่วงเวลาหนึ่งโดยยังคงรักษาคำสัญญา เมื่อยังอยู่ในงบ คุณสามารถรับความเสี่ยงการส่งมอบเพิ่มได้ เมื่อใช้จนหมด งานความน่าเชื่อถือต้องมาก่อนฟีเจอร์ใหม่

เพื่อให้เป้าหมายมีความน่าเชื่อถือ ติดตามสัญญาณไม่กี่อย่างที่สอดคล้องกับผลกระทบจริง: ความหน่วงของการกระทำหลัก, ข้อผิดพลาด (คำขอล้มเหลว, การแครช, ฟลว์พัง), ความอิ่มตัว (CPU, หน่วยความจำ, การเชื่อมต่อฐานข้อมูล, คิว), และความพร้อมใช้งานบนเส้นทางสำคัญแบบ end to end

เมื่อกำหนดเป้าหมายแล้ว ให้เป้าหมายนั้นเปลี่ยนการตัดสินใจ ถ้าการปล่อยเพิ่มอัตราข้อผิดพลาด ห้ามถกเถียง หยุด แก้ หรือย้อนกลับ

ถ้าคุณใช้แพลตฟอร์มโค้ดที่เน้นความเร็วอย่าง Koder.ai เป้าหมายยิ่งสำคัญ ความเร็วมีประโยชน์ก็ต่อเมื่อมันถูกจำกัดด้วยคำสัญญาความน่าเชื่อถือที่คุณรักษาได้

นิสัยเชิงสถาปัตยกรรมที่ปกป้องความน่าเชื่อถือเมื่อขยาย

การกระโดดความน่าเชื่อถือจาก “ใช้ได้สำหรับทีมเรา” เป็น “ใช้ได้สำหรับ Fortune 500” ส่วนใหญ่เกิดจากสถาปัตยกรรม การเปลี่ยนแนวคิดสำคัญคือ: สมมติว่าส่วนของระบบจะล้มในวันธรรมดา ไม่ใช่แค่ช่วงล่มใหญ่

ออกแบบเพื่อรับมือความล้มเหลวโดยทำให้การพึ่งพาเป็นตัวเลือกเมื่อทำได้ ถ้าผู้ให้บริการบิลลิ่ง อีเมล หรือพายป์ไลน์วิเคราะห์ช้า แอปแกนกลางของคุณควรยังโหลด ล็อกอิน และให้ผู้คนทำงานหลักได้

ขอบเขตการแยก (isolation boundaries) เป็นเพื่อนที่ดีที่สุดของคุณ แยกเส้นทางสำคัญ (ล็อกอิน เวิร์กโฟลว์หลัก การเขียนเข้าฐานข้อมูลหลัก) ออกจากฟีเจอร์เสริม (คำแนะนำ ฟีดกิจกรรม การส่งออก) เมื่อส่วนที่เป็นทางเลือกพัง มันควรล้มแบบปิดโดยไม่ลากแกนหลักลงมาด้วย

นิสัยไม่กี่อย่างป้องกันการแพร่กระจายของความล้มเหลวในทางปฏิบัติ:\n\n- ตั้ง timeout เข้มงวดในการเรียกเน็ตเวิร์คทุกครั้ง\n- retry เฉพาะการดำเนินการที่ปลอดภัยต่อการทำซ้ำ และใส่ jitter เพื่อลด retry storm\n- ใช้ circuit breaker เพื่อให้ dependency ล้มตัวหนึ่งไม่ใช้ worker หรือการเชื่อมต่อฐานข้อมูลทั้งหมด\n- ควบคุมโหลดด้วยคิวและ backpressure เพื่อให้การสไปกกลายเป็นการชะลอตัวไม่ใช่การล่ม\n- นิยม degradation อย่างละมุน: คืนผลบางส่วนพร้อมข้อความชัดเจน แทนการตอบ 500\n

ความปลอดภัยของข้อมูลคือที่ที่ “เราจะแก้ทีหลัง” กลายเป็นเวลาหยุดทำงาน แผนแบ็กอัพ การเปลี่ยนสคีมา และการกู้คืนเหมือนคุณจะต้องใช้จริง เพราะคุณจะต้องใช้จริง ฝึกการกู้คืนเหมือนฝึกหนีไฟ

ตัวอย่าง: ทีมหนึ่งส่งแอป React กับ API Go และ PostgreSQL ลูกค้าองค์กรใหม่อิมพอร์ต 5 ล้านเร็กคอร์ด หากไม่มีขอบเขต การอิมพอร์ตจะแข่งขันกับทราฟิกปกติและทุกอย่างช้าลง ด้วยเกราะป้องกันที่ถูกต้อง การอิมพอร์ตวิ่งผ่านคิว เขียนเป็นแบตช์ ใช้ timeout และ retry ที่ปลอดภัย และสามารถหยุดได้โดยไม่กระทบผู้ใช้ประจำ หากคุณสร้างบนแพลตฟอร์มอย่าง Koder.ai ให้ปฏิบัติเช่นเดียวกันกับโค้ดที่สร้างขึ้น: เพิ่มเกราะป้องกันเหล่านี้ก่อนที่ลูกค้าจริงจะพึ่งพามัน

การปฏิบัติการ: ส่วนที่หลายผลิตภัณฑ์เพิ่มช้าไป

เหตุการณ์ไม่ใช่หลักฐานว่าคุณล้มเหลว มันคือต้นทุนปกติของการรันซอฟต์แวร์จริงสำหรับลูกค้าจริง โดยเฉพาะเมื่อการใช้งานเพิ่มและการดีพลอยเกิดบ่อย ความต่างคือทีมของคุณตอบสนองอย่างสงบและแก้สาเหตุ หรือรีบและซ้ำรอยเดิมในเดือนหน้า

ช่วงเริ่มต้น ผลิตภัณฑ์หลายชิ้นพึ่งพาคนไม่กี่คนที่ “รู้” ว่าต้องทำอะไร องค์กรจะไม่ยอมรับแบบนั้น พวกเขาต้องการการตอบสนองที่คาดเดาได้ การสื่อสารที่ชัดเจน และหลักฐานว่าคุณเรียนรู้จากความล้มเหลว

ความพร้อม on-call (ก่อนที่คุณจะต้องใช้)

การ on-call ไม่ได้เกี่ยวกับฮีโร แต่เกี่ยวกับการตัดสินใจที่เดาได้เวลา 2 โมงเช้า การตั้งค่าที่เรียบง่ายครอบคลุมสิ่งที่ลูกค้าใหญ่สนใจส่วนใหญ่:\n\n- ตั้งเจ้าของหลักสำหรับแต่ละบริการ\n- เก็บรันบุ๊กสั้นสำหรับโหมดความล้มเหลวยอดนิยม\n- กำหนดการยกระดับ: โทรหาใคร, เมื่อไหร่, เร็วแค่ไหน\n- ฝึกอย่างน้อยหนึ่งครั้งที่เป็นการซ้อม\n- มีที่เดียวสำหรับตรวจสถานะปัจจุบันและการเปลี่ยนแปลงล่าสุด\n

การมอนิเตอร์ที่สำคัญ

ถ้าแจ้งเตือนดังทั้งวัน คนจะปิดเสียง และเหตุการณ์จริงจะถูกพลาด ผูกการแจ้งเตือนไปที่ผลกระทบต่อผู้ใช้: ล็อกอินล้ม, อัตราข้อผิดพลาดเพิ่ม, ความหน่วงข้ามเกณฑ์ชัดเจน, หรืองานแบ็กกราวด์ค้าง

หลังเหตุการณ์ ทำการทบทวนที่มุ่งไปที่การแก้ไขไม่ใช่โทษ จับภาพสิ่งที่เกิดขึ้น สัญญาณที่ขาด และเกราะป้องกันที่จะลดรัศมีความเสียหาย เปลี่ยนสิ่งนั้นเป็นการเปลี่ยนแปลง 1–2 อย่างที่จับต้องได้ มอบเจ้าของ และกำหนดวันเสร็จ

พื้นฐานการปฏิบัติการเหล่านี้คือตัวที่แยก “แอปที่ทำงานได้” ออกจากบริการที่ลูกค้าเชื่อถือได้

ขั้นตอนทีละขั้น: เสริมความแข็งแรงให้แอปของคุณสำหรับลูกค้าที่ใหญ่ขึ้น

ลูกค้ารายใหญ่ไม่ค่อยขอฟีเจอร์ใหม่เป็นอันดับแรก พวกเขาถามว่า “เราวางใจใช้งานนี้ใน production ได้ไหม ทุกวัน?” วิธีที่เร็วที่สุดในการตอบคือทำตามแผนเสริมความแข็งแรงและแสดงหลักฐาน ไม่ใช่คำสัญญา

แผนการเสริมความแข็งแรง 5 ขั้นตอนที่ใช้งานได้จริง

-

จดว่าคุณรองรับอะไรได้แล้วและขาดอะไรบ้าง เขียนความคาดหวังขององค์กรที่คุณรองรับจริงวันนี้ (เป้าหมาย uptime, การควบคุมการเข้าถึง, บันทึกการตรวจสอบ, การเก็บข้อมูล, ที่ตั้งข้อมูล, SSO, ชั่วโมงสนับสนุน) ติดป้ายแต่ละข้อว่า พร้อม, บางส่วน, หรือยังไม่พร้อม นี่จะเปลี่ยนแรงกดดันที่คลุมเครือเป็น backlog สั้นๆ

-

เพิ่มความปลอดภัยของการปล่อยก่อนจะปล่อยเพิ่ม องค์กรสนใจน้อยกว่าความถี่การดีพลอย แต่สนใจว่าคุณดีพลอยได้โดยไม่เกิดเหตุ ใช้สเตจที่สะท้อน production ใช้ feature flags สำหรับการเปลี่ยนแปลงเสี่ยง การปล่อยแบบ canary สำหรับการม้วนทีละน้อย และแผนการย้อนกลับที่ทำได้เร็ว ถ้าคุณสร้างบนแพลตฟอร์มที่รองรับสแนปช็อตและการย้อนกลับ (Koder.ai ทำได้) ฝึกการกู้คืนเวอร์ชันก่อนให้เป็นความเคยชิน

-

พิสูจน์การปกป้องข้อมูล แล้วพิสูจน์อีกครั้ง แบ็กอัพไม่ใช่แค่ติ๊กในช่อง ตั้งแบ็กอัพอัตโนมัติ กำหนดการเก็บ และรันเที่ยวการกู้คืนตามปฏิทิน เพิ่มบันทึกการตรวจสอบสำหรับการกระทำสำคัญ (การเปลี่ยนแปลงแอดมิน การส่งออกข้อมูล การแก้สิทธิ์) เพื่อให้ลูกค้าสืบสวนปัญหาและตอบข้อกำหนดการปฏิบัติตาม

-

เอกสารการสนับสนุนและการตอบเหตุการณ์เป็นภาษาง่าย เขียนคำสัญญาหน้าหนึ่ง: วิธีรายงานเหตุการณ์ เวลาตอบที่คาดไว้ ใครสื่อสารอัปเดต และวิธีการทำรายงานหลังเหตุการณ์

-

รันการทบทวนความพร้อมพร้อมแผนทดสอบโหลดที่สมจริง เลือกสถานการณ์แบบองค์กรหนึ่งกรณีแล้วทดสอบ end to end: ทราฟิกพีค, ฐานข้อมูลช้า, โหนดล้ม, และการย้อนกลับ ตัวอย่าง: ลูกค้าใหม่อิมพอร์ต 5 ล้านเร็กคอร์ดในเช้าวันจันทร์ขณะที่ 2,000 ผู้ใช้ล็อกอินและรันรายงาน วัดสิ่งที่พัง แก้อุปสรรคใหญ่ที่สุด แล้วทำซ้ำ

ทำ 5 ขั้นตอนนี้ การคุยเรื่องการขายจะง่ายขึ้นเพราะคุณแสดงงานที่ทำ ไม่ใช่การพูดเว้า

เรื่องเล่าจริงของการขยาย: ลูกค้าองค์กรใหม่รายหนึ่ง

แอป SaaS ขนาดกลางมีลูกค้าร้อยกว่ารายและทีมขนาดเล็ก แล้วเซ็นสัญญากับลูกค้าที่อยู่ในกลุ่มกฎระเบียบ: ธนาคารภูมิภาค ข้อตกลงรวมเป้าหมาย uptime เข้มงวด การควบคุมการเข้าถึงเข้ม และสัญญาว่าตอบคำถามด้านความปลอดภัยอย่างรวดเร็ว ฟีเจอร์หลักของผลิตภัณฑ์ไม่เปลี่ยน แต่กฎรอบการรันมันเปลี่ยน

ใน 30 วันแรก ทีมทำการอัปเกรดแบบ “มองไม่เห็น” ที่ลูกค้ายังรู้สึกได้ การมอนิเตอร์เปลี่ยนจาก “เรายังขึ้นไหม?” เป็น “อะไรพัง ที่ไหน และกระทบใคร?” พวกเขาเพิ่มแดชบอร์ดต่อบริการและตั้งการแจ้งเตือนที่ผูกกับผลกระทบต่อผู้ใช้ ไม่ใช่เสียงรบกวน CPU การควบคุมการเข้าถึงเป็นทางการขึ้น: การยืนยันตัวตนที่เข้มข้นขึ้นสำหรับการกระทำของแอดมิน บทบาทที่ทบทวน และการเข้าถึง production ที่บันทึกและจำกัดเวลา ความสามารถในการตรวจสอบกลายเป็นข้อกำหนดของผลิตภัณฑ์ด้วยบันทึกที่สม่ำเสมอสำหรับการล็อกอินล้ม การเปลี่ยนสิทธิ์ การส่งออกข้อมูล และการแก้ไขคอนฟิก

สองสัปดาห์ต่อมา การปล่อยผิดพลาด มิเกรชันฐานข้อมูลใช้เวลานานกว่าที่คาดและเริ่ม timeout คำขอสำหรับกลุ่มผู้ใช้ย่อย สิ่งที่ทำให้มันไม่กลายเป็นเหตุการณ์หลายวันคือวินัยพื้นฐาน: แผนการย้อนกลับที่ชัดเจน ผู้รับผิดชอบเหตุการณ์คนเดียว และสคริปต์การสื่อสาร

พวกเขาหยุดการม้วนปล่อย เปลี่ยนทราฟิกไปทางที่ไม่ช้า และย้อนกลับเป็นเวอร์ชันที่ทราบว่าดีล่าสุด ถ้าแพลตฟอร์มของคุณรองรับสแนปช็อตและการย้อนกลับ (Koder.ai ทำได้) เรื่องนี้จะเร็วกว่ามาก แต่คุณยังต้องมีขั้นตอนที่ฝึกฝน ในระหว่างการกู้คืน พวกเขาส่งอัปเดตสั้นทุก 30 นาที: อะไรได้รับผลกระทบ กำลังทำอะไร และเวลาตรวจครั้งถัดไป

หนึ่งเดือนต่อมา “ความสำเร็จ” ดูน่าเบื่อในทางที่ดีที่สุด การแจ้งเตือนน้อยลงแต่มีความหมาย Recovery เร็วขึ้นเพราะความเป็นเจ้าของชัดเจน: คนหนึ่ง on-call หนึ่งคนประสานงาน และหนึ่งคนสื่อสาร ธนาคารหยุดถามว่า “คุณควบคุมได้ไหม?” และเริ่มถามว่า “เมื่อไหร่เราจะขยายการใช้งานได้?”

กับดักทั่วไปที่ทำให้ความน่าเชื่อถือแย่ลงเมื่อโตขึ้น

การเติบโตเปลี่ยนกฎ ผู้ใช้มากขึ้น ข้อมูลมากขึ้น และลูกค้าขนาดใหญ่ทำให้ช่องว่างเล็กๆ กลายเป็นการล่ม เหตุการณ์เสียงดัง หรือเธรดซัพพอร์ตยาว หลายปัญหาเหล่านี้รู้สึกว่า “โอเค” จนกว่าสัปดาห์ที่คุณเซ็นสัญญารายใหญ่ครั้งแรก

กับดักที่พบบ่อยที่สุด:\n\n- ปล่อยเร็วโดยไม่มีปุ่มย้อนกลับที่ปลอดภัย ถ้าคุณย้อนกลับไม่ไดในไม่กี่นาที ทุกดีพลอยกลายเป็นเหตุการณ์ความเสี่ยงสูง ชะลอคุณและเพิ่มความเครียด\n- ทำให้ความน่าเชื่อถือเป็นแค่เรื่องของวิศวกร การล่มคือปัญหาของซัพพอร์ตและการสื่อสารด้วย หากซัพพอร์ตไม่มีอัปเดตสถานะชัดเจน การแก้ทางเทคนิคมาถึงสายเกินไปเพื่อปกป้องความเชื่อมั่น\n- เสียงแจ้งเตือนมากเกินไปจนคนเพิกเฉย ถ้าทุกอย่างเพจ ทั้งหมดจะไม่ฉุกเฉิน การตอบช้าลงเมื่อแจ้งเตือนที่สำคัญมาจริง\n- คิดว่าแบ็กอัพหมายความว่าคุณกู้คืนได้ แบ็กอัพพิสูจน์ข้อมูลถูกเก็บ ไม่ใช่คุณกู้คืนไว ถ้าคุณไม่เคยฝึกกู้คืน คุณไม่รู้เวลากู้คืนจริงของคุณ\n- ฟีเจอร์เฉพาะลูกค้าแบบ one-off ที่ทำให้แกนหลักอ่อนแอ พฤติกรรมพิเศษ ธงที่ซ่อนอยู่ และดีพลอยแบบพิเศษสะสม แต่ละข้อยกตัวอย่างเพิ่มผิวการทดสอบและทำให้การวินิจฉัยเหตุการณ์ยากขึ้น

ตัวอย่างง่าย: ทีมเพิ่มการผสานรวมเฉพาะสำหรับลูกค้ารายใหญ่และดีพลอยเป็นฮอตฟิกซ์วันศุกร์ดึก ไม่มีการย้อนกลับเร็ว การแจ้งเตือนรบกวนอยู่แล้ว และคน on-call ต้องเดา บั๊กเล็ก แต่การกู้คืนลากยาวหลายชั่วโมงเพราะเส้นทางการกู้คืนไม่เคยถูกทดสอบ

ถ้าเช็คลิสต์ความพร้อมของคุณมีแต่รายการเทคนิค ให้ขยายมัน รวมการย้อนกลับ การฝึกกู้คืน และแผนการสื่อสารที่ฝ่ายซัพพอร์ตสามารถรันได้โดยไม่ต้องมีวิศวกรในห้อง

เช็คลิสต์ความพร้อมสำหรับองค์กร (ตรวจสอบด่วน)

เมื่อผู้มีอำนาจถามว่า “คุณพร้อมสำหรับองค์กรไหม?” พวกเขามักถามเรื่องเดียว: เราไว้ใจให้สิ่งนี้รันใน production ได้ไหม? ใช้สิ่งนี้เป็นการตรวจสอบตนเองก่อนสัญญาใดๆ ในการคอลขาย

- ความน่าเชื่อถือและการจัดการเหตุการณ์ถูกกำหนด (ไม่ใช่สันนิษฐาน) คุณมีเป้าหมาย uptime และประสิทธิภาพที่ชัดเจน มอนิเตอร์พร้อมการแจ้งเตือน และกระบวนการเหตุการณ์ที่คนทำตามจริง\n\n- พื้นฐานความปลอดภัยบังคับใช้เป็นค่าเริ่มต้น การเข้าถึงเป็นแบบ least privilege การกระทำของแอดมินถูกบันทึก และคีย์/ความลับมีเจ้าของและแผนการหมุนเวียน\n\n- ข้อมูลสามารถกู้คืนได้โดยเจตนา ไม่ใช่โดยโชค แบ็กอัพทำงานอัตโนมัติ การกู้คืนถูกทดสอบตามตาราง และคุณอธิบายการย้ายสคีมาและนโยบายการเก็บแบบง่ายๆ ได้\n\n- การปล่อยถูกควบคุมและย้อนกลับได้ คุณสามารถทำ staged releases ย้อนกลับอย่างรวดเร็ว และมีกระบวนการอนุมัติที่เรียบง่าย (แม้เพียงบันทึกการเปลี่ยนแปลงและคนที่ตรวจ)\n\n- คำสัญญาการสนับสนุนตรงกับความเป็นจริง คุณมีกระบวนการสนับสนุน (รับเรื่อง, ประเมินความรุนแรง, เวลาตอบ) และเจ้าของการยกระดับที่ชัดเจน\n

ก่อนโชว์เดโม รวบรวมหลักฐานที่คุณชี้ให้ดูโดยไม่ต้องพูดเว้า: ภาพมอนิเตอร์ที่แสดงอัตราข้อผิดพลาดและความหน่วง, ตัวอย่างบันทึกการตรวจสอบที่ปกปิดข้อมูลบางส่วน (“ใครทำอะไร เมื่อไหร่”), หมายเหตุการกู้คืนแบบ redacted (คุณกู้คืนอะไรและใช้เวลานานเท่าไร), และบันทึกหนึ่งหน้าสำหรับการปล่อยและการย้อนกลับ

ถ้าคุณสร้างแอปบนแพลตฟอร์มอย่าง Koder.ai ให้ปฏิบัติตรวจสอบเหล่านี้เหมือนกัน เป้าหมาย หลักฐาน และนิสัยที่ทำซ้ำได้สำคัญกว่าตัวเครื่องมือที่คุณใช้

ขั้นตอนถัดไป: ทำให้ความพร้อมเป็นนิสัยที่ทำซ้ำได้

ความพร้อมสำหรับองค์กรไม่ใช่การผลักดันครั้งเดียวก่อนดีลใหญ่ จงปฏิบัติต่อมันเหมือนกิจวัตรที่ทำให้ผลิตภัณฑ์สงบภายใต้ความกดดัน แม้ทีม ทราฟิก และความคาดหวังลูกค้าจะเติบโต

แปลงเช็คลิสต์เป็นแผนงานสั้นๆ เลือก 3 ช่องว่างที่เสี่ยงที่สุด ทำให้มันมองเห็นได้ และมอบเจ้าของพร้อมวันที่จะทำจริง กำหนด "เสร็จ" เป็นคำง่ายๆ (เช่น "การแจ้งเตือนทริกเกอร์ภายใน 5 นาที" หรือ "กู้คืนทดสอบแบบ end to end") เก็บเลนเล็กๆ ใน backlog สำหรับบล็อกเกอร์องค์กรเพื่อไม่ให้งานด่วนกลบงานสำคัญ เมื่อปิดช่องว่าง จดสิ่งที่เปลี่ยนแปลงไว้เพื่อให้เพื่อนร่วมงานใหม่ทำซ้ำได้

สร้างเอกสารความพร้อมภายในหนึ่งฉบับที่คุณใช้กับลูกค้าองค์กรทุกเจ้า เก็บสั้น และปรับปรุงหลังการสนทนาลูกค้ารายสำคัญ รูปแบบง่ายๆ ทำงานได้ดี: เป้าหมายความน่าเชื่อถือ, พื้นฐานความปลอดภัย, การจัดการข้อมูล, การปล่อยและการย้อนกลับ, และใครอยู่ on-call

ทำการทบทวนความน่าเชื่อถือทุกเดือนที่ผูกกับเหตุการณ์จริง ไม่ใช่ความเห็น ใช้เหตุการณ์และเกือบพังเป็นวาระ: อะไรล้ม วิธีที่คุณตรวจพบ วิธีที่กู้คืน และอะไรจะหยุดการซ้ำ

ถ้าคุณสร้างด้วย Koder.ai ให้ฝังความพร้อมลงในการปล่อย ใช้ Planning Mode ตั้งแต่ต้นเพื่อร่างข้อกำหนดองค์กรก่อนผูกมัดการสร้าง และพึ่งพาสแนปช็อตและการย้อนกลับระหว่างการปล่อยเพื่อให้การแก้ปัญหาเป็นเรื่องความเครียดต่ำ เมื่อคุณต้องการที่เดียวในการรวมเวิร์กโฟลว์นั้น koder.ai ถูกออกแบบมาเพื่อสร้างและ iterate ผ่านแชท ในขณะเดียวกันก็ให้การควบคุมเชิงปฏิบัติอย่างการส่งออกซอร์สโค้ด การดีพลอย และการย้อนกลับอยู่ใกล้มือ