ความหมายของ “ต้นทุน เวลา และแรงเสียดทาน” ในงานซอฟต์แวร์

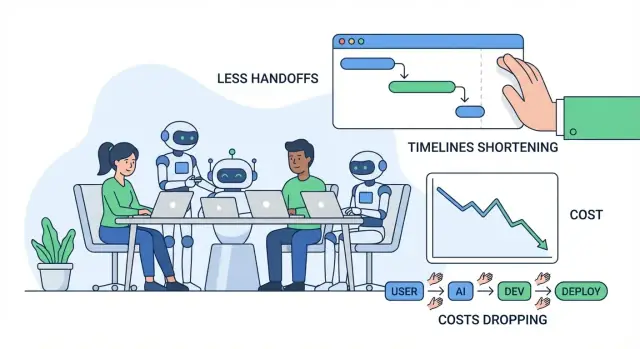

เมื่อคนพูดถึงการปรับปรุงการส่งมอบซอฟต์แวร์ มักหมายถึงสามเรื่อง: ต้นทุน, เวลา, และ แรงเสียดทาน ทั้งสามเชื่อมกันแต่ไม่เหมือนกัน—การนิยามให้ชัดก่อนพูดถึง AI ช่วยได้มาก

ต้นทุน: สิ่งที่คุณจ่ายเพื่อผลลัพธ์

ต้นทุน คือค่าใช้จ่ายโดยรวมที่จำเป็นในการส่งมอบและดูแลฟีเจอร์: เงินเดือน ชั่วโมงผู้รับจ้าง ค่าโฮสต์ เครื่องมือ และค่าใช้จ่ายที่ “ซ่อนอยู่” จากการประชุม การประสานงาน และการแก้ไขข้อผิดพลาด ฟีเจอร์ที่ใช้เวลานานขึ้นสองสัปดาห์ไม่ได้หมายถึงแค่ค่าแรงเพิ่มขึ้น—มันอาจเลื่อนรายได้ เพิ่มภาระซัพพอร์ต หรือต้องรันระบบเก่าไว้นานขึ้นด้วย

เวลา: ระยะเวลาจากไอเดียถึงคุณค่าที่ส่งมอบ

เวลา คือเวลาปฏิทินตั้งแต่ “เราควรสร้างนี่” จนถึง “ลูกค้าใช้งานได้อย่างเชื่อถือได้” รวมการพัฒนา การตัดสินใจ การอนุมัติ การรอรีวิว สภาพแวดล้อม ผลการ QA และการรอคำตอบจากคนที่มีบริบท

แรงเสียดทาน: แรงที่หายไปในความล่าช้า ความสับสน และการถูกขัดจังหวะ

แรงเสียดทาน คือแรงต้านในงานประจำวันที่ทำให้งานช้ากว่าที่ควรจะเป็น: ข้อกำหนดไม่ชัดเจน การโต้ตอบกลับไปกลับมา การสลับบริบท งานซ้ำซ้อน หรือการส่งต่องานระหว่างบทบาท/ทีม

ของเสียส่วนใหญ่ในโปรเจกต์ซอฟต์แวร์ปรากฏเป็น การส่งต่อ การทำซ้ำ และการรอ ความเข้าใจผิดเล็ก ๆ ตั้งแต่ต้นอาจกลายเป็นการออกแบบใหม่ การตามหาบั๊ก หรือการประชุมซ้ำ ๆ ต่อมา คิวรีวิวที่ช้าเอกสารที่ไม่ครบก็สามารถทำให้การทำงานติดขัดแม้ว่าทุกคนจะ “ยุ่ง” ก็ตาม

“เครื่องมือ AI” หมายถึงอะไร (และไม่ใช่อะไร)

ในบทความนี้ AI tools รวมถึง coding copilots, ผู้ช่วยแชทสำหรับการค้นคว้าและอธิบาย, การวิเคราะห์อัตโนมัติสำหรับข้อกำหนดและตั๋ว, ตัวช่วยสร้างการทดสอบ, และการอัตโนมัติเวิร์กโฟลว์ใน QA/DevOps

AI สามารถลดความพยายามและเร่งวงรอบได้—แต่ไม่ใช่การยกเลิกความรับผิดชอบ ทีมยังต้องมีความเป็นเจ้าของที่ชัดเจน การใช้วิจารณญาณ การควบคุมความปลอดภัย และการอนุมัติจากคนก่อนปล่อยของ

จุดที่โปรเจกต์ซอฟต์แวร์มักเสียเวลาและเงิน

การโอเวอร์รันส่วนใหญ่ไม่ได้มาจากการเขียนโค้ดที่ยาก แต่เกิดจากคอขวดประจำวันที่ทับซ้อนกัน: ข้อกำหนดไม่ชัดเจน การสลับบริบทบ่อย ๆ คิวรีวิวช้า และการทดสอบแมนนวลที่เกิดขึ้นช้าเกินไป

คอขวดทั่วไป (และทำไมมันแพง)

ข้อกำหนดไม่ชัดเจน สร้างต้นทุนที่ตามมามากที่สุด ความเข้าใจผิดเล็กน้อยตั้งแต่ต้นอาจกลายเป็นการทำซ้ำเป็นสัปดาห์ต่อมา—โดยเฉพาะเมื่อคนต่างกันตีความฟีเจอร์ไม่เหมือนกัน

การสลับบริบท เป็นฆาตกรเงียบของผลผลิต วิศวกรต้องกระโดดไปมาระหว่างตั๋ว คำถามในแชท การประชุม และปัญหาโปรดักชัน ทุกการสลับมีค่าเริ่มต้นใหม่: โหลดโค้ด ประวัติการตัดสินใจ และเหตุผลว่าทำไม

คิวรีวิวที่ช้า ไม่ได้แค่ชะลอการรวมโค้ด—แต่มันชะลอการเรียนรู้ หากคำติชมมาช้าหลายวัน ผู้เขียนอาจย้ายไปทำอย่างอื่นแล้ว และการแก้ไขก็ใช้เวลานานขึ้น

การทดสอบแมนนวลและ QA ที่มาช้า มักเจอปัญหาเมื่อต้นทุนในการแก้สูงที่สุด: หลังจากมีฟีเจอร์อื่นซ้อนกันหรือก่อนปล่อยผลิตภัณฑ์

ต้นทุนแฝงที่คนมักไม่งบประมาณ

ต้นทุนที่เห็นชัดคือเงินเดือนและบิลผู้ขาย ต้นทุนที่ซ่อนอยู่ส่งผลมากกว่า:

- การทำซ้ำ: เขียนโค้ดใหม่และออกแบบใหม่เพราะข้อกำหนดเปลี่ยนหรือเข้าใจผิด

- การล่าช้า: รอการตัดสินใจ อนุมัติ สภาพแวดล้อมทดสอบ หรือคนสำคัญตอบ

- ค่าใช้จ่ายในการประสานงาน: ซิงค์ระหว่างผลิตภัณฑ์ การออกแบบ วิศวกรรม QA ความปลอดภัย และผู้มีส่วนได้ส่วนเสีย

ไอเดียเรียบง่าย → เวิร์กโฟลว์การปล่อย (พร้อมจุดเจ็บ)

Idea → requirements → design → build → review → test → release → monitor

จุดเจ็บทั่วไป: requirements (กำกวม) build (ถูกขัดจังหวะ) review (คิว) test (งานแมนนวล) release (การส่งต่อ) monitor (การแก้ปัญหาช้า)

การวินิจฉัยด่วน: แผนที่แรงเสียดทาน

ลองทำ “friction map” ใน 30 นาที: ลิสต์แต่ละขั้น แล้วทำเครื่องหมาย (1) ที่งานรอ (2) ที่การตัดสินใจติด (3) ที่การทำซ้ำเกิดขึ้น บริเวณที่ทำเครื่องหมายคือจุดที่ AI มักสร้างการประหยัดได้เร็ว—โดยลดความเข้าใจผิด เร่งคำติชม และตัดงานแมนนวลซ้ำ ๆ

การค้นพบและข้อกำหนดด้วย AI: ลดความเข้าใจผิด

การค้นพบเป็นจุดที่โปรเจกต์หลายอันค่อย ๆ เลี้ยวผิดทาง: โน้ตกระจัดกระจาย ฟีดแบ็กขัดแย้ง และการตัดสินใจอยู่ในหัวคน AI ไม่สามารถแทนการคุยกับผู้ใช้ได้ แต่ช่วยลดการสูญเสียจากการแปลความระหว่างการสนทนา เอกสาร และสิ่งที่วิศวกรสร้างได้

เปลี่ยนอินพุตที่ยุ่งเป็นข้อกำหนดที่ใช้ได้

ทีมมักเก็บงานวิจัยเป็นกอง—ทรานสคริปต์การสัมภาษณ์ ตั๋วซัพพอร์ต ข้อความจากการโทรขาย คำตอบแบบสำรวจ—แล้วลำบากในการสกัดรูปแบบอย่างรวดเร็ว เครื่องมือ AI ช่วยได้โดย:

- สรุปโน้ตยาว ๆ เป็น takeaway ที่สม่ำเสมอ (ปัญหา เป้าหมาย ข้อคัดค้าน)

- จัดกลุ่มฟีดแบ็กเป็นธีม (เช่น ความสับสนใน onboarding vs การขาดการเชื่อมต่อ)

- ร่าง user stories แรกเริ่มและ jobs-to-be-done จากอินพุตดิบ

สิ่งนี้ไม่สร้างความจริงอัตโนมัติ แต่สร้างจุดเริ่มต้นที่ชัดเจนกว่าให้วิจารณ์ ปรับ และทำให้ทีมเห็นพ้อง

กำหนดขอบเขตและเกณฑ์การยอมรับให้เร็วยิ่งขึ้น

ความเข้าใจผิดมักปรากฏทีหลังเป็นงานแก้ “ไม่ใช่สิ่งที่ฉันหมายถึง” AI ช่วยโดยผลิตร่างแรกอย่างรวดเร็วของ:

- ขอบเขต (อะไรเข้า/ออกในรีลีสนี้)

- กรณีขอบข่ายและ “แล้วถ้า…” ตามรูปแบบที่คล้ายกัน

- เกณฑ์การยอมรับที่เฉพาะพอสำหรับการทดสอบ

ตัวอย่าง: ถ้าข้อกำหนดบอกว่า “ผู้ใช้ส่งออกรายงานได้” AI สามารถกระตุ้นให้ทีมชี้ชัด: รูปแบบไฟล์ (CSV/PDF) สิทธิ์ วันที่ ช่วงเวลา พฤติกรรมโซนเวลา และการส่งออกจะถูกอีเมลหรือดาวน์โหลด การตอบคำถามเหล่านี้แต่ต้นจะลดการสลับซ้ำในพัฒนาและ QA

เอกสารที่สม่ำเสมอและถูกใช้งานจริง

เมื่อข้อกำหนดแพร่หลายอยู่ในเอกสาร แชท และตั๋ว ทีมต้องจ่าย “ค่าภาษีสลับบริบท” ตลอดเวลา AI ช่วยรักษาเรื่องราวเดียวที่อ่านง่ายได้โดยร่างและดูแล:

- สรุปการประชุมพร้อมการตัดสินใจและคำถามค้าง

- เอกสารข้อกำหนดและคำอธิบายตั๋วในเทมเพลตเดียวกัน

- คำศัพท์เฉพาะโดเมน (เพื่อไม่ให้คำว่า “account”, “workspace”, “org” สับสน)

ผลตอบแทนคือการรบกวนน้อยลง (“เราตัดสินใจอะไรไปแล้ว?”) และการส่งต่องานระหว่างผลิตภัณฑ์ การออกแบบ วิศวกรรม และ QA ที่ราบรื่นขึ้น

การตั้งกรอบ: ตรวจสอบสมมติฐาน อย่าเอาออกจากทีม

ผลลัพธ์จาก AI ควรถูกถือเป็นสมมติฐาน ไม่ใช่ข้อกำหนด ดำเนินการด้วยกรอบง่าย ๆ:

- ตรวจสอบสรุปกับแหล่งข้อมูลต้นทางเสมอ (โดยเฉพาะคำพูดและตัวเลข)

- ทำเครื่องหมายรายการที่ไม่แน่นอนเป็นคำถาม แล้วยืนยันกับผู้ใช้และผู้มีส่วนได้ส่วนเสีย

- ให้ทีมเป็นเจ้าของการตัดสินใจ: AI ร่าง คนอนุมัติ

เมื่อใช้แบบนี้ การค้นพบที่ได้รับความช่วยเหลือจาก AI ลดความเข้าใจผิดโดยไม่ลดทอนความรับผิดชอบ—ช่วยลดต้นทุน เวลา และแรงเสียดทานก่อนจะเขียนโค้ดบรรทัดเดียว

การสร้างต้นแบบและการวนออกแบบที่เร็วขึ้นด้วย AI

การสร้างต้นแบบเป็นจุดที่หลายทีมประหยัดเวลาได้หลายสัปดาห์—หรือเผามันไป AI ทำให้สำรวจไอเดียได้ถูกลง จึงยืนยันได้ว่าผู้ใช้ต้องการอะไรจริง ๆ ก่อนทุ่มเวลาเอ็นจิเนียริ่งเต็มรูปแบบ

ร่างแรกอย่างรวดเร็วสำหรับหน้าจอและฟลो

แทนที่จะเริ่มจากหน้าว่าง คุณสามารถใช้ AI สร้าง:

- ข้อความ UI สำหรับปุ่ม ข้อความแสดงข้อผิดพลาด ขั้นตอน onboarding และ empty states (เลือกโทนเช่น “เป็นมิตร” หรือ “เป็นทางการ”)

- ไอเดีย wireframe ในรูปแบบคำอธิบายหน้าจอง่าย ๆ (มีอะไรบนหน้า อะไรเป็นหลัก/รอง)

- ตัวอย่าง user journeys: “ผู้ใช้ใหม่สมัคร → นำเข้าข้อมูล → ตั้งเป้าหมาย → ได้รับการเตือน”

ร่างเหล่านี้ไม่ใช่งานออกแบบสุดท้าย แต่ให้สิ่งเป็นรูปธรรมให้ทีมโต้ตอบ ลดการโต้เถียงแบบ “ฉันคิดว่าคุณหมายถึง X” หรือ “กระบวนการยังไม่ตรงกัน”

แอปเดโมและ POC อย่างรวดเร็ว

สำหรับการตัดสินใจหลายอย่าง คุณไม่จำเป็นต้องมีโค้ดคุณภาพโปรดักชันเพื่อเรียนรู้ AI ช่วยประกอบแอปเดโมหรือ proof-of-concept (POC) พื้นฐานที่แสดง:

- การโต้ตอบหลัก (ผู้ใช้คลิกอะไร เห็นอะไรต่อไป)

- ข้อมูลตัวอย่างและกรณีขอบเขตที่สมจริง

- “happy path” พื้นฐานที่พอใช้สำหรับการรีวิวภายในหรือสัมภาษณ์ผู้ใช้

ถ้าต้องการก้าวต่อจากม็อคอัพนิ่ง ๆ แพลตฟอร์มแบบ vibe-coding อย่าง Koder.ai อาจมีประโยชน์สำหรับการวนซ้ำเร็ว: คุณอธิบายฟีเจอร์ในอินเทอร์เฟซแชท สร้างร่างเว็บหรือมือถือที่ใช้งานได้ (มักเป็น React บนเว็บ และ Flutter บนมือถือ) แล้วปรับกับผู้มีส่วนได้ส่วนเสียก่อนตกลงทำวงรอบวิศวกรรมเต็ม

เวลาที่ประหยัดจริง ๆ มาจากไหน

การประหยัดใหญ่ไม่ได้มาจาก “เวลาการออกแบบ” แต่จากการหลีกเลี่ยงการสร้างสิ่งที่ผิด เมื่อต้นแบบเผยความสับสน ขั้นตอนที่ขาด หรือคุณค่าไม่ชัดเจน คุณสามารถปรับทิศทางในช่วงที่การเปลี่ยนแปลงยังถูกได้

คำเตือนสำคัญ: อย่าส่งโค้ดต้นแบบเป็นโปรดักชันโดยไม่ตั้งใจ

โค้ดต้นแบบที่สร้างโดย AI มักข้ามการทำความสะอาดสำคัญ: การตรวจสอบความปลอดภัย การเข้าถึงสำหรับผู้พิการ ประสิทธิภาพ การจัดการข้อผิดพลาด และโครงสร้างที่ง่ายต่อการบำรุงรักษา ถือว่าโค้ดต้นแบบเป็น disposable เว้นแต่คุณตั้งใจ harden มัน—ถ้าต้องแปลงต้นแบบเป็นฟีเจอร์จริง ให้มีเวิร์กโฟลว์ที่ทำให้การเปลี่ยนชัดเจน (เช่น โหมดวางแผน, snapshots, rollback) เพื่อให้ทีมเคลื่อนไหวเร็วโดยไม่เสียการติดตาม

การเขียนโค้ดเร็วขึ้นด้วยผู้ช่วย AI (และจุดที่ช่วยได้มากที่สุด)

ผู้ช่วยโค้ดมีค่าสูงสุดในงานที่ไม่น่าตื่นเต้น: จาก “ไม่มีอะไร” ไปสู่จุดเริ่มต้นที่ทำงานได้ และการลบงานซ้ำที่ชะลอทีม พวกมันไม่แทนการตัดสินใจเชิงวิศวกรรม แต่ย่นเวลาให้ไอเดียไปถึง pull request ที่พร้อมตรวจได้เร็วขึ้น

ลดเวลาเริ่มจากหน้าว่างอย่างไร

เมื่อเริ่ม endpoint ใหม่ job หรือ UI flow ชั่วโมงแรกมักใช้ไปกับการเดินสาย ตั้งชื่อ และคัดลอกรูปแบบจากโค้ดเก่า ผู้ช่วยสามารถร่างโครงสร้างเริ่มต้นได้เร็ว: โฟลเดอร์ ฟังก์ชันพื้นฐาน การจัดการข้อผิดพลาด การล็อก และเทสต์แทนที่ ทำให้วิศวกรใช้เวลามากขึ้นกับตรรกะผลิตภัณฑ์และกรณีขอบเขต น้อยลงกับโค้ดบอยเลอร์

สำหรับทีมที่อยากได้มากกว่า “ช่วยใน editor” แพลตฟอร์มอย่าง Koder.ai ห่อหุ้มสิ่งนี้เป็นเวิร์กโฟลว์เต็ม: จากสเปคในแชทถึงแอปที่รันได้พร้อมส่วนแบ็กเอนด์ (บ่อยครั้ง Go + PostgreSQL) พร้อมตัวเลือกเช่น export โค้ดและการดีพลอย ประโยชน์ปฏิบัติคือการลดต้นทุนประสานงานของการ “ไปให้ถึงสิ่งที่ตรวจได้”

งานที่เหมาะที่สุด (ช่วยได้ชัด)

งานที่มีแบบแผนและขอบเขตกระชับ จะได้ประโยชน์มาก โดยเฉพาะเมื่อโค้ดเบสมีคอนเวนชันชัดเจน:

- Scaffolding: routes/controllers ใหม่ หน้าจอ CRUD คำสั่ง CLI งานแบคกราวด์ SDK wrappers

- Refactors: เปลี่ยนชื่อและจัดระเบียบโมดูล แยกฟังก์ชัน นำการจัดการข้อผิดพลาดไปใช้ร่วมกัน อัปเดต API ที่เลิกใช้

- Translations: พอร์ตคอมโพเนนต์เล็ก ๆ ข้ามภาษา/เฟรมเวิร์ก (เช่น Python → TypeScript) พร้อมเทสต์ยืนยันพฤติกรรม

- ฟีเจอร์เล็กๆ: เพิ่มฟังก์ชันขนาดจำกัดเช่นตัวกรอง การส่งออก webhook handler หรือกฎการตรวจสอบ

- เครื่องมือภายใน: หน้าผู้ดูแล สคริปต์ แก้ข้อมูล รายงาน—มีมูลค่าสูง UX ไม่ต้องเนี้ยบ

รูปแบบพรอมท์ที่ให้โค้ดใช้ได้จริง

พรอมท์ที่ดีมีลักษณะเหมือนมินิสเปค ไม่ใช่ “เขียนฟีเจอร์ X” ให้รวม:

- บริบท: โมดูลทำอะไร อยู่ที่ไหน API รอบข้างเป็นอย่างไร

- เงื่อนไขจำกัด: ไลบรารี กฎสไตล์ ความต้องการประสิทธิภาพ ความปลอดภัย

- ตัวอย่าง: ไฟล์ที่คล้ายกันหรือตัวอย่าง input/output

- เทสต์การยอมรับ: กรณีขอบเขตและเช็กว่า “เสร็จหมายถึง…”

Add a /v1/invoices/export endpoint.

Context: Node/Express, uses InvoiceService.list(), auth middleware already exists.

Constraints: stream CSV, max 50k rows, no PII fields, follow existing error format.

Example: match style of routes/v1/customers/export.ts.

Acceptance: returns 401 if unauthenticated; CSV has headers A,B,C; handles empty results.

การตรวจทานเป็นเรื่องที่ต้องทำ

โค้ดที่สร้างด้วย AI ยังคงต้องมีมาตรฐานเหมือนเดิม: code review, security review, และเทสต์ ผู้พัฒนายังคงรับผิดชอบความถูกต้อง การจัดการข้อมูล และการปฏิบัติตามข้อบังคับ—ถือผู้ช่วยเป็นร่างเร็ว ไม่ใช่ผู้เชี่ยวชาญ

ลดวงจรการรีวิวและการทำซ้ำด้วย AI

การรีวิวโค้ดเป็นแหล่งที่ต้นทุนแอบแฝงสะสม: การรอคำติชม อธิบายเจตนาใหม่ และแก้ปัญหาแบบเดิมซ้ำ ๆ AI ไม่สามารถแทนการตัดสินใจของรีวิวเวอร์ได้ แต่ลดเวลาที่ใช้กับการเช็กเชิงกลและความเข้าใจผิดได้

AI ช่วยในการรีวิวโค้ดอย่างไร

เวิร์กโฟลว์ AI ที่ดีสนับสนุนรีวิวเวอร์ก่อนจะเปิด PR:

- สรุปการเปลี่ยนแปลง: สร้างสรุปเป็นภาษาง่าย ๆ ว่า PR ทำอะไร ไฟล์ไหนเปลี่ยน และพฤติกรรมที่ตั้งใจไว้ ช่วยรีวิวเวอร์โฟกัสเร็วขึ้นและลดคอมเมนต์แบบ “ฉันดูอะไรอยู่?”

- เตือนรูปแบบเสี่ยง: ชี้จุดบั๊กที่พบบ่อย—การขาดเช็ก null การแยกพารามิเตอร์สายสตริงที่ไม่ปลอดภัย ลอจิกเวลาที่ไม่แน่นอน ข้อผิดพลาดที่ไม่ได้จัดการ หรือการเปลี่ยนสิทธิ์ที่น่าสงสัย

- แนะนำเทสต์: แนะนำเคสเทสต์จาก diff (“เพิ่มเทสต์สำหรับ input ไม่ถูกต้อง” “ตรวจสิทธิ์สำหรับ role X” “ครอบคลุมกรณีขอบเขตในการแบ่งหน้า”)

ลดการส่งกลับไปกลับมาน้อยลง

AI ยังช่วยปรับความชัดเจนและความสม่ำเสมอ ซึ่งเป็นปัจจัยหลักที่ทำให้รีวิวเด้งกลับ:

- ร่างคำอธิบาย PR ที่ดีกว่า (แรงจูงใจ แนวทาง ข้อแลกเปลี่ยน)

- บังคับความสอดคล้องในการตั้งชื่อและฟอร์แมตเพื่อลดข้อโต้แย้งเชิงอัตนัย

- เสนอ refactor เล็ก ๆ ที่ทำให้โค้ดอ่านง่ายขึ้นเพื่อลดคำขอ rewrite ขนาดใหญ่

กฎปฏิบัติที่ปลอดภัย

ใช้ AI เพื่อเร่งรีวิวโดยไม่ลดมาตรฐาน:

- ต้องมีการอนุมัติจากคน สำหรับทุก PR

- ปรับคำแนะนำของ AI ให้สอดคล้องกับ style guide และ lint rules ของทีม

- เก็บ PR ให้ เล็กและชัดเจน เพื่อให้ทั้งคนและ AI ตัดสินใจได้ง่าย

จุดที่ AI ยังทำได้ไม่ดี

AI อ่อนแอที่สุดใน ตรรกะโดเมน และ สถาปัตยกรรม: กฎธุรกิจ กรณีขอบเขตที่ผูกกับผู้ใช้จริง และการแลกเปลี่ยนระดับระบบ ยังคงต้องการวิจารณญาณจากผู้มีประสบการณ์ จงถือ AI เป็นผู้ช่วย ไม่ใช่รีวิวเวอร์

AI ในการทดสอบและ QA: จับปัญหาตั้งแต่ต้นด้วยงานแมนนวลน้อยลง

การทดสอบคือจุดที่ความเข้าใจผิดเล็ก ๆ กลายเป็นเซอร์ไพรส์ที่แพง AI ไม่รับประกันคุณภาพ แต่ลดงานซ้ำ ๆ ได้มาก—ทำให้คนมีเวลามากขึ้นกับเคสที่ซับซ้อนจริง ๆ

การสร้างเทสอัตโนมัติ: เริ่มจากเส้นทางโค้ดจริง

เครื่องมือ AI สามารถเสนอ unit tests โดยอ่านโค้ดที่มีอยู่และระบุเส้นทางการทำงานทั่วไป ("happy path") รวมถึงสาขาที่มักลืม (การจัดการข้อผิดพลาด ค่า null/ค่าว่าง retry timeout) ถ้าคุณให้สเปคสั้น ๆ หรือเกณฑ์การยอมรับ AI จะเสนอกรณีขอบเขตจากข้อกำหนดโดยตรง—เช่น ค่าขอบเขต รูปแบบไม่ถูกต้อง การเช็คสิทธิ์ และ “ถ้าบริการภายนอกล้ม?”

การใช้ที่ดีที่สุดคือเร่งร่างเทสต์ให้เร็ว แล้วให้วิศวกรปรับ assertion ให้ตรงกับกฎธุรกิจจริง

ข้อมูลทดสอบ mocks และ fixtures ที่เร็วยิ่งขึ้น

แหล่งเสียเวลาที่คาดไม่ถึงใน QA คือการเตรียมข้อมูลทดสอบและเดินสายม็อก AI ช่วยได้โดย:

- สร้างเรคคอร์ดตัวอย่างที่เป็นตัวแทน (รวมกรณี “ประหลาด”) ตามกฎการตรวจสอบ

- เขียนม็อก/สตับสำหรับบริการภายนอกที่ตอบแบบคาดเดาได้

- สร้าง fixtures ที่นำกลับมาใช้ซ้ำได้ ทำให้เทสต์สั้นลงและอ่านง่ายขึ้น

สิ่งนี้เร่งทั้ง unit tests ที่นักพัฒนาสร้างและ integration tests โดยเฉพาะเมื่อมี API หลายตัว

รายงานบั๊กที่ชัดเจน: แก้เร็วยิ่งขึ้น

เมื่อปัญหาไหลไปถึง QA หรือโปรดักชัน AI ช่วยปรับรายงานบั๊กให้เป็นขั้นตอนการทำซ้ำที่มีโครงสร้าง และแยก expected vs actual ให้ชัดเจน หากมีล็อกหรือคอนโซลเอาต์พุต AI สรุปรูปแบบ (จุดที่ล้มแรกสุด อะไรเกิดซ้ำ อะไรสัมพันธ์กับความล้มเหลว) ทำให้วิศวกรไม่ต้องใช้ชั่วโมงแรกแค่อ่านรายงาน

การควบคุมคุณภาพ (ที่ต้องมี)

เทสต์ที่สร้างด้วย AI ต้องยังคง:

- มีความหมาย: assertion ผูกกับข้อกำหนดจริง ไม่ใช่แค่ “รันแล้วไม่พัง”

- มีความคงที่: ไม่มีความล้มเหลวเพราะเวลา โซนสุ่ม หรือพึ่งพาภายนอกไม่เสถียร

- ได้รับการบำรุงรักษา: ปฏิบัติเหมือนโค้ดโปรดักชัน—ถูกตรวจ ทื่อชื่อดี และอัปเดตเมื่อพฤติกรรมเปลี่ยน

ใช้แบบนี้ AI ลดงานแมนนวลและช่วยทีมจับปัญหาให้เร็วกว่าที่จะกลายเป็นค่าใช้จ่ายแพง

การปล่อยและการปฏิบัติการ: รอให้น้อยลง แก้ปัญหาได้เร็วขึ้น

งานปล่อยคือที่ที่ "ความล่าช้าเล็ก ๆ" ทับซ้อนกัน: pipeline ที่ไม่เสถียร ข้อผิดพลาดที่ไม่ชัด ค่าคอนฟิกขาด หรือการส่งต่อล่าช้า AI ช่วยย่นเวลาได้ระหว่าง "มีปัญหา" ถึง "รู้ว่าจะทำอะไรต่อ"

AI สำหรับ CI/CD และ DevOps

ระบบ CI/CD สมัยใหม่สร้างสัญญาณมากมาย (ล็อก build เอาต์พุตเทสต์ เหตุการณ์การดีพลอย) AI สรุปสัญญาณเหล่านั้นเป็นมุมมองสั้น ๆ ที่ลงมือทำได้: อะไรพัง ที่แรกที่มันปรากฏ และอะไรเปลี่ยนไปล่าสุด

AI ยังชี้การแก้ไขที่เป็นไปได้ตามบริบท—เช่น ชี้ความไม่ตรงกันของเวอร์ชันใน Docker ขั้นตอนเรียงผิดลำดับในเวิร์กโฟลว์ หรือขาด environment variable—โดยไม่ต้องไล่ดูหลักร้อยบรรทัดด้วยตา

ถ้าคุณใช้แพลตฟอร์ม end-to-end เช่น Koder.ai สำหรับการสร้างและโฮสต์ คุณลักษณะการปฏิบัติการอย่าง snapshots และ rollback จะลดความเสี่ยงในการปล่อย: ทีมสามารถทดลอง ดีพลอย และยกเลิกได้อย่างรวดเร็วเมื่อความเป็นจริงต่างจากแผน

สนับสนุนเหตุการณ์: สมมติฐานและเช็คลิสต์ที่เร็วขึ้น

ในเหตุการณ์ ความเร็วสำคัญที่สุดใน 15–30 นาทีแรก AI ช่วยได้โดย:

- ร่างสมมติฐานสาเหตุหลักจากล็อก การแจ้งเตือน และการดีพลอยล่าสุด

- สร้างเช็คลิสต์การแก้ไข (rollback ปิดฟีเจอร์ เพิ่มสเกล ล้างคิว ยืนยันการเชื่อม DB)

- เสนอคำสั่งและคิวรีที่ตรงจุดเพื่อตรวจหรือปฏิเสธแต่ละสมมติฐาน

สิ่งนี้ลดภาระ on-call โดยเร่งการไตรเอจ—ไม่ใช่แทนคนที่เป็นเจ้าของบริการ ความเป็นเจ้าของ การตัดสินใจ และความรับผิดชอบยังอยู่กับทีม

หมายเหตุความปลอดภัย (อย่าข้าม)

AI มีประโยชน์เมื่อใช้ปลอดภัย:

- อย่าแปะความลับ (API keys โทเค็น ข้อมูลลูกค้า) ลงในพรอมท์—ใช้การลบข้อมูลและการเข้าถึงแบบ least-privilege

- ถือ output ของ AI เป็นคำแนะนำ ไม่ใช่การเปลี่ยนแปลงโดยตรง การตรวจสอบโค้ด การอนุมัติ และการจัดการการเปลี่ยนแปลงยังต้องมี

- เลือกเครื่องมือที่ทำงานกับล็อกที่ถูกทำความสะอาดและมี audit trails เพื่อการปฏิบัติตามข้อกำหนด

เอกสารและการแบ่งปันความรู้: หยุดการหยุดชะงักและการส่งต่อ

เอกสารที่ดีเป็นวิธีถูกที่สุดวิธีหนึ่งในการลดแรงเสียดทานวิศวกรรม—แต่มักเป็นสิ่งแรกที่ถูกละทิ้งเมื่อเส้นตายใกล้ AI ช่วยโดยเปลี่ยนงานเอกสารจากงาน "ทีหลัง" ให้เป็นส่วนเล็ก ๆ ที่ทำซ้ำได้ในงานประจำ

สิ่งที่ AI เร่งได้ (โดยไม่ยกเลิกความเป็นเจ้าของ)

ทีมมักเห็นผลเร็วในเอกสารที่มีแพทเทิร์นชัดเจน:

- เอกสาร API: สร้างคำอธิบาย endpoint ตัวอย่าง request/response และตารางข้อผิดพลาดจากสเปคหรือคอมเมนต์โค้ดที่มีอยู่

- Runbooks: ร่าง playbook เหตุการณ์ทีละขั้นจากตั๋วและ postmortem ก่อนหน้า

- Changelogs และ release notes: สรุป PR ที่ merged เป็นเวอร์ชันสำหรับลูกค้าและภายใน

- คู่มือการเริ่มต้น: สร้าง checklist สัปดาห์แรก ภาพรวมบริการ และหน้า glossary จากโครงสร้าง repo และเอกสารที่มี

กุญแจคือ AI ผลิตร่างแรกที่แข็งแรง คนยืนยันสิ่งที่จริง ปลอดภัยแชร์ และสำคัญ

รบกวนน้อยลง คอขวดน้อยลง

เมื่อเอกสารค้นหาได้และปรับปรุงอยู่ คนจะใช้เวลาตอบคำถามซ้ำ ๆ น้อยลง เช่น “คอนฟิกอยู่ที่ไหน?” หรือ “รันโปรเจกต์นี้ยังไงในเครื่อง?” สิ่งนี้ลดการสลับบริบท ปกป้องเวลาจดจ่อ และป้องกันความรู้ติดอยู่กับคนเดียว

เอกสารที่ดูแลดีช่วยลดการส่งต่อ: สมาชิกใหม่ QA ซัพพอร์ต และผู้มีส่วนได้ส่วนเสียที่ไม่ใช่เทคนิคสามารถหาคำตอบเองแทนรอวิศวกร

เวิร์กโฟลว์ปฏิบัติที่ใช้ได้จริง

รูปแบบง่าย ๆ ใช้ได้กับหลายทีม:

- สร้างอัปเดตเอกสารจาก PRs (สรุป + อะไรเปลี่ยน + วิธีทดสอบ)

- คนแก้และยืนยัน (ความถูกต้อง ความปลอดภัย ความเหมาะสมของผู้ชม)

- เก็บเอกสารเวอร์ชันใน repo ร่วมกับโค้ด เพื่อให้การเปลี่ยนมีการตรวจและปล่อยพร้อมกัน

ความเข้าใจสำหรับผู้อ่านที่ไม่ใช่เทคนิค

AI สามารถเขียนโน้ตหนาแน่นให้เป็นภาษาที่ชัดเจน แบ่งหัวข้ออย่างสม่ำเสมอ และมาตรฐานโครงสร้าง ทำให้เอกสารใช้งานได้เกินกว่าวิศวกร—โดยไม่ขอให้วิศวกรกลายเป็นนักเขียนมืออาชีพ

การวัด ROI: วิธีคำนวณการประหยัดแบบไม่เดา

ROI เบลอเมื่อคุณถามแค่ว่า “เราปล่อยเร็วขึ้นไหม?” วิธีที่ดีกว่าคือกำหนดราคาในตัวขับเคลื่อนต้นทุนที่ AI แตะต้อง แล้วเปรียบเทียบ baseline กับรันที่มี AI สำหรับเวิร์กโฟลว์เดียว

แม็ปตัวขับเคลื่อนต้นทุนจริงของคุณ

เริ่มด้วยการลิสต์บัคเก็ตที่ทีมคุณจริงจังกับมัน:

- ชั่วโมงวิศวกรรม: สร้าง รีวิว ทดสอบ แก้ไข ทำซ้ำ

- ค่าใช้จ่ายคลาวด์: สภาพแวดล้อมที่รันอยู่ไปเรื่อย ๆ pipeline ช้า การรันเทสต์ซ้ำ

- ค่าสมัครเครื่องมือ: seat ของ AI เครื่องมือทดสอบ การมอนิเตอร์ การออกแบบ

- ภาระซัพพอร์ต: การตอบเหตุการณ์ การคัดแยกบั๊ก ตั๋วลูกค้า

- ต้นทุนการล่าช้า: รายได้ที่เลื่อนสัญญาทางการค้า ต้นทุนโอกาส

ประมาณแบบ baseline vs with-AI ง่าย ๆ

เลือกฟีเจอร์หรือสปรินต์หนึ่งงาน แบ่งเวลาเป็นเฟส แล้ววัดสองค่าในแต่ละเฟส: ชั่วโมงเฉลี่ย ไม่มี AI เทียบกับ มี AI รวมถึงค่าใช้จ่ายเครื่องมือใหม่

สูตรแบบเบา ๆ:

Savings = (Hours_saved × Blended_hourly_rate) + Cloud_savings + Support_savings − Tool_cost

ROI % = Savings / Tool_cost × 100

คุณไม่ต้องติดตามแบบเป๊ะ ๆ—ใช้ไทม์ล็อก เวลา PR รอบ เกิดรอบรีวิว อัตราเทสต์ล้ม และ lead time to deploy เป็นพร็อกซีได้

อย่าลืม “ต้นทุนความเสี่ยง”

AI อาจเพิ่มต้นทุนถ้าไม่ได้จัดการ: การเปิดเผยความปลอดภัย ปัญหาลิขสิทธิ์/IP ช่องว่างการปฏิบัติตาม หรือคุณภาพโค้ดลด ให้คำนวณเป็นต้นทุนคาดหวัง:

- Risk cost = Probability × Impact (เช่น งานทำซ้ำหลังพบช่องโหว่ความปลอดภัย เวลาแก้ audit)

เริ่มเล็กแล้วขยาย

เริ่มจากเวิร์กโฟลว์เดียว (เช่น การสร้างเทสต์หรือการชี้แจงข้อกำหนด) รัน 2–4 สัปดาห์ บันทึกเมตริกก่อน/หลัง แล้วค่อยขยาย วิธีนี้ทำให้การนำ AI เป็นวงรอบปรับปรุงที่วัดได้ ไม่ใช่การซื้อแบบความเชื่อ

ความเสี่ยงและการตั้งกรอบ: ความปลอดภัย คุณภาพ และการปฏิบัติตาม

AI ช่วยตัดงานวุ่นได้มาก แต่นำโหมดความล้มเหลวใหม่มา ให้ถือ output ของ AI เป็น autocomplete ที่แข็งแรง: เร็วแต่ไม่ใช่ความจริง

ความเสี่ยงสำคัญที่ต้องวางแผน

อันดับแรก ผลลัพธ์ไม่ถูกต้องหรือไม่ครบ โมเดลอาจฟังดูถูกแต่พลาดกรณีขอบเขต สร้าง API ที่ไม่มีอยู่จริง หรือผลิตโค้ดผ่านเทสต์ happy-path แต่พังในโปรดักชัน

อันดับสอง การรั่วไหลของข้อมูล การแปะความลับ ข้อมูลลูกค้า หรือล็อกเหตุการณ์ลงในเครื่องมือที่ไม่ได้อนุมัติอาจสร้างการรั่วไหล นอกจากนี้ยังมีความเสี่ยงที่โค้ดที่สร้างอาจมีรูปแบบไม่ปลอดภัย

อันดับสาม ลิขสิทธิ์/IP โค้ดที่ถูกสร้างอาจคล้ายชิ้นส่วนที่มีลิขสิทธิ์หรือดึงการพึ่งพาด้วยไลเซนส์ที่ไม่เข้ากัน ถ้าคัดลอกแบบไม่คิด

อันดับสี่ การตัดสินใจที่มีอคติหรือไม่สม่ำเสมอ AI อาจชี้นำการจัดลำดับความสำคัญ คำพูด หรือนโยบายในทางที่ไม่ตั้งใจให้บางกลุ่มผู้ใช้ถูกตัดสิทธิ์หรือขัดต่อนโยบายภายใน

แนวปฏิบัติที่เก็บความเร็วไว้

ให้ การตรวจทานโดยมนุษย์เป็นกฎ ไม่ใช่คำแนะนำ: ห้าม merge การเปลี่ยนแปลงที่สร้างด้วย AI โดยไม่ผ่าน code review และให้รีวิวเวอร์ตรวจเรื่องความปลอดภัย การจัดการข้อผิดพลาด และเทสต์ ไม่ใช่แค่รูปแบบ

เพิ่ม นโยบายและการควบคุมการเข้าถึงแบบเบา: เครื่องมือที่อนุมัติเท่านั้น SSO สิทธิ์ตามบทบาท และกฎชัดเจนเกี่ยวกับข้อมูลที่แชร์ได้

เก็บ audit trails: บันทึกพรอมท์และเอาต์พุตในสภาพแวดล้อมที่อนุมัติเมื่อเป็นไปได้ และบันทึกเมื่อมีการใช้ AI สำหรับข้อกำหนด โค้ด หรือเทสต์

พื้นฐานการจัดการข้อมูล

อย่าส่งข้อมูลละเอียดอ่อน (PII, คีย์, ล็อกโปรดักชัน, สัญญาลูกค้า) ไปยังเครื่องมือ AI ทั่วไป ให้ใช้สภาพแวดล้อมที่อนุมัติ การลบข้อมูล และตัวอย่างสังเคราะห์

สรุป

ผลลัพธ์จาก AI เป็น คำแนะนำ ไม่ใช่ข้อรับประกัน ด้วยกรอบ—การตรวจทาน นโยบาย การควบคุมการเข้าถึง และการติดตาม คุณจะได้ประโยชน์จากความเร็วโดยไม่สละความปลอดภัย คุณภาพ หรือการปฏิบัติตาม

โรดแมปการนำไปใช้ที่ปฏิบัติได้สำหรับทีมทุกขนาด

การนำ AI มาใช้ได้ผลดีที่สุดเมื่อมองเป็นการเปลี่ยนกระบวนการ: เริ่มเล็ก มาตรฐานสิ่งที่ได้ผล แล้วขยายพร้อมกรอบชัดเจน เป้าหมายไม่ใช่ “ใช้ AI ทุกที่” แต่เพื่อลดการส่งต่อ งานทำซ้ำ และการรอที่เลี่ยงได้

เฟส 1: ทดลอง (1–2 สัปดาห์)

เลือกทีมหนึ่งและเวิร์กโฟลว์หนึ่งที่ความผิดพลาดมีความเสี่ยงต่ำแต่เห็นการประหยัดเวลาได้ชัด (เช่น เขียน user stories สร้างเคสเทสต์ refactor โมดูลเล็ก) เก็บขอบเขตแคบและเปรียบเทียบกับ baseline ปกติ

เฟส 2: มาตรฐาน (กะทัดรัด ไม่เป็นราชการ)

จดว่า “การใช้ AI ที่ดี” เป็นอย่างไรสำหรับทีม

- เทมเพลตพรอมท์: พรอมป์สั้นที่นำกลับมาใช้ได้สำหรับงานทั่วไป (ชี้แจงข้อกำหนด ร่างโน้ตรีวิว ร่างแผนทดสอบ)

- เช็คลิสต์การตรวจทาน: สิ่งที่มนุษย์ต้องยืนยัน (ความถูกต้อง ความปลอดภัย กรณีขอบเขต)

- รายการ Do/Don’t:

- Do: ให้บริบท เงื่อนไข ข้อยกตัวอย่าง และตัวอย่าง

- Don’t: แปะความลับ คีย์การผลิต หรือข้อมูลที่เป็นกรรมสิทธิ์ที่ไม่ควรแชร์

เฟส 3: การฝึกอบรม (2–4 เซสชันสั้น)

สอนคนถามคำถามให้ดีกว่าและตรวจผลอย่างไร เน้นสถานการณ์ปฏิบัติ: “เปลี่ยนข้อกำหนดคลุมเครือเป็นเกณฑ์ที่ทดสอบได้” หรือ “ร่างแผนมิเกรชัน แล้วตรวจความเสี่ยง”

เฟส 4: อัตโนมัติ (เมื่อการทำซ้ำเป็นปัญหา)

เมื่อทีมเชื่อใจเวิร์กโฟลว์แล้ว ให้อัตโนมัติส่วนที่ซ้ำ: ร่างคำอธิบาย PR โครงสร้างเทสต์ โน้ตปล่อย และการคัดแยกตั๋ว เก็บขั้นตอนอนุมัติด้วยคนสำหรับสิ่งที่จะปล่อยจริง

ถ้าประเมินแพลตฟอร์ม ให้ดูว่ามีฟีเจอร์ iteration ที่ปลอดภัยหรือไม่ (เช่น โหมดวางแผน snapshots rollback) และตัวเลือกนำไปใช้จริง (เช่น การ export โค้ด) นี่คือพื้นที่ที่ Koder.ai ถูกออกแบบมาให้เข้ากับความคาดหวังวิศวกรรม: เคลื่อนไหวเร็ว แต่ยังคุมได้

เฟส 5: ปรับปรุงต่อเนื่อง

ทบทนเทมเพลตและกฎทุกเดือน เลิกใช้พรอมป์ที่ไม่ช่วย แล้วขยายมาตรฐานเมื่อเห็นรูปแบบความล้มเหลวซ้ำ

เมตริกที่ต้องติดตาม (เพื่อให้ ROI ไม่ใช่การเดา)

ติดตามตัวชี้วัดไม่กี่ตัวอย่างสม่ำเสมอ:

- Cycle time (idea → deployed)

- Review time (PR open → merged)

- Defect rate (บั๊กที่หลุด + ที่เจอใน QA)

- Rework % (ตั๋วที่เปิดอีกครั้ง churn การเปลี่ยนซ้ำ)

- ความพึงพอใจทีม (แบบสำรวจสั้น)

ใช้เช็คลิสต์นี้ในโปรเจกต์ถัดไปของคุณ

ถ้าคุณเผยแพร่บทเรียนจากพิลอต อาจคุ้มค่าที่จะทำเป็นแนวทางภายในหรือเขียนเป็นบทความสาธารณะ—หลายทีมพบว่าการบันทึกเมตริกก่อน/หลังเป็นสิ่งที่ทำให้การนำ AI เปลี่ยนจากทดลองเป็นกระบวนการที่ทำซ้ำได้ (บางแพลตฟอร์ม รวมถึง Koder.ai ยังมีโปรแกรมที่ให้เครดิตทีมที่แชร์เนื้อหาที่ปฏิบัติได้จริงหรือแนะนำผู้อื่น ซึ่งช่วยชดเชยค่าใช้จ่ายในช่วงทดลอง)