06 ก.ย. 2568·3 นาที

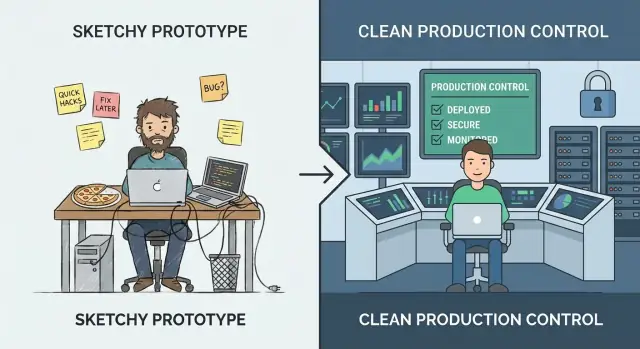

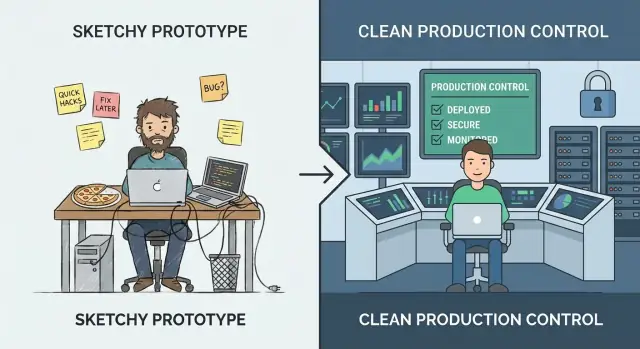

เมื่อไรควรหยุด Vibe Coding และทำให้ระบบพร้อมใช้งานจริง

เรียนรู้สัญญาณว่าโปรโตไทป์กำลังกลายเป็นผลิตภัณฑ์จริง พร้อมเช็คลิสต์ใช้งานได้ที่จะช่วยเสริมความน่าเชื่อถือ ความปลอดภัย การทดสอบ และการปฏิบัติการสำหรับการใช้งานจริง

เรียนรู้สัญญาณว่าโปรโตไทป์กำลังกลายเป็นผลิตภัณฑ์จริง พร้อมเช็คลิสต์ใช้งานได้ที่จะช่วยเสริมความน่าเชื่อถือ ความปลอดภัย การทดสอบ และการปฏิบัติการสำหรับการใช้งานจริง

“Vibe coding” คือช่วงที่ความเร็วมีค่าน้ำหนักกว่าความแม่นยำ คุณกำลังทดลอง เรียนรู้ว่าสิ่งที่ผู้ใช้ต้องการจริง ๆ คืออะไร และลองไอเดียที่อาจอยู่ได้ไม่กี่วัน เป้าหมายคือข้อมูลเชิงลึก: ยืนยันเวิร์กโฟลว์ พิสูจน์คุณค่าหรือยืนยันท่ามกลางข้อมูลที่จำเป็น โหมดนี้ขอบหยาบเป็นเรื่องปกติ—มีขั้นตอนแบบแมนนวล การจัดการข้อผิดพลาดไม่ละเอียด และโค้ดที่ปรับเพื่อให้"ทำงาน"ได้เร็ว

“การเสริมความแข็งแรงสำหรับ production” แตกต่างออกไป มันคือการทำให้พฤติกรรมคาดเดาได้เมื่อใช้งานจริง: input ยุ่งเหยิง การหยุดชั่วคราวบางส่วน ปริมาณผู้ใช้สูงสุด และคนทำสิ่งที่คุณไม่ได้คาดคิด การเสริมความแข็งแรงมุ่งลดความประหลาดใจ—เพื่อให้ระบบล้มอย่างปลอดภัย กู้คืนสะอาด และเข้าใจได้สำหรับคนต่อไปที่ต้องดูแลมัน

ถ้าคุณเสริมความแข็งแรงเร็วเกินไป คุณอาจชะลอการเรียนรู้ ลงทุนในสเกล อัตโนมัติ หรือสถาปัตยกรรมที่ขัดเกลาในทิศทางผลิตภัณฑ์ซึ่งเปลี่ยนสัปดาห์หน้า นั่นแพงและทำให้ทีมเล็กติดขัด

ถ้าคุณเสริมความแข็งแรงช้าเกินไป คุณสร้างความเสี่ยง ช็อตคัตที่ใช้ได้ในเดโมกลายเป็นเหตุการณ์ที่กระทบลูกค้า: ความไม่สอดคล้องของข้อมูล ช่องโหว่ด้านความปลอดภัย และเวลาหยุดทำงานที่ทำลายความเชื่อใจ

แนวปฏิบัติที่เป็นไปได้คือยังคงทดลองต่อไปในขณะที่เสริมความแข็งแรงที่ “thin waist” ของระบบ: เส้นทางสำคัญไม่กี่รายการที่ต้องเชื่อถือได้ (สมัคร, การจ่ายเงิน, การเขียนข้อมูล, การเชื่อมต่อสำคัญ) คุณยังสามารถ iterate อย่างรวดเร็วกับฟีเจอร์รอบนอก—แต่อย่าให้สมมติฐานของโปรโตไทป์ปกครองส่วนที่ผู้ใช้จริงพึ่งพาทุกวัน

นี่คือที่การเลือกเครื่องมือมีความหมาย แพลตฟอร์มที่สร้างมาเพื่อการทดลองรวดเร็วช่วยให้คุณอยู่ในโหมด “vibe” โดยไม่เสียความสามารถในการเป็นมืออาชีพในภายหลัง ตัวอย่างเช่น Koder.ai ออกแบบมาสำหรับ vibe-coding ผ่านแชทเพื่อสร้างเว็บ แบ็กเอนด์ และแอปมือถือ แต่ก็รองรับการส่งออกซอร์สโค้ด การปรับใช้/โฮสติ้ง โดเมนกำหนดเอง และ snapshot/rollback—ฟีเจอร์ที่สอดคล้องกับแนวคิด “thin waist” (ส่งของเร็ว แต่ปกป้องเส้นทางสำคัญและกู้คืนได้เร็ว)

Vibe coding เหมาะเมื่อคุณต้องการเรียนรู้เร็ว: ไอเดียนี้จะเวิร์กไหม? ความผิดพลาดคือการถือว่า นิสัยแบบเดิมจะรับมือเมื่อคนจริงหรือกระบวนการธุรกิจจริงพึ่งพาผลลัพธ์ได้

วิธีที่ใช้ตัดสินใจว่าต้องเสริมความแข็งแรงไหมคือการตั้งชื่อสเตจที่คุณอยู่:

เมื่อคุณเคลื่อนไปทางขวา คำถามเปลี่ยนจาก “มันทำงานไหม?” เป็น “เราจะเชื่อใจมันได้ไหม?” นั่นเพิ่มความคาดหวังเช่นประสิทธิภาพคาดเดาได้ การจัดการข้อผิดพลาดที่ชัดเจน การตรวจสอบ และความสามารถในการย้อนการเปลี่ยนแปลง มันยังบังคับให้คุณกำหนดความเป็นเจ้าของ: ใครรับผิดชอบเมื่อมีสิ่งผิดพลาด?

บั๊กที่แก้ในช่วงไอเดีย/เดโมถูกเพราะคุณกำลังเปลี่ยนโค้ดที่ยังไม่มีใครพึ่งพา หลังปล่อย เหยียบบั๊กเดียวกันอาจก่อให้เกิดเวลาซัพพอร์ต การทำความสะอาดข้อมูล ลูกค้าหาย หรือพลาดเดดไลน์ การเสริมความแข็งแรงไม่ใช่ความเพอร์เฟ็กต์—แต่เป็นการลด blast radius ของความผิดพลาดที่หลีกเลี่ยงไม่ได้

เครื่องมือภายในที่กระทบการออกใบแจ้งหนี้ การจัดเส้นทางลีด หรือการควบคุมการเข้าถึง ก็เป็นโปรดักชันถ้าธุรกิจพึ่งพามัน ถ้าความล้มเหลวจะหยุดงาน เปิดเผยข้อมูล หรือนำความเสี่ยงทางการเงิน ให้ปฏิบัติเหมือนเป็น production แม้มีผู้ใช้เพียง 20 คน

โปรโตไทป์เปราะได้ มันพิสูจน์ไอเดีย เปิดการสนทนา และช่วยคุณเรียนรู้เร็ว จุดที่คนจริงเริ่มพึ่งพามัน ต้นทุนการแก้แบบเร็วเพิ่มขึ้น—ความเสี่ยงเปลี่ยนจากน่ารำคาญเป็นกระทบธุรกิจ

กลุ่มผู้ใช้เปลี่ยนไป ถ้าจำนวนผู้ใช้เพิ่มขึ้นเรื่อยๆ คุณมีลูกค้าที่จ่ายเงิน หรือเซ็นสัญญาที่มีข้อคาดหวัง uptime/response คุณไม่ทดลองอีกต่อไป—คุณกำลังให้บริการ

ข้อมูลมีความอ่อนไหวมากขึ้น วันที่ระบบของคุณเริ่มแตะ PII (ชื่อ อีเมล ที่อยู่) ข้อมูลการเงิน ข้อมูลรับรอง หรือไฟล์ส่วนตัว คุณต้องการการควบคุมการเข้าถึงที่เข้มงวดขึ้น บันทึกการตรวจสอบ และค่าเริ่มต้นที่ปลอดภัย เดโมอาจ “ปลอดภัยพอสำหรับโชว์” แต่ข้อมูลจริงไม่ใช่

การใช้งานกลายเป็นกิจวัตรหรือสำคัญต่อภารกิจ เมื่อเครื่องมือเป็นส่วนหนึ่งของเวิร์กโฟลว์ประจำวันหรือความล้มเหลวบล็อกคำสั่งซื้อ รายงาน การอบรม หรืองานซัพพอร์ต เวลาหยุดและ edge case แปลกๆ จะไม่เป็นที่ยอมรับ

ทีมอื่นพึ่งพาผลลัพธ์ของคุณ ถ้าทีมภายในสร้างกระบวนการรอบแดชบอร์ด เอ็กซ์พอร์ต เว็บฮุค หรือ API ของคุณ ทุกการเปลี่ยนเป็นการเปลี่ยนแปลงที่อาจทำให้เสียหาย คุณจะรู้สึกแรงกดดันให้คงพฤติกรรมและสื่อสารการเปลี่ยนแปลง

การพังเกิดซ้ำ กระแสข้อความ “มันพัง” แจ้งเตือนใน Slack และตั๋วซัพพอร์ตสม่ำเสมอเป็นสัญญาณว่าคุณใช้เวลาตอบสนองมากกว่าการเรียนรู้ นั่นคือสัญญาณให้ลงทุนในความเสถียรแทนฟีเจอร์เพิ่ม

ถ้า outage หนึ่งชั่วโมงจะน่าอาย คุณกำลังเข้าใกล้ production ถ้ามันจะมีค่าใช้จ่าย—รายได้หาย คำสัญญาขาด หรือความเชื่อใจเสียหาย—คุณอยู่ที่นั่นแล้ว

ถ้าคุณถกเถียงว่าแอป “พร้อมไหม” แปลว่าคุณถามคำถามผิด คำถามที่ดีกว่า: ต้นทุนของการผิดพลาดคือเท่าไร? การเสริมความแข็งแรงไม่ใช่เครื่องหมายเกียรติ—มันคือการตอบสนองต่อความเสี่ยง

จดว่าความล้มเหลวเป็นอย่างไรสำหรับระบบ ของคุณ หมวดทั่วไป:\n\n- Downtime: บริการใช้งานไม่ได้เลย\n- ผลลัพธ์ผิด: มันรันแต่ให้ผลลัพธ์ผิด (มักแย่กว่าการหยุด)\n- การตอบช้าลง: ผู้ใช้ละทิ้งงาน ออโตเมชันหมดเวลา ตั๋วซัพพอร์ตพุ่ง

จะเฉพาะเจาะจง เช่น “ค้นหาใช้เวลา 12 วินาทีสำหรับ 20% ของผู้ใช้ในช่วงพีค” เป็นสิ่งที่ทำได้ ในขณะที่ “ปัญหาประสิทธิภาพ” ไม่ใช่

ไม่ต้องตัวเลขเป๊ะ—ใช้ช่วงได้:\n\n- รายได้: การขายหาย พลาดการต่ออายุ ค่าเสียหายจาก SLA\n- การสูญเสียความเชื่อใจ/ churn: ผู้ใช้ไม่กลับหลังประสบการณ์แย่\n- ผลผลิตหาย: ทีมภายในติดขัด งานแมนนวลมากขึ้น\n- การปฏิบัติตามกฎ: ข้อค้นพบ audit ผิดสัญญา หรือความรับผิดชอบรายงาน

ถ้าผลกระทบวัดยาก ให้ถาม: ใครจะถูก page? ใครต้องขอโทษ? ใครจ่าย?

ความล้มเหลวจากโปรโตไทป์สู่โปรดักชันมักรวมเป็นไม่กี่กลุ่ม:\n\n- การสูญหายหรือเสียหายของข้อมูล (ไม่มี backup, migration ไม่ปลอดภัย, การเข้าถึงอ่อนแอ)\n- การโจมตีความปลอดภัย (token รั่ว, สิทธิ์กว้างเกินไป, endpoint เปิดเผย)\n- ออโตเมชันผิดพลาด (LLM หรือสคริปต์ทำการเปลี่ยนผิดพลาดในระดับใหญ่)

จัดอันดับความเสี่ยงตามความน่าจะเป็น × ผลกระทบ นี่จะเป็น roadmap การเสริมความแข็งแรงของคุณ

หลีกเลี่ยงความสมบูรณ์แบบ เลือกเป้าหมายที่ตรงกับความเสี่ยงปัจจุบัน เช่น “availability เวลาทำการ”, “ความสำเร็จ 99% สำหรับเวิร์กโฟลว์หลัก”, หรือ “กู้คืนภายใน 1 ชั่วโมง” เมื่อการใช้งานและการพึ่งพาเพิ่ม ให้ยกระดับบาร์อย่างตั้งใจ แทนที่จะตื่นตกใจ

การเสริมความแข็งแรงมักล้มเหลวด้วยเหตุผลง่ายๆ: ไม่มีใครบอกว่าใครรับผิดชอบระบบแบบ end-to-end และไม่มีใครบอกว่า “เสร็จ” หมายถึงอะไร

ก่อนจะใส่ rate limit, load test หรือ logging stack ใหม่ ให้ล็อกสองสิ่งพื้นฐาน: ความเป็นเจ้าของและขอบเขต พวกนี้เปลี่ยนโปรเจ็กต์วิศวกรรมที่ไม่มีที่สิ้นสุดให้เป็นชุดความมุ่งมั่นที่จัดการได้

เขียนลงว่าใครเป็นเจ้าของระบบแบบ end-to-end—ไม่ใช่แค่โค้ด เจ้าของรับผิดชอบ availability คุณภาพข้อมูล การปล่อย และผลกระทบต่อผู้ใช้ นั่นไม่ใช่หมายความว่าเขาทำทุกอย่าง แต่หมายความว่าเขาตัดสินใจ ประสานงาน และมั่นใจว่ามีคนรับผิดชอบเมื่อมีปัญหา

ถ้าการเป็นเจ้าของแชร์กัน ให้ตั้ง primary: คน/ทีมที่พูด “ใช่/ไม่” และรักษาความสำคัญให้สอดคล้อง

ระบุ user journeys และ critical paths ซึ่งเป็น flow ที่ความล้มเหลวสร้างความเสียหายจริง: สมัคร/ล็อกอิน, ชำระเงิน, ส่งข้อความ, นำเข้าข้อมูล, สร้างรายงาน เป็นต้น

เมื่อมี critical paths คุณก็สามารถเสริมความแข็งแรงแบบคัดเลือกได้:\n\n- ตั้งเป้าหมายความน่าเชื่อถือรอบเส้นทางเหล่านั้นก่อน\n- ตัดสินใจว่าข้อมูลใดห้ามสูญหาย\n- เลือกเมตริกไม่กี่ตัวที่นิยามว่า “ทำงาน”

เอกสารว่าตอนนี้ครอบคลุมอะไรบ้างและอะไรไว้ทำทีหลัง เพื่อไม่ให้การเตรียมพร้อมสำหรับ production กลายเป็น “ซอฟต์แวร์สมบูรณ์แบบ” ให้ชัดเจนว่าสิ่งที่ยังไม่รองรับ (ภูมิภาค เบราว์เซอร์ การจราจรสูง การเชื่อมต่อ)

สร้าง runbook เบาๆ: วิธี deploy, rollback, debug ให้สั้นและใช้งานได้ตอนตีสอง—เช็คลิสต์ dashboard สำคัญ โหมดล้มเหลวที่พบบ่อย และคนติดต่อ คุณสามารถพัฒนามันได้ แต่ไม่สามารถแต่งขึ้นขณะเกิด incident แรกได้

ความน่าเชื่อถือไม่ใช่ทำให้ความล้มเหลวเป็นไปไม่ได้—แต่เป็นการทำให้พฤติกรรมคาดเดาได้เมื่อมีปัญหาหรือโหลดสูง โปรโตไทป์มัก “ทำงานบนเครื่องฉัน” เพราะการจราจรต่ำ ข้อมูลเป็นมิตร และไม่มีใครยิง endpoint เดียวกันพร้อมกัน

เริ่มจากการป้องกันที่น่าเบื่อแต่ให้ผลมาก:\n\n- ตรวจสอบ input ที่ขอบ (API, ฟอร์ม UI, payload ของ webhook) ปฏิเสธข้อมูลไม่ถูกต้องตั้งแต่ต้น พร้อมข้อความผิดที่ชัดเจน\n- timeouts ทุกที่ที่เรียกสิ่งช้า/ภายนอก (DB, third-party APIs, คิว) ไม่มี timeout จะเปลี่ยนอุบัติเหตุเล็กๆ ให้กลายเป็นกองพะเนิน\n- retry อย่างระมัดระวัง: retry เฉพาะการดำเนินการที่ปลอดภัย ใช้ exponential backoff + jitter และจำกัดความพยายาม การ retry แบบไม่คิดอาจขยาย outage\n- circuit breakers เพื่อหยุดเรียก dependency ที่ล้มและฟื้นตัวอัตโนมัติเมื่อเสถียร

เมื่อระบบทำงานไม่เต็มที่ มันควรยังทำงานในแบบที่ปลอดภัยสุด เช่น ให้ค่าที่แคชไว้ ปิดฟีเจอร์ไม่สำคัญ หรือคืน response “ลองอีกครั้ง” พร้อม request ID ชอบการ graceful degradation มากกว่าการเขียนข้อมูลบางส่วนเงียบๆ หรือ error ทั่วไปที่สับสน

ภายใต้โหลด คำขอซ้ำและงานทับซ้อนเกิดขึ้น (ดับเบิลคลิก, retry เน็ตเวิร์ก, redelivery ของคิว) ออกแบบเพื่อรองรับ:\n\n- ทำให้การกระทำสำคัญ idempotent (คำขอเดียวกันสองครั้งให้ผลเหมือนเดิม)\n- ใช้ locks หรือ optimistic concurrency เมื่อจำเป็นเพื่อป้องกัน race condition

ความน่าเชื่อถือรวมถึง “อย่าทำให้ข้อมูลเสีย” ใช้ transaction สำหรับการเขียนหลายขั้นตอน เพิ่ม constraints (unique keys, foreign keys) และปฏิบัติตามวินัยการ migration (การเปลี่ยนแปลงที่เข้ากันได้ย้อนหลัง ทดสอบการปล่อย)

ตั้งขีดจำกัดบน CPU, memory, connection pools, ขนาดคิว และ payload ของคำขอ ถ้าไม่มีขีดจำกัด ลูกค้าหนึ่งรายที่มีเสียงดังหรืองานที่หนักอาจทำให้ทุกอย่างขาดแคลน

การเสริมความแข็งแรงด้านความปลอดภัยไม่ใช่การทำป้อมปราการ แต่มันคือการถึงมาตรฐานขั้นต่ำที่ความผิดพลาดปกติ—ลิงก์เปิดเผย token รั่ว หรือผู้ใช้สงสัย—จะไม่กลายเป็นเหตุการณ์ที่กระทบลูกค้า

ถ้าคุณมี “สภาพแวดล้อมเดียว” คุณมี blast radius เดียว สร้าง dev/staging/prod ที่แยกจากกันโดยมี ความลับที่ใช้ร่วมกันน้อยที่สุด Staging ควรใกล้กับ production พอจะเผยปัญหา แต่ไม่ควรใช้ credential หรือข้อมูลสำคัญของ production

หลายโปรโตไทป์หยุดแค่ “ล็อกอินได้” Production ต้องการ least privilege:\n\n- กำหนดบทบาทชัดเจน (เช่น admin, support, standard user) และบังคับขอบเขตฝั่งเซิร์ฟเวอร์\n- ล็อกดาวน์เครื่องมือภายในและ endpoint แอดมิน\n- เก็บ audit trail สำหรับการกระทำสำคัญ (ล็อกอิน, รีเซ็ตรหัสผ่าน, เปลี่ยนบทบาท, ส่งออก, ลบ) คุณไม่ต้องการ analytics สมบูรณ์—แค่พอจะตอบว่า “ใครทำอะไร เมื่อไร”

ย้าย API keys รหัสผ่านฐานข้อมูล และ secret ต่างๆ ไปยัง secrets manager หรือ environment variables ที่ปลอดภัย แล้วแน่ใจว่ามันไม่รั่ว:\n\n- อย่าพิมพ์ token ลงในล็อกแอปพลิเคชัน\n- หลีกเลี่ยงการส่งความลับไปยังโค้ดฝั่งลูกค้า\n- หมุน credential ที่เคยถูกคอมมิตใน repo

ได้ประโยชน์มากสุดจากการแก้บาง failure mode ทั่วไป:\n\n- Injection (SQL/command): ใช้ parameterized queries และไลบรารีที่ปลอดภัย\n- การควบคุมการเข้าถึงผิดพลาด: ตรวจสิทธิ์ในทุกคำขอ ไม่ใช่แค่ใน UI\n- การเปิดเผยข้อมูล: เข้ารหัสระหว่างการส่ง ปรับจำกัดข้อมูลที่ส่งกลับโดยดี และหลีกเลี่ยงการส่งออกกว้างเกินไป

ตัดสินใจว่าใครรับผิดชอบการอัปเดตและความถี่การแพตช์ dependency และ base images แผนง่ายๆ (ตรวจสัปดาห์ละครั้ง + อัปเดตเดือนละครั้ง, แก้ไขด่วนภายใน 24–72 ชั่วโมง) ดีกว่า “จะทำทีหลัง”

การทดสอบคือสิ่งที่เปลี่ยนจาก “มันทำงานบนเครื่องฉัน” เป็น “มันยังทำงานให้ลูกค้า” เป้าหมายไม่ใช่ครอบคลุมสมบูรณ์—แต่เป็นความมั่นใจในพฤติกรรมที่แพงที่สุดถ้าพัง: การเรียกเก็บเงิน ความสมบูรณ์ของข้อมูล สิทธิ์ เวิร์กโฟลว์สำคัญ และสิ่งที่ยากจะดีบักเมื่อ deploy แล้ว

พีระมิดที่ใช้งานได้จริงมักเป็นแบบนี้:\n\n- Unit tests สำหรับลอจิกบริสุทธิ์ (เร็ว มีเยอะ)\n- Integration tests สำหรับขอบเขต (DB, คิว, third-party APIs โดยใช้ mocks)\n- E2E tests สำหรับเส้นทางผู้ใช้สำคัญไม่กี่เส้น (ช้า รักษาให้เล็ก)

ถ้าแอปของคุณเป็น API + DB ให้ถ่วงน้ำหนักไปที่ integration tests ถ้าเน้น UI ให้มีชุด E2E เล็กๆ ที่สะท้อนการสำเร็จและความล้มเหลวของผู้ใช้จริง

เมื่อบั๊กทำให้เกิดค่าใช้จ่าย ให้เพิ่ม regression test ทันที ให้ลำดับพฤติกรรมเช่น “ลูกค้าจ่ายเงินได้” “งานไม่คิดเงินซ้ำ” หรือ “อัปเดตไม่ทำให้ข้อมูลเสีย” สิ่งนี้สร้างตาข่ายความปลอดภัยรอบพื้นที่เสี่ยงสูงแทนการกระจายการทดสอบทั่ว

Integration tests ควร deterministic ใช้ fixtures และ seeded data เพื่อให้การรันทดสอบไม่พึ่งกับฐานข้อมูลของนักพัฒนา รีเซ็ตสถานะระหว่างการทดสอบ และเก็บข้อมูลทดสอบให้เล็กแต่เป็นตัวแทน

ยังไม่ต้องมีโปรแกรมทดสอบโหลดเต็มรูปแบบ แต่ควรมีการตรวจเช็คประสิทธิภาพเร็วๆ สำหรับ endpoint และงาน background สำคัญ การทดสอบ smoke แบบเกณฑ์ง่าย (เช่น p95 response time ต่ำกว่า X ms ที่ concurrency เล็ก) ช่วยจับ regression สำคัญได้เร็ว

ทุกการเปลี่ยนควรเรียกเกตอัตโนมัติ:\n\n- linting และการจัดรูปแบบ\n- type checks (ถ้ามี)\n- ชุด unit + integration\n- สแกนความปลอดภัยพื้นฐาน (dependency/vulnerability)

ถ้าการทดสอบไม่รันอัตโนมัติ มันก็เป็นทางเลือก—และ production จะพิสูจน์ในที่สุด

เมื่อโปรโตไทป์พัง คุณอาจ “ลองอีกครั้ง” ได้ ใน production การเดาผลกลายเป็น downtime churn และคืนที่ยาว Observability ช่วยย่นเวลาจาก “รู้สึกผิดปกติ” เป็น “นี่คือสิ่งที่เปลี่ยน ที่ไหน และใครบ้างที่ได้รับผลกระทบ”

บันทึกสิ่งที่สำคัญ ไม่ใช่ทุกอย่าง คุณต้องการบริบทพอจะทำซ้ำปัญหาโดยไม่ดัมพ์ข้อมูลอ่อนไหว\n\n- ใส่ request ID ในทุกคำขอและพาออกไปในระบบ\n- เพิ่ม user/session identifiers อย่างปลอดภัย (hashed หรือ internal IDs; ห้าม raw passwords, ข้อมูลบัตรชำระเงิน หรือความลับ)\n- บันทึก outcomes: success/failure, status codes, และสาเหตุข้อผิดพลาดที่มีความหมาย\n\nกฎดีๆ: ทุกบันทึกข้อผิดพลาดควรทำให้เห็นชัดว่าล้มอะไรและควรตรวจสอบอะไรต่อ

การเสริมความแข็งแรงไม่ได้มีแต่โค้ด—มันเกี่ยวกับวิธีที่คุณเปลี่ยนระบบเมื่อคนพึ่งพามัน โปรโตไทป์ทนกับ “push to main and hope” Production ไม่ทำแบบนั้น ความเป็นระเบียบในการปล่อยและปฏิบัติการทำให้การส่งของเป็นกิจวัตร ไม่ใช่เหตุการณ์ความเสี่ยงสูง

ชัยชนะคือความสอดคล้อง: คุณสามารถทำซ้ำการปล่อย เทียบสองเวอร์ชัน และหลีกเลี่ยง “works on my machine”

รักษาวินัย: ตั้งชื่อชัดเจน กำหนดเจ้าของ และเอาออกเมื่อจบการทดลอง ธงถาวรที่ไม่ชัดเจนกลายเป็นความเสี่ยงเชิงปฏิบัติการ

จากนั้นซ้อมในสภาพแวดล้อมปลอดภัย วัดเวลาที่ใช้และจดขั้นตอน หาก rollback ต้องพึ่งผู้เชี่ยวชาญที่กำลังลาพัก มันไม่ใช่กลยุทธ์

ถ้าคุณใช้แพลตฟอร์มที่รองรับ reversal ให้ใช้ประโยชน์ เช่น Koder.ai ที่มี snapshots และ workflow rollback ช่วยให้การหยุดเลือดเป็นการดำเนินการที่ทำซ้ำได้ในขณะที่ยังคงสปีดการพัฒนา

ถ้าทำดี ระเบียบการปล่อยและปฏิบัติการทำให้การส่งของรู้สึกปลอดภัย—แม้คุณจะเคลื่อนไหวเร็ว

เหตุฉุกเฉินเกิดขึ้นแน่เมื่อมีผู้ใช้จริง ความแตกต่างระหว่าง “วันแย่” กับ “ภัยคุกคามต่อธุรกิจ” คือการตัดสินใจล่วงหน้าว่าใครทำอะไร สื่อสารอย่างไร และเรียนรู้อย่างไร

เขียน postmortem ที่เน้น การแก้ไข ไม่ใช่โทษ บทสรุปที่ดีผลิตงานติดตามที่ชัดเจน: alert หาย → เพิ่ม alert; ความเป็นเจ้าของไม่ชัด → กำหนด on-call; การปล่อยเสี่ยง → ใส่ canary ขั้นตอน เก็บโทนเป็นข้อเท็จจริงและทำให้ง่ายต่อการร่วมมือ

ติดตามปัญหาซ้ำๆ อย่างชัดเจน: timeout เดิมๆ ทุกสัปดาห์ไม่ใช่ “โชคร้าย” มันคือ backlog item เก็บรายการปัญหาซ้ำและแปลงปัญหาอันดับต้นเป็นงานที่มีเจ้าของและเดดไลน์

คุณไม่ต้องเสริมความแข็งแรงทุกอย่างพร้อมกัน คุณต้องเสริมความแข็งแรงในส่วนที่ทำร้ายผู้ใช้ เงิน หรือชื่อเสียง—และเก็บส่วนที่เหลือไว้ยืดหยุ่นเพื่อเรียนรู้ต่อ

ถ้าสิ่งเหล่านี้อยู่ใน user journey ให้ปฏิบัติเป็น “production paths” และเสริมก่อนขยายการเข้าถึง:\n\n- Auth & permissions: สมัคร เข้าสู่ระบบ รีเซ็ตรหัสผ่าน การตรวจบทบาท การลบบัญชี\n- เงิน & การผูกมัด: การเรียกเก็บเงิน การคืนเงิน การเปลี่ยนแผน เช็คเอาต์ ใบแจ้งหนี้\n- ความสมบูรณ์ของข้อมูล: การเขียนเรคคอร์ดหลัก idempotency การย้ายข้อมูล backup/restore\n- ความน่าเชื่อถือที่ผู้ใช้เห็น: timeouts, retries, rate limits, graceful degradation\n- พื้นฐานความปลอดภัย: การจัดการความลับ, least-privilege, ตรวจสอบ input, audit trail ของการกระทำสำคัญ\n- พื้นฐานปฏิบัติการ: มอนิเตอร์ SLI สำคัญ (error rate, latency, saturation), alerts ที่ page คนได้, runbooks สำหรับโหมดล้มเหลวหลัก

เก็บสิ่งเหล่านี้ไว้เบาๆ จนกว่าจะหา product–market fit:\n\n- เครื่องมือภายใน ที่ใช้โดยทีมเล็กและผ่านการฝึกอบรม\n- การทดลองและโปรโตไทป์ที่ทิ้งได้ อยู่หลัง feature flags\n- ความปราณีตของ UI ที่ไม่เปลี่ยนเวิร์กโฟลว์หลัก\n- ออโตเมชันที่ไม่สำคัญ ที่มี fallback แมนนวลง่ายๆ

ถ้าต้องการเวอร์ชันหนึ่งหน้าของนี้ ให้เปลี่ยนบูลเล็ตข้างต้นเป็นเช็คลิสต์และทบทวนทุกการปล่อยหรือการขยายการเข้าถึง

Vibe coding มุ่งที่ความเร็วและการเรียนรู้: พิสูจน์ไอเดีย ยืนยันเวิร์กโฟลว์ และค้นหาข้อกำหนด

การเสริมความแข็งแรงสำหรับ production มุ่งที่ความคาดเดาได้และความปลอดภัย: จัดการ input ที่ยุ่ง ความล้มเหลว ภาระงานหนัก และการดูแลรักษาระยะยาว

กฎที่ใช้ได้: vibe coding ตอบคำถาม “เราควรสร้างไหม?” ส่วนการเสริมความแข็งแรงตอบ “เราจะเชื่อใจมันทุกวันได้ไหม?”

คุณเสริมความแข็งแรงเร็วเกินไปเมื่อทิศทางยังเปลี่ยนทุกสัปดาห์ และคุณใช้เวลาระดับสถาปัตยกรรมมากกว่าการยืนยันคุณค่า

สัญญาณที่บ่งชี้ว่าคุณยังเร็วไป:

ช้าเกินไปเมื่อปัญหาด้านความน่าเชื่อถือเริ่มกระทบลูกค้าหรือขัดขวางธุรกิจ

สัญญาณทั่วไป:

“Thin waist” คือชุดเล็กๆ ของเส้นทางหลักที่ทุกอย่างพึ่งพา (flows ที่มี blast radius สูง)

โดยปกติรวมถึง:

เสริมความแข็งแรงจุดเหล่านี้ก่อน แล้วเก็บฟีเจอร์รอบนอกไว้ทดลอง

ใช้เป้าหมายที่เหมาะกับสเตจ ปรับตามความเสี่ยงปัจจุบัน ไม่ต้องสมบูรณ์แบบ

ตัวอย่าง:

เขียน failure modes แบบเข้าใจง่าย (downtime, ผลลัพธ์ผิด, การตอบช้า) แล้วประเมินผลกระทบทางธุรกิจ

วิธีง่ายๆ:

ถ้ามีความเป็นไปได้ของ “ผลลัพธ์ผิด” ให้จัดลำดับความสำคัญ—ความผิดเงียบอาจแย่กว่าการหยุดทำงาน

อย่างน้อยเพิ่มการป้องกันที่ขอบและการพึ่งพา:

สิ่งเหล่านี้ให้ผลสูงโดยไม่ต้องสถาปัตยกรรมสมบูรณ์แบบ

มาตรฐานขั้นต่ำที่ป้องกันเหตุการณ์ง่ายๆ ที่กระทบลูกค้า:

ถ้าจัดการ PII/ข้อมูลการเงิน ให้มองเป็นข้อบังคับ

เน้นการทดสอบพฤติกรรมที่แพงที่สุดถ้าแตก:

ออโตเมตใน CI เพื่อไม่ให้การทดสอบเป็นทางเลือก: lint/typecheck + unit/integration + ตรวจ dependency พื้นฐาน

ทำให้ตอบได้ง่ายว่า: “มันล่มไหม? มันช้าไหม? ทำไม?”

จุดเริ่มต้นที่ใช้งานได้จริง:

สิ่งนี้จะทำให้ incident กลายเป็นกิจวัตร ไม่ใช่เหตุการณ์ฉุกเฉิน