31 ต.ค. 2568·3 นาที

การตัดสินใจตอนต้นของ Joe Beda ที่หล่อหลอม Kubernetes

มองชัด ๆ ถึงการตัดสินใจตอนแรกของ Joe Beda ใน Kubernetes—โมเดลเชิงประกาศ, control loops, Pods, Services และ labels—และวิธีที่สิ่งเหล่านี้หล่อหลอมแพลตฟอร์มแอปสมัยใหม่

มองชัด ๆ ถึงการตัดสินใจตอนแรกของ Joe Beda ใน Kubernetes—โมเดลเชิงประกาศ, control loops, Pods, Services และ labels—และวิธีที่สิ่งเหล่านี้หล่อหลอมแพลตฟอร์มแอปสมัยใหม่

Joe Beda เป็นหนึ่งในคนสำคัญที่อยู่เบื้องหลังการออกแบบ Kubernetes ยุคแรก—ร่วมกับผู้ก่อตั้งคนอื่น ๆ ที่นำบทเรียนจากระบบภายในของ Google มาสู่แพลตฟอร์มแบบเปิด ผลกระทบของเขาไม่ได้อยู่ที่การตามหาฟีเจอร์ฮิต แต่เป็นการเลือก primitive ที่เรียบง่ายซึ่งทนต่อความยุ่งเหยิงในสภาพแวดล้อมการผลิตจริง และ ยังคงเข้าใจได้โดยทีมทั่วไป

การตัดสินใจในตอนแรกเหล่านี้คือเหตุผลที่ Kubernetes กลายเป็นมากกว่า "เครื่องมือคอนเทนเนอร์" มันกลายเป็นเคอร์เนลที่นำกลับมาใช้ใหม่ได้สำหรับแพลตฟอร์มแอปสมัยใหม่

“การออร์เคสตราคอนเทนเนอร์” คือชุดกฎและการอัตโนมัติที่ทำให้แอปของคุณยังรันได้เมื่อเครื่องล้ม, ปริมาณทราฟฟิคพุ่งขึ้น, หรือคุณปล่อยเวอร์ชันใหม่ แทนที่จะให้คนคอยดูแลเซิร์ฟเวอร์ ระบบจะจัดตารางคอนเทนเนอร์ไปยังคอมพิวเตอร์ รีสตาร์ทเมื่อพวกมันล้ม กระจายเพื่อความทนทาน และจัดการเครือข่ายเพื่อให้ผู้ใช้เข้าถึงได้

ก่อนที่ Kubernetes จะเป็นที่นิยม ทีมมักจะต่อเครื่องมือสคริปต์และเครื่องมือเฉพาะทางเข้าด้วยกันเพื่อแก้คำถามพื้นฐาน:

ระบบ DIY เหล่านั้นใช้งานได้—จนกระทั่งไม่ใช่ ทุกแอปหรือทีมใหม่เพิ่มโลจิกจุดเดียว และความสอดคล้องด้านการปฏิบัติการก็ยากที่จะทำให้เกิดขึ้น

บทความนี้จะอธิบายการตัดสินใจการออกแบบ Kubernetes ตอนต้น (“รูปทรง” ของ Kubernetes) และเหตุผลที่สิ่งเหล่านี้ยังมีผลต่อแพลตฟอร์มสมัยใหม่: โมเดลเชิงประกาศ, controllers, Pods, labels, Services, API ที่แข็งแกร่ง, สถานะคลัสเตอร์ที่สอดคล้อง, การจัดตารางแบบ pluggable และความสามารถขยายได้ แม้คุณจะไม่รัน Kubernetes โดยตรง คุณก็น่าจะใช้แพลตฟอร์มที่สร้างบนแนวคิดเหล่านี้—หรือกำลังเจอปัญหาเดียวกัน

ก่อน Kubernetes “การรันคอนเทนเนอร์” มักหมายถึงการรันไม่กี่คอนเทนเนอร์ ทีมต่อ bash scripts, cron jobs, golden images และเครื่องมือเฉพาะเพื่อให้สิ่งต่าง ๆ ถูกปรับใช้งาน เมื่อมีปัญหา การแก้ไขมักอยู่ในหัวของใครบางคน—หรือใน README ที่ไม่มีใครไว้ใจ งานปฏิบัติการคือการแทรกแซงเฉพาะหน้า: รีสตาร์ทกระบวนการ เปลี่ยนปลายทาง load balancer ทำความสะอาดดิสก์ และเดาว่าเครื่องไหนปลอดภัยที่จะเข้าไปแตะ

คอนเทนเนอร์ทำให้การแพ็กเกจง่ายขึ้น แต่ไม่ได้ลบส่วนที่ยุ่งยากของการผลิตออกไป เมื่อขยายขนาด ระบบจะล้มเหลวในหลายรูปแบบและบ่อยขึ้น: โหนดหาย เครือข่ายแบ่ง พิมพ์อิมเมจถูกปล่อยไม่สม่ำเสมอ และงานเปลี่ยนจากสิ่งที่คุณ คิดว่า รันอยู่ การปรับใช้ที่ดู “เรียบง่าย” อาจกลายเป็นโดมิโน—บางอินสแตนซ์อัปเดต บางตัวไม่, บางอันติดค้าง, บางอันยังดีแต่เข้าถึงไม่ได้

ปัญหาจริงไม่ใช่การเริ่มคอนเทนเนอร์ แต่คือการรักษาให้คอนเทนเนอร์ ที่ถูกต้อง ทำงานใน รูปร่างที่ถูกต้อง ท่ามกลางการเปลี่ยนแปลงอย่างต่อเนื่อง

ทีมต้องจัดการกับสภาพแวดล้อมที่ต่างกัน: ฮาร์ดแวร์ on‑prem, VMs, ผู้ให้บริการคลาวด์ยุคแรก และการตั้งค่าเครือข่ายและสตอเรจที่หลากหลาย แพลตฟอร์มแต่ละแห่งมีศัพท์และรูปแบบการล้มเหลวของตัวเอง โดยไม่มีโมเดลร่วม การย้ายแต่ละครั้งหมายถึงการเขียนเครื่องมือปฏิบัติการใหม่และฝึกคนใหม่

Kubernetes ตั้งใจจะให้วิธีการอธิบายแอปและความต้องการปฏิบัติการแบบเดียวกัน โดยไม่คำนึงว่าเครื่องจะอยู่ที่ไหน

นักพัฒนาต้องการ self-service: ปรับใช้โดยไม่ต้องขอชั่วตั๋ว, ขยายโดยไม่ต้องขอทรัพยากร และย้อนกลับโดยไม่มีดราม่า ทีม ops ต้องการความคาดเดาได้: การตรวจสุขภาพมาตรฐาน, การปรับใช้งานซ้ำได้, และแหล่งข้อมูลความจริงชัดเจนว่าควรจะรันอะไร

Kubernetes ไม่ได้พยายามเป็นเพียง scheduler หรู มันต้องการเป็นพื้นฐานของแพลตฟอร์มแอปที่เชื่อถือได้—ซึ่งเปลี่ยนความยุ่งเหยิงให้เป็นระบบที่คุณสามารถอธิบายเหตุผลได้

หนึ่งในการเลือกที่มีอิทธิพลตั้งแต่ต้นคือการทำให้ Kubernetes เป็นเชิงประกาศ: คุณอธิบายสิ่งที่ต้องการ แล้วระบบก็ทำให้ความจริงตรงกับคำอธิบายนั้น

เทอร์โมสตัทเป็นตัวอย่างประจำวันที่ดี คุณไม่ต้องเปิดปิดฮีตเตอร์ทุกไม่กี่นาที คุณตั้งอุณหภูมิที่ต้องการ—เช่น 21°C—แล้วเทอร์โมสตัทจะคอยตรวจและปรับฮีตเตอร์ให้ใกล้เคียงเป้าหมายนั้น

Kubernetes ทำงานในลักษณะเดียวกัน แทนที่จะบอกคลัสเตอร์ทีละขั้นตอนว่า “เริ่มคอนเทนเนอร์นี้บนเครื่องนั้น แล้วรีสตาร์ทถ้ามันล้ม” คุณประกาศผลลัพธ์: “ฉันต้องการให้รันแอปนี้ 3 สำเนา” Kubernetes จะตรวจสอบสิ่งที่รันจริงอย่างต่อเนื่องและแก้ไขการเบี่ยงเบน

การคอนฟิกเชิงประกาศลดเช็คลิสต์การปฏิบัติการที่มักซ่อนอยู่ในหัวของใครบางคนหรือใน runbook ที่อัปเดตไม่ครบ คุณนำคอนฟิกไปใช้ และ Kubernetes จัดการกลไก—การจัดวาง การรีสตาร์ท และการประสานการเปลี่ยนแปลง

นี่ยังทำให้การตรวจทานการเปลี่ยนแปลงง่ายขึ้น เพราะการเปลี่ยนแปลงปรากฏเป็น diff ของคอนฟิก ไม่ใช่ชุดคำสั่งแบบ ad-hoc

เพราะ desired state ถูกเขียนลง คุณสามารถนำแนวทางเดียวกันไปใช้ใน dev, staging และ production ได้ สภาพแวดล้อมอาจต่างกัน แต่ เจตนา ยังคงเหมือนกัน ซึ่งทำให้การปรับใช้งานคาดเดาได้และตรวจสอบได้ง่ายขึ้น

ระบบเชิงประกาศมีแนวโน้มที่จะต้องเรียนรู้: คุณต้องคิดเป็น “อะไรที่ควรจะเป็นจริง” แทนที่จะเป็น “ฉันต้องทำอะไรทีถัดไป” และพวกมันขึ้นกับค่าเริ่มต้นที่ดีและคอนเวนชันที่ชัดเจน—หากไม่มี ทีมอาจสร้างคอนฟิกที่ทำงานได้แต่เข้าใจและดูแลยาก

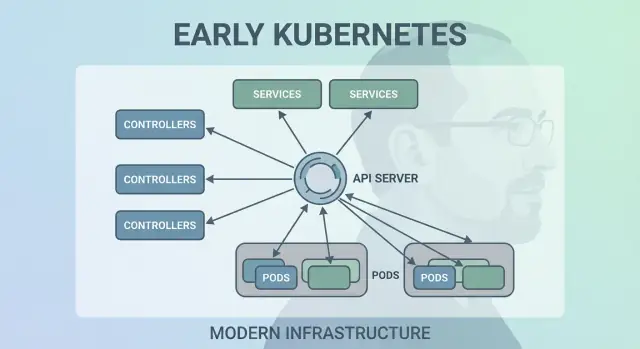

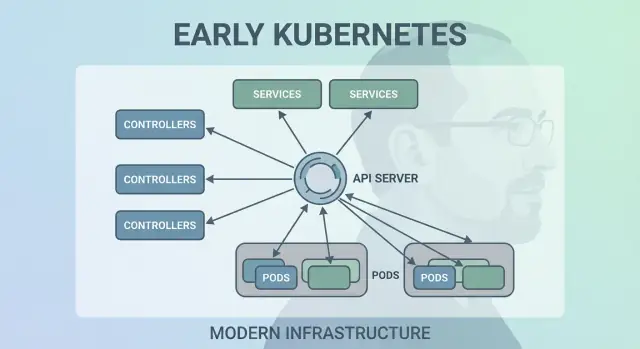

Kubernetes ไม่ประสบความสำเร็จเพราะมันสามารถรันคอนเทนเนอร์ได้ครั้งหนึ่ง—แต่มันประสบความสำเร็จเพราะมันสามารถทำให้คอนเทนเนอร์รันได้อย่างถูกต้องตลอดเวลา การเคลื่อนไหวสำคัญคือการทำให้ “control loops” (controllers) เป็นแกนหลักของระบบ

Controller คือวงจรง่าย ๆ:

มันไม่ใช่เหมือนงานครั้งเดียว แต่เหมือน autopilot คุณไม่ต้องคอยดูแล workloads; คุณประกาศสิ่งที่ต้องการและ controllers จะคอยปรับคลัสเตอร์กลับสู่ผลลัพธ์นั้น

รูปแบบนี้คือเหตุผลที่ Kubernetes ทนเมื่อสิ่งจริงเกิดปัญหา:

แทนที่จะมองความล้มเหลวเป็นกรณีพิเศษ controllers มองเป็น “ความไม่ตรงกันของสถานะ” แล้วแก้เหมือนกันทุกครั้ง

สคริปต์อัตโนมัติโบราณมักสมมติว่าสภาพแวดล้อมคงที่: ทำ A แล้ว B แล้ว C ในระบบกระจาย การสมมติเหล่านั้นพังบ่อย Controllers สเกลได้ดีกว่าเพราะพวกมัน idempotent (ปลอดภัยเมื่อรันซ้ำ) และ eventually consistent (จะพยายามจนกว่าจะถึงเป้าหมาย)

ถ้าคุณใช้ Deployment คุณก็พึ่งพา control loops ใต้ผิว Kubernetes ใช้ controller ของ ReplicaSet เพื่อให้จำนวน pods ที่ร้องขอมีอยู่จริง—และมี Deployment controller เพื่อจัดการ rolling updates และ rollback อย่างคาดเดาได้

Kubernetes อาจจะเลือกจัดตารางเฉพาะ “คอนเทนเนอร์” แต่ทีมของ Joe Beda แนะนำ Pods ให้เป็นหน่วยที่เล็กที่สุดที่ระบบจะวางบนเครื่อง ความคิดสำคัญคือ: แอปจริงหลายตัวไม่ใช่กระบวนการเดียว แต่เป็น กลุ่มเล็ก ๆ ของกระบวนการที่ต้องอยู่ด้วยกัน

Pod เป็นตัวห่อรอบหนึ่งหรือหลายคอนเทนเนอร์ที่มีชะตากรรมร่วมกัน: เริ่มพร้อมกัน รันบนโหนดเดียวกัน และ scale ด้วยกัน นี่ทำให้แพตเทิร์นอย่าง sidecars เป็นเรื่องธรรมชาติ—คิดถึง log shipper, proxy, reloader หรือเอเจนต์ความปลอดภัยที่ควรเดินไปกับแอปหลักเสมอ

แทนที่จะสอนให้ทุกแอปรวมตัวช่วยเหล่านั้นเข้าด้วยกัน Kubernetes ให้คุณบรรจุพวกมันเป็นคอนเทนเนอร์แยกต่างหากที่ยังทำงานร่วมกันเหมือนหน่วยเดียว

Pods ทำให้ข้อสมมติสองอย่างเป็นไปได้:

localhost ซึ่งเรียบง่ายและเร็วการเลือกเหล่านี้ลดความจำเป็นในการเขียนโค้ดเชื่อมต่อเฉพาะทาง ในขณะที่ยังคงแยกคอนเทนเนอร์ในระดับกระบวนการ

ผู้ใช้ใหม่มักคาดหวังว่า “คอนเทนเนอร์หนึ่งตัว = แอปหนึ่งตัว” แล้วสะดุดกับแนวคิดระดับ Pod: การรีสตาร์ท, IP และการสเกล หลายแพลตฟอร์มจะทำให้เรื่องนี้เรียบง่ายด้วยเทมเพลตมีความเห็นชอบ (เช่น “web service,” “worker,” หรือ “job”) ที่สร้าง Pods อยู่เบื้องหลัง—ทำให้ทีมได้รับประโยชน์จาก sidecars และทรัพยากรที่แชร์โดยไม่ต้องคิดเรื่องกลไก Pod ทุกวัน

การตัดสินใจที่ทรงพลังและเงียบ ๆ ในตอนต้นคือการถือว่า labels เป็น metadata ชั้นหนึ่งและ selectors เป็นวิธีหลักในการ “ค้นหา” สิ่งต่าง ๆ แทนที่จะผูกความสัมพันธ์ไว้แน่น (เช่น “สามเครื่องนี้รันแอปของฉัน”) Kubernetes สนับสนุนให้คุณอธิบายกลุ่มโดยคุณลักษณะที่ใช้ร่วมกัน

Label คือคู่คีย์/ค่าเบา ๆ ที่คุณแนบกับทรัพยากร—Pods, Deployments, Nodes, Namespaces และอื่น ๆ มันทำหน้าที่เหมือน “แท็ก” ที่สืบค้นได้:

app=checkoutenv=prodtier=frontendเพราะ labels เบาและกำหนดโดยผู้ใช้ คุณสามารถจำลองความเป็นจริงขององค์กรมาควบคุม: ทีม, ศูนย์ต้นทุน, โซนปฏิบัติตามข้อบังคับ, ช่องทางการปล่อย, หรือสิ่งที่สำคัญต่อวิธีการปฏิบัติการของคุณ

Selectors คือการสืบค้นบน labels (ตัวอย่างเช่น “Pod ทั้งหมดที่ app=checkout และ env=prod”) นี่ดีกว่าการใช้รายการโฮสต์คงที่เพราะระบบสามารถปรับเมื่อ Pods ถูกย้าย สเกลขึ้น/ลง หรือถูกแทนที่ระหว่าง rollout คอนฟิกของคุณจะคงที่แม้ว่าตัวอย่างด้านล่างจะเปลี่ยนไปตลอดเวลา

การออกแบบนี้สเกลในเชิงปฏิบัติการ: คุณไม่ต้องจัดการตัวตนของหลายพันอินสแตนซ์—คุณจัดการชุดป้ายไม่กี่ชุดที่มีความหมาย นี่คือแก่นของการผูกแบบหลวม: คอมโพเนนต์เชื่อมต่อกับ กลุ่ม ที่สามารถเปลี่ยนสมาชิกได้อย่างปลอดภัย

เมื่อ labels มีอยู่ มันกลายเป็นคำศัพท์ร่วมกันในแพลตฟอร์ม พวกมันถูกใช้สำหรับการกำหนดเส้นทางทราฟฟิค (Services), ขอบเขตนโยบาย (NetworkPolicy), ตัวกรองการสังเกตการณ์ (metrics/logs), และแม้กระทั่งการติดตามต้นทุนและการคิดค่าใช้จ่าย แนวคิดง่าย ๆ เดียว—ติดแท็กสิ่งต่าง ๆ ให้สม่ำเสมอ—ปลดล็อกระบบอัตโนมัติทั้งระบบ

Kubernetes ต้องการวิธีทำให้เครือข่ายรู้สึกคาดเดาได้แม้ว่าคอนเทนเนอร์จะไม่คงที่ Pods ถูกแทนที่ ย้ายที่ และสเกลขึ้น/ลง—ดังนั้น IP และเครื่องที่รันจะเปลี่ยนได้ ความคิดหลักของ Service คือ: ให้ประตูหน้า (front door) คงที่ไปยังชุด Pod ที่เปลี่ยนแปลงได้

Service ให้ IP เสมือนและชื่อ DNS คงที่ (เช่น payments) Kubernetes จะติดตาม Pod ที่ตรงกับ selector ของ Service อยู่ตลอดและส่งทราฟฟิคไปยังพวกมัน ถ้า Pod ตายและมี Pod ใหม่ปรากฏ Service จะยังชี้ไปยังจุดหมายที่ถูกต้องโดยไม่ต้องเปลี่ยนการตั้งค่าของแอป

แนวทางนี้ลดการต่อสายด้วยมือหลายอย่าง แทนที่จะฝัง IP ลงในไฟล์คอนฟิก แอปสามารถพึ่งพาชื่อได้ คุณปรับใช้แอป ปรับใช้ Service แล้วคอมโพแนนต์อื่นสามารถค้นหาผ่าน DNS—ไม่ต้องมีรีจิสทรีเฉพาะ ไม่ต้องตั้ง endpoints แบบคงที่

Services ยังแนะนำพฤติกรรมการกระจายโหลดพื้นฐานข้าม endpoints ที่พร้อมใช้งาน นั่นหมายความว่าทีมไม่ต้องสร้าง (หรือสร้างใหม่) load balancer สำหรับไมโครเซอร์วิสภายในแต่ละตัว การกระจายทราฟฟิคลดผลกระทบจากความล้มเหลวของ Pod เดียวและทำให้การอัปเดตแบบหมุนเวียนมีความเสี่ยงน้อยลง

Service ดีสำหรับทราฟฟิค L4 (TCP/UDP) แต่ไม่จำลองกฎการกำหนดเส้นทาง HTTP, การยุติ TLS, หรือโพลิซีที่ขอบ นั่นคือที่ที่ Ingress และ, ในปัจจุบัน, Gateway API เข้ามา: พวกมันวางอยู่บน Services เพื่อจัดการ hostnames, paths, และจุดเข้าออกภายนอกได้สะอาดขึ้น

หนึ่งในการเลือกที่ค่อนข้างปฏิวัติในตอนต้นคือการปฏิบัติ Kubernetes เป็น API ที่คุณสร้างต่อ—ไม่ใช่เครื่องมือโมโนลิธที่คุณ "ใช้" การยึด API เป็นหัวใจทำให้ Kubernetes รู้สึกน้อยกว่าเป็นผลิตภัณฑ์ที่คลิกผ่าน และมากกว่าเป็นแพลตฟอร์มที่คุณสามารถขยาย เขียนสคริปต์ และควบคุมได้

เมื่อ API เป็นพื้นผิว ทีมแพลตฟอร์มสามารถทำมาตรฐานใน วิธี ที่แอปถูกอธิบายและจัดการ โดยไม่ขึ้นกับ UI, pipeline, หรือพอร์ทัลภายในที่วางอยู่ด้านบน “การปรับใช้แอป” กลายเป็น “การส่งและอัปเดตวัตถุ API” (เช่น Deployments, Services, ConfigMaps) ซึ่งเป็นสัญญาที่สะอาดกว่าระหว่างทีมแอปและแพลตฟอร์ม

เพราะทุกอย่างผ่าน API เดียวกัน การสร้างเครื่องมือใหม่ไม่จำเป็นต้องมี backdoor ที่มีสิทธิพิเศษ แดชบอร์ด, GitOps controllers, engines นโยบาย, และระบบ CI/CD สามารถทำงานเป็นไคลเอนต์ API ปกติโดยมีสิทธิจำกัดอย่างเหมาะสม

ความสมมาตรนี้สำคัญ: กฎ เดียวกัน การพิสูจน์ตัวตน การตรวจสอบ และ admission controls ใช้ได้ไม่ว่าจะเป็นคำขอจากคน สคริปต์ หรือ UI ภายใน

การเวอร์ชัน API ทำให้สามารถพัฒนา Kubernetes โดยไม่ทำลายคลัสเตอร์หรือเครื่องมือทั้งหมดในชั่วข้ามคืน การยกเลิกใช้งานสามารถทำเป็นลำดับขั้น; ความเข้ากันได้สามารถทดสอบ; การอัปเกรดสามารถวางแผน สำหรับองค์กรที่รันคลัสเตอร์มาหลายปี นี่คือความแตกต่างระหว่าง “เราสามารถอัปเกรดได้” กับ “เราติดอยู่"

kubectl แสดงอะไรจริง ๆkubectl ไม่ใช่ Kubernetes—มันเป็น ลูกค้า หนึ่งตัว แบบคิดนี้ผลักดันให้ทีมคิดเป็นเวิร์กโฟลว์ API: คุณสามารถสลับ kubectl กับการอัตโนมัติ, เว็บ UI, หรือพอร์ทัลเฉพาะของคุณ และระบบยังคงสอดคล้องเพราะสัญญาคือ API เอง

Kubernetes ต้องการ “แหล่งความจริง” เดียวว่าคลัสเตอร์ควรมีหน้าตาอย่างไรตอนนี้: Pod ไหนมีอยู่ โหนดไหนมีสุขภาพดี Service ชี้ไปที่ไหน และวัตถุใดกำลังอัปเดต นั่นคือสิ่งที่ etcd ให้มา

etcd คือฐานข้อมูลของ control plane. เมื่อคุณสร้าง Deployment, ปรับขนาด ReplicaSet, หรืออัปเดต Service การกำหนดค่าที่ต้องการจะถูกเขียนลงใน etcd controllers และองค์ประกอบ control-plane อื่น ๆ จะเฝ้าดูสถานะที่เก็บไว้และพยายามทำให้ความจริงตรงกับมัน

คลัสเตอร์ Kubernetes เต็มไปด้วยส่วนที่เคลื่อนไหว: scheduler, controllers, kubelets, autoscalers, และ admission checks ต่างก็สามารถตอบสนองพร้อมกัน หากพวกเขาอ่านเวอร์ชันที่ต่างกันของ “ความจริง” คุณจะได้การแข่งขัน—เช่น สององค์ประกอบตัดสินใจขัดแย้งเกี่ยวกับ Pod เดียวกัน

ความสอดคล้องเข้มแข็งของ etcd ทำให้เมื่อ control plane บอกว่า “นี่คือสถานะปัจจุบัน” ทุกคนตรงกัน การสอดคล้องนั้นคือสิ่งที่ทำให้ control loops คาดเดาได้แทนที่จะเป็นความโกลาหล

เพราะ etcd ถือการกำหนดค่าคลัสเตอร์และประวัติการเปลี่ยนแปลง มันจึงเป็นสิ่งที่คุณต้องปกป้องเมื่อ:

ปฏิบัติต่อสถานะ control-plane เหมือนข้อมูลสำคัญ จัดทำ สแนปชอต etcd เป็นประจำ ทดสอบการคืนค่า และเก็บสำรองนอกคลัสเตอร์ หากคุณใช้ Kubernetes แบบมีผู้ให้บริการ จงเรียนรู้ว่าผู้ให้บริการสำรองอะไรให้—และอะไรที่คุณยังต้องสำรองเอง (เช่น persistent volumes และข้อมูลระดับแอป)

Kubernetes ไม่มองว่า “จะรันวอร์กโหลดที่ไหน” เป็นเรื่องรอง ตั้งแต่ต้น scheduler ถูกแยกเป็นคอมโพเนนต์ที่ชัดเจนด้วยงานหนึ่ง: จับคู่ Pods กับโหนดที่สามารถรันพวกมันได้ โดยใช้สถานะคลัสเตอร์ปัจจุบันและความต้องการของ Pod

ในภาพรวม การจัดตารางคือการตัดสินใจสองขั้น:

โครงสร้างนี้ทำให้สามารถพัฒนา scheduling ของ Kubernetes ต่อไปได้โดยไม่ต้องเขียนใหม่ทั้งหมด

การตัดสินใจสำคัญคือการเก็บความรับผิดชอบให้ชัดเจน:

เพราะความรับผิดชอบถูกแยก การปรับปรุงในด้านหนึ่ง (เช่น plugin CNI ใหม่) จะไม่บังคับให้เปลี่ยนโมเดล scheduling

การรับรู้ทรัพยากรเริ่มจาก requests และ limits ให้สัญญาณที่มีความหมายแก่ scheduler แทนการเดา จากนั้น Kubernetes เพิ่มการควบคุมที่ร่ำรวยขึ้น—node affinity/anti-affinity, pod affinity, priorities and preemption, taints and tolerations, และการกระจายตาม topology—สร้างบนรากฐานเดียวกัน

แนวทางนี้ช่วยให้เกิดคลัสเตอร์ที่แชร์กันในปัจจุบัน: ทีมสามารถแยกบริการสำคัญด้วย priorities และ taints ขณะเดียวกันทุกคนก็ได้ประโยชน์จากการใช้ทรัพยากรที่สูงขึ้น ด้วยการจัดบรรจุที่ดีขึ้นและการควบคุม topology แพลตฟอร์มสามารถวางวอร์กโหลดได้คุ้มค่ากว่าโดยไม่แลกกับความน่าเชื่อถือ

Kubernetes อาจส่งมาพร้อมประสบการณ์แพลตฟอร์มที่เต็มรูปแบบ—buildpacks, กฎการกำหนดเส้นทางแอป, งานพื้นหลัง, ขนบในการตั้งค่า ฯลฯ แต่ Joe Beda และทีมตอนแรกเลือกให้ core มุ่งสัญญาที่เล็กกว่า: รันและซ่อมแซมวอร์กโหลดอย่างน่าเชื่อถือ เปิดเผยพวกมัน และให้ API สอดคล้องเพื่ออัตโนมัติ

PaaS ที่สมบูรณ์จะบังคับเวิร์กโฟลว์เดียวและชุดการแลกเปลี่ยนหนึ่งชุดแก่ทุกคน Kubernetes มุ่งสู่พื้นฐานที่กว้างกว่าเพื่อรองรับสไตล์แพลตฟอร์มหลากหลาย—แบบง่ายเหมือน Heroku, การกำกับดูแลองค์กร, pipeline สำหรับ batch + ML, หรือการควบคุมโครงสร้างพื้นฐานแบบเปลือย—โดยไม่ล็อกอินสู่ปรัชญาผลิตภัณฑ์เดียว

กลไกการขยายของ Kubernetes สร้างวิธีการที่ควบคุมได้ในการเติบโตความสามารถ:

Certificate หรือ Database) ที่มีความรู้สึกเหมือนเนทีฟนั่นหมายความว่าทีมแพลตฟอร์มภายในและผู้ขายสามารถส่งมอบฟีเจอร์เป็น add-on ขณะที่ยังใช้ primitives ของ Kubernetes เช่น RBAC, namespaces, และ audit logs

สำหรับผู้ขาย มันทำให้สามารถสร้างผลิตภัณฑ์แตกต่างกันโดยไม่ต้องแตกโค้ด Kubernetes สำหรับทีมภายใน มันเปิดทางให้ “แพลตฟอร์มบน Kubernetes” ที่ปรับแต่งได้ตามความต้องการองค์กร

ข้อแลกเปลี่ยนคือการกระจายของระบบนิเวศ: CRDs มากเกินไป, เครื่องมือทับซ้อน, และขนบปฏิบัติที่ไม่สอดคล้องกัน การกำกับดูแล—มาตรฐาน ความเป็นเจ้าของ การเวอร์ชัน และกฎการยกเลิก—กลายเป็นงานส่วนหนึ่งของการสร้างแพลตฟอร์ม

การเลือกตั้งต้นของ Kubernetes ไม่ได้สร้างเพียง scheduler คอนเทนเนอร์—แต่สร้าง เคอร์เนลแพลตฟอร์ม ที่นำกลับมาใช้ได้ นั่นคือเหตุผลที่แพลตฟอร์มพัฒนาภายในสมัยใหม่ (IDPs) หลายแห่งมีแกนกลางเป็น “Kubernetes บวกเวิร์กโฟลว์ที่มีความเห็นชอบ” โมเดลเชิงประกาศ controllers และ API ที่สอดคล้องกันทำให้เป็นไปได้สร้างผลิตภัณฑ์ระดับสูงขึ้นโดยไม่ต้องคิดใหม่เรื่องการปรับใช้ การประสาน และการค้นหาระบบทุกครั้ง

เพราะ API คือพื้นผิวผลิตภัณฑ์ ผู้ขายและทีมแพลตฟอร์มสามารถทำมาตรฐานบน control plane เดียวและสร้างประสบการณ์ต่าง ๆ บนมัน: GitOps, การจัดการหลายคลัสเตอร์, นโยบาย, service catalogs, และการอัตโนมัติการปรับใช้ นี่เป็นเหตุผลสำคัญที่ Kubernetes กลายเป็นตัวส่วนร่วมสำหรับแพลตฟอร์ม cloud native: การผสานรวมมุ่งเป้าที่ API ไม่ใช่ UI ใด UI หนึ่ง

แม้จะมีนามธรรมที่ชัดเจน งานที่ยากที่สุดยังคงเป็นการปฏิบัติการ:

ถามคำถามที่เปิดเผยความพร้อมปฏิบัติการ:

แพลตฟอร์มที่ดีลดภาระทางความคิดโดยไม่ซ่อน control plane พื้นฐานหรือทำให้ทางหนี (escape hatches) ยาก

เลนส์ปฏิบัติหนึ่ง: แพลตฟอร์มช่วยให้ทีมเปลี่ยนจาก “ไอเดีย → บริการที่รันอยู่” ได้โดยไม่บังคับให้ทุกคนเป็นผู้เชี่ยวชาญ Kubernetes ตั้งแต่วันแรกหรือไม่? เครื่องมือในกลุ่ม “vibe-coding”—เช่น Koder.ai—เน้นในจุดนี้โดยให้ทีมสร้างแอปจริงจากการแชท (เว็บใน React, backend ใน Go กับ PostgreSQL, มือถือใน Flutter) แล้ววนรอบอย่างรวดเร็วด้วยฟีเจอร์อย่างโหมดวางแผน, สแนปชอต, และการย้อนกลับ ไม่ว่าคุณจะเลือกเครื่องมือแบบนั้นหรือสร้างพอร์ทัลของตัวเอง เป้าหมายก็เหมือนกัน: รักษา primitives ที่แข็งแกร่งของ Kubernetes ในขณะลดภาระเวิร์กโฟลว์รอบ ๆ พวกมัน

Kubernetes อาจดูซับซ้อน แต่ความประหลาดใจส่วนใหญ่ของมันเป็นเรื่องมีเจตนา: มันคือชุด primitive เล็ก ๆ ที่ออกแบบมาให้ประกอบกันเป็นแพลตฟอร์มหลายรูปแบบ

แรก: “Kubernetes คือแค่การออร์เคสตรา Docker.” Kubernetes ไม่ได้หมายถึงการเริ่มคอนเทนเนอร์เป็นหลัก แต่มันคือการประสาน desired state (สิ่งที่คุณต้องการให้รัน) กับ actual state (สิ่งที่รันจริง) ต่อหน้าความล้มเหลว การ rollout และความต้องการที่เปลี่ยนแปลง

ที่สอง: “ถ้าเราใช้ Kubernetes ทุกอย่างจะกลายเป็น microservices.” Kubernetes รองรับ microservices แต่ก็รองรับ monoliths, batch jobs, และแพลตฟอร์มภายใน หน่วยต่าง ๆ (Pods, Services, labels, controllers, และ API) เป็นกลาง; การตัดสินใจสถาปัตยกรรมของคุณไม่ได้ถูกบังคับโดยเครื่องมือ

ส่วนที่ยากมักไม่ใช่ YAML หรือ Pods—แต่เป็น เครือข่าย ความปลอดภัย และการใช้งานโดยหลายทีม: ตัวตนและการเข้าถึง, การจัดการความลับ, นโยบาย, ingress, การสังเกตการณ์, การควบคุม supply-chain, และการสร้าง guardrails เพื่อให้ทีมส่งมอบอย่างปลอดภัยโดยไม่ขัดกัน

เมื่อวางแผน คิดในเชิงเดิมพันการออกแบบเดิม:

แมปความต้องการจริงของคุณไปยัง primitives และเลเยอร์แพลตฟอร์มของ Kubernetes:

Workloads → Pods/Deployments/Jobs

Connectivity → Services/Ingress

Operations → controllers, นโยบาย, และการสังเกตการณ์

ถ้าคุณกำลังประเมินหรือนำมาตรฐานมาใช้ ให้เขียนแผนที่นี้ลงแล้วทบทวนกับผู้มีส่วนได้ส่วนเสีย—แล้วสร้างแพลตฟอร์มของคุณทีละส่วนตามช่องว่าง ไม่ใช่ตามเทรนด์

ถ้าคุณต้องการเร่งด้านการ “สร้าง” ไม่ใช่แค่การ “รัน” ให้คิดว่าเวิร์กโฟลว์การส่งมอบของคุณเปลี่ยนเจตนาเป็นบริการที่ปรับใช้ได้อย่างไร สำหรับบางทีมคือชุดเทมเพลตที่คัดสรรไว้; สำหรับบางทีมคือเวิร์กโฟลว์ที่ช่วยด้วย AI อย่าง Koder.ai ที่สามารถสร้างบริการพื้นฐานได้อย่างรวดเร็วแล้วส่งออกซอร์สโค้ดเพื่อปรับแต่งต่อ—ขณะที่แพลตฟอร์มของคุณยังคงได้ประโยชน์จากการตัดสินใจเชิงออกแบบของ Kubernetes ข้างใต้

Container orchestration คือการอัตโนมัติที่ทำให้แอปยังรันได้เมื่อเครื่องล้มเหลว ปริมาณทราฟฟิคเปลี่ยน หรือเกิดการปรับใช้ ในทางปฏิบัติจะจัดการ:

Kubernetes ทำให้เกิดโมเดลที่สอดคล้องกันสำหรับการทำงานเหล่านี้ข้ามสภาพแวดล้อมโครงสร้างพื้นฐานที่ต่างกัน.

ปัญหาหลักไม่ใช่การเริ่มคอนเทนเนอร์—แต่เป็นการรักษาให้คอนเทนเนอร์ที่ ถูกต้อง ทำงานในรูปร่างที่ ถูกต้อง ท่ามกลางการเปลี่ยนแปลงอย่างต่อเนื่อง ที่ระดับใหญ่ระบบจะล้มเหลวเป็นประจำและเกิดการเบี่ยงเบนจากสถานะที่คาดไว้ เช่น:

Kubernetes มุ่งหมายที่จะทำให้งานปฏิบัติการทำซ้ำได้และคาดการณ์ได้ด้วยการให้ control plane และศัพท์กลางที่เป็นมาตรฐาน.

ในระบบแบบ declarative คุณอธิบาย ผลลัพธ์ ที่ต้องการ (เช่น “ให้รัน 3 สำเนา”) แล้วระบบจะทำงานอย่างต่อเนื่องเพื่อให้ความจริงตรงกับความต้องการ

เวิร์กโฟลว์เชิงปฏิบัติ:

kubectl apply หรือ GitOps)นี่ช่วยลด “เช็คลิสต์ที่ซ่อนอยู่” และทำให้การเปลี่ยนแปลงตรวจสอบได้เป็น diff แทนคำสั่งแบบ ad-hoc.

Controllers เป็นลูปควบคุมที่ทำซ้ำ:

การออกแบบนี้ทำให้ความผิดพลาดทั่วไปกลายเป็นเรื่องปกติแทนที่จะเป็นกรณีพิเศษ ตัวอย่างเช่น ถ้า Pod ล้มเหลวหรือโหนดหาย ตัว controller ที่เกี่ยวข้องก็จะเห็นว่า “เรามีสำเนาน้อยกว่าที่ต้องการ” และสร้างตัวทดแทนขึ้นมาเอง.

Kubernetes ทำการจัดตารางเป็น Pod (ไม่ใช่คอนเทนเนอร์เดี่ยว) เพราะหลายงานจริงต้องการกระบวนการช่วยเหลือที่อยู่ใกล้เคียงกัน

Pods อำนวยความสะดวกให้รูปแบบเช่น:

localhost ระหว่างคอนเทนเนอร์)กฎง่าย ๆ: รวมคอนเทนเนอร์เฉพาะที่ต้องแชร์วงจรชีวิต ตัวตนเครือข่าย หรือข้อมูลท้องถิ่นเข้าด้วยกันเท่านั้น.

Labels เป็นแท็ก key/value เบา ๆ (เช่น app=checkout, env=prod) ในขณะที่ selectors คือการสืบค้นจากป้ายเหล่านั้นเพื่อสร้างกลุ่มแบบไดนามิก

สิ่งนี้สำคัญเพราะตัวอย่างนั้นมีชีวิตสั้น: Pods เกิดและหายไประหว่างการย้ายและ rollout ด้วย labels/selectors ความสัมพันธ์ยังคงคงตัว (“Pod ทั้งหมดที่มีป้ายเหล่านี้”) แม้ว่าสมาชิกจะเปลี่ยนไป

เคล็ดลับเชิงปฏิบัติ: กำหนด taxonomy ป้ายเล็ก ๆ (app, team, env, tier) และบังคับใช้ด้วยนโยบายเพื่อหลีกเลี่ยงความสับสนในภายหลัง.

Service ให้ IP เสมือนและชื่อ DNS ที่คงที่ซึ่งชี้ไปยังกลุ่ม Pod ที่เปลี่ยนแปลงได้ตาม selector

ใช้ Service เมื่อ:

สำหรับการกำหนดเส้นทาง HTTP, การยุติ TLS และกฎ edge มักจะวาง Ingress หรือ Gateway API บน Services อีกชั้นหนึ่ง.

Kubernetes มอง API เป็นพื้นผิวผลิตภัณฑ์หลัก: ทุกอย่างเป็นวัตถุ API (Deployments, Services, ConfigMaps ฯลฯ) เครื่องมือทั้งหลาย—รวมถึง kubectl, CI/CD, GitOps, dashboard—เป็นแค่ไคลเอนต์ API

ประโยชน์เชิงปฏิบัติ:

ถ้าคุณกำลังสร้างแพลตฟอร์มภายใน ให้วางเวิร์กโฟลว์บนสัญญา API แทนที่จะยึดติดกับเครื่องมือ UI ตัวใดตัวหนึ่ง.

etcd คือฐานข้อมูลของ control plane และแหล่งข้อมูลเดียวที่บอกว่าคลัสเตอร์ควรมีหน้าตาเป็นอย่างไร ตอนที่คุณสร้าง Deployment หรืออัปเดต Service การกำหนดค่าที่ต้องการจะถูกเขียนลงใน etcd และ controllers จะเฝ้ามองสถานะนั้นแล้วทำให้ความจริงตรงกับมัน

คำแนะนำเชิงปฏิบัติ:

ในบริการ Kubernetes แบบมีผู้จัดการ ให้เรียนรู้ว่าผู้ให้บริการสำรองอะไรให้คุณและอะไรที่คุณยังต้องสำรองเอง (เช่น persistent volumes และข้อมูลของแอป).

Kubernetes เก็บแกนเล็กไว้และให้คุณเพิ่มความสามารถผ่านนามธรรมขยาย:

สิ่งนี้ทำให้เกิด “แพลตฟอร์มบน Kubernetes” แต่ก็อาจนำไปสู่การกระจุกของเครื่องมือและนิสัยที่ไม่สอดคล้องกัน

พิจารณาเมื่อประเมินแพลตฟอร์ม Kubernetes:

อะไรเป็น Kubernetes มาตรฐาน กับอะไรเป็นส่วนขยายเฉพาะ?

การอัปเกรดจัดการและย้อนกลับอย่างไร?

มีการป้องกันการตั้งค่าผิดพลาดอย่างไร?

ใครรับผิดชอบ day-2 operations (observability, incident response)?