03 พ.ค. 2568·3 นาที

ทำไมการสร้างการทดสอบอัตโนมัติจึงเข้ากับตรรกะที่เขียนโดย AI

เรียนรู้ว่าทำไมการทดสอบที่สร้างอัตโนมัติเข้ากับตรรกะที่เขียนโดย AI ได้อย่างเป็นธรรมชาติ และวิธีสร้างเวิร์กโฟลว์ที่โค้ด เทสต์ และการตรวจสอบ CI พัฒนาพร้อมกัน

เรียนรู้ว่าทำไมการทดสอบที่สร้างอัตโนมัติเข้ากับตรรกะที่เขียนโดย AI ได้อย่างเป็นธรรมชาติ และวิธีสร้างเวิร์กโฟลว์ที่โค้ด เทสต์ และการตรวจสอบ CI พัฒนาพร้อมกัน

ตรรกะของแอปที่เขียนโดย AI หมายถึงส่วน "ที่ทำงานได้" ของโค้ดเบสที่ร่างขึ้นด้วยความช่วยเหลือจากผู้ช่วย: ฟังก์ชันใหม่ ฟีเจอร์เล็ก ๆ การ refactor การจัดการกรณีขอบ หรือแม้แต่การเขียนโมดูลเดิมใหม่ คุณยังเป็นคนตัดสินใจว่าจะสร้างอะไร แต่เวอร์ชันแรกของการใช้งานมักมาเร็วขึ้น—และบางครั้งมากับสมมติฐานที่คุณอาจไม่สังเกตจนกว่าจะช้ากว่า

การสร้างเทสต์อัตโนมัติคือความสามารถฝั่งการยืนยันที่เข้าคู่กัน แทนที่จะเขียนเทสต์ทุกตัวด้วยมือ เครื่องมือสามารถเสนอกรณีทดสอบและการอ้างสิทธิ์จากโค้ด สเปก หรือรูปแบบที่เรียนรู้จากบั๊กในอดีต ในทางปฏิบัติ อาจเป็นรูปแบบเช่น:

เทสต์ที่สร้างอาจชี้นำผิด: มันอาจอ้างพฤติกรรมปัจจุบันแม้ว่าพฤติกรรมนั้นจะผิด หรืออาจพลาดกฎของผลิตภัณฑ์ที่อยู่ในหัวคนหรือคอมเมนต์ของติกเก็ต นั่นคือเหตุผลที่การตรวจคนจริงสำคัญ ต้องมีคนยืนยันว่าชื่อเทสต์ การตั้งค่า และการอ้างสิทธิ์สะท้อนเจตนาจริง — ไม่ใช่แค่สิ่งที่โค้ดทำตอนนี้

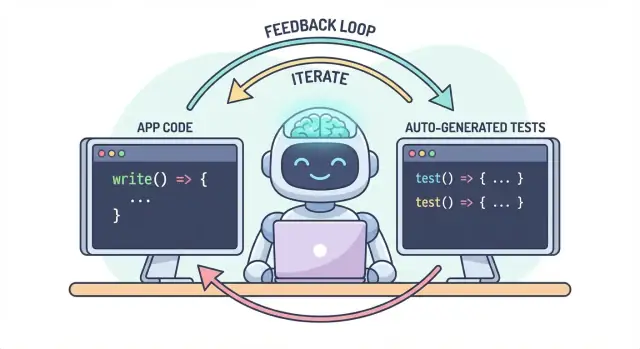

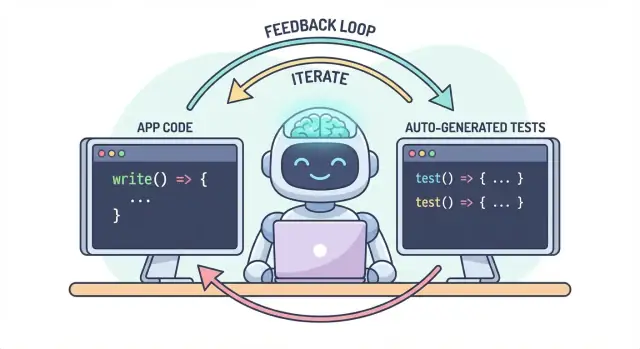

แนวคิดหลักเรียบง่าย: โค้ดและเทสต์ควรพัฒนาไปด้วยกันเป็นเวิร์กโฟลว์เดียว หาก AI ช่วยให้คุณเปลี่ยนตรรกะเร็วขึ้น การสร้างเทสต์อัตโนมัติจะช่วยล็อกพฤติกรรมที่ต้องการให้เร็วขึ้นเช่นกัน—ดังนั้นการเปลี่ยนแปลงครั้งถัดไป (โดยคนหรือ AI) จะมีคำนิยามที่ชัดเจนและรันได้ของคำว่า “ยังถูกต้อง”

ในการใช้งานจริง แนวทาง “ผลลัพธ์คู่” นี้ง่ายขึ้นเมื่อลำดับการพัฒนาของคุณขับเคลื่อนด้วยแชท ตัวอย่างเช่น ใน Koder.ai (แพลตฟอร์ม vibe-coding สำหรับสร้างเว็บ แบ็กเอนด์ และแอปมือถือผ่านแชท) ธรรมชาติการทำงานคือมอง "ฟีเจอร์ + เทสต์" เป็นสิ่งที่ส่งมอบเดียว: คุณอธิบายพฤติกรรม สร้างการใช้งาน แล้วสร้างและตรวจทานเทสต์ในวงสนทนาเดียวกันก่อนดีพลอย

โค้ดที่เขียนโดย AI ให้ความรู้สึกเหมือนพลังวิเศษ: ฟีเจอร์ปรากฏอย่างรวดเร็ว โค้ดเทมเพลตหายไป และการ refactor ที่เคยใช้เวลาหลายชั่วโมงอาจเสร็จในเวลาสั้น ความเสี่ยงเปลี่ยนรูปแบบ เมื่อโค้ดง่ายต่อการสร้าง มันก็ง่ายต่อการส่งมอบความผิดพลาด—บางครั้งเป็นความผิดพลาดที่ละเอียดอ่อน

ผู้ช่วย AI ถนัดการสร้างการใช้งานที่ “สมเหตุสมผล” แต่ “สมเหตุสมผล” ไม่เท่ากับถูกต้องสำหรับโดเมนของคุณ

กรณีขอบมักเป็นผู้เสียชีวิตแรก ตรรกะที่สร้างโดย AI มักจัดการเส้นทางปกติได้ดี แต่พลาดเงื่อนไขขอบ: อินพุตว่าง ปัญหาเขตเวลา การปัดเศษ ค่า null พฤติกรรม retry หรือสถานะที่คิดว่า “ไม่ควรเกิด” แต่เกิดในโปรดักชัน

สมมติฐานผิดเป็นปัญหาบ่อย ผู้ช่วยอาจอนุมานความต้องการที่ไม่ได้บอกไว้ (เช่น “ผู้ใช้ถูกพิสูจน์ตัวตนเสมอ” “ID เป็นตัวเลข” “ฟิลด์นี้ต้องมี”) หรืออาจใช้แพตเทิร์นที่คุ้นเคยซึ่งไม่ตรงกับกฎของระบบคุณ

การถดถอยแบบเงียบมักมีต้นทุนสูงสุด คุณขอการเปลี่ยนแปลงเล็ก ๆ ผู้ช่วยอาจเขียนตรรกะใหม่ แล้วบางอย่างที่ไม่เกี่ยวกลับพัง—โดยไม่มีข้อผิดพลาดชัดเจน โค้ดยังคอมไพล์ UI ยังโหลดได้ แต่กฎการคิดราคา การตรวจสิทธิ์ หรือการแปลงข้อมูลผิดเพี้ยนเล็กน้อย

เมื่อการเปลี่ยนแปลงโค้ดเร่งขึ้น การทดสอบด้วยมือกลายเป็นคอขวดและเป็นการเสี่ยง คุณต้องเลือก: คลิกมากขึ้น (ชะลอการส่งมอบ) หรือทดสอบน้อยลง (เพิ่มความเสี่ยง) แม้ทีม QA ที่มีวินัยก็ไม่สามารถครอบคลุมทุกตัวแปรด้วยมือได้เมื่อการเปลี่ยนแปลงบ่อยและกว้าง

ยิ่งกว่านั้น การตรวจด้วยมือยากที่จะทำซ้ำอย่างสม่ำเสมอ มันอยู่ในความจำของใครบางคนหรือเช็คลิสต์ และง่ายต่อการข้ามเมื่อตารางเวลาตึง—ซึ่งเป็นช่วงที่ความเสี่ยงสูงสุด

เทสต์อัตโนมัติสร้างตาข่ายนิรภัยถาวร: พวกมันทำให้ความคาดหวังสามารถรันได้ เทสต์ที่ดีบอกว่า “เมื่อได้รับอินพุตและบริบทนี้ ผลลัพธ์ที่เราพึ่งพาคือแบบนี้” นั่นไม่ใช่แค่การยืนยัน แต่เป็นการสื่อสารสำหรับตัวคุณในอนาคต เพื่อนร่วมทีม และแม้แต่ผู้ช่วย AI

เมื่อมีเทสต์ การเปลี่ยนแปลงไม่น่ากลัวเพราะการตอบกลับจะมาทันที แทนที่จะพบปัญหาระหว่างการรีวิวโค้ด ในสเตจิง หรือจากลูกค้า คุณจะพบภายในไม่กี่นาทีหลังการเปลี่ยนแปลง

ยิ่งพบบั๊กเร็วเท่าไร ยิ่งแก้ถูกและถูกกว่า เทสต์ย่อวงจรการตอบกลับ: พวกมันเผยความไม่ตรงกันของสมมติฐานและกรณีขอบในขณะที่เจตนายังสดอยู่ ลดงานซ้ำ หลีกเลี่ยงแพตช์แบบ “fix-forward” และทำให้ความเร็วของ AI ไม่กลายเป็นการวนลูปซ่อมบ่อย

โค้ดที่เขียนโดย AI ทำงานเร็วที่สุดเมื่อคุณมองมันเป็นบทสนทนา ไม่ใช่สิ่งที่ส่งมอบครั้งเดียว เทสต์คือสิ่งที่ทำให้บทสนทนานั้นวัดได้

Spec: คุณอธิบายสิ่งที่ควรเกิดขึ้น (อินพุต ผลลัพธ์ ขอบกรณี)

Code: AI เขียนการใช้งานที่อ้างว่าเข้ากับคำอธิบายนั้น

Tests: คุณ (หรือ AI) สร้างการตรวจที่พิสูจน์ว่าพฤติกรรมนั้นเป็นจริง

ทำซ้ำวงจรนี้และคุณไม่ได้แค่ผลิตโค้ดมากขึ้น—คุณกำลังค่อย ๆ กระชับคำนิยามของคำว่า “เสร็จ” ให้แน่นขึ้น

ข้อกำหนดคลุมเครืออย่าง “จัดการผู้ใช้ไม่ถูกต้องอย่างสุภาพ” ง่ายต่อการละเลยในโค้ด แต่เทสต์ไม่สามารถคลุมเครือได้ มันบังคับให้เจาะจง:\n

โค้ดที่สร้างโดย AI อาจดูถูกต้องในขณะที่ซ่อนสมมติฐาน เทสต์ที่สร้างเป็นวิธีปฏิบัติในการตรวจสอบคำกล่าวอ้างของโค้ด:\n

เทสต์ที่ล้มเป็นฟีดแบ็กที่ทำได้จริง: ชี้ไปยังความไม่ตรงกันเฉพาะระหว่างสเปกกับการใช้งาน แทนที่จะถาม AI ว่า “แก้ไขให้หน่อย” คุณสามารถวางความล้มเหลวและบอกว่า: “อัปเดตโค้ดให้เทสต์นี้ผ่านโดยไม่เปลี่ยน public API” นั่นเปลี่ยนการดีบักให้เป็นการวนซ้ำที่มีเป้าหมายแทนการเดา

การสร้างเทสต์อัตโนมัติมีประโยชน์ที่สุดเมื่อมันสนับสนุนกลยุทธ์การทดสอบที่มีอยู่ โดยเฉพาะพีระมิดการทดสอบแบบคลาสสิก พีระมิดไม่ใช่กฎโดยตัวมันเอง แต่มันช่วยให้การตอบกลับเร็วและเชื่อถือได้ ในขณะที่ยังจับความล้มเหลวในโลกจริง

AI ช่วยสร้างเทสต์ได้ทุกเลเยอร์ แต่ผลลัพธ์ดีที่สุดเมื่อคุณสร้างมากขึ้นในเทสต์ราคาถูก(ชั้นล่างของพีระมิด) และน้อยลงในเทสต์ที่แพง(ชั้นบน) สมดุลนี้ทำให้ CI ของคุณเร็วในขณะที่ยังปกป้องประสบการณ์ผู้ใช้

เทสต์หน่วยเป็นการตรวจเล็ก ๆ สำหรับฟังก์ชัน เมทอด หรือโมดูลแต่ละชิ้น พวกมันรันเร็ว ไม่ต้องพึ่งระบบภายนอก และเหมาะกับการสร้างโดย AI เพื่อครอบคลุมกรณีขอบ\n การใช้งานที่ดีของการสร้างเทสต์อัตโนมัติที่นี่คือ:\n

เทสต์การรวมยืนยันการทำงานร่วมกันของชิ้นส่วน: API กับฐานข้อมูล บริการเรียกบริการอื่น การประมวลผลคิว การพิสูจน์ตัวตน เป็นต้น\n เทสต์การรวมที่สร้างโดย AI มีคุณค่า แต่ต้องมีวินัยมากขึ้น:\n

E2E ตรวจเส้นทางผู้ใช้สำคัญ แต่เป็นเทสต์ที่แพงที่สุด: รันช้า เปราะบาง และยาก debug\n การสร้าง E2E อัตโนมัติช่วยร่างสถานการณ์ได้ แต่ควรคัดกรองอย่างเข้มงวด เก็บชุดเล็กของเส้นทางสำคัญ (สมัครสมาชิก ชำระเงิน งานหลัก) และหลีกเลี่ยงการพยายามสร้าง E2E สำหรับทุกฟีเจอร์

อย่าพยายามสร้างทุกอย่าง แทนที่จะนั้น:\n

การสร้างเทสต์อัตโนมัติไม่ได้จำกัดแค่ “เขียนเทสต์หน่วยให้ฟังก์ชันนี้” ตัวสร้างที่มีประโยชน์มากสุดดึงจากสามแหล่ง: โค้ดที่คุณมี เจตนาที่อยู่เบื้องหลัง และข้อผิดพลาดที่คุณเคยเจอ

เมื่อนำฟังก์ชันหรือโมดูล เครื่องมือสามารถอนุมานกรณีทดสอบจากอินพุต/เอาต์พุต สาขาเงื่อนไข และเส้นทาง exception ซึ่งมักหมายถึง:\n

ถ้าคุณมี acceptance criteria user stories หรือตารางตัวอย่าง ตัวสร้างสามารถแปลงพวกนั้นเป็นเทสต์ที่อ่านเหมือนสเปก ซึ่งมีค่ายิ่งกว่าการสร้างจากโค้ดเพราะมันล็อกว่า “ควรเกิดอะไร” ไม่ใช่แค่ “ตอนนี้เกิดอะไร”\n รูปแบบปฏิบัติ: ให้ตัวอย่างจริง (อินพุต + ผลลัพธ์ที่คาดหวัง) สองสามตัว แล้วขอให้ตัวสร้างเติมกรณีขอบที่สอดคล้องกับกฎเหล่านั้น

การสร้างจากบั๊กเป็นวิธีที่เร็วที่สุดในการสร้างชุดเทสต์ป้องกันการถดถอย ป้อนขั้นตอนทำซ้ำ (หรือ logs และ payload ขั้นต่ำ) แล้วสร้าง:\n

Snapshot (golden) tests มีประสิทธิภาพสำหรับผลลัพธ์ที่คงที่ (UI ที่เรนเดอร์ ข้อมูลที่ serialize) ใช้ด้วยความระมัดระวัง: snapshot ขนาดใหญ่สามารถ “อนุมัติ” ความผิดพลาดเล็กๆ ได้ ชอบ snapshots เล็กและมุ่งเป้า พร้อมการอ้างสิทธิ์บนฟิลด์สำคัญที่ต้องถูกต้อง

การสร้างเทสต์อัตโนมัติได้ผลดีเมื่อคุณให้ลำดับความสำคัญชัดเจน หากชี้ไปทั้งโค้ดเบสและขอ “ทุกเทสต์” คุณจะได้เสียงรบกวน: การตรวจสอบค่าต่ำ ความซ้ำซ้อน และเทสต์เปราะที่ชะลอการส่งมอบ

เริ่มจากฟลว์ที่ถ้าพังจะมีต้นทุนสูงสุด—ทางการเงิน กฎหมาย หรือชื่อเสียง ตัวกรองความเสี่ยงง่าย ๆ ช่วยให้ขอบเขตเป็นจริงในขณะที่ปรับปรุงคุณภาพได้เร็ว

ให้โฟกัสก่อนที่:\n

สำหรับแต่ละฟลว์ที่เลือก สร้างเทสต์เป็นชั้น: เทสต์หน่วยเร็ว ๆ สำหรับตรรกะที่ซับซ้อน และเทสต์การรวม 1–2 ตัวที่ยืนยันทั้งเส้นทาง

ขอการครอบคลุมที่สอดคล้องกับความล้มเหลวจริง ๆ แทนการรวมเชิงทฤษฎี ชุดเริ่มต้นที่ดีคือ:\n

ตั้งกฎชัด: ฟีเจอร์ยังไม่เสร็จจนกว่าเทสต์จะมี คำจำกัดความนี้สำคัญยิ่งขึ้นกับโค้ดที่เขียนโดย AI เพราะมันป้องกันไม่ให้ "ส่งเร็ว" กลายเป็น "ถดถอยเร็ว"

ถ้าต้องการให้ติดจริง ๆ ผนวกเข้ากับเวิร์กโฟลว์ (เช่น บังคับเทสต์ก่อน merge ใน CI) และเชื่อมความคาดหวังไว้ในเอกสารทีม (เช่น /engineering/definition-of-done)

AI สร้างเทสต์ได้เร็ว แต่คุณภาพขึ้นกับวิธีถาม เป้าหมายคือชี้โมเดลไปยังเทสต์ที่ปกป้องพฤติกรรม ไม่ใช่เทสต์ที่แค่รันโค้ด

เริ่มด้วยการล็อก "รูปร่าง" ของเทสต์เพื่อให้ผลลัพธ์ตรงกับรีโปของคุณ\n ใส่:\n

should_<behavior>_when_<condition>)\n- ตำแหน่งไฟล์และโครงสร้าง (เช่น src/ และ tests/, หรือ __tests__/)\n- ข้อตกลงใด ๆ (fixtures, factory helpers, ไลบรารีม็อก)นี้ป้องกันไม่ให้โมเดลประดิษฐ์แพตเทิร์นที่ทีมไม่ใช้

วางไฟล์เทสต์ที่มีอยู่ (หรือส่วนสั้น ๆ) และบอกชัดว่า: “ทำตามสไตล์นี้” นี่ช่วยยึดการตัดสินใจเช่นการจัดข้อมูลทดสอบ การตั้งชื่อตัวแปร และรูปแบบการทดสอบ

ถ้าโครงการมี helper (เช่น buildUser() หรือ makeRequest()), ใส่ส่วนนั้นด้วยเพื่อให้เทสต์ที่สร้างใช้ซ้ำแทนการเขียนขึ้นใหม่

ระบุชัดว่าดีเป็นอย่างไร:\n

บรรทัดที่มีประโยชน์ใน prompt: “แต่ละเทสต์ต้องมีอย่างน้อยหนึ่งการอ้างสิทธิ์เกี่ยวกับพฤติกรรมธุรกิจ (ไม่ใช่แค่ ‘ไม่มี exception’)”

AI มักเอียงไปทาง "happy path" ตรงกันข้ามให้ร้องขอ:\n

Generate unit tests for <function/module>.

Standards: <language>, <framework>, name tests like <pattern>, place in <path>.

Use these existing patterns: <paste 1 short test example>.

Coverage requirements:

- Happy path

- Boundary cases

- Negative/error cases

Assertions must verify business behavior (outputs, state changes, side effects).

Return only the test file content.

AI ร่างเทสต์ได้เร็ว แต่ไม่อาจเป็นผู้ตัดสินสุดท้ายว่าเทสต์นั้นสะท้อนเจตนาของคุณหรือไม่ การตรวจคนจริงเปลี่ยน "เทสต์ที่รันได้" เป็น "เทสต์ที่ปกป้องเรา" เป้าหมายไม่ใช่จับผิดสไตล์ แต่เพื่อยืนยันว่าเทสต์จะจับการถดถอยที่มีความหมายโดยไม่กลายเป็นภาระการบำรุงรักษา

เริ่มด้วยสองคำถาม:\n

เทสต์ที่สร้างบางครั้งล็อกพฤติกรรมโดยไม่ตั้งใจ (รายละเอียดการใช้งานปัจจุบัน) แทนที่จะเป็นกฎที่ตั้งใจ ถ้าเทสต์อ่านเหมือนการคัดลอกโค้ดมากกว่าการอธิบายผลลัพธ์ ให้ผลักไปยังการอ้างสิทธิ์ระดับบน

แหล่งที่มาของ flaky หรือ fragile ได้แก่ over-mocking, timestamp ตายตัว, ค่า random ถ้าเทสต์ต้องใช้ mocking มากเกินไป อาจกำลังทดสอบการเชื่อมต่อมากกว่าพฤติกรรมจริง

เทสต์ที่ผ่านยังอาจไร้ประโยชน์ถ้ามันยังผ่านเมื่อฟีเจอร์พัง (false positive) มองหา assertion อ่อนเช่น “ไม่ขว้าง” หรือเช็คแค่การเรียกเมทอด เสริมด้วยการอ้างผลลัพธ์ การเปลี่ยนแปลงสถานะ หรือข้อมูลที่ persist

ตรวจให้แน่ใจ:\n

ปฏิบัติเหมือนโค้ดอื่น ๆ: merge เฉพาะสิ่งที่คุณพร้อมจะรับผิดชอบในอีกหกเดือนข้างหน้า

AI ช่วยให้เขียนโค้ดเร็วขึ้น แต่ชัยชนะจริงคือการทำให้โค้ดนั้นถูกต้องต่อเนื่อง วิธีที่ง่ายสุดในการล็อกคุณภาพคือให้เทสต์และเช็ครันโดยอัตโนมัติในทุกการเปลี่ยนแปลง—เพื่อให้การถดถอยถูกจับก่อนส่งมอบ

หลายทีมใช้เวิร์กโฟลว์เบา ๆ แบบนี้:\n

ข้อสุดท้ายสำคัญ: โค้ดที่เขียนโดย AI ไม่มีเทสต์แนบมามักจะลอยไปไกล เมื่อมีเทสต์ คุณกำลังบันทึกพฤติกรรมที่ตั้งใจในรูปแบบที่ CI สามารถบังคับได้

ตั้ง CI ให้รันในทุก pull request (และบน merge ไปยัง main) ขั้นต่ำควร:\n

นี้ป้องกันปัญหา “เครื่องฉันผ่าน” และจับการแตกโดยไม่ตั้งใจเมื่อเพื่อนร่วมทีม (หรือ prompt ถัดไปของ AI) เปลี่ยนโค้ดที่อื่น

เทสต์สำคัญ แต่ไม่ได้จับทุกอย่าง เพิ่มเกตเล็ก ๆ ที่รันเร็วซึ่งเสริมการสร้างเทสต์:\n

ทำให้เช็คเหล่านี้เร็ว—ถ้า CI ช้า ผู้คนจะหาทางเลี่ยงมัน

ถ้าคุณขยายการรัน CI เพราะสร้างเทสต์เพิ่ม ตรวจสอบงบประมาณและความจุ ถ้าจับ CI minutes ให้พิจารณาข้อจำกัดและตัวเลือก (ดู /pricing)

วิธีที่มีประสิทธิภาพคือมองเทสต์ที่ล้มเป็น prompt ถัดไป แทนที่จะถามโมเดลให้ “ปรับปรุงฟีเจอร์” ให้คุณยื่นความล้มเหลวที่จับได้และให้ข้อจำกัดการแก้ไขนั้น

แทนที่จะ:\n

shouldRejectExpiredToken. นี่คือเอาต์พุตการล้มและโค้ดที่เกี่ยวข้อง อัปเดตการใช้งานให้เทสต์นี้ผ่าน โดยไม่เปลี่ยนพฤติกรรมที่ไม่เกี่ยวข้อง. ถ้าจำเป็น ให้เพิ่มเทสต์ป้องกันการถดถอย”เทสต์ที่ล้มกำจัดการเดา มันนิยามว่า “ถูกต้อง” หมายความว่าอะไรในรูปแบบที่รันได้ คุณจะไม่ต้องเจรจาข้อกำหนดในแชทเยอะ และแต่ละ prompt ถูกจำกัดให้อยู่ที่ผลลัพธ์เดียว ทำให้รีวิวมนุษย์เร็วขึ้นและมองเห็นได้ง่ายเมื่อ AI “แก้” อาการ แต่ทำให้บางอย่างอื่นพัง

นี่คือจุดที่เวิร์กโฟลว์แบบเอเยนต์ให้ประโยชน์: เอเยนต์หนึ่งโฟกัสที่การเปลี่ยนแปลงเล็กสุด อีกตัวเสนอการปรับเทสต์ แล้วคุณรีวิว diff แพลตฟอร์มอย่าง Koder.ai สร้างเวิร์กโฟลว์แชทเช่นนี้ให้รู้สึกเป็นโหมดเริ่มต้น แทนที่จะเป็นเทคนิคพิเศษ

การสร้างเทสต์อัตโนมัติอาจทำให้ชุดเทสต์ใหญ่ขึ้นทันที—แต่ "ใหญ่" ไม่เท่ากับ "ดี" เป้าหมายคือความเชื่อมั่น: จับการถดถอยเร็ว ลดบั๊กในโปรดักชัน และให้ทีมเคลื่อนที่ได้ต่อเนื่อง

เริ่มด้วยสัญญาณที่แมพไปยังผลลัพธ์ที่คุณสนใจ:\n

Coverage เป็นสัญญาณเตือนใช้ได้—โดยเฉพาะเพื่อหาทางที่ยังไม่ถูกทดสอบ—แต่มันง่ายที่จะถูกหลอก เทสต์ที่สร้างอาจเพิ่ม coverage ในขณะที่อ้างน้อย เลือกตัวบ่งชี้เช่น:\n

ถ้าคุณติดตามแค่จำนวนเทสต์หรือ coverage คุณจะปรับให้ได้ปริมาณสูงสุด ให้ติดตาม บั๊กที่ถูกจับก่อนปล่อย: บั๊กที่พบใน CI, QA, หรือสเตจิง ที่ถ้าไม่พบจะถึงผู้ใช้ เมื่อการสร้างเทสต์อัตโนมัติทำงาน ตัวเลขนี้ควรเพิ่มขึ้นในขณะที่เหตุการณ์ในโปรดักชันลดลง

ชุดเทสต์ที่สร้างต้องการการบำรุงรักษา ตั้งงานประจำเพื่อ:\n

ความสำเร็จคือ CI ที่สงบกว่า การตอบกลับเร็วขึ้น และความประหลาดใจน้อยลง—ไม่ใช่แดชบอร์ดที่ดูน่าประทับใจ

การสร้างเทสต์อัตโนมัติสามารถยกระดับคุณภาพได้เร็ว—แต่เฉพาะเมื่อคุณมองมันเป็นผู้ช่วย ไม่ใช่ผู้ตัดสินสุดท้าย ความล้มเหลวใหญ่ที่สุดมักซ้ำรูปแบบ และป้องกันได้

การพึ่งพามากเกินไปเป็นกับดักคลาสสิก: เทสต์ที่สร้างสามารถสร้างภาพลวงความปลอดภัยในขณะที่พลาดความเสี่ยงจริง ถ้าผู้คนหยุดคิด критически ("เครื่องมือเขียนเทสต์แล้ว เราปลอดภัย") คุณจะส่งบั๊กได้เร็วกว่า—เพียงแค่มีเครื่องหมายถูกมากขึ้น

ปัญหาอีกอย่างคือการทดสอบรายละเอียดการใช้งานแทนพฤติกรรม AI มักจับชื่อเมทอดภายใน helper หรือตรวจข้อความข้อผิดพลาดเฉพาะ เทสต์เหล่านี้เปราะ: refactor ทำให้พังแม้ฟีเจอร์ยังทำงาน ปฏิบัติโดยให้เทสต์อธิบาย สิ่งที่จะเกิดขึ้น มากกว่า วิธีที่เกิดขึ้น

การสร้างเทสต์มักเกี่ยวข้องการคัดลอกโค้ด, stack trace, logs หรือสเปกลงใน prompt นั่นอาจเผยความลับ (API keys), ข้อมูลลูกค้า หรือตรรกะกรรมสิทธิ์

เก็บ prompt และไฟxtures ให้ปลอดภัย:\n

ถ้าคุณใช้แพลตฟอร์ม AI ที่โฮสต์ ให้ปฏิบัติเช่นเดียวกัน แม้แพลตฟอร์มจะรองรับการโฮสต์ตามภูมิภาค แต่ prompt และ fixtures ยังเป็นส่วนหนึ่งของนโยบายความปลอดภัย

เริ่มเล็กและทำเป็นกิจวัตร:\n

เป้าหมายไม่ใช่เทสต์ให้มากที่สุด—แต่สร้างการตอบกลับที่เชื่อถือได้ที่ทำให้ตรรกะที่เขียนโดย AI ซื่อสัตย์

เพราะเมื่อ AI ช่วยเร่งการเปลี่ยนแปลงตรรกะของแอป มันก็สามารถเร่งการเกิดสมมติฐานผิดหรือการถดถอยแบบเงียบได้เช่นกัน การสร้างเทสต์อัตโนมัติให้วิธีการที่รวดเร็วและปฏิบัติได้จริงในการล็อกพฤติกรรมที่ต้องการ เพื่อให้การเปลี่ยนแปลงครั้งต่อไป (โดยคนหรือ AI) มีการตอบกลับทันทีเมื่อมีสิ่งใดผิดพลาด

ไม่ใช่ แค่เพราะเทสต์ถูกสร้างไม่ได้แปลว่ามั่นใจได้เสมอไป เทสต์ที่สร้างอาจเผลอ “รับรอง” พฤติกรรมปัจจุบันแม้ว่าพฤติกรรมนั้นจะผิด หรืออาจพลาดกฎธุรกิจที่ไม่ได้ระบุไว้ในโค้ด ให้ถือเทสต์ที่สร้างเป็นร่างและตรวจทานชื่อการทดสอบ การตั้งค่า และการอ้างสิทธิ์เพื่อให้แน่ใจว่าสะท้อนเจตนาของผลิตภัณฑ์

เมื่อคุณต้องการความคุ้มครองที่เป็นโครงสร้างรอบ ๆ ตรรกะใหม่หรือที่แก้ไข โดยเฉพาะหลังการ refactor ที่ช่วยโดย AI เหมาะสำหรับ:

เริ่มจากเลเยอร์ต้นทุนต่ำและสัญญาณสูง: เทสต์หน่วย

มุ่งไปที่เทสต์ที่เน้นพฤติกรรม ซึ่งจะล้มลงด้วยเหตุผลที่ถูกต้อง เสริมการอ้างสิทธิ์ที่อ่อนด้วย:

สาเหตุทั่วไปของความเปราะบางคือการม็อกเกินไป, เวลาที่เข้ารหัสตายตัว, ข้อมูลสุ่ม, และการตรวจสอบภายในมากเกินไป ใช้ข้อมูลขาเข้าแบบกำหนดได้และการตรวจสอบที่เสถียร ทดสอบพฤติกรรมสาธารณะมากกว่ารายละเอียดการใช้งานภายใน เพื่อให้การรีแฟกเตอร์ที่ไม่สำคัญไม่ทำให้เทสต์แตก

ใช้วงจรสั้น:

วิธีนี้ผูกคำว่า “เสร็จ” เข้ากับความคาดหวังที่รันได้ ไม่ใช่แค่การตรวจสอบด้วยมือ

ใส่ข้อจำกัดและบริบทจริงของรีโป:

สิ่งเหล่านี้ลดการคิดลอยและเพิ่มความง่ายต่อการตรวจทาน

เทสต์ที่สร้างต้องได้รับการตรวจคนจริงเพื่อให้แน่ใจว่าเทสต์นั้นช่วยจริง ไม่ใช่แค่ทำงานได้ ตรวจสอบสองคำถามหลัก:

ตรวจหาเทสต์ที่ล็อกพฤติกรรมโดยไม่ได้ตั้งใจแทนที่จะทดสอบเจตนา และคัดกรองเทสต์ที่เปราะบางหรือโอเวอร์ม็อก

ใช้ความล้มเหลวเป็น prompt ถัดไป:

การทำแบบนี้แคบขอบเขตการแก้ไขและลดการเดาใจ ทำให้การรีวิวมนุษย์เร็วขึ้น

วัดผลด้วยสัญญาณที่สะท้อนความเชื่อมั่น ไม่ใช่ปริมาณ:

ใช้ coverage เป็นตัวบอกเบื้องต้น แต่อย่าเอาเป็นเป้า ปล่อยให้การลบเทสต์ที่ซ้ำซ้อนและการปรับปรุงเป็นงานสม่ำเสมอเพื่อรักษาคุณภาพจริง