ทำไมแนวคิดของ Shannon ยังคงสำคัญต่อเทคโนโลยีประจำวัน

คุณใช้แนวคิดของ Claude Shannon ทุกครั้งที่ส่งข้อความ ดูวิดีโอ หรือเชื่อมต่อ Wi‑Fi ไม่ใช่ว่าโทรศัพท์ของคุณ “รู้จัก Shannon” แต่เพราะระบบดิจิทัลสมัยใหม่ถูกออกแบบรอบคำสัญญาง่ายๆ: เราสามารถเปลี่ยนข้อความจากโลกจริงที่ยุ่งเหยิงให้เป็นบิต ขนส่งบิตเหล่านั้นผ่านช่องทางที่ไม่สมบูรณ์ แล้วยังคืนเนื้อหาต้นฉบับได้ด้วยความน่าเชื่อถือสูง

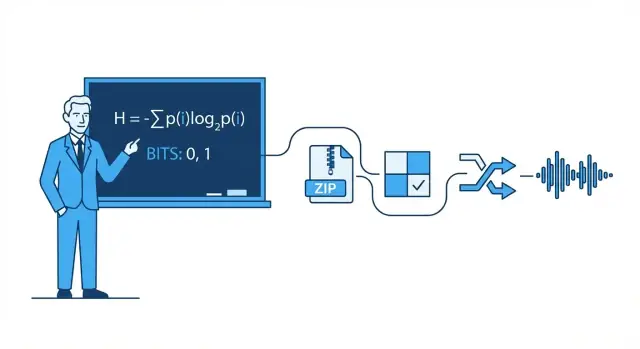

ทฤษฎีข้อมูล แบบง่ายๆ

ทฤษฎีข้อมูลคือคณิตศาสตร์ของข้อความ: มี "ตัวเลือก" (ความไม่แน่นอน) เท่าไรในข้อความหนึ่งข้อความ จะเก็บอย่างมีประสิทธิภาพแค่ไหน และจะส่งได้อย่างเชื่อถือได้แค่ไหนเมื่อมีสัญญาณรบกวน การรบกวน และการคับคั่งเข้ามาขัดขวาง

มีคณิตศาสตร์อยู่เบื้องหลัง แต่คุณไม่จำเป็นต้องเป็นนักคณิตศาสตร์เพื่อเข้าใจสัญชาตญาณปฏิบัติ เราจะใช้ตัวอย่างในชีวิตจริง—เช่น ทำไมบางภาพถ่ายบีบอัดได้ดีกว่าภาพอื่น หรือทำไมการโทรบางครั้งฟังดูดีแม้สัญญาณจะอ่อน—เพื่ออธิบายแนวคิดโดยไม่ต้องใช้สูตรหนักๆ

เสาหลักสี่ข้อที่คุณจะเห็นในทุกที่

บทความนี้หมุนรอบเสาหลักสี่ข้อที่ได้แรงบันดาลใจจาก Shannon และปรากฏในเทคโนโลยีสมัยใหม่:

- การบีบอัด: ย่อข้อมูล (เสียง วิดีโอ ไฟล์) โดยไม่สูญเสียสิ่งที่สำคัญ

- การแก้ไขข้อผิดพลาด: เพิ่มบิตเสริม เท่าที่จำเป็น เพื่อให้ตรวจพบและแก้ไขความผิดพลาดได้

- ความน่าเชื่อถือของเครือข่าย: รับมือกับแพ็กเก็ตที่หลุดด้วยการส่งซ้ำ การจัดลำดับ และการทรงตัวของแบนด์วิดท์

- การสื่อสารดิจิทัลแบบเอนด์ทูเอนด์: มองทั้งสายงานตั้งแต่แหล่งข้อมูล (ข้อความของคุณ) ถึงช่องทาง (Wi‑Fi, มือถือ, ไฟเบอร์) แล้วกลับมาอีกครั้ง

สิ่งที่คุณจะคิดได้หลังอ่าน

เมื่อจบ คุณควรจะคิดได้เกี่ยวกับการแลกเปลี่ยนจริง: ทำไมคุณภาพวิดีโอสูงต้องการแบนด์วิดท์มากขึ้น ทำไม "แถบสัญญาณมากขึ้น" ไม่ได้แปลว่าจะเร็วขึ้นเสมอไป ทำไมแอปบางตัวรู้สึกทันทีในขณะที่บางแอปต้องบัฟเฟอร์ และทำไมทุกระบบถึงมีขีดจำกัด—โดยเฉพาะ Shannon limit ที่มีชื่อเสียงว่าจำกัดปริมาณข้อมูลที่ช่องทางสามารถส่งได้อย่างเชื่อถือได้

Claude Shannon ในหน้าเดียว: ไอเดียใหญ่

ในปี 1948 นักคณิตศาสตร์และวิศวกร Claude Shannon เผยแพร่เอกสารชื่อเรียบง่าย A Mathematical Theory of Communication ที่เปลี่ยนวิธีคิดเกี่ยวกับการส่งข้อมูล จากการมองเป็นศิลปะ เขามองเป็นปัญหาทางวิศวกรรม: แหล่งข้อมูลสร้างข้อความ ช่องทางขนส่งมัน สัญญาณรบกวนทำให้มันผิดเพี้ยน และผู้รับพยายามประกอบคืนว่าส่งมาอะไร

ข้อมูลคือ "การลดความไม่แน่นอน" ไม่ใช่ "ความหมาย"

การเคลื่อนไหวสำคัญของ Shannon คือการนิยาม ข้อมูล ในแบบที่วัดค่าได้และเป็นประโยชน์ต่อเครื่องจักร ในกรอบของเขา ข้อมูลไม่ใช่ว่าเนื้อหามีความสำคัญแค่ไหน หรือหมายความว่าอย่างไร แต่วัดจากความ น่าประหลาดใจ—ความไม่แน่นอนที่ถูกตัดออกเมื่อคุณได้รู้ผลลัพธ์

ถ้าคุณรู้ล่วงหน้าว่าจะเกิดอะไรขึ้น ข้อความนั้นแทบไม่ให้อะไรใหม่เลย แต่ถ้าคุณไม่แน่ใจจริงๆ การได้รู้ผลจะให้ข้อมูลมากกว่า

บิต: หน่วยง่ายที่สุดที่นับได้

เพื่อวัดข้อมูล Shannon ทำให้บิต (bit) เป็นหน่วยยอดนิยม บิตคือปริมาณข้อมูลที่ต้องใช้เพื่อแก้ความไม่แน่นอนแบบใช่/ไม่ใช่หนึ่งข้อ

ตัวอย่าง: ถ้าฉันถามว่า "ไฟเปิดอยู่ไหม?" และคุณไม่รู้ล่วงหน้า คำตอบ (ใช่หรือไม่ใช่) ให้ข้อมูลประมาณ 1 บิต ข้อความจริงจำนวนมากสามารถแตกเป็นลำดับของการตัดสินใจแบบไบนารีเหล่านี้ ซึ่งเป็นเหตุผลว่าทำไมข้อความ ภาพ และเสียงจึงเก็บและส่งเป็นบิตได้

บทความนี้จะทำอะไร (และจะไม่ทำอะไร)

บทความนี้เน้นสัญชาตญาณเชิงปฏิบัติเกี่ยวกับแนวคิดของ Shannon และเหตุผลที่แนวคิดเหล่านี้ปรากฏทุกที่: การบีบอัด (ทำให้ไฟล์เล็กลง), การแก้ไขข้อผิดพลาด (ซ่อมข้อมูลที่เสียหาย), ความน่าเชื่อถือของเครือข่าย (การลองซ้ำและปัญหาทราฟฟิก), และ ความจุช่องทาง (ความเร็วที่เป็นไปได้เหนือช่องทางที่มีสัญญาณรบกวน)

สิ่งที่จะไม่ทำคือการพิสูจน์เชิงคณิตศาสตร์หนักๆ คุณไม่ต้องการคณิตศาสตร์ขั้นสูงเพื่อเข้าใจใจความสำคัญ: เมื่อคุณสามารถ วัด ข้อมูลได้ คุณจะออกแบบระบบที่เข้าใกล้ประสิทธิภาพสูงสุดได้—บ่อยครั้งใกล้เกือบถึงขีดจำกัดเชิงทฤษฎีที่ Shannon อธิบายไว้

บิต, สัญลักษณ์, และรหัส: คำศัพท์ใช้งานได้จริง

ก่อนจะพูดถึงเอนโทรปี การบีบอัด หรืิอการแก้ไขข้อผิดพลาด ควรกำหนดคำศัพท์พื้นฐานบางอย่างไว้ก่อน แนวคิดของ Shannon จะชัดขึ้นเมื่อคุณตั้งชื่อแต่ละชิ้นได้

สัญลักษณ์ ตัวอักษร และข้อความ

สัญลักษณ์ คือหน่วย "ตัวตน" หนึ่งจากชุดที่ตกลงกัน ชุดนั้นคือ อักษร (alphabet) ในข้อความภาษาอังกฤษ อักษรสามารถเป็นตัวอักษร เว้นวรรค และเครื่องหมายวรรคตอน ในไฟล์คอมพิวเตอร์ อักษรอาจเป็นค่าบิตแบบไบต์ 0–255

ข้อความ คือลำดับของสัญลักษณ์จากอักษรนั้น: คำ ประโยค ไฟล์ภาพ หรือสตรีมตัวอย่างเสียง

เพื่อให้เข้าใจง่าย ลองจินตนาการอักษรเล็กๆ: {A, B, C} ข้อความตัวอย่างอาจเป็น:

A A B C A B A ...

บิตและรหัส

บิต คือเลขฐานสอง: 0 หรือ 1 คอมพิวเตอร์เก็บและส่งบิตเพราะฮาร์ดแวร์สามารถแยกสองสถานะได้อย่างน่าเชื่อถือ

รหัส คือกฎในการแทนสัญลักษณ์ด้วยบิต (หรือสัญลักษณ์อื่น) ตัวอย่างสำหรับอักษร {A, B, C} หนึ่งรหัสอาจเป็น:

ตอนนี้ข้อความที่ประกอบด้วย A/B/C สามารถแปลงเป็นสตรีมของบิตได้

การเข้ารหัส การบีบอัด และการเข้ารหัสลับต่างกันอย่างไร

คำเหล่านี้มักสับสนกัน:

- การเข้ารหัส (Encoding): แปลงข้อมูลเป็นฟอร์แมตรวมเพื่อจัดเก็บ/ส่ง/ประมวลผล (เช่น การแมป A/B/C เป็นบิต หรือการแปลงข้อความเป็น UTF‑8)

- การบีบอัด (Compression): การเข้ารหัสที่ใช้ บิตน้อยลงโดยเฉลี่ย โดยการใช้รูปแบบและความถี่ที่ไม่เท่ากัน

- การเข้ารหัสลับ (Encryption): การทำให้ข้อมูลสับสนด้วยคีย์เพื่อไม่ให้ผู้อื่นอ่านได้ มันเกี่ยวกับความลับ ไม่ใช่ขนาดไฟล์

สัญชาตญาณความน่าจะเป็นแบบเร็วๆ

ข้อความจริงไม่ใช่สุ่มทั้งหมด: สัญลักษณ์บางตัวเกิดบ่อยกว่าตัวอื่น สมมติว่า A เกิด 70% B 20% C 10% ระบบบีบอัดที่ดีมักให้ รหัสสั้นกว่าสาหรับสัญลักษณ์ที่พบบ่อย (A) และรหัสยาวกว่าสำหรับสัญลักษณ์ที่หายาก (C) ความไม่เท่ากันนี้คือสิ่งที่ส่วนหลังจะวัดด้วยเอนโทรปี

เอนโทรปี: การวัดความ "ประหลาดใจ" (และทำไมมันทำนายการบีบอัดได้)

แนวคิดที่มีชื่อเสียงที่สุดของ Shannon คือ เอนโทรปี: วิธีวัดว่ามีความ "ประหลาดใจ" หรือความไม่สามารถทำนายได้อยู่เท่าไร ไม่ใช่ความประหลาดใจในเชิงอารมณ์ แต่เป็นความไม่คาดเดาได้ หากสัญลักษณ์ถัดไปยากจะทำนาย มันจะให้ข้อมูลมากเมื่อปรากฏ

เอนโทรปีเป็น "ความประหลาดใจเฉลี่ย"

ลองนึกถึงการพลิกเหรียญ

- เหรียญสมดุล (50/50): ทุกครั้งยากจะทำนาย หัวกับก้อยมีโอกาสเท่ากัน ทุกครั้งจึงเป็นความประหลาดใจ—นั่นหมายถึง เอนโทรปีสูง

- เหรียญโหลด (เช่น หัว 95% ก้อย 5%): ส่วนใหญ่เป็นหัว หลังจากหลายครั้งคุณจะคาดหวังหัว ดังนั้นการเห็นหัวจึงให้ข้อมูลน้อย มีเพียงก้อยที่น่าประหลาดใจ ในเฉลี่ยลำดับนี้มี เอนโทรปีต่ำ

กรอบ "ความประหลาดใจเฉลี่ย" นี้ตรงกับรูปแบบในชีวิตจริง: ไฟล์ข้อความที่มีช่องว่างและคำที่พบบ่อยจะทำนายได้ง่ายกว่าข้อมูลสุ่ม

ทำไมการทำนายได้แปลว่าบีบอัดได้ดี

การบีบอัดทำงานโดยการให้ รหัสสั้นกว่าสำหรับสัญลักษณ์ที่พบบ่อย และรหัสยาวกว่าสำหรับสัญลักษณ์ที่หายาก ถ้าแหล่งข้อมูลทำนายได้ (เอนโทรปีต่ำ) คุณจะใช้รหัสสั้นบ่อยครั้งและประหยัดที่เก็บได้ ถ้ามันเกือบสุ่ม (เอนโทรปีสูง) พื้นที่บีบอัดจะน้อยเพราะไม่มีรูปแบบให้ใช้ประโยชน์

เอนโทรปีกับความยาวรหัสเฉลี่ยที่ดีที่สุด

Shannon แสดงว่าเอนโทรปีกำหนดเกณฑ์แนวคิด: มันคือ ขีดจำกัดล่างเชิงแนวคิดของจำนวนบิตเฉลี่ยต่อสัญลักษณ์ ที่คุณบรรลุได้เมื่อเข้ารหัสข้อมูลจากแหล่งนั้น

สำคัญ: เอนโทรปีไม่ใช่อัลกอริทึมการบีบอัด มันไม่บอกคุณว่าควรบีบอัดไฟล์อย่างไร มันบอกว่าในทางทฤษฎีเป็นไปได้แค่ไหน—และเมื่อคุณใกล้ขีดจำกัดแล้ว

การบีบอัด: เปลี่ยนเอนโทรปีให้เป็นไฟล์เล็กลง

การบีบอัดคือเมื่อนำข้อความที่ "สามารถ" อธิบายด้วยบิตน้อยกว่า แล้วทำให้จริง การสังเกตของ Shannon คือข้อมูลที่มีเอนโทรปีต่ำมีที่ว่างให้ย่อ ในขณะที่ข้อมูลเอนโทรปีสูงแทบไม่ย่อได้

ทำไมรูปแบบและความถี่ไม่เท่ากันบีบอัดได้ดี

รูปแบบที่ซ้ำเป็นประโยชน์ชัดเจน: ถ้าไฟล์มีลำดับซ้ำกัน คุณเก็บลำดับหนึ่งครั้งและอ้างอิงไปหลายครั้ง แต่แม้ไม่มีการซ้ำชัดเจน ความเบ้ของความถี่สัญลักษณ์ ก็ช่วยได้

ถ้าข้อความใช้ "e" บ่อยกว่า "z" หรือไฟล์ล็อกซ้ำเวลาและคีย์เวิร์ดเดิมๆ คุณไม่จำเป็นต้องใช้จำนวนบิตเท่ากันสำหรับทุกตัวอักษร ยิ่งความถี่ไม่เท่ากันมากเท่าไร แหล่งข้อมูลยิ่งทำนายได้มากขึ้นและยิ่งบีบอัดได้มากขึ้น

การเข้ารหัสความยาวแปร (หลักการสำคัญ)

วิธีปฏิบัติที่ใช้ประโยชน์จากความเบ้คือ การเข้ารหัสความยาวแปร:

- สัญลักษณ์ที่พบบ่อยได้รับ รหัสสั้น

- สัญลักษณ์ที่หายากได้รับ รหัสยาว

ถ้าทำอย่างระมัดระวัง จะลดจำนวนบิตเฉลี่ยต่อสัญลักษณ์โดยไม่สูญเสียข้อมูล

คอมเพรสเซอร์ไร้การสูญเสียในโลกจริงมักผสมหลายแนวคิด แต่คุณมักจะได้ยินตระกูลเหล่านี้:

- Huffman coding: สร้างตารางรหัสำหรับ "สั้นสำหรับที่พบบ่อย"

- Arithmetic coding: บรรจุสัญลักษณ์ลงในช่วงเศษส่วน บีบอัดได้ใกล้ขีดจำกัดเอนโทรปีมากขึ้น

- LZ (Lempel–Ziv): หาเซกเมนต์ที่ซ้ำและแทนที่ด้วยการอ้างอิง (ใช้ในฟอร์แมต ZIP)

ไร้การสูญเสีย vs สูญเสีย (ZIP vs JPEG/MP3)

การบีบอัดแบบไร้การสูญเสีย คืนต้นฉบับได้สมบูรณ์ (เช่น ZIP, PNG) จำเป็นสำหรับซอฟต์แวร์ เอกสาร และข้อมูลที่ผิดพลาดไม่ได้

การบีบอัดแบบสูญเสีย ทิ้งข้อมูลที่ผู้คนมักไม่สังเกต (เช่น JPEG, MP3/AAC) เป้าหมายเปลี่ยนเป็น "ประสบการณ์ที่เหมือนเดิม" แทนที่จะคืนบิตเดิม ทำให้ไฟล์เล็กลงมากโดยตัดรายละเอียดเล็กๆ ที่รับรู้ได้น้อย

ข้อผิดพลาดเกิดได้: ทำไมความซ้ำซ้อนจึงมีประโยชน์

แชร์กับทีมของคุณ

วางต้นแบบของคุณบนโดเมนแบบกำหนดเองเพื่อการแชร์และทดสอบผู้ใช้ที่รวดเร็ว

ระบบดิจิทัลทั้งหมดตั้งอยู่บนสมมติฐานเปราะบาง: 0 ต้องเป็น 0 และ 1 ต้องเป็น 1 ในความเป็นจริง บิตอาจพลิกได้

ข้อผิดพลาดมาจากไหน

ในการส่ง ข้อความรบกวนทางไฟฟ้า สัญญาณ Wi‑Fi อ่อน หรือสัญญาณวิทยุรบกวนสามารถดันสัญญาณจนผู้รับตีความผิดได้ ในการเก็บข้อมูล ปัจจัยทางกายภาพเล็กๆ เช่น การสึกหรอของแฟลช สร้างความเปลี่ยนแปลงในประจุ หรือรังสีรบกวน อาจเปลี่ยนสถานะที่เก็บข้อมูล

เพราะข้อผิดพลาดหลีกเลี่ยงไม่ได้ วิศวกรจึงเติม ความซ้ำซ้อน: บิตเพิ่มเติมที่ไม่ได้ให้ "ข้อมูลใหม่" แต่ช่วยให้ตรวจหรือซ่อมความเสียหาย

ความซ้ำซ้อนง่ายๆ ที่คุณเคยใช้แล้ว

พาริตีบิต (ตรวจจับเร็ว). เพิ่มบิตหนึ่งบิตให้จำนวน 1 เป็นคู่หรือคี่ ถ้าบิตเดียวพลิก การตรวจสอบพาริตีจะล้มเหลว

- จุดเด่น: ถูกและเร็ว

- ข้อจำกัด: มักไม่บอกได้ว่าบิตไหนผิด และสองบิตที่พลิกอาจยกเลิกกันและดูเหมือน "ปกติ"

เช็กซัม (ตรวจจับดีกว่าสำหรับชิ้นข้อมูล). คำนวณสรุปสั้นๆ ของแพ็กเก็ตหรือไฟล์ (เช่น CRC) ผู้รับคำนวณใหม่และเปรียบเทียบ

- จุดเด่น: ตรวจจับข้อผิดพลาดหลายบิตในบล็อกได้ดี

- ข้อจำกัด: ยังเป็นการตรวจเจ้าเท่านั้น ถ้าล้มเหลวต้องส่งซ้ำหรือใช้สำเนาสำรอง

รหัสการทำซ้ำ (แก้ไขง่าย). ส่งบิตแต่ละตัวสามครั้ง: 0 → 000, 1 → 111 ผู้รับใช้เสียงข้างมากตัดสิน

- จุดเด่น: แก้บิตที่พลิกได้หนึ่งบิตในแต่ละกลุ่มสามได้

- ข้อจำกัด: ไม่คุ้มค่า—เพิ่มข้อมูลสามเท่า

การตรวจจับ vs การแก้ไข (และเมื่อใช้แต่ละแบบ)

การตรวจจับข้อผิดพลาด ตอบว่า: "มีอะไรผิดไหม?" มักใช้เมื่อการส่งซ้ำถูกและง่าย เช่น แพ็กเก็ตเน็ตเวิร์กที่สามารถส่งซ้ำได้

การแก้ไขข้อผิดพลาด ตอบว่า: "บิตเดิมคืออะไร?" ใช้เมื่อการส่งซ้ำแพงหรือเป็นไปไม่ได้ เช่น เสียงสตรีมมิงผ่านลิงก์แย่ การสื่อสารดาวลึก หรือการอ่านข้อมูลจากสื่อที่อาจยังมีข้อผิดพลาด

ความซ้ำซ้อนดูเหมือนสิ้นเปลือง แต่เป็นเหตุผลที่ระบบสมัยใหม่ทำงานเร็วและเชื่อถือได้แม้อุปกรณ์หรือช่องทางจะไม่สมบูรณ์

ความจุช่องทางและ Shannon Limit (ไม่ลงรายละเอียดคณิตศาสตร์)

เมื่อคุณส่งข้อมูลผ่านช่องทางจริง—Wi‑Fi มือถือ สาย USB หรือฮาร์ดไดรฟ์—สัญญาณรบกวนอาจพลิกบิตหรือทำให้สัญลักษณ์พร่ามัว คำสัญญาของ Shannon น่าประหลาดใจ: การสื่อสารที่เชื่อถือได้เป็นไปได้ แม้ในช่องทางที่มีสัญญาณรบกวน ตราบใดที่คุณไม่พยายามผลักข้อมูลมากเกินไป

ความจุช่องทางในคำง่ายๆ

ความจุช่องทาง คือ "ขีดจำกัดความเร็ว" ของช่องทาง: อัตราสูงสุด (บิต/วินาที) ที่คุณสามารถส่งได้ โดยที่ข้อผิดพลาดสามารถทำให้เข้าใกล้ศูนย์ได้ ภายใต้ระดับสัญญาณรบกวนและข้อจำกัดเช่นแบนด์วิดท์และพลังงาน

มันไม่เหมือนกับอัตราสัญลักษณ์ดิบ (ความเร็วที่คุณสลับสัญญาณ) แต่มันเกี่ยวกับข้อมูล ที่มีความหมาย หลุดรอดหลังจากรวมการเข้ารหัสอัจฉริยะ ความซ้ำซ้อน และการถอดรหัสเข้าด้วยกัน

Shannon limit: ขอบเขตที่วิศวกรไล่ตาม

Shannon limit คือชื่อที่คนทั่วไปเรียกขอบเขตนี้: ต่ำกว่าขอบเขต คุณสามารถทำให้การสื่อสารเชื่อถือได้ตามต้องการ ในทางทฤษฎี; เหนือขอบเขต คุณไม่สามารถ—จะมีข้อผิดพลาดเหลืออยู่ไม่ว่าออกแบบอย่างไร

วิศวกรทุ่มเทพยายามให้ใกล้ขอบเขตนี้ด้วยการปรับโหมดมอดูเลชันและรหัสแก้ไขข้อผิดพลาด ระบบสมัยใหม่เช่น LTE/5G และ Wi‑Fi ใช้รหัสขั้นสูงเพื่อทำงานใกล้ขอบเขตนี้แทนที่จะสิ้นเปลืองพลังสัญญาณหรือแบนด์วิดท์มากเกินจำเป็น

การแลกเปลี่ยนสำคัญ (อัตรา vs ความน่าจะเป็นผิดพลาด)

นึกถึงการบรรจุของลงรถขนของในถนนที่ขรุขระ:

- บรรจุ แน่นเกินไป (อัตราเกินความจุ) ของบางอย่างจะพังเสมอ (มีระดับข้อผิดพลาดไม่เป็นศูนย์)

- บรรจุ ให้ระยะและกันกระแทก (อัตราต่ำกว่าความจุ) คุณสามารถทำให้การพังหายากมาก—แต่แลกด้วยอัตราผลตอบแทนที่ต่ำลงหรือความซ้ำซ้อนมากขึ้น

Shannon ไม่ได้ให้รหัสที่ดีที่สุดชิ้นเดียวแก่เรา แต่พิสูจน์ว่า "ขีดจำกัด" มีอยู่—และการพยายามเข้าใกล้มันคุ้มค่า

รหัสแก้ไขข้อผิดพลาดในระบบจริง

รับรางวัลจากการสร้าง

รับเครดิตโดยการแบ่งปันสิ่งที่คุณสร้างกับ Koder.ai และสิ่งที่คุณเรียนรู้

ทฤษฎีช่องทางมีเสียงว่า: ถ้าคุณส่งข้อมูลต่ำกว่าความจุของช่องทาง จะมีรหัสที่ทำให้ข้อผิดพลาดหายากมาก ในทางปฏิบัติ วิศวกรรมคือการเปลี่ยน "หลักฐานการมีอยู่" นั้นให้เป็นสกีมที่ใช้ได้จริงในชิป แบตเตอรี่ และตามกรอบเวลา

กล่องเครื่องมือเชิงปฏิบัติ: บล็อก, การสลับตำแหน่ง, และการคาดเดาที่ดีขึ้น

ระบบจริงมักใช้ รหัสแบบบล็อก (ป้องกันชิ้นข้อมูลเป็นกลุ่ม) หรือ รหัสแบบสตรีม (ป้องกันลำดับต่อเนื่อง)

ด้วย รหัสแบบบล็อก คุณเพิ่มความซ้ำซ้อนอย่างรอบคอบในแต่ละบล็อกเพื่อให้ผู้รับตรวจจับและแก้ไขความผิดพลาดได้ ด้วย การสลับตำแหน่ง (interleaving) คุณจัดเรียงบิต/สัญลักษณ์ใหม่เพื่อให้การรบกวนเป็นช่วงๆ ถูกกระจายเป็นข้อผิดพลาดเล็กๆ ทั่วหลายบล็อก—สำคัญสำหรับไร้สายและการจัดเก็บ

อีกการแบ่งสำคัญคือวิธีที่ผู้รับ "ตัดสินใจ" ว่าได้ยินอะไร:

- การตัดสินใจแบบฮาร์ด (Hard decisions): สัญญาณที่รับมาแปลงเป็น 0 หรือ 1 ทันที

- การตัดสินใจแบบซอฟต์ (Soft decisions): ผู้รับเก็บความมั่นใจด้วย (เช่น "น่าจะเป็น 1 แต่ยังไม่แน่")

การตัดสินใจแบบซอฟต์ให้ข้อมูลมากขึ้นแก่ตัวถอดรหัสและปรับปรุงความน่าเชื่อถืออย่างมีนัยสำคัญ โดยเฉพาะใน Wi‑Fi และเครือข่ายมือถือ

รหัสที่คุณอาจเคยใช้แล้ว

- Reed–Solomon: ทำงานกับสัญลักษณ์แทนบิตและยอดเยี่ยมกับข้อผิดพลาดเป็นช่วง ใช้ใน QR codes, CD/DVD, และระบบบroadcast/storage บางชนิด

- Convolutional: ตัวเลือกคลาสสิกสำหรับสตรีมต่อเนื่อง; เคยใช้ในลิงก์ดาวเทียม

- Turbo: ก้าวกระโดดในยุค 1990s ใช้กันใน 3G/4G

- LDPC (Low-Density Parity-Check): รหัสบล็อกสมัยใหม่มีประสิทธิภาพสูง ใช้ใน Wi‑Fi, 5G, และระบบผ่านหัวโหลดสูงหลายแห่ง

มันสำคัญตรงไหน

ตั้งแต่ การสื่อสารดาวลึก (การส่งซ้ำแพงหรือเป็นไปไม่ได้) ไปจนถึง ดาวเทียม, Wi‑Fi, และ 5G รหัสแก้ไขข้อผิดพลาดเป็นสะพานปฏิบัติระหว่างทฤษฎีของ Shannon กับความเป็นจริงของช่องทางที่มีเสียงรบกวน—แลกบิตและการคำนวณเพิ่มเติมกับการโทรที่ลดลง ดาวน์โหลดเร็วขึ้น และลิงก์ที่เชื่อถือได้มากขึ้น

ความน่าเชื่อถือของเครือข่าย: แพ็กเก็ต, การส่งซ้ำ, และอัตราผ่านข้อมูล

อินเทอร์เน็ตทำงานได้แม้ลิงก์แต่ละตัวจะไม่สมบูรณ์ Wi‑Fi จาง มือถือถูกบัง สายทองแดงและไฟเบอร์ยังเจอเสียงรบกวนและความผิดพลาดบางครั้ง ความคิดหลักของ Shannon—เสียงรบกวนหลีกเลี่ยงไม่ได้ แต่ความน่าเชื่อถือยังเป็นไปได้—ปรากฏในเครือข่ายเป็นการผสมระหว่าง การตรวจ/แก้ไขข้อผิดพลาด และ การส่งซ้ำ

แพ็กเก็ต: เดิมพันเล็กแทนเดิมพันใหญ่

ข้อมูลถูกแบ่งเป็นแพ็กเก็ตเพื่อให้เครือข่ายสามารถเลี่ยงปัญหาและกู้จากการสูญเสียโดยไม่ต้องส่งทุกอย่างใหม่ แพ็กเก็ตแต่ละชิ้นมีบิตเสริม (เฮดเดอร์และเช็ก) ที่ช่วยผู้รับตัดสินใจว่าที่มาถึงเชื่อถือได้หรือไม่

รูปแบบทั่วไปคือ ARQ (Automatic Repeat reQuest):

- ผู้รับตรวจแพ็กเก็ต (โดยปกติด้วยเช็กซัม/CRC)

- ถ้ามันถูกต้อง จะส่งการยืนยัน (ACK)

- ถ้ามันหายหรือเสียหาย ผู้ส่งจะส่งซ้ำหลังหมดเวลา (หรือเมื่อได้รับ NACK)

แก้ไขทันที vs ส่งซ้ำ: การแลกเปลี่ยนความหน่วง

เมื่อแพ็กเก็ตผิดพลาด คุณมีตัวเลือกสองอย่างหลัก:

- แก้ไขทันที โดยใช้ forward error correction (FEC): เพิ่มความซ้ำซ้อนพอให้ผู้รับแก้ข้อผิดพลาดได้โดยไม่ต้องขอใหม่

- ส่งซ้ำ โดยใช้ ARQ: ใส่ความซ้ำซ้อนน้อยขึ้นตอนแรก แต่จ่ายด้วยเวลาพิเศษเมื่อมีข้อผิดพลาด

FEC ลดความหน่วงบนลิงก์ที่การส่งซ้ำแพง (ความหน่วงสูง การขาดช่วงเป็นช่วง) ARQ มีประสิทธิภาพเมื่อการสูญเสียน้อย เพราะคุณไม่ต้อง "เก็บค่าโทษ" กับทุกแพ็กเก็ตด้วยความซ้ำซ้อนหนาแน่น

อัตราผ่านข้อมูล คอนเจสชัน และทำไมความน่าเชื่อถือไม่ฟรี

กลไกความน่าเชื่อถือใช้ความจุ: บิตพิเศษ แพ็กเก็ตเพิ่มเติม และเวลารอคอย การส่งซ้ำเพิ่มภาระซึ่งอาจทำให้คอนเจสชันแย่ลง คอนเจสชันเพิ่มความหน่วงและการสูญเสีย กระตุ้นการลองซ้ำมากขึ้น

การออกแบบเครือข่ายที่ดีหาจุดสมดุล: ความน่าเชื่อถือพอเพียงเพื่อส่งข้อมูลอย่างถูกต้อง ในขณะที่เก็บต้นทุนโอเวอร์เฮดให้ต่ำเพื่อรักษา throughput ให้ดีภายใต้สภาพต่างๆ

การสื่อสารดิจิทัลแบบเอนด์ทูเอนด์: จากแหล่งถึงช่องทาง

วิธีที่มีประโยชน์ในการเข้าใจระบบดิจิทัลสมัยใหม่คือมองเป็นท่อที่มีสองงาน: ทำให้ข้อความเล็กลง และ ทำให้ข้อความผ่านการเดินทางได้ Shannon ชี้ให้เห็นว่าคุณมักคิดสองงานนี้แยกกันได้—แม้ผลิตภัณฑ์จริงบางครั้งจะผสานกัน

ขั้นตอน 1: การเข้ารหัสแหล่งข้อมูล (source coding / การบีบอัด)

คุณเริ่มจาก "แหล่ง": ข้อความ เสียง วิดีโอ หรือเซ็นเซอร์ การ เข้ารหัสแหล่ง เอาโครงสร้างทำนายได้ออกเพื่อไม่เสียบิต ตัวอย่างเช่น ZIP สำหรับไฟล์, AAC/Opus สำหรับเสียง, หรือ H.264/AV1 สำหรับวิดีโอ

การบีบอัดคือที่ที่เอนโทรปีปรากฏในการปฏิบัติ: เนื้อหาทำนายได้มากเท่าไร ยิ่งต้องใช้บิตเฉลี่ยน้อยลงเท่านั้น

ขั้นตอน 2: การเข้ารหัสช่องทาง (channel coding / การแก้ไขข้อผิดพลาด)

จากนั้นบิตที่บีบอัดต้องข้ามช่องทางที่มีสัญญาณรบกวน: Wi‑Fi มือถือ ไฟเบอร์ สาย USB การเข้ารหัสช่องทาง เพิ่มความซ้ำซ้อนอย่างระมัดระวังเพื่อให้ผู้รับตรวจจับและแก้ไขข้อผิดพลาดได้ นี่คือโลกของ CRCs, Reed–Solomon, LDPC และวิธี FEC อื่นๆ

ความคิดแยกตาม Shannon (โมเดลคิดช่วยได้)

Shannon แสดงว่า ในทางทฤษฎี คุณสามารถออกแบบ การเข้ารหัสแหล่ง ให้เข้าใกล้การบีบอัดที่ดีที่สุด และ การเข้ารหัสช่องทาง ให้เข้าใกล้ความน่าเชื่อถือภายใต้ความจุ—โดยอิสระจากกัน

ในทางปฏิบัติ การแยกยังคงเป็นวิธีที่ดีในการหาเหตุผล: ถ้าประสิทธิภาพแย่ คุณสามารถถามได้ว่าต้นเหตุอยู่ที่การบีบอัด (source coding) การเสียบนลิงก์ (channel coding) หรือความหน่วงจากการส่งซ้ำและบัฟเฟอร์

ตัวอย่างชัดเจน: สตรีมมิงวิดีโอบน Wi‑Fi

เมื่อคุณสตรีมวิดีโอ แอปใช้โคเด็กบีบอัดเฟรม เหนือ Wi‑Fi แพ็กเก็ตอาจหายหรือเสียหาย ระบบจึงเพิ่มการตรวจจับข้อผิดพลาด บางครั้ง FEC แล้วใช้ การส่งซ้ำ (ARQ) เมื่อจำเป็น ถ้าการเชื่อมต่อแย่ลง ผู้เล่นอาจสลับไปยังสตรีมบิตเรทต่ำกว่า

ระบบจริงมักเบลอการแยกระหว่างสองส่วนนี้เพราะเวลาเป็นปัจจัยสำคัญ: การรอการส่งซ้ำอาจทำให้บัฟเฟอร์ การสลับคุณภาพและการเพิ่ม/ลดความซ้ำซ้อนจึงมักรวมกันเพื่อรับมือสภาพเครือข่ายที่เปลี่ยนเร็ว—ไม่แยกอย่างสมบูรณ์ แต่ยังคงได้รับการชี้นำจากโมเดลของ Shannon

ความเข้าใจผิดทั่วไปและการแลกเปลี่ยนเชิงปฏิบัติ

ตรวจสอบในสภาพแวดล้อมการผลิต

ปรับใช้และโฮสต์งานของคุณเพื่อดูพฤติกรรมบนเครือข่ายจริง

ทฤษฎีข้อมูลถูกอ้างบ่อย และบางความคิดถูกทำให้เรียบง่ายมากเกินไป นี่คือความเข้าใจผิดที่พบบ่อย—และการแลกเปลี่ยนที่จริงแล้ววิศวกรต้องทำเมื่อออกแบบการบีบอัด การจัดเก็บ และเครือข่าย

ความเข้าใจผิด 1: “เอนโทรปีหมายถึงความสุ่ม”

ในภาษาทั่วไป “สุ่ม” อาจหมายถึงยุ่งหรือทำนายไม่ได้ แต่เอนโทรปีของ Shannon แคบกว่า: มันวัด ความประหลาดใจ ตามแบบจำลองความน่าจะเป็น

- สตรีมที่ทำนายได้สมบูรณ์ (เช่น ศูนย์ทั้งหมด) มีเอนโทรปีต่ำ

- สตรีมที่ยากจะทำนาย ตามสิ่งที่คุณรู้ มีเอนโทรปีสูง

ดังนั้นเอนโทรปีไม่ใช่แค่ความรู้สึก มันเป็นตัวเลขผูกกับสมมติฐานเกี่ยวกับพฤติกรรมของแหล่งข้อมูล

ความเข้าใจผิด 2: “บีบอัดมากขึ้นย่อมดีกว่าเสมอ”

การบีบอัดเอาความซ้ำซ้อนออก ในขณะที่การแก้ไขข้อผิดพลาดมัก เพิ่ม ความซ้ำซ้อนโดยตั้งใจเพื่ิอให้ผู้รับซ่อมข้อมูลได้

นั่นสร้างความขัดแย้งในทางปฏิบัติ:

- ถ้าคุณบีบอัดมากแล้วส่งผ่านช่องทางที่มีเสียงรบกวน คุณอาจมีพื้นที่น้อยสำหรับกู้คืนเมื่อข้อมูลเสียหาย

- ระบบที่ออกแบบดีมักบีบอัดก่อน แล้วจึงเพิ่มความซ้ำซ้อนเชิงโครงสร้าง (รหัสแก้ข้อผิดพลาด) สำหรับช่องทาง

ความเข้าใจผิด 3: “เราทำให้เชื่อถือได้สมบูรณ์ที่ความเร็วใดก็ได้”

ความจุช่องทางของ Shannon บอกว่าทุกช่องทางมีเพดานแบนด์วิดท์ที่เชื่อถือได้ ภายใต้สภาพสัญญาณที่กำหนด ต่ำกว่าพื้นที่นั้น อัตราข้อผิดพลาดสามารถทำให้เข้าใกล้ศูนย์ได้ด้วยรหัสที่เหมาะสม; เหนือมัน ข้อผิดพลาดจะหลีกเลี่ยงไม่ได้

นี่คือเหตุผลที่ "เชื่อถือได้สมบูรณ์ที่ความเร็วใดก็ได้" เป็นไปไม่ได้: การผลักความเร็วขึ้นมักหมายถึงยอมรับอัตราข้อผิดพลาดสูงขึ้น ความหน่วงสูงขึ้น (การส่งซ้ำมากขึ้น) หรือโอเวอร์เฮดมากขึ้น (รหัสที่เข้มแข็งขึ้น)

เช็คลิสต์ง่ายๆ สำหรับระบบจริง

เมื่อประเมินผลิตภัณฑ์หรือสถาปัตยกรรม ให้ถาม:

- สถิติแหล่งข้อมูล: ข้อมูลทำนายได้หรือไม่ (ข้อความ, บันทึก) หรือใกล้เคียงกับสุ่มแล้ว (เข้ารหัส, บีบอัดแล้ว)?

- เสียงรบกวน: อะไรคุกคามข้อมูล—การรบกวนไร้สาย การสึกหรอของสื่อ การสูญเสียแพ็กเก็ต?

- งบประมาณความหน่วง: คุณทนรอการส่งซ้ำและการบัฟเฟอร์ได้หรือไม่ หรือต้องเรียลไทม์?

- ตัวเลือกโอเวอร์เฮด: คุณใช้บิตไปกับการบีบอัด การแก้ไขข้อผิดพลาด การส่งซ้ำ หรืองานผสม?

การตั้งค่าสี่ข้อนี้ถูกต้องสำคัญกว่าการจำสูตร

ข้อสรุปสำคัญและทางไปต่อ

ข้อความหลักของ Shannon คือข้อมูลสามารถวัด ย้าย ปกป้อง และบีบอัดได้โดยใช้ชุดแนวคิดเพียงไม่กี่ข้อ

- บิต คือสกุลเงินร่วมที่ทำให้ข้อความ ทุกชนิดถูกปฏิบัติเดียวกันเมื่อตั้งเป็นบิต

- เอนโทรปี วัดความไม่แน่นอนของแหล่ง และความไม่แน่นอนนั้นทำนายการบีบอัดได้

- เสียงรบกวนและการสูญเสียหลีกเลี่ยงไม่ได้ ดังนั้นระบบที่เชื่อถือได้เพิ่ม ความซ้ำซ้อน ผ่านการตรวจจับข้อผิดพลาดและ รหัสแก้ไขข้อผิดพลาด

- ความจุช่องทาง กำหนดเพดานจริง: เกินอัตราหนึ่งแล้วไม่มีทางที่การออกแบบจะได้ความน่าเชื่อถือสมบูรณ์ คุณต้องลดอัตรา ปรับปรุงช่องทาง หรือเปลี่ยนการเข้ารหัส

เครือข่ายและระบบเก็บข้อมูลสมัยใหม่คือการแลกเปลี่ยนระหว่างอัตรา ความน่าเชื่อถือ ความหน่วง และการคำนวณอย่างไม่หยุดนิ่ง

ข้อสังเกตเชิงปฏิบัติสำหรับผู้สร้าง

ถ้าคุณสร้างผลิตภัณฑ์จริง—API ฟีเจอร์สตรีมมิง แอปมือถือ หรือพายไลน์เทเลเมทรี—กรอบคิดของ Shannon เป็นเช็คลิสต์การออกแบบที่มีประโยชน์: บีบอัดสิ่งที่บีบอัดได้ ปกป้องสิ่งที่จำเป็น และระบุงบประมาณความหน่วง/อัตราอย่างชัดเจน สิ่งนี้เห็นได้ชัดเมื่อลองต้นแบบระบบเอนด์ทูเอนด์อย่างรวดเร็วแล้ววนทำซ้ำ: ด้วยแพลตฟอร์มแบบแชทเป็นโค้ดอย่าง Koder.ai ทีมสามารถสปินขึ้นเว็บแอป React, แบ็กเอนด์ Go กับ PostgreSQL, และแม้แต่ไคลเอนต์ Flutter จากสเป็กที่ขับเคลื่อนด้วยแชท แล้วทดสอบการแลกเปลี่ยนในโลกจริง (ขนาดเพย์โหลด การลองซ้ำ พฤติกรรมบัฟเฟอร์) ตั้งแต่เนิ่นๆ ฟีเจอร์อย่างโหมดวางแผน สแนปช็อต และการย้อนกลับช่วยให้ทดลองปรับ "ความน่าเชื่อถือมากขึ้น vs โอเวอร์เฮดต่ำ" ได้ง่ายโดยไม่เสียโมเมนตัม

ใครควรอ่านต่อ

การอ่านเชิงลึกคุ้มค่าสำหรับ:

- นักศึกษา ที่ต้องการแบบคิดชัดเจนเชื่อมความน่าจะเป็นกับการบีบอัดและการเข้ารหัส

- ผู้จัดการผลิตภัณฑ์ ที่ต้องตัดสินใจแลกเปลี่ยนระหว่างคุณภาพ ความหน่วง แบนด์วิดท์ และต้นทุน

- วิศวกร ที่ทำงานบนเครือข่าย โคเด็กสื่อ การเก็บข้อมูล เทเลเมทรี หรืองานพายไลน์ข้อมูลของ ML

ถ้าต้องการต่อยอด ลองอ่านเอกสารอธิบายที่เกี่ยวข้องใน /blog แล้วตรวจดู /docs สำหรับวิธีที่ผลิตภัณฑ์ของเรารExpose การตั้งค่าและ API เกี่ยวกับการสื่อสารและการบีบอัด ถ้ากำลังเปรียบแผนหรือขีดจำกัดอัตราผ่าน ข้อความถัดไปคือ /pricing