19 ต.ค. 2568·3 นาที

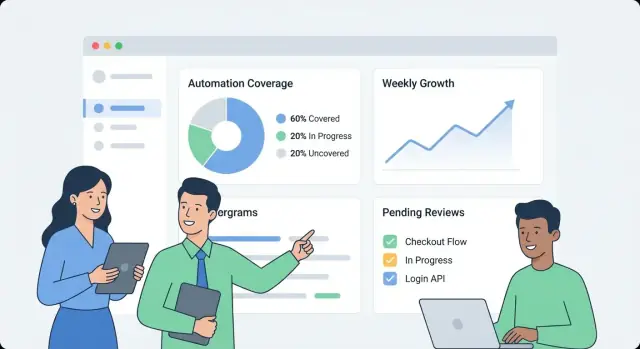

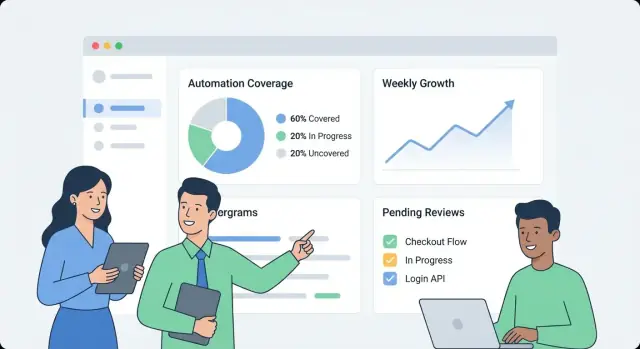

วิธีสร้างเว็บแอปเพื่อติดตามการครอบคลุมการอัตโนมัติภายในองค์กร

เรียนรู้การออกแบบและสร้างเว็บแอปเพื่อติดตามการครอบคลุมการอัตโนมัติภายใน: เมตริก แบบข้อมูล การผสานรวม UX แดชบอร์ด และการแจ้งเตือน

เรียนรู้การออกแบบและสร้างเว็บแอปเพื่อติดตามการครอบคลุมการอัตโนมัติภายใน: เมตริก แบบข้อมูล การผสานรวม UX แดชบอร์ด และการแจ้งเตือน

ก่อนจะเริ่มสร้างอะไร ให้เขียนลงไปก่อนว่า “การครอบคลุมการอัตโนมัติ” หมายถึงอะไรในองค์กรคุณ มิฉะนั้นแดชบอร์ดจะกลายเป็นชุดตัวเลขกระจัดกระจายที่ทีมต่าง ๆ แปลความหมายต่างกัน

เริ่มจากการเลือก หน่วย ที่คุณจะวัด ตัวเลือกที่พบบ่อยได้แก่:

เลือกคำนิยามหลักสำหรับ v1 แล้วบันทึกประเภทรองที่อาจเพิ่มในภายหลัง ระบุกรณีขอบเขตอย่างชัดเจน เช่น ขั้นตอน “กึ่งอัตโนมัติ” ที่ยังต้องมีการอนุมัติอยู่

ผู้ชมที่ต่างกันจะตั้งคำถามต่างกัน:

เขียน 5–10 “คำถามยอดนิยม” และถือเป็นข้อกำหนดผลิตภัณฑ์

กำหนดผลลัพธ์หลัก: การมองเห็น (อะไรมีอยู่), การจัดลำดับความสำคัญ (ควรอัตโนมัติอะไรต่อไป), ความรับผิดชอบ (ใครเป็นเจ้าของ), และ การติดตามแนวโน้ม (มันดีขึ้นหรือไม่)

ตั้งขอบเขตชัดเจนสำหรับ v1 ตัวอย่างเช่น: “เราจะยังไม่ให้คะแนนคุณภาพ”, “เราไม่วัดเวลาที่ประหยัดได้”, หรือ “เราจะรวมเฉพาะเทสต์จาก CI เท่านั้น ไม่รวมสคริปต์ท้องถิ่น”

สุดท้าย ตัดสินใจว่า “ความสำเร็จ” เป็นอย่างไร: การนำไปใช้อย่างสม่ำเสมอ (ผู้ใช้รายสัปดาห์), ความสดของข้อมูลสูง (อัพเดตภายใน 24 ชั่วโมง), จุดบอดลดลง (ครอบคลุมระบบสำคัญทั้งหมด), และการติดตามผลที่วัดได้ (มอบหมายเจ้าของและช่องว่างลดลงทุกเดือน)

ก่อนจะวัดการครอบคลุม คุณต้องรู้ว่า “หลักฐานการอัตโนมัติ” อยู่ที่ไหน ในองค์กรส่วนใหญ่ การอัตโนมัติกระจายอยู่ในเครื่องมือต่าง ๆ ที่ทีมต่างกันนำมาใช้ในเวลาแตกต่างกัน

เริ่มด้วยรายการจริงจังที่ตอบคำถาม: สัญญาณใดยืนยันได้ว่างานเป็นอัตโนมัติ และเราดึงมันมาจากที่ไหน?

แหล่งทั่วไปรวมถึงพายป์ไลน์ CI (งาน build/test), เฟรมเวิร์กการทดสอบ (ผล unit/integration/E2E), เครื่องมือเวิร์กโฟลว์ (การอนุมัติ การปรับใช้ การเปลี่ยนสถานะตั๋ว), runbook (สคริปต์และคู่มือ), และแพลตฟอร์ม RPA สำหรับแต่ละแหล่ง ให้จับตัวระบุที่คุณจะใช้เชื่อมต่อภายหลัง (รีโป, ชื่อบริการ, สภาพแวดล้อม, ทีม) และ “หลักฐาน” ที่จะเก็บ (การรันงาน, รายงานชุดทดสอบ, กฎการอัตโนมัติ, การรันสคริปต์)

ต่อมารายการระบบเป็นแหล่งอ้างอิงที่กำหนดว่าอะไร "ควรมี": โฮสต์รีโป, ตัวติดตามปัญหา, และ CMDB/แคตตาล็อกบริการ แหล่งเหล่านี้มักให้รายการบริการ เจ้าของ และความสำคัญที่เป็นทางการ—จำเป็นสำหรับการคำนวณการครอบคลุมแทนการนับกิจกรรมอย่างเดียว

จับคู่แต่ละแหล่งกับวิธีการนำเข้าที่เปราะบางน้อยที่สุด:

บันทึก rate limits, วิธีการพิสูจน์ตัวตน (PAT, OAuth, บัญชีเซอร์วิส), หน้าต่างการเก็บข้อมูล, และปัญหาคุณภาพข้อมูลที่รู้จัก (บริการเปลี่ยนชื่อ, การตั้งชื่อไม่สอดคล้อง, เจ้าของหาย)\n\nสุดท้าย วางแผนให้มี คะแนนความน่าเชื่อถือของแหล่งข้อมูล ต่อคอนเนคเตอร์ (และถ้าต้องการต่อเมตริก) เพื่อให้ผู้ใช้เห็นตัวเลขว่าเป็น “ความมั่นใจสูง” หรือ “ความพยายามดีที่สุด” สิ่งนี้ป้องกันความเท็จแน่นอนและช่วยจัดลำดับความสำคัญของการปรับปรุงคอนเนคเตอร์ในภายหลัง

แดชบอร์ดการครอบคลุมที่มีประโยชน์เริ่มจากแบบข้อมูลที่แยกความตั้งใจว่าจะอัตโนมัติออกจากสิ่งที่รันจริงๆ หากผสมกัน เลขของคุณอาจดูดีทั้งที่การอัตโนมัติล้าสมัย

เริ่มด้วยบล็อกพื้นฐานเหล่านี้:

เลือกระดับการรายงานหลักหนึ่งระดับและยึดตามมัน:

คุณสามารถสนับสนุนมุมมองหลายแบบในภายหลัง แต่เวอร์ชันแรกควรมีระดับ “แหล่งความจริง” หนึ่งระดับ

ใช้ ID ที่อยู่รอดจากการ refactor:

ปฏิบัติกับชื่อที่แสดงเป็นสิ่งที่แก้ไขได้ ไม่ใช่ตัวระบุ

รูปแบบปฏิบัติได้จริง:\n\n- Requirement คือ เป้าหมาย\n- CoverageClaim เชื่อม Requirement ↔ Automation Asset (เป็น คำอ้าง ว่าครอบคลุม)\n- Run เชื่อมกับ Automation Asset (เป็น หลักฐาน)\n\nสิ่งนี้ช่วยให้ตอบได้ว่า: “อะไรที่ควรถูกครอบคลุม?”, “อะไรอ้างว่าครอบคลุมมัน?”, และ “อะไรที่รันจริง?”

จับ:\n\n- last_seen_at (asset ยังมีอยู่)\n- last_run_at, last_failure_at\n- last_reviewed_at (มีคนยืนยันคำอ้างยังใช้ได้)\n\nฟิลด์ความสดทำให้เน้นรายการที่ "ถูกครอบคลุมแต่ล้าสมัย" ได้โดยไม่ต้องโต้เถียง

ถ้าเมตริกการครอบคลุมคลุมเครือ ทุกชาร์ตจะกลายเป็นข้อโต้แย้ง เริ่มด้วยการเลือก เมตริกหลักหนึ่งตัว สำหรับสรุปผู้บริหาร แล้วเพิ่มการแยกย่อยรองสำหรับทีม

องค์กรส่วนใหญ่เลือกหนึ่งในนี้:\n\n- % อัตโนมัติตามจำนวน: อธิบายง่ายสุด (เช่น “120 จาก 200 งาน”) เหมาะเมื่อรายการใกล้เคียงกัน\n- % อัตโนมัติตามน้ำหนักความพยายาม: ดีกว่าเมื่อบางรายการใหญ่กว่ามาก ให้ถ่วงน้ำหนักตามชั่วโมงประมาณหรือความซับซ้อน\n- % อัตโนมัติตามความเสี่ยง: โฟกัสสิ่งที่จะทำให้เกิดผลกระทบร้ายแรง (ผลต่อลูกค้า, ข้อกำหนด, การล่มของระบบ)\n\nคุณยังสามารถแสดงทั้งสามได้ แต่ต้องระบุชัดว่าตัวไหนเป็นตัวเลข "หัวข้อ"\n

เขียนกฎชัดเจนเพื่อให้ทีมให้คะแนนด้วยความสอดคล้อง:\n\n- Automated: รันแบบ end-to-end โดยไม่ต้องทำด้วยมือและมีเอาต์พุตที่ตรวจสอบได้\n- Partially automated: มีการอัตโนมัติ แต่ยังต้องการการอนุมัติด้วยมือ การเตรียมข้อมูลด้วยมือ หรือแก้ด้วยมือบ่อยครั้ง\n- Manual: ไม่มีการอัตโนมัติ หรือมีสคริปต์แต่รันไม่ได้เชื่อถือได้ \nทำให้กฎเป็นสิ่งที่วัดได้ หากสองคนไม่สามารถให้คะแนนรายการเดียวกันได้ ให้ปรับคำนิยาม

ใช้สเกลจำนวนเต็มเล็ก ๆ (1–5) สำหรับอินพุตเช่น risk, business impact, run frequency, และ time saved ตัวอย่าง: weight = risk + impact + frequency.

อย่านับรายการเป็น “อัตโนมัติ” เว้นแต่จะมีหลักฐาน เช่น:\n\n- อย่างน้อย N การรันที่สำเร็จใน 30 วันที่ผ่านมา\n- ลิงก์ไปยัง งาน CI, บันทึกรัน, หรือบัตรที่พิสูจน์การดำเนินการ\n\nวิธีนี้เปลี่ยนการครอบคลุมจากคำอ้างที่รายงานเองเป็นสัญญาณที่สังเกตได้

เก็บกฎการให้คะแนนและตัวอย่างไว้ในหน้าเดียว (เชื่อมจากแดชบอร์ด) เพื่อการตีความที่สอดคล้อง ทำให้แนวโน้มเชื่อถือได้

แอปการครอบคลุมภายในควร “น่าเบื่อ” ในความหมายที่ดี: ดูแลง่าย เปลี่ยนแปลงง่าย และชัดเจนว่าเลขมาจากไหน รูปทรงพื้นฐาน “API + ฐานข้อมูล + แดชบอร์ด” มักดีกว่าระบบกระจายจนกว่าคุณจะต้องการจริงๆ

เลือกสแตกที่ทีมของคุณรองรับอยู่แล้ว พื้นฐานทั่วไปคือ:\n\n- Backend: เว็บ API เดียว (เช่น Node/Express, Python/FastAPI, Ruby on Rails)\n- Database: Postgres สำหรับเอนทิตีหลัก\n- Frontend: แดชบอร์ดน้ำหนักเบา (React/Vue) อ่านจาก API

ถ้าอยากไปเร็วในเวอร์ชันภายในแรก วิธีก้าวเร็วแบบ vibe-coding ก็ใช้ได้ ตัวอย่างเช่น Koder.ai สามารถช่วยสร้างแดชบอร์ด React พร้อม backend Go + PostgreSQL จากสเปคที่มีโครงสร้าง แล้วให้ทีมต่อยอดผ่านแชทพร้อมการส่งออกซอร์สโค้ดเต็มรูปแบบและการ deploy ปกติ

แม้ในระบบ "เรียบง่าย" ให้แยกความรับผิดชอบ:

ใช้ตารางเชิงสัมพันธ์สำหรับเอนทิตี canonical (ทีม, บริการ, อัตโนมัติ, หลักฐาน, เจ้าของ) สำหรับแนวโน้ม (การรันตามเวลา, การครอบคลุมตามสัปดาห์) ให้เก็บ:\n\n- ตาราง time-series ใน Postgres (partition ตามวันที่), หรือ\n- ที่เก็บ time-series แยกต่างหาก เฉพาะเมื่อปริมาณการคิวรีสูงมาก

ถ้าหลายทีมใช้แอปเดียว ให้เพิ่ม org_id/team_id ตั้งแต่ต้น เพื่อรองรับสิทธิ์และหลีกเลี่ยงการย้ายข้อมูลเจ็บปวดเมื่อผู้นำขอ “แดชบอร์ดเดียว แต่แยกส่วน”

รัน dev/staging/prod และกำหนดวิธีการย้ายข้อมูล:\n\n- ใช้สคีมาที่คล้าย production ในทุกสภาพแวดล้อม\n- ใน staging ให้ดึงข้อมูลในขอบเขตจำกัดหรือชุดข้อมูลสังเคราะห์\n- โปรโมตโค้ดผ่าน CI; หลีกเลี่ยงการแก้ไขแมปปิ้งใน production ด้วยมือ (ใช้การเปลี่ยนแปลงที่มีการตรวจสอบผ่าน UI)

สำหรับข้อมูลเพิ่มเติมเกี่ยวกับการทำให้ UI ใช้งานง่าย ดู /blog/design-dashboard-ux.

แดชบอร์ดการครอบคลุมกลายเป็นแหล่งความจริงได้อย่างรวดเร็ว ดังนั้นการควบคุมการเข้าถึงและการจัดการข้อมูลจึงสำคัญเท่ากับชาร์ต เริ่มแบบเรียบง่าย แต่ออกแบบให้ความปลอดภัยขึ้นเข้มงวดขึ้นได้โดยไม่ต้องเขียนใหม่มาก

ถ้าบริษัทมี SSO อยู่แล้ว ให้ผสานตั้งแต่วันแรก (OIDC มักง่ายที่สุด; SAML พบได้ในองค์กรใหญ่) หากต้องการเปิดใช้ภายในอย่างรวดเร็ว คุณอาจเริ่มหลัง proxy ที่ฉีด header ตัวตน แล้วค่อยเปลี่ยนเป็น SSO แบบเนทีฟเมื่อพร้อม

ไม่ว่าจะเลือกทางใด ให้ทำให้ตัวตนเป็นคีย์ผู้ใช้ที่เสถียร (email อาจเปลี่ยน) เก็บโปรไฟล์ผู้ใช้อย่างน้อยที่สุดและดึงกลุ่ม/สมาชิกทีมเมื่อจำเป็น

กำหนดชุดบทบาทเล็ก ๆ และทำให้การอนุญาตสอดคล้องทั้ง UI และ API:\n\n- Viewer: อ่านแดชบอร์ดและดูหลักฐานได้\n- Editor: เสนอหรือปรับเมตาดาต้า (เจ้าของ, แท็ก) และส่งการแก้ไข\n- Admin: จัดการการเชื่อมต่อ กฎการให้คะแนน และการตั้งค่าระดับโลก\n- Service owner (จำกัดสโคป): ปรับคำอ้างและเวิร์กโฟลว์เฉพาะบริการที่ตัวเองเป็นเจ้าของ

ชอบการอนุญาตตามสโคป (ตามทีม/บริการ) มากกว่า “super users” เพราะลดความเสี่ยงและหลีกเลี่ยงคอขวด

หลักฐานการครอบคลุมมักรวมลิงก์ไปยังล็อก CI, ตั๋วเหตุการณ์, หรือเอกสารภายใน จำกัดการเข้าถึง URL เหล่านั้นและล็อกดิบ เก็บเฉพาะสิ่งที่ต้องการสำหรับการยืนยัน (เช่น build ID, timestamp, สรุปสถานะ) แทนการคัดลอกล็อกทั้งก้อนลงฐานข้อมูล

การแก้ไขด้วยมือใด ๆ ในคำอ้างการครอบคลุมหรือเมตาดาต้าควรสร้างบันทึก audit: ใครเปลี่ยนอะไร เวลาใด และเหตุผล (ช่องข้อความอิสระ) สุดท้าย กำหนดนโยบายการเก็บรักษาสำหรับประวัติการรันและหลักฐาน—กำหนดระยะเวลาเก็บและปฏิบัติการลบอย่างปลอดภัยเพื่อให้ระเบียนเก่า ๆ ถูกลบทิ้งโดยไม่ทำลายการคำนวณการครอบคลุมปัจจุบัน

แดชบอร์ดการครอบคลุมประสบความสำเร็จเมื่อใครสักคนตอบคำถามสามข้อได้ภายในหนึ่งนาที: เราเป็นอย่างไร? มีอะไรเปลี่ยนแปลง? ควรแก้อะไรต่อ? ออกแบบ UX รอบการตัดสินใจเหล่านั้น ไม่ใช่รอบแหล่งข้อมูล

ให้หน้าจอแรกเป็นภาพรวมเรียบง่าย:\n\n- การครอบคลุมการอัตโนมัติโดยรวม (ตัวเลขหัวข้อหนึ่งตัว) พร้อม tooltip คำจำกัดความสั้น ๆ (“% ของกระบวนการที่มีการรันอัตโนมัติที่ตรวจสอบได้อย่างน้อยหนึ่งครั้งใน X วันที่ผ่านมา”)\n- แนวโน้มตามเวลา (30/90 วันที่ผ่านมา) เพื่อให้ทีมเห็นว่าการครอบคลุมดีขึ้นหรือลดลงหรือไม่\n- ความสด (หลักฐานรันล่าสุดเมื่อไร) สัญญาณล้าสมัยควรแตกต่างมองเห็นได้จากการรันที่ล้มเหลว\n- ช่องว่างสำคัญ: รายการสั้น ๆ ของบริเวณที่ไม่มีหรือล้าสมัยมากที่สุด โดยเรียงตามผลกระทบ (เช่น ความสำคัญ × ปริมาณ)

ใช้ป้ายคำที่เป็นภาษาธรรมดา (“รันเมื่อเร็ว ๆ นี้” ดีกว่า “ความสดของหลักฐาน”) และหลีกเลี่ยงการบังคับให้ผู้อ่านตีความสถานะเชิงเทคนิค

จากเมตริกภาพรวม ให้ผู้ใช้คลิกเข้าไปยังหน้าบริการ/กระบวนการที่ตอบคำถามว่า “อะไร” และ “โดยอะไร”:\n\n- อะไรที่ถูกอัตโนมัติ (ขั้นตอน/ความสามารถใด) และ อะไรที่ไม่ถูก\n- โดย asset ใด (สคริปต์, workflow, งาน CI, บอท RPA) รวมถึง เวลาการรันล่าสุด และ ผลการรันล่าสุด\n- เส้นเวลาเล็ก ๆ หรือประวัติการรันเพื่อแสดงว่าความล้มเหลวเป็นครั้งเดียวหรือเกิดซ้ำ

ออกแบบแต่ละแถว/การ์ดให้มี “เหตุผลเบื้องหลังตัวเลข”: ลิงก์หลักฐาน, เจ้าของ, สถานะการรันล่าสุด, และ การดำเนินการถัดไป ชัดเจน (“รันงานอีกครั้ง”, “มอบหมายเจ้าของ”, “เพิ่มหลักฐานที่หายไป”)

เสนอฟิลเตอร์ที่แมปกับการทำงานจริงขององค์กร:\n\n- ทีม, สภาพแวดล้อม (prod/staging), ความสำคัญ, ช่วงเวลา, และระบบแหล่งที่มา

เก็บสถานะฟิลเตอร์ให้มองเห็นและแชร์ได้ (พารามิเตอร์ URL) เพื่อให้คนส่งลิงก์เช่น “Prod + Tier-1 + 14 วันล่าสุด” ให้ผู้เกี่ยวข้องได้ง่าย

ใช้คำอธิบายสั้น ๆ แทนเอกสารยาว:\n\n- Tooltip สำหรับเมตริก และคำชี้แจงสั้น ๆ เช่น “การครอบคลุมยกเว้นการเช็คด้วยมือ”\n- ความหมายสีที่สอดคล้อง (เช่น เขียว = ยืนยันแล้ว, เหลือง = ล้าสมัย, แดง = ล้มเหลว) พร้อมไอคอน/ข้อความสำหรับการเข้าถึง\n- ลิงก์ “เรียนรู้ว่าหมายความว่าอย่างไร” ไปยังหน้าอธิบายภายใน เช่น /docs/coverage-metrics

การผสานรวมคือจุดที่แอปการครอบคลุมของคุณกลายเป็นของจริง เป้าหมายไม่ใช่เลียนแบบทุกฟีเจอร์ของ CI หรือเครื่องมือทดสอบ แต่ดึงชุดข้อเท็จจริงที่สอดคล้องกัน: อะไรรัน, เมื่อใดรัน, อะไรที่มันครอบคลุม, และใครเป็นเจ้าของ

เริ่มจากระบบที่ผลิตสัญญาณการอัตโนมัติ: CI (GitHub Actions, GitLab CI, Jenkins), ตัวรันเทสต์ (JUnit, pytest), และเครื่องมือคุณภาพ (รายงาน coverage, linters, สแกนความปลอดภัย)

คอนเนคเตอร์ควรดึง (หรือรับผ่าน webhook) payload ขั้นต่ำ:\n\n- ตัวระบุ pipeline/build และสถานะ\n- ชื่อชุดทดสอบ ผลทดสอบแต่ละตัว (ถ้าต้องการ) และจำนวนผ่าน/ล้มเหลว\n- timestamp ของการรัน ระยะเวลา และสภาพแวดล้อม (เช่น staging/prod)\n- repository, branch, และ commit SHA

ทำให้คอนเนคเตอร์ idempotent: การดึงซ้ำไม่ควรสร้างรายการซ้ำ

ช่องว่างบางอย่างตั้งใจเป็นเช่นนั้น (ระบบเก่า, ข้อจำกัดของบุคคลที่สาม, โครงการหยุดชั่วคราว) ให้มีระเบียน “ข้อยกเว้น” เบา ๆ ที่ต้อง:\n\n- มีเจ้าของ (บุคคลหรือทีม)\n- ระบุเหตุผล/หมวดหมู่ (เช่น blocked, out of scope, deprecated)\n- มีวันที่ทบทวน (เพื่อให้ข้อยกเว้นหมดอายุหากไม่ได้ยืนยัน)

วิธีนี้ป้องกันไม่ให้เกิดจุดบอดถาวรและทำให้มุมมองผู้นำตรงไปตรงมาขึ้น

แหล่งข้อมูลต่าง ๆ มักใช้ชื่อต่างกัน: หนึ่งระบบเรียก “payments-service”, อีกระบบเรียก “payments”, อีกระบบใช้ slug ของรีโป

สร้างกฎการปรับชื่อสำหรับ:\n\n- ชื่อบริการ\n- ชื่อรีโป\n- สภาพแวดล้อม (prod, production, live → prod)

ทำสิ่งนี้แต่เนิ่น ๆ; เมตริกทั้งหมดขึ้นอยู่กับมัน

เพิ่มตาราง alias (เช่น service_aliases, repo_aliases) ที่แมปชื่อภายนอกหลายชื่อไปเป็นเอนทิตี canonical เมื่อข้อมูลใหม่มาถึง ให้แมปกับ ID canonical ก่อน แล้วจึงเทียบกับ alias\n\nถ้าชื่อใหม่ไม่แมตช์ ให้สร้างคำแนะนำการรวม (เช่น “payments-api” ดูคล้าย “payments-service”) เพื่อให้แอดมินอนุมัติ

ตั้งงานที่รันเป็นช่วงเพื่อตรวจสอบ timestamp การรันล่าสุดต่อแหล่งและทำเครื่องหมายสิ่งที่ล้าสมัย (เช่น ไม่มีรัน CI ใน 7 วัน) เปิดเผยข้อมูลนี้ใน UI เพื่อไม่ให้การครอบคลุมต่ำสับสนกับข้อมูลขาดหาย

แดชบอร์ดมีประโยชน์ แต่การแจ้งเตือนและเวิร์กโฟลว์แบบเบาทำให้ข้อมูลที่น่าสนใจกลายเป็นการปรับปรุงที่ต่อเนื่อง เป้าหมายคือแจ้งคนที่เหมาะสมในเวลาที่เหมาะสม พร้อมบริบทพอให้ดำเนินการได้

เริ่มด้วยชุดเล็ก ๆ ของการแจ้งเตือนที่สัญญาณชัดเจน:\n\n- การลดของการครอบคลุม (เช่น บริการลดจาก 80% เหลือ 65% หลังการปล่อย)\n- หลักฐานล้าสมัย (มีการอ้างถึงการอัตโนมัติ แต่หลักฐาน/ลิงก์ไม่ได้อัพเดต N วัน)\n- การอัตโนมัติที่ล้มเหลวบ่อย (เทสต์หรืองานล้มเหลวบ่อย ทำให้การครอบคลุมไม่จริง)\n- ขาดเจ้าของ (บริการหรือเวิร์กโฟลว์สำคัญไม่มีทีมรับผิดชอบ)

แต่ละการแจ้งเตือนควรลิงก์ไปยังมุมมองเจาะลึกที่เกี่ยวข้อง เพื่อให้ผู้คนไม่ต้องตามหา (เช่น /services/payments?tab=coverage หรือ /teams/platform?tab=owners)

หลีกเลี่ยงเกณฑ์แบบ one-size-fits-all ให้ทีมตั้งกฎเช่น:\n\n- เปอร์เซ็นต์การครอบคลุมขั้นต่ำสำหรับบริการของพวกเขา\n- หน้าต่าง “ล้าสมัย” สำหรับหลักฐาน (7 วัน สำหรับระบบเคลื่อนไหวเร็ว, 30 วัน สำหรับระบบเสถียร)\n- จำนวนความล้มเหลวหรือระยะเวลาก่อนการแจ้งเตือนแบบ paging เทียบกับ “แจ้งเฉยๆ”

วิธีนี้ทำให้สัญญาณมีความหมายและลดความเหนื่อยหน่ายจากการแจ้งเตือน

ส่งการแจ้งเตือนไปยังช่องทางที่มีอยู่ (อีเมลและ Slack) โดยรวม: อะไรเปลี่ยน ทำไมถึงสำคัญ และใครเป็นเจ้าของ ควบคู่กับการแจ้งเตือนแบบเรียลไทม์ ให้มี สรุประดับสัปดาห์ ที่ครอบคลุม:\n\n- การเปลี่ยนแปลงการครอบคลุมตั้งแต่สัปดาห์ก่อน\n- โอกาสการอัตโนมัติสูงสุด (ช่องว่างใหญ่สุดตามผลกระทบ)\n- รายการถูกบล็อก (ขาดเจ้าของ, pipeline แตก, หลักฐานหาย)

ปฏิบัติต่อการแจ้งเตือนเหมือนงาน: อนุญาตให้ ยืนยัน, มอบหมาย, และมี สถานะ (open/triaged/resolved) เส้นความเห็นสั้น ๆ (“แก้แล้วใน PR #1234”) ทำให้การรายงานน่าเชื่อถือและป้องกันปัญหาเดิมกลับมาเงียบ ๆ

แดชบอร์ดที่รู้สึกเร็วเมื่อ API ตอบคำถามที่ UI ถามโดยตรง—โดยไม่บังคับเบราว์เซอร์เรียกหลายครั้ง เริ่มด้วย surface API แบบมินิมอลสำหรับแดชบอร์ด แล้วเพิ่มงานแบ็กกราวด์เพื่อคำนวณล่วงหน้าสิ่งที่แพง

โฟกัสเวอร์ชันแรกที่หน้าจอหลัก:\n\n- Services list: GET /api/services (ตัวกรองเช่น team, language, tier)\n- Coverage summary: GET /api/services/{id}/coverage (คะแนนรวม + การแยกย่อยหลัก)\n- Evidence runs: GET /api/services/{id}/evidence?status=passed&since=...\n- Update metadata (owner, tags, status): PATCH /api/services/{id}\n\nออกแบบการตอบสนองให้แดชบอร์ดสามารถเรนเดอร์ได้ทันที: รวมชื่อบริการ เจ้าของ เวลาเห็นหลักฐานล่าสุด และคะแนนปัจจุบันใน payload เดียวแทนที่จะต้องเรียกหลายครั้ง

รายการและตารางเจาะลึกควรมีการแบ่งหน้าเสมอ (limit + cursor) สำหรับเอนด์พอยต์ที่ถูกเรียกบ่อย ให้เพิ่ม caching ชั้น API (หรือ shared cache) ที่คีย์โดยตัวกรองและสโคปการเข้าถึงของผู้เรียก

สำหรับสิ่งที่ต้องสแกนหลักฐานจำนวนมาก (เช่น “การครอบคลุมตามทีม”) ให้คำนวณ rollups เป็นงานตอนกลางคืน เก็บผลในตารางแยก (หรือ materialized view) เพื่อให้การอ่านเรียบง่ายและคาดการณ์ได้

แนวโน้มง่ายที่สุดเมื่อคุณเก็บ สแนปชอตรายวัน:\n\n- งานตามตารางคำนวณการครอบคลุมต่อบริการทุกวัน\n- API เปิด GET /api/services/{id}/trend?days=90\n\nสแนปชอตหลีกเลี่ยงการคำนวณเมตริกประวัติซ้ำ ๆ ในทุกการโหลดหน้าและทำให้ "ความสด" (หลักฐานรันล่าสุด) ง่ายต่อการพล็อต

การ onboarding จำนวนมากราบรื่นขึ้นด้วย:\n\n- POST /api/import/services (อัปโหลด CSV)\n- GET /api/export/services.csv\n\nสุดท้าย บังคับกฎการ validate ตอนเขียน: เจ้าของที่จำเป็น ค่า status ที่อนุญาต และ timestamp ที่สมเหตุสมผล (ไม่มีหลักฐานในอนาคต) ปฏิเสธข้อมูลไม่ถูกต้องแต่เนิ่น ๆ ป้องกันการแก้ไขช้าและสับสนในอนาคต—โดยเฉพาะเมื่อ rollups ขึ้นกับอินพุตที่สม่ำเสมอ

แดชบอร์ดการครอบคลุมมีประโยชน์เมื่อผู้คนเชื่อใจมัน ปฏิบัติด้านการปรับใช้และการปฏิบัติการเป็นส่วนหนึ่งของผลิตภัณฑ์: ปล่อยที่คาดเดาได้ สัญญาณสุขภาพชัดเจน และการกู้คืนง่ายเมื่อเกิดปัญหา

สำหรับแอปภายใน ให้เน้นความหนาเบาและการ iterate เร็ว:\n\n- ปรับใช้ภายในก่อน โดยใช้ image คอนเทนเนอร์ + ฐานข้อมูลที่จัดการ (เช่น Postgres), หรือ platform-as-a-service ที่สนับสนุน scheduled jobs และ env vars\n- เก็บการตั้งค่านอก image (env vars หรือ secrets manager) เพื่อให้โปรโมต build เดียวกันข้ามสภาพแวดล้อมได้

ถ้าคุณใช้แพลตฟอร์มอย่าง Koder.ai เพื่อเร่งการพัฒนา ให้ใช้ประโยชน์จากการส่งออกซอร์สโค้ดและเวิร์กโฟลว์การปรับใช้ตั้งแต่ต้น เพื่อให้แอปภายในยังคงปฏิบัติตามกระบวนการโปรโมต ตรวจทาน และ rollback ปกติ

คุณไม่จำเป็นต้องมีสแต็กซับซ้อนเพื่อให้สัญญาณเชื่อถือได้:\n\n- ติดตาม structured logs สำหรับเหตุการณ์สำคัญ: เริ่ม/จบการดึงข้อมูล, ระเบียนที่ประมวลผล, และข้อผิดพลาดการทำ normalization\n- ติดตามเมตริกพื้นฐานที่ผูกกับความเชื่อมั่นของผู้ใช้:\n - Ingestion lag (ข้อมูลล้าสุดเท่าไร)\n - Job failures (คอนเนคเตอร์, parser, งานให้คะแนน)\n - API latency (p95 สำหรับเอนด์พอยต์หลัก)\n- เปิดเผย health checks (liveness/readiness) และสร้างหน้าแอดมินเล็ก ๆ ที่แสดงสถานะคอนเนคเตอร์, การ sync สำเร็จครั้งล่าสุด, และข้อความข้อผิดพลาดล่าสุด

ตั้งค่าการสำรองฐานข้อมูลอัตโนมัติและนโยบายการเก็บรักษาที่ตรงกับความต้องการของคุณ:\n\n- กำหนดเวลาสำรองและยืนยันว่าคุณกู้คืนได้สู่ instance ใหม่\n- รันการฝึกกู้คืนสั้น ๆ หลังการเปลี่ยนสคีมา หรืออัปเกรดคอนเนคเตอร์

บันทึก runbooks สำหรับ:\n\n- การหมุนความลับและโทเค็น API\n- การรันนำเข้าซ้ำอย่างปลอดภัย (idempotent jobs, backfills)\n- ขั้นตอนเหตุการณ์: ปิดคอนเนคเตอร์, ย้อนกลับ, และสื่อสารความสดของข้อมูลบนแดชบอร์ด

ระเบียบวินัยด้านการปฏิบัติงานเล็กน้อยป้องกันไม่ให้ "การครอบคลุม" กลายเป็นการเดา

แอปการตรวจสอบช่วยได้เมื่อทีมเชื่อถือและใช้งานจริง ปฏิบัติต่อการเปิดตัวเหมือนการเปิดตัวผลิตภัณฑ์: เริ่มเล็ก กำหนดความเป็นเจ้าของชัด และฝังจังหวะการอัปเดตที่คาดเดาได้

ทำให้การ onboard เบาและทำซ้ำได้:\n\n- แมปสิ่งที่จะติดตาม: รายการบริการ รีโป และพายป์ไลน์ที่แทนกระบวนการส่งมอบจริงของทีม\n- เชื่อมต่อแหล่งข้อมูล: CI, ตั๋ว, runbook, เครื่องมือเหตุการณ์, แพลตฟอร์มทดสอบ—อะไรก็ตามที่คุณใช้เป็นหลักฐานการอัตโนมัติ\n- มอบหมายเจ้าของ: ตั้งเจ้าของหลักต่อบริการ (และสำรอง) เจ้าของรับผิดชอบแก้ข้อมูลล้าสมัยและทบทวนช่องว่าง

เป้าหมายที่ดีคือ “เห็นแดชบอร์ดครั้งแรกภายใน 30 นาที” ไม่ใช่การตั้งค่าหลายวัน

ตั้งสองจังหวะ:\n\n- ทบทวนการครอบคลุมรายเดือน: แต่ละทีมทบทวนการเปลี่ยนแปลง อธิบายการลด/เพิ่มที่สำคัญ และยืนยัน 1–3 การปรับปรุงสูงสุด\n- ตรวจสอบกฎเมตริกระยะไตรมาส: ทบทวนกฎการให้คะแนนว่าเป็นธรรมและเกี่ยวข้องหรือไม่ (เช่น มาตรฐาน CI ใหม่ เครื่องมือที่เลิกใช้)

คะแนนการครอบคลุมอาจเป็นเรื่องการเมืองถ้ากฎเปลี่ยนโดยไม่แจ้ง ให้กำหนดกลุ่มกำกับดูแลเล็ก ๆ (มักเป็น Eng Productivity + Security/Quality) ที่สามารถ:\n\n- อัปเดตกฎทั่วไป (อะไรนับเป็นหลักฐาน)\n- เปลี่ยนกฎการให้คะแนนและน้ำหนัก\n- อนุมัติคอนเนคเตอร์ใหม่ที่กระทบหลายทีม

เผยแพร่การเปลี่ยนแปลงใน changelog ง่าย ๆ เช่น /docs/scoring-changelog

ติดตามการนำไปใช้ด้วยเมตริกง่าย ๆ: ผู้ใช้แอคทีฟ, บริการที่ติดตาม, และ การปฏิบัติตามความสด (บริการที่มีหลักฐานทันสมัย) ใช้ตัวชี้วัดเหล่านี้เพื่อแนะนำการปรับปรุง: การถ่วงน้ำหนักที่ดีขึ้น, ประเภทหลักฐานที่ละเอียดขึ้น, และคอนเนคเตอร์เพิ่มขึ้น—เน้นสิ่งที่จะลดงานด้วยมือของทีมเสมอ

หากคุณตัดสินใจจะแชร์บทเรียนภายในสู่สาธารณะ ให้พิจารณามาตรฐานบันทึกการสร้างและเทมเพลต: ทีมที่ใช้ Koder.ai ยังสามารถรับเครดิตโดยสร้างเนื้อหาเกี่ยวกับเวิร์กโฟลว์การพัฒนา หรืแนะนำผู้ใช้คนอื่น ๆ เพื่อช่วยระดมทุนสำหรับการพัฒนาเครื่องมือภายในต่อไป

การครอบคลุมการอัตโนมัติคือสิ่งที่องค์กรของคุณตัดสินใจวัดว่า “งานใดถูกจัดการโดยอัตโนมัติ” เทียบกับงานที่ต้องทำด้วยมือ เพื่อหลีกเลี่ยงความสับสน ให้เลือกหน่วยหลักสำหรับ v1 เช่น: กระบวนการ, ข้อกำหนด/การควบคุม, ชุดทดสอบ หรือ runbook แล้วเขียนกฎชัดเจนสำหรับกรณีขอบเขตอย่างเช่นขั้นตอนที่ "กึ่งอัตโนมัติ" ซึ่งยังต้องการการอนุมัติ

คำนิยามที่ดีคือคำนิยามที่สองคนจะให้คะแนนรายการเดียวกันในทางเดียวกัน

เริ่มด้วยการเขียน 5–10 “คำถามยอดนิยม” ที่ผู้ใช้ต้องการคำตอบ และถือเป็นข้อกำหนดของผลิตภัณฑ์ ตัวอย่างทั่วไป:

ผู้ชมต่างกัน (QA, Ops, ผู้นำ) ต้องการมุมมองต่างกัน ดังนั้นตัดสินใจว่า v1 จะโฟกัสตอบกลุ่มใด

จดว่าหลักฐานของการอัตโนมัติอยู่ที่ไหน และระบบใดเป็นแหล่งอ้างอิงที่ “ควรมี” จริงๆ

ถ้าไม่มีระบบบันทึกที่เป็นแหล่งอ้างอิง คุณจะนับกิจกรรมได้ แต่จะยากที่จะคำนวณการครอบคลุมอย่างเชื่อถือได้ เพราะคุณไม่รู้ชุดเป้าหมายทั้งหมด

เลือกวิธีดึงข้อมูลที่ยืดหยุ่นน้อยสุดสำหรับแต่ละแหล่ง:

พร้อมกันนี้ ให้บันทึกข้อจำกัดของคอนเนคเตอร์ (rate limits, auth, หน้าต่างการเก็บข้อมูล) เพื่อให้ผู้ใช้เข้าใจความสดของข้อมูลและความมั่นใจ

แยกระหว่างความตั้งใจ ข้ออ้าง และหลักฐาน เพื่อไม่ให้เมตริกดูเป็นสีเขียวทั้งที่การอัตโนมัติไม่ได้รันจริง

แบบจำลองที่ใช้งานได้จริง:

ใช้ timestamp ความสดและกฎข้อกำหนดของหลักฐาน

ฟิลด์ทั่วไป:

last_seen_at (asset ยังคงมีอยู่)last_run_at, last_failure_atlast_reviewed_at (มีคนยืนยันว่าข้ออ้างยังใช้ได้)แล้วบังคับกฎเช่น “นับเป็นอัตโนมัติเมื่อมี N รอบสำเร็จใน 30 วันที่ผ่านมา” เพื่อแยกแยะระหว่าง “มีอยู่” กับ “ทำงานได้ล่าสุด”

เลือกเมตริกหัวข้อเดียวและทำให้กฎการให้คะแนนชัดเจน

ตัวเลือกยอดนิยม:

ใช้สเกลเล็กๆ (เช่น 1–5) สำหรับน้ำหนัก และให้ตัวอย่างชัดเจนว่า "อัตโนมัติ / กึ่งอัตโนมัติ / ด้วยมือ" หมายความว่าอย่างไร

ปรับชื่อให้ปกติในระยะเริ่มต้นและจัดการการเปลี่ยนชื่ออย่างชัดเจน

ขั้นตอนปฏิบัติ:

service_aliases, repo_aliases) เพื่อแมปชื่อภายนอกเข้ากับ ID canonicalแนวทางนี้ป้องกันการซ้ำและรักษาแนวโน้มประวัติเมื่อทีมเปลี่ยนโครงสร้างหรือเปลี่ยนชื่อรีโป

เริ่มด้วย SSO (OIDC/SAML) ถ้ามี หรือตั้งหน้าแอปไว้หลัง internal auth proxy ชั่วคราวแล้วค่อยสลับไปใช้ SSO แบบเนทีฟ

กำหนดชุดบทบาทเล็กๆ และทำให้การอนุญาตสอดคล้องระหว่าง UI และ API:

เก็บหลักฐานที่ละเอียดอ่อนให้น้อยที่สุด: เก็บแค่ build ID, timestamp และสรุปสถานะ แทนการคัดลอกล็อกทั้งหมด บันทึกการแก้ไขด้วย audit (ใคร/อะไร/เมื่อไร/ทำไม) และกำหนดนโยบายการเก็บรักษาประวัติการรัน

ทำให้การแจ้งเตือนมีบริบทและป้องกันเสียงรบกวน

ประเภทการแจ้งเตือนที่มีสัญญาณสูง:

ให้ทีมกำหนดเกณฑ์ของตัวเอง (หน้าต่าง "ล้าสมัย" และกฎการ paging) และใส่ลิงก์ลึกไปยังหน้ารายละเอียดที่เกี่ยวข้องเพื่อให้ผู้คนสามารถดำเนินการได้ทันที รองรับการยอมรับ การมอบหมาย และสถานะเพื่อปิดวงจรการติดตาม

เพิ่มเจ้าของ (ทีม/บุคคล) และตัวระบุที่เสถียรเพื่อให้การเปลี่ยนชื่อไม่ทำลายประวัติ