01 ก.ย. 2568·3 นาที

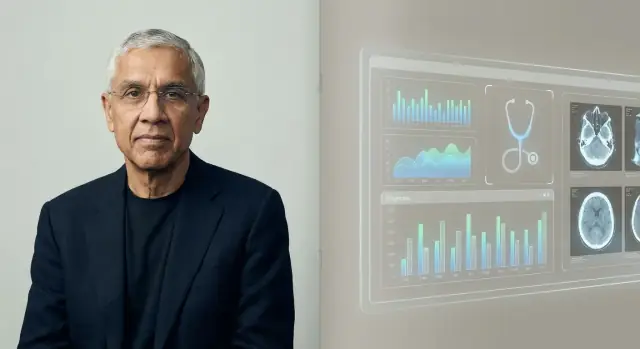

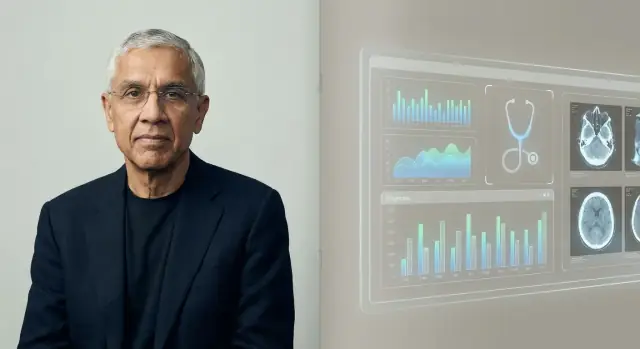

Vinod Khosla และเดิมพันว่า AI จะมาแทนที่แพทย์

ทำไม Vinod Khosla เชื่อว่า AI อาจมาแทนที่งานของแพทย์หลายอย่าง—ตรรกะเบื้องหลัง การเดิมพันด้านการแพทย์ที่เกี่ยวข้อง สิ่งที่ AI ทำได้และทำไม่ได้ และความหมายต่อผู้ป่วย

ทำไม Vinod Khosla เชื่อว่า AI อาจมาแทนที่งานของแพทย์หลายอย่าง—ตรรกะเบื้องหลัง การเดิมพันด้านการแพทย์ที่เกี่ยวข้อง สิ่งที่ AI ทำได้และทำไม่ได้ และความหมายต่อผู้ป่วย

เมื่อ Vinod Khosla พูดว่า “AI จะมาแทนที่แพทย์” เขามักไม่ได้อธิบายภาพโรงพยาบาลนิยายวิทยาศาสตร์ที่ไม่มีคนเลย แต่เขากำลังเสนอข้อสังเกตเชิงปฏิบัติ: งานหลายอย่างที่ตอนนี้ใช้เวลาของแพทย์—โดยเฉพาะงานที่ต้องจัดการข้อมูลจำนวนมาก—สามารถทำโดยซอฟต์แวร์ที่เร็วกว่า ถูกกว่า และแม่นยำขึ้นเรื่อยๆ

ในกรอบของ Khosla คำว่า “มาแทนที่” มักหมายถึง ทดแทนสัดส่วนใหญ่ของสิ่งที่แพทย์ทำประจำวัน ไม่ใช่การลบล้างอาชีพ คิดถึงส่วนที่ซ้ำๆ ของการดูแล: เก็บอาการ ตรวจแนวทาง จัดลำดับการวินิจฉัยที่เป็นไปได้ แนะนำการตรวจถัดไป ติดตามภาวะเรื้อรัง และเตือนความเสี่ยงตั้งแต่เนิ่นๆ

นั่นคือเหตุผลที่แนวคิดนี้เป็นไปในทิศทาง “สนับสนุนการอัตโนมัติ” มากกว่า “ต่อต้านแพทย์” ข้อเดิมพันพื้นฐานคือการดูแลมีรูปแบบจำนวนมาก และการจดจำรูปแบบในระดับใหญ่เป็นจุดที่ AI มักเด่นชัด

บทความชิ้นนี้ถือว่าคำพูดนั้นเป็นสมมติฐานที่ต้องประเมิน ไม่ใช่คำขวัญให้เชียร์หรือปฏิเสธ เราจะดูตรรกะเบื้องหลัง ประเภทผลิตภัณฑ์ด้านการแพทย์ที่สอดคล้องกับมุมมองนี้ และข้อจำกัดที่แท้จริง: การกำกับดูแล ความปลอดภัย ความรับผิดชอบ และด้านมนุษย์ของการแพทย์

Vinod Khosla เป็นผู้ประกอบการและนักลงทุนใน Silicon Valley ที่มีชื่อเสียงจากการร่วมก่อตั้ง Sun Microsystems ในทศวรรษ 1980 และต่อมาสร้างอาชีพด้าน venture capital หลังจากทำงานที่ Kleiner Perkins เขาก่อตั้ง Khosla Ventures ในปี 2004

การผสมผสานนี้—ประสบการณ์ในฐานะผู้ปฏิบัติงานบวกกับทศวรรษของการลงทุน—ช่วยอธิบายว่าทำไมคำกล่าวเกี่ยวกับ AI และการแพทย์ของเขาถึงถูกพูดซ้ำไกลออกไปนอกวงการเทค

Khosla Ventures มีชื่อเสียงในการสนับสนุนเดิมพันขนาดใหญ่และมั่นใจสูงซึ่งอาจดูไม่สมเหตุสมผลในตอนแรก บริษัทมักโน้มไปทาง:

สิ่งนี้สำคัญเพราะคำทำนายอย่าง “AI จะมาแทนที่แพทย์” ไม่ใช่แค่คำพูดเชิงโฆษณา—มันสามารถกำหนดได้ว่า startup ไหนจะได้เงินทุน ผลิตภัณฑ์ใดจะถูกสร้าง และเรื่องราวใดที่บอร์ดและผู้บริหารให้ความสำคัญ

การแพทย์เป็นส่วนหนึ่งของเศรษฐกิจที่ใหญ่และมีค่าใช้จ่ายสูง และยังเต็มไปด้วยสัญญาณที่ AI สามารถเรียนรู้ได้: ภาพ ผลแลป บันทึก อุปกรณ์เซ็นเซอร์ และผลลัพธ์ แม้การปรับปรุงเพียงเล็กน้อยในความแม่นยำ ความเร็ว หรือค่าใช้จ่าย ก็แปลเป็นการประหยัดและการเข้าถึงที่มีความหมาย

Khosla และบริษัทของเขามักโต้แย้งว่าการแพทย์พร้อมสำหรับการเปลี่ยนแปลงด้วยซอฟต์แวร์—โดยเฉพาะในพื้นที่อย่างการคัดแยก การช่วยตัดสินใจการวินิจฉัย และการอัตโนมัติของเวิร์กโฟลว์ ไม่ว่าคุณจะเห็นด้วยกับกรอบความคิด “แทนที่” หรือไม่ มุมมองนี้ก็สำคัญเพราะสะท้อนว่าพลังส่วนใหญ่ของ venture capital ประเมินอนาคตของการแพทย์อย่างไร—และเงินจะไหลไปที่ไหนต่อไป

คำทำนายของ Khosla ตั้งอยู่บนข้อสรุปง่ายๆ: สัดส่วนใหญ่ของการแพทย์—โดยเฉพาะการดูแลปฐมภูมิและการคัดแยกครั้งแรก—เป็นการจดจำรูปแบบภายใต้ความไม่แน่นอน หากการวินิจฉัยและการเลือกการรักษาในหลายกรณีเป็น “จับคู่การนำเสนอนี้กับสิ่งที่น่าจะเป็นที่สุด” ซอฟต์แวร์ที่ฝึกจากตัวอย่างเป็นล้านน่าจะทำได้ดีกว่าแพทย์คนเดียวที่เรียนรู้จากพันกว่ากรณี

มนุษย์เก่งในการเห็นรูปแบบ แต่เราถูกจำกัดด้วยความจำ ความใส่ใจ และประสบการณ์ ระบบ AI สามารถกินข้อมูลมากกว่าที่แพทย์คนเดียวจะเจอได้ เช่น เคส แนวทางปฏิบัติ ผลลัพธ์ แล้วใช้การจับคู่รูปแบบที่เรียนรู้นั้นอย่างสม่ำเสมอ ในกรอบของ Khosla เมื่ออัตราความผิดพลาดของระบบต่ำกว่าแพทย์โดยเฉลี่ย ทางเลือกที่มีเหตุผลสำหรับคนไข้และผู้จ่ายเงินคือการให้การตัดสินใจตามปกติผ่านเครื่อง

เศรษฐศาสตร์เป็นอีกแรงกดดัน การดูแลปฐมภูมิมีข้อจำกัดด้านเวลา ภูมิศาสตร์ และแรงงาน การพบแพทย์อาจมีราคา แทบไม่พอเวลา และคุณภาพแตกต่างกัน บริการ AI สามารถให้บริการ 24/7 สเกลไปยังพื้นที่ที่ขาดแคลน และให้การตัดสินใจที่มีความสม่ำเสมอมากขึ้น—ลดปัญหา “ขึ้นกับว่าใครเป็นคนตรวจ”

ระบบผู้เชี่ยวชาญในอดีตล้มเหลวเพราะขึ้นกับกฎที่เขียนด้วยมือและชุดข้อมูลจำกัด ความเป็นไปได้ปรับปรุงเมื่อข้อมูลการแพทย์ถูกทำให้เป็นดิจิทัล (EHRs ภาพ ห้องแลป อุปกรณ์สวมใส่) และการประมวลผลทำให้การฝึกโมเดลบนข้อมูลขนาดใหญ่และการอัปเดตอย่างต่อเนื่องเป็นไปได้

แม้ภายใต้ตรรกะนี้ เส้นแบ่ง “แทนที่” มักถูกวาดรอบการวินิจฉัยประจำและการจัดการตามโปรโตคอล—ไม่ใช่ส่วนของการแพทย์ที่มุ่งเน้นความไว้วางใจ การตัดสินใจเชิงเทรดออฟที่ซับซ้อน และการสนับสนุนผู้ป่วยเมื่อต้องเผชิญความกลัว ความไม่แน่ใจ หรือการตัดสินใจที่เปลี่ยนชีวิต

ประโยค “AI จะมาแทนที่แพทย์” ของ Khosla มักกล่าวเป็นการทำนายชวนให้คิด ไม่ใช่สัญญาว่าโรงพยาบาลจะไร้คน ธีมที่ซ้ำกันในการพูดและสัมภาษณ์ของเขาคือ ส่วนใหญ่ของการแพทย์—โดยเฉพาะการวินิจฉัยและการตัดสินใจการรักษาประจำ—เป็นรูปแบบที่ซอฟต์แวร์สามารถเรียนรู้ วัดผล และปรับปรุงได้

เขามักมองการให้เหตุผลทางคลินิกเป็นการจับคู่รูปแบบระหว่างอาการ ประวัติ ภาพ ห้องแลป และผลลัพธ์ ข้ออ้างหลักคือเมื่อโมเดล AI ถึงมาตรฐานคุณภาพหนึ่ง มันสามารถใช้งานได้แพร่หลายและอัปเดตอย่างต่อเนื่อง—ในขณะที่การฝึกแพทย์ช้า แพง และไม่สม่ำเสมอในหลายภูมิภาค

ความละเอียดอ่อนสำคัญในกรอบของเขาคือความแปรปรวน: แพทย์อาจเก่งแต่ไม่สม่ำเสมอเพราะความเหนื่อยล้า ภาระงาน หรือการขาดการรับรู้กรณีหายาก AI ในทางกลับกันสามารถมอบประสิทธิภาพที่คงที่และอาจมีอัตราความผิดพลาดต่ำกว่าเมื่อทดสอบ ติดตาม และปรับเทรนอย่างเหมาะสม

แทนที่จะจินตนาการว่า AI เป็นการตัดสินใจเดียวที่แทนที่คน คำเวอร์ชันที่รุนแรงกว่าของเขาคือ: ผู้ป่วยส่วนใหญ่จะปรึกษา AI ก่อน และคลินิกจะทำหน้าที่ตรวจสอบกรณีซับซ้อน กรณีขอบ หรือการตัดสินใจที่มีความเสี่ยงสูง

ผู้สนับสนุนมองว่านี่เป็นแรงผลักดันไปสู่ผลลัพธ์ที่วัดได้และการเข้าถึงที่ดีขึ้น ฝ่ายวิจารณ์ชี้ว่าการแพทย์จริงเต็มไปด้วยความไม่ชัดเจน จริยธรรม และความรับผิดชอบ—และว่า “การแทนที่” ขึ้นอยู่กับกฎ ระเบียบ เวิร์กโฟลว์ และความไว้วางใจมากเท่ากับความแม่นยำของโมเดล

คำกล่าวของ Khosla ว่า “AI จะมาแทนที่แพทย์” สอดคล้องกับประเภทของสตาร์ทอัพด้านการแพทย์ที่ VC ชอบลงทุน: บริษัทที่สเกลได้เร็ว มาตรฐานงานคลินิกที่ยุ่งเหยิง และเปลี่ยนการตัดสินของผู้เชี่ยวชาญให้เป็นซอฟต์แวร์

เดิมพันที่สอดคล้องรวมตัวกันในธีมที่ทำซ้ำได้ไม่กี่ประเภท:

การแทนที่หรือย่อความจำเป็นของคลินิกเป็นรางวัลใหญ่: ค่าใช้จ่ายด้านการแพทย์มหาศาล และแรงงานเป็นศูนย์กลางต้นทุน นั่นสร้างแรงจูงใจให้กำหนดระยะเวลาอย่างกล้าได้กล้าเสีย—เพราะการระดมทุนตอบแทนเรื่องราวที่ชัดเจนและโอกาสสูง แม้การนำไปใช้จริงและกฎระเบียบจะช้ากว่าเทคโนโลยี

โซลูชันเฉพาะทางทำงานหนึ่งอย่างได้ดี (เช่น อ่าน X-ray ปอด) แพลตฟอร์มตั้งใจจะทำงานข้ามเวิร์กโฟลว์หลายอย่าง—triage, การช่วยตัดสินใจ, การติดตาม, การคิดค่าบริการ—โดยใช้ท่อข้อมูลและโมเดลร่วมกัน

นิทัศน์ “แทนที่แพทย์” พึ่งพาแพลตฟอร์มมากกว่า: ถ้า AI ชนะแค่ในงานแคบๆ แพทย์จะปรับได้ ถ้ามันประสานงานหลายงานแบบ end-to-end บทบาทของคลินิกอาจเปลี่ยนเป็นการตรวจสอบ ข้อยกเว้น และความรับผิดชอบ

สำหรับผู้ก่อตั้งที่สำรวจไอเดียแบบแพลตฟอร์ม ความเร็วสำคัญในระยะแรก: คุณมักต้องมีต้นแบบการรับข้อมูล แบบแดชบอร์ดสำหรับคลินิก และบันทึกการตรวจสอบก่อนจะทดสอบเวิร์กโฟลว์ เครื่องมืออย่าง Koder.ai ช่วยทีมสร้างเว็บแอปภายใน (โดยมักใช้ React ด้านหน้า, Go + PostgreSQL ด้านหลัง) จากอินเทอร์เฟซแชท แล้วส่งออกซอร์สโค้ดเพื่อวนรอบอย่างรวดเร็ว สำหรับอะไรที่เกี่ยวข้องกับการตัดสินใจทางคลินิก คุณยังต้องการการตรวจสอบความถูกต้อง การตรวจสอบความปลอดภัย และกลยุทธ์ด้านกฎระเบียบ—แต่การสร้างต้นแบบอย่างรวดเร็วสามารถย่นระยะทางสู่พายล็อตที่เป็นไปได้จริง

AI เอาชนะมนุษย์ได้แล้วในแง่ย่อยของงานคลินิกเฉพาะ—โดยเฉพาะเมื่องานเป็นการจดจำรูปแบบ ความเร็ว และความสม่ำเสมอ นั่นไม่ใช่ “แพทย์ AI” ในความหมายกว้าง แต่หมายความว่า AI เป็นองค์ประกอบที่แข็งแกร่งของการดูแล

AI มักโดดเด่นเมื่อมีข้อมูลซ้ำๆ และมีวงป้อนกลับชัดเจน:

ในด้านเหล่านี้ “ดีกว่า” มักหมายถึงการพลาดน้อยลง การตัดสินที่ได้มาตรฐานมากขึ้น และเวลาในการตอบกลับที่เร็วขึ้น

ชัยชนะในโลกจริงตอนนี้ส่วนใหญ่มาจาก clinical decision support (CDS): AI เสนอโรคที่น่าจะเป็น แจ้งความเป็นไปได้ที่อันตราย แนะนำการตรวจถัดไป หรือเช็กการปฏิบัติตามแนวทาง—ในขณะที่คลินิกยังรับผิดชอบการตัดสินใจ

การวินิจฉัยอิสระ (AI ตัดสินใจจบวงจรเอง) เป็นไปได้ในบริบทจำกัดที่มีกฎเข้มงวด—เช่น เวิร์กโฟลว์การคัดกรองที่ชัดเจน—แต่ไม่ใช่ค่าเริ่มต้นสำหรับผู้ป่วยที่มีโรคร่วมหลายอย่างซับซ้อน

ความแม่นยำของ AI ขึ้นกับข้อมูลฝึกที่สอดคล้องกับประชากรผู้ป่วยและสภาพการดูแล โมเดลอาจเปลี่ยนเมื่อ:

ในบริบทที่มีความเสี่ยงสูง การมีมนุษย์ตรวจสอบไม่ใช่ตัวเลือก—มันเป็นชั้นความปลอดภัยสำหรับกรณีขอบ อาการผิดปกติ และการตัดสินค่าความสำคัญเชิงคุณค่า (ผู้ป่วยยอมรับได้แค่ไหน ทนผลข้างเคียงได้เท่าไหร่) AI อาจเยี่ยมในการ "เห็น" แต่คลินิกยังต้องตัดสินใจว่าสิ่งนั้นหมายถึงอะไรสำหรับบุคคลนี้ในวันนี้

AI อาจน่าประทับใจในการจับรูปแบบ สรุปบันทึก และเสนอการวินิจฉัยที่เป็นไปได้ แต่การแพทย์ไม่ได้เป็นเพียงงานทำนาย หลายส่วนที่ยากที่สุดเกิดขึ้นเมื่อคำตอบที่ “ถูกต้อง” ไม่ชัดเจน เป้าหมายผู้ป่วยขัดกับแนวทาง หรือระบบรอบการดูแลยุ่งเหยิง

คนไม่ได้ต้องการแค่ผลลัพธ์ พวกเขาต้องการรู้สึกถูกฟัง เชื่อถือ และปลอดภัย แพทย์สังเกตความกลัว ความอับอาย ความสับสน หรือความเสี่ยงในครอบครัว แล้วปรับบทสนทนาและแผนการรักษาตามนั้น การตัดสินใจร่วม (shared decision-making) ยังต้องการการเจรจาเทรดออฟ (ผลข้างเคียง ค่าใช้จ่าย ไลฟ์สไตล์ การสนับสนุนจากครอบครัว) ในลักษณะที่สร้างความไว้วางใจในระยะยาว

ผู้ป่วยจริงมักมีหลายโรคร่วม ประวัติไม่ครบ และอาการที่ไม่เข้าพิมพ์หรือตรงกับเทมเพลต โรคร้ายแรงที่หายากและอาการผิดปกติอาจดูเหมือนปัญหาทั่วไป—จนกว่าจะไม่ใช่ AI อาจให้คำแนะนำที่เป็นไปได้ แต่ “เป็นไปได้” ไม่เท่ากับ “พิสูจน์ทางคลินิก” โดยเฉพาะเมื่อบริบทละเอียดอ่อน (การเดินทางล่าสุด ยาใหม่ ปัจจัยสังคม ความรู้สึกว่า "มีบางอย่างผิดปกติ")

แม้โมเดลแม่นยำสูงก็ยังล้มเหลวได้ คำถามยากคือใครเป็นผู้รับผิดชอบ: แพทย์ที่เชื่อเครื่องมือ โรงพยาบาลที่นำไปใช้ หรือผู้ขายที่พัฒนา? ความรับผิดชอบที่ชัดเจนมีผลต่อความระมัดระวังของทีมและวิธีที่ผู้ป่วยเรียกร้องความรับผิดชอบ

การดูแลเกิดขึ้นภายในเวิร์กโฟลว์ หากเครื่องมือ AI ไม่รวมเข้ากับ EHR ระบบสั่งตรวจ การจัดทำเอกสาร และการคิดค่าบริการอย่างเรียบร้อย—หรือถ้าเพิ่มคลิกและความไม่แน่ใจ—ทีมที่ยุ่งจะไม่พึ่งพา มันไม่ว่าเดโมจะดีแค่ไหนก็ตาม

AI ทางการแพทย์ไม่ใช่แค่ปัญหาวิศวกรรม—มันเป็นปัญหาความปลอดภัย เมื่อซอฟต์แวร์มีผลต่อการวินิจฉัยหรือการรักษา ผู้กำกับดูแลมองว่าเป็นอุปกรณ์การแพทย์มากกว่าปกติ

ในสหรัฐฯ FDA กำกับดูแลเครื่องมือ "Software as a Medical Device" หลายประเภท โดยเฉพาะเครื่องมือที่วินิจฉัย แนะนำการรักษา หรืมีผลโดยตรงต่อการตัดสินใจการดูแล ในสหภาพยุโรป การขึ้นทะเบียน CE ภายใต้ Medical Device Regulation มีบทบาทคล้ายกัน

กรอบเหล่านี้ต้องการหลักฐานว่าเครื่องมือนั้นปลอดภัยและมีประสิทธิผล ความชัดเจนในวัตถุประสงค์การใช้งาน และการติดตามหลังการนำไปใช้ กฎเหล่านี้สำคัญเพราะโมเดลที่ดูดีในเดโมอาจล้มเหลวในคลินิกจริงกับผู้ป่วยจริง

ความเสี่ยงเชิงจริยธรรมใหญ่คือความแม่นยำที่ไม่เท่ากันระหว่างประชากร (เช่น เพศ อายุ สีผิว ภาษา หรือโรคร่วม) หากข้อมูลฝึกสอนไม่เป็นตัวแทน ระบบอาจพลาดการวินิจฉัยหรือแนะนำการรักษามากเกินไปสำหรับกลุ่มนั้น การทดสอบความเป็นธรรม การรายงานผลตามกลุ่มย่อย และการออกแบบชุดข้อมูลอย่างพิถีพิถันไม่ใช่ของเสริม—แต่เป็นส่วนพื้นฐานของความปลอดภัย

การฝึกและปรับปรุงโมเดลมักต้องข้อมูลสุขภาพที่ละเอียดอ่อนจำนวนมาก นำคำถามเกี่ยวกับการยินยอม การใช้ครั้งที่สอง ขีดจำกัดการทำให้ไม่สามารถระบุตัวตน และใครได้ประโยชน์ทางการเงิน การกำกับดูแลที่ดีรวมประกาศให้ผู้ป่วยทราบ การควบคุมการเข้าถึงอย่างเข้มงวด และนโยบายการเก็บข้อมูลและการอัปเดตโมเดล

เครื่องมือคลินิกหลายตัวออกแบบให้ช่วย ไม่ใช่แทน โดยให้คลินิกเป็นผู้ตัดสินใจขั้นสุดท้าย รูปแบบ "มนุษย์ในวงจร" นี้สามารถจับความผิดพลาด ให้บริบทที่โมเดลขาด และสร้างความรับผิดชอบ—แต่จะได้ผลก็ต่อเมื่อเวิร์กโฟลว์และแรงจูงใจป้องกันการทำงานแบบอัตโนมัติแบบตาบอด

คำกล่าวของ Khosla มักถูกฟังว่า “แพทย์จะล้าสมัย” การอ่านที่เป็นประโยชน์กว่าคือการแยก การแทนที่ (AI ทำงานตั้งแต่ต้นจนจบด้วยการมีส่วนร่วมน้อย) จาก การเปลี่ยนการจัดสรรงาน (มนุษย์ยังคงเป็นผู้รับผิดชอบผลลัพธ์ แต่หน้าที่เปลี่ยนไปสู่การกำกับดูแล ความเห็นอกเห็นใจ และการประสานงาน)

ในหลายบริบท AI น่าจะแทนที่ ชิ้นส่วน ของงานคลินิกก่อน: ร่างบันทึก เปิดเผยความแตกต่างของการวินิจฉัย ตรวจสอบการปฏิบัติตามแนวทาง และสรุปประวัติผู้ป่วย งานของคลินิกจะเปลี่ยนจากการให้คำตอบเป็นการ ตรวจสอบ จัดกรอบ และสื่อสาร คำตอบเหล่านั้น

การดูแลปฐมภูมิอาจรู้สึกถึงการเปลี่ยนแปลงเมื่อการคัดแยก "ประตูหน้า" ดีขึ้น: ตัวตรวจอาการและการบันทึกแบบอัตโนมัติจะลดเวลาการพบปกติ ในขณะที่กรณีซับซ้อนและการดูแลที่เน้นความสัมพันธ์ยังคง由มนุษย์เป็นผู้นำ

รังสีวิทยาและพยาธิวิทยาอาจเห็นการแทนที่งานโดยตรงมากขึ้นเพราะงานเป็นดิจิทัลและขึ้นกับรูปแบบแล้ว แต่นั่นไม่ได้หมายถึงมีผู้เชี่ยวชาญน้อยลงในชั่วข้ามคืน—มีแนวโน้มจะเป็น ปริมาณงานเพิ่มขึ้น กระบวนการคุณภาพใหม่ และแรงกดดันต่อการชดเชย

การพยาบาลเกี่ยวกับการประเมินต่อเนื่อง การศึกษา และการประสานงานมากกว่าเป็นการวินิจฉัย AI อาจลดภาระงานเอกสาร แต่การดูแลข้างเตียงและการตัดสินใจในการยกระดับการรักษายังเป็นมนุษย์เป็นศูนย์กลาง

คาดว่าจะมีการเติบโตในบทบาทเช่น ผู้ควบคุม AI (monitoring performance), informatics ทางคลินิก (workflow + data stewardship), และ ผู้ประสานงานการดูแล (ปิดช่องว่างที่โมเดลชี้) บทบาทเหล่านี้อาจนั่งอยู่ในทีมเดิมมากกว่าจะเป็นตำแหน่งแยกต่างหาก

การศึกษาแพทย์อาจเพิ่มความรู้เรื่อง AI: วิธีตรวจสอบผลการทำงาน บันทึกการพึ่งพา และสังเกตโหมดความล้มเหลว การออกใบอนุญาตอาจพัฒนาไปสู่เกณฑ์ “มนุษย์ในวงจร”—ใครใช้เครื่องมือไหน ภายใต้การกำกับดูแลแบบใด และความรับผิดชอบจัดอย่างไรเมื่อ AI ผิดพลาด

ข้ออ้างของ Khoslaเป็นสิ่งชวนคิดเพราะเขามองว่า “แพทย์” เป็นเครื่องมือวิเคราะห์การวินิจฉัยเป็นหลัก การคัดค้านที่แข็งแรงที่สุดโต้แย้งว่าถึงแม้ AI จะเทียบแพทย์ด้านการจดจำรูปแบบได้ การแทนที่แพทย์เป็นงานที่ต่างออกไปโดยสิ้นเชิง

มูลค่าทางคลินิกมากอยู่ที่การกำหนดกรอบปัญหา ไม่ใช่แค่ตอบคำถาม แพทย์แปลเรื่องเล่ายุ่งให้เป็นตัวเลือกที่ใช้งานได้ ต่อรองเทรดออฟ (ความเสี่ยง ค่าใช้จ่าย เวลา ค่าแรง) และประสานการดูแลระหว่างผู้เชี่ยวชาญ พวกเขายังจัดการการยินยอม ความไม่แน่นอน และการรอคอยอย่างมีแบบแผน—พื้นที่ที่ความไว้วางใจและความรับผิดชอบสำคัญเท่ากับความแม่นยำ

หลายระบบ AI ดูน่าประทับใจในการศึกษาย้อนหลัง แต่ไม่เท่ากับการปรับปรุงผลลัพธ์ในโลกจริง หลักฐานที่ยากที่สุดคืองานเชิงทดลองแบบ prospective: AI ลดการวินิจฉัยพลาด ภาวะแทรกซ้อน หรือการตรวจที่ไม่จำเป็นข้ามโรงพยาบาล กลุ่มผู้ป่วย และเวิร์กโฟลว์หรือไม่

การทั่วไป (generalization) เป็นจุดอ่อนอีกอย่าง โมเดลอาจเสื่อมเมื่อประชากรเปลี่ยน อุปกรณ์ต่างกัน หรือพฤติกรรมการบันทึกเปลี่ยน ระบบที่ดีในที่หนึ่งอาจสะดุดที่อื่น—โดยเฉพาะในโรคหายาก

แม้เครื่องมือจะแข็งแกร่ง ก็อาจสร้างรูปแบบความล้มเหลวใหม่ แพทย์อาจยอมตามโมเดลเมื่อมันผิด (automation bias) หรือหยุดตั้งคำถามที่สองซึ่งจะจับกรณีขอบ เมื่อเวลาผ่านไป ทักษะอาจเสื่อมถ้ามนุษย์กลายเป็น "ตราประทับยาง" ทำให้ยากที่จะเข้ามาแทรกเมื่อ AI ไม่แน่ใจหรือผิดพลาด

การแพทย์ไม่ใช่ตลาดเทคโนโลยีบริสุทธิ์ ความรับผิดชอบ การชดเชย วงจรการจัดซื้อ การผสานกับ EHR และการฝึกอบรมล้วนชะลอการใช้งาน ผู้ป่วยและหน่วยงานกำกับดูแลอาจยังต้องการผู้ตัดสินใจมนุษย์สำหรับการตัดสินใจที่มีความเสี่ยงสูง—หมายความว่า "AI ทุกที่" อาจยังคงเป็น "AI ที่อยู่ภายใต้การดูแลของแพทย์" ไปอีกนาน

AI ปรากฏตัวแล้วในการดูแลสุขภาพในรูปแบบเงียบๆ—คะแนนความเสี่ยงในแฟ้ม การอ่านภาพอัตโนมัติ ตัวตรวจอาการ และเครื่องมือที่จัดลำดับผู้ที่ต้องพบก่อน สำหรับผู้ป่วย เป้าหมายไม่ใช่การ "เชื่อ AI" หรือ "ปฏิเสธ AI" แต่เป็นการรู้ว่าจะคาดหวังอะไรและควบคุมได้อย่างไร

คุณน่าจะเห็นการคัดกรองมากขึ้น (ข้อความ แบบสอบถาม ข้อมูลจากอุปกรณ์สวมใส่) และการคัดแยกที่เร็วขึ้น—โดยเฉพาะในคลินิกและ ER ที่มีคนแน่น นั่นอาจหมายถึงคำตอบที่เร็วขึ้นสำหรับปัญหาทั่วไปและการตรวจพบระยะแรกสำหรับบางโรค

คุณภาพจะไม่เท่ากัน เครื่องมือบางอย่างยอดเยี่ยมในงานแคบๆ แต่บางอย่างอาจไม่สอดคล้องในอายุ สีผิว โรคหายาก หรือข้อมูลจริงที่ยุ่งเหยิง ถือว่า AI เป็นผู้ช่วย ไม่ใช่คำตัดสินขั้นสุดท้าย

ถ้าเครื่องมือ AI ส่งผลต่อการดูแลของคุณ ถาม:

ผลลัพธ์จาก AI มักเป็นความน่าจะเป็น ("เสี่ยง 20%") ไม่ใช่ความแน่นอน ถามว่าตัวเลขหมายถึงอะไรสำหรับคุณ: จะเกิดอะไรขึ้นที่ระดับความเสี่ยงต่างกัน และอัตราปลอมบวกเป็นเท่าไร

ถ้าคำแนะนำเป็นเรื่องเสี่ยงสูง (ผ่าตัด เคมีบำบัด หยุดยาหนึ่งตัว) ขอคำแนะนำที่สอง—จากมนุษย์และ/หรือเครื่องมืออื่น เป็นเรื่องสมเหตุสมผลที่จะถามว่า “ถ้าไม่มีผล AI ชุดนี้ คุณจะทำอย่างไร?”

คุณควรได้รับแจ้งเมื่อซอฟต์แวร์มีอิทธิพลต่อการตัดสินใจอย่างมีนัยสำคัญ หากคุณไม่สบายใจ ให้ถามถึงทางเลือก วิธีเก็บข้อมูลของคุณ และการเลือกไม่ใช้จะมีผลต่อการเข้าถึงการดูแลอย่างไร

การนำ AI มาใช้ในระบบการแพทย์ง่ายที่สุดเมื่อคุณปฏิบัติต่อมันเหมือนเครื่องมือคลินิกทั่วไป: กำหนดกรณีการใช้งาน ทดสอบ มอนิเตอร์ และทำให้ความรับผิดชอบชัดเจน

ก่อนนำ AI มาใช้ในการวินิจฉัย ให้ใช้มันเพื่อลดแรงเสียดทานในชีวิตประจำวัน ชัยชนะระยะแรกที่ปลอดภัยที่สุดคือเวิร์กโฟลว์ที่เพิ่มผ่านput โดยไม่ตัดสินการแพทย์:

พื้นที่เหล่านี้มักให้ผลประหยัดเวลาที่วัดได้ และช่วยทีมสร้างความมั่นใจในการจัดการการเปลี่ยนแปลง

หากทีมของคุณต้องการเครื่องมือภายในน้ำหนักเบาเพื่อสนับสนุนเวิร์กโฟลว์เหล่านี้—ฟอร์มรับข้อมูล แดชบอร์ดการกำหนดเส้นทาง บันทึกการตรวจสอบ—การสร้างแอปอย่างรวดเร็วอาจมีค่าพอๆ กับคุณภาพโมเดล แพลตฟอร์มเช่น Koder.ai ออกแบบมาสำหรับทีมที่ต้องการ “vibe-coding”: คุณอธิบายแอปในแชท วนรอบเร็ว และส่งออกซอร์สโค้ดเมื่อพร้อมผลิต สำหรับบริบททางคลินิก ให้ถือว่านี่เป็นวิธีเร่งการพัฒนาแอปปฏิบัติการและพายล็อต ในขณะที่ยังทำงานความปลอดภัย ความสอดคล้อง และการตรวจสอบที่จำเป็น

สำหรับระบบ AI ใดๆ ที่มีผลต่อการดูแลผู้ป่วย—แม้อย่างอ้อม—ต้องการหลักฐานและการควบคุมเชิงปฏิบัติ:

ถ้าผู้ขายอธิบายไม่ได้ว่าโมเดลถูกประเมิน อัปเดต และตรวจสอบอย่างไร ให้ถือว่านั่นเป็นสัญญาณความปลอดภัย

ทำให้ "วิธีที่เราใช้เครื่องมือนี้" ชัดเจนเท่า "มันทำอะไร" ฝึกอบรมคลินิกเกี่ยวกับโหมดความล้มเหลวทั่วไป และกำหนด เส้นทางการยกระดับชัดเจน (เมื่อให้ผลลบ AI ต้องละเลยเมื่อไร ให้เพื่อนร่วมงานตรวจ เมื่อใดควรส่ง ER) กำหนดเจ้าของสำหรับการทบทวนประสิทธิภาพและการรายงานเหตุการณ์

ถ้าต้องการความช่วยเหลือในการเลือก พายล็อต หรือนโยบายการกำกับดูแลเครื่องมือ ให้เพิ่มช่องทางภายในสำหรับผู้มีส่วนได้ส่วนเสียเพื่อขอการสนับสนุนผ่าน /contact (หรือ /pricing หากคุณแพ็กการให้บริการปรับใช้)

การทำนายว่า AI “จะมาแทนที่แพทย์” มักพลาดเมื่อถือว่าแพทย์เป็นงานเดียวที่มีเส้นชัยเดียว มุมมองที่สมจริงกว่าคือการเปลี่ยนแปลงจะมาถึงไม่สม่ำเสมอ—ตามสาขา สถานที่ และงาน—และจะเร่งขึ้นเมื่อตัวจูงใจและกฎสอดคล้องกัน

ในระยะใกล้ ผลประโยชน์ใหญ่ที่สุดน่าจะเป็น “ชัยชนะด้านเวิร์กโฟลว์”: การคัดแยกที่ดีขึ้น การจัดทำเอกสารที่ชัดเจน การอนุมัติล่วงหน้าที่เร็วขึ้น และการสนับสนุนการตัดสินใจที่ลดข้อผิดพลาดชัดเจน เหล่านี้สามารถขยายการเข้าถึงโดยไม่บังคับให้ผู้ป่วยเชื่อใจเครื่องมือเพียงลำพัง

ในระยะยาว คุณจะเห็นการเปลี่ยนแปลงทีละน้อยในว่าใครทำอะไร—โดยเฉพาะการดูแลที่เป็นมาตรฐาน ปริมาณสูง ที่ข้อมูลมีมากและผลลัพธ์วัดได้

การแทนที่ไม่ค่อยหมายความว่าแพทย์หายไป มันอาจมีลักษณะเป็น:

มุมมองที่สมดุล: ความก้าวหน้าจะเป็นของจริงและบางครั้งน่าตกใจ แต่การแพทย์ไม่ได้มีเพียงการจดจำรูปแบบ ความไว้วางใจ บริบท และการดูแลที่มุ่งเน้นผู้ป่วยจะยังคงทำให้มนุษย์อยู่ตรงกลาง—แม้เครื่องมือจะเปลี่ยนไป

Khosla มักหมายถึง AI จะมาแทนส่วนสำคัญของงานประจำวันในคลินิก โดยเฉพาะงานที่ต้องใช้ข้อมูลมาก เช่น การคัดแยกอาการ (triage), การตรวจสอบแนวทางปฏิบัติ, การจัดลำดับการวินิจฉัยที่เป็นไปได้ และการติดตามภาวะเรื้อรัง

มันไม่ใช่ “ไม่มีคนเลยในโรงพยาบาล” แต่เป็น “ซอฟต์แวร์กลายเป็นการพิจารณาระยะแรกสำหรับการตัดสินใจประจำ”

ตามนิยามในบทความนี้:

การใช้งานในโลกจริงระยะใกล้มีลักษณะเป็นการเสริม (augment) มากกว่า การแทนที่ทั้งหมด โดยการแทนที่จะเกิดขึ้นในเวิร์กโฟลว์เฉพาะที่ชัดเจน

ตรรกะหลักคือ การจดจำรูปแบบในระดับใหญ่: การตัดสินทางคลินิกหลายอย่าง (โดยเฉพาะการคัดแยกครั้งแรกและการวินิจฉัยทั่วไป) เหมือนกับการจับคู่ชุดอาการ ประวัติ ผลทางห้องปฏิบัติการ และภาพถ่ายกับภาวะที่เป็นไปได้

AI สามารถฝึกจากตัวอย่างจำนวนมากกว่าที่แพทย์คนเดียวจะเจอได้ และนำการเรียนรู้นั้นมาใช้สม่ำเสมอ ซึ่งอาจลดอัตราความผิดพลาดโดยเฉลี่ยเมื่อเวลาผ่านไป

ทัศนะของ Khosla สำคัญเพราะนักลงทุนร่วมทุน (VC) มักฟังและอาจเปลี่ยนทิศทางทรัพยากรตามนั้น:

แม้จะไม่เห็นด้วยกับกรอบความคิด การมีแนวคิดนี้ก็มีผลต่อทิศทางเงินทุนและความสำคัญของการนำไปใช้

เพราะการแพทย์เป็นสัดส่วนใหญ่ของค่าใช้จ่ายในเศรษฐกิจและต้องใช้แรงงานสูง นอกจากนี้ยังสร้างข้อมูลจำนวนมาก (บันทึก EHR, ห้องปฏิบัติการ, ภาพทางการแพทย์, ข้อมูลจากอุปกรณ์สวมใส่)

การปรับปรุงแม้เพียงเล็กน้อยในความแม่นยำ ความเร็ว หรือค่าใช้จ่าย ก็สามารถสร้างประโยชน์มหาศาลด้านการเข้าถึงและการประหยัดได้ จึงเป็นเป้าหมายที่น่าลงทุน

AI แสดงศักยภาพเหนือกว่ามนุษย์ในงานเฉพาะที่มีลักษณะซ้ำๆ และมีการวัดผลชัดเจน เช่น:

ชัยชนะเหล่านี้มักเป็น “ชิ้นส่วน” ของการดูแลที่ลดภาระงานของผู้ให้บริการโดยไม่ทำให้การดูแลถูกแทนที่ทั้งหมด

ข้อจำกัดสำคัญ ได้แก่:

ความแม่นยำในสาธิตไม่เท่ากับการทำงานอย่างปลอดภัยและเชื่อถือได้ในคลินิก

เครื่องมือที่มีผลต่อการวินิจฉัยหรือการรักษามักถูกนับเป็น Software as a Medical Device:

การติดตามหลังการนำไปใช้สำคัญเพราะโมเดลสามารถเปลี่ยนพฤติกรรมเมื่อประชากรหรือฮาร์ดแวร์เปลี่ยนไป

ความลำเอียงเกิดขึ้นเมื่อข้อมูลฝึกสอนไม่ครอบคลุมกลุ่มประชากรบางกลุ่มหรือการตั้งค่าการดูแล ส่งผลให้ประสิทธิภาพไม่เท่ากันตามเพศ อายุ สีผิว ภาษา หรือโรคร่วม

การลดความเสี่ยงเชิงปฏิบัติรวมถึงการทดสอบตามกลุ่มย่อย รายงานผลแยกกลุ่ม และการติดตามหลังการนำไปใช้—ไม่ใช่แค่การทำเครื่องหมายว่า “เสร็จแล้ว”

เริ่มจากความโปร่งใสและการควบคุม:

คำถามที่มีประโยชน์: “คุณจะทำอย่างไรถ้าไม่มีผลจาก AI ชุดนี้?”