12 Kas 2025·8 dk

Kâr Amacı Gütmeyen Laboratuvardan Yapay Zeka Liderine: OpenAI'nin Tarihi

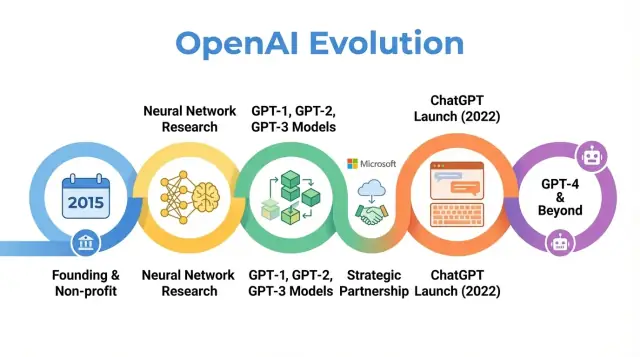

OpenAI'nin tarihini keşfedin: kâr amacı gütmeyen başlangıcından önemli araştırma dönüm noktalarına, ChatGPT ve GPT-4'ün lansmanına ve misyonunun nasıl evrildiğine kadar.

Genel Bakış: OpenAI Tarihi Neden Önemli

OpenAI, erken araştırma makalelerinden ChatGPT gibi ürünlere kadar insanların yapay zekâ hakkında düşünme biçimini şekillendiren bir AI araştırma ve dağıtım şirketidir. OpenAI'nin 2015'teki küçük bir kâr amacı gütmeyen laboratuvardan AI'da merkezi bir aktöre dönüşmesini anlamak, modern yapay zekânın bugün neden bu şekilde göründüğünü açıklamaya yardımcı olur.

OpenAI'nin hikâyesi sadece model duyurularının bir dizisi değildir. Misyon, teşvikler, teknik atılımlar ve kamu baskısının nasıl etkileştiğinin bir vaka çalışmasıdır. Organizasyon, açık araştırma ve geniş fayda vurgusuyla başladı, sonra sermaye çekmek için yeniden yapılandı, Microsoft ile derin bir ortaklık kurdu ve yüz milyonlarca kişi tarafından kullanılan ürünler piyasaya sürdü.

Bu tarih neden önemli?

OpenAI'nin tarihini izlemek şu daha geniş eğilimleri aydınlatır:

-

Misyon ve değerler: OpenAI, yapay genel zekânın tüm insanlığa fayda sağlamasını sağlama hedefiyle kuruldu. Bu misyonun zaman içinde nasıl yorumlandığı ve revize edildiği, ideallik hedefleri ile ticari gerçeklikler arasındaki gerilimleri ortaya koyar.

-

Araştırma atılımları: Erken projelerden GPT-3, GPT-4, DALL·E ve Codex gibi sistemlere geçiş, birçok güncel AI uygulamasını besleyen büyük ölçekli temel modeller yönündeki daha geniş kaymayı izler.

-

Yönetim ve yapı: Tamamen kâr amacı gütmeyenden kâr sınırlı varlığa geçiş ve karmaşık yönetişim mekanizmalarının yaratılması, güçlü teknolojileri yönetmek için yeni organizasyonel biçimlerin denendiğini gösterir.

-

Kamu etkisi ve denetim: ChatGPT ve diğer sürümlerle OpenAI, AI çevrelerinde bilinen bir araştırma laboratuvarından milyonların kullandığı bir marka haline geldi ve güvenlik, uyum ve düzenleme tartışmalarının odağı oldu.

Bu makale, OpenAI'nin 2015'ten en son gelişmelere kadar olan yolculuğunu izliyor; her aşamanın AI araştırması, ekonomi ve yönetişiminde daha geniş değişimleri nasıl yansıttığını ve bunun alanın geleceği için ne anlama gelebileceğini gösteriyor.

OpenAI'nin Kuruluşu: Misyon ve Erken Ekip

2015'teki AI Anı

OpenAI, Aralık 2015'te kuruldu; o sırada makine öğrenimi—özellikle derin öğrenme—hızla iyileşiyordu ama hâlâ genel zekâdan uzaktı. Görüntü tanıma benchmark'ları düşüyor, konuşma sistemleri gelişiyor ve Google, Facebook, Baidu gibi şirketler AI'ya büyük yatırımlar yapıyordu.

Araştırmacılar ve teknoloji liderleri arasında artan bir endişe, gelişmiş AI'nın birkaç güçlü şirket veya hükümetin kontrolünde toplanabileceği yönündeydi. OpenAI, dar ticari avantaj yerine uzun vadeli güvenlik ve AI faydalarının geniş dağılımına odaklanan bir denge unsuru olarak tasarlandı.

Misyon: Tüm İnsanlık İçin AGI

Başından itibaren OpenAI misyonunu yapay genel zekâ (AGI) bağlamında tanımladı; sadece kademeli makine öğrenimi ilerlemeleri değil. Temel ifade, OpenAI'nin eğer AGI yaratılırsa bunun "tüm insanlığa fayda sağlamasını" güvence altına almak için çalışacağıydı.

Bu misyonun birkaç somut etkisi vardı:

- Güvenlik araştırmalarına ve uzun vadeli uyum sorularına öncelik verme

- Mümkün olduğunca araştırma, kod ve bulguları paylaşma taahhüdü

- Diğer kurumlarla işbirliği yaparak kazananın her şeyi aldığı bir yarış dinamiğinden kaçınma

Erken dönem blog yazıları ve kurucu tüzük hem açıklığı hem de ihtiyatı vurguladı: OpenAI çalışmalarının çoğunu yayınlayacaktı, ama güçlü yeteneklerin yayımlanmasının toplumsal etkilerini de göz önünde bulunduracaktı.

Kurucular, Erken Liderler ve Yapı

OpenAI, başlangıçta bir kâr amacı gütmeyen araştırma laboratuvarı olarak kuruldu. İlk finansman taahhütleri yaklaşık 1 milyar dolar civarında duyuruldu; bu bir kerelik nakitten ziyade uzun vadeli taahhütlerdi. Erken destekçiler arasında Elon Musk, Sam Altman, Reid Hoffman, Peter Thiel, Jessica Livingston ve YC Research ile Amazon Web Services ve Infosys gibi şirketler yer aldı.

Erken liderlik ekibi, girişimcilik, araştırma ve operasyon deneyimini bir araya getirdi:

- Sam Altman – kurucu ortak ve başlangıçta yönetim kurulu başkanı (sonrasında CEO)

- Elon Musk – kurucu ortak ve erken bağışçı, ilk dönemde yönetim kurulu üyesi

- Greg Brockman – eski Stripe CTO'su, CTO ve kurucu ortak olarak katıldı

- Ilya Sutskever – önde gelen derin öğrenme araştırmacısı, Baş Bilim İnsanı olarak katıldı

- Wojciech Zaremba ve John Schulman – kurucu ortaklar ve çekirdek araştırma liderleri

Bu Silikon Vadisi girişimciliği ile yüksek düzey AI araştırmasının karışımı, OpenAI'nin erken kültürünü şekillendirdi: AI yeteneklerinin sınırlarını zorlamaya yönelik büyük iddialar, ama kısa vadeli ticarileştirme yerine uzun vadeli küresel etkiyi hedefleyen bir misyon odaklı yapı.

Kâr Amacı Gütmeyen Dönem: Erken Araştırma ve Açık Bilim

OpenAI 2015'te kâr amacı gütmeyen bir araştırma laboratuvarı olarak başladığında, kamuya verilen söz basit ama iddialıydı: yapay zekâyı ilerletirken mümkün olduğunca çok şeyi geniş toplulukla paylaşmak.

Varsayılan Olarak Açık

Erken yıllar "varsayılan olarak açık" felsefesiyle tanımlandı. Araştırma makaleleri hızla paylaşılıyor, kod genellikle yayımlanıyor ve dahili araçlar kamu projelerine dönüştürülüyordu. Fikir şuydu: geniş bilimsel ilerlemeyi—ve incelemeyi—hızlandırmak, yetenekleri tek bir şirket içinde yoğunlaştırmaktan daha güvenli ve faydalı olacaktır.

Aynı zamanda güvenlik konuşmanın bir parçasıydı. Ekip, açıklığın ne zaman kötüye kullanım riskini artırabileceğini tartıştı ve kademeli yayın ile politika incelemeleri fikirlerini çizmeye başladı; bu fikirler daha sonraki yönetişim süreçlerine kıyasla henüz daha gayri resmi idi.

Öncü Araştırma Alanları

OpenAI'nin erken bilimsel odak alanları birkaç ana konuyu kapsıyordu:

- Pekiştirmeli öğrenme (RL): Dota 2 gibi oyunlarda ve karmaşık kontrol görevlerinde ajanların ustalaşması üzerine çalışmalar, RL algoritmalarını, keşif yöntemlerini ve ölçeklenebilirliği ilerletti.

- Robotik: Fiziksel dünyaya aktarılabilen simülasyon ve RL yaklaşımlarıyla manipülasyon görevlerini çözen robot el deneyleri yapıldı.

- Gözetimsiz ve self-supervised öğrenme: Modellerin etiketlenmemiş büyük veri setlerinden nasıl öğrenebileceği araştırıldı ve bu, sonraki temel modellerin habercisiydi.

Bu projeler cilalanmış ürünlerden çok derin öğrenme, hesaplama ve akıllı eğitim rejimleriyle nelerin mümkün olduğunu test etmeye yönelikti.

Topluluğu Şekillendiren Araçlar

Bu dönemin en etkili çıktılarından ikisi OpenAI Gym ve Universe idi.

- OpenAI Gym, ortak bir RL ortamları ve benchmark seti sağladı. Araştırmacıların algoritmaları karşılaştırma şeklini standartlaştırdı ve yeni laboratuvarlar ile öğrenciler için bariyeri önemli ölçüde düşürdü.

- Universe, ajanları oyunlardan web uygulamalarına kadar çeşitli mevcut yazılım ortamlarında eğitmeyi ve değerlendirmeyi amaçladı. Universe sonunda emekliye ayrıldıysa da, genel amaçlı ajanlara olan ilgiyi somutlaştırdı.

Her iki proje de mülkiyetçi avantaj yerine paylaşılan altyapıya bağlılık şeklinde bir yaklaşımı yansıtıyordu.

Akademi ve Medyanın Görüşü

Bu kâr amacı gütmeyen dönemde OpenAI genellikle büyük teknoloji firmalarının AI laboratuvarlarına karşı misyon odaklı bir denge olarak sunuluyordu. Meslektaşlar araştırmasının kalitesini, kod ve ortamların erişilebilirliğini ve güvenlik tartışmalarına katılma isteğini takdir etti.

Medya, yüksek profilli finansörler, ticari olmayan yapı ve açıkça yayınlama vaadi gibi alışılmadık birleşimi vurguladı. Bu itibar—uzun vadeli sonuçlarla ilgilenen etkili, açık bir araştırma laboratuvarı olarak—organizasyon her stratejik değişiklik yaptığında tepkileri şekillendiren beklentileri yarattı.

Güçlü Modeller İnşa Etmek: GPT-1'den GPT-3'e

OpenAI tarihinde dönüm noktası, büyük transformer tabanlı dil modellerine odaklanma kararıydı. Bu yönelim, OpenAI'yi ağırlıklı olarak araştırma odaklı bir kuruluş olmaktan, başkalarının üzerine inşa edebileceği temel modellerle tanınan bir şirkete dönüştürdü.

GPT-1: Transformer Fikrini Kanıtlamak (2018)

GPT-1, sonraki standartlara göre mütevazıydı—117 milyon parametre, BookCorpus üzerinde eğitilmiş—ama kritik bir kavram kanıtı sundu.

Her NLP görevi için ayrı modeller eğitmek yerine, GPT-1 basit bir amaçla (bir sonraki kelimeyi tahmin etme) eğitilmiş tek bir transformer modelinin, az miktarda ince ayarla soru yanıtlama, duygu analizi ve metin tümlenmesi gibi görevlere uyarlanabileceğini gösterdi.

OpenAI'nin yol haritası için GPT-1 üç fikri doğruladı:

- Ölçek önemlidir: daha büyük modeller ve daha fazla veri beklenenden daha genel biçimde daha iyi performans gösterir.

- Ön eğitim + ince ayar, görev‑özgü sistemleri yenebilir.

- Transformer'lar dil için güçlü bir mimaridir.

GPT-2: Yetenekler ve Kötüye Kullanım Endişeleri (2019)

GPT-2 aynı temel tarifi çok daha ileri taşıdı: 1.5 milyar parametre ve çok daha büyük, web kaynaklı bir veri seti. Ürettikleri genellikle şaşırtıcı derecede tutarlıydı: çok paragraflı makaleler, kurmaca öyküler ve insan yazısına benzeyen özetler.

Bu yetenekler otomatik propaganda, spam, taciz ve sahte haber gibi kötüye kullanım riskleri konusunda alarm verdi. OpenAI, tam modelin hemen yayınlanmaması yönünde kademeli bir yayın stratejisi benimsedi:

- İlk olarak daha küçük bir modelin yayımlanması, teknik makale ve örneklerle

- İç ve dış red‑teaming ile kötüye kullanım senaryolarının araştırılması

- Risk değerlendirmeleri tamamlandıkça daha büyük versiyonların kademeli olarak yayımlanması

Bu, OpenAI'nin dağıtım kararlarını güvenlik ve toplumsal etkiye bağladığını açıkça gösteren ilk yüksek profilli örneklerden biriydi.

GPT-3: Ölçek, Genellik ve API (2020)

GPT-3 bir kez daha ölçeği büyüttü—bu kez 175 milyar parametreye kadar. Model, her görev için ince ayara dayanmak yerine, prompt içinde talimatlar ve birkaç örnekle yeni bir görevi yerine getirebilme—“few-shot” ve hatta “zero-shot” öğrenme—gösterdi.

Bu düzeyde genellik, hem OpenAI hem de daha geniş endüstri için AI sistemleri hakkında düşünüşü değiştirdi. Birçok dar model oluşturmak yerine, tek bir büyük model genel amaçlı bir motor olarak hizmet edebilirdi:

- Metin üretimi ve içerik yazımı

- Kod parçacıkları ve otomatik tamamlama

- Soru yanıtlama, sohbet ve arama destekleri

Önemli olarak, OpenAI GPT-3'ü açık kaynak yapmamayı seçti. Erişim ticari bir API üzerinden sunuldu. Bu stratejik bir dönüşü işaret ediyordu:

- Modelleri yayınlamaktan ziyade işletilen hizmetler haline getirmek

- Saf araştırma laboratuvarından müşterileri olan bir platform sağlayıcısına dönüşmek

- Tek seferlik demolar yerine geliştiriciler ekosistemi oluşturmak

GPT‑1, GPT‑2 ve GPT‑3, OpenAI'nin tarihinde açık bir yayın izini takip eder: transformer'ları ölçeklendirmek, ortaya çıkan yetenekleri keşfetmek, güvenlik ve kötüye kullanımla uğraşmak ve ChatGPT ile GPT‑4 gibi ürünleri destekleyecek ticari temelleri atmak.

Organizasyonun Yeniden Yapılandırılması: OpenAI LP ve Kâr Sınırlı Model

2018 itibarıyla OpenAI liderleri, küçük, bağışlarla yürüyen bir laboratuvar olarak kalmanın çok büyük AI sistemlerini inşa etmek ve güvenli şekilde yönlendirmek için yeterli olmayacağına ikna olmuştu. Sınır modellerini eğitmek zaten milyonlarca dolarlık hesaplama ve yetenek gerektiriyordu ve maliyet eğrileri çok daha yükseğe işaret ediyordu. En iyi araştırmacıları çekmek, ölçek denemeleri yapmak ve bulut altyapısına erişimi güvence altına almak için OpenAI, misyonundan vazgeçmeden ciddi sermaye çekebilecek bir yapıya ihtiyaç duyuyordu.

Neden OpenAI LP Kuruldu?

2019'da OpenAI, yeni bir “kâr sınırlı” limited ortaklık olan OpenAI LP'yi başlattı. Amaç büyük dış yatırımı serbest bırakmak ama kâr amacı gütmeyen kuruluşun misyonunu—yani AGI'nin tüm insanlığa fayda sağlamasını—karar verme hiyerarşisinin tepesinde tutmaktı.

Geleneksel risk sermayesi destekli girişimler sınırsız getiri arayan hissedarlara hesap verir. OpenAI'nin kurucuları bunun güvenlik, açıklık veya dikkatli dağıtım yerine kârı önceliklendirmesi yönünde güçlü baskı yaratacağından endişeliydi. LP yapısı bir uzlaşıydı: sermaye benzeri çıkarlar ihraç edip büyük ölçekli para toplayabilirdi, ama farklı kurallar altında.

Kâr Sınırlı Model Nasıl Çalışır?

Kâr sınırlı modelde yatırımcılar ve çalışanlar OpenAI LP'deki paylarından belli bir kat sınıra kadar getiri elde edebilirler (erken yatırımcılar için sıkça söylenen değerler örnek olarak 100x'e kadar, sonraki turlarda daha düşük kaplarla). Bu sınır aşıldıktan sonra yaratılan ek değer nonprofit ana kuruluşa akıtılmak üzere tasarlanmıştır.

Bu, tipik girişimlerden keskin bir şekilde ayrılır; tipik girişimlerde sermaye teorik olarak sınırsız büyüyebilir ve hissedar değeri maksimize etmek yasal ve kültürel bir varsayımdır.

Nonprofit ile LP Arasındaki İlişki

OpenAI Nonprofit kontrol eden varlık olarak kalır. Yönetim kurulu OpenAI LP'yi denetler ve misyonu belirli yatırımcı veya çalışan gruplarının çıkarlarından önde tutacak şekilde görev almıştır.

Resmi olarak:

- Nonprofit, OpenAI LP üzerinde kontrol edici paya sahiptir.

- Nonprofit yönetim kurulu kilit liderlik atamalarını yapar ve misyonla çatışan kararları prensipte veto edebilir.

- Hukuki yükümlülükler nonprofit tüzüğüne göre çerçevelenir, salt finansal optimizasyona göre değil.

Bu yönetişim tasarımı, OpenAI'ye ticari bir organizasyonun işe alım ve finansman esnekliğini verirken misyon odaklı kontrolü korumayı amaçlıyordu.

Tartışmalar ve Finansman-İşe Alım Üzerindeki Etkiler

Yeniden yapılandırma içeride ve dışarıda tartışmalara yol açtı. Destekleyenler, bunun güvenlik ve ölçek gereksinimlerini karşılarken misyonu sınırlandırılmış kâr mekanizmasıyla koruyabilmenin tek pratik yolu olduğunu savundu. Eleştirmenler, büyük getiriler sunan herhangi bir yapının gerçekten ticari baskılara direnip direnemeyeceğini ve sınırların yeterince düşük ya da uygulanabilir olup olmadığını sorguladı.

Pratikte OpenAI LP büyük stratejik yatırımlara kapı açtı; bunların en önemlisi Microsoft yatırımıydı. Ayrıca şirketin rekabetçi tazminat paketleri sunmasına imkân verdi. Bu da OpenAI'nin araştırma ekiplerini büyütmesini, GPT-3 ve GPT-4 gibi modeller için eğitim koşularını genişletmesini ve ChatGPT gibi küresel ölçekli sistemleri konuşlandırmak için gereken altyapıyı inşa etmesini sağladı—bütün bunlar nonprofit kökenlerine resmi bir yönetişim bağıyla bağlanmış halde gerçekleşti.

Microsoft ile Stratejik Ortaklık

Gereksinimlerden API'ler üretin

Uç noktaları ve veri ihtiyaçlarını tarif ederek PostgreSQL ile bir Go backend oluşturun.

2019 Yatırımı ve Uzun Vadeli Anlaşma

2019'da OpenAI ve Microsoft çok yıllı bir ortaklık açıkladı; bu, her iki şirketin AI'daki rollerini yeniden şekillendirdi. Microsoft raporlara göre 1 milyar dolara yakın bir yatırım yaptı; nakit ve Azure bulut kredileri kombinasyonu ile Microsoft, OpenAI'nin tercih edilen ticari ortağı oldu.

Anlaşma, OpenAI'nin artan büyüklükte modelleri eğitmek için muazzam hesaplama kaynaklarına ihtiyacıyla, Microsoft'un ise ürünlerini ve bulut platformunu farklılaştıracak ileri düzey AI'ya erişme isteğini hizaladı. Takip eden yıllarda ilişki, ek finansman ve teknik işbirliğiyle derinleşti.

Azure OpenAI'nin Bulut Omurgası Oldu

OpenAI, Azure'u birincil bulut platformu olarak seçti; bunun birkaç nedeni vardı:

- Ölçek ve özel donanım: Azure, büyük ölçekli eğitim için binlerce GPU içeren ve daha sonra özel hızlandırıcılar ekleyen kümeler oluşturmayı taahhüt etti.

- Ortak mühendislik: OpenAI mühendisleri, büyük dil modelleri için ağ, depolama ve orkestrasyon optimizasyonu yapmak için Azure ekipleriyle yakından çalıştı.

- Finansal yapı: Yatırım ve bulut kredileri, başka yerlerde maliyeti aşırı olan deneylerin ön maliyetini düşürdü.

Bu, GPT‑3, Codex ve daha sonra GPT‑4 gibi modellerin eğitimi ve sunumu için Azure'u varsayılan ortam haline getirdi.

Süperbilgisayar Altyapısını Birlikte Geliştirmek

Ortaklık, OpenAI iş yükleri için Azure üzerinde inşa edilen dünyanın en büyük AI süperbilgisayarlarından birine yol açtı. Microsoft bu küme örneklerini Azure'un AI yeteneklerinin amiral gemileri olarak vurguladı; OpenAI ise model boyutu, eğitim verisi ve deneyim hızını artırmak için bunlara güvendi.

Bu ortak altyapı çalışması “müşteri” ile “ortağın” sınırlarını bulanıklaştırdı: OpenAI, Azure'un AI yol haritasını etkiledi; Azure ise OpenAI'nin ihtiyaçlarına göre optimize edildi.

Lisanslama, Ürünler ve Kamu Algısı

Microsoft, özellikle GPT‑3 gibi bazı teknolojiler üzerinde özel lisanslama hakları aldı. Bu, Microsoft'un OpenAI modellerini Bing, Office, GitHub Copilot ve Azure OpenAI Service gibi ürünlerde gömülü şekilde kullanabilmesine izin verdi; diğer şirketler ise OpenAI'nin kendi API'si üzerinden erişim sağladı.

Bu ayrıcalık tartışmalara yol açtı: destekleyenler bunun güçlü AI'nın ölçeklenmesi ve güvenli şekilde dağıtılması için gereken finansman ve dağıtımı sağladığını savundu; eleştirmenler ise bunun sınır modelleri üzerindeki etkinin tek bir büyük teknoloji şirketi etrafında yoğunlaşmasına yol açtığını endişe etti.

Aynı zamanda ortaklık OpenAI'ye ana akım görünürlük kazandırdı. Microsoft'un markalaşması, ürün entegrasyonları ve kurumsal satış kanalları OpenAI sistemlerini araştırma demolarından milyonlarca insanın kullandığı araçlara taşıdı ve OpenAI'yi hem bağımsız bir laboratuvar hem de Microsoft'un temel AI ortağı olarak algılanmasına neden oldu.

Metin Dışında Atılımlar: DALL·E, CLIP ve Codex

OpenAI'nin modelleri dil anlama ve üretmede ilerledikçe ekip yeni modalitelere—görüntü ve koda—yöneldi. Bu kayma OpenAI'nin çalışmalarını yazı ve diyalog dışına taşıyarak görsel yaratıcılık ve yazılım geliştirmeye genişletti.

CLIP: Görüntü ve Dilin Bağlanması

CLIP (Contrastive Language–Image Pretraining), 2021 başlarında duyuruldu ve modellerin dünyayı insanlara daha benzer şekilde anlamaya başlamasında önemli bir adım oldu.

CLIP, yalnızca etiketli görüntüler üzerinde eğitim yapmak yerine, halka açık webden toplanan yüz milyonlarca görüntü–altyazı çiftinden öğrendi. Görselleri en olası metin açıklamasıyla eşleştirmeyi ve yanlış eşleşmeleri ayırt etmeyi hedefleyecek şekilde eğitildi.

Bu CLIP'e şaşırtıcı derecede genel yetenekler kazandırdı:

- Görev‑özgü eğitim olmadan nesneleri ve stilleri tanıma

- Doğal dil istemlerini takip ederek (ör. “bir tekir kedi fotoğrafı”) görüntüleri sınıflandırma

- Diğer sistemler için esnek bir görsel temel sağlama

CLIP, OpenAI'nin sonraki üretken görüntü çalışmalarının temelini oluşturdu.

DALL·E ve DALL·E 2: Metinden Görüntüye Yaratıcılık

DALL·E (2021), GPT tarzı mimarileri görüntülere uygulayarak metin istemlerinden doğrudan resimler üretti: “avokado şeklinde bir koltuk” veya “üzerinde ‘openai’ yazan bir dükkân tabelası” gibi. Dil modellerinin tutarlı, sık sık eğlenceli görseller üretebileceğini gösterdi.

DALL·E 2 (2022), çözünürlük, gerçekçilik ve kontrol edilebilirlik açısından büyük gelişmeler getirdi. Aşağıdaki gibi özellikler sundu:

- Inpainting: Bir görüntünün parçalarını metinle düzenleme

- Outpainting: Bir görüntüyü orijinal sınırlarının ötesine uzatma

- Stil ve kompozisyon kontrolü: Ayrıntılı istemlerle çıktıyı yönlendirme

Bu sistemler tasarımcıların, pazarlamacıların, sanatçıların ve hobi kullanıcılarının fikirleri prototipleme şeklini değiştirdi; bazı yaratıcı işleri manuel taslaktan yinelemeli istem odaklı keşfe kaydırdı.

Codex ve Yazılım Geliştirmenin Geleceği

Codex (2021), GPT‑3 ailesini kaynak koda uyarladı ve büyük kamu kod tabanları üzerinde eğitildi. Python, JavaScript ve daha birçok dil için doğal dilden çalışan kod parçacıkları üretebiliyor.

GitHub Copilot, Codex üzerine inşa edilerek günlük geliştirme araçlarına getirildi. Programcılar artık doğal dil yorumlarıyla rehberlik ederek fonksiyonlar, testler ve boilerplate kodu önerileri alabildi.

Yazılım geliştirme için Codex kademeli bir kaymayı işaret etti:

- Her satırı elle yazmaktan AI tarafından üretilmiş taslakları denetleme ve düzeltmeye geçiş

- Söz dizimini ezberlemek yerine mimari, niyet ve incelemeye odaklanma

CLIP, DALL·E ve Codex birlikte OpenAI'nin yaklaşımının metin dışına, görsel yaratıcılık ve kod üretimine de genişleyebileceğini gösterdi; bu da araştırmanın etkisini sanat, tasarım ve mühendislik alanlarına yaydı.

ChatGPT ve Kamusal Odak

İçerik üreterek kredi kazanın

Koder.ai hakkında içerik oluşturun ve geliştirmeye devam etmeniz için kredi kazanın.

Lansman ve Hızlı Benimseme

OpenAI, ChatGPT'yi 30 Kasım 2022'de ücretsiz bir “araştırma önizlemesi” olarak başlattı; bunu büyük bir pazarlama kampanyası yerine kısa bir blog yazısı ve tweet ile duyurdu. Model, diyaloğa optimize edilmiş GPT‑3.5 tabanlıydı ve bazı zararlı veya güvensiz talepleri reddetmek için güvenlik önlemleri vardı.

Kullanım hemen patladı. Milyonlarca kullanıcı kısa sürede kaydoldu ve ChatGPT şimdiye kadar en hızlı büyüyen tüketici uygulamalarından biri haline geldi. Kullanıcıların yazı yazma, kod hata ayıklama, e-posta taslağı hazırlama ve karmaşık konuları sade şekilde açıklama yeteneklerini test ettiği ekran görüntüleri sosyal medyayı doldurdu.

İşte, okulda ve evde günlük kullanım

ChatGPT'nin çekiciliği tek bir dar kullanım senaryosundan ziyade çok yönlülüğünden geldi.

Eğitimde öğrenciler okumaları özetlemek, pratik sorular üretmek, akademik makaleleri çevirmek veya basitleştirmek ve matematik ya da fen problemlerini adım adım açıklatmak için kullandılar. Öğretmenler ise müfredat tasarlamak, rubrik oluşturmak ve farklılaştırılmış öğrenme materyalleri hazırlamak için denemeler yaptı; aynı zamanda okullar bunun nasıl izin verileceği konusunda tartıştı.

İş yerinde profesyoneller e-postalar, pazarlama metinleri ve raporlar taslağı, sunum ana hatları, kod parçaları, test vakaları oluşturma ve ürün fikirleri için beyin fırtınası amaclı kullandı. Serbest çalışanlar ve küçük işletmeler özellikle içeriğe ve analize düşük maliyetli bir asistan olarak güvendi.

Günlük sorun çözmede insanlar ChatGPT'yi seyahat planları, buzdolabındaki malzemelerle yemek fikirleri, temel hukuki ve tıbbi açıklamalar (genellikle bir uzmana başvurulması gerektiği uyarısıyla) ve yeni beceriler veya diller öğrenme gibi işler için kullandı.

Ücretsiz önizlemeden ücretli tekliflere

Başlangıç araştırma önizlemesi, hatalar, kötüye kullanım ve eksik yeteneklerle ilgili geri bildirim toplamak için ücretsiz tutuldu. Kullanım arttıkça OpenAI hem yüksek altyapı maliyetleriyle hem de daha güvenilir erişim talebiyle karşılaştı.

Şubat 2023'te OpenAI, ChatGPT Plus adlı bir abonelik planı tanıttı; daha hızlı yanıtlar, yoğun saatlerde öncelikli erişim ve GPT‑4 gibi yeni özelliklere erken erişim sundu. Bu, geniş erişimi korurken düzenli gelir akışı oluşturdu.

Zamanla OpenAI, API erişimi, ChatGPT Enterprise ve ekip planları gibi daha kurumsal seçenekler ekledi; bu teklifler daha yüksek güvenlik, yönetici kontrolleri ve uyumluluk özellikleri arayan kuruluşlara yöneliktir.

Tartışma, düzenleme ve etik kaygılar

ChatGPT'nin ani görünürlüğü uzun süredir devam eden AI tartışmalarını yoğunlaştırdı.

Düzenleyiciler gizlilik, veri koruma ve mevcut yasalara uyum konularında endişe duydu; özellikle Avrupa Birliği gibi bölgelerde bazı otoriteler ChatGPT'yi geçici olarak kısıtlama veya veri işleme uygulamalarını inceleme yoluna gitti.

Eğitimciler intihal ve akademik dürüstlük konularıyla yüzleşti; öğrenciler tarafından üretilen denemeler ve ödev cevapları tespit edilmesi zor çıktılar verebiliyordu. Bu, bazı okullarda yasaklara veya sıkı politikalara, diğerlerinde ise süreç ve sözlü sınavlara dayalı ödev tasarımlarına yol açtı.

Etikçiler ve araştırmacılar dezenformasyon, kritik kararlar için AI'ya aşırı güvenme, yanlılık ve yaratıcı/mesleki işlerin geleceği hakkında endişe dile getirdi. Ayrıca eğitim verileri, telif hakları ve modellerin davranışını etkileyebilecek sanatçı ve yazar haklarıyla ilgili sorular gündeme geldi.

OpenAI için ChatGPT bir dönüm noktasıydı: organizasyonu büyük dil modellerinin nasıl dağıtılacağı, düzenleneceği ve günlük yaşama entegre edileceği konusundaki küresel tartışmaların merkezine taşıdı.

GPT-4 ve AI Yeteneklerini Geliştirmek

GPT-3.5'ten GPT-4'e

OpenAI Mart 2023'te GPT-4'ü yayınladı; bu, başlangıçta ChatGPT'yi çalıştıran GPT‑3.5'in ötesinde önemli bir adımdı. GPT‑4 muhakemede, karmaşık talimatları takip etmede ve daha uzun konuşmalarda tutarlılığı korumada gelişti. Ayrıca hukuki maddeleri açıklama, teknik makaleleri özetleme veya belirsiz gereksinimlerden kod oluşturma gibi nüanslı istemleri ele almada çok daha iyi hale geldi.

GPT‑3.5'e kıyasla GPT‑4 birçok bariz hata modunu azalttı: atıf isterken kaynak uydurma olasılığı düştü, matematik ve mantık konusundaki uç durumları daha güvenilir şekilde ele aldı ve tekrar edilen sorgularda daha tutarlı çıktılar üretti.

Multimodal ve Benchmark Performansı

GPT‑4 bazı konfigürasyonlarda metne ek olarak görüntüleri de girdi olarak kabul eden multimodal yetenekler tanıttı. Bu, grafiklerin tanımlanması, el yazısı notların okunması, kullanıcı arayüzü ekran görüntülerinin yorumlanması veya fotoğraflardan yapılandırılmış bilgi çıkarma gibi kullanım durumlarını mümkün kıldı.

Standartlaştırılmış benchmark'larda GPT‑4 önceki modellere göre önemli ölçüde daha iyi performans gösterdi. Baro sınavı, SAT ve çeşitli ileri düzey testler gibi simüle edilmiş mesleki sınavlarda üst yüzde dilimlerine yakın puanlar aldı. Kodlama ve muhakeme benchmark'larında da gelişmeler gösterdi; bu, dil anlama ve problem çözme yeteneklerinde güçlenmeyi yansıtıyor.

Ekosistem Etkisi ve Kalan Zorluklar

GPT‑4 hızla OpenAI'nin API'sinin merkezine yerleşti ve üretkenlik araçlarında, kodlama asistanlarında, müşteri destek araçlarında, eğitim platformlarında ve hukuk, finans ve sağlık gibi dikey uygulamalarda yeni bir dalga üçüncü taraf ürünü besledi.

Buna rağmen GPT‑4 hâlâ halüsinasyon üretebiliyor, güvenlik veya yanlılığa sokulabiliyor ve güncel olgusal bilgiye her zaman sahip değil. OpenAI, RLHF, red‑teaming ve sistem düzeyinde güvenlik kuralları gibi teknik yaklaşımlarla GPT‑4 için uyum çalışmalarına yoğunlaştı; ancak riskleri ve kötüye kullanımı yönetmek için dikkatli dağıtım, izleme ve sürekli araştırma gerektiğini vurguluyor.

OpenAI'de Güvenlik, Uyum ve Yönetişim

OpenAI erken yıllarından itibaren güvenlik ve uyumu misyonunun merkezine koydu. Organizasyon, yetenekli AI sistemleri geliştirme hedefinin insan değerleriyle uyumlu olmasını ve dağıtımın hissedarlar veya erken ortaklardan ziyade herkes için fayda sağlamayı amaçladığını sürekli belirtti.

OpenAI Charter ve Belirtilen Öncelikler

2018'de OpenAI, önceliklerini resmileştiren OpenAI Charter belgesini yayımladı. Bu belgede öne çıkanlar:

- Geniş fayda sağlayan AGI oluşturmak ve insanlığa zarar verebilecek kullanımları engellemek

- Güvenlik konusunda diğer araştırma ve politika kurumlarıyla işbirliği yapmak

- Eğer başka projeler OpenAI'den daha güvenli AGI'ye yakınsa onlara yardım etmeye hazır olmak

Charter, araştırma yönleri, dağıtım hızı ve dış ortaklık kararlarını şekillendiren bir yönetişim pusulası işlevi görüyor.

Güvenlik, Politika ve Red‑Teaming Yapıları

Modeller daha yetenekli hale geldikçe OpenAI, çekirdek araştırma ekiplerinin yanında özel güvenlik ve yönetişim fonksiyonları kurdu:

- Uyum ve güvenlik araştırma grupları modellerin insan niyetiyle uyumlu davranmasını nasıl sağlayacağı üzerinde çalışır.

- Politika ve yönetişim ekipleri toplumsal etkileri analiz eder, sorumlu dağıtım politikalarını yönetir ve hükümetlerle etkileşime girer.

- Red‑teaming programları modelleri kötüye kullanım, önyargı, güvenlik zayıflıkları ve diğer zararlı davranışlar için stres‑test eder.

Bu gruplar GPT‑4 ve DALL·E gibi modellerin lansman kararlarını, erişim düzeylerini ve kullanım politikalarını etkiler.

Teknikler: RLHF ve Ötesi

Belirgin bir teknik yaklaşım insan geri bildirimiyle pekiştirmeli öğrenme (RLHF) olmuştur. İnsan değerlendirenler model çıktısını gözden geçirir, sıralar ve bir ödül modeli eğitir. Ana model daha sonra insan‑tercihli davranışa yakın çıktılar üretmek üzere optimize edilir; bu toksik, önyargılı veya güvensiz çıktıları azaltmaya yardımcı olur.

Zamanla OpenAI, RLHF'yi sistem düzeyi güvenlik politikaları, içerik filtreleri, belirli alanlar için ince ayar ve riskli kullanımları kısıtlayıp işaretleyebilen izleme araçlarıyla destekledi.

Dış İşbirliği ve Kamusal Çerçeveler

OpenAI, hükümetlerle gönüllü taahhütler, model raporlama uygulamaları ve frontier model güvenliği standartları gibi kamusal güvenlik çerçevelerine katıldı. Akademisyenler, sivil toplum kuruluşları ve güvenlik araştırmacılarıyla değerlendirmeler, red‑teaming ve denetimler konusunda işbirliği yaptı.

Bu işbirlikleri, Charter gibi resmi belgeler ve gelişen kullanım politikaları OpenAI'nin giderek güçlenen AI sistemlerini yönetişim yaklaşımının temelini oluşturuyor.

Tartışmalar, Eleştiriler ve İç Gerilimler

Kodu tamamen kontrol edin

Projeyi daha ileri taşımaya hazır olduğunuzda kaynak kodu dışa aktararak tam kontrolü elinizde tutun.

OpenAI'nin hızlı yükselişi, organizasyonun özgür, güvenli fayda misyonuyla ne kadar uyumlu olduğu konusunda eleştiriler ve iç gerilimlerle gölgelendi.

“Açık” Bilimden Kapalı Modellere

Başlangıçta OpenAI açık yayıncılığı ve paylaşımı vurguluyordu. Modeller GPT‑2, GPT‑3 ve GPT‑4 gibi daha yetenekli hale geldikçe şirket sınırlı yayınlara, yalnızca API erişimine ve daha az teknik detaya kaydı.

Eleştirmenler bu hareketin “OpenAI” isminin ima ettiği vaade aykırı olduğunu savundular. Şirket içindeki destekçiler ise tam model ağırlıklarını ve eğitim ayrıntılarını saklamanın kötüye kullanımı ve güvenlik kaygılarını yönetmek için gerekli olduğunu savundu.

OpenAI, güvenlik değerlendirmeleri, sistem kartları ve politika belgeleri yayımlayarak yanıt verdi; ancak çekirdek model ağırlıklarını hâlâ mülkiyetinde tutuyor. Bunu açıklık, güvenlik ve rekabet baskıları arasında bir denge olarak sunuyor.

Güç, Veri ve Ticarileşme

OpenAI Microsoft ile ortaklık derinleştikçe—modellerin Azure'a entegrasyonu ve Copilot gibi ürünlere gömülmesi—bazen hesaplama, veri ve karar verme gücünün yoğunlaşmasına ilişkin endişeler gündeme geldi.

Eleştirmenler, en gelişmiş genel amaçlı modelleri ve bunların arkasındaki altyapıyı kontrol eden birkaç şirket olduğunu ve bunun riskler taşıdığını savunuyor. Diğerleri ise agresif ticarileşmenin (ChatGPT Plus, kurumsal teklifler, özel lisanslama) geniş paylaşım misyonundan uzaklaştığını belirtiyor.

OpenAI liderliği geliri pahalı araştırmaları finanse etmek için gerekli olarak çerçeveliyor; aynı zamanda kâr sınırlı yapı ve misyonu önceliklendiren bir tüzüğün varlığına işaret ediyor. OpenAI, ücretsiz erişim katmanları, araştırma ortaklıkları ve bazı açık kaynak araçlar gibi kamusal fayda gösteren programlar da sundu.

Liderlik Gerilimleri ve Yüksek Profilli Ayrılıklar

Hızla ilerleme hızı, açıklık düzeyi ve güvenliğe öncelik verme konusunda iç anlaşmazlıklar zaman zaman ortaya çıktı.

Dario Amodei ve diğerleri 2020'de Anthropic'i kurmak üzere ayrıldı; farklı güvenlik ve yönetişim görüşleri bunun nedenlerinden biri olarak gösterildi. Daha sonra Jan Leike gibi bazı önemli güvenlik araştırmacılarının 2024'teki istifaları kısa vadeli ürün hedeflerinin uzun vadeli güvenlik çalışmalarına baskı yaptığı yönünde kamuoyuna yansıyabilecek endişeleri vurguladı.

En görünür kopma Kasım 2023'te yaşandı: yönetim kurulu kısa süreliğine CEO Sam Altman'ı görevden aldı ve güven kaybı gerekçe gösterildi. Çalışanların yoğun itirazı ve Microsoft dahil diğer paydaşların araya girmesi sonrası Altman geri döndü, kurul yenilendi ve OpenAI yönetişim reformları, yeni bir Güvenlik ve Emniyet Komitesi dahil olmak üzere taahhüt etti.

Bu olaylar, organizasyonun hızlı dağıtım, ticari başarı ve güvenlik ile geniş fayda sorumluluklarını nasıl uzlaştıracağı konusunda hâlâ mücadele ettiğini gösterdi.

OpenAI'nin Yapay Zekânın Geleceğindeki Değişen Rolü

OpenAI küçük, araştırma odaklı bir nonprofit'ten AI için merkezi bir altyapı sağlayıcısına dönüşerek yeni araçların nasıl inşa edildiğini, düzenlendiğini ve anlaşıldığını etkiliyor.

Laboratuvardan Platforma

Sadece modeller yayınlamak yerine OpenAI artık GPT‑4, DALL·E ve gelecekteki sistemler için API'lar işletiyor; bu sayede:

- Sağlık, eğitim, geliştirici araçları ve yaratıcı endüstrilerde ürünler için teknik bir temel oluşturdu

- Diğer laboratuvarların benimseyip eleştirdiği performans ölçütleri, en iyi uygulamalar ve güvenlik varsayılanları için referans noktası haline geldi

Bu platform rolü, OpenAI'nin yalnızca araştırmayı ilerletmediği; aynı zamanda milyonlarca insanın güçlü AI'yla ilk deneyimini belirleyen varsayılanları oluşturduğu anlamına geliyor.

Araştırma, Endüstri ve Politika Şekillendirme

OpenAI'nin çalışmaları rakipleri ve açık kaynak topluluklarını yeni modeller, eğitim yöntemleri ve güvenlik yaklaşımlarıyla yanıt vermeye zorluyor. Bu rekabet ilerlemeyi hızlandırırken açıklık, merkezileşme ve ticarileştirme konusundaki tartışmaları da keskinleştiriyor.

Hükümetler ve düzenleyiciler giderek OpenAI'nin uygulamalarını, şeffaflık raporlarını ve uyum araştırmalarını AI dağıtımı, güvenlik değerlendirmeleri ve sorumlu kullanım için yazdıkları kurallarda göz önünde bulunduruyor. Kamu konuşmaları ChatGPT, GPT‑4 ve gelecek sistemler hakkında toplumun hem riskleri hem de faydaları nasıl hayal ettiğini şekillendiriyor.

Açık Sorular: Güç, Eşitlik, Hesap Verebilirlik

Modeller daha yetenekli hale geldikçe OpenAI'nin rolüyle ilgili çözülmemiş meseleler daha da önem kazanıyor:

- Sınır modelleri üzerindeki kontrol ne kadar yoğun olmalı?

- Kimler erken veya ayrıcalıklı erişim elde eder—hangi şartlarda?

- Eğitim verileri, çevresel etkiler ve dış denetimler nasıl yönetilir?

- OpenAI'nin müşterisi olmayan ama teknolojilerinden etkilenen insanlar ve ülkeler karşısındaki sorumlulukları nelerdir?

Bu sorular, gelecekteki AI sistemlerinin mevcut eşitsizlikleri çoğaltıp çoğaltmayacağını veya azaltıp azaltmayacağını belirleyecek.

Bugün OpenAI ile Nasıl İlişki Kurulur

Geliştiriciler ve işletmeler şunları yapabilir:

- OpenAI'nin API'ları üzerine inşa ederken bağımsız güvenlik kontrolleri, red‑teaming ve izlemeyi uygulamak

- Aşırı bağımlılığı önlemek için OpenAI modellerini açık kaynak araçlarla birleştirmek

- Mümkün olduğunda geri bildirim programlarına, politika danışmalarına ve araştırma işbirliklerine katılmak

Bireyler şunları yapabilir:

- Modellerin nasıl çalıştığını, sınırlamalarını ve verilerin nasıl kullanıldığını öğrenmek

- AI araçlarını eleştirel kullanmak—çıktıları doğrulamak, aşırı bağımlılıktan kaçınmak ve zararlı davranışı bildirmek

OpenAI'nin gelecekteki etkisi yalnızca şirketin iç kararlarına değil, hükümetlerin, rakiplerin, sivil toplumun ve sıradan kullanıcıların bu sistemlerle nasıl etkileşime girdiğine, eleştirdiğine ve hesap sorulduğuna da bağlı olacaktır.

SSS

OpenAI neden kuruldu?

OpenAI 2015'te, yapay genel zekâ (AGI) yaratılırsa bunun tüm insanlığa fayda sağlamasını güvence altına almak amacıyla kurulmuş bir kâr amacı gütmeyen araştırma laboratuvarı olarak ortaya çıktı.

Kuruluşu şekillendiren birkaç faktör şunlardı:

- Güçlü AI'nın birkaç şirket veya hükümet tarafından kontrol edilme endişesi

- Kısa vadeli kârdan ziyade uzun vadeli güvenlik ve uyumun önceliklendirilmesi arzusu

- Kapatık, tescilli sistemler yerine açık, işbirlikçi araştırmayı hızlandırma isteği

Bu kuruluş hikâyesi bugün hâlâ OpenAI'nin yapısını, ortaklıklarını ve kamu taahhütlerini etkilemektedir.

OpenAI AGI ile ne demek istiyor ve misyonu nedir?

AGI (artificial general intelligence) tek bir işe odaklanmış dar araçlar yerine, insan düzeyinde veya üzerinde geniş bir bilişsel görev yelpazesini yerine getirebilen AI sistemlerini ifade eder.

OpenAI'nin misyonu şunlardır:

- Kapsamlı şekilde fayda sağlayan AGI geliştirilmesine yardımcı olmak; bunun dar bir grubun eline geçmesini önlemek

- Güçlü sistemlerin insan değerleriyle uyumlu davranması için güvenlik ve uyum çalışmalarına odaklanmak

- Araştırma, ortaklıklar ve erişim programları aracılığıyla faydaları mümkün olduğunca geniş şekilde paylaşmak

Bu misyon OpenAI Charter ve önemli araştırma ile dağıtım kararlarını şekillendirir.

OpenAI neden nonprofit'ten capped-profit yapısına geçti?

OpenAI, öncelikle büyük miktarda sermaye gerektiren öncü AI araştırmaları için finansman sağlamak amacıyla saf bir kâr amacı gütmeyen yapıdan “kâr sınırlı” bir limited ortaklığa (OpenAI LP) geçti.

Öne çıkan noktalar:

- Yatırımcılar ve çalışanlar, sınırlı bir çarpana kadar getiri elde edebilirler

- Kâr amacı gütmeyen ana kuruluş OpenAI LP'yi kontrol eder ve insanlığın çıkarlarını ön planda tutması beklenir

- Bu yapı fon ve yetenek erişimi ile güvenlik/etik kaygılar arasında bir denge kurmayı hedefler

Bu bir yönetişim deneyidir ve etkinliği tartışma konusudur.

Microsoft ortaklığından Microsoft ne kazanıyor?

Microsoft, OpenAI'ye Azure üzerinden büyük ölçekli bulut hesaplama sağlıyor ve şirkete milyarlarca dolar yatırım yaptı.

Ortaklık şunları içerir:

- GPT‑4 gibi büyük modellerin eğitimi için özel süperbilgisayar altyapısı

- Bazı teknolojilerin (ör. GPT‑3) lisanslama haklarıyla Microsoft ürünlerine entegrasyon

- OpenAI modellerinin GitHub Copilot, Bing ve Microsoft 365 gibi ürünlere gömülmesi

Bunun karşılığında OpenAI, küresel ölçekte sınır modeli deneyleri yapmak için gerekli kaynaklara erişirken Microsoft, kendi ekosistemine farklılaşan AI yetenekleri kazandırır.

GPT-1, GPT-2, GPT-3 ve GPT-4 OpenAI'nin yönünü nasıl değiştirdi?

- GPT‑1 (2018): Günümüz standartlarına göre küçüktü ama tek bir transformer modelinin birçok dil görevine uyarlanabileceğini gösterdi.

- GPT‑2 (2019): Çok daha büyük ve şaşırtıcı derecede tutarlı metinler üretti; kötüye kullanım endişeleri nedeniyle kademeli ve temkinli bir yayın stratejisi izlendi.

- GPT‑3 (2020): Ölçek ve çok yönlülükte büyük sıçrama; few-shot ve zero-shot yetenekleriyle dikkat çekti ve ticari bir API üzerinden erişim sunuldu.

- GPT‑4 (2023): Daha iyi muhakeme, daha yüksek tutarlılık ve multimodal (metin + görüntü) yetenekler; ChatGPT ve birçok üçüncü taraf uygulamanın temelini oluşturdu.

OpenAI bugün neden eskisi kadar "açık" değil?

OpenAI başlangıçta “varsayılan olarak açık” bir yaklaşım izliyordu: makaleler, kod ve araçlar genişçe paylaşılıyordu. Modeller güçlendikçe yön değişti:

- Tam model ağırlıklarının sınırlı veya gecikmeli yayınlanması

- İndirilebilir modeller yerine API tabanlı erişim

- Ham eğitim ayrıntıları yerine güvenlik değerlendirmeleri ve sistem kartlarına daha fazla vurgu

OpenAI bunu kötüye kullanım risklerini azaltmak ve güvenlik endişelerini yönetmek için gerekli olduğunu savunuyor; eleştirmenler ise bunun kuruluşun isminin ima ettiği “açıklık” vaadini zayıflattığını iddia ediyor.

OpenAI AI sistemlerini nasıl güvenli ve uyumlu tutmaya çalışıyor?

OpenAI, güvenliği ve uyumu misyonunun merkezine koyduğunu sürekli olarak belirtiyor.

Kullandığı yöntemler arasında şunlar var:

- Geniş fayda sağlayan AGI taahhüdünü içeren bir Charter

- Lansman ve erişim kararlarını etkileyen güvenlik, politika ve red‑teaming ekipleri

- İnsan geri bildirimiyle pekiştirmeli öğrenme (RLHF), içerik filtreleri ve izleme araçları

- Kademeli yayınlar ve yüksek riskli yetenekler için farklı erişim seviyeleri

Bu önlemler riskleri azaltıyor ancak halüsinasyonlar, önyargı ve kötüye kullanım gibi sorunları tamamen ortadan kaldırmıyor; bu alanlar hâlâ aktif araştırma ve politika konuları.

ChatGPT'nin çıkışı OpenAI ve genel olarak AI için neden bir dönüm noktasıydı?

ChatGPT, 2022 sonlarında başlatıldığında büyük dil modellerini basit bir sohbet arayüzüyle genel kullanıma açtı.

Neden kırılma noktası oldu:

- Araştırma teknolojisini yazma, kodlama ve öğrenme gibi günlük araçlara dönüştürdü

- Milyonlarca insanı hızlıca konuşmacı AI ile tanıştırdı

- Okullar, şirketler ve düzenleyiciler gibi kurumları intihal, gizlilik, önyargı ve AI'ya bağımlılık gibi pratik sorularla yüzleştirdi

Bu görünürlük, OpenAI'nin yönetişimini, iş modelini ve güvenlik uygulamalarını daha sıkı incelemeye açtı.

OpenAI'nin teknolojileri işlere ve yaratıcı çalışmalara nasıl etki edebilir?

OpenAI'nin modelleri, özellikle Codex ve GPT‑4, bilgi ve yaratıcı işleri etkilemeye başladı.

Olası faydalar:

- Tekrarlayan yazma ve kodlama görevlerini otomatikleştirme

- Taslak hazırlama, beyin fırtınası ve çeviri işleri için yardımcı olma

- Konuşma tabanlı öğrenme araçlarıyla eğitime erişimi genişletme

Riskler ve endişeler:

Bireyler ve kuruluşlar bugün OpenAI ile sorumlu şekilde nasıl etkileşime girebilir?

OpenAI ekosistemiyle sorumlu şekilde etkileşim kurmanın yolları:

- Kullanıcı olarak: ChatGPT ve diğer araçları deneyin, güçlü ve zayıf yanlarını öğrenin; çıktıları son gerçek olarak değil, gözden geçirilmesi gereken taslaklar olarak görün.

- Geliştirici/iş olarak: OpenAI API'larını ürünlere entegre ederken kendi güvenlik kontrollerinizi, günlükleme ve alanınıza özel korumaları ekleyin.

- Vatandaş/araştırmacı olarak: OpenAI Charter ve güvenlik raporlarını takip edin; mümkünse kamu danışmalıklarına, denetimlere ve eleştirel araştırmalara katılın.

Her durumda, modellerin nasıl eğitildiği ve yönetildiği hakkında bilgili olmak, şeffaflık, hesap verebilirlik ve adil erişim taleplerinde bulunmak önemlidir.