Yapay zeka ile oluşturulan kod ve otomatik testlerin neden birlikte olması gerektiği

Yapay zeka tarafından yazılan uygulama mantığı, kod tabanınızın "işleyen" parçalarının bir asistan yardımıyla taslak halinde ortaya çıkması demektir: yeni fonksiyonlar, küçük özellikler, refaktörler, uç durumların ele alınması ve hatta mevcut modüllerin yeniden yazılması. Ne inşa edeceğinize siz karar verirsiniz, ancak uygulamanın ilk sürümü genellikle daha hızlı gelir—ve bazen ancak sonradan fark edeceğiniz varsayımlar içerir.

Otomatik test oluşturma doğrulama tarafında eşleşen yetenektir. Her testi elle yazmak yerine, araçlar kodunuza, bir spesifikasyona veya önceki hatalardan öğrenilen desenlere dayanarak test vakaları ve doğrulamalar önerebilir. Pratikte bu şu şekillerde görünebilir:

- "Bu fonksiyon imzası ve dallanmalara göre tipik girdileri, sınırları ve hata yollarını kapsayan testler."

- "Üretimde gördüğümüz çökmeyi tekrar eden regresyon testleri."

Önemli beklenti: oluşturulan testler otomatik olarak "iyi" değildir

Oluşturulan bir test yanıltıcı olabilir: mevcut davranışı doğrulayabilir, hatta davranış yanlış olsa bile; ya da kodun içinde olmayan ürün kurallarını atlayabilir. Bu yüzden insan incelemesi önemlidir. Birinin test adının, kurulumu ve doğrulamalarının gerçek niyeti yansıtıp yansıtmadığını doğrulaması gerekir—yalnızca kodun bugün yaptığı şey değil.

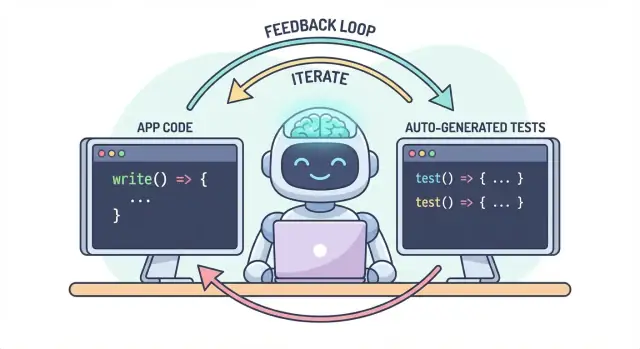

Tek iş akışı, iki çıktı

Temel fikir basit: kod ve testler tek bir iş akışı içinde birlikte evrilmeli. Yapay zeka mantığı hızlıca değiştirmenize yardımcı oluyorsa, otomatik test oluşturma de aynı hızla beklenen davranışı kilitlemenize yardımcı olur—böylece bir sonraki değişiklik (insan ya da yapay zeka) için "hala doğru"nun açık, yürütülebilir bir tanımı olur.

Pratikte bu "eşlenmiş çıktı" yaklaşımı, geliştirme akışınız zaten sohbet odaklı olduğunda daha kolay korunur. Örneğin Koder.ai'da (sohbet yoluyla web, backend ve mobil uygulamalar inşa etmeye yönelik bir vibe-coding platformu) "özellik + testler"i tek bir teslimat olarak ele almak doğal: davranışı tanımlarsınız, uygulamayı üretirsiniz, sonra aynı konuşma döngüsünde testleri oluşturur ve gözden geçirirsiniz, sonra dağıtıma geçersiniz.

Sorun: daha hızlı kod daha hızlı hatalar anlamına gelebilir

Yapay zeka ile yazılmış kod bir süper güç gibi gelebilir: özellikler hızla ortaya çıkar, boilerplate kaybolur ve saatler alan refaktörler kahveniz soğumadan tamamlanabilir. Dezavantajı, hız riskin şeklini değiştirir. Kod üretmek kolaylaştığında, hata göndermek de kolaylaşır—bazen ince hatalar.

Yapay zeka tarafından yazılan mantığın yaygın hata modları

Yapay zeka yardımcıları "makul" implementasyonlar üretmede iyidir, ama makul olmak sizin özel alanınız için doğru olmak demek değildir.

Uç durumlar ilk kurbanlardır. Yapay zeka ile oluşturulan mantık genellikle mutlu yolu iyi ele alır, sonra sınır koşullarında tökezler: boş girdiler, saat dilimi incelikleri, yuvarlama, null değerleri, tekrar deneme davranışı veya "hiç olmaması gereken" ancak üretimde gerçekleşen durumlar.

Yanlış varsayımlar sık görülen bir diğer sorundur. Bir yardımcı, açıkça belirtilmeyen gereksinimleri varsayabilir ("kullanıcılar her zaman kimlik doğrulamalı", "IDs sayısal", "bu alan her zaman mevcut"), ya da sisteminizin kurallarına uymayan tanıdık bir deseni uygulayabilir.

Sessiz regresyonlar çoğunlukla en maliyetli olanlardır. Küçük bir değişiklik istersiniz, yardımcı mantığın bir kısmını yeniden yazar ve alakasız bir şey bozulur—belirgin bir hata olmadan. Kod hala derlenir, UI hâlâ yüklenir, ama fiyatlandırma kuralı, izin kontrolü veya veri dönüşümü hafifçe yanlış olabilir.

Daha hızlı kodla manuel testin ölçeklenmemesi

Kod değişimleri hızlandığında, manuel testler darboğaz ve kumar haline gelir. Ya daha fazla zaman harcarsınız (teslimatı yavaşlatır) ya da daha az test yaparsınız (kaçışları artırır). Disiplinli QA ekipleri bile sık ve geniş değişiklikler olduğunda her varyantı elle kaplayamaz.

Dahası, manuel kontroller tutarlı tekrarlanması zordur. Birinin hafızasında veya bir kontrol listesinde yaşarlar ve son teslim tarihlerinde atlanması kolaydır—tam da riskin en yüksek olduğu zamanlarda.

Testler hem güvenlik ağı hem iletişim aracı olarak

Otomatik testler dayanıklı bir güvenlik ağı oluşturur: beklentileri yürütülebilir kılar. İyi bir test der ki: "Bu girdiler ve bu bağlam verildiğinde, güvendiğimiz sonuç budur." Bu sadece doğrulama değil; gelecekteki siz, ekip arkadaşlarınız ve hatta yapay zeka asistanı için bir iletişimdir.

Testler olduğunda, değişiklikler daha az korkutucu olur çünkü geri bildirim anidir. Sorunları kod incelemesinden, staging'den veya müşterilerden sonra keşfetmek yerine değişiklikten dakikalar sonra bulursunuz.

Sorunları daha erken yakalayarak yeniden işi azaltın

Bir hata ne kadar erken yakalanırsa, çözülmesi o kadar ucuzdur. Testler geri bildirim döngüsünü kısaltır: niyet hâlâ taze iken uyumsuz varsayımları ve gözden kaçan sınır durumlarını gün yüzüne çıkarır. Bu yeniden işi azaltır, "ileriye düzeltme" yamalarından kaçınır ve yapay zeka hızının yapay zeka kaynaklı sürtüşmeye dönüşmesini engeller.

Testlerin yapay zeka tarafından yazılan mantık için nasıl bir geri besleme döngüsü yarattığı

Yapay zeka tarafından yazılan kodı bir seferlik teslimat yerine bir konuşma olarak ele aldığınızda en hızlı çalışır. Testler bu konuşmayı ölçülebilir kılar.

"spec → code → tests" döngüsü (basitçe)

-

Spec: Ne olması gerektiğini tanımlarsınız (girdiler, çıktılar, uç durumlar).

-

Code: Yapay zeka bu açıklamaya uyduğunu iddia eden implementasyonu yazar.

-

Tests: Siz (veya yapay zeka) davranışın gerçekten doğru olduğunu kanıtlayan kontroller oluşturursunuz.

Bu döngüyü tekrarlayın; sadece daha fazla kod üretmiyorsunuz—"yapılma" tanımını sürekli sıkılaştırıyorsunuz.

Testler daha net gereksinimler ve arayüzler zorlar

"Geçersiz kullanıcıları nazikçe ele al" gibi belirsiz bir gereksinim kodda gözden kaçırılması kolaydır. Bir test belirsiz olamaz. Test şu soruları hemen gündeme getirir:

- "Geçersiz" ne demek? Eksik ID, yasaklı statü, hatalı e-posta?

- "Nazikçe" ne anlama geliyor? Hata mesajı, durum kodu, yedek değer?

- Arayüz nedir? Fonksiyon imzası, dönüş şekli, istisnalar?

Bu ayrıntıları bir test ile ifade etmeye çalıştığınız anda, belirsiz parçalar hemen ortaya çıkar. Bu netlik yapay zekaya verdiğiniz promptu iyileştirir ve genellikle daha basit, daha stabil arayüzlere yol açar.

Oluşturulan testler kodun iddiasını doğrular

Yapay zeka kodu doğru görünür ama varsayımları saklayabilir. Oluşturulan testler kodun iddia ettiği şeyleri doğrulamanın pratik yoludur:

- "Bu fonksiyon saf" → dış etkisi olmadığını test edin.

- "Uç durumları ele alıyor" → null'lar, boş listeler, sınır değerleri test edin.

- "Geriye dönük uyumlu" → eski girdileri ve beklenen çıktıları test edin.

Amaç oluşturulan testlere körü körüne güvenmek değil—onları hızlı, yapılandırılmış bir şüphecilik olarak kullanmaktır.

Başarısız testler bir sonraki prompt olur

Başarısız bir test eyleme geçirilebilir geri bildirimdir: spec ile implementasyon arasındaki belirli bir uyumsuzluğa işaret eder. Yapay zekadan "düzelt" demek yerine hatayı yapıştırıp: "Public API'yi değiştirmeden bu testi geçecek şekilde kodu güncelle" diyebilirsiniz. Bu, hata ayıklamayı tahmine dayalı bir oyun yerine odaklanmış bir yinelemeye dönüştürür.

Otomatik test oluşturmanın test piramidinizdeki yeri

Otomatik test oluşturma, mevcut test stratejinizi—özellikle klasik "test piramidi"ni—desteklediğinde en faydalıdır. Piramit kendi başına bir kural değil; hızlı ve güvenilir geri bildirim verirken gerçek dünya hatalarını yakalamanın bir yoludur.

Yapay zeka her katmanda test oluşturmanıza yardımcı olabilir, ama en iyi sonucu ucuz testlerden (piramidin altı) daha fazla, pahalı olanlardan (tepe) daha az oluşturduğunuzda alırsınız. Bu denge CI hattınızı hızlı tutarken kullanıcı deneyimini korur.

Birim testleri: hızlı, odaklı ve çok üretilebilir

Birim testleri bireysel fonksiyonlar, metodlar veya modüller için küçük kontrollerdir. Hızlı çalışır, dış sistemlere ihtiyaç duymaz ve sınır durumlarının yapay zeka tarafından oluşturulması için idealdir.

Otomatik test oluşturmanın iyi kullanımları:

- Girdi doğrulama ve "garip" sınır değerlerini zorlamak

- İş kurallarını doğrulamak (indirimler, izinler, durum geçişleri)

- Unutması kolay hata düzeltmelerini regresyon testiyle kilitlemek

Birim testleri dar kapsamlı olduğu için gözden geçirmek daha kolay ve daha az dalgalıdır.

Entegrasyon testleri: daha az ama yüksek değerli

Entegrasyon testleri parçaların birlikte nasıl çalıştığını doğrular: API ile veritabanı, bir servisin başka bir servisi çağırması, kuyruk işlemleri, kimlik doğrulama vb.

Yapay zeka tarafından oluşturulan entegrasyon testleri değerli olabilir, ama daha fazla disiplin gerektirir:

- Testlerin veri sızıntısı yapmaması için net kurulum/temizlik

- Kararlı test ortamları (container'lar, test veritabanları, uygun yerlerde mock'lar)

- İç uygulama detayları yerine sonuçlara odaklanan doğrulamalar

Bunları bileşenler arasındaki dikişlerin hâlâ sağlam olduğunu gösteren "sözleşme kontrolleri" olarak düşünün.

Uçtan uca testler: seçerek oluşturun

Uçtan uca (E2E) testleri ana kullanıcı akışlarını doğrular. En pahalı olanlardır: çalışması daha yavaş, daha kırılgan ve hata ayıklamak daha zordur.

Otomatik test oluşturma E2E senaryolarını taslak hâline getirmede yardımcı olabilir, ama bunları agresifçe kürate etmelisiniz. Küçük bir kritik yol seti tutun (kayıt, ödeme, temel iş akışı) ve her özellik için E2E testi üretmeye çalışmaktan kaçının.

Pratik öneri: dengeli bir karışım oluşturun

Her şeyi üretmeye çalışmayın. Bunun yerine:

- AI ile yazılmış mantığı işlev düzeyinde dürüst tutmak için çok sayıda birim testi üretin

- En yüksek riskli sınırlar (DB, kimlik doğrulama, ödemeler) için hedeflenmiş entegrasyon testleri ekleyin

- Kırılmasına tahammül edemeyeceğiniz birkaç kullanıcı yolculuğu için minimal E2E setini koruyun

Bu yaklaşım piramidi korur ve otomatik test oluşturmayı gürültü kaynağı değil bir kuvvet çarpanı yapar.

Ne tür şeyler üretilebilir: koddan, spesifikasyonlardan ve gerçek hatalardan

Otomatik test oluşturma yalnızca "bu fonksiyon için birim testi yaz" ile sınırlı değildir. En yararlı üreticiler üç kaynaktan yararlanır: elinizdeki kod, arkasındaki niyet ve zaten gördüğünüz hatalar.

1) Kod yapısından: satır değil davranışı zorlamak

Bir fonksiyon veya modül verildiğinde, araçlar girdiler/çıktılar, dallanma ve istisna yollarından test vakalarını çıkarabilir. Bu genellikle şunları içerir:

- Bilinen sonucu üretmesi gereken "mutlu yol" girdileri

- Sınır değerler (boş string, sıfır, maksimum uzunluk)

- Dallanma kapsamı (if/else yolları)

- Hata işleme (geçersiz girdiler, eksik alanlar, zaman aşımı)

Bu stil, yapay zeka tarafından yazılan mantığı hızlıca çevreleyen ve bugün gerçekten ne yaptığını onaylayan kontroller oluşturmak için iyidir.

2) Gereksinimlerden: niyeti çalıştırılabilir örneklere dönüştürme

Kabul kriterleriniz, kullanıcı hikayeleriniz veya örnek tablolarınız varsa, üreticiler bunları spesifik gibi okunan testlere dönüştürebilir. Bu, koddan türetilen testlerden genellikle daha değerlidir çünkü "ne olması gerektiğini" kilitler, "şu an ne olduğuna" değil.

Pratik bir desen: birkaç somut örnek (girdiler + beklenen sonuçlar) sağlayın ve üreticiden bu kurallara uygun sınır durumlarını eklemesini isteyin.

3) Hata raporlarından: önce çoğalt, sonra engelle

Hata tabanlı üretim, anlamlı regresyon paketi oluşturmanın en hızlı yoludur. Çoğaltma adımlarını (veya logları ve minimal payload'u) verip şu çıktıyı oluşturun:

- mevcut hatalı davranışta başarısız olan bir test,

- düzeltildikten sonra aynı testin başarılı olması—böylece sonsuza dek yeniden girilmesini engelleyin.

Snapshot/golden testleri: faydalı, ama uyarı ile

Snapshot (golden) testler sabit çıktılar (render edilmiş UI, serileştirilmiş cevaplar) için verimli olabilir. Dikkatli kullanın: büyük snapshot'lar ince hataları "onaylayabilir." Küçük, odaklı snapshot'ları tercih edin ve doğru olması gereken ana alanlar üzerinde ayrıca doğrulamalar yapın.

Nereden başlamalı (okyanusu kaynatmadan)

Otomatik test oluşturma, net öncelikler verdiğinizde en etkili olur. Tüm kod tabanına "tüm testleri" üretmesini söylerseniz gürültü elde edersiniz: çok sayıda düşük değerli kontrol, yinelenen kapsam ve teslimatı yavaşlatan kırılgan testler.

İşin acı hissettiği yerden başlayın

Kırılmanın en maliyetli olacağı akışlarla başlayın—maddi, yasal ya da itibar açısından. Basit bir risk-temelli filtre kapsamı gerçekçi tutar ve hızla kaliteyi artırır.

Öncelik verin:

- İş açısından kritik yollar (kayıt, ödeme, temel iş akışları) ve sık değişen alanlar (aktif özellikler, refaktörler, yeni entegrasyonlar).

- Yüksek riskli alanlar: ödemeler, kimlik doğrulama, veri bütünlüğü, izinler/roller ve kullanıcıların ne görebileceğini/ne yapabileceğini etkileyen her şey.

Seçilen her akış için katmanlarda testler oluşturun: karmaşık mantık için birkaç hızlı birim testi ve tüm yolun çalıştığını doğrulayan bir-iki entegrasyon testi.

"Mutlu yol + en önemli sınır durumları" eksiksiz kombinasyonlardan daha iyidir

Gerçek hatalara uygun kapsam isteyin, teorik permütasyonlara değil. İyi bir başlangıç seti:

- Beklenen davranışı kanıtlayan bir mutlu yol testi.

- Aslında endişe duyduğunuz en önemli sınır durumları: eksik/geçersiz giriş, süresi geçmiş tokenlar, yetersiz izin, eşzamanlılık çatışmaları ve "boş durum" verisi.

Daha sonra hatalara, olay raporlarına veya kullanıcı geri bildirimine göre genişletebilirsiniz.

"Tamam" tanımını belirleyin ki gerçekten tamam kalsın

Kuralı açık yapın: bir özellik testler olana kadar tamamlanmış sayılmaz. Bu bitiş tanımı yapay zeka ile yazılan kodda daha da önemlidir, çünkü "hızlı gönderim"in sessizce "hızlı regresyonlar"a dönüşmesini önler.

Bunu kalıcı kılmak istiyorsanız, iş akışınıza entegre edin (ör. merge öncesi ilgili testlerin zorunlu olması) ve beklentiyi ekip dokümanlarınızda belirtin (ör. /engineering/definition-of-done).

Daha iyi testler üreten prompting kalıpları

Yapay zeka testleri hızlı üretebilir ama kalite nasıl sorduğunuza büyük ölçüde bağlıdır. Amaç modeli "davranışı koruyan" testlere yönlendirmektir—kod çalıştırmak için değil.

Kodlama standardınızı doğrudan prompta koyun

Başlarken testlerin şeklini sabitleyin ki çıktı depo standartlarınıza uysun.

Dahil edin:

- Dil + test çerçevesi (örn. TypeScript + Jest, Python + pytest)

- İsimlendirme kuralları (örn.

should_<davranış>_when_<koşul>)

- Dosya konumu ve yapı (örn.

src/ ve tests/ veya __tests__/)

- Herhangi bir konvansiyon (fixture'lar, factory yardımcıları, mock kütüphanesi)

Bu, modelin ekip tarafından kullanılmayan desenler icat etmesini engeller.

Kopyalanacak 1–2 gerçek test örneği verin

Mevcut bir test dosyasını (veya küçük bir alıntıyı) yapıştırın ve açıkça söyleyin: "Bu stili eşle." Bu, test verilerini nasıl düzenlediğiniz, değişkenleri nasıl adlandırdığınız ve tablo tabanlı testleri tercih edip etmediğiniz gibi kararları sabitler.

Projede yardımcılarınız varsa (örn. buildUser() veya makeRequest()), bu snippet'leri de ekleyin ki oluşturulan testler bunları yeniden uygulamak yerine kullansın.

Anlamlı doğrulamalar isteyin (sadece "çalıştı" değil)

"İyi"nin ne olduğunu belirtin:

- Çıktılar ve durum değişiklikleri üzerinde doğrulama

- Yan etkileri doğrulama (örn. veritabanı yazımı, yayılan olaylar)

- Uygunsa hata türleri/mesajları üzerinde doğrulama

Kullanışlı bir prompt satırı: "Her test en az bir işletme davranışı doğrulamalıdır (sadece 'istisna oluşmadı' değil)."

Negatif ve sınır testleri talep edin

Çoğu AI üretimi "mutlu yola" eğilimlidir. Bunu dengelemek için isteyin:

- Geçersiz girişler ve beklenen hatalar

- Sınır değerleri (boş stringler, sıfır, maksimum uzunluk)

- İzin/authorization hataları

- Eksik bağımlılıklar (örn. null yanıtlar, zaman aşımı)

Pratik bir prompt şablonu

Generate unit tests for <function/module>.

Standards: <language>, <framework>, name tests like <pattern>, place in <path>.

Use these existing patterns: <paste 1 short test example>.

Coverage requirements:

- Happy path

- Boundary cases

- Negative/error cases

Assertions must verify business behavior (outputs, state changes, side effects).

Return only the test file content.

İnsan incelemesi: oluşturulan testlerin gerçekten işe yaradığından emin olmak

Yapay zeka birçok testi hızla taslak hâline getirebilir, ama bu testlerin niyetinizi temsil edip etmediğinin nihai yargıcı olamaz. İnsan kontrolü "çalışan testler"i "bizi koruyan testler"e dönüştürür. Amaç stil açısından nitpick etmek değil—test paketinin anlamlı regresyonları yakalayacağını doğrulamaktır.

Doğruluk ve alaka düzeyi için inceleme

İki soru ile başlayın:

- Test, ürünün gerçekten ihtiyacı olan davranışı mı doğruluyor?

- Bu test gelecekte başarısız olsaydı hoşnut olur muydunuz—çünkü gerçek bir problemi işaret ediyordu?

Oluşturulan testler bazen kazara mevcut davranışı (uygulama içi detayları) kilitler. Bir test kodun kopyası gibi okunuyorsa, onu daha üst düzey doğrulamalara yönlendirin.

Kırılganlığı izleyin (görünmez verimlilik düşmanı)

Dalgalı veya kırılgan testlerin yaygın kaynakları aşırı moklama, sert kodlanmış zaman damgaları ve rastgele değerlerdir. Deterministik girdiler ve kararlı doğrulamalar tercih edin (ör. ham Date.now() stringi yerine analize edilmiş tarih veya aralık doğrulaması). Bir testin geçmesi için aşırı moklama gerekiyorsa, muhtemelen bağlantıyı değil davranışı test ediyor demektir.

Hataların doğru nedenle oluştuğundan emin olun

Bir test "geçiyor" olsa bile işe yaramaz olabilir eğer özellik bozuk olduğunda bile geçiyorsa (sahte pozitif). "Hata yok" veya sadece bir fonksiyonun çağrıldığını kontrol eden zayıf doğrulamalara dikkat edin. Bunları çıktı, durum değişiklikleri, döndürülen hatalar veya kalıcı veriler üzerinde doğrulamayla güçlendirin.

Hafif bir kod inceleme kontrol listesi kullanın

Basit bir kontrol listesi incelemeleri tutarlı kılar:

- Okunabilirlik: açık isimler, minimal kurulum, bariz niyet

- Niyetin kapsamı: ana uç durumlar ve hata yolları dahil

- Sürdürülebilirlik: iç detayları aşırı belirtmekten kaçınma; minimal moklama

- Sinyal kalitesi: gerçek bir regresyon olduğunda başarısız olur, zararsız refaktörlerde bozulmaz

Oluşturulan testleri diğer kodlar gibi değerlendirin: altı ay sonra sahiplenebileceğiniz şeyleri merge edin.

Kalıcı kılma: AI kodunu dürüst tutacak CI kontrolleri

Yapay zeka kod yazmanızı hızlandırır, ama gerçek kazanım bu kodu zaman içinde doğru tutmaktır. Kaliteyi "kilitlemenin" en basit yolu, her değişiklikte testlerin ve kontrollerin otomatik çalışmasını sağlamaktır—böylece regresyonlar gönderilmeden önce yakalanır.

İşe yarayan pratik bir akış

Pek çok ekibin benimsediği hafif iş akışı şöyle görünür:

- Özelliği oluşturun veya düzenleyin (AI destekli olabilir).

- Yeni davranış için testleri oluşturun (ve çözdüğünüz hataya yönelik testleri de ekleyin).

- Her şeyi yerelde çalıştırarak yeşil olduğundan emin olun.

- Kod + testleri birlikte commit edin.

Son adım önemlidir: AI ile yazılmış mantık test olmadan sürüklenmeye başlar. Testlerle niyeti CI'nin uygulayabileceği şekilde kaydediyorsunuz.

CI: vazgeçilemez güvenlik ağı

CI hattınızı her pull request'te (ve ideal olarak main'e merge'lerde) çalışacak şekilde yapılandırın. En azından:

- Temiz bir ortamda bağımlılıkları yükleyin

- Birim/entegrasyon testlerini çalıştırın

- Herhangi bir test başarısızsa build'i başarısız sayın

Bu, "makinemde çalıştı" sürprizlerini önler ve bir ekip üyesi (veya sonraki bir AI promptu) başka yerde kod değiştirdiğinde kazara bozulmaları yakalar.

Hafif kalite kapıları ekleyin

Testler temel, ama her şeyi yakalamazlar. Test oluşturmayı tamamlayacak küçük, hızlı kapılar ekleyin:

- Linting (stil + yaygın hatalar)

- Tip kontrolleri (uygunsa)

- Formatlama kontrolleri (diff'leri okunur tutmak için)

Bu kontroller hızlı olmalı—eğer CI yavaş veya gürültülü hissedilirse, insanlar etrafından yollar arar.

Maliyet ve kapasite planlaması

Daha fazla test ürettiğiniz için CI çalıştırmalarınızı artırıyorsanız, bütçenizin yeni tempoya uygun olduğundan emin olun. CI dakikalarını izliyorsanız, limitleri ve seçenekleri gözden geçirmek faydalıdır (bakınız /pricing).

Başarısız testleri bir sonraki AI yinelemesine rehber olarak kullanma

Yapay zeka ile çalışmanın şaşırtıcı derecede etkili yolu, başarısız testleri "bir sonraki prompt" olarak kullanmaktır. Modelden genişçe "özelliği geliştir" demek yerine somut bir hatayı verirsiniz ve bu hata değişikliği sınırlar.

İş akışı: hata → prompt → düzeltme → tekrar

- Test paketini (veya CI'yi) çalıştırın ve tek bir başarısızlık yakalayın. Başarısız test adını ve ilgili assertion mesajını/stack trace'i kopyalayın.

- Yapay zekadan yalnızca o hatayı gidermesini isteyin. Minimal kod bağlamını sağlayın (başarısız test ve test edilen fonksiyon/modül) ve ihlal edilebilecek iş kuralını ekleyin.

- Önce regresyon testi isteyin. Hata bir rapordan veya üretim sorunudansa, yapay zekadan hatayı çoğaltan veya düzeltilmeden önce yakalayan bir test eklemesini isteyin.

- Testi geçen en küçük değişikliği uygulayın. Testleri hemen yeniden çalıştırın.

- Bir sonraki başarısız teste geçin. Her seferinde bir hata, yinelemeyi sıkı ve anlaşılır tutar.

Prompt kalıbı: küçük ve doğrulanabilir tutun

Bunun yerine:

- "Giriş: oturum açma mantığını düzelt ve testleri güncelle." demeyin.

Kullan:

- "Bu test başarısız:

shouldRejectExpiredToken. İşte hata çıktısı ve ilgili kod. Uygulamayı, genel API'yi değiştirmeden bu testi geçecek şekilde güncelle. Gerekirse, problemi yakalayan bir regresyon testi ekle."

Neden bu geri dönüşleri azaltır

Başarısız testler tahmin oyununu ortadan kaldırır. "Doğru"nun ne olduğunu çalıştırılabilir biçimde tanımlar, böylece sohbet içinde gereksiz pazarlık yapmazsınız. Ayrıca geniş çaplı düzenlemelerden kaçınırsınız: her prompt tek, ölçülebilir bir sonuca odaklanır, insan incelemesini hızlandırır ve yapay zekanın belirtileri düzeltip başka bir şeyi bozduğunu fark etmeyi kolaylaştırır.

Bu, agent-tarzı iş akışlarının avantaj sağlayabileceği yerdir: bir agent en küçük kod değişikliğine odaklanır, başka bir agent test düzenlemesi önerir ve siz diff'i incelersiniz. Koder.ai gibi platformlar bu tarz yinelemeci, sohbet-öncelikli geliştirme akışlarını destekleyecek şekilde tasarlanmıştır—"testler bir sonraki prompttur" yaklaşımını varsayılan moda dönüştürür.

Gösterişli metriklerin peşinden gitmeden başarıyı ölçme

Otomatik test oluşturma test paketini bir gecede büyütebilir—ama "büyüklük" "daha iyi" demek değildir. Amaç güven: regresyonları erken yakalamak, üretim hatalarını azaltmak ve ekibin hareket etmesini sürdürmek.

Gerçek kaliteyi yansıtan metrikler

Aşağıdaki sinyaller, sonuçlarla bağlantılıdır:

- Build geçme oranı (main üzerinde): Merge'ler sık sık kırılıyorsa, oluşturulan testler çok kırılgan olabilir veya promptlar yanlış varsayımlar üretiyor olabilir.

- Dalgalanan test oranı: Testlerin yeniden çalıştırmada ne sıklıkla başarısız/başarılı olduğu. Yükselen bir dalgalanma oranı geliştirici güvenine vergi bindirir.

- Regresyonları tespit etme süresi: Bir hatanın eklenmesinden CI'nin yakalamasına kadar geçen süre. Oluşturulan testler bu pencereyi kısaltmalı.

Kapsamı bir gösterge olarak kullanın, puan olarak değil

Kapsam faydalı bir duman alarmı olabilir—özellikle kritik yolların test edilmediğini bulmak için—ama kolayca manipüle edilebilir. Oluşturulan testler kapsamı şişirebilir ama az değerli doğrulamalar yapabilir. Tercih edin:

- Test başına doğrulama sayısı (küçük bir kontrol)

- (Kullanıyorsanız) mutasyon testi sonuçları

- Davranışı kasten bozduğunuzda testlerin başarısız olup olmadığı

"Yayımdan önce yakalanan hatalar"a odaklanın

Sadece test sayısını veya kapsamı izlerseniz, hacim optimize edersiniz. Yayımdan önce yakalanan hataları takip edin: hataların CI, QA veya staging'de bulunma sayısı. Otomatik test oluşturma düzgün çalışıyorsa bu sayı artar ve üretim olayları azalır.

Kazancın gerçek kalması için temizlik zamanlayın

Oluşturulan test paketleri bakım gerektirir. Periyodik görev planlayın:

- Benzersiz koruma sağlamayan gereksiz testleri kaldırın

- Dalgalanan testleri stabilize edin veya silin

- Örtüşen vaka setlerini daha net, niyeti gösteren testlere konsolide edin

Başarı daha sakin bir CI, daha hızlı geri bildirim ve daha az sürprizdir—gösterişli paneller değil.

Yaygın tuzaklar ve pratik bir yayılma planı

Otomatik test oluşturma kaliteyi hızla artırabilir—ama onu bir yardımcı olarak, yetkili olarak değil, ele almalısınız. En büyük başarısızlıklar ekipler arasında benzer görünür ve önlenebilirdir.

Dikkat edilmesi gereken yaygın tuzaklar

Aşırı güven en klasik tuzaktır: oluşturulan testler güvenlik yanılsaması yaratabilirken gerçek riskleri kaçırır. İnsanlar eleştirel düşünmeyi bırakırsa ("araç test yazdı, o halde tamamız"), hataları daha hızlı gönderirsiniz—sadece daha çok yeşil onay işaretiyle.

Bir diğer sık sorun, davranış yerine uygulama detaylarını test etmektir. AI araçları genellikle mevcut yöntem adlarına, iç yardımcı fonksiyonlara veya tam hata mesajlarına takılır. Bu testler kırılgan olur: refaktörler testi bozar ama özellik çalışmaya devam eder. Testler ne olması gerektiğini açıklamalı, nasıl olduğuna kilitlenmemeli.

Güvenlik ve gizlilik: paylaşmamanız gerekenleri sızdırmayın

Test oluşturma genellikle kod, stack trace, log veya spesifikasyon yapıştırmayı gerektirir. Bu, sırları (API anahtarları), müşteri verilerini veya tescilli mantığı açığa çıkarabilir.

Promptları ve test verilerini hassas bilgiden arındırın:

- Jetonları, kimlik bilgilerini ve iç URL'leri kırpın

- Üretim loglarını kişisel veri içerebileceği için yapıştırmayın

- Test verileri için sentetik örnekler kullanın

- Gerçek vaka paylaşmanız gerekiyorsa anonimleştirin

Barındırılan bir AI geliştirme platformu kullanıyorsanız bile aynı disiplini uygulayın. Platform modern dağıtımlar ve bölge bazlı hosting desteklese bile promptlar ve fixture'lar güvenlik duruşunuzun parçası sayılmalıdır.

Pratik bir yayılma planı (ekiplerin gerçekten uyguladığı)

Küçük başlayın ve rutine dönüştürün:

- Sık değişen bir servis veya modül seçin.

- En yüksek riskli yollar için birim testleri oluşturun (para akışı, izinler, veri dönüşümleri).

- Basit bir CI kuralı ekleyin: yeni AI ile yazılmış özellikler test içermeli (bakınız /blog/ci-checks-for-ai-code).

- Hızlı insan inceleme kontrol listesi zorunlu kılın: "Bu test davranışı doğruluyor mu? Doğru nedenden başarısız olur mu?"

- Regresyonları önlediğinizi gördükten sonra entegrasyon testlerine genişleyin.

Amaç maksimum test değil—AI ile yazılan mantığı dürüst tutan güvenilir geri bildirimdir.