06 Ara 2025·8 dk

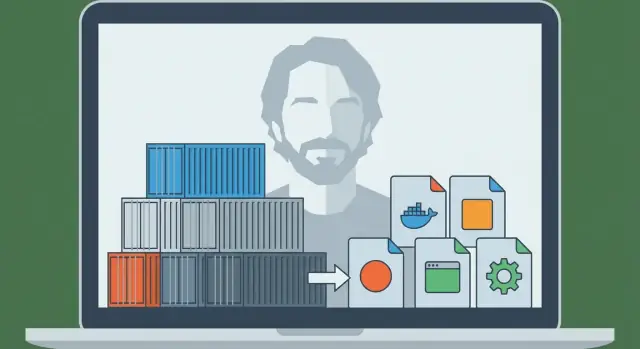

Solomon Hykes ve Docker: Konteynerler Neden Varsayılan Oldu?

Solomon Hykes ve Docker'ın konteynerleri nasıl popülerleştirdiğini öğrenin; Dockerfile'lar, imajlar ve registry'lerin modern uygulamaların paketlenip dağıtılmasında neden standart hâline geldiğini keşfedin.