Khosla'nın “Yapay Zeka Doktorları Değiştirecek” Söyleminden Ne Anlamalıyız

Vinod Khosla “Yapay zeka doktorları değiştirecek” dediğinde genellikle bilimkurgu filmlerindeki insan içermeyen hastanelerden söz etmiyor. Daha keskin, operasyonel bir iddia ortaya koyuyor: özellikle bilgi yoğun işleri yapan, bir hekimin zamanını alan birçok görevin daha hızlı, daha ucuz ve giderek daha doğru yazılımlar tarafından yapılabileceği.

Kapsam: görevlerin değiştirilmesi, şefkatin değil

Khosla'nın çerçevesinde “değiştirme” sıklıkla doktorların günlük olarak yaptıklarının büyük bir kısmının yerine geçmek anlamına gelir; mesleğin ortadan kalkması değil. Bakımın tekrarlayan kısımlarını düşünün: semptom toplama, kılavuzları kontrol etme, olası tanıları sıralama, bir sonraki testleri önermek, kronik durumları izlemek ve riski erken işaretlemek.

Bu yüzden fikir “doktorlara karşı” olmaktan çok “otomasyona eğilimli.” Temel bahis, sağlık hizmetlerinin kalıp dolu olduğu—ve kalıp tanımada ölçeklendirme yapabilen yapay zekanın genellikle üstün olduğu—iddiası.

Bu makale için beklentiler

Bu yazı bu ifadeyi değerlendirilmesi gereken bir hipotez olarak ele alıyor; tezahür veya reddedilecek bir slogan olarak değil. Arkasındaki mantığı, hangi tür sağlık ürünlerinin bununla uyumlu olduğunu ve gerçek kısıtları: düzenleme, güvenlik, sorumluluk ve tıbbın insan yönünü inceleyeceğiz.

Kullanacağımız ana terimler

- Değiştirme: Yapay zeka bir görevi uçtan uca, minimal klinisyen müdahalesiyle gerçekleştirir.

- Destekleme (augment): Yapay zeka yardımcı olur, ancak karar verici klinisyendir.

- Klinisyen: Hasta bakımını sunan lisanslı profesyonel (hekim, hemşire pratisyeni, doktor yardımcısı).

- Tanı: Sadece bir hastalığı adlandırmak değil; olasılık ağırlıklı açıklama oluşturmak ve sonraki eylemleri seçmektir (testler, tedavi, takip).

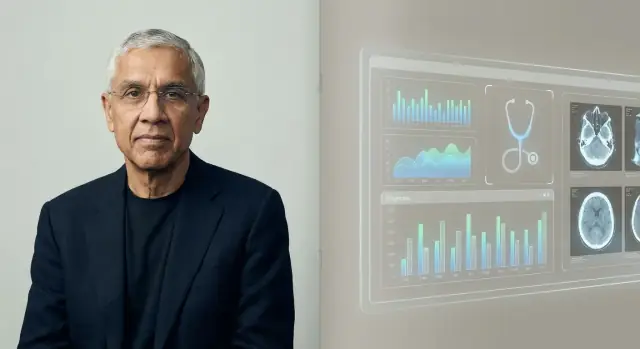

Vinod Khosla Kimdir ve Görüşü Neden Önemli?

Kısa, nesnel bir arka plan

Vinod Khosla, 1980'lerde Sun Microsystems'ın kurucularından biri olarak tanınan ve daha sonra risk sermayesi alanında uzun bir kariyer inşa eden Silikon Vadisi girişimcisi ve yatırımcısıdır. Kleiner Perkins'te geçirilen dönemden sonra 2004'te Khosla Ventures'ı kurdu.

Bu operasyon tecrübesi ile on yılları aşkın yatırımcılık tecrübesinin birleşimi, tıp ve yapay zeka hakkında yaptığı iddiaların teknoloji çevrelerinin ötesinde de yankı bulmasını açıklıyor.

Khosla Ventures tarzı, basitçe

Khosla Ventures genellikle ilk bakışta makul görünmeyen büyük, yüksek inançlı bahisleri destekleme eğiliminde olmasıyla bilinir. Şirket sıklıkla şunlara yönelir:

- karşıtı tezler (pek çok uzmanın başta reddettiği fikirler)

- platform değişimleri (birden çok sektörü yeniden şekillendiren teknolojiler)

- uzun zaman ufukları (düzenleme, benimseme veya altyapı için beklemeye istekli olma)

Bu önemli çünkü “yapay zeka doktorları değiştirecek” gibi tahminler sadece retorik değil—hangi girişimlerin fonlandığını, hangi ürünlerin geliştirildiğini ve yöneticilerin hangi anlatıları ciddiye aldığını etkileyebilir.

Neden sağlık, AI bahisleri için hedef oldu

Sağlık, ekonominin en büyük ve en pahalı parçalarından biri ve görüntüler, laboratuvar sonuçları, notlar, sensör verileri ve sonuçlar gibi yapay zekanın öğrenebileceği sinyallerle dolu. Doğruluk, hız veya maliyetteki küçük iyileşmeler bile anlamlı tasarruflar ve erişim kazanımları sağlayabilir.

Khosla ve firması, triyaj, tanı desteği ve iş akışı otomasyonu gibi alanlarda tıbbın yazılım odaklı değişime uygun olduğunu sıkça savunuyor. “Değiştirme” çerçevesine katılmasanız bile, bu görüş tıbbın geleceğini değerlendiren büyük bir sermaye dilimini ve paranın nereye akacağını yansıttığı için önem taşıyor.

Tahminin Arkasındaki Mantık

Khosla'nın tahmini basit bir iddiaya dayanır: tıbbın büyük bir kısmı—özellikle birincil bakım ve erken triyaj—belirsizlik altında kalıp tanıma işidir. Tanı ve tedavi seçimi birçok durumda "bu sunumu en olası olanla eşleştir" ise, milyonlarca örnekten öğrenebilen bir yazılımın zamanla bireysel klinisyenlerden daha iyi performans göstermesi beklenir.

Ölçeklenmiş kalıp tanıma

İnsanlar kalıpları görmekte iyidir ama hafıza, dikkat ve deneyimle sınırlıyız. Bir yapay zeka sistemi herhangi bir doktorun kariyeri boyunca görebileceğinden çok daha fazla vaka, kılavuz ve sonucu yiyebilir ve sonra bu öğrenilen kalıp eşleştirmesini tutarlı şekilde uygulayabilir. Khosla'nın çerçevesinde, sistemin hata oranı ortalama bir klinisyenin altına düştüğünde, hastalar ve ödeme yapanlar için akıllıca seçim rutin kararları makineye yönlendirmek olur.

Maliyet, erişim ve tutarlılık

Ekonomi diğer zorlayıcı faktördür. Birincil bakım zaman, coğrafya ve personel sıkıntılarıyla kısıtlıdır; muayeneler pahalı, kısa ve kalitede değişken olabilir. Bir AI hizmeti 7/24 erişilebilir, hizmet altındaki bölgelere ölçeklendirilebilir ve daha uniform karar verme sunarak "kime göründüğüne bağlı" problemini azaltabilir.

Neden bu mümkün hale geldi

Erken uzman sistemleri el ile kodlanmış kurallar ve dar veri setlerine dayandığı için zorlanıyordu. Uygulanabilirlik, tıbbi verilerin dijitalleşmesi (EHR'ler, görüntüleme, laboratuvarlar, giyilebilirler) ve hesaplamanın büyük korpuslarda modeller eğitmeyi ve bunları sürekli güncellemeyi pratik hale getirmesiyle gelişti.

Otomasyon vs insan bakımı

Bu mantıkta bile, “değiştirme” çizgisi genellikle rutin tanılar ve protokole dayalı yönetim etrafında çizilir—güven, karmaşık takaslar ve korku, belirsizlik veya hayat değiştiren kararlarda hastaları destekleme gibi tıbbın insan odaklı kısımları değil.

Temel Argümanlar ve Alıntılar (Doğru Bağlamıyla)

Khosla'nın “Yapay zeka doktorları değiştirecek” ifadesi tipik olarak kışkırtıcı bir öngörü olarak sunulur, hastanelerde insan olmayacağına dair kelimesi kelimesine bir vaat değil. Konuşma ve röportajlarında tekrarlanan tema, tıbbın büyük bir kısmının—özellikle tanı ve rutin tedavi kararlarının—yazılımın öğrenebileceği, ölçebileceği ve geliştirebileceği kalıplara uyduğudur.

Argüman 1: Kalıp tanıma insan eğitiminden daha hızlı ölçeklenir

Klinik akıl yürütmeyi semptomlar, öyküler, görüntüler, laboratuvarlar ve sonuçlar arasında bir tür kalıp eşleştirme olarak sıkça çerçeveler. Temel iddia şudur: bir AI modeli belirli bir kalite barına ulaştığında, geniş ölçekte konuşlandırılabilir ve sürekli güncellenebilir—oysa klinisyen eğitimi yavaş, pahalı ve bölgeler arasında dengesizdir.

Khosla'nın çerçevesindeki önemli nüans değişkendir: klinisyenler mükemmel olabilir ama yorgunluk, iş yükü veya nadir vakalara sınırlı maruz kalma nedeniyle tutarsızlık gösterebilir. Yapay zeka ise test, izleme ve yeniden eğitim düzgün yapılırsa daha istikrarlı performans ve potansiyel olarak daha düşük hata oranları sunabilir.

Argüman 3: İkinci görüş varsayılan olur

Yapay zekayı tek ve kesin bir "doktor değiştirici" olarak hayal etmek yerine, en güçlü versiyonu şöyle okunabilir: çoğu hasta önce bir yapay zekaya danışacak ve insan klinisyenler giderek kompleks vakalar, uç durumlar ve yüksek riskli kararlar için denetleyici olacak.

Önemli bağlam: tartışmalı bir öngörü, kesinleşmiş bir gerçek değil

Destekçiler bu duruşu ölçülebilir sonuçlar ve erişim yönünde bir itiş olarak yorumlarken; eleştirmenler gerçek dünya tıbbının belirsizlik, etik ve hesap verebilirlik içerdiğini, ve “değiştirme”nin model doğruluğu kadar düzenleme, iş akışı ve güvene de bağlı olduğunu not eder.

Bu Teze Uyan Sağlık Bahisleri

Khosla'nın “Yapay zeka doktorları değiştirecek” iddiası, risk sermayedarlarının yatırım yapmayı sevdiği sağlık girişimi türleriyle net şekilde örtüşür: hızla ölçeklenebilen, dağınık klinik işleri standardize edebilen ve uzman yargısını yazılıma dönüştürebilen şirketler.

Ana yatırım kategorileri

Bu tezle uyumlu bahislerin çoğu birkaç tekrarlanabilir temaya toplanır:

- Tanı ve erken tespit: laboratuvarlar, semptomlar, öykü ve önceki kayıtları birleştirip tek bir risk puanı oluşturan araçlar.

- Triyaj ve yönlendirme: kimin acil bakıma ihtiyacı olduğunu, kimin kendi kendine tedavi edebileceğini ve hangi uzmana gitmesi gerektiğini belirleyen AI “ön kapıları”.

- Görüntüleme ve sinyal yorumlama: radyoloji, patoloji, dermatoloji fotoğrafları, EKG’ler—kalıp tanımanın merkezi olduğu ve performansın ölçülebileceği alanlar.

- İş akışı otomasyonu: rapor özeti, dokümantasyon, ön onay desteği, kodlama ve gelen kutusu yönetimi—başlık haberleri kadar gösterişli olmasa da klinisyen zamanına doğrudan bağlı.

Neden bu bahisler VC teşvikleriyle uyumlu

Klinisyen ihtiyacını azaltmak (veya küçültmek) büyük bir ödül: sağlık harcamaları muazzam ve emek büyük bir maliyet merkezi. Bu, zaman çizelgelerini cesurca çerçevelemeye teşvik eder—çünkü fonlama net, yüksek getirili bir hikayeyi ödüllendirir; oysa klinik benimseme ve düzenleme yazılımdan daha yavaş hareket edebilir.

Bir nokta çözüm bir işi iyi yapar (ör. akciğer grafilerini okumak). Bir platform triyaj, tanı desteği, takip, faturalama gibi birden fazla iş akışının üzerinde yer almak hedefindedir—paylaşılan veri boru hattı ve modeller kullanır.

“Doktorları değiştirme” anlatısı daha çok platformlara bağlıdır: AI yalnızca dar bir görevin üstesinden gelirse doktorlar uyum sağlar; eğer birçok görevi uçtan uca koordine ederse, klinisyenin rolü denetim, istisnalar ve hesap verebilirlik yönüne kayabilir.

Kurucular bu “platform” fikirlerini keşfederken, erken hız önemlidir: genellikle bir iş akışını test edebilmek için alım akışlarının, klinisyen panolarının ve denetim izlerinin çalışan prototiplerine ihtiyacınız olur. Koder.ai gibi araçlar ekiplerin bir sohbet arayüzünden dahili web uygulamaları (genellikle ön yüzde React, arka uçta Go + PostgreSQL) oluşturmasına, sonra kaynak kodunu dışa aktarmasına ve hızlıca yinelemesine yardımcı olabilir. Klinik kararları etkileyen her şey için yine de uygun doğrulama, güvenlik incelemesi ve düzenleyici strateji gerekir—ancak hızlı prototipleme gerçekçi bir pilot yolunu kısaltabilir.

Yapay Zekanın Klinisyenleri Gerçekçi Olarak Eşleştirip Geçebildiği Yerler

Mobil kontrol noktaları oluşturun

Takipler ve uzaktan anketler için Flutter uygulamalarını sohbet istemlerinden oluşturun.

Yapay zeka zaten belirli, dar klinik iş dilimlerinde insanları geride bırakıyor—özellikle iş çoğunlukla kalıp tanıma, hız ve tutarlılık gerektirdiğinde. Bu “AI doktoru” anlamına gelmez. AI bakımın çok güçlü bir bileşeni olabilir.

Yapay zekanın gerçekten güçlü olduğu görevler

AI, tekrar eden bilgilerin çok olduğu ve net geri bildirim döngülerinin bulunduğu yerlerde parlamaya eğilimlidir:

- Özetleme: uzun dosyaları temiz bir zaman çizelgesine dönüştürme (ilaçlar, laboratuvarlar, önceki tanılar) veya ziyaret notlarını transkriptlerden taslaklama.

- Triyaj: semptomları ve risk faktörlerini aciliyet kovalarına ayırma (evde bakım vs aynı gün ziyaret vs acil servis), özellikle yüksek hacimli ortamlarda.

- Kalıp tespiti: görüntülerde ve dalga formlarında (radyoloji, dermatoloji fotoğrafları, EKG) ince sinyalleri bulma ve insanın yorgun veya aceleci olduğu zamanlarda kaçırabileceği laboratuvar trendlerinin kombinasyonlarını fark etme.

Bu alanlarda “daha iyi” genellikle daha az kaçırılmış bulgu, daha standart kararlar ve daha hızlı dönüş süresi demek.

Klinik karar desteği vs otonom tanı

Bugünün çoğu gerçek dünya kazanımı klinik karar desteği (CDS) şeklinde: AI muhtemel durumları önerir, tehlikeli alternatifleri işaretler, bir sonraki testleri önerir veya kılavuz uyumunu kontrol eder—bir klinisyen ise hesap verebilirliğini korur.

Otonom tanı (AI'nin uçtan uca kararı vermesi) dar, iyi tanımlanmış bağlamlarda mümkündür—örneğin sıkı protokollerle yürütülen tarama iş akışları—ama çoklu komorbiditeli karmaşık hastalar için varsayılan değildir.

Yakalama: veri kalitesi ve temsil edilebilirlik

AI'nın doğruluğu eğitim verisinin hasta popülasyonu ve bakım ortamıyla güçlü şekilde eşleşmesine bağlıdır. Modeller şu durumlarda sapma gösterebilir:

- hastanenin farklı ekipman veya dokümantasyon stilleri kullanması,

- hasta karmasının farklı olması (yaş, etnik köken, komorbiditeler),

- “gerçek etiket”lerin tutarsız olması.

Neden insan denetimi hâlâ önemli

Yüksek riskli ortamlarda denetim isteğe bağlı değildir—uç durumlar, alışılmadık sunumlar ve değer temelli yargı (hastanın neyi yapmaya, tolere etmeye veya önceliklendirmeye istekli olduğu) için güvenlik katmanıdır. AI görmede mükemmel olabilir, ama klinisyenler bunun bugün bu kişi için ne anlama geldiğine karar vermelidir.

Yapay Zekanın Hâlâ Eksik Olduğu Yerler

AI kalıp eşlemede, kayıt özetlemede ve olası tanıları önermede etkileyici olabilir. Ama tıp sadece bir tahmin görevi değildir. En zor kısımlar, “doğru” cevabın net olmadığı, hastanın hedeflerinin kılavuzlarla çeliştiği veya bakım etrafındaki sistemin dağınık olduğu zamanlarda ortaya çıkar.

Güven, yatarak bakım ve ortak kararlar

İnsanlar yalnızca bir sonuç istemezler—duyulmak, inanılmak ve güvende hissetmek isterler. Bir klinisyen korku, utanç, kafa karışıklığı veya ev içi riskleri fark edebilir, sonra konuşmayı ve planı buna göre ayarlayabilir. Ortak karar verme ayrıca yan etkiler, maliyet, yaşam tarzı, aile desteği gibi takasları müzakere etmeyi gerektirir; bu güveni zaman içinde inşa eder.

Belirsizlik, çoklu komorbidite ve nadir vakalar

Gerçek hastalar genellikle birden çok duruma, eksik öykülere ve temiz şablona uymayan semptomlara sahiptir. Nadir hastalıklar ve atipik sunumlar yaygın problemlere benzer görünebilir—ta ki farklı oldukları ortaya çıkana kadar. AI makul öneriler üretebilir, ama “makul” klinik olarak kanıtlanmış ile aynı şey değildir, özellikle ince bağlam (son seyahat, yeni ilaçlar, sosyal faktörler, "bir şeyler yanlış hissettiriyor") önemliyse.

AI yanlış yaptığında hesap verebilirlik

Oldukça doğru bir model bile bazen başarısız olur. Zor soru: kim sorumluluğu üstlenir: aracı takip eden klinisyen mi, aracı konuşlandıran hastane mi, yoksa sağlayıcı mı? Net hesap verebilirlik ekiplerin ne kadar temkinli olması gerektiğini ve hastaların nasıl başvuruda bulunabileceğini etkiler.

Operasyonel gerçeklik: kliniklere ve EHR'lere uyum

Bakım iş akışları içinde gerçekleşir. Bir AI aracı EHR'lerle, siparişleme sistemleriyle, dokümantasyon ve faturalama ile temiz entegrasyon sağlayamıyorsa—veya tıklama ve belirsizlik ekliyorsa—meşgul ekipler demoda ne kadar iyi görünse de ona güvenmez.

Tıbbi Yapay Zekada Düzenleme, Etik ve Güvenlik

Tıbbi AI sadece mühendislik sorunu değil—bir güvenlik sorunudur. Yazılım tanı veya tedaviyi etkilediğinde, düzenleyiciler onu tipik bir uygulamadan çok bir tıbbi cihaz gibi ele alır.

FDA ve CE denetimi: temel bilgiler

ABD'de, FDA tanı koyan, tedavi öneren veya doğrudan bakım kararlarını etkileyen birçok “Software as a Medical Device” aracını düzenler. AB'de, MDR kapsamındaki CE işareti benzer bir rol üstlenir.

Bu çerçeveler aracın güvenli ve etkili olduğuna dair kanıt, kullanım amacı hakkında netlik ve konuşlandırıldıktan sonra sürekli izleme gerektirir. Kurallar önemlidir çünkü demoda etkileyici görünen bir model gerçek kliniklerde başarısız olabilir ve gerçek hastalar üzerinde etkileri olur.

Büyük bir etik risk, farklı yaş grupları, cilt tonları, diller veya komorbiditeler arasında değişken doğruluktur. Eğitim verileri bazı grupları az temsil ediyorsa, sistem belirli gruplarda tanıları kaçırabilir veya gereksiz müdahaleleri aşırı önerebilir. Adalet testi, altgrup raporlaması ve dikkatli veri seti tasarımı temel güvenlik gereksinimleridir.

Gizlilik, onam ve hasta verileri

Modelleri eğitmek ve geliştirmek genellikle büyük miktarda hassas sağlık verisi gerektirir. Bu, onam, ikincil kullanım, kimliksizleştirme sınırları ve kimin finansal olarak fayda sağladığı gibi soruları gündeme getirir. İyi yönetişim net hasta bildirimleri, sıkı erişim kontrolleri ve veri saklama ile model güncellemeleri politikalarını içerir.

Güvenlik deseni olarak “insan döngüde”

Birçok klinik AI aracı yardım edecek şekilde tasarlanır, değiştirmeyecek şekilde—nihai karar için bir klinisyeni sorumlu tutarak. Bu “insan döngüde” yaklaşımı hataları yakalayabilir, modelin kaçırdığı bağlamı sağlayabilir ve hesap verebilirlik yaratabilir—ancak iş akışları ve teşvikler kör otomasyonu engelleyecek şekilde düzenlenmelidir.

Bu Doktorlar ve Sağlık İşleri İçin Ne Anlama Geliyor

Tıbbi AI pilotunuzu planlayın

Ekranları, verileri ve rolleri yazmadan önce Planlama Modu ile eşleyin.

Khosla'nın iddiası genellikle “doktorlar gereksiz olacak” şeklinde algılanır. Daha kullanışlı bir okuma, değiştirme (AI bir görevi insan girdisi olmadan yapar) ile yeniden tahsis (insanlar sonuçların sahibi olmaya devam eder, ancak iş gözetim, empati ve koordinasyona kayar) arasındaki ayrımı yapmaktır.

Değiştirme vs yeniden tahsis

Birçok ortamda AI ilk önce klinik işlerin parçalarını değiştirebilir: notların taslaklarını oluşturma, diferansiyel tanıları ortaya çıkarma, kılavuza uyumu kontrol etme ve hasta öyküsünü özetleme. Klinisyenin işi, cevap üretmekten bunları denetleme, bağlamsallaştırma ve iletişim kurma yönüne kayar.

Hangi roller önce değişir

Birincil bakım değişimi “ön kapı” triyajı iyileştikçe hissedebilir: semptom denetleyicileri ve ortam bazlı dokümantasyon rutin ziyaret süresini azaltırken, karmaşık vakalar ve ilişkiye dayalı bakım insan liderliğinde kalır.

Radyoloji ve patoloji daha dijital ve kalıp tabanlı oldukları için daha doğrudan görev değişimi görebilir. Bu, uzmanların bir gecede azalması anlamına gelmez—daha ziyade daha yüksek verim, yeni kalite iş akışları ve geri ödeme üzerinde baskı anlamına gelir.

Hemşirelik tanıdan daha çok sürekli değerlendirme, eğitim ve koordinasyon ile ilgilidir. AI idari yükü azaltabilir ama yatak başı bakım ve yükseltme kararları insan merkezli kalır.

Ortaya çıkan yeni işler

Şunlarda büyüme bekleyin: AI denetleyicisi (model performansını izleyen), klinik informatik (iş akışı + veri sorumluluğu) ve bakım koordinatörü (modelin işaretlediği boşlukları kapatan). Bu roller mevcut ekiplerin içinde ortaya çıkabilir.

Eğitim ve yetkilendirme

Tıp eğitimi AI okuryazarlığını ekleyebilir: çıktıları nasıl doğrulayacağınızı, güvenilmezlik modlarını nasıl belgeleyeceğinizi ve başarısızlık modlarını nasıl tespit edeceğinizi öğretir. Yetkilendirme “insan döngüde” standartlarına evrilebilir—kim hangi araçları hangi denetimle kullanabilir ve AI yanlış yaptığında hesap verebilirlik nasıl atanır gibi.

Khosla'nın Görüşüne Yönelik En Güçlü Karşı Argümanlar

Khosla'nın iddiası “doktoru” çoğunlukla bir tanı motoru olarak ele aldığı için kışkırtıcıdır. En güçlü itiraz, AI klinisyenlerle kalıp tanımada eşitleşse bile doktorları değiştirmek farklı bir iştir demektir.

Tıp tanıdan daha fazlasıdır

Klinik değerin büyük bir kısmı problemi çerçevelemede yatar, sadece cevabı vermede değil. Doktorlar dağınık hikayeleri uygulanabilir seçeneklere çevirir, risk, maliyet, zaman ve değerlerin takaslarını müzakere eder ve uzmanlar arasında koordinasyonu sağlar. Ayrıca onam, belirsizlik ve "izleme"—güven ve hesap verebilirliğin doğruluğu kadar önemli olduğu alanlar—işin bir parçasıdır.

Kanıt boşlukları: denemeler, sonuçlar ve genelleme

Birçok AI sistemi retrospektif çalışmalarda etkileyici görünür, ama bu gerçek dünyada sonucu iyileştirmekle aynı şey değildir. En zor kanıt prospektif kanıttır: AI kaçırılan tanıları, komplikasyonları veya gereksiz testleri farklı hastanelerde, hasta gruplarında ve iş akışlarında azaltıyor mu?

Genelleme bir diğer zayıf nokta. Popülasyon değiştiğinde, ekipman farklı olduğunda veya dokümantasyon alışkanlıkları kaydığında modeller bozulabilir. Bir sitede iyi performans gösteren sistem başka yerde tökezleyebilir—özellikle nadir durumlar için.

Otomasyon yanlılığı ve aşırı güven

Güçlü araçlar yeni hata modları yaratabilir. Klinisyenler model yanlış olduğunda ona güvenebilir (otomasyon yanlılığı) veya kenar durumları yakalayan ikinci soruyu sormayı bırakabilir. Zamanla beceriler körelirse insanlar “lastik damga” olurlar ve AI belirsiz veya hatalı olduğunda müdahale etmek zorlaşır.

Teknoloji çalışsa bile benimseme gecikebilir

Sağlık saf bir teknoloji pazarı değildir. Sorumluluk, geri ödeme, tedarik döngüleri, EHR entegrasyonu ve klinisyen eğitimi dağıtımı yavaşlatır. Hastalar ve düzenleyiciler yüksek riskli kararlar için insan karar vericisi talep edebilir—bu da “her yerde AI”nın uzun süre “doktorlar tarafından denetlenen AI” gibi görünmesine sebep olabilir.

Hastalar İçin Pratik Çıkarımlar

Öğrenirken kredi kazanın

Yapınızı paylaşarak veya ekip arkadaşlarınızı Koder.ai'ye davet ederek kredi kazanın.

Yapay zeka zaten bakımda sessizce yer alıyor—kaydınızdaki risk puanları, taramalarda otomatik okumalar, semptom denetleyicileri ve kimin önce görülmesi gerektiğini önceliklendiren araçlar. Hastalar için amaç “AI'ya güven” veya “AI'yı reddet” değil; ne beklemeniz gerektiğini bilmek ve kontrolü elinizde tutmaktır.

Ne bekleyebilirsiniz (iyi ve daha az iyi)

Yoğun kliniklerde ve acil servislerde daha fazla tarama (mesajlar, anketler, giyilebilir verisi) ve daha hızlı triyaj görebilirsiniz. Bu yaygın sorunlarda daha hızlı cevaplar ve bazı durumlarda erken tespit sağlayabilir.

Kalite karışık olacaktır. Bazı araçlar dar görevlerde mükemmeldir; diğerleri yaş grupları, cilt tonları, nadir hastalıklar veya dağınık gerçek dünya verisi karşısında tutarsız olabilir. AI'yı nihai hüküm değil, bir yardımcı olarak değerlendirin.

AI devreye girdiğinde sorulacak sorular

- Tanı, görüntüleme yorumu, triyaj veya tedavi önerilerinde AI kullanıldı mı?

- Hangi verileri kullandı (öyküm, laboratuvarlarım, görüntülerim, giyilebilir verim)?

- Benim gibi hastalarda doğrulandı mı (yaş, cinsiyet, etnik köken, durumlar)?

- Nihai karardan kim sorumlu—kliniğim mi yoksa yazılım mı?

- Önerinin arkasındaki mantığı veya kanıtı görebilir miyim?

AI çıktılarını nasıl yorumlamalı

Pek çok AI çıktısı bir kesinlik değil, olasılıktır (“%20 risk”). Bu sayının sizin için ne anlama geldiğini sorun: farklı risk seviyelerinde ne olur ve yanlış alarm oranı nedir.

Öneri yüksek riskliyse (ameliyat, kemoterapi, bir ilacı bırakma), insan ve/veya farklı bir araç tarafından ikinci görüş isteyin. "Bu AI sonucu olmasaydı ne yapardınız?" demek makul bir sorudur.

Bilgilendirilmiş onam ve şeffaflık

Yazılım önemli ölçüde kararlara yön veriyorsa size söylenmelidir. Rahatsızsanız alternatifleri, verilerinizin nasıl saklandığını ve çıkmayı seçmenin bakım erişimini etkileyip etkilemeyeceğini sorun.

Klinikler ve Sağlık Ekipleri İçin Pratik Çıkarımlar

AI'yı sağlıkta benimsemek, onu herhangi bir klinik araç gibi ele aldığınızda en kolay: kullanım amacını tanımlayın, test edin, izleyin ve hesap verebilirliği görünür kılın.

Risk düşük, hacim yüksek yerlerden başlayın

Tanı için AI kullanmadan önce, günlük sürtüşmeyi azaltmak üzere kullanın. En güvenli erken kazanımlar tıbbi karar vermeyen ancak verimi artıran iş akışlarıdır:

- Dokümantasyon desteği (ziyaret notları, sonrasında verilen özetler)

- Planlama, sevkler, ön onay taslakları

- Hasta mesajlaşma triyajı ve yönlendirme

Bu alanlar genellikle ölçülebilir zaman tasarrufu sağlar ve ekiplerin değişimi yönetme konusunda güven inşa etmesine yardımcı olur. Eğer ekibiniz bu iş akışlarını destekleyecek hafif iç araçlara ihtiyaç duyuyorsa—alım formları, yönlendirme panoları, denetim kayıtları—hızlı uygulama oluşturma model kalitesi kadar değerli olabilir. Koder.ai gibi platformlar ekiplerin sohbetle uygulama tanımlayıp hızla yinelemesine yöneliktir. Klinik bağlamlar için bunu operasyon yazılımlarını ve pilotları hızlandırmanın bir yolu olarak değerlendirin; gerekli güvenlik, uyumluluk ve doğrulama çalışmalarını yapmayı unutmayın.

Dağıtımdan önce basit bir değerlendirme kontrol listesi

Hastaya dokunan herhangi bir AI sistemi için bile—dolaylı olsa bile—kanıt ve operasyonel kontroller talep edin:

- Doğruluk: sadece satıcı demolarına değil, kendi hasta karmanıza göre doğrulayın

- Yanlılık testi: yaş, cinsiyet, ırk/etnik köken, dil ve komorbiditeler bazında performansı kontrol edin

- İzleme: sapma kontrolleri, uyarı eşikleri ve müdahale edecek kişiyi tanımlayın

- Denetim izleri: girdileri, çıktıları, model/sürüm ve klinisyenin aldığı aksiyonları kaydedin

Bir satıcı modelin nasıl değerlendirildiğini, güncellendiğini ve denetlendiğini açıklayamıyorsa bunu bir güvenlik sinyali olarak değerlendirin.

Ağrılı başarısızlıkları önleyen uygulama temelleri

"Bunu nasıl kullanıyoruz"u "ne yaptığı" kadar açık hale getirin. Klinikilere yaygın hata modlarını içeren eğitim verin ve açık yükseltme yolları (ne zaman AI'yı görmezden gelmeli, ne zaman bir meslektaşa sormalı, ne zaman sevk yapmalı, ne zaman ED'ye göndermeli) oluşturun. Performans incelemeleri ve olay raporlaması için bir sahip atayın.

Yardım seçmek, pilot etmek veya yönetişim kurmak istiyorsanız, paydaşların destek talep edebileceği dahili bir yol ekleyin (görünür metin: /contact veya /pricing gibi).

Gerçekçi Bir Zaman Çizelgesi ve Sonraki İzlenecekler

“Yapay zeka doktorları değiştirecek” tahminleri, tıbbı tek bir iş ve tek bir bitiş çizgisi gibi ele aldıklarında başarısız olma eğilimindedir. Değişimin daha gerçekçi görünümü, uzmanlık, ortam ve görev bazında düzensiz geleceğidir—ve teşviklerle kurallar nihayet uyum sağladığında hızlanır.

Kısa vadeli vs uzun vadeli beklentiler (tarihi bilmiyormuş gibi)

Kısa vadede en büyük kazançlar muhtemelen “iş akışı kazanımları”dır: daha iyi triyaj, daha net dokümantasyon, daha hızlı ön onaylar ve bariz hataları azaltan karar destekleri. Bunlar hastaları makineye yalnızca güvenmeye zorlamadan erişimi genişletebilir.

Uzun vadede, veri bol ve sonuçlar ölçülebilir olan standartlaştırılmış, yüksek hacimli bakımda kim ne yapar sorusunda kademeli kaymalar göreceksiniz.

“Değiştirme”nin aşamalı görünümü

Değiştirme nadiren doktorların yok olması demektir. Şöyle görünebilir:

- Yardımcı: AI önerir, özetler ve riskleri işaretler; klinisyenler birincil karar vericidir.

- Denetleyici: klinisyenler AI liderliğindeki değerlendirmeleri gözetir, uç durumlar ve hesap verebilirlik için devreye girer.

- Otomatikleştirme: dar, iyi tanımlanmış problemler için AI tüm döngüyü (tarama → karar → takip) insan müdahalesine ihtiyaç duymadan yönetir; insan ise yükseltme gerektiğinde devreye girer.

İzlenmesi gereken sinyaller

- Geri ödeme: sigortacıların AI destekli ziyaretler, uzaktan izleme veya otonom tarama için ödeme yapması.

- Düzenleyici onaylar: yalnızca “destek” değil, klinik kararları yapmak veya yürütmek için onaylanmış araçlar.

- Sorumluluk normları: AI yanlış yaptığında kim sorumlu olur—sağlayıcı, klinisyen veya sağlık sistemi gibi daha net kurallar.

Dengeleyici çıkarım: ilerleme gerçek ve kimi zaman şaşırtıcı olacaktır, ama tıp sadece kalıp tanıma değildir. Güven, bağlam ve hasta merkezli bakım insanları merkezde tutmaya devam edecek—araç seti değişse bile.