2025年7月25日·2 分钟

大型语言模型如何把普通英文想法变成全栈应用

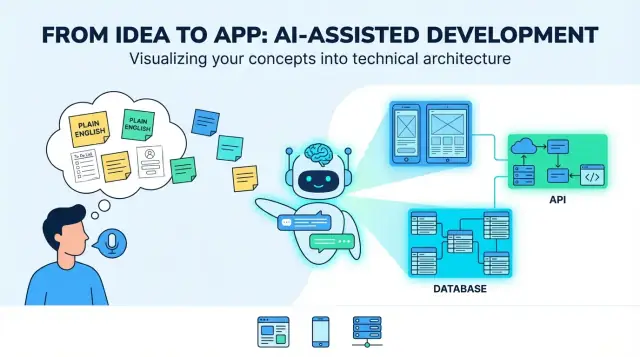

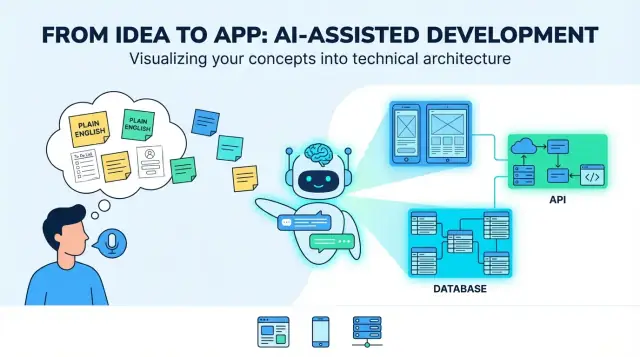

大型语言模型如何将普通英语的产品想法转为 Web、移动与后端应用:需求、UI 流程、数据模型、API、测试与部署。

大型语言模型如何将普通英语的产品想法转为 Web、移动与后端应用:需求、UI 流程、数据模型、API、测试与部署。

一个“普通英语的产品想法”通常以意图和希望的混合开始:它的目标用户是谁、它解决什么问题、以及成功看起来像什么。可能只是几句话(“一个用于安排遛狗服务的应用”)、一个粗略的工作流(“客户请求 → 遛狗者接受 → 支付”),以及几条必备项(“推送通知、评分”)。这些足够用来讨论想法,但不足以可靠地构建。

当人们说 LLM 可以“把想法翻译成应用”时,实用的含义是:把模糊的目标变成具体、可测试的决策。这种“翻译”不仅仅是改写——而是增加结构,以便你能审查、质疑并实现它。

LLM 擅长产出核心构建块的初稿:

典型的“最终产物”看起来像一个全栈产品的蓝图:一个 Web 界面(通常用于管理员或桌面任务)、一个移动界面(面向移动用户)、后端服务(认证、业务逻辑、通知)以及数据存储(数据库加文件/媒体存储)。

LLM 无法可靠地替你做出产品权衡,因为正确答案依赖于你可能没写下的上下文:

把模型当作提出选项和默认值的系统,而不是最终真理。

最大的失败模式是可预见的:

“翻译”的真正目标是把假设可视化——以便在它们变成代码之前,你能确认、修改或拒绝它们。

在 LLM 将“为 X 构建一个应用”变成屏幕、API 和数据模型之前,你需要一个足够具体可以据以设计的产品简报。这一步是把模糊意图变成共同目标。

用一两句话写出问题陈述:谁遇到困难、遇到什么困难、为什么重要。再加上可观测的成功指标。

例如:“减少诊所安排随访预约所需的时间。”指标可以包括平均安排时间、爽约率或通过自助预约的患者百分比。

列出主要用户类型(不是所有可能接触系统的人)。为每种用户定义一个首要任务和简短场景。

一个有用的提示模板是:“作为 [角色],我想 [做某事],以便 [收益]。”目标是 3–7 个描述 MVP 的核心用例。

约束是原型与可发布产品的差别。包括:

明确说明首发包含什么、哪些推后。一个简单规则:MVP 功能必须端到端支持主要用例,无需人工绕行。

如果愿意,把它做成一页简报,并作为下一步(需求、UI 流与架构)的“事实来源”。

一个普通英语的想法通常是目标(“帮助人们预订课程”)、假设(“用户会登录”)和模糊范围(“要简单”)的混合。LLM 在这里的作用是把混乱的输入变成你可以审查、修正并批准的需求。

从把每句话改写为用户故事开始。这会强制明确谁需要什么以及为什么:

如果一个故事没有指明用户类型或收益,说明它仍然太模糊。

接着,把故事分组为功能,并将每项标为 must-have 或 nice-to-have。这有助于在设计与工程开始前防止范围蔓延。

例如:“推送通知”可以是 nice-to-have,而“取消预订”通常是 must-have。

在每个故事下加入简单、可测试的规则。好的验收标准是具体且可观察的:

LLM 常默认快乐路径,所以明确请求边界情况,例如:

这个需求包将成为你用来评估后续输出(UI 流、API 和测试)的事实来源。

当普通英语想法转成用户旅程与由清晰导航连接的屏幕时,它才变得可构建。在这一步,你不需要选颜色——你要定义人们可以做什么、按什么顺序,以及成功是什么样子。

从列出最重要的路径开始。对于很多产品,可以把它们结构化为:

模型可以把这些流草拟为逐步序列。你的工作是确认哪些是可选的、哪些是必须的,以及用户在何处可以安全退出与恢复。

要求两个交付物:一个屏幕清单和一个导航图。

好的输出会统一命名屏幕(例如 “Order Details” vs “Order Detail”),定义入口点,并包含空状态(无结果、无已保存项)。

把需求转为表单字段与规则:必填/可选、格式、限制与友好错误信息。例如:密码规则、支付地址格式或“日期必须是未来时间”。确保校验在用户输入时(内联)和提交时都执行。

包括可读的字号、清晰对比度、Web 的完整键盘支持,以及解释如何修复问题的错误信息(而不仅仅是“输入无效”)。还要确保每个表单字段有标签且焦点顺序合理。

“架构”是应用的蓝图:有哪些部分、每部分负责什么、它们如何互相通信。当 LLM 提出架构时,你的任务是确保它既足够简单以便现在构建,又足够清晰以便未来演进。

对多数新产品,单一后端(单体) 是合适的起点:一个代码库、一次部署、一个数据库。它构建更快、调试更容易、运营成本更低。

模块化单体 通常是折衷:仍然一次部署,但按模块组织(Auth、Billing、Projects 等),边界清晰。把服务拆分的时机留到真的有压力时——例如流量很大、团队需要独立部署或某部分扩展需求不同。

如果 LLM 立即建议“微服务”,要求其用具体需求而非未来假设来证明其必要性。

好的架构提纲会列出必需项:

模型还应说明每块“放在哪儿”(后端 vs 移动 vs Web),并定义客户端如何与后端交互(通常是 REST 或 GraphQL)。

除非把基础钉死,否则架构会含糊:后端框架、数据库、托管与移动策略(原生 vs 跨平台)。要求模型把这些作为“假设”写出来,让所有人知道设计基于哪些前提。

别一开始大刀阔斧改写,偏好小的“逃生门”:热读缓存、后台队列、以及无状态的应用服务器以便后续扩容。最好的架构提案会解释这些选项,同时保持 v1 简单。

产品想法里通常充满名词:“用户”、“项目”、“任务”、“支付”、“消息”。数据建模是 LLM 将这些名词转换为共享的存储图景——以及它们如何相互关联——的步骤。

先列出关键实体并问:什么属于什么?

例如:

然后定义关系和约束:任务可以在没有项目的情况下存在吗?评论可以编辑吗?项目被归档时任务如何处理?

接着,模型会给出第一版模式(SQL 表或 NoSQL 集合)。保持简洁,关注会影响行为的决定。

一个典型草案可能包括:

重要的是及早捕捉“状态”字段、时间戳与唯一约束(如唯一邮箱)。这些细节会驱动 UI 过滤、通知和报表。

大多数真实应用需要清晰的谁能看什么规则。LLM 应把所有权显式化(owner_user_id)并建模访问(成员/角色)。对于多租户产品(多家公司在同一系统),加入 tenant/organization 实体,并把 tenant_id 关联到需要隔离的所有数据上。

还要定义权限如何强制执行:按角色(admin/member/viewer)、按所有权,或两者结合。

最后,决定哪些必须记录、哪些必须删除。例如:

这些选择能在合规、支持或计费问题出现时避免麻烦。

后端 API 是应用承诺变为真实动作的地方:"保存我的资料"、"展示我的订单"、"搜索列表"。好的输出从用户动作开始,把它们转成一小组清晰的端点。

列出用户交互的主要对象(例如 Projects、Tasks、Messages)。对每个对象定义用户能做什么:

这通常映射到如下端点:

POST /api/v1/tasks(创建)GET /api/v1/tasks?status=open&q=invoice(列表/搜索)GET /api/v1/tasks/{taskId}(读取)PATCH /api/v1/tasks/{taskId}(更新)DELETE /api/v1/tasks/{taskId}(删除)创建任务:用户提交标题和截止日期。

POST /api/v1/tasks

{

"title": "Send invoice",

"dueDate": "2026-01-15"

}

响应返回保存的记录(包括服务器生成字段):

201 Created

{

"id": "tsk_123",

"title": "Send invoice",

"dueDate": "2026-01-15",

"status": "open",

"createdAt": "2025-12-26T10:00:00Z"

}

让模型产出一致的错误格式:

对于重试,偏好在 POST 上使用幂等键并给出清晰指导,例如“5 秒后重试”。

移动客户端更新慢。使用版本化基础路径(/api/v1/...)并避免破坏性更改:

GET /api/version)记录变更安全不是“之后再做”的任务。当 LLM 把你的想法变成应用规格时,你希望安全的默认值是显式的——以免首版生成的功能无意中暴露滥用风险。

让模型推荐一种主要登录方式与备选方式,并说明出问题时如何处理(丢失访问、可疑登录等)。常见选择包括:

说明会话处理(短期访问令牌、刷新令牌、设备登出)以及是否支持多因子认证。

认证识别用户;授权限制访问。鼓励模型选择一个清晰模式:

project:edit、invoice:export),适用于灵活产品好输出会包含示例规则,例如:“只有项目所有者可以删除项目;合作者可以编辑;查看者可以评论。”

让模型列出具体防护措施,而不是泛泛承诺:

还要要求一份基础威胁清单:CSRF/XSS 保护、Secure cookie、以及安全的文件上传处理。

默认最小化数据收集:只收集功能真正需要的数据,并尽可能短期保存。

让 LLM 起草简明文字说明:

如果加入分析,强制提供退出选项(或在必要时要求用户主动同意),并在设置和隐私策略页中清楚记录。

一个好的 LLM 可以把你的需求变成一个相当可用的测试计划——前提是你强制它把一切锚定在验收标准上,而不是泛泛的“应该工作”。

从给模型你的功能清单和验收标准开始,然后让它为每条标准生成测试。可靠的输出包括:

如果某个测试指不回具体的验收标准,那它可能就是噪音。

LLM 也能建议反映真实使用的夹具:混乱的姓名、缺失字段、时区、长文本、网络波动与“几乎重复”的记录。

要求:

让模型加入专门的移动清单:

LLM 很擅长起草测试骨架,但你要审查:

把模型视为快速的测试作者,而不是最终 QA 签字人。

模型可以生成大量代码,但用户只有在你安全发布并能看到上线后的表现时才会受益。这一步是关于可重复的发布流程:每次相同的步骤,最少意外。

在每个 PR 和合并到主分支时运行一个简单 CI:

即使 LLM 写了代码,CI 也是告诉你变更后是否仍可用的工具。

使用三个环境并明确用途:

配置通过环境变量与机密管理(不要写死)。一个好规则:如果改一个值需要改代码,那它可能配置错误。

对于典型全栈应用:

规划三类信号:

这里是 AI 辅助开发变成可运营产品的环节:你不仅生成代码,而且在运行产品。

LLM 能把模糊想法变为看起来完整的计划,但华丽的文字可能掩盖缺口。最常见的失败是可预见的,你可以通过一些可复用的习惯来防止它们。

大多数薄弱输出源自四类问题:

给模型具体材料:

为每个交付物要求检查表。例如,需求在包含验收标准、错误状态、角色/权限与可衡量的成功指标之前不算“完成”。

当规范、API 注记和 UI 想法分散在不同线程时,LLM 输出会漂移。维护一个活文档(即使是简单的 markdown 文件),链接:

再次提示模型时,粘贴最新摘录并说明:"只更新 X 与 Y;保持其余不变。"

如果你边实现边迭代,也有利于用支持快照/回滚的工作流来避免丢失可追溯性。例如,Koder.ai 的“planning mode”很适合这类需求:你可以锁定规范(假设、未决问题、验收标准),从一个对话线程生成 Web/移动/后端脚手架,并依赖快照/回滚以防更改引入回归。代码导出在你希望生成的架构与代码仓库保持一致时尤其有用。

下面示范“LLM 翻译”端到端是什么样子——以及人工在哪些节点应该放慢并做出实际决策。

普通英语想法:“一个宠物保姆市场,宠物主人发布请求、照看者申请,工作完成后释放付款。”

LLM 可把它变成初稿:

POST /requests、GET /requests/{id}、POST /requests/{id}/apply、GET /requests/{id}/applications、POST /messages、POST /checkout/session、POST /jobs/{id}/complete、POST /reviews。这很有用——但还不是“完成”。它是需要验证的结构化提案。

产品决策: 什么样的“申请”算有效?店主能否直接邀请照看者?何时一个请求被视为“已填满”?这些规则影响所有屏幕与 API。

安全与隐私审查: 确认基于角色的访问(业主不能读其他业主的聊天)、保护支付、以及定义数据保留(例如聊天 X 个月后删除)。加入滥用控制:速率限制、垃圾信息防护、审计日志。

性能权衡: 决定哪些操作必须快速且可扩展(搜索/过滤请求、聊天)。这会影响缓存、分页、索引与后台任务的选择。

在试点后,用户可能要求“重复请求”或“部分退款取消”。把这些作为更新后的需求,重新生成或修补受影响的流程,然后重新运行测试与安全检查。

记录“为什么”而不仅是“是什么”:关键业务规则、权限矩阵、API 合同、错误码、数据库迁移,以及简短的发布与事故响应运行手册。这些会让生成的代码在六个月后仍可理解。

在这个语境中,“翻译”指的是把一个模糊的想法转换为具体的、可测试的决策:角色、用户旅程、需求、数据模型、API 和成功衡量标准。

它不仅仅是改写——而是把假设显式化,以便在编写代码之前你可以确认或否决它们。

一个实用的初稿通常包括:

把它当作一个需要你审阅的草案蓝图,而不是最终规范。

因为 LLM 无法可靠地知道你的真实约束或权衡,仍然需要人为决策的包括:

把模型当作提出方案的工具,然后由人来有意识地选择。

让模型有足够可用的上下文去设计:

如果你不能把这交给同事并得到相同理解,那它还没准备好。

把目标转成用户故事 + 验收标准:

一个强有力的包通常包含:

这会成为 UI、API 和测试的“真相来源”。

要求两个交付物:

然后检验:

你的目标是设计行为,而不是视觉风格。

对于大多数 v1 产品,默认选择是单体(或模块化单体)。

如果模型马上提出“微服务”,要它用具体需求(不是未来假设)来证明:流量、独立部署需求或不同部分的扩展差异。更好的做法是准备“逃生舱”:

让 v1 易于交付与调试。

让模型把下面几点写清楚:

数据决策会影响 UI 过滤、通知、报表与安全性,早期明确能避免后续代价高昂的重写。

坚持一致性并考虑移动端使用场景:

/api/v1/...)POST 请求支持幂等 key避免破坏性变更:新增可选字段并保留弃用窗口。

让模型基于验收标准起草测试计划,然后审查:

还要要求真实的测试数据:时区、长文本、近似重复记录、网络抖动。把生成的测试当作起点,而非最终 QA。