2025年11月16日·1 分钟

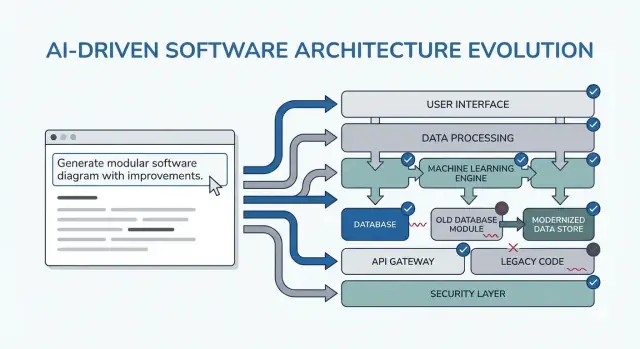

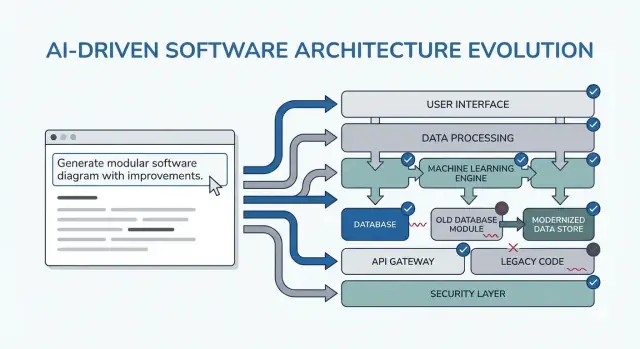

用于更清晰软件架构和更少重写的提示模式

学习经验证的提示模式,引导 AI 得到更清晰的需求、模块化设计和可测试代码——从而减少重构与重写循环。

学习经验证的提示模式,引导 AI 得到更清晰的需求、模块化设计和可测试代码——从而减少重构与重写循环。

本文所说的“更清晰的架构”不是指某个特定框架或完美的图表。它的含义是:你能用简单的话解释系统、在不破坏无关部分的情况下修改它,并在不做大量测试的前提下验证行为。

清晰 意味着从简短描述中能看出系统的目的与形态:它做什么、谁使用、处理哪些数据、以及绝不能做什么。在 AI 辅助的工作流里,清晰还意味着模型可以以你愿意签名确认的方式复述需求。

模块化 意味着职责有清晰边界。每个模块有自己的工作、输入/输出,并尽量少了解其它模块的内部实现。当 AI 生成代码时,模块化能阻止它把业务规则涂抹到控制器、UI 和数据访问层中。

可测试 意味着架构让“证明它可行”变得廉价。业务规则能在无需完整系统运行的情况下被测试,集成测试则关注少数契约而不是每一条代码路径。

重写通常不是因为“代码差”——而是因为缺失的约束、模糊的范围和隐含假设。例如:

AI 会通过快速产出看起来合理的内容来加速这一失败模式,这让基于不稳固基础的构建变得容易。

下面的模式是可适配的模板,不是魔法提示。它们的真正目标是把正确的对话提早强制进行:澄清约束、比较选项、记录假设、定义契约。如果你跳过这些思考,模型会乐意填空——而你以后要为此付出代价。

你会在整个交付周期中使用它们:

如果你在使用一种“vibe-coding”式工作流(通过聊天生成并迭代系统),这些检查点会变得更重要。例如,在 Koder.ai 中,你可以运行一个“规划模式”循环,在生成 React/Go/PostgreSQL 代码前锁定需求和契约,然后用快照/回滚在假设变化时安全迭代——避免每次改动都变成重写。

当提示模式能减少决策震荡时,它们最有价值。诀窍是把它们当作简短且可重复的检查点——在编码前、设计时和评审中使用——这样 AI 产生的是可复用工件,而不是你需要筛选的额外文字。

编码前: 运行一次“对齐”循环以确认目标、用户、约束和成功指标。

设计中: 使用能强制显式权衡的模式(例如备选方案、风险、数据边界)再开始实现。

评审时: 用清单式提示在改动还便宜时找出漏洞(边缘情况、监控、安全、性能)。

带上一小套一致的输入包会得到更好输出:

如果你不知道,就明确说明并让 AI 列出假设。

不要只说“解释设计”,而要请求能直接粘进文档或工单的工件:

做 10–15 分钟的短循环:提示 → 略读 → 收紧。始终包含验收标准(设计被认为可接受的条件),然后让 AI 对照它们自检。这样能防止无休止的重设计,并让后面的模式更快可用。

大多数“架构重写”不是因图画不好,而是因为做了错误(或不完整)的事。使用 LLM 时,不要先要求架构,而是让它揭露模糊点。

把模型当作需求分析师。目标是产出一份简短且有优先级的规格,能在任何人设计组件、选数据库或确定 API 前就被确认。

下面是可复制粘贴的模板:

You are my requirements analyst. Before proposing any architecture, do this:

1) Ask 10–15 clarifying questions about missing requirements and assumptions.

- Group questions by: users, workflows, data, integrations, security/compliance, scale, operations.

2) Produce a prioritized scope list:

- Must-have

- Nice-to-have

- Explicitly out-of-scope

3) List constraints I must confirm:

- Performance (latency/throughput targets)

- Cost limits

- Security/privacy

- Compliance (e.g., SOC2, HIPAA, GDPR)

- Timeline and team size

4) End with: “Restate the final spec in exactly 10 bullets for confirmation.”

Context:

- Product idea:

- Target users:

- Success metrics:

- Existing systems (if any):

### 输出中要注意的点

你希望看到能促成决策的问题(而不是泛泛的“请多说一点”),以及能在你的时间线上完成的 must-have 列表。

把“10 条要点”的重述当作合同:粘到工单/PRD,快速让利益相关者 Yes/No,然后再做架构。这一步能防止最常见的晚期重构原因:为并非真正必要的功能做了实现。

## 模式 2:先写用户旅程,再做技术选择

如果一开始就问“我们应该用事件溯源吗?”之类的问题,你会倾向为工具而设计而不是为用户。更好的路径是让 AI 先描述用户旅程,然后再把这些旅程翻译成组件、数据与 API。

### 一个简单的旅程优先提示模板

可复制粘贴的起点:

- **角色:** user / admin / system

- **关键动作:** 每个角色尝试完成的事情

- **边缘情况:** 会出什么错(无效输入、缺权限、部分完成)

然后要求:

1) “用通俗语言描述每个动作的逐步流程。”

2) “提供简单的状态图或状态列表(例如 Draft → Submitted → Approved → Archived)。”

3) “列出非理想路径:超时、重试、重复请求、取消和无效输入。”

### 把旅程转成决策(不要跳太前)

流程清楚后,你可以要求 AI 把它们映射到技术选择上:

- 哪里需要**验证**,哪里是**业务规则**?

- 哪些步骤需要**幂等性**(安全重试)?

- 什么数据必须**持久化**,什么可以派生,什么需要审计轨迹?

只有在这些清楚后,再请求与流程步骤直接关联的架构草图(服务/模块、边界与职责)。

### 把流程转为可测试的验收标准

最后让 AI 把每个旅程转成可实际测试的验收准则:

- 对每个步骤和失败案例写出“Given/When/Then”。

- 系统应该返回或展示什么?

- 应记录什么,什么应触发重试而非面向用户的错误?

这个模式能让架构基于用户行为成长,而不是基于对技术的假设,从而减少重写。

## 模式 3:假设日志以防止意外重写

大多数架构返工不是因为“设计不好”——而是因为隐藏的假设被证明是错的。当你请求 LLM 生成架构时,它会把空白用看起来合理的猜测填上。假设日志让这些猜测在成本低的时候可见。

### 要求模型做的事情

目标是把**你提供的事实**和**它发明的假设**明确分离。

使用这个提示模式:

> **Template prompt**

> “Before proposing any solution: list your assumptions. Mark each as **validated** (explicitly stated by me) or **unknown** (you inferred it). For each unknown assumption, propose a fast way to validate it (question to ask, metric to check, or quick experiment). Then design based only on validated assumptions, and call out where unknowns could change the design.”

### 一个可复用的“假设日志”格式

保持简短以便实际使用:

- **Assumption:** …

- **Status:** validated / unknown

- **Why it matters:** what decision it affects

- **How to validate:** question, check, or spike

- **If wrong, likely change:** what you’d redesign

### “哪些会改变你的答案?”触发项

加一行让模型告诉你其临界点:

- “列出 5 个触发器:**什么会改变你的答案?**(例如:用户量、延迟目标、合规需求、数据保留规则)。”

这个模式把架构变成一系列有条件的决策。你不仅得到一张图——你得到了一份在确认前需要核实的事项清单。

## 模式 4:在选定之前比较多个架构

AI 工具擅长给出一个“最佳”设计,但那通常只是第一个看起来合理的方案。更清晰的架构经常出现在你强制早期比较时——那时变更成本还低。

### 核心提示模板

使用一个要求给出**多个**架构并带结构化权衡表的提示:

```text

Propose 2–3 viable architectures for this project.

Compare them in a table with criteria: complexity, reliability, time-to-ship, scalability, cost.

Then recommend one option for our constraints and explain why it wins.

Finally, list “what we are NOT building” in this iteration to keep scope stable.

Context:

- Users and key journeys:

- Constraints (team size, deadlines, budget, compliance):

- Expected load and growth:

- Current systems we must integrate with:

比较会迫使模型(和你)显式化隐含假设:状态放在哪里、服务如何通信、哪些必须同步、哪些可以延后。

权衡表很重要,因为它能把“微服务 vs 单体”这类争论从意见驱动变成与你关注点(快速上线、降低运维开销、提升可靠性)相关的决策。

不要接受“看情况而定”的答案。要求明确推荐并说明它优化的具体约束。

还要坚持列出“本次迭代不做”的内容。示例: “MVP 不做多区域故障转移”,“不做插件系统”,“不做实时通知”。这能阻止架构为未承诺的功能悄然扩张,从而避免后来发生的惊喜式重写。

重写常发生于边界模糊:一切都彼此依赖,小变动引发大面修改。该模式使用能在实现之前强制明确模块所有权的提示。

要求 AI 定义模块与职责,并注明每个模块明确不负责的事项。然后请求接口(输入/输出)和依赖规则,而不是构建计划或实现细节。

适用于草拟新功能或重构脏区时:

List modules with:

For each module, define interfaces only:

Dependency rules:

Future change test: Given these likely changes: <list 3>, show which single module should absorb each change and why.

目标是得到可以在一分钟内向同事描述清楚的模块。如果 AI 建议一个“Utils”模块或把业务规则放在控制器里,就要推动它:把决策移到领域模块,让适配器保持轻量。

完成后你会有能经受新需求的边界——因为改动有明确去处,依赖规则也防止了意外耦合。

集成返工往往不是因为“代码差”——而是因为契约不清晰。若数据模型和 API 形状晚确定,每个团队或模块都会自行填空,下一次冲刺你就用时间去对齐不匹配的假设。

在开始谈框架、数据库或微服务前,先提示生成契约。一个明确的契约成为 UI、后端和数据管道之间的共享参考。

尽早对你的 AI 助手使用这个提示:

随后立即要求:

你要的是具体工件,不是长篇描述。例如:

Subscription

以及 API 草图:

POST /v1/subscriptions

{

"customer_id": "cus_123",

"plan_id": "pro_monthly",

"start_date": "2026-01-01"

}

201 Created

{

"id": "sub_456",

"status": "active",

"current_period_end": "2026-02-01"

}

422 Unprocessable Entity

{

"error": {

"code": "VALIDATION_ERROR",

"message": "start_date must be today or later",

"fields": {"start_date": "in_past"}

}

}

让 AI 明确诸如:“增量字段允许无需版本提升;重命名需走 /v2;客户端必须忽略未知字段。”这一步能防止静悄悄的破坏性变更以及随后必须做的重写。

当“快乐路径”设计遇上真实流量、易碎依赖和不可预期用户行为时,架构会被重写。该模式让可靠性成为显式的设计产物,而不是上线后的抢救清单。

在已有架构描述上使用:

List failure modes; propose mitigations; define observability signals.

For each failure mode:

- What triggers it?

- User impact (what the user experiences)

- Mitigation (design + operational)

- Retries, idempotency, rate limits, timeouts considerations

- Observability: logs/metrics/traces + alert thresholds

按可能失败的接口来集中回答:外部 APIs、数据库、队列、认证提供者、后台作业。然后要求具体决策:

以“返回一个我们 2 分钟内能审查的简单检查表”结尾。好的检查表包含:依赖超时设置、重试有界、关键创建/收费操作幂等、限流/背压存在、定义良好的降级路径等项。

要求围绕用户关键时刻定义事件(而不是只有系统内部):“user_signed_up”, “checkout_submitted”, “payment_confirmed”, “report_generated”。对每个事件要求:

这会把可靠性变成一个在代码存在前就能验证的设计工件。

AI 辅助设计常常在早期鼓励“完整”架构,导致过度构建。解决办法是强制从最小的、可用的切片开始——能交付价值、验证设计并保留未来选项。

当解决方案膨胀快于需求时使用:

Template: “Propose the smallest usable slice; define success metrics; list follow-ups.”

要求模型输出:

再补一条:“给出阶段化路线:MVP → v1 → v2,并说明每个阶段降低了哪些风险。”这能把后续想法可视化但不强制进入首发。

示例理想结果:

最有力的一句通常是:“列出对 MVP 明确排除的项。”排除项保护架构决策免于过早复杂化。

好的排除例子:

最后让模型“把 MVP 转成工单,每个工单包含验收标准与依赖”。这强迫清晰并揭示隐藏耦合。一个稳妥的工单拆分通常包含:

可让模型按你团队的格式输出(例如 Jira 字段),把之后阶段留作单独 backlog。

防止架构漂移的简单方法是先强制通过测试说明清晰度。当你让 LLM 先写验收测试时,它必须命名行为、输入/输出与边缘案例,这会自然暴露缺失需求并推动实现清晰的模块边界。

在要设计组件前作为“门槛”提示使用:

接着问:“按模块职责分组测试(API 层、领域逻辑、持久化、外部集成)。对每组说明哪些被 mock、哪些是真实依赖。”

这会把 LLM 从纠结于把一切揉在一起的设计中拉出来。如果它无法说明集成测试从何开始,你的架构可能还不够清晰。

要求:“给出测试数据策略:fixtures vs factories、如何生成边缘案例以及如何保持测试确定性。列出哪些依赖可用内存假体,哪些在 CI 里需要真实服务。”

你常会发现一个“简单”功能实际上需要契约、种子数据或稳定 ID——最好现在发现这些,而不是在重写时。

以轻量检查表结束:

设计评审不能只在代码存在后进行。用 AI,你可以对架构草案做“事前模拟评审”(即使只是几段文字和一个文字图示),获得在变成重写前的具体问题清单。

以直言不讳的审稿人立场开始并强制具体性:

Prompt: “Act as a reviewer; list risks, inconsistencies, and missing details in this design. Be concrete. If you can’t evaluate something, say what information is missing.”

粘入你的设计摘要、约束(预算、时间线、团队技能)和非功能性需求(延迟、可用性、合规)。

评审失败时常因反馈模糊。要求一份有优先级的修复清单:

Prompt: “Give me a prioritized punch list. For each item: severity (Blocker/High/Medium/Low), why it matters, suggested fix, and the smallest validation step.”

这会产出决策就绪的任务,而不是无休的争论。

一个有用的强制手段是简单评分:

Prompt: “Assign a rewrite risk score from 1–10. Explain the top 3 drivers. What would reduce the score by 2 points with minimal effort?”

你不是追求精确度,而是在揭示最易促成重写的假设。

为避免评审导致范围扩张:

Prompt: “Provide a diff plan: minimal changes needed to reach the target design. List what stays the same, what changes, and any breaking impacts.”

当你在每次迭代重复此模式时,架构会通过小而可逆的步骤演进——而重大问题会被提前捕获。

把这个包当作你每个功能都能重复的轻量工作流。要点是串联提示,使每一步产出成为下一步可复用的工件——减少“上下文丢失”和意外重写。

在实践中,团队通常把这条链做成可复用的“功能配方”。如果你在用 Koder.ai,该结构很容易映射到聊天驱动的构建流程:把工件集中保存,生成第一条可工作切片,再用快照迭代以保证实验可回滚。当 MVP 就绪后,你可以导出源码或部署/绑定自定义域——在寻求 AI 加速交付的同时避免被某一环境锁死。

SYSTEM (optional)

You are a software architecture assistant. Be practical and concise.

Guardrail: When you make a recommendation, cite the specific lines from *my input* you relied on by quoting them verbatim under “Input citations”. Do not cite external sources or general industry claims.

If something is unknown, ask targeted questions.

1) REQUIREMENTS CLARIFIER

Context: <product/system overview>

Feature: <feature name>

My notes: <paste bullets, tickets, constraints>

Task:

- Produce: (a) clarified requirements, (b) non-goals, (c) constraints, (d) open questions.

- Include “Input citations” quoting the exact parts of my notes you used.

2) ARCHITECTURE OPTIONS

Using the clarified requirements above, propose 3 architecture options.

For each: tradeoffs, complexity, risks, and when to choose it.

End with a recommendation + “Input citations”.

3) MODULAR BOUNDARIES

Chosen option: <option name>

Define modules/components and their responsibilities.

- What each module owns (and does NOT own)

- Key interfaces between modules

- “Input citations”

4) DATA & API CONTRACTS

For each interface, define a contract:

- Request/response schema (or events)

- Validation rules

- Versioning strategy

- Error shapes

- “Input citations”

5) TEST-FIRST ACCEPTANCE

Write:

- Acceptance criteria (Given/When/Then)

- 5–10 critical tests (unit/integration)

- What to mock vs not mock

- “Input citations”

6) RELIABILITY + DESIGN REVIEW

Create:

- Failure modes list (timeouts, partial failure, bad data, retries)

- Observability plan (logs/metrics/traces)

- Review checklist tailored to this feature

- “Input citations”

如果你想要更深入的配套内容,请参见 /blog/prompting-for-code-reviews。若在评估工具或团队推广,/pricing 是一个实用的后续入口。

“更清晰的架构”在本指南中的含义是:

在 AI 辅助的工作中,这也意味着模型能以你会认可的方式复述需求供签字确认。

AI 能快速产出看起来可信的代码和设计,这会让人在不充分澄清约束和假设的情况下继续构建,从而放大导致重写的触发点,比如:

解决之道不是少用 AI,而是用能把约束、契约和假设早期暴露出来的提示模式。

把这些模式当作能产出可复用工件的短检查点(不是额外的长篇说明):

保持每次迭代在 10–15 分钟:提示 → 略读 → 收紧 → 基于验收标准自检。

带上一小套一致的输入,你会获得更好输出:

如果未知,就明确说明并让模型把假设列出来,而不是私自填空。

请求可以直接粘到文档或工单里的工件,而不是泛泛的文字:

这样能让 AI 的输出更可执行,减少因为“上下文丢失”带来的返工。

把模型当作需求面试官。让它:

把那 10 条当作合同:贴到工单/PRD,快速让相关人 Yes/No,再开始设计。

先从角色和动作开始,然后让模型输出:

在流程清楚后,把它们映射到决策:验证放在哪、业务规则放在哪、哪些步骤需要幂等、什么数据必须存储、什么可推导。最后把流程转成可测试的 Given/When/Then 验收准则。

LLM 常会用合理猜测填补空白,假设日志让这些猜测在早期可见:

还要问“什么情况会改变你的回答?”(例如用户量、延迟目标、合规要求、数据保留),把架构变成有条件的决策地图,从而降低惊喜式重写的概率。

强制模型给出 2–3 个可行架构并做结构化对比(复杂度、可靠性、上线速度、可扩展性、成本)。然后要求:

对比让隐含假设(状态在哪里、服务如何通信、哪些同步/可延迟)浮出水面;“我们不做”条目防止架构悄然膨胀并引发后续重写。

合同优先能避免集成返工:先决定数据模型和 API 形状,再谈框架或服务划分。要让模型产出:

当 UI、后端和集成方共享同一合同工件时,就能大幅减少后期因假设不一致导致的对齐工作。

把可靠性作为设计产出,而不是上线后的抢救清单。让模型针对每个失败模式给出:触发条件、用户影响、缓解措施(设计 + 运营)、重试/幂等/速率限制/超时策略,以及可观测性(日志/指标/追踪 + 告警阈值)。

最后要求一个 2 分钟内可审查的可靠性检查表,包含诸如依赖超时已设置、重试有界、关键操作幂等、限流/降级方案和日志事件(按用户动作命名)等项。

当设计开始膨胀时,强制提出最小可用切片(MVP slice):能交付价值、验证设计并保持后续选项开放的最小功能集。要求模型输出:

并给出阶段化路线(MVP → v1 → v2)与每阶段减少的风险,以及明确排除项(例如:MVP 不做多区域容灾、不做插件系统、只接入一个支付提供商)。把 MVP 拆成带验收准则和依赖的工单,能暴露隐藏耦合并防止过度设计。

在请求设计前先让 LLM 写验收测试,这会迫使它命名行为、输入/输出与边缘情况,从而暴露缺失的需求并推动实现更清晰的模块边界。提示要点:

结束时包含“完成定义”检查表(测试通过、最小文档、监控/告警、灰度/回滚计划),以促进设计能被交付。

在代码存在之前就做“事前评审”。让模型以审稿人姿态列出风险、不一致与缺失细节;如果无法评估某项,就说明缺哪些信息。把反馈转成可执行的修复清单:

重复此过程能让架构通过小且可逆的步骤演进,且把重大问题提前抓住。