19 may 2025·8 min

Crea una aplicación web para analizar cancelaciones y probar la retención

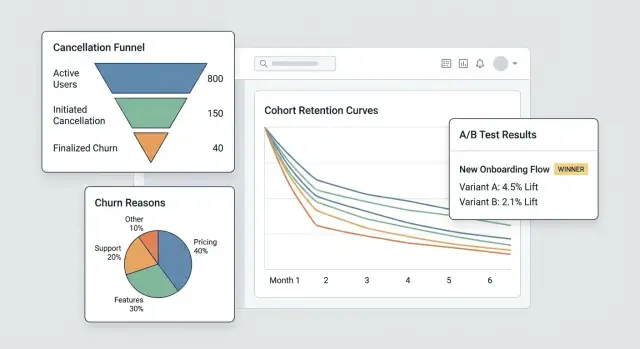

Aprende a planear, construir y lanzar una app web que rastree cancelaciones de suscripción, analice sus causas y ejecute experimentos de retención de forma segura.

Qué vas a construir y por qué importa

Las cancelaciones son uno de los momentos con mayor señal en un negocio de suscripción. Un cliente te está diciendo explícitamente “ya no vale la pena”, a menudo justo después de encontrar fricción, decepción o una discrepancia precio/valor. Si tratas la cancelación como un simple cambio de estado, pierdes una oportunidad rara para aprender qué se está rompiendo —y para arreglarlo.

El problema que estás resolviendo

La mayoría de los equipos solo ven el churn como un número mensual. Eso oculta la historia:

- Quién está cancelando (usuarios nuevos vs. clientes de largo plazo, tipo de plan, segmento)

- Cuándo cancelan (día 1, tras la prueba, después de un aumento de precio, tras un pago fallido)

- Por qué cancelan (demasiado caro, faltan funcionalidades, errores, cambian a un competidor, “no lo uso”)

Esto es lo que significa en la práctica análisis de cancelaciones de suscripción: convertir un clic de cancelación en datos estructurados en los que puedas confiar y segmentar.

Qué significan los “experimentos de retención”

Una vez que puedes ver patrones, puedes probar cambios diseñados para reducir el churn—sin adivinar. Los experimentos de retención pueden ser cambios de producto, precio o mensajes, por ejemplo:

- mejorar el flujo de cancelación (opciones más claras, rutas de downgrade mejores)

- ofrecer una pausa o descuento al segmento correcto

- corregir fallos en la incorporación que se correlacionan con cancelaciones tempranas

La clave es medir el impacto con datos limpios y comparables (por ejemplo, una prueba A/B).

Qué construirás en esta guía

Vas a crear un sistema pequeño con tres partes conectadas:

- Tracking: eventos alrededor del ciclo de vida de la suscripción y del flujo de cancelación, incluyendo razones.

- Un panel: embudos, cohortes y segmentos que revelan de dónde viene el churn.

- Un ciclo de experimentos: la capacidad de ejecutar pruebas dirigidas y ver si el churn realmente baja.

Al final, tendrás un flujo de trabajo que va de “tuvimos más cancelaciones” a “este segmento específico cancela después de la semana 2 por X—y este cambio redujo el churn en Y%”.

Cómo se ve el éxito

El éxito no es un gráfico más bonito: es velocidad y confianza:

- Insights más rápidos (días, no meses)

- Reducción medible del churn vinculada a cambios concretos

- Aprendizaje repetible: cada cancelación te enseña algo accionable

Establece objetivos, métricas y alcance para el MVP

Antes de construir pantallas, tracking o paneles, aclara con rigor qué decisiones debe habilitar este MVP. Una app de análisis de cancelaciones funciona cuando responde unas pocas preguntas de alto valor rápidamente—no cuando intenta medirlo todo.

Empieza con las preguntas que impulsan la acción

Escribe las preguntas que quieres responder en tu primera versión. Buenas preguntas para un MVP son específicas y llevan a pasos obvios, por ejemplo:

- ¿Cuáles son las principales razones de cancelación y cómo difieren por plan, región o canal de inscripción?

- ¿Cuánto tiempo tardan los clientes en cancelar (time-to-cancel) y qué patrones aparecen en los primeros 7/30/90 días?

- ¿Qué planes (o ciclos de facturación) tienen la mayor tasa de cancelación y los usuarios están degradando antes de cancelar?

Si una pregunta no influye en un cambio de producto, playbook de soporte o experimento, déjala para después.

Elige 3–5 métricas “norte” para el MVP

Elige una lista corta que revisarás semanalmente. Mantén definiciones sin ambigüedades para que producto, soporte y liderazgo hablen de los mismos números.

Métricas típicas de inicio:

- Tasa de cancelación (en un periodo definido, p. ej., semanal/mensual)

- Tasa de guardado (porcentaje de intentos de cancelación que terminan en retención)

- Tasa de reactivación (clientes que vuelven tras cancelar)

- Time-to-cancel (días medianos desde el inicio hasta la cancelación)

- Distribución de razones (principales razones por volumen y por impacto en ingresos)

Para cada métrica, documenta la fórmula exacta, la ventana temporal y las exclusiones (pruebas, reembolsos, pagos fallidos).

Nombra a los responsables y las restricciones

Identifica quién usará y mantendrá el sistema: producto (decisiones), soporte/success (calidad de razones y seguimientos), data (definiciones y validación) y engineering (instrumentación y fiabilidad).

Luego acuerda las restricciones desde el inicio: requisitos de privacidad (minimización de PII, límites de retención), integraciones necesarias (proveedor de facturación, CRM, herramienta de soporte), cronograma y presupuesto.

Escribe un alcance de una página para evitar feature creep

Mantenlo corto: objetivos, usuarios principales, las 3–5 métricas, integraciones “imprescindibles” y una lista clara de no objetivos (p. ej., “no suite BI completa”, “sin atribución multi-touch en v1”). Esta página será tu contrato de MVP cuando lleguen nuevas solicitudes.

Modela las suscripciones y los eventos del ciclo de vida

Antes de poder analizar cancelaciones, necesitas un modelo de suscripción que refleje cómo se mueven realmente los clientes por tu producto. Si tus datos solo almacenan el estado actual de la suscripción, te costará responder preguntas básicas como “¿Cuánto tiempo estuvieron activos antes de cancelar?” o “¿Los downgrades predecían churn?”.

Mapea el ciclo de vida que medirás

Empieza con un mapa de ciclo de vida simple y explícito con el que todo el equipo acuerde:

Trial → Active → Downgrade → Cancel → Win-back

Puedes añadir más estados después, pero incluso esta cadena básica obliga a aclarar qué cuenta como “activo” (¿pagado? ¿dentro del periodo de gracia?) y qué cuenta como “win-back” (¿reactivado en 30 días? ¿en cualquier momento?).

Define las entidades principales

Como mínimo, modela estas entidades para que eventos y dinero puedan vincularse consistentemente:

- User: la persona que usa la app (puede cambiar con el tiempo)

- Account: el contenedor de facturación/cliente (a menudo la unidad correcta para churn)

- Subscription: el acuerdo que puede iniciarse, renovarse, cambiar o terminar

- Plan: el nivel de producto (nombre, precio, intervalo de facturación)

- Invoice: lo facturado, cuándo y si fue pagado/reembolsado

- Cancel event: cuándo se solicitó la cancelación y cuándo tomó efecto

Elige identificadores estables (account_id vs user_id)

Para analítica de churn, account_id suele ser el identificador principal más seguro porque los usuarios pueden cambiar (empleados se van, admins cambian). Aun así puedes atribuir acciones a user_id, pero agrega las cancelaciones y retención a nivel de cuenta salvo que vendas suscripciones personales.

Almacena historial de estado, no solo un estado

Implementa un status history (effective_from/effective_to) para poder consultar estados pasados de forma fiable. Esto hace posible el análisis de cohortes y el comportamiento previo a la cancelación.

Planea los casos límite desde el inicio

Modela explícitamente estos casos para que no contaminen los números de churn:

- Pausas (parada temporal sin cancelar)

- Reembolsos/chargebacks (reverso de pago vs churn voluntario)

- Cambios de plan (upgrade/downgrade como eventos, no “nueva suscripción”)

- Periodos de gracia (pago fallido vs cancelación real)

Instrumenta el flujo de cancelación (eventos y razones)

Si quieres entender el churn (y mejorar la retención), el flujo de cancelación es tu momento de la verdad más valioso. Instrúyelo como una superficie de producto, no como un formulario—cada paso debe producir eventos claros y comparables.

Rastrea los pasos clave (y hazlos imposibles de saltar)

Como mínimo, captura una secuencia limpia para poder construir un embudo después:

cancel_started— el usuario abre la experiencia de cancelaciónoffer_shown— se muestra cualquier oferta de retención, opción de pausa, ruta de downgrade o CTA “habla con soporte”offer_accepted— el usuario acepta una oferta (pausa, descuento, downgrade)cancel_submitted— cancelación confirmada

Estos nombres de evento deben ser consistentes entre web/móvil y estables en el tiempo. Si evolucionas el payload, incrementa la versión del esquema (p. ej., schema_version: 2) en lugar de cambiar significados silenciosamente.

Captura contexto que explique por qué sucedió

Cada evento relacionado con cancelación debe incluir los mismos campos de contexto para que puedas segmentar sin adivinanzas:

- plan, tenure, precio

- país, dispositivo

- canal de adquisición

Guárdalos como propiedades en el evento (no inferidos luego) para evitar atribuciones rotas cuando otros sistemas cambien.

Recoge razones de churn que puedas analizar y leer

Usa una lista de razones predefinida (para gráficos) más un campo libre opcional (para matices).

cancel_reason_code(p. ej.,too_expensive,missing_feature,switched_competitor)cancel_reason_text(opcional)

Almacena la razón en cancel_submitted, y considera también registrarla cuando se selecciona por primera vez (ayuda a detectar indecisión o comportamiento de ida y vuelta).

No te quedes en la cancelación: sigue los resultados

Para medir intervenciones de retención, registra resultados posteriores:

reactivateddowngradedsupport_ticket_opened

Con estos eventos puedes conectar la intención de cancelar con los resultados—y ejecutar experimentos sin discutir qué significan los datos.

Diseña tu pipeline de datos y almacenamiento

Un buen análisis de churn comienza con decisiones aburridas hechas bien: dónde viven los eventos, cómo se limpian y cómo todos acuerdan qué es “una cancelación”.

Elige almacenamiento: OLTP + (opcional) warehouse

Para la mayoría de los MVPs, guarda los eventos crudos en la base de datos principal de la app (OLTP) primero. Es simple, transaccional y fácil de consultar para debugging.

Si esperas alto volumen o reporting intensivo, añade un warehouse analítico después (replica de lectura Postgres, BigQuery, Snowflake, ClickHouse). Un patrón común: OLTP como “fuente de verdad” + warehouse para dashboards rápidos.

Tablas core que querrás

Diseña tablas alrededor de “lo que ocurrió” en lugar de “lo que crees que necesitarás”. Un conjunto mínimo:

events: una fila por evento trackeado (p. ej.,cancel_started,offer_shown,cancel_submitted) conuser_id,subscription_id, timestamps y propiedades JSON.cancellation_reasons: filas normalizadas para selecciones de razón, incluyendo feedback de texto opcional.experiment_exposures: quién vio qué variante, cuándo y en qué contexto (feature flag / nombre del test).

Esta separación mantiene tu analítica flexible: puedes unir razones y experimentos a cancelaciones sin duplicar datos.

Eventos tardíos, duplicados e idempotencia

Los flujos de cancelación generan reintentos (botón atrás, problemas de red, refresh). Añade una idempotency_key (o event_id) y aplica unicidad para que el mismo evento no se cuente dos veces.

Decide además una política para eventos tardíos (móvil/offline): típicamente los aceptas, pero usa la timestamp original del evento para análisis y el tiempo de ingestión para debugging.

ETL/ELT para rendimiento en reporting

Aunque no tengas un warehouse completo, crea un job ligero que construya “tablas de reporting” (agregados diarios, pasos de embudo, snapshots de cohortes). Esto mantiene los dashboards rápidos y reduce joins caros sobre eventos crudos.

Documenta definiciones para que las métricas coincidan

Escribe un diccionario de datos corto: nombres de eventos, propiedades requeridas y fórmulas de métricas (p. ej., “la tasa de churn usa cancel_effective_at”). Ponlo en tu repo o docs internas para que producto, data e ingeniería interpreten los gráficos igual.

Construye el panel: embudos, cohortes y segmentos

Escala cuando estés listo

Amplía más allá de lo básico con mayor capacidad cuando aumente tu volumen de eventos y paneles.

Un buen panel no intenta responder cada pregunta a la vez. Debe ayudarte a pasar de “algo se ve mal” a “aquí está el grupo y el paso exacto que lo causa” en un par de clics.

Vistas core que usarás cada semana

Empieza con tres vistas que reflejen cómo la gente investiga el churn:

- Embudo de cancelación: de

cancel_started→ selección de razón →offer_shown→offer_acceptedocancel_submitted. Esto revela dónde la gente abandona y dónde tu flujo de salvado falla o funciona. - Distribución de razones: desglose de razones seleccionadas, con un bucket “Otro (texto libre)” que pueda muestrearse. Muestra tanto conteos como % para que los picos sean obvios.

- Cohortes por mes de inicio: retención o tasa de cancelación por mes de inicio de suscripción. Las cohortes dificultan que te engañen la estacionalidad o cambios en el mix de adquisición.

Segmentos que hacen accionable el insight

Cada gráfico debe ser filtrable por los atributos que afectan el churn y la aceptación de ofertas:

- Plan o nivel

- Tenencia (p. ej., 0–7 días, 8–30, 31–90, 90+)

- Región / país

- Fuente de adquisición (orgánico, pagado, partner, ventas)

- Método de pago (tarjeta, factura, PayPal, etc.)

Mantén la vista por defecto en “Todos los clientes”, pero recuerda: la meta es localizar qué segmento está cambiando, no solo si el churn se movió.

Controles de tiempo y rendimiento del “save flow”

Añade presets de fecha rápidos (últimos 7/30/90 días) más un rango personalizado. Usa el mismo control de tiempo en todas las vistas para evitar comparaciones desalineadas.

Para trabajo de retención, trackea el save flow como un mini-embudo con impacto de negocio:

- Vistas de oferta

- Tasa de aceptación de oferta

- MRR neto retenido (MRR conservado tras descuentos, créditos o downgrades)

Drill-down sin romper la confianza

Cada gráfico agregado debe permitir un drill-down a la lista de cuentas afectadas (p. ej., “clientes que seleccionaron ‘Demasiado caro’ y cancelaron dentro de 14 días”). Incluye columnas como plan, tenencia y última factura.

Bloquea el drill-down tras permisos (control de roles) y considera enmascarar campos sensibles por defecto. El panel debe facilitar la investigación respetando la privacidad y reglas internas de acceso.

Añade un marco de experimentos (A/B tests y targeting)

Si quieres reducir cancelaciones, necesitas una forma fiable de probar cambios (copy, ofertas, timing, UI) sin discutir desde opiniones. Un framework de experimentos es el “control de tráfico” que decide quién ve qué, lo registra y vincula resultados a una variante concreta.

1) Define la unidad del experimento (evita contaminación cruzada)

Decide si la asignación ocurre a nivel de account o user.

- A nivel de cuenta suele ser más seguro para SaaS: todos en el mismo workspace ven la misma variante, evitando mensajes mixtos y resultados contaminados.

- A nivel de usuario puede funcionar en apps de consumo, pero cuidado con dispositivos compartidos, múltiples inicios de sesión o cuentas de equipo.

Escribe esta elección por experimento para que tu análisis sea consistente.

2) Elige un método de asignación

Soporta algunos modos de targeting:

- Aleatorio (A/B clásico): buen default.

- Ponderado (p. ej., 90/10): útil para despliegues cautelosos.

- Reglas: mostrar una variante solo a segmentos específicos (plan, país, tenencia, estado “a punto de cancelar”). Mantén las reglas simples y versionadas.

3) Registra la exposición cuando realmente ocurra

No cuentes “asignado” como “expuesto”. Registra exposición cuando el usuario realmente ve la variante (p. ej., se renderiza la pantalla de cancelación, se abre el modal de oferta). Guarda: experiment_id, variant_id, id de la unidad (account/user), timestamp y contexto relevante (plan, número de asientos).

4) Define métricas: primaria + guardarraíles

Elige una métrica primaria, como tasa de guardado (cancel_started → resultado retenido). Añade guardarraíles para evitar victorias dañinas: contactos a soporte, solicitudes de reembolso, tasa de quejas, time-to-cancel o churn por downgrade.

5) Planifica duración y supuestos de tamaño de muestra

Antes de lanzar, decide:

- Tiempo mínimo de ejecución (a menudo 1–2 ciclos de facturación para comportamiento de suscripción)

- Tamaño mínimo de muestra según la tasa de guardado actual y la menor mejora que te importa detectar

Esto evita detenerse temprano por datos ruidosos y ayuda al panel a mostrar “aún aprendiendo” vs. “estadísticamente útil”.

Diseña intervenciones de retención para probar

Modela eventos y motivos

Crea rápidamente un backend en Go y PostgreSQL para eventos, motivos y exposiciones de experimentos.

Las intervenciones de retención son las cosas que muestras u ofreces durante la cancelación que podrían cambiar la decisión—sin hacer que los usuarios se sientan engañados. El objetivo es aprender qué opciones reducen el churn manteniendo alta la confianza.

Variantes comunes para probar

Empieza con un menú pequeño de patrones que puedas combinar:

- Ofertas alternativas: descuento por tiempo limitado, un mes gratis o extensión de prueba

- Opción de pausa: permitir pausar la facturación 1–3 meses (y fijar expectativas de reactivación)

- Downgrade de plan: cambiar a un nivel más barato o menos asientos en lugar de cancelar

- Copy del mensaje: copy corto y específico que recuerde valor (“Exporta tus datos cuando quieras”) vs. copy genérico (“Lamentamos verte ir”)

Diseña ofertas que no atrapen a los usuarios

Haz cada opción clara y reversible cuando sea posible. La ruta de “Cancelar” debe ser visible y no requerir búsqueda. Si ofreces descuento, di exactamente cuánto dura y a qué precio volverá. Si ofreces pausa, muestra qué pasa con el acceso y las fechas de facturación.

Una buena regla: un usuario debería poder explicar lo que seleccionó en una frase.

Usa disclosure progresivo

Mantén el flujo ligero:

-

Pide la razón (un toque)

-

Muestra una respuesta personalizada (pausa para “demasiado caro”, downgrade para “no lo uso lo suficiente”, soporte para “errores”)

-

Confirma el resultado final (pausa/downgrade/cancel)

Esto reduce fricción y mantiene la experiencia relevante.

Añade una página de resultados y un changelog

Crea una página interna de resultados de experimentos que muestre: conversión al resultado “guardado”, tasa de churn, lift vs. control y un intervalo de confianza o reglas simples de decisión (p. ej., “deploy si lift ≥ 3% y muestra ≥ 500”).

Mantén un changelog de qué se probó y qué se lanzó, para que pruebas futuras no repitan ideas y puedas conectar cambios de retención a despliegues concretos.

Privacidad, seguridad y control de acceso

Los datos de cancelación son algunos de los datos de producto más sensibles que manejarás: a menudo incluyen contexto de facturación, identificadores y texto libre que puede contener datos personales. Trata la privacidad y la seguridad como requisitos de producto, no como algo posterior.

Autenticación y roles

Empieza con acceso autenticado (SSO si puedes). Luego añade roles simples y explícitos:

- Admin: gestiona ajustes, retención de datos, accesos y exportaciones.

- Analyst: ve dashboards, crea segmentos, ejecuta experimentos.

- Support: ve el historial a nivel cliente necesario para ayudar (campos limitados).

- Solo lectura: ve dashboards agregados sin drill-down.

Haz las comprobaciones de rol del lado del servidor, no solo en la UI.

Minimiza la exposición de datos sensibles

Limita quién puede ver registros a nivel cliente. Prefiere agregados por defecto, con drill-down tras permisos más estrictos.

- Enmascara identificadores (email, ID de cliente) en la UI cuando sea posible.

- Hash identificadores para joins y deduplicación (p. ej., SHA-256 con salt secreto) para que los analistas puedan segmentar sin ver PII crudo.

- Separa tablas de “identidad/facturación” de las tablas de eventos analíticos, conectadas mediante una clave hasheada.

Reglas de retención de datos

Define la retención desde el principio:

- Conserva datos de eventos solo el tiempo necesario para análisis de cohortes (p. ej., 13–18 meses).

- Aplica retenciones o redacciones más cortas para textos libres de razones de cancelación, que pueden incluir info personal accidental.

- Proporciona flujos de eliminación para atender solicitudes de usuarios y políticas internas.

Logs de auditoría

Registra accesos y exportaciones del panel:

- Quién vio páginas a nivel cliente

- Quién exportó datos, cuándo y qué filtros usó

- Cambios admin a retenciones y permisos

Checklist de seguridad antes del lanzamiento

Cubre lo básico antes de enviar: riesgos OWASP (XSS/CSRF/inyecciones), TLS en todas partes, cuentas de BD con privilegios mínimos, gestión de secretos (no claves en código), limitación de tasa en endpoints de auth y procedimientos probados de backup/restore.

Plan de implementación (Frontend, Backend y pruebas)

Esta sección mapea la construcción en tres partes—backend, frontend y calidad—para que puedas lanzar un MVP coherente, lo suficientemente rápido para uso real y seguro para evolucionar.

Backend: suscripciones, eventos y experimentos

Comienza con una API pequeña que soporte CRUD para suscripciones (crear, actualizar estado, pausar/reanudar, cancelar) y almacene fechas clave del ciclo de vida. Mantén las rutas de escritura simples y validadas.

Luego añade un endpoint de ingestión de eventos para trackear acciones como “abrió la página de cancelación”, “seleccionó razón” y “confirmó cancelación”. Prefiere ingestión del lado servidor (desde tu backend) cuando sea posible para reducir bloqueadores de anuncios y manipulación. Si debes aceptar eventos del cliente, firma las peticiones y limita la tasa.

Para experimentos de retención, implementa la asignación del experimento del lado servidor para que la misma cuenta siempre tenga la misma variante. Un patrón típico: obtener experimentos elegibles → hash (account_id, experiment_id) → asignar variante → persistir la asignación.

Si quieres prototiparlo rápido, una plataforma de desarrollo asistido (vibe-coding) como Koder.ai puede generar la base (dashboard en React, backend en Go, esquema PostgreSQL) a partir de una especificación corta en chat—luego exportas el código y adaptas el modelo de datos, contratos de eventos y permisos.

Frontend: panel, filtros y exportaciones

Construye unas cuantas páginas de panel: embudos (cancel_started → offer_shown → cancel_submitted), cohortes (por mes de registro) y segmentos (plan, país, canal de adquisición). Mantén los filtros consistentes entre páginas.

Para compartir controlado, ofrece export CSV con guardarraíles: exporta solo resultados agregados por defecto, requiere permisos elevados para exportaciones a nivel de fila y registra exports para auditoría.

Fundamentos de rendimiento

Usa paginación para listas de eventos, indexa filtros comunes (fecha, subscription_id, plan) y añade pre-agregaciones para gráficos pesados (conteos diarios, tablas de cohortes). Cachea resúmenes de “últimos 30 días” con un TTL corto.

Pruebas y fiabilidad

Escribe tests unitarios para definiciones de métricas (p. ej., qué cuenta como “cancelación iniciada”) y para consistencia de asignación (la misma cuenta siempre cae en la misma variante).

Para fallos de ingestión, implementa reintentos y una dead-letter queue para evitar pérdida silenciosa de datos. Muestra errores en logs y en una página de admin para poder arreglar problemas antes de que distorsionen decisiones.

Despliega, monitoriza y mantén la confianza en los datos

Instrumenta el flujo de cancelación

Implementa el seguimiento cancel_started, offer_shown y cancel_submitted con payloads limpios.

Lanzar la app de análisis de cancelaciones es solo la mitad del trabajo. La otra mitad es mantenerla precisa mientras tu producto y experimentos cambian semana a semana.

Elige un enfoque de despliegue

Escoge la opción más simple que encaje con el estilo operativo de tu equipo:

- Hosting gestionado (PaaS): camino más rápido a producción si quieres deploys, logs y escalado integrados.

- Contenedores (Docker + orquestador): mejor cuando necesitas builds reproducibles y control de dependencias.

- Serverless: ideal para cargas con picos (ingestión de eventos, jobs programados), pero cuidado con cold starts y límites de proveedor.

Trates la app analítica como un sistema de producción: versiona, automatiza despliegues y guarda la configuración en variables de entorno.

Si no quieres gestionar todo el pipeline el primer día, Koder.ai también puede encargarse del despliegue y hosting (incluyendo dominios personalizados) y soporta snapshots y rollback—útil cuando iteras rápido en un flujo tan sensible como la cancelación.

Entornos separados (y datos separados)

Crea dev, staging y producción con aislamiento claro:

- Bases de datos y buckets separados para que eventos de prueba no contaminen métricas.

- Un entorno staging que refleje el esquema y el routing de producción.

- Namespaces de experimentos distintos (p. ej., prefija experiment IDs en no-prod) para evitar “variantes fantasma” en los dashboards.

Monitorización que protege la toma de decisiones

No solo monitorices uptime—monitoriza la verdad:

- Uptime/salud de la API, workers y panel.

- Lag de ingestión (tiempo del evento vs tiempo procesado) con alertas cuando se desvía.

- Errores de asignación de experimentos: picos en “unassigned units”, desequilibrios de variante o cambios de asignación para la misma cuenta.

Jobs automáticos de validación de datos

Programa checks ligeros que fallen ruidosamente:

- Eventos clave faltantes (p. ej.,

cancel_startedsincancel_submitted, donde se esperaría). - Cambios de esquema (propiedades nuevas/eliminadas, cambios de tipo, enums inesperados).

- Anomalías de volumen (eventos que caen casi a cero tras un release).

Plan de rollback para cambios en la UI del experimento

Para cualquier experimento que toque el flujo de cancelación, preplanifica rollback:

- Feature flags para desactivar variantes al instante.

- Ruta rápida para redeploy del último build conocido bueno.

- Nota en el panel que marque la ventana de rollback para que los analistas no interpreten mal los datos.

Opera el sistema: del insight a los experimentos continuos

Una app de análisis de cancelaciones solo paga cuando se vuelve un hábito, no un reporte puntual. La meta es convertir “notamos churn” en un bucle constante de insight → hipótesis → prueba → decisión.

Ejecuta una cadencia semanal simple

Escoge un momento fijo cada semana (30–45 minutos) y mantén el ritual ligero:

- Revisa el panel por cambios en métricas clave (churn global, churn por plan, churn por tenencia y top razones de cancelación).

- Señala una anomalía para investigar (p. ej., pico de churn entre renovaciones anuales o una razón que subió al #1).

- Elige exactamente una hipótesis para probar la semana siguiente.

Limitarse a una hipótesis fuerza claridad: ¿qué creemos que pasa, quién está afectado y qué acción podría cambiar el resultado?

Prioriza experimentos (impacto × esfuerzo)

Evita correr demasiadas pruebas a la vez—especialmente en el flujo de cancelación—porque los cambios solapados dificultan confiar en los resultados.

Usa una cuadrícula simple:

- Alto impacto / bajo esfuerzo: hazlos primero (cambios de copy, redirección a soporte, oferta de cambio anual).

- Alto impacto / alto esfuerzo: plánificalos (flexibilidad de facturación, arreglos de producto).

- Bajo impacto: aplázalos.

Si eres nuevo en experimentación, alinea las reglas básicas y de decisión antes de lanzar: /blog/ab-testing-basics.

Cierra el ciclo con input cualitativo

Los números dicen qué pasa; las notas de soporte y los comentarios de cancelación suelen decir por qué. Cada semana, muestrea unas cuantas cancelaciones recientes por segmento y resume temas. Luego mapea temas a intervenciones testeables.

Construye un playbook de “intervenciones ganadoras”

Registra aprendizajes a lo largo del tiempo: qué funcionó, para quién y en qué condiciones. Guarda entradas cortas como:

- Definición de segmento (plan, tenencia, uso)

- Hipótesis y cambio lanzado

- Resultado y nivel de confianza

- Acción de seguimiento (desplegar, iterar o revertir)

Cuando estés listo para estandarizar ofertas (y evitar descuentos ad-hoc), vincula tu playbook de nuevo a tu packaging y límites: /pricing.