29 mar 2025·8 min

Construir una aplicación web para ejecutar flujos de trabajo de moderación de contenido

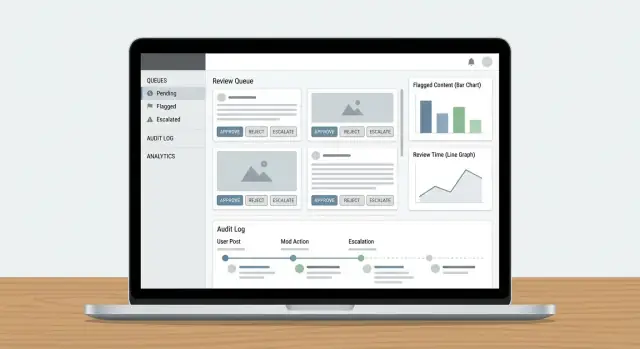

Aprende a diseñar y construir una app web para moderación de contenido: colas, roles, políticas, escalado, registros de auditoría, analítica e integraciones seguras.

Definir el alcance y las métricas de éxito

Antes de diseñar un flujo de moderación, decide qué estás moderando realmente y cómo se ve el “éxito”. Un alcance claro evita que tu cola de moderación se llene de casos límite, duplicados y solicitudes que no pertenecen allí.

Qué cuenta como “contenido”

Anota cada tipo de contenido que pueda generar riesgo o daño para los usuarios. Ejemplos comunes incluyen texto generado por usuarios (comentarios, publicaciones, reseñas), imágenes, vídeo, retransmisiones en directo, campos de perfil (nombres, biografías, avatares), mensajes directos, grupos comunitarios y anuncios del marketplace (títulos, descripciones, fotos, precios).

También anota fuentes: envíos de usuarios, importaciones automáticas, ediciones a elementos existentes e informes de otros usuarios. Esto evita construir un sistema que solo funcione para “publicaciones nuevas” y pase por alto ediciones, re-subidas o abuso en DMs.

Tus objetivos (y los trade-offs)

La mayoría de los equipos equilibran cuatro objetivos:

- Velocidad: tiempo hasta la decisión corto para que el contenido dañino se gestione rápido

- Consistencia: casos similares reciben resultados similares entre revisores

- Cumplimiento de políticas y seguridad: las decisiones se alinean con tus reglas y obligaciones legales

- Control de costes: el tiempo de los revisores es finito; la automatización y la priorización importan

Sé explícito sobre qué objetivo es primario en cada área. Por ejemplo, abusos de alta gravedad pueden priorizar velocidad sobre consistencia perfecta.

Acciones que debes soportar

Lista el conjunto completo de resultados que tu producto requiere: aprobar, rechazar/eliminar, editar/editar para ocultar, etiquetar/poner control de edad, restringir visibilidad, poner bajo revisión, escalar a un responsable, y acciones a nivel de cuenta como advertencias, bloqueos temporales o baneos.

Métricas de éxito para rastrear

Define objetivos medibles: tiempo medio y percentil 95 de revisión, tamaño del backlog, tasa de reversiones en apelaciones, precisión de políticas según muestreo de QA, y el porcentaje de ítems de alta gravedad gestionados dentro de un SLA.

Stakeholders a involucrar pronto

Incluye moderadores, líderes de equipo, política, soporte, ingeniería y legal. La desalineación aquí provoca retrabajo más adelante—especialmente en torno a qué significa “escalado” y quién toma decisiones finales.

Modelar el flujo de moderación de extremo a extremo

Antes de construir pantallas y colas, bosqueja el ciclo de vida completo de un solo contenido. Un flujo claro evita “estados misteriosos” que confunden a los revisores, rompen notificaciones y hacen que las auditorías sean dolorosas.

Mapea el ciclo de vida como estados explícitos

Comienza con un modelo de estados simple y de extremo a extremo que puedas poner en un diagrama y en tu base de datos:

Submitted → Queued → In review → Decided → Notified → Archived

Mantén los estados mutuamente exclusivos y define qué transiciones están permitidas (y por quién). Por ejemplo: “Queued” puede pasar a “In review” solo cuando está asignado, y “Decided” debe ser inmutable salvo a través de un flujo de apelación.

Separa señales automáticas de decisiones humanas

Los clasificadores automáticos, coincidencias por palabras clave, límites de tasa e informes de usuarios deben tratarse como señales, no decisiones. Un diseño de “humano-en-el-bucle” mantiene el sistema honesto:

- Las señales influyen en la prioridad y en las acciones recomendadas.

- La decisión del revisor es el resultado autoritativo.

Esta separación también facilita mejorar los modelos más tarde sin reescribir la lógica de política.

Planea apelaciones y re-revisiones

Las decisiones serán impugnadas. Añade flujos de primera clase para:

- Envío de apelación del usuario (vinculado al caso original)

- Re-revisión por un revisor diferente o un equipo especializado

- Resultados posibles: mantener, revertir, modificar o solicitar más información

Modela las apelaciones como nuevos eventos de revisión en lugar de editar el historial. Así puedes contar la historia completa de lo que ocurrió.

Decide qué debe ser trazable

Para auditorías y disputas, define qué pasos deben registrarse con marcas de tiempo y actores:

- Cambios de asignación

- Evidencia visualizada (cuando aplique)

- Decisión, motivo de la política y acción de aplicación

- Notificaciones enviadas

Si no puedes explicar una decisión más tarde, asume que no ocurrió.

Diseñar roles, permisos y estructura de equipo

Una herramienta de moderación vive o muere por el control de acceso. Si todo el mundo puede hacer todo, obtendrás decisiones inconsistentes, exposición accidental de datos y ninguna responsabilidad clara. Empieza definiendo roles que coincidan con cómo trabaja realmente tu equipo de confianza y seguridad, y luego tradúcelos a permisos que tu app pueda hacer cumplir.

Roles básicos a soportar

La mayoría de los equipos necesitan un pequeño conjunto de roles claros:

- Moderador: revisa ítems en una cola de moderación, aplica resultados (aprobar/eliminar/etiquetar) y deja notas internas.

- Revisor senior: todo lo que hace un moderador, además de anulaciones, manejar escalados y coaching (por ejemplo, resolver disputas).

- Editor de políticas: actualiza el texto de la política, definiciones de reglas y guías de decisión, pero no puede moderar ítems directamente.

- Admin: gestiona usuarios, roles, configuración del equipo, integraciones y acciones de alto riesgo.

- Solo lectura: puede ver paneles, casos y entradas del registro de auditoría, pero no cambiar nada.

Esta separación ayuda a evitar “cambios accidentales de política” y mantiene la gobernanza de políticas distinta de la ejecución diaria.

Permisos de mínimo privilegio (RBAC)

Implementa control de acceso basado en roles para que cada rol obtenga solo lo que necesita:

- Limita quién puede ver datos sensibles de usuarios (PII, reportes, señales de dispositivos).

- Restringe acciones de alto impacto como decisiones masivas, penalizaciones a nivel de cuenta y borrado de casos.

- Divide permisos por capacidad (por ejemplo,

can_apply_outcome,can_override,can_export_data) en lugar de por página.

Si luego añades nuevas funciones (exportaciones, automatizaciones, integraciones de terceros), puedes adjuntarlas a permisos sin redefinir toda la estructura organizativa.

Estructura multi-equipo (idioma, región, producto)

Planea múltiples equipos desde temprano: pods por idioma, grupos por región o líneas separadas para diferentes productos. Modela los equipos explícitamente y luego limita colas, visibilidad de contenido y asignaciones por equipo. Esto evita revisiones entre regiones y mantiene medible la carga de trabajo por grupo.

Salvaguardas y aprobaciones para suplantación

Los admins a veces necesitan suplantar usuarios para depurar accesos o reproducir un problema del revisor. Trata la suplantación como una acción sensible:

- Requiere un permiso específico para suplantar.

- Registra quién suplantó a quién, cuándo y por qué.

- Muestra un banner persistente de “suplantando” y deshabilita acciones riesgosas por defecto.

Para acciones irreversibles o de alto riesgo, añade aprobación de admin (o revisión por dos personas). Esa fricción pequeña protege contra errores y abuso interno, manteniendo la moderación rutinaria rápida.

Construir colas, priorización y asignación

Las colas son donde el trabajo de moderación se vuelve manejable. En lugar de una lista interminable, divide el trabajo en colas que reflejen riesgo, urgencia e intención—luego dificulta que los ítems se pierdan.

Define los tipos de cola

Empieza con un pequeño conjunto de colas que coincidan con cómo opera tu equipo:

- Nuevos ítems: contenido recién creado esperando la primera revisión.

- Alto riesgo: ítems que probablemente causen daño (p. ej., menores, señales de autolesión, patrones conocidos de estafa).

- Escalaciones: todo aquello que un revisor no puede decidir con confianza o que necesita un especialista.

- Apelaciones: solicitudes de usuarios para reconsiderar acciones.

- Backlog: ítems más antiguos, menor urgencia o desbordes durante picos.

Mantén las colas mutuamente exclusivas cuando sea posible (un ítem debería tener un “hogar”) y usa etiquetas para atributos secundarios.

Elige reglas de priorización que no se puedan manipular

Dentro de cada cola, define reglas de puntuación que determinen qué sube al tope:

- Severidad (categoría de política + confianza)

- Viralidad/alcance (vistas, compartidos, número de seguidores)

- Reportes de usuarios (conteo, reputación del reportante, reportantes únicos)

- Temporizadores de SLA (antigüedad, plazos de escalado, tiempo desde el primer reporte)

Haz las prioridades explicables en la UI (“¿Por qué veo esto?”) para que los revisores confíen en el orden.

Evita trabajo duplicado con claiming + timeouts

Usa claiming/locking: cuando un revisor abre un ítem, se le asigna y se oculta a los demás. Añade un timeout (p. ej., 10–20 minutos) para que los ítems abandonados vuelvan a la cola. Siempre registra eventos de claim, release y completion.

Maneja la equidad: evita el sesgo de “ganancias fáciles”

Si el sistema premia la velocidad, los revisores elegirán casos rápidos y evitarán los difíciles. Contrarresta esto con:

- Asignación automática de una porción del trabajo

- Mezcla de niveles de dificultad (batching inteligente)

- Rotación de colas de alto impacto en el equipo

El objetivo es cobertura consistente, no solo alto rendimiento.

Convertir tus políticas en reglas aplicables

Una política que solo existe como PDF será interpretada de forma distinta por cada revisor. Para hacer las decisiones consistentes (y auditables), traduce el texto de la política en datos estructurados y opciones de UI que tu flujo pueda hacer cumplir.

Crea una taxonomía de políticas

Empieza por descomponer la política en un vocabulario compartido que los revisores puedan seleccionar. Una taxonomía útil normalmente incluye:

- Categoría (p. ej., Acoso, Contenido adulto, Desinformación)

- Tipo de violación (p. ej., Discurso de odio vs. insulto general)

- Nivel de severidad (p. ej., Bajo/Medio/Alto/Crítico)

- Evidencia requerida (qué debe estar presente para aplicar la política—frases específicas, contexto, reportes, enlaces, marcas de tiempo)

Esta taxonomía será la base para colas, escalado y analítica más adelante.

Usa plantillas de decisión para reducir la inconsistencia

En lugar de pedir a los revisores que escriban una decisión desde cero cada vez, proporciona plantillas de decisión vinculadas a ítems de la taxonomía. Una plantilla puede rellenar por defecto:

- La acción recomendada (eliminar, etiquetar, restringir, advertir, no actuar)

- El mensaje hacia el usuario (editable, pero guiado)

- La checklist interna (qué evidencia confirmar)

Las plantillas aceleran la “ruta feliz”, permitiendo excepciones cuando sea necesario.

Soporta versionado de políticas y fechas de vigencia

Las políticas cambian. Almacena políticas como registros versionados con fechas de vigencia y registra qué versión se aplicó en cada decisión. Esto evita confusión cuando casos antiguos son apelados y asegura que puedas explicar resultados meses después.

Captura razones estructuradas (no solo texto libre)

El texto libre es difícil de analizar y fácil de olvidar. Exige que los revisores elijan una o más razones estructuradas (desde tu taxonomía) y opcionalmente añadan notas. Las razones estructuradas mejoran el manejo de apelaciones, el muestreo de QA y los informes de tendencias—sin obligar a los revisores a escribir ensayos.

Diseñar el panel y la UX del revisor

Desarrolla con React y Go

Obtén un frontend en React con un backend en Go y PostgreSQL que puedes ampliar.

Un panel de revisor tiene éxito cuando minimiza la “búsqueda” de información y maximiza decisiones confiadas y repetibles. Los revisores deben poder entender qué pasó, por qué importa y qué hacer a continuación—sin abrir cinco pestañas.

Muestra el contenido con el contexto adecuado

No muestres una publicación aislada y esperes decisiones consistentes. Presenta un panel de contexto compacto que responda preguntas comunes de un vistazo:

- Vista de conversación/hilo: unos pocos mensajes antes y después del ítem señalado, con destacado claro del contenido reportado.

- Historial del usuario: advertencias recientes, suspensiones, eliminaciones previas y resultados de apelaciones (limitado en el tiempo para mantener relevancia).

- Acciones previas: quién tocó el ítem antes, qué decisión tomó y notas asociadas.

Mantén la vista por defecto concisa, con opciones de expansión para profundizar. Los revisores rara vez deberían necesitar salir del panel para decidir.

Acciones rápidas que correspondan a decisiones reales

La barra de acciones debe mapear a los resultados de la política, no a botones CRUD genéricos. Patrones comunes incluyen:

- Aprobar / Rechazar con un clic

- Etiquetado (p. ej., spam, acoso, autolesión, desinformación) para soporte de reportes y entrenamiento

- Editar o redactar (cuando la política permite eliminación parcial)

- Escalar a especialistas o una segunda revisión

- Pedir más información (para casos ambiguos) con prompts templados

Haz que las acciones sean visibles y que los pasos irreversibles sean explícitos (confirmación solo cuando sea necesario). Captura un código corto de motivo más notas opcionales para auditorías posteriores.

Funciones de velocidad: atajos de teclado y acciones masivas

El trabajo de alto volumen exige poca fricción. Añade atajos de teclado para las acciones principales (aprobar, rechazar, siguiente ítem, añadir etiqueta). Muestra una hoja de trucos de atajos dentro de la UI.

Para colas con trabajo repetitivo (p. ej., spam evidente), soporta selección masiva con salvaguardas: muestra un conteo previo, exige un código de motivo y registra la acción en lote.

Diseña para la seguridad emocional del revisor

La moderación expone a las personas a material dañino. Añade valores por defecto de seguridad:

- Difuminar medios sensibles por defecto con clic para revelar

- Banners de advertencia para probable autolesión, contenido sexual o violencia gráfica

- Un toggle rápido de ocultar contenido que preserva la capacidad de decidir sin exposición prolongada

Estas opciones protegen a los revisores y mantienen decisiones precisas y coherentes.

Añadir registros de auditoría y trazabilidad

Los registros de auditoría son tu “fuente de la verdad” cuando alguien pregunta: ¿Por qué se eliminó este post? ¿Quién aprobó la apelación? ¿Lo decidió el modelo o un humano? Sin trazabilidad, las investigaciones se vuelven conjeturas y la confianza de los revisores cae rápido.

Captura cada decisión (y la evidencia)

Para cada acción de moderación, registra quién la hizo, qué cambió, cuándo ocurrió y por qué (código de política + notas de texto libre). Igual de importante: almacena snapshots antes/después de los objetos relevantes—texto del contenido, hashes de medios, señales detectadas, etiquetas y el resultado final. Si el ítem puede cambiar (ediciones, eliminaciones), los snapshots evitan que “el registro” derive.

Un patrón práctico es un registro de eventos append-only:

{

"event": "DECISION_APPLIED",

"actor_id": "u_4821",

"subject_id": "post_99102",

"queue": "hate_speech",

"decision": "remove",

"policy_code": "HS.2",

"reason": "slur used as insult",

"before": {"status": "pending"},

"after": {"status": "removed"},

"created_at": "2025-12-26T10:14:22Z"

}

Registra eventos de cola para claridad operativa

Más allá de las decisiones, registra la mecánica del flujo: claimed, released, timed out, reassigned, escalated y auto-routed. Estos eventos explican “por qué tardó 6 horas” o “por qué este ítem rebotó entre equipos”, y son esenciales para detectar abuso (p. ej., revisores que eligen casos fáciles).

Haz los rastros de auditoría buscables para investigaciones

Proporciona a los investigadores filtros por usuario, ID de contenido, código de política, rango temporal, cola y tipo de acción. Incluye exportación a un archivo de caso, con marcas de tiempo inmutables y referencias a ítems relacionados (duplicados, re-subidas, apelaciones).

Define reglas de retención que coincidan con cumplimiento

Establece ventanas de retención claras para eventos de auditoría, snapshots y notas de revisores. Mantén la política explícita (p. ej., 90 días para logs de cola rutinaria, más tiempo para retenes legales) y documenta cómo las solicitudes de redacción o eliminación afectan la evidencia almacenada.

Conectar reportes, notificaciones y acciones de usuario

Una herramienta de moderación solo es útil si cierra el ciclo: los reportes se convierten en tareas de revisión, las decisiones llegan a las personas correctas y las acciones a nivel de usuario se ejecutan de forma consistente. Aquí es donde muchos sistemas fallan—alguien resuelve la cola, pero nada más cambia.

Ingesta: unifica todo tipo de reportes

Trata reportes de usuarios, señales automáticas (spam/CSAM/coincidencias de hash/señales de toxicidad) y escalaciones internas (soporte, community managers, legal) como el mismo objeto central: un reporte que puede generar una o más tareas de revisión.

Usa un único enrutador de reportes que:

- Deduplica (mismo contenido reportado muchas veces)

- Vincula ítems relacionados (mismo autor, mismo hilo)

- Aplica triage básico (gravedad, categoría, jurisdicción)

- Crea/actualiza ítems en la cola de moderación

Si las escalaciones desde soporte forman parte del flujo, vincúlalas directamente (p. ej., /support/tickets/1234) para que los revisores no cambien de contexto.

Resultados: notifica a usuarios sin crear nuevo riesgo

Las decisiones de moderación deben generar notificaciones templadas: contenido eliminado, advertencia emitida, sin acción o acción de cuenta aplicada. Mantén los mensajes consistentes y mínimos—explica el resultado, referencia la política relevante y proporciona instrucciones de apelación.

Operativamente, envía notificaciones mediante un evento como moderation.decision.finalized, para que correo/in-app/push puedan suscribirse sin ralentizar al revisor.

Acciones sobre usuarios: conectar con controles de cuenta

Las decisiones suelen requerir acciones más allá de un solo contenido:

- Suspensiones (temporales/permanentes)

- Restricciones (límites de publicación, límites de DM, shadow bans donde esté permitido)

- Actualizaciones de puntuación de confianza / niveles de riesgo

Haz estas acciones explícitas y reversibles, con duraciones y motivos claros. Vincula cada acción a la decisión y al reporte subyacente para trazabilidad, y proporciona una vía rápida a Apelaciones para que las decisiones puedan revisarse sin investigación manual.

Elegir modelos de datos y estrategia de almacenamiento

Crea un flujo de trabajo de apelaciones

Añade casos de apelación, enrutamiento para nuevas revisiones e historial de decisiones inmutable.

Tu modelo de datos es la “fuente de la verdad” sobre lo que ocurrió con cada ítem: qué se revisó, por quién, bajo qué política y cuál fue el resultado. Si aciertas esta capa, todo lo demás—colas, paneles, auditorías y analítica—se vuelve más fácil.

Separa contenido, decisiones y códigos de política

Evita guardar todo en un solo registro. Un patrón práctico es mantener:

- Referencias de contenido (qué se está revisando): un ID estable, tipo de contenido (post/comentario/imagen/video), ID del autor, hora de creación y un puntero a la ubicación del contenido crudo.

- Decisiones de moderación (qué hicieron los revisores): ID de decisión, ID del revisor, resultado, marcas de tiempo, notas de texto libre y campos estructurados (p. ej., confianza, severidad).

- Códigos de política (por qué se decidió): identificadores canónicos como

HARASSMENT.H1oNUDITY.N3, almacenados como referencias para que las políticas puedan evolucionar sin reescribir la historia.

Esto mantiene la aplicación de políticas consistente y facilita los informes (p. ej., “códigos de política más infringidos esta semana”).

Almacena medios grandes de forma segura

No metas imágenes/videos grandes directamente en la base de datos. Usa almacenamiento de objetos y guarda solo claves de objeto + metadata en tu tabla de contenido.

Para los revisores, genera URLs firmadas de corta duración para que los medios sean accesibles sin hacerse públicos. Las URLs firmadas permiten controlar expiración y revocar acceso si es necesario.

Indexa para velocidad donde importa

Las colas e investigaciones dependen de búsquedas rápidas. Añade índices para:

- Filtros de cola (status, prioridad, revisor asignado, created_at)

- Búsqueda de texto (motivo reportado, texto del contenido donde se permita)

- Consultas de logs de auditoría (actor, tipo de acción, rango temporal, ID de contenido)

Rastrea transiciones de estado para evitar ítems “atascados”

Modela la moderación como estados explícitos (por ejemplo, NEW → TRIAGED → IN_REVIEW → DECIDED → APPEALED). Almacena eventos de transición de estado (con marcas de tiempo y actor) para detectar ítems que no han progresado.

Una salvaguarda simple: un campo last_state_change_at más alertas para ítems que exceden un SLA, y un job de reparación que reencola ítems en IN_REVIEW tras un timeout.

Seguridad, privacidad y resistencia al abuso

Las herramientas de Trust & Safety suelen manejar los datos más sensibles de tu producto: contenido generado por usuarios, reportes, identificadores de cuenta y a veces solicitudes legales. Trata la app de moderación como un sistema de alto riesgo y diseña seguridad y privacidad desde el día uno.

Acceso seguro para revisores y admins

Empieza con autenticación fuerte y controles de sesión estrictos. Para la mayoría de los equipos, eso significa:

- SSO (SAML/OIDC) para que el acceso siga las políticas de identidad de la empresa

- MFA para roles privilegiados (admins, editores de políticas, exportaciones)

- Timeouts de sesión cortos y re-autenticación para acciones riesgosas (acciones masivas, exportes, cambios de rol)

- Listas de IP permitidas para tooling interno, cuando tenga sentido (p. ej., estaciones de contratistas o rangos de oficina)

Combina esto con RBAC para que los revisores solo vean lo que necesitan (por ejemplo: una cola, una región o un tipo de contenido).

Protege contenido sensible y datos de usuarios

Encripta datos en tránsito (HTTPS en todo) y en reposo (encriptación gestionada de base de datos/almacenamiento). Luego céntrate en minimizar exposición:

- Muestra previsualizaciones redactadas por defecto (difumina medios, enmascara teléfono/email) con una acción de revelar que se registre

- Separa permisos de visualización de permisos de exportación

- Limita el acceso a campos de alto riesgo (direcciones exactas, datos de pago) a un conjunto pequeño de roles

Si manejas consentimiento o categorías especiales de datos, marca esas banderas visible para los revisores y hazlas cumplir en la UI (p. ej., visualización restringida o reglas de retención).

Resistencia al abuso en reportes y apelaciones

Los endpoints de reporte y apelación son objetivos frecuentes de spam y acoso. Añade:

- Limitaciones de ritmo por usuario/IP/dispositivo

- Protecciones anti-bot (desafíos en picos, detección de anomalías)

- Controles de coste (límites por día, fricción escalable para uso repetido)

Finalmente, haz que cada acción sensible sea rastreable con un registro de auditoría (ver /blog/audit-logs) para investigar errores de revisores, cuentas comprometidas o abuso coordinado.

Analítica, QA y mejora continua

Esboza el modelo de datos de moderación

Usa el modo Planificación para mapear Contenido, Informes, Decisiones y estados antes de generar código.

Un flujo de moderación solo mejora si puedes medirlo. La analítica debe decirte si el diseño de colas, las reglas de escalado y la aplicación de políticas están produciendo decisiones consistentes—sin agotar a los revisores ni dejar contenido dañino esperando.

Métricas que se mapéan a la operación real

Empieza con un pequeño conjunto de métricas vinculadas a resultados:

- Throughput: ítems revisados por hora/día, desglosado por cola, tipo de contenido y equipo.

- Tiempos de respuesta: tiempo hasta la primera revisión y tiempo hasta resolución (por cola y banda de prioridad).

- Señales de precisión (proxy): tasa de revocación en apelaciones, correcciones de admins y tasa de “violación confirmada” tras escalado.

Pon esto en un panel SLA para que los leads de ops vean qué colas están retrasadas y si el cuello de botella es personal, reglas poco claras o un aumento de reportes.

Desacuerdo y muestreo: tu sistema de alerta temprana

El desacuerdo no siempre es malo—puede indicar casos límite. Mide:

- Tasas de desacuerdo entre revisores sobre el mismo ítem (p. ej., muestras con doble revisión).

- Resultados de muestreo de auditoría: tasas de aprobación/fallo de QA y las razones de fallo más comunes.

Usa tu registro de auditoría para conectar cada decisión muestreada con el revisor, la regla aplicada y la evidencia. Esto te da explicabilidad al entrenar revisores y al evaluar si la UI de revisión está sesgando elecciones.

Encontrar huecos en la política y necesidades de entrenamiento

La analítica de moderación debe ayudarte a responder: “¿Qué estamos viendo que nuestra política no cubre bien?” Busca agrupamientos como:

- Alto desacuerdo en una categoría de política específica.

- Uso frecuente de razones “otro/no claro”.

- Escalaciones que rebotan entre equipos.

Convierte esas señales en acciones concretas: reescribir ejemplos de política, añadir árboles de decisión al panel del revisor o actualizar presets de aplicación (p. ej., tiempos por defecto vs advertencias).

Cerrar el ciclo sin romper la confianza

Trata la analítica como parte de un sistema humano-en-el-bucle. Comparte desempeño a nivel de cola públicamente dentro del equipo, pero maneja métricas individuales con cuidado para evitar incentivar velocidad sobre calidad. Combina KPIs cuantitativos con sesiones de calibración regulares y pequeñas actualizaciones de política frecuentes: así la herramienta y las personas mejoran juntas.

Pruebas, despliegue y operaciones continuas

Una herramienta de moderación falla con más frecuencia en los bordes: publicaciones raras, rutas de escalado infrecuentes y momentos en que varias personas tocan el mismo caso. Trata las pruebas y el despliegue como parte del producto, no como un checkbox final.

Prueba con escenarios realistas (no solo rutas felices)

Construye un pequeño “paquete de escenarios” que refleje el trabajo real. Incluye:

- Casos límite (medios mixtos, cuentas eliminadas, contenido editado, ambigüedad de idioma)

- Apelaciones y reversiones (una decisión es impugnada, re-revisada y revocada)

- Escalaciones (transferencias a especialistas, legal o política) y SLAs basados en tiempo

- Concurrencia (dos revisores abriendo el mismo ítem, condiciones de carrera en acciones, reportes duplicados)

Usa volúmenes similares a producción en un entorno staging para detectar lentitud en colas y problemas de paginación/búsqueda temprano.

Despliegue por etapas para proteger el throughput

Un patrón de despliegue más seguro es:

- Equipo piloto: una cola, acciones limitadas, bucle de feedback diario

- Modo shadow: ejecuta el sistema nuevo junto al antiguo (registra decisiones pero no aplique enforcement visible al usuario)

- Migración completa: cambia la ejecución, mantén caminos de rollback y vigila métricas clave cada hora la primera semana

El modo shadow es especialmente útil para validar reglas de enforcement y automatizaciones sin arriesgar falsos positivos.

Documenta playbooks y entrena para consistencia

Escribe playbooks cortos y basados en tareas: “Cómo procesar un reporte”, “Cuándo escalar”, “Cómo manejar apelaciones” y “Qué hacer cuando el sistema está incierto”. Luego entrena con el mismo paquete de escenarios para que los revisores practiquen los flujos exactos que usarán.

Operaciones continuas: las políticas cambian, las colas crecen

Planifica mantenimiento como trabajo continuo: nuevos tipos de contenido, reglas de escalado actualizadas, muestreos periódicos de QA y planificación de capacidad cuando las colas aumenten. Mantén un proceso de lanzamiento claro para actualizaciones de política para que los revisores vean qué cambió y cuándo—y puedas correlacionar cambios con la analítica de moderación.

Construir esto más rápido con Koder.ai (opcional)

Si lo implementas como una aplicación web, una gran parte del esfuerzo es andamiaje repetitivo: RBAC, colas, transiciones de estado, registros de auditoría, paneles y el pegamento orientado a eventos entre decisiones y notificaciones. Koder.ai puede acelerar esa construcción permitiéndote describir el flujo de moderación en una interfaz de chat y generar una base funcional para iterar—típicamente con un frontend en React y un backend en Go + PostgreSQL.

Dos formas prácticas de usarlo para herramientas de confianza y seguridad:

- Modo planificación primero: define tus entidades (Content, Report, ReviewTask, Decision, PolicyCode, AuditEvent), transiciones de la máquina de estados y SLAs antes de generar código.

- Snapshots y rollback: útil cuando afinas reglas de escalado, puntuación de colas o salvaguardas de acciones masivas y quieres iteración rápida y segura.

Una vez que la base está en su lugar, puedes exportar el código fuente, conectar tus señales de modelo existentes como “inputs” y mantener la decisión del revisor como autoridad final—coincidiendo con la arquitectura humano-en-el-bucle descrita arriba.

Preguntas frecuentes

¿Cómo defino el alcance de “contenido” para una app de moderación?

Comienza por listar todos los tipos de contenido que vas a gestionar (publicaciones, comentarios, mensajes directos, perfiles, anuncios, medios), además de todas las fuentes (nuevas publicaciones, ediciones, importaciones, informes de usuarios, señales automáticas). Luego define qué queda fuera de alcance (por ejemplo, notas internas de administración, contenido generado por el sistema) para que tu cola no se convierta en un vertedero.

Una comprobación práctica: si no puedes nombrar el tipo de contenido, la fuente y el equipo responsable, probablemente no debería generar una tarea de moderación todavía.

¿Qué métricas de éxito debería rastrear para un flujo de moderación?

Elige un pequeño conjunto de KPIs operativos que reflejen tanto velocidad como calidad:

- Mediana y p95 del tiempo hasta la decisión

- Tamaño del backlog (total y por cola)

- Cumplimiento de SLA para ítems de alta gravedad

- Tasa de revocación en apelaciones (y motivos)

- Precisión de QA a partir de muestreos de revisiones

Fija objetivos por cola (por ejemplo, alta gravedad vs backlog) para no optimizar trabajo de baja urgencia mientras contenido dañino espera.

¿Cuál es un buen state machine de extremo a extremo para casos de moderación?

Usa un modelo de estados simple y explícito y aplica transiciones permitidas, por ejemplo:

SUBMITTED → QUEUED → IN_REVIEW → DECIDED → NOTIFIED → ARCHIVED

Haz que los estados sean mutuamente exclusivos, y trata “Decided” como inmutable salvo mediante un flujo de apelación/re-revisión. Esto evita “estados misteriosos”, notificaciones rotas y ediciones difíciles de auditar.

¿Cómo debo integrar clasificadores automáticos sin que “decidan”?

Trata a los sistemas automáticos como señales, no como resultados finales:

- Modelos, coincidencias por palabras clave y reportes influyen en prioridad, acciones recomendadas y enrutamiento.

- La decisión del revisor es el resultado autoritativo.

Esto mantiene la aplicación de la política explicable y facilita mejorar los modelos más tarde sin reescribir la lógica de decisión.

¿Cómo diseño un proceso de apelaciones y re-revisión?

Construye las apelaciones como objetos de primera clase vinculados a la decisión original:

- Una apelación de usuario crea un nuevo evento de revisión (no reescribe el historial).

- Enrútala a un o a un equipo especializado.

¿Qué roles y permisos debería soportar una herramienta de moderación?

Comienza con un conjunto pequeño y claro de roles RBAC:

- Moderador: revisar/aplicar resultados/anotar

- Revisor senior: anulaciones + escalados

- Editor de políticas: actualizar contenido/taxonomía de políticas, sin aplicar medidas directamente

- : roles, integraciones y acciones de alto riesgo

¿Cómo debo estructurar las colas y las reglas de priorización?

Usa múltiples colas con propiedad clara:

- Nuevos ítems

- Alto riesgo

- Escalaciones

- Apelaciones

- Backlog

Prioriza dentro de cada cola usando señales explicables como gravedad, alcance, reportes únicos y temporizadores de SLA. En la UI, muestra “¿Por qué veo esto?” para que los revisores confíen en el orden y puedas detectar tácticas de manipulación.

¿Cómo evito que dos revisores trabajen el mismo ítem?

Implementa claiming/locking con timeouts:

- Cuando un revisor abre un ítem, queda asignado y se oculta a otros.

- Si lo abandona, un timeout lo devuelve a la cola.

- Registra eventos de claim, release, timeout y completion.

Esto reduce trabajo duplicado y te da datos para diagnosticar cuellos de botella y selecciones sesgadas.

¿Cómo traduzco las políticas de moderación en reglas aplicables en la app?

Convierte tu política en una taxonomía estructurada y plantillas:

- Categoría → tipo de violación → nivel de severidad → evidencia requerida

- Plantillas de decisión que rellenan la acción recomendada, el mensaje al usuario y la checklist interna

- Exigir códigos de motivo estructurados (más notas opcionales)

- Soportar versionado de políticas con fechas de efecto y registrar la versión aplicada por decisión

Esto mejora la consistencia, hace útiles los análisis y facilita auditorías y apelaciones.

¿Qué debe incluir el registro de auditoría de un sistema de moderación?

Registra todo lo necesario para reconstruir la historia:

- Quién hizo qué, cuándo y por qué (código de política + notas)

- Mecánica del flujo (claimed, released, reassigned, escalated)

- Snapshots antes/después del contenido y del estado cuando los ítems pueden cambiar

Haz los logs buscables por actor, ID de contenido, código de política, cola y rango de tiempo, y define reglas de retención (incluyendo retenes legales y cómo las solicitudes de eliminación afectan la evidencia almacenada).