Definir objetivos y el significado de la cobertura de automatización

Antes de construir nada, escribe qué significa “cobertura de automatización” dentro de tu organización. De lo contrario, el panel se convierte en un conjunto de números no relacionados que distintos equipos interpretan de forma diferente.

¿Qué cuenta como cobertura de automatización?

Empieza por elegir las unidades que vas a medir. Opciones comunes incluyen:

- Procesos de negocio u operativos (p. ej., “onboarding de un nuevo cliente”): la cobertura significa “pasos automatizados vs. manuales”.

- Pruebas (unitarias/integración/e2e): la cobertura significa “qué flujos críticos están verificados automáticamente”.

- Jobs y runbooks (tareas programadas, playbooks de incidentes): la cobertura significa “cuánto trabajo puede ejecutarse sin intervención humana”.

- Scripts y bots (scripts puntuales, RPA, herramientas internas): la cobertura significa “tareas repetibles manejadas con mínima intervención humana”.

Elige una definición principal para la v1 y anota los tipos secundarios que puedes añadir después. Sé explícito sobre casos límite, como pasos “semi-automatizados” que aún requieren aprobaciones.

¿Quién usará la app y qué necesitan responder?

Distintas audiencias hacen distintas preguntas:

- Ingeniería / QA: ¿Qué áreas están poco automatizadas? ¿Qué cambió esta semana? ¿Dónde hay automatizaciones intermitentes?

- Ops / Soporte: ¿Qué flujos siguen dependiendo de humanos? ¿Qué se rompe con más frecuencia?

- Liderazgo: ¿Estamos reduciendo riesgo y trabajo manual con el tiempo? ¿Qué equipos necesitan inversión?

Escribe de 5 a 10 “preguntas principales” y trátalas como requisitos de producto.

Resultados, alcance y criterios de éxito

Define los resultados primarios: visibilidad (qué existe), priorización (qué automatizar a continuación), responsabilidad (quién lo posee) y seguimiento de tendencias (¿está mejorando?).

Establece límites claros para la v1. Ejemplos: “No puntuaremos calidad todavía”, “No mediremos tiempo ahorrado” o “Solo incluiremos pruebas basadas en CI, no scripts locales.”

Finalmente, decide cómo se verá el éxito: adopción constante (usuarios activos semanales), alta frescura de datos (p. ej., actualizaciones en 24 horas), menos puntos ciegos (cobertura mapeada para todos los sistemas críticos) y seguimiento medible (propietarios asignados y brechas reduciéndose mes a mes).

Mapear fuentes de datos y opciones de ingesta

Antes de poder medir la cobertura, necesitas saber dónde vive la “evidencia de automatización”. En la mayoría de organizaciones, la automatización está dispersa entre herramientas adoptadas en distintos momentos por distintos equipos.

Haz un inventario de tus fuentes de automatización

Comienza con un inventario pragmático que responda: ¿Qué señales prueban que una actividad está automatizada y dónde podemos recuperarlas?

Las fuentes típicas incluyen pipelines de CI (jobs de build/test), frameworks de pruebas (resultados unit/integración/E2E), herramientas de workflow (aprobaciones, despliegues, transiciones de tickets), runbooks (scripts y procedimientos documentados) y plataformas RPA. Para cada fuente, captura el identificador con el que podrás enlazar después (repo, nombre del servicio, entorno, equipo) y la “prueba” que almacenarás (ejecución de job, informe de suite de pruebas, regla de automatización, ejecución de script).

Identifica sistemas de registro

A continuación, lista tus sistemas de registro que definen lo que “debería existir”: hosting de repos, tracker de issues y una CMDB/catalogo de servicios. Estas fuentes suelen proporcionar la lista autorizada de servicios, propietarios y criticidad—esencial para calcular cobertura en lugar de solo contar actividad.

Elige métodos de ingesta

Asocia cada fuente con el método de ingesta menos frágil:

- Polling por API para herramientas con buenas APIs pero soporte limitado de webhooks.

- Webhooks cuando necesites actualizaciones casi en tiempo real (p. ej., eventos de finalización de pipeline).

- Importes programados para exportes CSV o warehouses de datos.

- Entrada manual para cubrir huecos (con etiquetado claro), especialmente para runbooks o automatizaciones legacy.

Documenta limitaciones y confianza

Registra límites de tasa, métodos de autenticación (PAT, OAuth, cuentas de servicio), ventanas de retención y problemas de calidad de datos conocidos (servicios renombrados, nombres inconsistentes, propietarios faltantes).

Finalmente, planifica una puntuación de fiabilidad de la fuente por conector (y opcionalmente por métrica) para que los usuarios vean si un número es “alta confianza” o “mejor esfuerzo”. Esto evita una precisión falsa y ayuda a priorizar mejoras en los conectores más tarde.

Diseñar un modelo de datos para cobertura, evidencia y propiedad

Un panel de cobertura útil empieza con un modelo de datos que separa lo que pretendes automatizar de lo que efectivamente se ejecutó recientemente. Si mezclas ambas cosas, tus números pueden parecer buenos aun cuando la automatización esté obsoleta.

Entidades clave (mantén pocas, pero explícitas)

Comienza con estos bloques:

- Aplicación/Servicio: el área de producto sobre la que informas (a menudo mapea a un repo o entrada de catálogo de servicios).

- Proceso: el flujo de negocio o ingeniería que quieres automatizar (p. ej., “Desplegar a staging”, “Conciliación de facturas”).

- Requirement (Requisito): un objetivo que debe estar cubierto (paso de proceso, control, caso de prueba o ítem de checklist).

- Automation Asset (Activo de automatización): lo que reclama cobertura (workflow de CI, script, bot, suite de pruebas).

- Run (evidencia): una ejecución única con estado, logs/URL y entorno.

- Owner (Propietario): persona/equipo responsable del requisito o activo.

Decide la granularidad desde el inicio

Elige un nivel de reporte principal y apégate a él:

- por servicio (bueno para resúmenes para liderazgo)

- por proceso o paso de proceso (mejor para la verdad operativa)

- por suite de pruebas (funciona para organizaciones dirigidas por QA)

- por entorno (prod vs staging suele cambiar la historia)

Puedes soportar múltiples vistas después, pero tu primera versión debe tener un nivel “fuente de la verdad”.

Identificadores estables (evita que renombres rompan el historial)

Usa IDs que sobrevivan refactors:

- repo + ruta de archivo (para workflows/scripts)

- ID de job/workflow de CI (si es estable)

- IDs personalizados almacenados en un manifiesto (lo mejor cuando las herramientas varían)

Trata los nombres para mostrar como editables, no como identificadores.

Modela relaciones: objetivos, afirmaciones y evidencia

Un patrón práctico:

- Requirement es el objetivo.

- CoverageClaim enlaza un Requirement ↔ Automation Asset (la afirmación de cobertura).

- Run enlaza con un Automation Asset (la prueba).

Esto te permite responder: “¿Qué debería estar cubierto?”, “¿Qué lo reclama?”, y “¿Qué se ejecutó realmente?”.

Timestamps de frescura que generan confianza

Captura:

last_seen_at (el activo sigue existiendo)last_run_at, last_failure_atlast_reviewed_at (alguien confirmó que la afirmación sigue siendo válida)

Los campos de frescura facilitan resaltar ítems “cubiertos pero obsoletos” sin debate.

Definir métricas de cobertura y reglas de puntuación

Si tu métrica de cobertura es difusa, cada gráfico se convierte en una discusión. Empieza eligiendo una métrica principal para los resúmenes ejecutivos y añade desgloses de apoyo para los equipos.

Elige la métrica que optimizarás

La mayoría de las organizaciones eligen una de estas:

- % automatizado por conteo: más fácil de explicar (p. ej., “120 de 200 tareas”). Bueno cuando las tareas son similares.

- % automatizado por esfuerzo ponderado: mejor cuando algunos ítems son mucho más grandes. Pondera por horas estimadas o complejidad.

- % automatizado por riesgo: centra la atención en lo que puede perjudicarte (impacto al cliente, cumplimiento, outages).

Aun puedes mostrar las tres, pero deja explícito cuál es el número de “titular”.

Define qué significa “automatizado”

Escribe reglas explícitas para que los equipos puntúen ítems de forma consistente:

- Automatizado: se ejecuta de extremo a extremo sin pasos manuales y produce una salida verificable.

- Parcialmente automatizado: existe automatización, pero aún requiere aprobación manual, preparación manual de datos o arreglos frecuentes.

- Manual: no hay automatización, o existen scripts que no son ejecutables de forma fiable.

Mantén las reglas medibles. Si dos personas no pueden puntuar el mismo ítem igual, refina la definición.

Añade ponderaciones simples (y mantén las escalas sencillas)

Usa escalas enteras pequeñas (1–5) para entradas como riesgo, impacto de negocio, frecuencia de ejecución y tiempo ahorrado. Ejemplo: weight = risk + impact + frequency.

Evita el “gaming” con requisitos de evidencia

No cuentes un ítem como “automatizado” a menos que tenga evidencia, como:

- al menos N ejecuciones exitosas en los últimos 30 días

- un job de CI vinculado, log de ejecución o ticket que pruebe la ejecución

Esto convierte la cobertura de una afirmación autoinformada a una señal observable.

Documenta supuestos

Pon las reglas de puntuación y ejemplos en una página compartida (enlázala desde el panel). La interpretación consistente es lo que hace confiables las tendencias.

Elegir una arquitectura adecuada para uso interno

Una app interna de cobertura debería ser aburrida en el mejor sentido: fácil de operar, fácil de cambiar y clara sobre de dónde provienen los números. Una forma simple “API + base de datos + panel” suele ganar a un sistema distribuido hasta que realmente lo necesites.

Empieza con una pila sencilla

Elige una pila que tu equipo ya soporte. Una base común es:

- Backend: una API web única (p. ej., Node/Express, Python/FastAPI, Ruby on Rails)

- Base de datos: Postgres para entidades centrales

- Frontend: un panel ligero (React/Vue) que consuma la API

Si quieres avanzar más rápido en la primera versión interna, un enfoque de "vibe-coding" puede funcionar bien: por ejemplo, Koder.ai puede ayudar a generar un dashboard en React más un backend en Go + PostgreSQL a partir de una especificación estructurada, y luego dejar que tu equipo itere vía chat manteniendo exportación completa del código y despliegue convencional.

Componentes centrales que realmente necesitarás

Incluso en un sistema “simple”, separa responsabilidades:

- Workers de ingesta: extraen datos de CI, tickets, repos o herramientas de pruebas y escriben registros normalizados

- API: sirve métricas de cobertura, listas de drill-down y vistas por propietarios

- UI: dashboards, filtros y páginas de detalle para equipos y servicios

- Auth: SSO + acceso basado en roles para quién puede ver/editar mapeos

- Jobs en background: recalculado programado, deduplicado, backfills

- Notificaciones: alertas, resúmenes semanales y mensajes de “acción necesaria”

Ajuste de base de datos: relacional + tendencias

Usa tablas relacionales para entidades canónicas (equipos, servicios, automatizaciones, evidencia, propietarios). Para tendencias (ejecuciones a lo largo del tiempo, cobertura semanal), conserva:

- Una tabla de series temporales en Postgres (particionada por fecha), o

- Un store de series temporales separado solo si el volumen de consultas lo exige

Planifica separación multi-equipo

Si varios equipos comparten la app, añade campos org_id/team_id desde temprano. Esto permite permisos y evita migraciones dolorosas cuando liderazgo pida “un solo panel, pero segmentado”.

Ejecuta dev/staging/prod y define cómo se mueve la data:

- Usa esquemas similares a producción en todos los entornos

- En staging, ingiere desde ámbitos limitados o datasets sintéticos

- Promociona código vía CI; evita editar mapeos de producción manualmente (prefiere cambios auditados vía UI)

Para más sobre cómo hacer la UI fácil de navegar, ve a /blog/design-dashboard-ux.

Autenticación, roles y principios básicos de seguridad

Crea un panel de cobertura rápido

Convierte dudas sobre cobertura de automatización en un panel interno funcional a partir de una especificación de chat.

Un panel de cobertura pronto se convierte en una fuente de verdad, así que el control de acceso y el manejo de datos importan tanto como los gráficos. Comienza simple, pero diseña para que la seguridad pueda endurecerse sin reescrituras importantes.

Inicio de sesión: SSO primero, proxy si necesitas velocidad

Si tu compañía ya tiene SSO, intégralo desde el día uno (OIDC suele ser lo más sencillo; SAML es común en organizaciones grandes). Si necesitas un lanzamiento interno rápido, puedes empezar detrás de un proxy de autenticación interno que inyecte cabeceras de identidad y luego migrar a SSO nativo.

Cualquiera que sea la ruta, normaliza la identidad a una clave de usuario estable (el email puede cambiar). Persiste un perfil de usuario mínimo y consulta membresías de grupo/equipo bajo demanda cuando sea posible.

Roles y permisos que reflejen cómo trabaja la gente

Define un conjunto pequeño de roles y mantén autorización consistente en UI y API:

- Viewer: puede leer dashboards y explorar evidencia.

- Editor: puede proponer o aplicar cambios de metadata (propiedad, etiquetas) y enviar correcciones.

- Admin: puede gestionar integraciones, reglas de puntuación y configuraciones globales.

- Service owner (basado en alcance): puede actualizar afirmaciones y workflows solo para servicios que posee.

Prefiere permisos basados en alcance (por equipo/servicio) sobre “super usuarios”. Reduce riesgo y evita cuellos de botella.

Maneja la evidencia sensible con cuidado

La prueba de cobertura a menudo incluye enlaces a logs de CI, tickets de incidentes o docs internas. Restringe el acceso a esas URLs y a cualquier log bruto. Almacena solo lo necesario para la verificación (por ejemplo: un ID de build, timestamp y un resumen corto de estado) en lugar de copiar logs completos en la base de datos.

Auditoría y retención

Cualquier edición manual a afirmaciones de cobertura o metadata debe crear un registro de auditoría: quién cambió qué, cuándo y por qué (razón en texto libre). Finalmente, define una política de retención para el historial de ejecuciones y evidencia—establece cuánto tiempo conservar y permite purgado seguro para que registros antiguos puedan eliminarse sin romper los cálculos actuales de cobertura.

Diseñar la UX del dashboard para claridad y drill-down

Un panel de cobertura triunfa cuando alguien puede responder tres preguntas en menos de un minuto: ¿Cómo vamos? ¿Qué está cambiando? ¿Qué debemos arreglar primero? Diseña la UX alrededor de esas decisiones, no alrededor de las fuentes de datos.

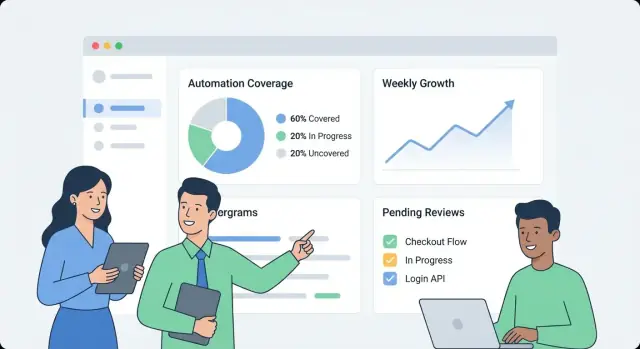

Empieza con un “status board” de alto nivel

Haz que la primera pantalla sea una visión general simple:

- Cobertura de automatización general (un número titular) con un tooltip de definición corto (“% de procesos con al menos una ejecución verificada en los últimos X días”).

- Tendencia en el tiempo (últimos 30/90 días) para que los equipos vean si la cobertura mejora o empeora.

- Frescura (qué tan recientemente se observó evidencia). Una señal obsoleta debe distinguirse visualmente de una ejecución fallida.

- Principales brechas: una lista corta de las áreas más descubiertas u obsoletas, ordenadas por impacto (p. ej., criticidad × volumen).

Usa etiquetas en lenguaje sencillo (“Automatizado recientemente” es mejor que “Recencia de evidencia”) y evita forzar a los lectores a interpretar estados técnicos.

Haz que el drill-down cuente una narrativa

Desde cualquier métrica de resumen, permite que los usuarios hagan clic en una página de servicio/proceso que responda “qué” y “por qué”:

- Qué está automatizado (qué pasos/capacidades) y qué no.

- Por qué activo (script, workflow, job de CI, bot RPA), incluyendo última ejecución y último resultado.

- Una línea de tiempo compacta o historial de ejecuciones para mostrar si los fallos son puntuales o recurrentes.

Diseña cada fila/tarjeta para incluir el “porqué detrás del número”: enlace de evidencia, propietario, estado de la última ejecución y una próxima acción clara (“Re-ejecutar job”, “Asignar propietario”, “Añadir evidencia faltante”).

Filtros que respondan a preguntas reales

Ofrece filtros que mapeen cómo funciona la organización:

- Equipo, entorno (prod/staging), criticidad, rango de fechas y sistema fuente.

Mantén el estado del filtro visible y compartible (parámetros en la URL), para que alguien pueda enviar un enlace como “Prod + Tier-1 + últimos 14 días” a un stakeholder.

Ayuda a lectores no técnicos sin saturar

Usa definiciones inline, no documentación larga:

- Tooltips para métricas y llamados cortos como “La cobertura excluye checks manuales.”

- Semántica de color consistente (p. ej., verde = verificado, ámbar = obsoleto, rojo = fallando), con iconos/texto para accesibilidad.

- Un enlace “Aprende qué significa” a una explicación interna como /docs/coverage-metrics.

Implementar integraciones y normalización de datos

Mantén control total del código fuente

Exporta el código fuente completo para que puedas realizar revisiones, auditorías y CI como ya lo haces.

Las integraciones son donde tu app de cobertura se vuelve real. El objetivo no es replicar cada feature de tu CI o herramientas de pruebas—es extraer un conjunto consistente de hechos: qué se ejecutó, cuándo, qué cubrió y quién lo posee.

Construir conectores para CI y herramientas de prueba

Comienza con los sistemas que ya generan señales de automatización: CI (GitHub Actions, GitLab CI, Jenkins), runners de pruebas (JUnit, pytest) y herramientas de calidad (informes de cobertura, linters, escaneos de seguridad).

Un conector debe obtener (o recibir vía webhook) la carga mínima viable:

- identificadores y estados de pipeline/build

- nombres de suites de pruebas, resultados individuales (opcional) y conteos de pass/fail

- timestamp de ejecución, duración y entorno (p. ej., staging/prod)

- repositorio, rama y SHA de commit

Mantén los conectores idempotentes: pulls repetidos no deben crear duplicados.

Añade un flujo manual para excepciones

Algunas brechas de cobertura son intencionales (sistemas legacy, restricciones de terceros, iniciativas pausadas). Proporciona un registro ligero de “excepción” que requiera:

- un propietario (persona o equipo)

- una razón/categoría (p. ej., bloqueado, fuera de alcance, deprecated)

- una fecha de revisión (para que las excepciones expiren a menos que se reafirmen)

Esto evita puntos ciegos permanentes y mantiene las vistas de liderazgo honestas.

Normaliza nombres entre herramientas

Las distintas fuentes raramente coinciden en identificadores: un sistema dice “payments-service”, otro “payments” y un tercero usa un slug de repo.

Crea reglas de normalización para:

- nombres de servicio

- nombres de repos

- entornos (prod, production, live → prod)

Haz esto temprano; cada métrica posterior depende de ello.

Gestiona duplicados y renombres con alias

Introduce tablas de alias (p. ej., service_aliases, repo_aliases) que mapeen muchos nombres externos a una entidad canónica. Cuando llegue nueva data, intenta hacer match contra IDs canónicos primero y luego contra alias.

Si un nombre nuevo no hace match, genera sugerencias de fusión (p. ej., “payments-api” parece “payments-service”) para que un administrador las apruebe.

Añade un job de frescura de datos

Programa un job recurrente que revise el timestamp de la última ejecución por fuente y marque cualquier cosa obsoleta (p. ej., sin ejecuciones de CI en 7 días). Expón esto en la UI para que una baja cobertura no se confunda con datos faltantes.

Un panel es útil, pero las alertas y flujos ligeros son lo que convierten datos interesantes en mejora sostenida. La meta es simple: notificar a las personas correctas en el momento correcto, con el contexto suficiente para actuar.

Tipos de alerta que impulsan acción

Comienza con un conjunto pequeño de alertas de alta señal:

- Caídas de cobertura (p. ej., un servicio cae de 80% a 65% tras un release)

- Evidencia obsoleta (existe automatización, pero las pruebas/enlaces no se han actualizado en N días)

- Automatización fallando (tests o jobs fallando repetidamente, por lo que la cobertura no es real)

- Propietarios faltantes (un servicio o workflow crítico no tiene responsable)

Cada alerta debe enlazar directamente a la vista de drill-down relevante (por ejemplo, /services/payments?tab=coverage o /teams/platform?tab=owners) para que la gente no tenga que buscar.

Umbrales por equipo/servicio (evita reglas globales ruidosas)

Evita reglas “one-size-fits-all”. Permite que los equipos configuren reglas como:

- Porcentaje mínimo de cobertura para sus servicios

- Ventana de “obsolescencia” de evidencia (7 días para sistemas de ritmo rápido, 30 para los estables)

- Conteo o duración de fallos antes de pager vs. “solo notificar”

Esto mantiene las señales significativas y reduce la fatiga por alertas.

Notificaciones + resúmenes semanales

Envía alertas a canales existentes (email y Slack) e incluye: qué cambió, por qué importa y el propietario. Junto con alertas en tiempo real, añade un resumen semanal que cubra:

- Cambios de cobertura desde la semana anterior

- Principales oportunidades de automatización (mayores brechas por impacto)

- Ítems bloqueados (propietarios faltantes, pipelines rotos, evidencia faltante)

Reconocer, asignar y cerrar el ciclo

Trata las alertas como tareas: permite reconocimiento, asignación y estado (open/triaged/resolved). Un breve rastro de comentarios (“arreglado en PR #1234”) hace que los reportes sean creíbles y evita que los mismos problemas resurjan en silencio.

Construir la API y jobs backend para rendimiento

Un dashboard de monitoreo se siente rápido cuando la API responde a las preguntas que la UI realmente hace—sin obligar al navegador a componer docenas de llamadas. Comienza con una superficie de API mínima enfocada en el dashboard, luego añade jobs en background para precomputar lo caro.

Empieza con una API mínima que coincida con la UI

Mantén la primera versión enfocada en las pantallas centrales:

- Lista de servicios:

GET /api/services (filtros como equipo, lenguaje, tier)

- Resumen de cobertura:

GET /api/services/{id}/coverage (puntaje general + desgloses clave)

- Evidencia (runs):

GET /api/services/{id}/evidence?status=passed&since=...

- Actualizar metadata (propietario, tags, estado):

PATCH /api/services/{id}

Diseña respuestas para que el dashboard pueda renderizar de inmediato: incluye nombre de servicio, propietario, último timestamp de evidencia y puntaje actual en una sola carga en lugar de requerir búsquedas adicionales.

Haz las consultas del dashboard económicas: paginación, cache y rollups

Las listas y tablas de drill-down deben siempre paginarse (limit + cursor). Para endpoints muy consultados, añade cache en la capa de API (o un cache compartido) indexado por filtros y el scope de acceso del llamador.

Para cualquier cosa que requiera escanear mucha evidencia (p. ej., “cobertura por equipo”), precomputen rollups en un job nocturno. Almacena rollups en una tabla separada (o una view materializada) para que las lecturas sean simples y previsibles.

Las tendencias son más sencillas cuando guardas snapshots diarios:

- Un job programado calcula la cobertura por servicio cada día.

- La API expone

GET /api/services/{id}/trend?days=90.

Los snapshots evitan recalcular métricas históricas en cada carga de página y facilitan graficar la “frescura” (qué tan recientemente se ejecutó la evidencia).

Importación/exportación y guardas de consistencia

La incorporación masiva es más fácil con:

POST /api/import/services (subida CSV)GET /api/export/services.csv

Finalmente, aplica validaciones al escribir: propietario requerido, valores de estado permitidos y timestamps sensatos (sin evidencia en el futuro). Rechazar datos malos temprano evita correcciones lentas y confusas más adelante—especialmente cuando los rollups dependen de entradas consistentes.

Despliegue, observabilidad y mantenimiento

Convierte preguntas en pantallas

Convierte tus preguntas frecuentes y las consultas más comunes de usuarios en requisitos, pantallas y endpoints rápidamente.

Un dashboard de cobertura solo es útil si la gente confía en él. Trata despliegue y operaciones como parte del producto: releases predecibles, señales de salud claras y recuperación simple cuando algo falla.

Comienza con un despliegue amigable para uso interno

Para una app interna, optimiza por baja carga operativa y rápida iteración.

- Despliega internamente primero usando una imagen contenedorizada más una base de datos gestionada (p. ej., Postgres), o una platform-as-a-service que soporte jobs programados y variables de entorno.

- Mantén la configuración fuera de la imagen (env vars o un gestor de secretos) para poder promover la misma build entre entornos.

Si usas una plataforma como Koder.ai para acelerar el desarrollo, aprovecha la exportación de código fuente y flujos de despliegue/hosting desde temprano, de modo que tu app interna siga prácticas estándar de promoción, revisión y rollback.

Añade la observabilidad mínima que responda “¿Está funcionando?”

No necesitas un stack complejo para obtener señales fiables.

- Instrumenta logs estructurados para eventos clave: inicio/fin de ingesta, registros procesados y errores de normalización.

- Rastrea métricas básicas que mapeen a la confianza del usuario:

- Retraso de ingesta (qué tan obsoletos están los datos)

- Fallos de jobs (conectores, parsers, jobs de puntuación)

- Latencia API (p95 para endpoints centrales)

- Expón health checks (liveness/readiness) y crea una pequeña página admin que muestre estado de conectores, último sync exitoso y el último mensaje de error.

Backups y restauración: prueba, no asumas

Configura backups automáticos de la base de datos y una política de retención acorde a tus necesidades.

- Programa backups y verifica que puedas restaurar en una instancia nueva.

- Ejecuta un breve ejercicio de restauración después de cambios de esquema o actualizaciones de conectores.

Runbooks operativos mantienen la app “aburrida” (en el buen sentido)

Documenta runbooks para:

- Rotar secretos y tokens de API

- Re-ejecutar importes de forma segura (jobs idempotentes, backfills)

- Pasos de incidente: deshabilitar un conector, hacer rollback y comunicar la frescura de datos en el dashboard

Un poco de disciplina operativa evita que la “cobertura” se convierta en conjetura.

Plan de despliegue, gobernanza y mejora continua

Una app de monitoreo solo ayuda si los equipos confían en ella y la usan. Trata el despliegue como un lanzamiento de producto: empieza pequeño, define propiedad clara e incorpora un ritmo predecible para actualizaciones.

Onboarding de un nuevo equipo

Mantén el onboarding ligero y repetible:

- Mapear qué rastrear: lista de servicios, repos y pipelines que representan el flujo real de entrega del equipo.

- Conectar fuentes: CI, ticketing, runbooks, herramientas de incidentes, plataformas de pruebas—lo que usen como evidencia de automatización.

- Asignar propietarios: un propietario primario por servicio (y un backup). Los propietarios son responsables de arreglar datos obsoletos y revisar brechas.

Un buen objetivo es “primer vista del panel en 30 minutos”, no una configuración de una semana.

Cadencia de revisión

Establece dos ritmos:

- Revisión mensual de cobertura: cada equipo revisa cambios, explica caídas/subidas importantes y confirma las 1–3 mejoras principales.

- Chequeo trimestral de reglas métricas: revisa reglas de puntuación por equidad y relevancia (p. ej., nuevo estándar de CI, herramientas deprecadas).

Gobernanza: quién puede cambiar definiciones

Las puntuaciones de cobertura pueden volverse políticas si las reglas cambian sin aviso. Define un pequeño grupo de gobernanza (a menudo Eng Productivity + Security/Quality) que pueda:

- actualizar definiciones globales (qué cuenta como evidencia)

- cambiar reglas y pesos de puntuación

- aprobar nuevos conectores que afecten a muchos equipos

Publica cambios en un changelog simple como /docs/scoring-changelog.

Medir adopción y mejorar continuamente

Mide adopción con métricas sencillas: usuarios activos, servicios rastreados y cumplimiento de frescura (cuántos servicios tienen evidencia actualizada). Usa estos para guiar iteración: mejores ponderaciones, tipos de evidencia más ricos y conectores adicionales—siempre priorizando mejoras que reduzcan trabajo manual para los equipos.

Si decides compartir aprendizajes internos públicamente, considera estandarizar notas de build y plantillas: los equipos que usan Koder.ai también pueden ganar créditos creando contenido sobre su flujo de desarrollo o refiriendo otros usuarios, lo que puede ayudar a financiar la iteración continua de herramientas internas.