Qué significa “el modelo de software del PC” — y por qué importó

El “modelo de software del PC” no era un único producto ni un truco de licencias ingenioso. Era una manera repetible para que todo un mercado funcionara: cómo los desarrolladores construían software, cómo lo enviaban a los usuarios y cómo ganaban dinero con ello.

Eso suena básico, hasta que recuerdas lo inusual que fue al inicio de la computación personal. Los primeros ordenadores a menudo se vendían como sistemas cerrados con hardware propietario, entornos operativos únicos y caminos poco claros para desarrolladores externos. La era del PC cambió eso al convertir el software en algo que podía escalar más allá de una sola máquina —o de una sola compañía.

Una definición en lenguaje claro del “modelo de software”

En términos prácticos, un modelo de software es el conjunto de supuestos que responde:

- ¿Para qué objetivo estoy construyendo? (una base estable de SO y hardware)

- ¿Cómo lo construyo de forma eficiente? (herramientas, lenguajes, documentación)

- ¿Cómo llego a los clientes y cobro? (distribución y condiciones comerciales)

Cuando esas respuestas son predecibles, los desarrolladores invierten. Cuando no lo son, dudan.

Los tres pilares que se reforzaban mutuamente

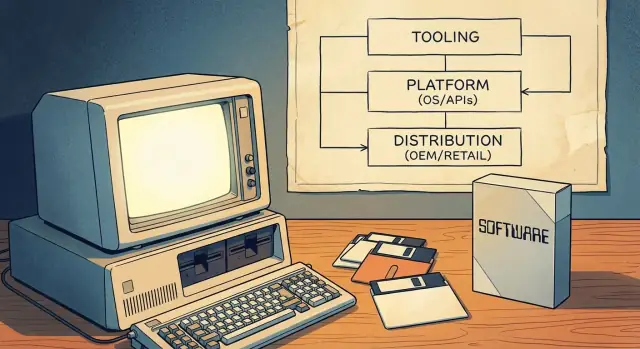

El modelo de software del PC funcionó porque unía tres pilares en una rueda de impulso:

- Herramientas de desarrollo: lenguajes accesibles, compiladores, IDEs y ejemplos que bajaban el coste de empezar.

- Superficie de plataforma: APIs y SDKs consistentes que permitían al software de terceros integrarse con el SO (y con otras apps).

- Canales de salida al mercado: formas claras de distribuir —mediante preinstalaciones OEM, venta al por menor y, más tarde, shareware— para que el software pudiera convertirse en negocio.

Juntos, hicieron del PC un “lugar para construir” fiable. Esa fiabilidad convirtió la computación personal en un ecosistema de desarrolladores mainstream, no solo en una escena de aficionados.

Antes de los PCs masivos: objetivos fragmentados y alcance limitado

Antes de los PCs de mercado masivo, “computación” solía significar mainframes y minicomputadores propiedad de gobiernos, universidades y grandes empresas. El acceso era escaso, caro y a menudo mediado por departamentos de TI. Si eras desarrollador, escribías software para una organización específica, no para un mercado público amplio.

Muchas máquinas, muchas incompatibilidades

Existían sistemas personales y para aficionados, pero no formaban un mercado único y fiable. El hardware variaba mucho (familias de CPU, formatos de disco, gráficos, periféricos) y los sistemas operativos eran inconsistentes o propietarios. Un programa que corría en una máquina a menudo necesitaba reescribirse para otra.

Esa fragmentación moldeó la economía del software:

- El software se empaquetaba comúnmente con el hardware o se entregaba como parte de una compra mayor.

- Mucho se hacía a medida para el flujo de trabajo de un cliente.

- Los vendedores vinculaban estrechamente apps a sus máquinas para proteger ventas de hardware.

Alcance limitado significaba incentivo reducido

Como la audiencia direccionable para una configuración concreta era pequeña, a los desarrolladores independientes les costaba justificar el tiempo y coste de crear productos pulidos y con amplio soporte. La distribución también era limitada: podías enviar cintas o disquetes directamente al cliente, depender de grupos de usuarios o compartir código informalmente. Nada de esto parecía un negocio escalable.

Qué cambió cuando los PCs se volvieron mainstream

Cuando los PCs se convirtieron en productos de consumo y oficina comunes, el valor pasó de despliegues únicos a ventas repetibles de software. La idea clave fue un objetivo estándar: una combinación predecible de expectativas de hardware, convenciones del sistema operativo y vías de distribución en la que los desarrolladores podían confiar.

Una vez existía una masa crítica de compradores y máquinas compatibles, escribir software dejó de ser “¿esto funcionará en otro sitio?” y pasó a ser “¿qué tan rápido podemos llegar a todos los que usan este estándar?”

Herramientas primero: los lenguajes como puerta de entrada para desarrolladores

Antes de que Microsoft fuera sinónimo de sistemas operativos, se la identificaba fuertemente con lenguajes de programación —especialmente BASIC. Esa elección no fue incidental. Si quieres un ecosistema, primero necesitas gente que pueda construir cosas, y los lenguajes son la rampa de menor fricción.

BASIC como “kit de inicio”

Los primeros microordenadores a menudo incluían BASIC en ROM, y las versiones de Microsoft se convirtieron en un punto de entrada familiar en muchas máquinas. Para un estudiante, aficionado o pequeño negocio, el camino era simple: enciende la máquina, obtén un prompt, escribe código y ve resultados. Esa inmediatez importó más que la elegancia. Hizo que programar se sintiera como un uso normal del ordenador, no como una profesión especializada.

La accesibilidad amplía la base de creadores

Al centrarse en herramientas accesibles, Microsoft ayudó a ensanchar el embudo de desarrolladores potenciales. Más personas escribiendo pequeños programas significó más experimentos, más “apps” locales y más demanda de mejores herramientas. Este es un ejemplo temprano de la cuota de mente de los desarrolladores actuando como interés compuesto: una generación que aprende en tu lenguaje y herramientas tiende a seguir construyendo —y comprando— dentro de esa órbita.

La consistencia entre máquinas genera confianza

La era del microordenador era fragmentada, pero Microsoft mantuvo ideas consistentes de plataforma a plataforma: sintaxis de lenguaje similar, expectativas de herramientas parecidas y la creciente sensación de que “si puedes programar aquí, probablemente puedes programar allí también”. Esa predictibilidad redujo el riesgo percibido de aprender a programar.

La lección estratégica es directa: las plataformas no empiezan con mercados o monetización. Empiezan con herramientas que hacen posible la creación y luego ganan lealtad haciendo que esa experiencia sea repetible.

MS‑DOS y la estandarización del objetivo PC

Un gran desbloqueo en la computación personal temprana fue la idea de una “capa estándar de SO”: en lugar de escribir una versión separada de tu app para cada combinación de hardware, podías apuntar a una interfaz común. Para los desarrolladores, eso significó menos ports, menos llamadas de soporte y un camino más claro para lanzar algo que funcionara para muchos clientes.

Un único lugar al que dirigir tu software

MS‑DOS se situó entre las aplicaciones y la variada variedad de hardware de PC. Aún existían diferentes tarjetas gráficas, impresoras, controladores de disco y configuraciones de memoria, pero MS‑DOS proporcionó una base compartida para acceso a archivos, carga de programas e interacción básica con dispositivos. Esa capa común convirtió “el PC” en un mercado único direccionable en vez de una colección de máquinas casi compatibles.

Qué significaba “compatibilidad” en la práctica

Para los clientes, compatibilidad significaba confianza: si un programa decía que funcionaba en MS‑DOS (y, por extensión, en compatibles IBM PC), era más probable que funcionara en su máquina también. Para los desarrolladores, compatibilidad significaba comportamiento predecible —llamadas de sistema documentadas, un modelo de ejecución estable y convenciones sobre cómo se instalan y lanzan los programas.

Esa predictibilidad hizo racional invertir en pulido, documentación y actualizaciones continuas, porque la audiencia ya no estaba limitada a los usuarios de un único proveedor de hardware.

El intercambio central: progreso vs preservación

La estandarización también impuso una restricción: mantener el software antiguo funcionando se convirtió en una prioridad. Esa presión por compatibilidad hacia atrás puede frenar cambios importantes, porque romper programas populares quiebra la confianza en la plataforma. La ventaja es una biblioteca de software acumulada; la desventaja es una menor libertad para innovaciones radicales a nivel de SO sin planes de transición cuidadosos.

Windows no se limitó a “sentarse sobre” MS‑DOS —cambió lo que los desarrolladores podían asumir sobre la máquina. En lugar de que cada programa inventara su propia forma de dibujar pantallas, manejar entradas y hablar con periféricos, Windows ofreció un modelo de interfaz compartida y un conjunto creciente de servicios del sistema.

Lo que Windows añadió más allá de DOS

El cambio principal fue la interfaz gráfica: ventanas, menús, diálogos y tipografías que lucían y se comportaban de forma consistente entre aplicaciones. Eso importó porque la consistencia redujo el coste de “reinvención de lo básico”. Los desarrolladores podían dedicar tiempo a las funcionalidades que interesaban a los usuarios, no a construir otra vez un toolkit de UI.

Windows también amplió los servicios comunes que eran dolorosos en la era DOS:

- Una forma estandarizada de trabajar con archivos y carpetas

- Impresión mediante drivers compartidos y cuadros de diálogo de impresión

- Soporte de red que no requería el enfoque personalizado de cada proveedor

Convenciones de GUI y componentes compartidos

Las convenciones de Windows —como atajos de teclado estándar, diseños de diálogo y controles comunes (botones, listas, cuadros de texto)— redujeron el esfuerzo de desarrollo y la formación de usuarios al mismo tiempo. Los componentes compartidos significaron menos soluciones a medida y menos sorpresas de compatibilidad cuando el hardware cambiaba.

Versiones, compatibilidad y planificación

A medida que Windows evolucionó, los desarrolladores tuvieron que elegir: soportar versiones antiguas para alcance o adoptar nuevas APIs para mejores capacidades. Esa planificación moldeó las hojas de ruta, las pruebas y el marketing.

Con el tiempo, las herramientas, la documentación, las bibliotecas de terceros y las expectativas de los usuarios empezaron a centrarse en Windows como el objetivo por defecto —no solo un sistema operativo, sino una plataforma con normas y momentum.

Experiencia de desarrollador: IDEs, compiladores, docs y ejemplos

Construye desde un prompt de chat

Convierte una idea en una app funcional con un constructor guiado por chat.

Una plataforma no se siente “real” para los desarrolladores hasta que es fácil publicar software en ella. En la era del PC, esa facilidad la moldeó menos el marketing y más la experiencia diaria de escribir, construir, depurar y empaquetar programas.

Las herramientas son multiplicadores de productividad

Compiladores, linkers, depuradores y sistemas de construcción marcan silenciosamente el ritmo de un ecosistema. Cuando los tiempos de compilación bajan, los mensajes de error mejoran y la depuración es fiable, los desarrolladores pueden iterar más rápido —y la iteración es lo que convierte una idea a medias en un producto.

Los Entornos de Desarrollo Integrados (IDEs) empujaron esto más allá al agrupar edición, construcción, depuración y gestión de proyectos en un flujo de trabajo. Un buen IDE reducía el “trabajo de pegar” que de otro modo consumía horas: configurar rutas de include, gestionar librerías, mantener builds consistentes y localizar fallos en tiempo de ejecución.

Menor riesgo para equipos pequeños

Las mejores herramientas no son solo “agradables de tener”: cambian la economía para equipos pequeños. Si uno o dos desarrolladores pueden construir y probar con confianza, pueden asumir proyectos que de otro modo requerirían más personal. Esto baja costes, acorta plazos y reduce el riesgo para un ISV que apuesta por un nuevo producto.

La documentación y los ejemplos ejecutables funcionan como un segundo producto: enseñan el modelo mental, muestran buenas prácticas y previenen errores comunes. Muchos desarrolladores no adoptan una API porque sea potente: la adoptan porque hay un ejemplo claro que funciona el primer día.

Las herramientas moldean lo que se siente “fácil” (y por ende “estándar”)

Los vendedores de herramientas influyen qué modelos de programación ganan al hacer ciertos caminos sin fricción. Si las plantillas, asistentes, librerías y vistas de depuración apuntan a un enfoque, ese enfoque se convierte en el predeterminado —no porque sea superior teóricamente, sino porque es más rápido de aprender y más seguro para publicar.

APIs y SDKs: hacer posible el software de terceros a escala

Un sistema operativo no es automáticamente una “plataforma”. Lo es cuando desarrolladores externos pueden construir sobre él de forma predecible. Ahí es donde las APIs y los SDKs importaron en la era del PC.

Una API es básicamente un menú de funciones que una app puede usar: dibujar una ventana, imprimir un documento, guardar un archivo, hablar con hardware, reproducir sonido. En vez de que cada desarrollador invente su propia manera de hacer estas cosas, la plataforma ofrece bloques de construcción compartidos.

Un SDK (kit de desarrollo) es el paquete que hace esos bloques utilizables: librerías, headers, herramientas, documentación y código de ejemplo que muestran cómo pedir del menú.

La estabilidad convierte el interés en inversión

Los desarrolladores asumen costes reales al construir software: tiempo, contratación, soporte, marketing y actualizaciones continuas. Las APIs estables reducen el riesgo de que una actualización rompa funciones centrales.

Cuando las reglas se mantienen consistentes —los diálogos de archivo se comportan igual, la impresión funciona igual, los controles de ventana siguen el mismo patrón— las compañías pueden planificar hojas de ruta plurianuales. Esa predictibilidad es una gran razón por la que el modelo de desarrollo de Windows atrajo ISVs serios y no solo aficionados.

Los programas para desarrolladores crean un bucle de retroalimentación

Los equipos de plataforma no solo publican APIs; fomentan la adopción. Programas para desarrolladores, documentación temprana, betas y lanzamientos de vista previa permiten a los creadores de software probar compatibilidad antes del lanzamiento completo.

Eso crea un ciclo: los desarrolladores encuentran casos límite, la plataforma los arregla y la siguiente ola de apps se lanza con menos sorpresas. Con el tiempo, esto mejora la calidad para los usuarios y reduce costes de soporte para todos.

Los riesgos: roturas, señales contradictorias, fragmentación

Las APIs también pueden ser una carga. Los cambios incompatibles fuerzan reescrituras costosas. Directrices inconsistentes (diferentes convenciones de UI entre apps del sistema) hacen que las apps de terceros parezcan “mal” aunque funcionen. Y la fragmentación —múltiples APIs que hacen la misma tarea— divide la atención y frena el impulso del ecosistema.

A gran escala, la mejor estrategia de plataforma suele ser aburrida: promesas claras, desaprobación cuidadosa y documentación actualizada.

Canales de distribución: acuerdos OEM, estanterías y shareware

Una plataforma no es solo APIs y herramientas —también es cómo el software llega a la gente. En la era del PC, la distribución decidió qué productos se convirtieron en “por defecto”, cuáles encontraron audiencia y cuáles desaparecieron silenciosamente.

Acuerdos OEM: el poder de ya estar ahí

Cuando los fabricantes de PC preinstalaban software (o lo incluían en la caja), moldeaban las expectativas del usuario. Si una hoja de cálculo, procesador de texto o runtime venía con la máquina, no era solo conveniente: se convertía en el punto de partida. Los acuerdos OEM también reducían la fricción para compradores: sin viajes extra a la tienda, sin conjeturas de compatibilidad.

Para los desarrolladores, las relaciones OEM ofrecían algo aún más valioso que marketing: volumen predecible. Enviar con una línea de hardware popular podía significar ventas constantes y previsibles —crucial para equipos que necesitaban financiar soporte, actualizaciones y documentación.

Estanterías minoristas y catálogos: la visibilidad como característica

Las cajas de software, el envío por catálogo y más tarde las grandes tiendas de informática crearon una “competencia por espacio en estantería”. El empaquetado, el reconocimiento de marca y los presupuestos de distribución importaban. Un producto mejor podía perder ante otro más visible.

Esta visibilidad generó un bucle: buenas ventas justificaban más presencia en estanterías, lo que empujaba más ventas. Los desarrolladores aprendieron que el canal no era neutral: premiaba productos que podían escalar promoción y soporte.

Shareware: un motor de distribución grassroots

El shareware (distribuido en discos por grupos de usuarios, revistas y BBS) bajó la barrera de entrada para nuevos participantes. Los usuarios podían probar antes de pagar y los pequeños desarrolladores podían alcanzar audiencias nicho sin acuerdos minoristas.

El hilo común entre todos estos canales fue alcance y predictibilidad. Cuando los desarrolladores pueden contar con cómo los clientes descubrirán, probarán y pagarán el software, pueden planificar personal, precios, actualizaciones y apuestas de producto a largo plazo.

La economía que atrajo a desarrolladores mainstream e ISVs

Compensa los costos mientras construyes

Obtén créditos creando contenido sobre Koder.ai o refiriendo a otros creadores.

Una gran razón por la que la era del PC atrajo a desarrolladores mainstream no fue solo la posibilidad técnica: fue la previsibilidad económica. El “modelo de software del PC” facilitó pronosticar ingresos, financiar mejoras continuas y construir negocios alrededor del software en vez de servicios.

Precios, licencias y ciclos de actualización

El precio del software empaquetado (y más tarde la licencia por puesto) creó expectativas de ingresos claras: vende una copia, obtén margen, repite. Las actualizaciones pagadas periódicas fueron importantes porque convirtieron el “mantenimiento” en un modelo de negocio: los desarrolladores podían planear versiones cada 12–24 meses, alinear marketing con lanzamientos y justificar invertir en soporte y documentación.

Para equipos pequeños, esto fue enorme: no necesitabas un contrato personalizado para cada cliente. Un producto podía escalar.

La base instalada moldea qué se construye

Una vez una plataforma alcanzó una gran base instalada, cambió qué aplicaciones valía la pena crear. Software vertical nicho (contabilidad para dentistas, inventarios para talleres), pequeñas utilidades y juegos se volvieron viables porque un pequeño porcentaje de un mercado grande aún es un negocio.

Los desarrolladores también empezaron a optimizar para productos amigables con la distribución: cosas que demuestran bien, caben en una caja de tienda y resuelven un problema específico rápidamente.

Compatibilidad, costes de soporte y la realidad de pequeñas empresas

Los compradores empresariales pequeños valoraban la estabilidad sobre la novedad. La compatibilidad con archivos, impresoras y flujos de trabajo existentes reducía las llamadas de soporte —a menudo el mayor coste oculto para los vendedores de software de PC. Las plataformas que mantuvieron apps antiguas funcionando bajaron el riesgo para clientes y desarrolladores.

Qué significaba ser un ISV

Un ISV era una compañía cuyo producto dependía de la plataforma de otro. El intercambio era simple: ganabas alcance y apalancamiento de distribución, pero vivías con las reglas de la plataforma, los cambios de versión y las expectativas de soporte impuestas por el ecosistema.

Efectos de red y el bucle de retroalimentación de la adopción

Los efectos de red son sencillos: cuando una plataforma tiene más usuarios, es más fácil para los desarrolladores justificar construir apps para ella. Y cuando tiene más apps, se vuelve más valiosa para los usuarios. Ese bucle es cómo las plataformas “suficientemente buenas” se convierten en predeterminadas.

Por qué se vuelven predeterminadas (incluso con alternativas)

En la era del PC, elegir dónde construir no fue solo cuestión de elegancia técnica. Fue elegir cómo alcanzar el mayor mercado direccionable con la menor fricción. Cuando MS‑DOS y luego Windows se convirtieron en el objetivo común, los desarrolladores podían publicar un producto y esperar que funcionara para una gran porción de clientes.

Los usuarios siguieron el software que querían —hojas de cálculo, procesadores de texto, juegos— y las empresas siguieron al talento. Con el tiempo, la plataforma con el catálogo más profundo se sintió más segura: mejor contratación, más material de formación, más integraciones de terceros y menos dudas de “¿funcionará?”.

Estándares que reforzaron el ciclo

Los efectos de red no fueron solo sobre la cantidad de apps. Los estándares tensaron el bucle:

- Formatos de archivo que permitían compartir documentos sin conversiones.

- Periféricos y drivers que “simplemente funcionaban” en muchas máquinas.

- APIs comunes que redujeron el coste de soportar impresoras, gráficos y redes.

Cada estándar redujo los costes de cambio para usuarios —y los costes de soporte para desarrolladores— haciendo la elección predeterminada más pegajosa.

Dónde puede fallar el modelo

La rueda se rompe cuando los desarrolladores no pueden triunfar:

- Herramientas pobres, documentación poco clara o APIs inestables.

- Distribución débil (los clientes no pueden encontrar o instalar apps fácilmente).

- Fragmentación que obliga a múltiples builds para dispositivos similares.

Una plataforma puede tener usuarios, pero sin un camino fiable para que los desarrolladores construyan, publiquen y cobren, el ecosistema de apps se estanca —y el bucle se invierte.

Elige una pila objetivo estable

Usa una pila consistente para apps listas para enviar: React, Go, PostgreSQL y Flutter.

El modelo de software del PC creó un gran upside para quien fijara el entorno “por defecto” —pero nunca significó control total. El ascenso de Microsoft ocurrió dentro de un mercado competitivo y a veces inestable donde otras compañías podían (y lo hicieron) cambiar las reglas.

Competencia que movía el terreno

Apple ofrecía una alternativa fuertemente integrada: menos combinaciones de hardware, una experiencia de usuario más controlada y una historia de desarrolladores distinta. En el otro extremo, el ecosistema “compatible con IBM” no era un único competidor sino una coalición de fabricantes de clones, proveedores de chips y editoras de software —cualquiera de los cuales podía cambiar estándares o poder de negociación.

Incluso dentro de la órbita IBM, la dirección de la plataforma se disputaba. OS/2 fue un intento serio de definir el siguiente entorno operativo mainstream, y su destino mostró lo difícil que es migrar desarrolladores cuando el objetivo existente (MS‑DOS y luego Windows) ya tiene momentum.

Más tarde, la era del navegador introdujo una nueva capa potencial de plataforma sobre el SO, replanteando la competencia en torno a predeterminados, distribución y qué runtime podían considerar fiables los desarrolladores.

El escrutinio antimonopolio —sin entrar en resultados legales— destaca una tensión recurrente: las mismas acciones que simplifican la vida para usuarios (características empaquetadas, software preinstalado, ajustes por defecto) pueden estrechar las opciones reales para desarrolladores y rivales.

Cuando un componente empaquetado se convierte en el predeterminado, los desarrolladores suelen seguir a la base instalada en lugar de elegir la “mejor” opción. Eso puede acelerar la estandarización, pero también puede excluir alternativas y reducir la experimentación.

Una conclusión equilibrada

Las estrategias de crecimiento de plataformas crean responsabilidades de ecosistema. Si te beneficias de ser el predeterminado, también estás moldeando la estructura de oportunidades del mercado —quién puede llegar a usuarios, qué se financia y qué tan fácil es crear algo nuevo. Cuanto más claras y transparentes sean las reglas de la plataforma, más durable será la confianza de los desarrolladores que la sustenta.

De los PCs a la web y al móvil: qué cambió, qué se mantuvo

La era del PC enseñó una regla simple: las plataformas ganan cuando facilitan a los desarrolladores llegar a muchos usuarios. La web y el móvil no borraron esa regla —la recablearon.

Qué cambió

Distribución, actualizaciones y descubrimiento se movieron en línea. En lugar de enviar cajas a tiendas (o mandar disquetes), el software pasó a ser descarga. Eso redujo la fricción, permitió actualizaciones frecuentes e introdujo nuevas formas de ser encontrado: búsquedas, enlaces, compartición social y más tarde feeds algorítmicos.

En móvil, las app stores se convirtieron en el canal por defecto. Simplificaron la instalación y los pagos, pero también crearon nuevos guardianes: directrices de revisión, sistemas de ranking y participaciones en ingresos. En otras palabras, la distribución se hizo más fácil y más centralizada a la vez.

El open source y las herramientas multiplataforma redujeron el vendor lock‑in. Un desarrollador puede construir en macOS o Linux, usar toolchains gratuitos y publicar a múltiples entornos. Navegadores, JavaScript y frameworks comunes también desplazaron poder lejos de un único proveedor de SO al hacer “ejecuta en cualquier sitio” más realista para muchas categorías.

Qué se mantuvo

Los desarrolladores siguen siguiendo el camino más fácil hacia los usuarios.

Ese camino está moldeado por:

- APIs claras y SDKs estables

- Excelente documentación, ejemplos y arranques rápidos

- Una forma predecible de probar, publicar y cobrar

Cuando esas piezas se alinean, los ecosistemas crecen —ya sea que la “plataforma” sea Windows, un navegador, una app store o un builder nativo para IA.

No necesitas recrear la era del PC para beneficiarte de su manual. La lección duradera es que las plataformas ganan cuando reducen la incertidumbre para los creadores de terceros —técnica, comercial y operativamente.

Comienza con lo básico que hace a los equipos sentir confianza para apostar su hoja de ruta en la tuya:

- Invierte temprano en tooling: los grandes SDKs importan, pero el flujo de trabajo día a día importa más (plantillas, depuración, pruebas locales, helpers para CI).

- Mantén las APIs estables por defecto: introduce versionado y políticas de desaprobación antes de necesitarlas.

- Haz la distribución predecible: reglas claras de envío, tiempos de revisión, precios, reembolsos y caminos de actualización —nada de sorpresas.

Diseña para partners, no solo para usuarios

Trata a los desarrolladores como un segmento de cliente primario. Eso significa:

- Documentación que responda “¿Cómo publico?” y no solo “¿Cómo funciona?”

- Canales de soporte con expectativas de respuesta definidas (aunque sea comunidad‑primero).

- Hojas de ruta lo suficientemente claras para planificar, más changelogs fáciles de escanear.

Si quieres ejemplos de cómo las elecciones del modelo de negocio afectan al comportamiento de partners, compara enfoques en /blog y /pricing.

Una razón por la que el modelo del PC sigue siendo útil es que se mapea bien a plataformas más recientes de “vibe‑coding”.

Por ejemplo, Koder.ai apuesta fuertemente por los mismos tres pilares:

- Tooling: un flujo de trabajo guiado por chat con asistencia tipo agente para que los equipos iteren rápido desde la intención hasta la implementación.

- Un objetivo consistente: defaults con opinión sobre apps modernas (React para web, Go + PostgreSQL para backends, Flutter para móvil) para que los proyectos sigan siendo publicables en vez de prototipos aislados.

- Distribución operacional: despliegue/hosting integrado, dominios personalizados y snapshots/rollback —reduciendo la distancia entre “funciona en mi máquina” y “está en producción”.

La plataforma también refleja una versión más nueva de la economía de la era PC: precios por niveles (free, pro, business, enterprise), exportación de código fuente e incentivos como créditos por contenido publicado o referidos —mecanismos concretos que hacen razonable construir (y seguir construyendo) desde el punto de vista financiero.

Evita trampas de lock‑in que erosionen la confianza

El control a corto plazo puede crear vacilación a largo plazo. Observa patrones que hagan sentir a los partners reemplazables: copiar apps exitosas, cambios de políticas repentinos o romper integraciones sin ruta de migración.

Apunta a la compatibilidad a largo plazo cuando sea posible. Cuando los cambios incompatibles sean inevitables, proporciona herramientas, cronogramas e incentivos para migrar —que los desarrolladores se sientan protegidos, no castigados.