10 nov 2025·8 min

Cambios de esquema y migraciones en sistemas generados por IA: una guía

Aprende cómo los sistemas generados por IA gestionan los cambios de esquema de forma segura: versionado, despliegues compatibles hacia atrás, migraciones de datos, pruebas, observabilidad y estrategias de rollback.

Qué significa “esquema” en sistemas generados por IA

Un esquema es simplemente el acuerdo compartido sobre la forma de los datos y qué significa cada campo. En sistemas generados por IA, ese acuerdo aparece en más lugares que solo las tablas de la base de datos —y cambia más a menudo de lo que los equipos esperan.

El esquema no es solo cosa de bases de datos

Te encontrarás esquemas en al menos cuatro capas comunes:

- Bases de datos: nombres de tablas/columnas, tipos de datos, restricciones, índices y relaciones.

- APIs: forma del JSON de request/response, campos requeridos vs. opcionales, enums, formatos de error, convenciones de paginación.

- Eventos y mensajes: los payloads enviados por streams, colas y webhooks (a menudo versionados implícitamente por los consumidores).

- Configs y contratos: feature flags, variables de entorno, configs YAML/JSON y “contratos ocultos” como formatos de archivos y convenciones de nombres.

Si dos partes del sistema intercambian datos, hay un esquema —incluso si nadie lo escribió.

Por qué los sistemas generados por IA ven cambios de esquema con más frecuencia

El código generado por IA puede acelerar drásticamente el desarrollo, pero también aumenta la rotación:

- El código generado refleja el prompt y el contexto más recientes, así que pequeños ajustes en el prompt pueden cambiar nombres de campos, anidamientos, valores por defecto o validaciones.

- Los requisitos evolucionan más rápido cuando es barato desplegar un nuevo endpoint o un paso en la canalización.

- Convenciones inconsistentes (snake_case vs. camelCase,

idvs.userId) aparecen cuando hay múltiples generaciones o refactors entre equipos.

El resultado es una “deriva de contrato” más frecuente entre productores y consumidores.

Si usas un flujo de trabajo vibe-coding (por ejemplo, generando handlers, capas de acceso a BD e integraciones a través de chat), vale la pena integrar disciplina de esquemas en ese flujo desde el día uno. Plataformas como Koder.ai ayudan a equipos a moverse rápido generando apps React/Go/PostgreSQL y Flutter desde una interfaz de chat —pero cuanto más rápido entregues, más importante será versionar interfaces, validar payloads y desplegar cambios deliberadamente.

El objetivo de esta guía

Este post se centra en formas prácticas de mantener producción estable mientras sigues iterando rápido: mantener compatibilidad hacia atrás, desplegar cambios de forma segura y migrar datos sin sorpresas.

Lo que no cubriremos

No profundizaremos en modelado teórico pesado, métodos formales o funciones específicas de proveedores. El énfasis está en patrones aplicables en distintas pilas —tanto si tu sistema está escrito a mano, asistido por IA o mayormente generado por IA.

Por qué los cambios de esquema ocurren más a menudo con código generado por IA

El código generado por IA tiende a normalizar los cambios de esquema —no porque los equipos sean descuidados, sino porque las entradas al sistema cambian con más frecuencia. Cuando el comportamiento de tu aplicación está parcialmente impulsado por prompts, versiones de modelos y código «pegamento» generado, la forma de los datos es más propensa a desviarse con el tiempo.

Disparadores comunes que verás en la práctica

Algunos patrones causan churn de esquema repetidamente:

- Nuevas funcionalidades de producto: añadir un nuevo campo (por ejemplo,

risk_score,explanation,source_url) o dividir un concepto en muchos (por ejemplo,addressenstreet,city,postal_code). - Cambios en la salida del modelo: un modelo más nuevo podría producir estructuras más detalladas, valores enum distintos o nombrado diferente (“confidence” vs. “score”).

- Actualizaciones del prompt: ajustes en el prompt para mejorar calidad pueden cambiar sin querer el formato, campos requeridos o anidamiento.

Patrones riesgosos que hacen frágiles a los sistemas con IA

El código generado por IA suele “funcionar” rápido, pero puede codificar supuestos frágiles:

- Supuestos implícitos: el código asume en silencio que un campo siempre está presente, siempre es numérico o siempre está dentro de cierto rango.

- Acoplamiento oculto: un servicio depende de los nombres internos de campos o del orden de otro servicio en lugar de una interfaz definida.

- Campos no documentados: el modelo empieza a emitir una nueva propiedad y el código downstream empieza a depender de ella sin que nadie acuerde explícitamente que forme parte del contrato.

Por qué la IA amplifica la frecuencia de cambios

La generación de código fomenta la iteración rápida: regenera handlers, parseadores y capas de acceso a BD a medida que cambian los requisitos. Esa velocidad es útil, pero también facilita enviar pequeños cambios de interfaz repetidamente —a veces sin notarlo.

La mentalidad más segura es tratar cada esquema como un contrato: tablas de BD, payloads de API, eventos e incluso respuestas estructuradas de LLM. Si un consumidor depende de ello, versionalo, validalo y cámbialo deliberadamente.

Tipos de cambios de esquema: añadidos vs. rupturistas

Los cambios de esquema no son todos iguales. La pregunta más útil es: ¿los consumidores existentes seguirán funcionando sin cambios? Si la respuesta es sí, suele ser un añadido. Si no, es rupturista —y necesita un plan de despliegue coordinado.

Cambios aditivos (normalmente seguros)

Los cambios aditivos extienden lo existente sin cambiar el significado previo.

Ejemplos comunes en bases de datos:

- Añadir una columna con un valor por defecto o permitir NULLs (p. ej.,

preferred_language). - Añadir una tabla nueva o un índice.

- Añadir un campo opcional a un JSON almacenado en una columna.

Ejemplos no relacionados con BD:

- Añadir una propiedad nueva en una respuesta API (los clientes que ignoran campos desconocidos siguen funcionando).

- Añadir un campo nuevo en un evento de stream/cola.

- Añadir un nuevo valor a un feature flag manteniendo el comportamiento antiguo por defecto.

Aditivo solo es “seguro” si los consumidores antiguos son tolerantes: deben ignorar campos desconocidos y no requerir los nuevos.

Cambios rupturistas (arriesgados)

Los cambios rupturistas alteran o eliminan algo de lo que los consumidores ya dependen.

Cambios rupturistas típicos en bases de datos:

- Cambiar el tipo de columna (string → integer, cambio en la precisión de timestamps).

- Renombrar un campo/columna (todo lo que lea el nombre antiguo falla).

- Drop de columna/tabla que aún se consulta.

Cambios no relacionados con BD:

- Renombrar/eliminar campos JSON en request/response.

- Cambiar la semántica de un evento (mismo nombre de campo, distinto significado).

- Modificar la estructura del payload de un webhook sin un bump de versión.

Documenta siempre el impacto en los consumidores

Antes de mergear, documenta:

- Quién lo consume (servicios, dashboards, pipelines de datos, partners).

- Compatibilidad (hacia atrás/adelante, y por cuánto tiempo).

- Modo de falla (errores de parseo, corrupción silenciosa de datos, lógica de negocio incorrecta).

Esta breve “nota de impacto” obliga a la claridad —especialmente cuando el código generado por IA introduce cambios de esquema implícitamente.

Estrategias de versionado para esquemas e interfaces

Versionar es cómo le dices a otros sistemas (y a tu yo futuro) “esto cambió, y así de riesgoso es”. El objetivo no es papeleo: es evitar roturas silenciosas cuando clientes, servicios o pipelines actualizan a distintas velocidades.

Mentalidad semántica en lenguaje llano

Piensa en términos de major / minor / patch, aunque no publiques literalmente 1.2.3:

- Major: cambio rupturista. Los consumidores antiguos pueden fallar o comportarse mal sin cambios.

- Minor: adición segura. Los consumidores antiguos siguen funcionando; los nuevos pueden usar capacidades nuevas.

- Patch: corrección de bugs o aclaración que no cambia el significado.

Una regla simple que salva equipos: nunca cambies el significado de un campo existente en silencio. Si status="active" antes significaba “cliente que paga”, no lo reutilices para significar “la cuenta existe”. Añade un campo nuevo o una nueva versión.

Endpoints versionados vs. campos versionados

Típicamente tienes dos opciones prácticas:

- Endpoints versionados (p. ej.,

/api/v1/ordersy/api/v2/orders):

Bueno cuando los cambios son realmente rupturistas o de gran alcance. Es claro, pero puede crear duplicación y mantenimiento prolongado si mantienes múltiples versiones.

- Campos versionados / evolución aditiva (p. ej., añadir

new_field, mantenerold_field):

Bueno cuando puedes hacer cambios aditivos. Los clientes antiguos ignoran lo que no entienden; los nuevos leen el campo nuevo. Con el tiempo, desaprueba y elimina el campo antiguo con un plan explícito.

Esquemas de eventos y registros

Para streams, colas y webhooks, los consumidores a menudo están fuera de tu control de despliegue. Un schema registry (o cualquier catálogo centralizado de esquemas con checks de compatibilidad) ayuda a imponer reglas como “solo cambios aditivos permitidos” y hace obvio qué productores y consumidores dependen de qué versiones.

Despliegues seguros: expandir/contratar (el patrón más fiable)

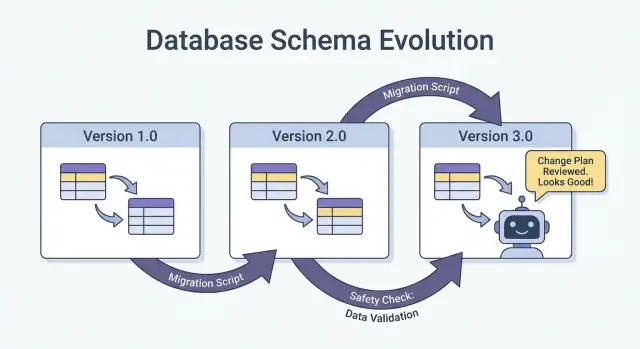

La forma más segura de enviar cambios de esquema —especialmente con múltiples servicios, jobs y componentes generados por IA— es el patrón expandir → backfill → switch → contratar. Minimiza el downtime y evita despliegues «todo o nada» donde un consumidor rezagado rompe producción.

Los cuatro pasos (y por qué funcionan)

1) Expandir: Introduce el nuevo esquema de forma compatible hacia atrás. Lectores y escritores existentes deben seguir funcionando sin cambios.

2) Backfill: Pobla los campos nuevos para datos históricos (o reprocesa mensajes) para que el sistema sea consistente.

3) Switch: Actualiza escritores y lectores para usar el campo/formato nuevo. Esto se puede hacer gradualmente (canary, rollout por porcentaje) porque el esquema soporta ambos.

4) Contratar: Elimina el campo/formato antiguo solo después de estar seguro de que nadie depende de él.

Los despliegues en dos fases (expandir → switch) y tres fases (expandir → backfill → switch) reducen el downtime porque evitan el acoplamiento estricto: los escritores pueden moverse primero, los lectores después, y viceversa.

Ejemplo: añadir una columna, backfill, luego hacerla requerida

Supongamos que quieres añadir customer_tier.

- Expandir: Añade

customer_tiercomo nullable con valor por defectoNULL. - Backfill: Ejecuta un job para calcular tiers en filas existentes.

- Switch: Actualiza la app y pipelines para siempre escribir

customer_tier, y actualiza lectores para preferirlo. - Contratar: Tras monitorizar, hazla NOT NULL (y opcionalmente elimina lógica legacy).

Coordinación: escritores y lectores deben ponerse de acuerdo

Trata cada esquema como un contrato entre productores (writers) y consumidores (readers). En sistemas generados por IA, esto es fácil de pasar por alto porque surgen rutas de código nuevas rápidamente. Haz rollouts explícitos: documenta qué versión escribe qué, qué servicios pueden leer ambos y la “fecha de contrato” exacta cuando se pueden eliminar los campos antiguos.

Migraciones de base de datos: cómo cambiar datos sin romper producción

Lanza con reversión preparada

Haz una instantánea antes de migraciones arriesgadas para recuperarte rápido si algo falla.

Las migraciones de BD son el “manual de instrucciones” para mover datos y estructura de un estado seguro a otro. En sistemas generados por IA, importan aún más porque el código generado puede asumir que existe una columna, renombrar campos de forma inconsistente o cambiar restricciones sin considerar filas existentes.

Archivos de migración vs. auto-migrations

Archivos de migración (versionados en control de código) son pasos explícitos como “añadir columna X”, “crear índice Y” o “copiar datos de A a B”. Son auditables, revisables y se pueden reproducir en staging y prod.

Auto-migrations (generadas por un ORM/framework) son convenientes para desarrollo temprano y prototipos, pero pueden producir operaciones riesgosas (dropear columnas, reconstruir tablas) o reordenar cambios de forma indeseada.

Una regla práctica: usa auto-migrations para bosquejar cambios, y luego conviértelos en archivos de migración revisados para cualquier cosa que toque producción.

Idempotencia y orden

Haz las migraciones idempotentes cuando sea posible: reejecutarlas no debería corromper datos ni fallar a medias. Prefiere “create if not exists”, añade columnas nuevas como nullable primero y protege transformaciones de datos con comprobaciones.

También mantiene un orden claro. Cada entorno (local, CI, staging, prod) debe aplicar la misma secuencia de migraciones. No “arregles” producción con SQL manual a menos que captures ese cambio en una migración después.

Migraciones de larga duración sin bloquear la tabla

Algunos cambios de esquema pueden bloquear escrituras (o incluso lecturas) si bloquean una tabla grande. Formas de reducir riesgo:

- Usa operaciones online/minimizadoras de locks soportadas por tu BD (p. ej., builds de índices concurrentes).

- Divide cambios en pasos: añade nuevas estructuras primero, backfill en lotes y luego cambia la app.

- Programa operaciones pesadas en ventanas de baja carga, con timeouts y monitorización.

Configuraciones multi-tenant y sharded

Para bases multi-tenant, ejecuta migraciones en un bucle controlado por tenant, con tracking de progreso y reintentos seguros. Para shards, trata cada shard como un sistema de producción separado: despliega migraciones shard por shard, verifica salud y luego procede. Esto limita el blast radius y hace factible el rollback.

Backfills y reprocesamiento: actualizar datos existentes

Un backfill es cuando poblas campos recién añadidos (o valores corregidos) para registros existentes. Reprocesar es cuando ejecutas datos históricos de nuevo por una pipeline —típicamente porque cambiaron reglas de negocio, se arregló un bug o se actualizó el formato de salida del modelo.

Ambos son comunes tras cambios de esquema: es fácil empezar a escribir la nueva forma para “datos nuevos”, pero los sistemas de producción también dependen de que los datos de ayer sean consistentes.

Enfoques comunes

Backfill online (en producción, gradualmente). Ejecutas un job controlado que actualiza registros en pequeños lotes mientras el sistema sigue en vivo. Es más seguro porque puedes limitar carga, pausar y reanudar.

Backfill por batch (offline o programado). Procesas grandes porciones durante ventanas de baja carga. Es más simple operativamente, pero puede crear picos de carga y tardar más en recuperarse de errores.

Backfill perezoso al leer. Cuando se lee un registro antiguo, la app calcula/puebla los campos faltantes y los escribe. Esto reparte el coste en el tiempo y evita un job grande, pero hace que la primera lectura sea más lenta y puede dejar datos antiguos sin convertir por mucho tiempo.

En la práctica, los equipos combinan: backfill perezoso para el long-tail y un job online para los datos más consultados.

Cómo validar un backfill

La validación debe ser explícita y medible:

- Conteos: cuántas filas/eventos deberían actualizarse vs. cuántas se actualizaron.

- Checksums/agregados: compara totales (p. ej., suma de montos, IDs distintos) antes/después.

- Muestreo: revisa al azar una muestra estadísticamente significativa, incluyendo casos límite.

También valida efectos downstream: dashboards, índices de búsqueda, cachés y cualquier export que dependa de los campos actualizados.

Costo, tiempo y criterios de aceptación

Los backfills intercambian velocidad (terminar rápido) por riesgo y coste (carga, cómputo y overhead operativo). Define criterios de aceptación por adelantado: qué significa “hecho”, runtime esperado, tasa máxima de error permitida y qué hacer si la validación falla (pausar, reintentar o revertir).

Evolución de esquemas de eventos y mensajes (Streams, Colas, Webhooks)

Ve a producción con confianza

Lanza con un dominio personalizado una vez que la nueva versión del esquema funcione de extremo a extremo.

Los esquemas no viven solo en bases de datos. Cada vez que un sistema envía datos a otro —Kafka topics, colas SQS/RabbitMQ, payloads de webhooks, incluso “eventos” escritos en object storage— has creado un contrato. Productores y consumidores se mueven de forma independiente, así que estos contratos tienden a romperse más que las tablas internas de una app.

El valor por defecto más seguro: evolucionar eventos compatible hacia atrás

Para streams de eventos y payloads de webhooks, prefiere cambios que los consumidores antiguos puedan ignorar y que los nuevos consumidores adopten.

Una regla práctica: añade campos, no elimines ni renombres. Si debes desaprobar algo, sigue enviándolo por un tiempo y documéntalo como deprecated.

Ejemplo: extender un evento OrderCreated añadiendo campos opcionales.

{

"event_type": "OrderCreated",

"order_id": "o_123",

"created_at": "2025-12-01T10:00:00Z",

"currency": "USD",

"discount_code": "WELCOME10"

}

Los consumidores antiguos leen order_id y created_at e ignoran el resto.

Contratos guiados por el consumidor (versión en lenguaje llano)

En lugar de que el productor adivine qué puede romper a otros, los consumidores publican de qué dependen (campos, tipos, reglas required/optional). El productor valida los cambios contra esas expectativas antes de enviarlos. Esto es especialmente útil en codebases generadas por IA, donde un modelo podría “ayudar” renombrando un campo o cambiando un tipo.

Manejar campos desconocidos de forma segura

Haz que los parseadores sean tolerantes:

- Ignora campos desconocidos por defecto (no falles solo porque apareció una clave nueva).

- Trata los campos nuevos como opcionales hasta que realmente los necesites.

- Loguea campos inesperados a bajo nivel para detectar adopciones sin generar pages.

Cuando necesites un cambio rupturista, usa un nuevo tipo de evento o un nombre versionado (por ejemplo OrderCreated.v2) y ejecuta ambos en paralelo hasta que todos los consumidores migren.

Salidas de IA como esquema: prompts, modelos y respuestas estructuradas

Cuando añades un LLM a un sistema, sus salidas se convierten rápido en un esquema de facto —incluso si nadie escribió un spec formal. El código downstream empieza a asumir “habrá un campo summary”, “la primera línea es el título” o “los bullets están separados por guiones”. Esos supuestos se endurecen con el tiempo, y un pequeño cambio en el comportamiento del modelo puede romperlos igual que un rename de columna.

Prefiere estructura explícita (y valídala)

En lugar de parsear “texto bonito”, pide salidas estructuradas (normalmente JSON) y valídalas antes de que entren al resto del sistema. Piensa en esto como pasar de “mejor esfuerzo” a un contrato.

Un enfoque práctico:

- Define un JSON Schema (o una interfaz tipada) para la respuesta del modelo.

- Rechaza o cuarentena respuestas inválidas (no las coerces silenciosamente).

- Loguea errores de validación para ver qué está cambiando.

Esto es especialmente importante cuando las respuestas de LLM alimentan pipelines de datos, automatizaciones o contenido visible para usuarios.

Planifica la deriva del modelo

Incluso con el mismo prompt, las salidas pueden desplazarse con el tiempo: campos omitidos, claves extra, y cambios de tipo ("42" vs 42, arrays vs strings). Trátalo como eventos de evolución de esquema.

Mitigaciones útiles:

- Haz campos opcionales cuando tenga sentido y define valores por defecto explícitos.

- Permite claves desconocidas pero ignóralas de forma segura (a menos que seas estricto por cumplimiento).

- Añade checks de guardrail (p. ej., campos requeridos, longitudes máximas, valores enum).

Trata los cambios de prompt como cambios de API

Un prompt es una interfaz. Si lo editas, versionalo. Mantén prompt_v1, prompt_v2 y despliega gradualmente (feature flags, canaries o toggles por tenant). Prueba con un conjunto de evaluación fijo antes de promover cambios y mantén versiones antiguas en ejecución hasta que los consumidores downstream se adapten. Para más sobre mecánicas de rollout seguro, enlaza tu enfoque a /blog/safe-rollouts-expand-contract.

Pruebas y validación para cambios de esquema

Los cambios de esquema suelen fallar de formas aburridas y costosas: falta una columna en un entorno, un consumidor sigue esperando un campo antiguo o una migración funciona en vacío pero se queda sin tiempo en producción. Las pruebas convierten esas “sorpresas” en trabajo predecible y arreglable.

Tres niveles de pruebas (y qué detecta cada una)

Unit tests protegen lógica local: funciones de mapeo, serializadores/deserializadores, validadores y query builders. Si se renombra un campo o cambia un tipo, los unit tests deben fallar cerca del código que requiere actualización.

Integration tests aseguran que tu app funciona con dependencias reales: el motor de BD real, la herramienta de migración real y formatos de mensajes reales. Aquí detectas issues como “el modelo ORM cambió pero la migración no” o “el nombre del índice nuevo entra en conflicto”.

End-to-end tests simulan usuarios o flujos completos entre servicios: crea datos, migralos, léelos vía APIs y verifica que los consumidores downstream siguen comportándose.

Tests de contrato para productores y consumidores

La evolución de esquemas suele romper en los límites: APIs servicio-a-servicio, streams, colas y webhooks. Añade contract tests que se ejecuten en ambos lados:

- Los productores prueban que pueden emitir eventos/respuestas que coincidan con un contrato acordado.

- Los consumidores prueban que pueden parsear tanto la versión antigua como la nueva durante un rollout.

Pruebas de migración: aplicar y revertir en entornos limpios

Testea migraciones tal como las desplegarías:

- Parte de un snapshot de BD limpio.

- Aplica todas las migraciones en orden.

- Verifica que la app puede leer/escribir.

- Ejecuta un rollback (si está soportado) o una migración “down” y confirma que vuelve a un estado funcional.

Fixtures para versiones de esquema antigua y nueva

Mantén un pequeño conjunto de fixtures que representen:

- Datos escritos bajo el esquema previo (filas/eventos legacy).

- Datos escritos bajo el nuevo esquema.

Estas fixtures hacen que las regresiones sean obvias, especialmente cuando el código generado por IA cambia sutilmente nombres de campos, opcionalidad o formato.

Observabilidad: detectar roturas temprano

Convierte contratos en código

Genera APIs y capas de BD, luego itera de forma segura con interfaces versionadas.

Los cambios de esquema rara vez fallan ruidosamente en el momento del despliegue. Más a menudo, la rotura aparece como un aumento lento en errores de parseo, advertencias de “campo desconocido”, datos faltantes o jobs en segundo plano atrasados. Buena observabilidad convierte esas señales débiles en feedback accionable mientras aún puedes pausar el rollout.

Qué monitorizar durante un rollout

Empieza por lo básico (salud de la app) y añade señales específicas de esquema:

- Errores: picos en 4xx/5xx, pero también errores “soft” como fallos en parseo JSON, deserialización y retries.

- Latencia: p95/p99 y tiempo de procesamiento de colas. Los cambios de esquema pueden añadir joins, payloads más grandes o validaciones extras.

- Señales de calidad de datos: aumento de tasas de null en columnas importantes, caídas bruscas en volumen de eventos, nuevos valores por defecto apareciendo con frecuencia o desajustes entre representaciones antigua y nueva.

- Lag de pipelines: lag de consumidores en streams/colas, backlog de webhooks y throughput de jobs de migración.

La clave es comparar antes vs. después y segmentar por versión de cliente, versión de esquema y segmento de tráfico (canary vs. estable).

Dashboards que realmente ayudan

Crea dos vistas de dashboard:

-

Comportamiento de la aplicación

- Tasa de requests, tasa de errores, latencia (RED)

- Top excepciones (agrupadas por mensaje)

- Conteo y porcentaje de errores de validación/parseo

- Distribución del tamaño de payloads (para detectar mensajes inesperadamente grandes)

-

Migraciones y jobs en background

- Progreso del job de migración (% completo), filas procesadas/sec, ETA

- Tasa de fallos y conteo de reintentos

- Profundidad de colas / lag de consumidores

- Volumen de dead-letter queue (si aplica)

Si ejecutas un rollout expand/contract, incluye un panel que muestre lecturas/escrituras divididas por esquema antiguo vs. nuevo para ver cuándo es seguro pasar a la siguiente fase.

Alertas para fallos específicos de esquema

Haz paging por problemas que indiquen pérdida o mala lectura de datos:

- Tasa de errores de validación de esquema por encima de un umbral bajo (a menudo <0.1% ya es significativo)

- Fallos de parseo/deserialización (especialmente si se concentran en un productor/consumidor)

- Advertencias de campo inesperado / campo requerido faltante que aumenten en tendencia

- Job de migración atascado (sin progreso N minutos) o lag creciendo más rápido que el throughput

Evita alertas ruidosas basadas en 500s sin contexto; ata las alertas al rollout de esquema usando tags como versión de esquema y endpoint.

Loguea la versión para poder depurar rápido

Durante la transición, incluye y registra:

- Versión de esquema (p. ej., cabecera

X-Schema-Version, campo metadata en mensajes) - Versión de la app productora y consumidora

- Versión del modelo / versión del prompt cuando salidas generadas por IA alimenten datos estructurados

Ese detalle hace que “¿por qué falló este payload?” sea respondible en minutos, no días —especialmente cuando distintos servicios (o versiones de modelos) están en vivo a la vez.

Rollback, recuperación y gestión del cambio

Los cambios de esquema fallan de dos maneras: el cambio en sí es incorrecto, o el sistema alrededor se comporta distinto a lo esperado (especialmente cuando el código generado por IA introduce supuestos sutiles). En cualquier caso, toda migración necesita una historia de rollback antes de enviarla —incluso si esa historia es explícitamente “sin rollback”.

Elegir “sin rollback” puede ser válido cuando el cambio es irreversible (por ejemplo, drop de columnas, reescritura de identificadores o desduplicación destructiva). Pero “sin rollback” no es la ausencia de un plan; es una decisión que desplaza el plan hacia arreglos hacia adelante, restauraciones y contención.

Opciones prácticas de rollback que realmente funcionan

Feature flags / gates de configuración: Envuelve nuevos lectores, escritores y campos API detrás de una flag para poder desactivar el comportamiento nuevo sin redeploy. Esto es muy útil cuando el código generado por IA puede ser sintácticamente correcto pero semánticamente equivocado.

Desactivar dual-write: Si escribes a esquemas viejo y nuevo durante un rollout expand/contract, mantén un kill switch. Apagar la ruta de escritura nueva detiene más divergencia mientras investigas.

Revertir lectores (no solo escritores): Muchos incidentes ocurren porque consumidores empiezan a leer campos o tablas nuevas demasiado pronto. Haz fácil señalar servicios de vuelta a la versión previa del esquema o ignorar campos nuevos.

Conoce los límites de la reversibilidad

Algunas migraciones no se deshacen limpiamente:

- Transformaciones destructivas (p. ej., hashing, normalización con pérdida).

- Drops/renames sin copia preservada.

- Backfills que sobrescriben el “source of truth”.

Para estos, planifica restore desde backup, replay desde eventos o recomputar desde inputs crudos —y verifica que aún conservas esos inputs.

Checklist pre-flight (antes de enviar)

- Decisión de rollback documentada (“revert”, “forward fix” o “sin rollback + ruta de restauración”).

- Botón de paro claro: flags y/o kill switch para dual-write.

- Backups/snapshots verificados; restauración probada al menos una vez.

- Migración idempotente; re-ejecuciones no corrompen datos.

- Monitorización y alertas para tasas de error, fallos de validación de esquema y lag.

- Propiedad: quién aprueba, quién ejecuta, quién está on-call durante el rollout.

Buena gestión del cambio hace que los rollbacks sean raros —y que la recuperación sea rutinaria cuando suceden.

Si tu equipo itera rápido con desarrollo asistido por IA, ayuda emparejar estas prácticas con tooling que soporte experimentación segura. Por ejemplo, Koder.ai incluye planning mode para diseño de cambios por adelantado y snapshots/rollback para recuperación rápida cuando un cambio generado desplaza un contrato accidentalmente. Usadas en conjunto, la generación rápida de código y la evolución disciplinada de esquemas te permiten moverte más rápido sin tratar producción como un entorno de pruebas.