13 jun 2025·8 min

Cómo construir una app web para la propiedad centralizada de métricas

Aprende un plan práctico para construir una app web que centralice definiciones de métricas, propietarios, aprobaciones y su reutilización entre equipos.

Aprende un plan práctico para construir una app web que centralice definiciones de métricas, propietarios, aprobaciones y su reutilización entre equipos.

Métricas centralizadas significa que tu empresa tiene un único lugar compartido donde se definen, poseen y explican las métricas de negocio —para que todos trabajen con el mismo manual. En la práctica, es un catálogo de métricas (un diccionario de KPI) donde cada métrica tiene una definición aprobada única, un propietario responsable y orientación clara sobre su uso.

Sin una definición centralizada, los equipos crean naturalmente sus propias versiones del mismo KPI. “Usuarios activos” puede significar “inició sesión” en Producto, “tuvo cualquier evento” en Analytics, y “suscriptores de pago que usaron una función” en Finanzas.

Cada versión puede ser razonable en aislamiento—pero cuando un dashboard, una revisión trimestral y un reporte de facturación no coinciden, la confianza se erosiona rápido.

También aparecen costes ocultos: trabajo duplicado, hilos largos en Slack para conciliar números, cambios de última hora antes de revisiones ejecutivas y una pila creciente de conocimiento tribal que se rompe cuando la gente cambia de rol.

Una app de métricas centralizada crea una única fuente de verdad para:

No se trata de imponer un único número para cada pregunta: se trata de hacer las diferencias explícitas, intencionales y fácilmente descubribles.

Sabrás que la gobernanza de métricas centralizada funciona cuando hay menos disputas sobre métricas, ciclos de reporting más rápidos, menos preguntas “¿qué definición usaste?” y KPI consistentes entre dashboards y reuniones, incluso a medida que la compañía escala.

Antes de diseñar pantallas o flujos, decide de qué se debe responsabilizar la app. Una app de métricas centralizada falla cuando las definiciones viven en comentarios, hojas de cálculo o en la cabeza de las personas. Tu modelo de datos debe hacer que cada métrica sea explicable, buscable y modificable de forma segura.

La mayoría de equipos puede cubrir la mayoría de casos con estos objetos:

Estos objetos hacen que el catálogo se sienta completo: los usuarios pueden saltar de una métrica a sus cortes, origen, responsable y dónde aparece.

Una página de métrica debe responder: ¿Qué es? ¿Cómo se calcula? ¿Cuándo debería usarla?

Incluye campos como:

Incluso a nivel de modelo de datos, planifica la gobernanza:

Los buenos catálogos son navegables:

Si aciertas con estos objetos y relaciones, la UX posterior (explorar el catálogo, páginas de métricas, plantillas) será sencilla —y las definiciones permanecerán coherentes conforme la compañía crece.

Una app de métricas centralizada solo funciona cuando cada métrica tiene un “adulto en la sala”. La propiedad responde a preguntas básicas rápidamente: ¿Quién garantiza que esta definición es correcta? ¿Quién aprueba cambios? ¿Quién comunica qué cambió?

Propietario de la métrica

La persona responsable del significado y uso de la métrica. Los propietarios no necesitan escribir SQL, pero sí autoridad y contexto.

Steward / revisor

Un guardián de calidad que verifica que las definiciones sigan estándares (nombres, unidades, reglas de segmentación, filtros permitidos), y que la métrica esté alineada con las métricas existentes.

Contribuidor

Cualquiera que pueda proponer una nueva métrica o sugerir ediciones (Product Ops, Analytics, Finanzas, Growth, etc.). Los contribuidores mueven ideas, pero no publican cambios por su cuenta.

Consumidor

La mayoría de usuarios: personas que leen, buscan y consultan métricas en dashboards, documentos y planificación.

Admin

Gestiona el sistema: permisos, asignación de roles, plantillas y acciones de alto riesgo como reasignación forzada de propiedad.

Los propietarios son responsables de:

Define expectativas directamente en la UI para que la gente no adivine:

Haz de “métrica sin propietario” un estado de primera clase. Un camino pragmático:

Esta estructura previene métricas fantasma y mantiene las definiciones estables cuando los equipos cambian.

Una app de métricas centralizada funciona cuando está claro quién puede cambiar una métrica, cómo se evaluan los cambios y qué garantiza que algo esté “aprobado”. Un modelo simple y fiable es un flujo impulsado por estados con permisos explícitos y un rastro visible.

Draft → Review → Approved → Deprecated debe ser más que etiquetas: cada estado debe controlar el comportamiento:

Trata nuevas métricas y cambios como propuestas. Una propuesta debe capturar:

Una checklist consistente mantiene las revisiones rápidas y justas:

Cada transición debe quedar registrada: proponente, revisores, aprobador, marcas temporales y un diff de lo que cambió. Este historial permite responder con confianza: “¿Cuándo cambió este KPI y por qué?” También facilita revertir cuando una definición causa sorpresas.

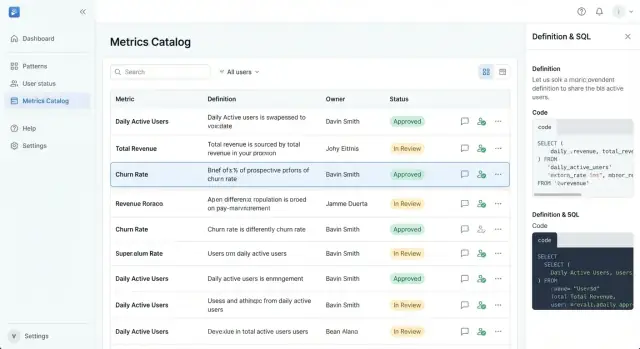

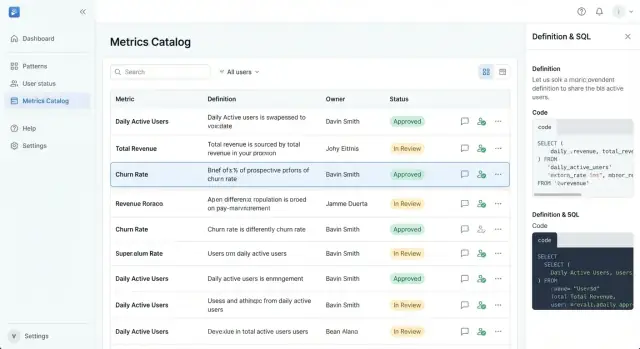

Tu app tendrá éxito o fracasará según si alguien puede responder, en menos de un minuto: “¿Esta métrica es real, está vigente y quién la posee?” La UX debe sentirse más como un catálogo de producto bien organizado que como una herramienta de datos.

Empieza con una página principal del catálogo que facilite escaneo rápido y selección confiable.

Haz la navegación principal con criterio:

Cada tarjeta/fila de métrica debe mostrar el conjunto mínimo de decisión: nombre de la métrica, definición corta, insignia de estado, propietario y fecha de última actualización. Esto evita que los usuarios tengan que entrar a múltiples páginas solo para saber si una métrica es utilizable.

Una página de métrica debe leerse de arriba abajo como una ficha técnica:

Mantén el contenido técnico colapsable (“Mostrar SQL / detalles de cálculo”) para que los usuarios no técnicos no tengan que procesarlo obligatoriamente.

Las plantillas reducen la inconsistencia. Usa campos obligatorios (nombre, definición, propietario, estado, dominio, numerador/denominador o fórmula) y ofrece redacciones sugeridas como “Count of…” o “Percentage of…”. Pre-llena ejemplos para evitar entradas vacías y vagas.

Escribe para la claridad: evita siglas en títulos, soporta sinónimos (“Usuarios Activos” vs. “DAU”) y muestra tooltips para jerga inevitable. Empareja siempre una métrica con un propietario humano: la gente confía más en personas que en tablas.

Si una app de métricas es donde las definiciones se vuelven oficiales, el control de acceso no puede ser una ocurrencia tardía. No solo proteges datos: proteges decisiones: qué cuenta como Ingresos, quién puede cambiarlo y cuándo.

Empieza con un enfoque claro de login y mantenlo consistente:

Sea lo que sea, haz que la identidad sea estable: los usuarios deben tener un ID único aunque su email cambie.

Usa control de acceso basado en roles (RBAC) para permisos amplios y añade propiedad a nivel de recurso para precisión.

Un modelo simple:

Luego superpone reglas de propiedad como “Solo el propietario de la métrica (o el aprobador de dominio) puede editar la definición aprobada.” Esto evita ediciones oportunistas y permite colaboración.

Algunas acciones requieren cheques más fuertes porque alteran la confianza:

Salvaguardas prácticas: diálogos de confirmación con texto de impacto claro, razones obligatorias para cambios y (para acciones sensibles) reautenticación o aprobación admin.

Añade un área de admin que soporte operaciones reales:

Incluso si tu primera versión es pequeña, diseñar estos controles temprano evita excepciones desordenadas y hace que la gobernanza se sienta predecible en lugar de política.

Cuando una métrica cambia, la confusión se propaga más rápido que la actualización. Una app de métricas centralizada debe tratar cada definición como un lanzamiento de producto: versionada, revisable y fácil de revertir (al menos conceptualmente) si algo sale mal.

Crea una nueva versión siempre que algo pueda afectar la interpretación: texto de definición, lógica de cálculo, inclusión/exclusión de datos, propiedad, umbrales o incluso el nombre. “Edición menor” y “edición mayor” pueden existir, pero ambas deben capturarse como versiones para que la gente pueda responder: ¿Qué definición usamos cuando tomamos esa decisión?

Una regla práctica: si un interesado podría preguntar “¿cambió esta métrica?”, merece una nueva versión.

Cada página de métrica debe incluir una línea temporal clara que muestre:

Las aprobaciones deben vincularse a la versión exacta que autorizaron.

Muchas métricas necesitan definiciones que cambien en un punto específico en el tiempo (nuevo precio, nuevo empaquetado, política revisada). Soporta fechas efectivas para que la app pueda mostrar:

Esto evita reescribir la historia y ayuda a los analistas a alinear correctamente los periodos de reporting.

La deprecación debe ser explícita, no silenciosa. Cuando una métrica se depreca:

Bien hecha, la deprecación reduce KPI duplicados preservando contexto para dashboards antiguos y decisiones pasadas.

Una app de métricas centralizada solo se vuelve fuente de verdad cuando encaja en cómo la gente ya trabaja: dashboards en BI, consultas en el warehouse y aprobaciones en chat. Las integraciones convierten definiciones en algo que los equipos pueden confiar y reutilizar.

La página de una métrica debe responder: “¿Dónde se usa este número?” Añade una integración BI que permita enlazar una métrica con dashboards, reportes o tiles específicos.

Esto crea trazabilidad bidireccional:

/bi/dashboards/123 si haces proxy o almacenas referencias internas).La ganancia práctica es auditorías más rápidas y menos debates: cuando un dashboard se ve extraño, la gente puede verificar la definición en vez de re-litigarla.

La mayoría de desacuerdos de métricas empieza en la consulta. Haz explícita la conexión con el warehouse:

No necesitas ejecutar consultas en la app al principio. Incluso SQL estático más lineage da a los revisores algo concreto que validar.

Enviar gobernanza por email ralentiza todo. Publica notificaciones en Slack/Teams para:

Incluye un enlace profundo a la página de la métrica y a la acción específica (revisar, aprobar, comentar).

Una API permite que otros sistemas traten métricas como un producto, no como un documento. Prioriza endpoints para búsqueda, lectura y estado:

Añade webhooks para que las herramientas puedan reaccionar en tiempo real (p. ej., anotar un BI cuando una métrica se depreca). Documenta esto en /docs/api y mantén payloads estables para que las automatizaciones no fallen.

En conjunto, estas integraciones reducen el conocimiento tribal y mantienen la propiedad de métricas visible dondequiera que se tomen decisiones.

Una app de métricas solo funciona cuando las definiciones son lo bastante consistentes para que dos personas leyendo la misma métrica lleguen a la misma interpretación. Los estándares y comprobaciones de calidad convierten “una página con una fórmula” en algo que los equipos pueden confiar y reutilizar.

Empieza estandarizando los campos que toda métrica debe tener:

Haz que estos campos sean obligatorios en la plantilla de la métrica, no “recomendados”. Si una métrica no cumple el estándar, no está lista para publicar.

La mayoría de desacuerdos ocurre en los bordes. Añade una sección dedicada a “Casos límite” con indicaciones para:

Añade campos estructurados de validación para que los usuarios sepan cuando una métrica está sana:

Antes de aprobar, exige una checklist como:

La app debe bloquear el envío o la aprobación hasta que los items requeridos pasen, convirtiendo la calidad de directriz en un flujo de trabajo.

Un catálogo de métricas solo funciona cuando se convierte en la primera parada para “¿Qué significa este número?” La adopción es un problema de producto, no solo de gobernanza: necesitas valor claro para usuarios diarios, caminos de contribución de baja fricción y respuesta visible de los propietarios.

Instrumenta señales simples que indiquen si la gente realmente usa el catálogo:

Usa estas señales para priorizar mejoras. Por ejemplo, una alta tasa de “sin resultados” suele significar nombres inconsistentes o sinónimos faltantes —arreglable con mejores plantillas y curación.

La gente confía más en definiciones cuando puede hacer preguntas en contexto. Añade feedback ligero donde aparezca la confusión:

Encamina el feedback al propietario y steward, y muestra el estado (“triageado”, “en revisión”, “aprobado”) para que los usuarios vean progreso en lugar de silencio.

La adopción se frena cuando los usuarios no saben cómo contribuir con seguridad. Proporciona dos guías prominentes y enlázalas desde estados vacíos y la navegación:

Mantén estas páginas vivas (p. ej., /docs/adding-a-metric y /docs/requesting-changes).

Establece una reunión semanal de revisión (30 minutos basta) con propietarios y stewards para:

La consistencia es la rueda de adopción: respuestas rápidas generan confianza y la confianza impulsa el uso repetido.

La seguridad para una app de propiedad de métricas no solo trata de prevenir brechas: también de mantener el catálogo confiable y seguro para compartir. La clave es ser claro sobre qué pertenece en el sistema, qué no y cómo se registran los cambios.

Trata la app como fuente de verdad para el significado, no como repositorio de hechos brutos.

Almacena de forma segura:

/dashboards/revenue)Evita almacenar:

Cuando los equipos quieran ejemplos, usa ejemplos sintéticos (“Pedido A, Pedido B”) o agregados (“total de la semana pasada”) con etiquetas claras.

Querrás un historial de auditoría para cumplimiento y responsabilidad, pero los logs pueden convertirse accidentalmente en una fuga de datos.

Registra:

No registres:

Define retenciones por política (por ejemplo, 90–180 días para logs estándar; más largo para eventos de auditoría) y separa eventos de auditoría de logs de depuración.

Expectativas mínimas:

Comienza con un piloto en un dominio (p. ej., Revenue o Adquisición) y 1–2 equipos. Define métricas de éxito como “% de dashboards vinculados a métricas aprobadas” o “tiempo para aprobar un KPI nuevo”. Itera sobre fricciones y luego expande dominio por dominio con formación ligera y una expectativa clara: si no está en el catálogo, no es una métrica oficial.

Si vas a convertir esto en una herramienta interna real, la vía más rápida suele ser lanzar una versión delgada pero completa: exploración del catálogo, páginas de métricas, RBAC y un flujo de aprobación —luego iterar.

Los equipos suelen usar Koder.ai para poner en vivo esa primera versión rápidamente: puedes describir la app en chat, usar el modo Planning para fijar el alcance y generar un stack funcional (React en frontend; Go + PostgreSQL en backend). A partir de ahí, snapshots y rollback te ayudan a iterar con seguridad, y la exportación de código mantiene libertad si quieres integrar el código en tu pipeline. Despliegue/hosting y dominios personalizados son útiles para rollouts internos, y los planes free/pro/business/enterprise facilitan empezar pequeño y escalar la gobernanza a medida que crece la adopción.

Las métricas centralizadas significan que existe un lugar compartido y aprobado para definir los KPI —normalmente un catálogo de métricas/diccionario de KPI— para que los equipos no mantengan versiones en conflicto.

En la práctica, cada métrica tiene:

Empieza inventariando los KPI que aparecen en revisiones ejecutivas, reportes de finanzas y los dashboards principales, y luego compara las definiciones lado a lado.

Señales comunes de alarma:

La mayoría de los equipos cubren bien los casos con estos objetos:

Busca campos que respondan: ¿Qué es? ¿Cómo se calcula? ¿Cuándo debo usarla?

Un conjunto “requerido” práctico:

Usa un flujo basado en estados que controle qué se puede editar y qué es “oficial”:

Además, guarda un registro de propuesta que capture .

Define roles claros y enlázalos con permisos:

Versiona cada vez que un cambio pueda alterar la interpretación (definición, lógica, filtros, grano, umbrales o incluso renombrados).

Incluye un changelog legible:

Soporta fechas efectivas para mostrar definiciones actuales, próximas y pasadas sin reescribir la historia.

Usa RBAC + propiedad a nivel de recurso:

Añade fricción extra para acciones sensibles (publicar/aprobar, deprecar/eliminar, cambiar propiedad/permisos) con avisos de confirmación y razones obligatorias.

Prioriza integraciones que reduzcan fricción diaria:

Trátalo como un despliegue de producto:

Para seguridad, almacena definiciones y metadatos, no datos raw de clientes ni secretos. Mantén logs de auditoría para cambios/aprobaciones, políticas de retención y copias de seguridad con pruebas de restauración.

Modela las relaciones explícitamente (por ejemplo, dashboards usan muchas métricas; métricas dependen de múltiples fuentes).

Haz de “métrica sin propietario” un estado de primera clase con reglas de escalado (sugerir automáticamente → asignación con límite de tiempo → escalar al responsable de gobernanza).