22 oct 2025·8 min

Cómo elegir el lenguaje de programación backend adecuado en 2026

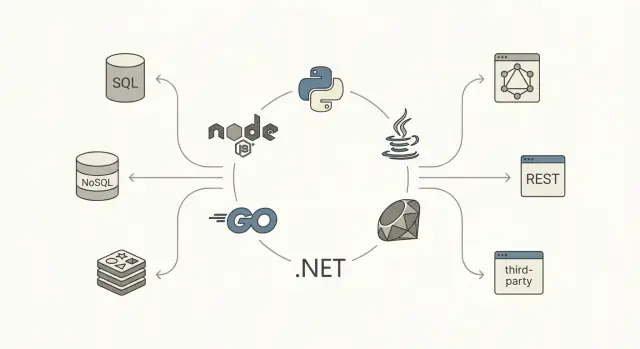

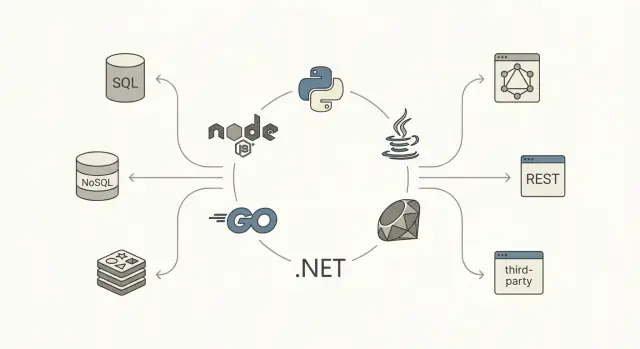

Compara Node.js, Python, Java, Go, .NET y Ruby para backend. Aprende las compensaciones en rendimiento, contratación, tooling, escalado y mantenimiento a largo plazo.

Compara Node.js, Python, Java, Go, .NET y Ruby para backend. Aprende las compensaciones en rendimiento, contratación, tooling, escalado y mantenimiento a largo plazo.

“Mejor lenguaje backend” suele ser una forma corta de decir “el que mejor encaja con lo que voy a construir, con las personas y las restricciones que tengo”. Un lenguaje puede ser perfecto para una carga de trabajo backend y un mal encaje para otra —incluso si es popular, rápido o querido por tu equipo.

Antes de comparar Node.js backend vs Python backend vs Java backend (y demás), nombra el trabajo que debe hacer tu backend:

Diferentes objetivos cambian el peso entre rendimiento y productividad. Un lenguaje que acelera la entrega de funciones para una API CRUD puede frenarte en streaming de alto rendimiento o sistemas de baja latencia.

Elegir un lenguaje backend muchas veces se decide por restricciones más que por características:

No hay un único mejor lenguaje backend en 2026—solo compensaciones. Ruby on Rails puede ganar en velocidad para construir producto, Go en simplicidad operativa, Java en ecosistemas maduros y tooling empresarial, y Node.js en tiempo real y alineación full‑stack JavaScript.

Al final de esta guía deberías poder elegir con confianza emparejando lenguaje con carga de trabajo, restricciones y responsabilidad a largo plazo—no por hype o rankings.

Elegir un lenguaje backend es menos sobre “qué es lo mejor” y más sobre qué optimiza tus resultados específicos. Antes de comparar Node.js con Python, o Java con Go, haz explícitos los criterios—si no, debatirás preferencias en vez de decidir.

Empieza con una lista corta que puedas puntuar:

Añade requisitos específicos del dominio (p. ej., tiempo real, procesamiento de datos pesado o cumplimiento estricto) como criterios adicionales.

TCO es el precio combinado de construir y poseer el sistema:

Un lenguaje que es rápido para prototipar puede volverse caro si causa incidentes frecuentes o código difícil de cambiar.

Algunas restricciones son innegociables: es mejor sacarlas a la luz pronto:

No trates cada criterio por igual. Si estás validando mercado, pondera más el tiempo‑al‑mercado. Si construyes una plataforma interna de larga vida, pondera mantenibilidad y estabilidad operativa. Una simple matriz de puntuación ponderada mantiene la conversación anclada y hace explícitos los trade‑offs para desarrollo de APIs y más allá.

Antes de comparar sintaxis o benchmarks, escribe qué debe hacer tu backend y cómo se va a moldear. Los lenguajes parecen “mejores” cuando casan con la carga de trabajo y la arquitectura que realmente construirás.

La mayoría de backends son una mezcla, pero lo dominante importa:

Si tu sistema es mayormente I/O‑bound, las primitivas de concurrencia, el tooling asíncrono y la ergonomía suelen importar más que la velocidad bruta. Si es CPU‑bound, el rendimiento predecible y la paralelización sencilla suben en prioridad.

La forma del tráfico cambia la presión sobre el lenguaje:

También anota las expectativas de latencia global y el SLA objetivo. Un SLA 99.9% con requisitos de p95 estrictos te empuja hacia runtimes maduros, buen tooling y patrones de despliegue probados.

Documenta tu camino de datos:

Finalmente, lista integraciones: APIs de terceros, mensajería/colas (Kafka, RabbitMQ, SQS) y trabajos en background. Si el trabajo asíncrono y consumidores de cola son centrales, elige un lenguaje/ecosistema donde workers, reintentos, patrones de idempotencia y monitorización sean pieza principal, no una ocurrencia tardía.

El rendimiento no es un solo número. Para backends suele descomponerse en latencia (qué tan rápido completa una petición), throughput (cuántas peticiones por segundo puedes servir) y uso de recursos (CPU, memoria, a veces red/I/O). El lenguaje y runtime afectan a los tres, sobre todo por cómo programan trabajo, gestionan memoria y tratan operaciones bloqueantes.

Un lenguaje que parece rápido en microbenchmarks puede producir mala latencia en cola (p95/p99) bajo carga—a menudo por contención, llamadas bloqueantes o presión de memoria. Si tu servicio es IO‑heavy (BD, cache, llamadas HTTP), las mayores mejoras suelen venir de reducir esperas y mejorar la concurrencia, no de recortar nanosegundos en cómputo puro.

Los distintos ecosistemas empujan enfoques diferentes:

Los runtimes gestionados por GC potencian la productividad, pero la tasa de asignación y el crecimiento del heap pueden afectar la latencia de cola por pausas o mayor CPU dedicada a la recolección. No necesitas ser un experto en GC—solo saber que “más asignaciones” y “objetos grandes” pueden convertirse en problemas de rendimiento a escala.

Antes de decidir, implementa (o prototipa) unos endpoints representativos y mide:

Trátalo como un experimento de ingeniería, no como una suposición. La mezcla de I/O, cómputo y concurrencia de tu carga hará que el “lenguaje más rápido” luzca distinto en la práctica.

Rara vez un lenguaje triunfa solo por su sintaxis. La experiencia diaria la moldean el ecosistema: qué tan rápido puedes generar servicios, evolucionar esquemas, asegurar endpoints, probar cambios y desplegar con seguridad.

Busca frameworks que casen con tu estilo preferido (minimalista vs batteries‑included) y tu arquitectura (monolito, monolito modular, microservicios). Un ecosistema sano suele tener al menos una opción “por defecto” ampliamente adoptada y buenas alternativas.

Fíjate en lo poco glamuroso: ORMs maduros o query builders, migraciones fiables, librerías de autenticación/autorización, validación de entradas y tooling para trabajos en background. Si estas piezas están fragmentadas o obsoletas, los equipos tienden a reimplementar básicos y acumular patrones inconsistentes.

El mejor gestor de paquetes es el que tu equipo puede operar con predictibilidad. Evalúa:

También revisa la cadencia de releases del lenguaje y framework. Releases rápidas pueden ser magníficas—si tu organización puede seguirles el ritmo. En entornos regulados o con muchos servicios, una cadencia lenta y LTS puede reducir riesgo operativo.

Los backends modernos necesitan observabilidad de primera clase. Asegúrate de que el ecosistema tiene opciones maduras para logging estructurado, métricas (Prometheus/OpenTelemetry), tracing distribuido y profiling.

Una prueba práctica: ¿puedes ir de “subida de p95” a un endpoint/consulta/llamada dependiente específica en minutos? Los lenguajes con integraciones sólidas de profiling y tracing ahorran mucho tiempo de ingeniería anualmente.

Las restricciones operativas deben influir en la elección. Algunos runtimes brillan en contenedores con imágenes pequeñas y arranque rápido; otros en servicios de larga vida con comportamiento de memoria predecible. Si serverless está sobre la mesa, importan características como cold‑start, límites de empaquetado y gestión de conexiones.

Antes de comprometerte, construye una rebanada vertical fina y despliega de la forma en que piensas correrla (por ejemplo, en Kubernetes o en una plataforma de funciones). A menudo revela más que leer listas de características.

La mantenibilidad trata menos sobre “código bonito” y más sobre cuán rápido un equipo puede cambiar comportamiento sin romper producción. La elección del lenguaje influye por sistemas de tipos, tooling y normas del ecosistema.

Los lenguajes fuertemente tipados (Java, Go, C#/.NET) tienden a hacer los refactors grandes más seguros porque el compilador actúa como un segundo revisor.\n Los lenguajes dinámicos (Python, Ruby, JavaScript sin TypeScript) pueden ser muy productivos, pero la corrección depende más de convenciones, cobertura de tests y comprobaciones en runtime. Si eliges este camino, el “tipado gradual” ayuda: TypeScript para Node.js o hints de tipo + comprobador (mypy/pyright) para Python. La clave es la consistencia—el código medio‑tipado puede ser peor que cualquiera de los extremos.

Los sistemas backend fallan en los límites: formatos request/response, payloads de eventos y mapeos a BD. Un stack mantenible hace los contratos explícitos.

OpenAPI/Swagger es la base común para APIs HTTP. Muchos equipos lo emparejan con validación de esquemas y DTOs para evitar APIs “stringly‑typed”. Ejemplos en la práctica:

El soporte para generación de código importa: generar clientes/servidores/DTOs reduce la deriva y mejora la incorporación.

Los ecosistemas difieren en cómo los tests encajan en el flujo de trabajo. Node usa comúnmente Jest/Vitest con feedback rápido. Pytest en Python es expresivo y destaca en fixtures. JUnit/Testcontainers en Java es fuerte para tests de integración. El paquete testing de Go fomenta tests directos, mientras que xUnit/NUnit en .NET se integra con IDEs y CI. La cultura de RSpec en Ruby es opinionada y legible.

Una regla práctica: elige el ecosistema donde a tu equipo le sea más fácil ejecutar tests localmente, mockear dependencias de forma limpia y escribir tests de integración sin demasiada ceremonia.

Elegir un lenguaje backend también es una decisión de personal. Un lenguaje “ideal” en papel puede resultar caro si no puedes contratar, incorporar y retener gente que lo opere con confianza.

Haz inventario de fortalezas actuales: no solo quién puede escribir código, sino quién puede depurar producción, afinar rendimiento, configurar CI, manejar incidentes y revisar PRs con rapidez.

Una regla simple que suele funcionar: prefiere lenguajes que el equipo pueda operar bien, no solo escribir. Si la rotación on‑call ya sufre con observabilidad, despliegues o bugs de concurrencia, añadir un runtime o paradigma nuevo puede amplificar el riesgo.

Los mercados de contratación varían según geografía y nivel. Por ejemplo, puedes encontrar muchos juniors de Node.js o Python localmente, pero menos seniors con experiencia profunda en ajuste de JVM o concurrencia en Go—o viceversa, según tu región.

Al evaluar “disponibilidad”, mira:

Incluso buenos ingenieros necesitan tiempo para ser efectivos en un nuevo ecosistema: modismos, frameworks, prácticas de testing, gestión de dependencias y tooling de despliegue. Estima onboarding en semanas, no días.

Preguntas prácticas:

Optimizar por velocidad inicial puede salir mal si al equipo no le gusta mantener el stack. Considera cadencia de upgrades, churn en frameworks y cuán agradable es el lenguaje para tests, refactors y rastrear bugs.

Si esperas rotación, prioriza legibilidad, tooling predecible y un bancaje profundo de mantenedores—porque la “propiedad” dura más que el primer lanzamiento.

Node.js destaca en APIs I/O‑heavy, chat, herramientas de colaboración y características en tiempo real (WebSockets, streaming). Un stack común es TypeScript + Express/Fastify/NestJS, a menudo con PostgreSQL/Redis y colas.

Los escollos habituales son trabajo CPU que bloquea el event loop, proliferación de dependencias e tipado inconsistente si te quedas en JavaScript plano. Cuando el rendimiento importa, desplaza el cómputo pesado a workers/servicios y mantén TypeScript estricto + linting.

Python es líder en productividad, especialmente para backends que tocan analítica, ML, ETL y automatización. Los frameworks suelen dividirse entre Django (baterías incluidas) y FastAPI (moderno, tipado, API‑first).

El rendimiento suele ser “suficiente” para muchos sistemas CRUD, pero las rutas calientes pueden ser costosas a escala. Estrategias comunes: I/O asíncrono, caching, mover cómputo a servicios especializados o usar runtimes/extensiones más rápidas cuando se justifique.

Java sigue siendo un default fuerte para sistemas empresariales: tooling JVM maduro, rendimiento predecible y un ecosistema profundo (Spring Boot, Quarkus, Kafka, tooling de observabilidad). La madurez en operaciones es una gran ventaja: los equipos saben desplegar y ejecutarlo.

Casos típicos: APIs de alto throughput, dominios complejos y entornos regulados donde la estabilidad y el soporte a largo plazo importan.

Go encaja en microservicios y servicios de red donde concurrencia y simplicidad son prioridades. Las goroutines hacen que “muchas cosas a la vez” sea sencillo, y la librería estándar es práctica.

Compensaciones: menos frameworks batteries‑included que Java/.NET, y puede que escribas más plumbing (aunque eso puede ser una característica).

El .NET moderno (ASP.NET Core) es excelente para APIs empresariales, con tooling fuerte (Visual Studio, Rider), gran rendimiento y buena paridad Windows/Linux. Un stack común es ASP.NET Core + EF Core + SQL Server/PostgreSQL.

Ruby on Rails sigue siendo una de las maneras más rápidas de lanzar un producto web pulido. El escalado suele solucionarse extrayendo cargas pesadas a jobs y servicios en background.

La contrapartida es el throughput bruto por instancia; normalmente escalas horizontalmente e inviertes antes en caché y colas.

Rara vez hay un único “mejor” lenguaje—solo el que mejor encaja con carga, equipo y perfil de riesgo. Aquí patrones comunes y los lenguajes que suelen casar.

Si la velocidad de iteración y contratar generalistas importan, Node.js y Python son elecciones frecuentes. Node.js brilla cuando el mismo equipo quiere compartir TypeScript front/backend y cuando el desarrollo de API es mayormente I/O‑bound. Python es fuerte para productos data‑heavy, scripting y equipos que prevén integrar analítica/ML temprano.

Ruby on Rails sigue siendo una gran “fábrica de funcionalidades” cuando el equipo conoce Rails y se construye una app web convencional con mucho CRUD y workflows administrativos.

Para servicios donde dominan latencia, throughput y uso de recursos predecible, Go es un default común: arranque rápido, modelo de concurrencia simple y fácil containerización. Java y .NET también son excelentes, sobre todo si necesitas profiling maduro, ajuste JVM/CLR y librerías probadas para sistemas distribuidos.

Si esperas conexiones de larga duración (streaming, websockets) o alto fan‑out, prioriza el comportamiento del runtime bajo carga y el tooling operativo más que microbenchmarks.

Para herramientas internas, el tiempo del desarrollador suele costar más que el cómputo. Python, Node.js y .NET (especialmente en organizaciones con fuerte presencia Microsoft) suelen ganar por entrega rápida, librerías fuertes e integración sencilla con sistemas existentes.

En escenarios de cumplimiento (auditabilidad, controles de acceso, ciclos largos de soporte), Java y .NET tienden a ser las opciones más seguras: prácticas de seguridad maduras, patrones de gobernanza establecidos y opciones LTS predecibles. Esto importa cuando “¿Quién puede aprobar una dependencia?” pesa tanto como rendimiento vs productividad.

Un monolito suele beneficiarse de un único lenguaje primario para simplificar onboarding y mantenimiento. Los microservicios pueden justificar más diversidad—pero solo cuando los equipos son verdaderamente autónomos y la plataforma (CI/CD, observabilidad, estándares) es robusta.

Una división pragmática es común: p. ej., Java/.NET/Go para APIs núcleo y Python para pipelines de datos. Evita la poliglotía “por preferencia” temprano; cada nuevo lenguaje multiplica la respuesta a incidentes, la revisión de seguridad y la sobrecarga de propiedad.

Elegir un lenguaje es más fácil tratándolo como una decisión de producto: define restricciones, puntúa opciones y valida con un PoC. La meta no es perfecta, sino defendible y explicable ante tu equipo y futuros contratados.

Empieza con dos listas:

Si un lenguaje falla un imprescindible, queda fuera—no hay debate de puntuación. Esto evita parálisis por análisis.

Crea una matriz corta y sé consistente entre candidatos.

| Criterio | Peso (%) | Puntuación (1–5) | Puntuación ponderada |

|---|---|---|---|

| Ajuste rendimiento & concurrencia | 20 | ||

| Ecosistema & librerías (BD, auth, colas) | 20 | ||

| Productividad del desarrollador | 15 | ||

| Contratación & mantenibilidad a largo plazo | 15 | ||

| Encaje operativo (despliegue, observabilidad) | 15 | ||

| Seguridad & corrección (tipado, tooling) | 15 |

Cómo calcular: Puntuación ponderada = Peso × Puntuación. Suma totales por lenguaje. Mantén a ~5–7 criterios para que los números sigan siendo significativos.

Checklist PoC (limítalo en tiempo a 1–3 días por lenguaje):

Decide de antemano qué significa “bien”:

Vuelve a puntuar los resultados del PoC en la matriz, luego elige la opción con mejor total y con menos riesgos en los imprescindibles.

La elección suele fallar cuando se hace de afuera hacia adentro—por lo que está de moda, lo que un talk alabó o lo que ganó un benchmark.

Un microbenchmark rara vez refleja tus cuellos de botella reales: consultas BD, APIs de terceros, serialización o latencia de red. Trata afirmaciones de “más rápido” como una pregunta inicial, no como un veredicto. Valida con un PoC fino que refleje patrones de acceso a datos, tamaños de payload y perfil de concurrencia.

Muchos equipos eligen un lenguaje productivo en código y pagan el precio en producción:

Si la organización no puede soportar el modelo operativo, el lenguaje no la salvará.

Asegurar el futuro a menudo significa no apostar todo de una vez. Favorece la migración incremental:

Significa el mejor ajuste para tu carga de trabajo, equipo y restricciones, no un ganador universal. Un lenguaje puede ser excelente para una API CRUD y no encajar para sistemas de streaming con baja latencia o para procesamiento intensivo en CPU. Toma la decisión con base en necesidades medibles (latencia, rendimiento, operaciones, contratación), no en rankings.

Empieza por escribir la carga de trabajo dominante:

Luego elige lenguajes cuyo modelo de concurrencia y ecosistema encajen con esa carga y valida con un pequeño PoC.

Usa una lista corta y puntuable:

Añade requisitos duros como cumplimiento, restricciones serverless o SDKs obligatorios.

El TCO incluye construir y mantener el sistema:

Un lenguaje que prototipa rápido puede ser caro si incrementa incidentes o hace los cambios riesgosos.

La concurrencia determina cómo tu servicio maneja muchas peticiones simultáneas y esperas largas en BD/HTTP/colas:

Porque en producción lo que duele es la latencia de cola (p95/p99), no la media. Los runtimes con GC pueden mostrar picos de latencia si la tasa de asignación y el crecimiento del heap son altos. La aproximación práctica es medir las rutas críticas reales y supervisar CPU/memoria bajo carga, en lugar de fiarse de microbenchmarks.

Haz una rebanada vertical del sistema que refleje trabajo real:

Pónlo en un límite temporal (1–3 días por lenguaje) y compara con objetivos predefinidos.

Depende de cómo quieras imponer la corrección:

Porque la propiedad en producción es tan importante como escribir código. Pregúntate:

Errores comunes:

Ajusta el modelo al workload dominante y a la madurez operativa del equipo.