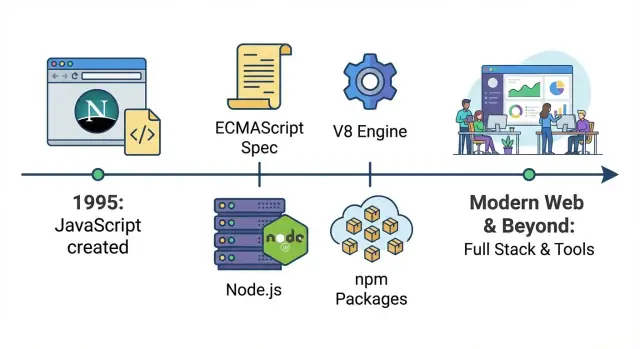

Un mapa rápido de la conquista de JavaScript

JavaScript nació como una forma de añadir un poco de interactividad a las páginas web: pequeños scripts que validaban un formulario, cambiaban una imagen o mostraban un desplegable. Esta guía sigue cómo ese “lenguaje ayudante” se convirtió en una plataforma de toda la empresa: la misma tecnología central hoy ejecuta interfaces de usuario, servidores, sistemas de construcción, automatizaciones y herramientas internas.

Qué significa “lenguaje por defecto de la web”

En términos prácticos, JavaScript es el único lenguaje que cada navegador mainstream puede ejecutar directamente. Si envías código a usuarios sin pedirles que instalen nada, JavaScript es la opción universal. Otros lenguajes pueden participar, pero normalmente compilando a JavaScript o ejecutándose en un servidor; JavaScript, en cambio, se ejecuta en el destino por defecto.

Las tres eras que verás

La primera es la era del navegador, donde JavaScript se convirtió en la forma estándar de controlar la página: reaccionar a clics, manipular el DOM y, con el tiempo, impulsar experiencias más ricas a medida que la web superaba los documentos estáticos.

La segunda es la era del backend, cuando motores más rápidos y Node.js hicieron práctico ejecutar JavaScript en servidores. Eso desbloqueó un lenguaje compartido entre frontend y backend, además de un ecosistema de paquetes que aceleró la reutilización.

La tercera es la era de las operaciones de negocio, donde las herramientas JavaScript se volvieron “el pegamento”: pipelines de build, testing, design systems, dashboards, scripts de automatización e integraciones. Incluso equipos que no se consideran “equipos JavaScript” a menudo dependen de herramientas basadas en JavaScript a diario.

Qué esperar de esta guía

Nos centraremos en los puntos de inflexión principales: estandarización, saltos de rendimiento, Node.js, npm y el cambio hacia aplicaciones basadas en frameworks—más que en catalogar cada librería o moda.

El origen: scripting dentro del navegador

JavaScript se creó en 1995 en Netscape como una manera sencilla de añadir interactividad a páginas web sin requerir un viaje al servidor o una “instalación” completa. Brendan Eich construyó la primera versión rápidamente, y el objetivo original fue modesto: permitir a autores web validar formularios, reaccionar a clics y hacer que las páginas se sintieran menos estáticas.

Una web hecha de páginas pequeñas y máquinas lentas

Las limitaciones tempranas de la web dieron forma a lo que JavaScript podía ser. Los ordenadores eran más lentos, los navegadores eran básicos y la mayoría de sitios eran mayormente texto con algunas imágenes. Los scripts tenían que ser ligeros y tolerantes: pequeños fragmentos que pudieran ejecutarse sin congelar la página.

Como las páginas eran sencillas, el JavaScript primitivo a menudo parecía “un poco de lógica” salpicada dentro del HTML: comprobar si un campo de email contenía un @, mostrar una alerta o cambiar una imagen al pasar el ratón por un enlace.

“Escribir código dentro de la página” fue un gran cambio

Antes de esto, una página web hacía básicamente lo que mostraba: presentaba contenido. Con JavaScript embebido en la página, podía responder inmediatamente a acciones del usuario. Incluso un script diminuto podía:

- Detener el envío de un formulario hasta que se completaran campos obligatorios

- Actualizar texto en la página tras un clic

- Realizar pequeños cálculos sin contactar al servidor

Fue el comienzo de que el navegador se convirtiera en un runtime de aplicaciones—no solo en un visor de documentos.

El dolor temprano: comportamiento inconsistente

La contrapartida era la imprevisibilidad. Los navegadores no siempre interpretaban JavaScript igual, y las APIs para interactuar con la página (comportamiento temprano del DOM, modelos de eventos y métodos de elementos) variaban mucho. Los desarrolladores tenían que escribir rutas de código diferentes según el navegador, probar constantemente y aceptar que algo que funcionaba en una máquina podía romper en otra.

Competencia de navegadores y el empuje a estandarizar (ECMAScript)

Las “guerras de navegadores” en términos sencillos

A finales de los 90 y principios de los 2000, los navegadores competían agresivamente sacando características lo más rápido posible. Netscape e Internet Explorer no solo corrían por velocidad: competían en comportamientos de JavaScript, APIs del DOM y extensiones propietarias.

Para los desarrolladores, esto significaba que el mismo script podía funcionar en un navegador y romper en otro. Verías bugs que no eran “tu culpa”: diferentes modelos de eventos, métodos ausentes y casos borde inconsistentes. Publicar un sitio a menudo requería escribir dos versiones de la misma lógica, más hacks de detección de navegador.

ECMAScript: el contrato detrás de JavaScript

Para reducir el caos, JavaScript necesitaba una definición compartida que no estuviera controlada por un único proveedor de navegador. Esa definición se convirtió en ECMAScript—el estándar que describe el núcleo del lenguaje (sintaxis, tipos, funciones, objetos, etc.).

Un modelo mental útil:

- JavaScript es lo que ejecutan los navegadores (y más tarde los servidores).

- ECMAScript es el libro de reglas que los motores de JavaScript intentan seguir.

Cómo ayudó la estandarización (despacio)

Una vez que los proveedores se alinearon en versiones de ECMAScript, el lenguaje se volvió más predecible entre navegadores. Las incompatibilidades no desaparecieron de la noche a la mañana—las APIs fuera del núcleo del lenguaje (como partes del DOM) seguían variando—pero la base se estabilizó. Con el tiempo, mejores suites de pruebas y expectativas compartidas hicieron que “funciona en mi navegador” fuera menos aceptable.

Por qué los patrones antiguos nunca murieron por completo

Aunque ECMAScript evolucionó, la retrocompatibilidad se volvió una promesa innegociable: los sitios antiguos debían seguir funcionando. Por eso los patrones legados—var, reglas extrañas de igualdad y soluciones previas a módulos—permanecieron en el ecosistema. La web no podía permitirse un reinicio radical, así que JavaScript creció añadiendo nuevas características en lugar de eliminar las viejas.

Ajax y el auge de las aplicaciones web reales

Antes de Ajax, la mayoría de sitios se comportaban como formularios en papel: haces clic o envías un formulario, el navegador recarga la página por completo y esperas a que el servidor devuelva un HTML nuevo.

Ajax (abreviatura de “Asynchronous JavaScript and XML”, aunque JSON pronto se convirtió en la verdadera estrella) cambió ese patrón. Con JavaScript, una página podía solicitar datos al servidor en segundo plano y actualizar solo la parte que necesitaba cambiar—sin recarga completa.

Actualizar partes de una página sin recargar

Ajax hizo que la web se sintiera menos como una serie de cargas de página y más como un programa interactivo. Un cuadro de búsqueda podía mostrar sugerencias mientras escribes. El total del carrito podía actualizarse al instante. Los comentarios podían aparecer después de publicarlos sin devolverte al inicio de la página.

Esto no fue solo una interfaz más agradable: redujo fricción. La gente dejó de tolerar “clic → espera → recarga” para cada pequeña acción.

Experiencias tipo Gmail redefinieron expectativas

Productos como Gmail demostraron que el navegador podía manejar interacciones tipo app: actualizaciones rápidas de la bandeja, etiquetado instantáneo, navegación suave y menos interrupciones. Una vez que los usuarios experimentaron esa capacidad de respuesta, pasó a ser la expectativa base para otros sitios.

APIs + JSON convirtieron al navegador en un cliente serio

Ajax empujó a los equipos a separar “datos” de “página”. En vez de enviar un HTML entero cada vez, los servidores empezaron a exponer APIs que devolvían datos estructurados (a menudo JSON). El navegador, potenciado por JavaScript, se convirtió en un cliente real responsable de renderizar, interacciones y estado.

El coste: más lógica se movió al frontend

La desventaja fue la complejidad. Más lógica de aplicación se trasladó al navegador: validación, estado de UI, caching, manejo de errores y preocupaciones de rendimiento. Eso preparó el terreno para herramientas de frontend más pesadas y, eventualmente, aplicaciones de una sola página completas donde el servidor provee principalmente APIs y el frontend actúa como una app real.

jQuery, el DOM y hacer JavaScript accesible

El JavaScript temprano no era difícil porque el lenguaje fuera imposible: era difícil por el entorno del navegador. Trabajar con el DOM implicaba lidiar con distintos modelos de eventos, APIs inconsistentes y peculiaridades de layout que cambiaban según el navegador de los usuarios. Incluso tareas básicas como “buscar este elemento y ocultarlo cuando se hace clic en un botón” podían convertirse en una pila de condicionales y soluciones específicas por navegador.

Por qué programar el DOM solía ser doloroso

Los desarrolladores pasaban mucho tiempo luchando contra la compatibilidad en lugar de construir funciones. Seleccionar elementos difería entre navegadores, adjuntar eventos no era consistente y manipular estilos podía comportarse de forma inesperada. El resultado: muchos equipos evitaban código cliente pesado o recurrían a soluciones no nativas como Flash y otros plugins para experiencias más ricas.

Cómo jQuery lo hizo simple

El gran truco de jQuery fue sencillo: ofrecía una API pequeña y legible y manejaba las diferencias entre navegadores tras bambalinas. Una única sintaxis de selectores funcionaba casi en todas partes, el manejo de eventos se volvió predecible y efectos comunes estaban a un llamado de función. En lugar de aprender diez reglas específicas de navegador, la gente aprendía “la forma jQuery” y entregaba resultados rápidamente.

Esa facilidad tuvo importancia cultural. JavaScript se convirtió en el primer lenguaje que muchos desarrolladores web aprendieron porque era el camino hacia progreso visible. Tutoriales, fragmentos y plugins se difundieron rápido; podías copiar unas líneas y publicar algo que pareciera moderno.

Cuando la era de plugins decayó, JavaScript ganó por defecto

A medida que los navegadores mejoraron y los plugins dejaron de ser aceptables (problemas de seguridad, falta de soporte móvil y preocupaciones de rendimiento), los equipos eligieron cada vez más tecnología web nativa. jQuery ayudó a tender ese puente: bajó la barrera para programar el DOM, y cuando la plataforma maduró, una generación ya conocía JavaScript lo suficiente como para construir la siguiente ola.

Reduce costos con créditos ganados

Obtén créditos por crear contenido sobre Koder.ai o por referir a otros usuarios.

Durante años, la mayor limitación de JavaScript no fueron la sintaxis o las características, sino la velocidad. Las páginas tempranas podían tolerar ejecución lenta porque los scripts eran pequeños: validar un formulario, alternar un menú, añadir un poco de interactividad. Cuando los desarrolladores intentaron construir aplicaciones completas en el navegador, el rendimiento se volvió el techo.

Qué es V8 (y por qué importó)

V8 es el motor de JavaScript de Google, creado para Chrome. Un “motor” es la parte del navegador que lee tu JavaScript y lo ejecuta. El avance de V8 fue tratar JavaScript menos como un lenguaje interpretado lento y más como código que puede optimizarse agresivamente en tiempo de ejecución.

En términos simples: V8 mejoró dramáticamente en convertir JavaScript en instrucciones de máquina de forma rápida, y luego re-optimizar las rutas calientes a medida que aprendía cómo se comportaba tu programa. Eso redujo el lag, suavizó animaciones y acortó el tiempo entre un clic del usuario y la respuesta en pantalla.

La ejecución más rápida permitió apps más grandes y UIs más ricas

Cuando JavaScript se volvió más rápido, los equipos pudieron mover más lógica al navegador sin que la experiencia se viniera abajo. Eso cambió lo que era “razonable” construir:

- Interfaces complejas (bandejas, dashboards, editores) que se comportan más como software de escritorio

- Actualizaciones intensas del DOM sin congelar la página tan a menudo

- Más cómputo en el cliente (filtrado, ordenado, renderizado) en vez de round-trips al servidor

El rendimiento no solo mejoró sitios existentes: amplió la categoría de software que la web podía hospedar.

El bucle de retroalimentación que aceleró todo

Una dinámica clave se puso en marcha:

Mejores motores → desarrolladores escriben más JavaScript → usuarios pasan más tiempo en apps pesadas en JS → los navegadores invierten más en motores.

A medida que las empresas competían por cuota de mercado de navegadores, la velocidad pasó a ser una característica destacada. Las aplicaciones web reales sirvieron de benchmark, y cada mejora animó a los desarrolladores a avanzar más.

Contexto: no fue solo V8

V8 no estuvo solo. SpiderMonkey (Mozilla/Firefox) y JavaScriptCore (Apple/Safari) también mejoraron rápido, cada uno con sus propias estrategias de optimización. Lo importante no es qué motor “ganó”, sino que la competencia convirtió el JavaScript rápido en una expectativa base.

Una vez que JavaScript se ejecutó lo bastante rápido como para impulsar interfaces exigentes de forma fiable, dejó de ser “solo un lenguaje de scripting para el navegador” y empezó a parecer una plataforma en la que los equipos podían apostar.

Node.js: JavaScript se traslada al backend

Node.js es un runtime que permite ejecutar JavaScript fuera del navegador. En lugar de escribir JavaScript solo para botones, formularios e interacciones de página, los desarrolladores pudieron usar el mismo lenguaje para construir servidores, herramientas de línea de comandos y jobs en background.

Por qué el event loop encaja con los servidores

Node.js está construido alrededor de un event loop: una forma de manejar muchas esperas—como solicitudes de red, consultas a bases de datos y lecturas de ficheros—sin crear un hilo separado por conexión.

Para muchas cargas web, los servidores pasan más tiempo esperando que computando. El modelo del event loop hizo práctico atender muchos usuarios concurrentes con código relativamente simple, especialmente para apps que se sienten “en vivo”, donde las actualizaciones deben empujarse con rapidez.

Casos de uso tempranos que lo probaron

Node.js ganó tracción donde la capacidad de respuesta importaba:

- Chat en tiempo real y apps colaborativas (mensajes y actualizaciones constantes)

- APIs ligeras que actúan entre frontend y base de datos

- Herramientas de desarrollo (scripts de build, servidores locales, automatización) que se benefician de JavaScript en todas partes

Aunque los equipos mantenían sistemas críticos en otros lenguajes, Node.js a menudo se convirtió en el servicio pegamento: manejando peticiones, orquestando llamadas a otros sistemas o alimentando utilidades internas.

Un lenguaje de punta a punta

Un gran cambio fue tanto cultural como técnico. Cuando frontend y backend usan JavaScript, los equipos pueden compartir reglas de validación, modelos de datos e incluso partes de la lógica de negocio. Los desarrolladores cambian menos de contexto entre ecosistemas, lo que ayuda a equipos pequeños a moverse más rápido y facilita a equipos grandes estandarizar cómo construyen y revisan código.

npm y el ecosistema que escaló el alcance de JavaScript

Genera un backend API en Go

Añade un backend en Go con PostgreSQL que se integre con tu frontend sin cambiar de herramientas.

npm (Node Package Manager) es la “tienda de apps” para código JavaScript. En lugar de escribirlo todo desde cero—manejo de fechas, enrutado, testing, widgets UI—los equipos podían instalar un paquete e ir adelante. Ese flujo (“instala, importa, publica”) aceleró el desarrollo y convirtió a JavaScript en algo más que un lenguaje: en una caja de herramientas compartida.

Por qué compartir paquetes aceleró la adopción

Una vez que Node.js hizo útil a JavaScript fuera del navegador, npm dio a los desarrolladores una forma estándar de publicar y reutilizar módulos. Una librería pequeña creada para un proyecto podía beneficiar a miles de otros. El resultado fue progreso compuesto: cada nuevo paquete hizo que el siguiente proyecto fuera más rápido de construir.

Las librerías open source también redujeron el coste de experimentar. Una startup podía montar un producto creíble con un equipo pequeño apoyándose en paquetes mantenidos por la comunidad para logging, helpers de autenticación, herramientas de build y más.

Semver y lockfiles (sin jerga)

La mayoría de paquetes npm sigue semantic versioning (semver), una versión en tres partes como 2.4.1:

- Major (

2) puede romper compatibilidad.

- Minor (

4) añade funciones de forma compatible.

- Patch (

1) corrige bugs.

Los lockfiles (como package-lock.json) registran las versiones exactas instaladas para que todos en el equipo—y tu CI—obtengan el mismo conjunto de dependencias. Esto evita sorpresas del tipo “funciona en mi máquina” causadas por pequeñas diferencias de versión.

Los trade-offs: proliferación de dependencias y mantenimiento

La contrapartida de instalar fácil es sobreuso fácil. Los proyectos pueden acumular cientos de dependencias indirectas, aumentando el trabajo de actualización y el riesgo de la cadena de suministro. Algunos paquetes quedan sin mantenimiento, forzando a los equipos a fijar versiones antiguas, reemplazar librerías o asumir mantenimiento ellos mismos. El ecosistema permitió velocidad—pero también convirtió la higiene de dependencias en una parte real del envío de software.

Los frontends maduran: SPAs, frameworks y código compartido

Los primeros sitios ensamblaban páginas en el servidor. Luego las Single-Page Applications (SPAs) invirtieron el modelo: el navegador se convirtió en el “runtime de la app”, pidiendo datos y renderizando UI sin recargas completas.

Ese cambio no solo alteró el código: cambió responsabilidades. El trabajo frontend pasó de “hacer que esta página se vea bien” a encargarse del enrutado, estado, caching, accesibilidad y presupuestos de rendimiento. Diseñadores, ingenieros backend y equipos de producto empezaron a colaborar en componentes y flujos de usuario, no solo en plantillas.

Los frameworks hicieron manejable la complejidad

A medida que las SPAs crecieron, el JavaScript ad-hoc se volvió difícil de mantener. React, Angular y Vue ayudaron ofreciendo patrones para organizar la complejidad UI:

- Estructura basada en componentes (UI como bloques reutilizables)

- Gestión de estado predecible (menos “¿dónde cambió este valor?”)

- Flujo de datos más claro entre UI y APIs

Diferentes ecosistemas hicieron distintos trade-offs, pero la gran victoria fue tener convenciones compartidas. Cuando llega un nuevo ingeniero, puede reconocer el mismo modelo mental en pantallas y funciones.

SSR y apps “universales”: puente a sitios más rápidos y descubribles

Las SPAs a veces sufrían en la primera carga y SEO, porque el navegador tenía que descargar y ejecutar mucho JavaScript antes de mostrar contenido.

El Server-Side Rendering (SSR) y las apps “universales” solucionaron eso: renderizan la primera vista en el servidor para una visualización e indexación rápidas y luego “hidratan” en el navegador para interactividad. Este enfoque se volvió común con frameworks como Next.js (React) y Nuxt (Vue), especialmente para páginas con mucho contenido y comercio electrónico.

El código compartido cambió cómo las empresas construyen productos

Una vez que frontend y backend eran ambos compatibles con JavaScript, los equipos empezaron a compartir lógica en toda la pila:

- Reglas de validación usadas en formularios y en el servidor

- Tipos/interfaces (a menudo vía TypeScript) para reducir desajustes de API

- Clientes de API compartidos y manejo de errores

El resultado: menos reglas duplicadas, entrega de funcionalidades más rápida y un empuje hacia pensar en “una base de código de producto” en varios equipos.

TypeScript y el JavaScript moderno para equipos grandes

A medida que JavaScript pasó de “un poco de scripting en el navegador” a aplicaciones críticas, los equipos empezaron a entender “JavaScript” como una familia de herramientas: características modernas de ECMAScript, pipelines de build y, con frecuencia, TypeScript.

Por qué TypeScript se hizo común (aunque la gente diga “JavaScript”)

TypeScript sigue siendo JavaScript en el fondo—solo añade un sistema de tipos y un paso de compilación. Eso facilita la adopción gradual: puedes empezar tipeando unos archivos difíciles, mantener el resto como .js y aun así desplegar una app empaquetada.

Por eso muchos equipos dicen que “escriben JavaScript” incluso cuando la base de código es mayormente .ts: el runtime es JavaScript, el ecosistema es JavaScript (paquetes npm, APIs del navegador, Node.js) y la salida de TypeScript es JavaScript.

Cómo los tipos ayudan a equipos grandes a moverse más rápido con menos errores

Cuando una base de código crece, lo más difícil no es escribir nuevas funciones sino cambiar las antiguas de forma segura. Los tipos actúan como contratos ligeros:

- Si renombras una propiedad o cambias la entrada de una función, tu editor y build señalarán cada lugar que quedó sin actualizar.

- El autocompletado es más preciso, así los desarrolladores pasan menos tiempo buscando en docs y código.

- Las revisiones son más sencillas porque muchos errores “obvios” (orden de argumentos, campos faltantes, problemas con null/undefined) se detectan antes de hacer merge.

El beneficio principal es confianza: los equipos pueden refactorizar y lanzar cambios con menos regresiones.

El JavaScript moderno evoluciona rápido, pero no todos los navegadores o entornos soportan cada característica al instante. Transpilación es simplemente:

- Escribe código moderno (y TypeScript)

- Compílalo a JavaScript ampliamente compatible que corra donde lo necesites

Esto permite usar sintaxis nueva sin esperar a que todos los dispositivos en el campo la soporten.

Estándares modernos que cambiaron el día a día de JavaScript

Muchas de las cosas que hicieron que el “JavaScript moderno” pareciera maduro son características estandarizadas que mejoraron la estructura y legibilidad:

- Módulos ES (

import/export) para código limpio y reutilizable

- async/await para lógica asíncrona más clara que callbacks anidados

- Actualizaciones continuas de ECMAScript (mejores utilidades de objetos/arrays, operadores más seguros, iteración mejorada)

En conjunto, TypeScript más ECMAScript moderno convirtieron proyectos JavaScript en algo escalable: más fácil de mantener, de incorporar a nuevos integrantes y menos arriesgado de cambiar.

Conserva la propiedad de tu código

Genera primero y luego exporta el código fuente cuando quieras tener control total.

JavaScript no se volvió “general dentro de la empresa” solo porque pudiera ejecutarse en navegadores y servidores. También se convirtió en el lenguaje que muchos equipos usan para ejecutar el trabajo: construir, probar, publicar y automatizar tareas diarias. Cuando eso sucedió, JavaScript dejó de ser solo un lenguaje de apps y pasó a actuar como una capa de operaciones internas.

Herramientas de build, testing y automatización

A medida que los frontends se complicaron, los equipos necesitaron builds repetibles y verificaciones confiables. Las herramientas basadas en JavaScript hicieron que eso resultara natural porque viven en el mismo repositorio y usan el mismo ecosistema de paquetes.

Un setup típico puede incluir:

- Scripts de build y bundling para producir assets listos para producción

- Linting y formateo para mantener el código legible entre equipos

- Tests unitarios y end-to-end para atrapar regresiones antes del despliegue

- Pequeños scripts de automatización para migraciones, procesamiento de contenido o release notes

Como estas herramientas corren en cualquier máquina de desarrollador y en CI, reducen el problema de “funciona en mi laptop”.

En la práctica, esta cadena de herramientas “JavaScript en todas partes” también hace posibles flujos de trabajo modernos de iteración veloz: cuando UI, build y despliegue siguen convenciones, puedes generar e iterar aplicaciones reales rápido. Plataformas como Koder.ai aprovechan esa realidad—permitiendo a equipos describir una app en chat y producir proyectos listos para producción (comúnmente React en frontend) con exportación de código, despliegue/alojamiento, dominios personalizados y snapshots/rollback para iterar con seguridad.

Código compartido a escala: monorepos y design systems

Las empresas en crecimiento a menudo optan por monorepos para que múltiples apps compartan dependencias, configuraciones y convenciones. Eso facilita mantener librerías de componentes compartidos, SDKs internos y design systems—sin copiar código entre proyectos.

Cuando un botón del design system recibe una corrección de accesibilidad, cada producto puede adoptarla mediante un solo bump de versión o paquete compartido. JavaScript (y cada vez más TypeScript) hace que ese compartir sea práctico porque los mismos componentes pueden alimentar prototipos, UI de producción y documentación.

Gates de calidad en CI/CD como estándar

Una vez estandarizados linting, tests y builds, se convierten en puertas de calidad en pipelines CI/CD: los merges quedan bloqueados si las comprobaciones fallan, los releases se automatizan y los traspasos entre equipos se suavizan. El resultado es menos conocimiento tribal, menos procesos ad-hoc y un camino más rápido de idea a característica entregada.

Qué no puede hacer bien JavaScript (y hacia dónde va)

JavaScript ahora corre casi en todas partes—dentro de contenedores en Kubernetes, como funciones serverless y cada vez más en el edge (CDNs y runtimes en el edge). Esa flexibilidad es una gran razón por la que los equipos lo estandarizan: un lenguaje, muchas opciones de despliegue.

Dónde JavaScript alcanza límites

JavaScript es excelente para trabajo intensivo en E/S (APIs, servidores web, manejo de eventos), pero flaquea cuando lo empujas a territorio de “cómputo pesado”.

- Techos de rendimiento: el JS compilado con JIT puede ser rápido, pero no sustituye a un rendimiento de bajo nivel y predecible. Servicios sensibles a latencia pueden sufrir pausas por GC.

- Uso de memoria: procesos Node.js grandes pueden consumir más memoria que servicios escritos en lenguajes optimizados para backends de larga vida.

- Trabajo CPU prolongado: procesamiento de vídeo, crunching de datos masivos, entrenamiento ML y otras tareas sostenidas suelen pertenecer a servicios especializados (o módulos nativos), con JS orquestando en lugar de ejecutar.

La seguridad es un centro de costes real

El ecosistema npm es una fortaleza—y un riesgo en la cadena de suministro. Los equipos maduros tratan las dependencias como proveedores externos: fijan versiones, automatizan auditorías, minimizan el recuento de dependencias y aplican gates de revisión para paquetes nuevos. “Rápido de añadir” debe equilibrarse con “seguro de ejecutar”.

Por qué importa para startups y empresas

Para startups, JavaScript reduce el time-to-market: habilidades compartidas entre frontend y backend, contratación rápida y despliegue directo desde serverless a contenedores según crece el tráfico. Para empresas, ofrece estandarización—a la vez que exige gobernanza (higiene de dependencias, pipelines de build, políticas de runtime).

Un patrón práctico cada vez más común es mantener JavaScript/TypeScript enfocado en la lógica de producto y experiencia de usuario, mientras se delegan partes sensibles en rendimiento o gobernanza a servicios en Go o Rust. Por eso los stacks híbridos son normales: por ejemplo, frontends React con backends en Go y PostgreSQL para rendimiento predecible y simplicidad operacional.

Qué sigue

WebAssembly seguirá ampliando lo práctico en runtimes web y server, permitiendo ejecutar código casi nativo junto a JavaScript. El futuro probable no es “JS lo sustituye todo”, sino JS sigue siendo el pegamento: coordinando servicios que mezclan TypeScript/JS con Rust/Go/Python donde encajen mejor.

A nivel de flujo de trabajo, el siguiente paso suele importar menos una nueva característica de sintaxis y más acortar bucles de retroalimentación: planificar, generar, revisar y desplegar software más rápido sin perder control. Ahí es donde herramientas como Koder.ai encajan naturalmente en un mundo dominado por JavaScript—ayudando a equipos a pasar de la idea a una app web/servidor/móvil funcional mediante chat, manteniendo siempre la opción de exportar y poseer el código cuando llega el momento de endurecer y escalar.