25 jul 2025·8 min

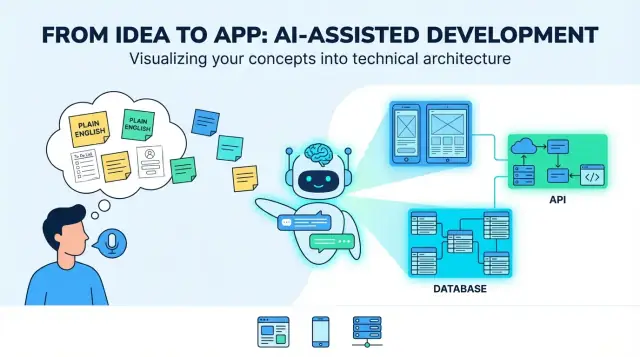

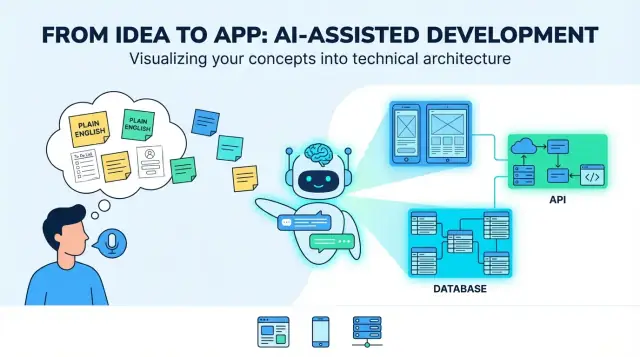

Cómo los LLMs convierten ideas en inglés simple en apps full-stack

Cómo los LLMs convierten ideas en inglés simple en apps web, móviles y backend: requisitos, flujos de UI, modelos de datos, APIs, pruebas y despliegue.

Cómo los LLMs convierten ideas en inglés simple en apps web, móviles y backend: requisitos, flujos de UI, modelos de datos, APIs, pruebas y despliegue.

Una “idea de producto en inglés simple” suele comenzar como una mezcla de intención y esperanza: a quién va dirigida, qué problema resuelve y qué aspecto tiene el éxito. Puede ser un par de frases (“una app para agendar paseadores de perros”), un flujo aproximado (“cliente solicita → paseador acepta → pago”), y un par de requisitos indispensables (“notificaciones push, valoraciones”). Eso basta para hablar de una idea, pero no para construirla de forma consistente.

Cuando la gente dice que un LLM puede “traducir” una idea a una app, el sentido útil es este: convertir objetivos difusos en decisiones concretas y comprobables. La “traducción” no es solo reescribir: es añadir estructura para que puedas revisar, desafiar e implementar.

Los LLMs son buenos produciendo un primer borrador de los bloques constructores principales:

El “resultado” típico parece un plano para un producto full-stack: una UI web (a menudo para admins o tareas de escritorio), una UI móvil (para usuarios en movimiento), servicios backend (auth, lógica de negocio, notificaciones) y almacenamiento de datos (base de datos más almacenamiento de archivos/medios).

Los LLMs no pueden elegir de forma fiable las compensaciones de tu producto, porque las respuestas correctas dependen del contexto que quizá no hayas escrito:

Trata al modelo como un sistema que propone opciones y valores por defecto, no como una verdad final.

Los modos de fallo más habituales son previsibles:

El objetivo real de la “traducción” es hacer visibles las suposiciones, para que puedas confirmarlas, revisarlas o rechazarlas antes de que se conviertan en código.

Antes de que un LLM pueda convertir “Construye una app para X” en pantallas, APIs y modelos de datos, necesitas un brief de producto lo bastante específico como para diseñar sobre él. Este paso trata de convertir la intención difusa en un objetivo compartido.

Escribe la declaración del problema en una o dos frases: quién tiene la dificultad, con qué y por qué importa. Después añade métricas de éxito observables.

Por ejemplo: “Reducir el tiempo que tarda una clínica en agendar citas de seguimiento.” Las métricas podrían incluir tiempo medio de agendado, tasa de no presentación o % de pacientes que reservan por autoservicio.

Lista los tipos de usuario primarios (no todo el que pueda tocar el sistema). Da a cada uno una tarea principal y un escenario corto.

Un prompt útil: “Como [rol], quiero [hacer algo] para [beneficio].” Apunta a 3–7 casos de uso centrales que describan el MVP.

Las restricciones son la diferencia entre un prototipo limpio y un producto enviable. Incluye:

Sé explícito sobre lo que entra en la primera versión y lo que se pospone. Una regla simple: las funcionalidades del MVP deben soportar los casos de uso primarios de principio a fin sin soluciones manuales.

Si quieres, captura esto en un brief de una página y úsalo como “fuente de verdad” para los siguientes pasos (requisitos, flujos de UI y arquitectura).

Una idea en lenguaje natural es normalmente una mezcla de objetivos (“ayudar a la gente a reservar clases”), suposiciones (“los usuarios iniciarán sesión”) y alcance vago (“hazlo simple”). Un LLM es útil aquí porque puede convertir la entrada desordenada en requisitos que puedas revisar, corregir y aprobar.

Empieza reescribiendo cada frase como una historia de usuario. Esto fuerza claridad sobre quién necesita qué y por qué:

Si una historia no nombra un tipo de usuario o beneficio, probablemente sigue siendo demasiado vaga.

Luego, agrupa historias en funcionalidades y etiqueta cada una como must-have o nice-to-have. Esto ayuda a prevenir la deriva de alcance antes de que diseño e ingeniería empiecen.

Ejemplo: “notificaciones push” puede ser nice-to-have, mientras que “cancelar una reserva” suele ser must-have.

Añade reglas simples y comprobables bajo cada historia. Buenos criterios de aceptación son específicos y observables:

Los LLMs tienden a dar por hecho el “camino feliz”, así que pide explícitamente casos límite como:

Este paquete de requisitos se convierte en la fuente de verdad que usarás para evaluar salidas posteriores (flujos de UI, APIs y pruebas).

Una idea en lenguaje natural es construible cuando se convierte en trayectos de usuario y pantallas conectadas por una navegación clara. En este paso no eliges colores: defines qué puede hacer la gente, en qué orden y qué significa el éxito.

Empieza listando las rutas que más importan. Para muchos productos puedes estructurarlas como:

El modelo puede redactar estos flujos como secuencias paso a paso. Tu trabajo es confirmar qué es opcional, qué es obligatorio y dónde los usuarios pueden salir y volver sin problema.

Pide dos entregables: un inventario de pantallas y un mapa de navegación.

Un buen resultado nombra las pantallas consistentemente (p. ej., “Order Details” vs “Order Detail”), define puntos de entrada e incluye estados vacíos (sin resultados, sin elementos guardados).

Convierte los requisitos en campos de formulario con reglas: requerido/opcional, formatos, límites y mensajes de error amigables. Ejemplo: reglas de contraseña, formatos de dirección de pago o “la fecha debe ser en el futuro”. Asegura validación inline (mientras el usuario escribe) y en el envío.

Incluye tamaños de texto legibles, contraste claro, soporte completo de teclado en web y mensajes de error que expliquen cómo arreglar el problema (no solo “Entrada inválida”). Asegura además que cada campo de formulario tenga una etiqueta y que el orden de enfoque tenga sentido.

Una “arquitectura” es el plano de la app: qué partes existen, cuál es la responsabilidad de cada una y cómo se comunican. Cuando un LLM propone una arquitectura, tu trabajo es asegurarte de que sea lo bastante simple para construir ahora y lo bastante clara para evolucionar después.

Para la mayoría de productos nuevos, un backend único (monolito) es la opción correcta para comenzar: un código, un despliegue, una base de datos. Es más rápido de construir, más fácil de depurar y más barato de operar.

Un monolito modular suele ser el punto óptimo: todavía un despliegue, pero organizado en módulos (Auth, Billing, Projects, etc.) con límites claros. Retrasas la separación en servicios hasta que haya una presión real—como tráfico alto, un equipo que necesita despliegues independientes o una parte del sistema que escala de otro modo.

Si el LLM sugiere de inmediato “microservicios”, pídele que justifique esa elección con necesidades concretas, no hipotéticas futuras.

Un buen esquema arquitectónico nombra lo esencial:

El modelo también debería especificar dónde vive cada pieza (backend vs móvil vs web) y definir cómo interactúan los clientes con el backend (normalmente REST o GraphQL).

La arquitectura sigue ambigua a menos que fijes lo básico: framework de backend, base de datos, hosting y enfoque móvil (nativo vs multiplataforma). Pide al modelo que escriba esto como “Suposiciones” para que todos sepan contra qué se está diseñando.

En lugar de grandes reescrituras, prefiere pequeñas “vías de escape”: cacheo para lecturas calientes, una cola para trabajos en background y servidores de aplicación sin estado para poder añadir instancias. Las mejores propuestas explican estas opciones manteniendo v1 sencilla.

Un producto está lleno de sustantivos: “usuarios”, “proyectos”, “tareas”, “pagos”, “mensajes”. Modelar datos es el paso donde un LLM convierte esos sustantivos en una imagen compartida de lo que la app debe almacenar y cómo se conectan las cosas.

Empieza listando las entidades clave y preguntando: ¿qué pertenece a qué?

Por ejemplo:

Luego define relaciones y restricciones: ¿puede existir una tarea sin proyecto?, ¿se pueden editar los comentarios?, ¿se pueden archivar proyectos?, ¿qué pasa con las tareas cuando se elimina un proyecto?

A continuación, el modelo propone un esquema de primera pasada (tablas SQL o colecciones NoSQL). Manténlo simple y enfocado en decisiones que afectan comportamiento.

Un borrador típico podría incluir:

Importante: captura campos de “status”, timestamps y restricciones únicas temprano (como email único). Esos detalles impulsan filtros de UI, notificaciones e informes.

La mayoría de las apps reales necesitan reglas claras sobre quién puede ver qué. Un LLM debería hacer explícita la propiedad (owner_user_id) y modelar el acceso (membresías/roles). Para productos multi-tenant (muchas empresas en un sistema), introduce una entidad tenant/organization y adjunta tenant_id a todo lo que debe aislarse.

También define cómo se aplican los permisos: por rol (admin/miembro/visor), por propiedad, o ambos.

Finalmente, decide qué debe registrarse y qué debe eliminarse. Ejemplos:

Estas elecciones evitan sorpresas desagradables cuando aparecen requisitos de cumplimiento, soporte o facturación.

Las APIs backend son donde las promesas de la app se convierten en acciones reales: “guardar mi perfil”, “mostrar mis pedidos”, “buscar listados”. Una buena salida parte de las acciones de usuario y las convierte en un conjunto pequeño de endpoints claros.

Lista las cosas principales con las que interactúan los usuarios (p. ej., Projects, Tasks, Messages). Para cada una define lo que el usuario puede hacer:

Eso suele mapearse a endpoints como:

POST /api/v1/tasks (create)GET /api/v1/tasks?status=open&q=invoice (list/search)GET /api/v1/tasks/{taskId} (read)PATCH /api/v1/tasks/{taskId} (update)DELETE /api/v1/tasks/{taskId} (delete)Crear una tarea: el usuario envía título y fecha de vencimiento.

POST /api/v1/tasks

{

"title": "Send invoice",

"dueDate": "2026-01-15"

}

La respuesta devuelve el registro guardado (incluyendo campos generados por el servidor):

201 Created

{

"id": "tsk_123",

"title": "Send invoice",

"dueDate": "2026-01-15",

"status": "open",

"createdAt": "2025-12-26T10:00:00Z"

}

Haz que el modelo produzca errores consistentes:

Para reintentos, prefiere claves de idempotencia en POST y orientación clara como “reintentar después de 5 segundos”.

Los clientes móviles se actualizan despacio. Usa una ruta base versionada (/api/v1/...) y evita cambios rompientes:

GET /api/version)La seguridad no es una tarea “para después”. Cuando un LLM convierte tu idea en especificaciones de app, quieres que los valores seguros por defecto sean explícitos—para que la primera versión generada no quede accidentalmente abierta al abuso.

Pide al modelo que recomiende un método de login principal y un fallback, además de qué ocurre cuando algo falla (pérdida de acceso, inicio sospechoso). Elecciones comunes:

Especifica manejo de sesiones (tokens de acceso de corta vida, refresh tokens, cierre de sesión por dispositivo) y si soportas autenticación multifactor.

La autenticación identifica; la autorización limita el acceso. Anima al modelo a elegir un patrón claro:

project:edit, invoice:export) para productos flexiblesUna buena salida incluye reglas de ejemplo: “Solo los propietarios del proyecto pueden eliminarlo; los colaboradores pueden editar; los espectadores pueden comentar.”

Haz que el modelo liste salvaguardas concretas, no promesas genéricas:

Pide además una checklist de amenazas básica: protecciones CSRF/XSS, cookies seguras y cargas de archivos seguras si aplica.

Por defecto, recolecta lo mínimo necesario: solo lo que la funcionalidad requiere y por el menor tiempo posible.

Pide al LLM que redacte en lenguaje claro:

Si añades analytics, exige una opción para darse de baja (o opt-in donde sea requerido) y documenta esto claramente en ajustes y páginas de política.

Un buen LLM puede convertir tus requisitos en un plan de pruebas usable—si le fuerzas a anclar todo a criterios de aceptación, no a afirmaciones vagas.

Empieza dándole al modelo tu lista de funcionalidades y criterios de aceptación, y pídele que genere pruebas por criterio. Una salida sólida incluye:

Si una prueba no puede vincularse a un criterio específico, probablemente es ruido.

Los LLMs también pueden proponer fixtures que imiten cómo la gente realmente usa la app: nombres desordenados, campos faltantes, zonas horarias, textos largos y registros casi idénticos.

Pide:

Haz que el modelo añada una checklist móvil dedicada:

Los LLMs son excelentes redactando esqueletos de pruebas, pero debes revisar:

Trata al modelo como un autor rápido de pruebas, no como el criterio final de QA.

Un modelo puede generar mucho código, pero los usuarios solo se benefician cuando se entrega con seguridad y puedes ver qué pasa después del lanzamiento. Este paso trata de lanzamientos repetibles: los mismos pasos cada vez, con la menor sorpresa.

Configura una pipeline de CI simple que corra en cada pull request y en cada merge a la rama principal:

Aunque el LLM haya escrito el código, CI te dice si sigue funcionando tras un cambio.

Usa tres entornos con propósitos claros:

La configuración debe manejarse vía variables de entorno y secretos (no hardcoded). Una regla útil: si cambiar un valor requiere cambiar código, probablemente está mal configurado.

Para una app full-stack típica:

Planifica tres señales:

Aquí es donde el desarrollo asistido por IA se vuelve operativo: no solo generas código, sino que gestionas un producto.

Los LLMs pueden convertir una idea vaga en algo que parece un plan completo—pero la prosa pulida puede ocultar huecos. Los fallos más comunes son previsibles, y puedes prevenirlos con unos hábitos repetibles.

La mayoría de las salidas débiles se rastrea hasta cuatro problemas:

Dale al modelo material concreto:

Pide checklists por entregable. Por ejemplo, los requisitos no están “hechos” hasta que incluyen criterios de aceptación, estados de error, roles/ permisos y métricas de éxito medibles.

Las salidas del LLM se desvían cuando las specs, notas de API e ideas de UI viven en hilos separados. Mantén un documento vivo (aunque sea un markdown simple) que enlace:

Cuando vuelvas a solicitar algo al LLM, pega el último extracto y di: “Actualiza solo las secciones X e Y; deja todo lo demás sin cambios.”

Si implementas sobre la marcha, también ayuda usar un flujo que soporte iteración rápida sin perder trazabilidad. Por ejemplo, la función de “planning mode” de Koder.ai encaja bien: puedes bloquear la spec (suposiciones, preguntas abiertas, criterios de aceptación), generar el scaffolding web/móvil/backend desde un solo hilo de chat y confiar en snapshots/rollback si un cambio introduce regresiones. La exportación de código es especialmente útil cuando quieres que la arquitectura generada y tu repo se mantengan alineados.

Esto es cómo puede verse la “traducción por LLM” de extremo a extremo—más los puntos de control donde un humano debe frenar y tomar decisiones reales.

Idea en lenguaje natural: “Un marketplace de cuidado de mascotas donde los dueños publican solicitudes, los cuidadores aplican y los pagos se liberan después del trabajo.”

Un LLM puede convertir esto en un primer borrador como:

POST /requests, GET /requests/{id}, POST /requests/{id}/apply, GET /requests/{id}/applications, POST /messages, POST /checkout/session, POST /jobs/{id}/complete, POST /reviews.Eso es útil—pero no está “hecho”. Es una propuesta estructurada que necesita validación.

Decisiones de producto: ¿Qué hace válida una “aplicación”? ¿Puede un dueño invitar directamente a un cuidador? ¿Cuándo se considera una solicitud “completada”? Estas reglas afectan cada pantalla y API.

Revisión de seguridad y privacidad: Confirma acceso por roles (los dueños no pueden leer chats de otros dueños), protege los pagos y define retención de datos (p. ej., borrar chats tras X meses). Añade controles de abuso: límites de tasa, prevención de spam, logs de auditoría.

Compensaciones de rendimiento: Decide qué debe ser rápido y escalable (búsquedas/filtrado, chat). Esto influye en cacheo, paginación, índices y trabajos en background.

Después de un piloto, los usuarios podrían pedir “repetir una solicitud” o “cancelar con reembolso parcial”. Alimenta eso como requisitos actualizados, regenera o parchea los flujos afectados y vuelve a ejecutar pruebas y chequeos de seguridad.

Captura el “por qué”, no solo el “qué”: reglas de negocio clave, matriz de permisos, contratos de API, códigos de error, migraciones de base de datos y un runbook corto para releases e incidentes. Esto es lo que mantiene el código generado entendible seis meses después.

En este contexto, “traducción” significa convertir una idea difusa en decisiones específicas y comprobables: roles, recorridos de usuario, requisitos, datos, APIs y criterios de éxito.

No es solo parafrasear: es hacer explícitas las suposiciones para que puedas confirmarlas o rechazarlas antes de construir.

Un primer borrador práctico incluye:

Trátalo como un plano inicial que debes revisar, no como una especificación final.

Porque un LLM no puede conocer de forma fiable tus restricciones y compensaciones del mundo real sin que tú las declares. Los humanos deben seguir decidiendo:

Usa el modelo para proponer opciones y luego elige deliberadamente.

Dale contexto suficiente para diseñar contra él:

Si no podrías darle esto a un compañero y obtener la misma interpretación, no está listo.

Céntrate en convertir objetivos en historias de usuario + criterios de aceptación.

Un paquete sólido normalmente incluye:

Esto se convierte en tu “fuente de verdad” para UI, APIs y pruebas.

Pide dos entregables:

Luego verifica:

Para la mayoría de los productos v1, empieza con un monolito o un monolito modular.

Cuestiona al modelo si propone microservicios: pide razones concretas (tráfico, necesidad de despliegues independientes, partes que escalan distinto). Prefiere “salidas de emergencia” en lugar de una arquitectura compleja desde el inicio:

Mantén v1 fácil de lanzar y de depurar.

Haz que el modelo deje claro:

Las decisiones de datos afectan filtros de UI, notificaciones, reporting y seguridad.

Exige consistencia y comportamiento apto para móviles:

/api/v1/...)POST reintentadosEvita cambios incompatibles; añade campos opcionales y mantén una ventana de deprecación.

Usa el modelo para redactar un plan y luego compáralo con los criterios de aceptación:

Exige datos de prueba reales: zonas horarias, textos largos, casi-duplicados, redes inestables. Trata las pruebas generadas como punto de partida, no como el QA final.

Estás diseñando comportamiento, no apariencia.