05 jun 2025·8 min

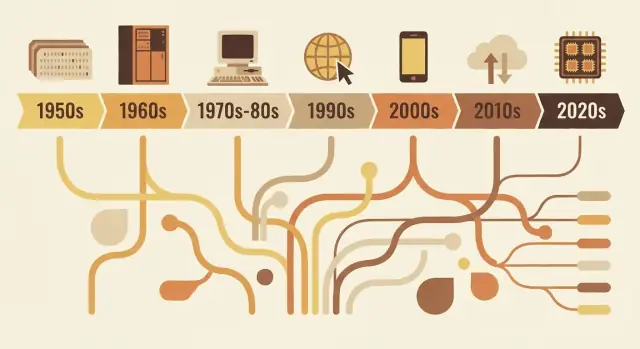

Cómo los lenguajes de programación reflejan las necesidades de su época

De FORTRAN a Rust, los lenguajes reflejan las prioridades de su época: límites de hardware, seguridad, la web y trabajo en equipo. Ve cómo las decisiones de diseño se corresponden con problemas reales.

Por qué los lenguajes se ven como se ven

Los lenguajes de programación no son simplemente versiones “mejores” o “peores” unos de otros. Son respuestas de diseño a los problemas que hacía falta resolver en un momento concreto de la informática.

Qué incluye realmente el “diseño de un lenguaje”

Cuando hablamos de diseño de lenguaje hablamos de más que de cómo se ve el código en la página. Un lenguaje es un conjunto de decisiones como:

- Sintaxis: cómo expresas ideas (palabras clave, puntuación, legibilidad)

- Tipos: si los valores tienen clases declaradas (y cuánto verifica el lenguaje)

- Modelo de memoria: quién gestiona la memoria y qué garantías de seguridad existen

- Modelo de ejecución: compilado vs interpretado, comportamiento en tiempo de ejecución, compensaciones de rendimiento

- Biblioteca estándar + herramientas: paquetes, sistemas de construcción, depuradores, formateadores y cómo los equipos entregan software

Esas decisiones suelen agruparse en torno a las limitaciones de la época: hardware limitado, tiempo de cómputo caro, ausencia de funciones del sistema operativo o (más tarde) equipos enormes, redes globales y amenazas de seguridad.

La idea central

Los lenguajes reflejan su tiempo. Los primeros lenguajes priorizaban exprimir valor de máquinas escasas. Los posteriores priorizaron la portabilidad al tener que ejecutarse en muchos sistemas. A medida que los proyectos crecieron, los lenguajes apostaron por la estructura, la abstracción y las herramientas para mantener bases de código grandes entendibles. Más recientemente, la concurrencia, el despliegue en la nube y las presiones de seguridad han impuesto nuevos compromisos.

Este artículo se centra en ejemplos representativos, no en una cronología completa año por año. Verás cómo algunos lenguajes influyentes encarnan las necesidades de su época y cómo las ideas se reciclan y refinan.

Por qué importa esto al elegir herramientas hoy

Entender el “por qué” detrás de un lenguaje te ayuda a predecir sus fortalezas y puntos ciegos. Aclara preguntas como: ¿Este lenguaje está optimizado para rendimiento ajustado, iteración rápida, mantenimiento por equipos grandes o seguridad? Al decidir qué aprender o qué usar en un proyecto, ese contexto es tan práctico como cualquier lista de características.

Restricciones de la informática temprana que lo moldearon todo

Los primeros lenguajes se moldearon menos por el gusto y más por la física y los presupuestos. Las máquinas tenían cantidades diminutas de memoria, el almacenamiento escaseaba y las CPU eran lentas según los estándares modernos. Eso obligó a constantes compensaciones: cada característica extra, cada instrucción más larga y cada capa de abstracción tenía un coste real.

Poca memoria, ciclos caros

Si solo tienes espacio para un programa pequeño y un conjunto de datos pequeño, diseñas lenguajes y herramientas que mantengan los programas compactos y predecibles. Los sistemas tempranos empujaban a los programadores hacia flujos de control simples y mínimo soporte en tiempo de ejecución. Incluso las características “agradables de tener”—como cadenas ricas, gestión dinámica de memoria o estructuras de datos de alto nivel—podían ser imprácticas porque requerían código y contabilidad adicional.

Procesamiento por lotes y ciclos largos de retroalimentación

Muchos programas tempranos se ejecutaban en lotes. Preparabas un trabajo (a menudo con tarjetas perforadas), lo enviabas y esperabas. Si algo fallaba, podrías no saber por qué hasta mucho después, cuando el trabajo terminaba o fallaba.

Ese ciclo largo de retroalimentación cambió lo que importaba:

- Los programas debían ejecutarse correctamente a la primera, porque volver a ejecutar era costoso.

- La depuración era más lenta, por lo que los desarrolladores se apoyaban en planificación cuidadosa y convenciones.

- Las herramientas y la exploración interactiva no eran la experiencia por defecto.

Por qué la legibilidad y los mensajes de error no eran prioridad

Cuando el tiempo de máquina era precioso y las interfaces limitadas, los lenguajes no optimizaban por diagnósticos amigables o claridad para principiantes. Los mensajes de error solían ser breves, a veces crípticos, y enfocados en ayudar a un operador a localizar un problema en un mazo de tarjetas o en una línea de salida impresa.

La ciencia y las matemáticas impulsaron las primeras características

Una gran parte de la demanda computacional temprana venía del trabajo científico e ingenieril: cálculos, simulaciones y métodos numéricos. Por eso las características iniciales solían centrarse en aritmética eficiente, arreglos y expresar fórmulas de una forma que mapease bien al hardware y a cómo los científicos ya trabajaban en papel.

FORTRAN, COBOL y lenguajes construidos para trabajos específicos

Algunos lenguajes tempranos no intentaban ser universales. Se diseñaron para resolver muy bien una clase estrecha de problemas—porque las computadoras eran caras, el tiempo escaso y “suficientemente bueno para todo” a menudo significaba “excelente en nada”.

FORTRAN: trabajo numérico, velocidad y la carga del científico

FORTRAN (FORmula TRANslation) se orientó directamente a la computación científica e ingenieril. Su promesa central fue práctica: permitir que la gente escribiera programas intensivos en matemáticas sin codificar manualmente cada detalle en ensamblador.

Ese objetivo moldeó su diseño. Se inclinó hacia operaciones numéricas y cómputo por arreglos, y apostó por el rendimiento. La innovación real no fue solo la sintaxis, sino la idea de que un compilador pudiera generar código máquina lo suficientemente eficiente como para que los científicos confiaran en él. Cuando tu tarea central son simulaciones, tablas balísticas o cálculos físicos, ahorrar tiempo de ejecución no es un lujo; es la diferencia entre obtener resultados hoy o la semana que viene.

COBOL: registros de negocio, legibilidad e informes

COBOL se orientó a otro universo: gobiernos, bancos, seguros, nóminas e inventarios. Estos son problemas de “registros e informes”: datos estructurados, flujos de trabajo previsibles y mucha auditoría.

Así, COBOL favoreció un estilo verborreico y parecido al inglés que hacía los programas más fáciles de revisar y mantener en organizaciones grandes. Las definiciones de datos eran una preocupación de primera clase, porque el software empresarial vive y muere por cómo modela formularios, cuentas y transacciones.

Qué significa realmente “cercano al dominio”

Ambos lenguajes muestran un principio de diseño que sigue importando: el vocabulario debe reflejar el trabajo.

FORTRAN habla en términos matemáticos y de cómputo. COBOL habla en términos de registros y procedimientos. Su popularidad revela las prioridades de su época: no la experimentación abstracta, sino resolver cargas de trabajo reales de manera eficiente—ya fuera computación numérica rápida o manejo claro de datos empresariales e informes.

La era de los sistemas: portabilidad y control (C, Unix)

Para finales de los 60 y 70, las computadoras se estaban volviendo más baratas y comunes, pero seguían siendo muy diferentes entre sí. Si escribías software para una máquina, portar ese software a otra a menudo significaba reescribir grandes partes a mano.

El dolor del ensamblador empujó los lenguajes hacia arriba

Mucho software importante se escribía en ensamblador, lo que daba máximo rendimiento y control, pero a un alto coste: cada CPU tenía su propio conjunto de instrucciones, el código era difícil de leer y pequeños cambios podían traducirse en días de ediciones cuidadosas. Ese dolor creó demanda por un lenguaje que se sintiera “cerca del metal” pero que no te atrapara en un solo procesador.

Objetivo central de C: código de sistema portable

C surgió como un compromiso práctico. Se diseñó para escribir sistemas operativos y herramientas—especialmente Unix—manteniendo la portabilidad entre hardware. C ofreció a los programadores:

- Un conjunto de características sencillo y pequeño que podía compilarse en muchas máquinas

- Acceso directo a la memoria mediante punteros

- La capacidad de escribir código de bajo nivel sin volver al ensamblador por cada detalle

Que Unix se reescribiera en C es el ejemplo famoso: el sistema operativo pudo trasladarse a nuevo hardware mucho más fácilmente que un sistema solo en ensamblador.

Por qué la gestión manual de memoria era aceptable

C esperaba que gestionaras la memoria tú mismo (asignarla, liberarla, evitar errores). Hoy suena arriesgado, pero encajaba con las prioridades de la época. Las máquinas tenían recursos limitados, los sistemas operativos necesitaban rendimiento predecible y los programadores trabajaban más cerca del hardware—a veces sabiendo incluso el diseño exacto de memoria que querían.

El intercambio perdurable

C se optimizó para rapidez y control, y lo logró. El precio fue la seguridad y la facilidad: desbordamientos de búfer, fallos y errores sutiles se convirtieron en riesgos habituales. En aquella era, esos riesgos se consideraban a menudo un coste aceptable por la portabilidad y el rendimiento.

Hacer programas grandes mantenibles: estructura y tipos

A medida que los programas crecieron de utilidades pequeñas y de propósito único a productos que ejecutaban negocios, surgió un nuevo problema: no solo “¿podemos hacerlo funcionar?” sino “¿podemos mantenerlo funcionando durante años?” El código temprano a menudo evolucionaba parchando y saltando con goto, produciendo “código espagueti” difícil de leer, probar o cambiar con seguridad.

Qué intentó arreglar la programación estructurada

La programación estructurada impulsó una idea simple: el código debe tener una forma clara. En lugar de saltar a líneas arbitrarias, los desarrolladores usaron bloques bien definidos—if/else, while, for y switch—para hacer el flujo de control predecible.

Esa previsibilidad importaba porque depurar consiste en gran medida en responder “¿cómo llegó la ejecución aquí?” Cuando el flujo es visible en la estructura, menos errores se esconden en las grietas.

El auge de los equipos y las bases de código duraderas

Una vez que el software se convirtió en actividad de equipo, la mantenibilidad dejó de ser solo un problema técnico y pasó a ser social. Nuevos compañeros necesitaban entender código que no habían escrito. Los gestores necesitaban estimaciones para cambios. Las empresas necesitaban confianza de que las actualizaciones no romperían todo.

Los lenguajes respondieron alentando convenciones que escalan más allá de la memoria de una sola persona: límites consistentes de funciones, ciclos de vida de variables más claros y formas de organizar código en archivos y bibliotecas separadas.

Por qué los tipos, módulos y ámbitos ganaron valor

Los tipos empezaron a importar porque actúan como “documentación incorporada” y detección temprana de errores. Si una función espera un número pero recibe texto, un sistema de tipos fuerte puede detectar eso antes de que llegue a los usuarios.

Los módulos y ámbitos ayudaron a limitar el radio de impacto de los cambios. Al mantener detalles privados y exponer solo interfaces estables, los equipos podían refactorizar internals sin reescribir el programa entero.

Movimientos de diseño que apoyaron la composición

Mejoras comunes incluyeron:

- Funciones más pequeñas y bien nombradas que hacen un trabajo

- Ámbito léxico para evitar interacciones accidentales entre variables

- Mejores patrones de composición (pasar funciones/datos de forma limpia en lugar de depender de estado global)

En conjunto, estos cambios orientaron los lenguajes hacia código más fácil de leer, revisar y evolucionar con seguridad.

Objetos y empresa: por qué la POO se volvió dominante

Construye y gana créditos

Gana créditos compartiendo contenido sobre tu proyecto en Koder.ai.

La programación orientada a objetos (POO) no “ganó” porque fuese la única buena idea: ganó porque encajaba con lo que muchos equipos intentaban construir: software empresarial duradero mantenido por mucha gente.

Qué prometía la POO

La POO ofrecía una historia ordenada para la complejidad: representar el programa como un conjunto de “objetos” con responsabilidades claras.

La encapsulación (ocultar detalles internos) sonaba a una forma práctica de prevenir roturas accidentales. La herencia y el polimorfismo prometían reuso: escribir una versión general una vez, especializarla después y conectar distintas implementaciones a la misma interfaz.

Por qué las GUI y las aplicaciones empresariales la impulsaron

A medida que el software de escritorio y las interfaces gráficas crecieron, los desarrolladores necesitaban formas de gestionar muchos componentes interactuantes: ventanas, botones, documentos, menús y eventos. Pensar en términos de objetos y mensajes encajaba bien con estas partes interactivas.

Al mismo tiempo, los sistemas empresariales crecían en dominios como banca, seguros, inventarios y RR. HH. Estos entornos valoraban la consistencia, la colaboración en equipo y las bases de código que podían evolucionar durante años. La POO encajaba con una necesidad organizacional: dividir el trabajo en módulos propiedad de distintos equipos, hacer cumplir límites y estandarizar cómo se añaden características.

Dónde ayudó—y dónde se enredó

La POO brilla cuando crea límites estables y componentes reutilizables. Se vuelve problemática cuando los desarrolladores sobre-modelan todo, creando jerarquías de clases profundas, “objetos dios” o patrones usados más por moda que por necesidad. Demasiadas capas pueden hacer que cambios simples parezcan papeleo.

Influencia perdurable

Incluso lenguajes que no son “PURO OOP” tomaron sus defaults: estructuras tipo clase, interfaces, modificadores de acceso y patrones de diseño. Gran parte de la sintaxis moderna refleja el enfoque de esa época en organizar equipos grandes alrededor de bases de código grandes.

La era de Java: portabilidad, seguridad y escala empresarial

Java surgió junto a un boom de software muy específico: sistemas empresariales grandes y duraderos desplegados en una mezcla heterogénea de servidores, sistemas operativos y hardware de proveedores. Las empresas querían despliegues previsibles, menos fallos y equipos que pudieran crecer sin reescribir todo cada pocos años.

Qué resolvió la JVM: portabilidad con un runtime gestionado

En lugar de compilar directamente a instrucciones de una máquina, Java compila a bytecode que se ejecuta en la Máquina Virtual de Java (JVM). Esa JVM se convirtió en la “capa estándar” en la que las empresas podían confiar: entregar el mismo artefacto y ejecutarlo en Windows, Linux o grandes Unix con cambios mínimos.

Esto es el núcleo de “write once, run anywhere”: no una garantía de ausencia total de peculiaridades de plataforma, sino una forma práctica de reducir el coste y el riesgo de soportar muchos entornos.

Predeterminados de seguridad que redujeron fallos en producción

Java convirtió la seguridad en una característica principal más que en una disciplina opcional.

El recolector de basura eliminó toda una categoría de errores de memoria (punteros colgantes, liberaciones dobles) comunes en entornos no gestionados. Las comprobaciones de límites de arreglos ayudaron a prevenir lecturas o escrituras fuera de una estructura de datos. Combinado con un sistema de tipos más estricto, estas decisiones apuntaban a convertir fallos catastróficos en excepciones predecibles—más fáciles de reproducir, registrar y arreglar.

Por qué encajó con la realidad empresarial

Las empresas valoraban la estabilidad, las herramientas y el gobierno: procesos de construcción estandarizados, fuerte soporte de IDE, bibliotecas extensas y un runtime que podía monitorizarse y gestionarse. La JVM también permitió un ecosistema rico de servidores de aplicaciones y frameworks que hicieron más consistente el desarrollo por equipos grandes.

Las compensaciones: sobrecarga, ajuste y complejidad

Los beneficios de Java no fueron gratis. Un runtime gestionado añade tiempo de arranque y sobrecarga de memoria, y la recolección de basura puede crear picos de latencia si no se ajusta. Con el tiempo, el ecosistema acumuló complejidad—capas de frameworks, configuración y modelos de despliegue—que exigían conocimiento especializado.

Aun así, para muchas organizaciones el trato valió la pena: menos fallos de bajo nivel, despliegue multiplataforma más sencillo y un runtime compartido que escaló con el tamaño del negocio y de la base de código.

Lenguajes de scripting y el empuje por productividad

Prototipa en una sola sesión

Prueba rápidamente una idea de producto y luego refínala en el chat.

A finales de los 90 y en los 2000, muchos equipos ya no escribían sistemas operativos: conectaban bases de datos, construían sitios web y automatizaban flujos internos. El cuello de botella pasó de la eficiencia pura de la CPU al tiempo del desarrollador. La retroalimentación rápida y los ciclos de lanzamiento cortos convirtieron “¿qué tan rápido podemos cambiar esto?” en un requisito de primera clase.

Por qué la iteración rápida se volvió prioritaria

Las aplicaciones web evolucionaban en días, no en años. Las empresas querían páginas nuevas, informes nuevos, integraciones rápidas y correcciones sin un pipeline completo de compilar–linkear–desplegar. Los lenguajes de scripting encajaron con ese ritmo: editar un archivo, ejecutarlo, ver el resultado.

Esto también cambió quién podía crear software. Administradores de sistemas, analistas y equipos pequeños pudieron entregar herramientas útiles sin un conocimiento profundo de la gestión de memoria o de sistemas de construcción.

Tipado dinámico y ecosistemas “baterías incluidas”

Lenguajes como Python y Ruby se inclinaron por el tipado dinámico: puedes expresar una idea con menos declaraciones y menos ceremonia. Combinado con bibliotecas estándar potentes, hicieron que tareas comunes se sintieran “a un import de distancia”:

- procesamiento de texto y manejo de archivos

- HTTP, correo y redes básicas

- acceso a bases de datos y formatos de datos (CSV, JSON, XML)

Ese enfoque “baterías incluidas” recompensó la experimentación y permitió que scripts de automatización crecieran naturalmente hasta convertirse en aplicaciones reales.

Python, Ruby y PHP como respuestas prácticas

Python se convirtió en la opción para automatización y programación general, Ruby aceleró el desarrollo web (especialmente con frameworks) y PHP dominó el servidor web temprano porque era fácil de incrustar directamente en páginas y desplegar casi en cualquier lugar.

Las compensaciones: velocidad, errores en tiempo de ejecución y prácticas de escalado

Las mismas características que hacían productivos a los lenguajes de scripting también introdujeron costes:

- ejecución más lenta comparada con lenguajes compilados

- más errores detectados en tiempo de ejecución

- escalar requería disciplina: testing, revisión de código, linters y convenciones

En otras palabras, los lenguajes de scripting optimizaron para el cambio. Los equipos aprendieron a “recuperar” confiabilidad con herramientas y prácticas—preparando el terreno para ecosistemas modernos donde velocidad de desarrollador y calidad del software se esperan simultáneamente.

JavaScript y el boom del software impulsado por el navegador

El navegador web se convirtió en una “computadora” sorpresa que llegó a millones de personas. Pero no era un lienzo en blanco: era una caja de arena, se ejecutaba en hardware impredecible y tenía que mantenerse responsiva mientras dibujaba pantallas y esperaba redes. Ese entorno moldeó el papel de JavaScript más que cualquier idea abstracta de un lenguaje perfecto.

Una plataforma con restricciones inusuales

Los navegadores requerían código que se entregara al instante, se ejecutara de forma segura junto a contenido no confiable y mantuviera la página interactiva. Eso empujó a JavaScript hacia arranques rápidos, comportamiento dinámico y APIs estrechamente ligadas a la página: clics, entradas, temporizadores y, más tarde, peticiones de red.

Por qué “estar en todas partes” venció a “ser perfecto”

JavaScript ganó en gran parte porque ya estaba presente. Si querías comportamiento en un navegador, JavaScript era la opción por defecto—sin paso de instalación, sin permisos, sin runtime separado que convencer a los usuarios de descargar. Las ideas competidoras a menudo parecían más limpias en el papel, pero no podían igualar la ventaja de distribución de “se ejecuta en cualquier sitio”.

Event-driven por necesidad

El navegador es fundamentalmente reactivo: los usuarios hacen clic, las páginas se desplazan, las peticiones vuelven cuando vuelven. El estilo orientado a eventos de JavaScript (callbacks, eventos, promesas) refleja esa realidad. En lugar de un programa que se ejecuta de principio a fin, gran parte del código web “espera algo y luego responde”, lo que encaja de forma natural con la interfaz y el trabajo de red.

Efectos a largo plazo: ecosistemas y compatibilidad

El éxito creó un pozo gravitatorio. Surgieron ecosistemas enormes alrededor de frameworks y bibliotecas, y la cadena de herramientas se convirtió en una categoría de producto: transpilers, bundlers, minificadores y gestores de paquetes. Al mismo tiempo, la promesa de compatibilidad hacia atrás del web significó que decisiones antiguas permanecieran—así que el JavaScript moderno a menudo se siente como capas de herramientas nuevas construidas para convivir con las restricciones de ayer.

Concurrencia y la realidad multicore

Durante mucho tiempo, tener un ordenador más rápido simplemente significaba que tu programa corría más rápido sin cambiar una línea de código. Ese acuerdo se rompió cuando los chips alcanzaron límites de calor y potencia y empezaron a añadir núcleos en lugar de subir la frecuencia. De repente, obtener más rendimiento a menudo requería hacer más de una cosa a la vez.

Por qué multicore hizo inevitable la concurrencia

Las apps modernas raramente realizan una sola tarea aislada. Manejan muchas peticiones, hablan con bases de datos, renderizan UI, procesan ficheros y esperan redes—todo mientras los usuarios esperan respuestas instantáneas. El hardware multicore hizo posible ejecutar trabajo en paralelo, pero también lo volvió doloroso cuando un lenguaje o runtime asumía “un hilo principal, un flujo”.

Qué añadieron los lenguajes para ayudar

La concurrencia temprana dependía de hilos del SO y bloqueos. Muchos lenguajes los expusieron directamente, lo que funcionó pero derivó la complejidad a los desarrolladores cotidianos.

Los diseños más nuevos intentan facilitar patrones comunes:

- Hilos con primitivas más seguras: mejores mutex, pools de hilos y modelos de memoria más claros.

- async/await: una forma de escribir código no bloqueante que aún se lee como lógica paso a paso.

- Canales y paso de mensajes: “compartir datos comunicando” (estilo CSP) para reducir errores por estado compartido.

Los servidores y los sistemas distribuidos cambiaron los defaults

Al moverse el software hacia servicios siempre activos, el “programa normal” pasó a ser un servidor que maneja miles de peticiones concurrentes. Los lenguajes empezaron a optimizar para cargas I/O-intensivas, cancelaciones/tiempos de espera y rendimiento predecible bajo carga.

Trampas que los lenguajes intentan prevenir

Los fallos de concurrencia suelen ser raros y difíciles de reproducir. El diseño de lenguajes apunta cada vez más a prevenir:

- Condiciones de carrera (dos tareas actualizando los mismos datos de forma impredecible)

- Interbloqueos (tareas esperando entre sí para siempre)

- Inanición (cierto trabajo nunca obtiene tiempo de CPU)

El gran cambio: la concurrencia dejó de ser un tema avanzado y se convirtió en una expectativa básica.

Prioridades modernas: seguridad, simplicidad y tooling (Go, Rust)

Mantén tu código fuente portátil

Obtén el código fuente cuando necesites control total o hacer una entrega.

Para la década de 2010, muchos equipos ya no luchaban por expresar algoritmos; luchaban por mantener servicios seguros, estables y fáciles de cambiar bajo presión de despliegue continuo. Surgieron dos problemas principales: vulnerabilidades de seguridad causadas por errores de memoria y fricción de ingeniería causada por pilas demasiado complejas e inconsistencia en las herramientas.

Arreglar errores que se repiten

Una gran parte de las vulnerabilidades de alta gravedad todavía se rastrea hasta problemas de seguridad de memoria: desbordamientos de búfer, uso después de liberar y comportamiento indefinido que solo aparece en ciertas compilaciones o máquinas. El diseño moderno de lenguajes trata esto cada vez más como “pistolas que se disparan en el pie” inaceptables, no solo errores del programador.

Rust es la respuesta más clara. Sus reglas de propiedad y préstamo son esencialmente un trato: escribes código que satisface comprobaciones estrictas en compilación y, a cambio, obtienes fuertes garantías sobre seguridad de memoria sin recolector de basura. Eso hace a Rust atractivo para código de sistemas que históricamente vivió en C/C++—servicios de red, componentes embebidos y librerías críticas en rendimiento—donde seguridad y velocidad importan a la vez.

Sencillez y servicios como carga de trabajo por defecto

Go toma casi la aproximación opuesta: limitar características del lenguaje para mantener las bases de código legibles y predecibles a través de equipos grandes. Su diseño refleja un mundo de servicios de larga duración, APIs e infraestructura en la nube.

Las primitivas de concurrencia incorporadas de Go (goroutines, channels) y su biblioteca estándar apoyan el desarrollo de servicios directamente, mientras que su compilador rápido e historia de dependencias sencilla reducen fricción en el trabajo diario.

La experiencia del desarrollador se vuelve característica

El tooling pasó de ser “extras opcionales” a parte de la promesa del lenguaje. Go normalizó esta mentalidad con gofmt y una fuerte cultura de formateo estándar. Rust continuó con rustfmt, clippy y una herramienta de construcción altamente integrada (cargo).

En el entorno actual de “entrega continua”, esta historia del tooling se extiende beyond compiladores y linters hacia flujos de trabajo de mayor nivel: planificación, scaffolding y bucles de iteración más rápidos. Plataformas como Koder.ai reflejan ese cambio al permitir que los equipos construyan aplicaciones web, backend y móviles mediante una interfaz de chat—luego exporten el código fuente, desplieguen y reviertan con snapshots cuando sea necesario. Es otro ejemplo del mismo patrón histórico: las herramientas que más se difunden son las que hacen el trabajo común de la época más barato y menos propenso a errores.

Cuando formateadores, linters y sistemas de construcción son de primera clase, los equipos pasan menos tiempo discutiendo estilo o luchando contra entornos inconsistentes y más tiempo entregando software fiable.

Qué sugieren los problemas de hoy sobre los lenguajes del mañana

Los lenguajes no “ganan” por ser perfectos. Ganan cuando hacen que el trabajo común del momento sea más barato, más seguro o más rápido—especialmente cuando vienen acompañados de las bibliotecas y hábitos de despliegue adecuados.

IA, trabajo con datos y el poder de los ecosistemas

Un gran motor de la popularidad actual de ciertos lenguajes es dónde está el trabajo: pipelines de datos, analítica, aprendizaje automático y automatización. Por eso Python sigue creciendo—no solo por su sintaxis, sino por su ecosistema: NumPy/Pandas para datos, PyTorch/TensorFlow para ML, notebooks para exploración y una gran comunidad que produce bloques reutilizables.

SQL es el ejemplo silencioso del mismo efecto. No es lo más trendy, pero sigue siendo la interfaz por defecto a datos empresariales porque encaja con el trabajo: consultas declarativas, optimizadores previsibles y amplia compatibilidad entre herramientas y proveedores. Los lenguajes nuevos a menudo terminan integrando SQL en lugar de reemplazarlo.

Mientras tanto, el ML de alto rendimiento empuja las herramientas orientadas a GPU. Vemos más atención de primera clase a vectorización, batching y aceleración por hardware—ya sea mediante ecosistemas CUDA, MLIR y pilas de compiladores, o lenguajes que facilitan enlazar con esos runtimes.

Qué puede dar forma a futuros diseños de lenguajes

Varias presiones probablemente influirán en los lenguajes de la “próxima era” y en grandes actualizaciones de lenguajes:

- Verificación y corrección: sistemas de tipos más fuertes, concurrencia más segura y herramientas que prueban propiedades en lugar de solo testear.

- Privacidad y políticas: mejor soporte para gobernanza de datos, auditabilidad y restricciones alrededor de datos sensibles.

- Uso de energía y eficiencia: lenguajes y runtimes que faciliten escribir código rápido sin microgestión manual.

Conclusión práctica

Al elegir un lenguaje, máchalo con tus restricciones: experiencia del equipo, mercado de contratación, bibliotecas de las que dependerás, objetivos de despliegue y necesidades de fiabilidad. Un lenguaje “bueno” suele ser aquel que hace que tus tareas más frecuentes sean aburridas—y que hace más fáciles de prevenir y diagnosticar tus fallos.

Si necesitas un ecosistema basado en frameworks, elige por el ecosistema; si necesitas corrección y control, elige por seguridad y rendimiento. Para una lista de verificación más profunda, véase /blog/how-to-choose-a-programming-language.