Qué debe hacer un gestor de experimentos de precios

Los experimentos de precios son pruebas estructuradas donde muestras diferentes precios (o empaquetados) a distintos grupos de clientes y mides qué cambia: conversión, upgrades, churn, ingresos por visitante y más. Es la versión de precios de una prueba A/B, pero con un riesgo adicional: un error puede confundir a clientes, generar tickets de soporte o incluso violar políticas internas.

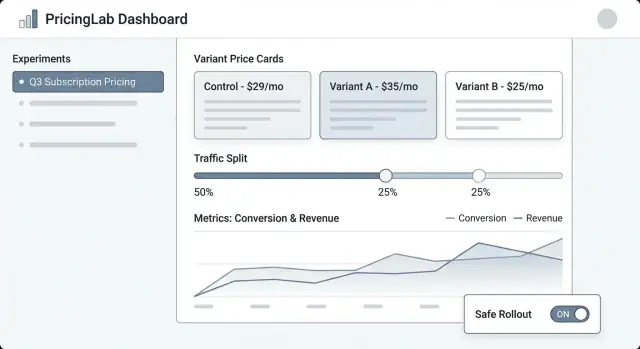

Un gestor de experimentos de precios es el sistema que mantiene estos tests controlados, observables y reversibles.

Los problemas que esta app debería resolver

Control: Los equipos necesitan un único lugar para definir qué se prueba, dónde y para quién. “Cambiamos el precio” no es un plan—un experimento requiere una hipótesis clara, fechas, reglas de segmentación y un interruptor de parada.

Seguimiento: Sin identificadores consistentes (clave de experimento, clave de variante, timestamp de asignación), el análisis se vuelve conjetural. El gestor debe asegurar que cada exposición y compra pueda atribuirse al test correcto.

Consistencia: Un cliente no debería ver un precio en la página de precios y otro distinto en el checkout. El gestor debe coordinar cómo se aplican las variantes en las superficies para que la experiencia sea coherente.

Seguridad: Los errores en precios son costosos. Necesitas salvaguardas como límites de tráfico, reglas de elegibilidad (p. ej., solo nuevos clientes), pasos de aprobación y auditabilidad.

Quién lo usa

- Producto para planear experimentos, definir métricas de éxito y decidir qué lanzar.

- Growth/Marketing para iterar en ofertas y mensajes ligados al precio.

- Finanzas para hacer cumplir reglas de ingresos, políticas de descuento y necesidades de reporting.

- Soporte para entender qué vio un cliente y resolver disputas rápidamente.

- Ingeniería para integrar cambios de precios de forma segura y predecible.

Qué estamos construyendo (y qué no)

Este post se centra en una aplicación web interna que gestiona experimentos: crearlos, asignar variantes, recolectar eventos y reportar resultados.

No es un motor completo de precios (cálculo de impuestos, facturación, catálogos multicurrency, prorrateos, etc.). En su lugar, es el panel de control y la capa de seguimiento que hace que las pruebas de precios sean lo suficientemente seguras para ejecutarse regularmente.

Alcance, requisitos y no-objetivos

Un gestor de experimentos de precios solo es útil si está claro lo que hará (y no hará). Un alcance ajustado mantiene el producto fácil de operar y más seguro de desplegar, especialmente cuando hay ingresos reales en juego.

Requisitos mínimos (capacidades imprescindibles)

Como mínimo, tu app web debe permitir a un operador no técnico ejecutar un experimento de extremo a extremo:

- Crear experimentos con nombre, hipótesis, producto(s) objetivo, segmento(s) objetivo y duración planificada.

- Definir variantes (p. ej., “Control: $29”, “Tratamiento: $35”), incluyendo moneda, periodo de facturación y reglas de elegibilidad.

- Iniciar / pausar / detener un experimento, con estado claro y timestamps efectivos.

- Ver resultados a un nivel básico: conversión, ingresos por visitante, valor medio de pedido, además de indicadores de confianza/incertidumbre.

Si no construyes otra cosa, haz bien esto—con valores por defecto claros y salvaguardas.

Tipos de experimentos soportados (mantenlo intencional)

Decide desde el principio qué formatos de experimento soportarás para que la UI, el modelo de datos y la lógica de asignación se mantengan consistentes:

- Pruebas A/B (un control vs un tratamiento) como camino principal.

- Multivariantes / multi-armed (múltiples puntos de precio) para equipos que necesiten más de dos opciones.

- Grupos holdout (p. ej., 5% ve el precio base) para medir efectos a largo plazo o a nivel de sistema.

- Despliegue gradual (rampas de tráfico en el tiempo) para reducir riesgo mientras se aprende.

No-objetivos (qué no estás construyendo explícitamente)

Sé explícito para evitar que el “scope creep” convierta una herramienta de experimentos en un sistema frágil crítico para el negocio:

- No es un reemplazo del sistema de facturación (facturas, impuestos, prorrateos, reembolsos).

- No es una plataforma BI completa (exploración libre de datos, SQL personalizado, modelado en warehouse).

- No es optimización ML compleja (motores de precios dinámicos, aprendizaje por refuerzo, auto-tuning).

Criterios de éxito

Define el éxito en términos operativos, no solo estadísticos:

- Insights listos para decisión: un PM puede elegir con confianza “lanzar / revertir / iterar”.

- Bajo riesgo operativo: valores por defecto seguros, rollback sencillo y exposición controlada.

- Auditabilidad: quién cambió qué, cuándo y por qué—adecuado para finanzas y revisiones de cumplimiento.

Modelo de datos: Experimentos, Variantes y Asignaciones

Una app de experimentos de precios vive o muere por su modelo de datos. Si no puedes responder con fiabilidad “qué precio vio este cliente y cuándo”, tus métricas estarán ruidosas y el equipo perderá la confianza.

Entidades clave para modelar

Empieza con un pequeño conjunto de objetos centrales que mapeen a cómo funcionan realmente los precios en tu producto:

- Producto: lo que se vende (p. ej., “Analytics Suite”).

- Plan: un nivel de empaquetado (p. ej., Starter, Pro, Enterprise).

- Precio: la cantidad real y reglas de facturación (moneda, intervalo, reglas por país/IVA, fechas efectivas).

- Cliente: la unidad de análisis (cuenta, usuario, workspace—elige una y mantenla).

- Segmento: una definición reutilizable (p. ej., “solo EE. UU.”, “autoservicio”, “nuevos clientes”).

- Experimento: el contenedor con scope, hipótesis, inicio/fin y targeting.

- Variante: cada tratamiento (Variante A = precio actual, Variante B = precio nuevo).

- Asignación: el registro de que un cliente fue colocado en una variante específica.

- Evento: acciones rastreadas (page_view, checkout_started, subscription_created, upgrade).

- Métrica: una definición computada (tasa de conversión, ARPA, ingresos por visitante, churn).

Identificadores y campos temporales que querrás después

Usa identificadores estables entre sistemas (product_id, plan_id, customer_id). Evita usar “nombres bonitos” como claves—cambian.

Los campos de tiempo son igual de importantes:

- created_at para todo.

- starts_at / ends_at en experimentos para ventanas de reporting.

- decision_date (o decided_at) para marcar cuándo se aceptó el resultado del experimento.

Considera también effective_from / effective_to en registros de Precio para poder reconstruir precios en un punto del tiempo.

Relaciones que hacen posible la atribución

Define relaciones explícitamente:

- Experiment → Variants (uno-a-muchos).

- Customer → Assignments (uno-a-muchos, pero a menudo limitado a una asignación activa por experimento).

- Event → Customer + Experiment + Variant.

Prácticamente, esto significa que un Evento debe llevar (o ser conectable a) customer_id, experiment_id y variant_id. Si solo almacenas customer_id y "buscas la asignación después", corres el riesgo de joins incorrectos cuando las asignaciones cambian.

Inmutabilidad: conserva el historial, no lo sobrescribas

Los experimentos de precios necesitan un historial apto para auditoría. Haz que los registros clave sean append-only:

- Precios deben versionarse, no actualizarse en sitio.

- Asignaciones nunca deben editarse para “arreglar” datos; si debes cambiar una exposición, crea un nuevo registro y cierra el anterior.

- Decisiones (winner, rationale, decision_date) deben preservarse incluso si vuelves a ejecutar un test similar.

Este enfoque mantiene tu reporting consistente y facilita características de gobernanza como logs de auditoría más adelante.

Flujo de trabajo y ciclo de vida del experimento

Un gestor de experimentos de precios necesita un ciclo de vida claro para que todos entiendan qué es editable, qué está bloqueado y qué pasa con los clientes cuando el experimento cambia de estado.

Ciclo de vida recomendado

Borrador → Programado → En ejecución → Detenido → Analizado → Archivado

- Borrador: Crear el experimento, variantes, audiencia y métricas. Nada se sirve a clientes.

- Programado: Se fija una hora de inicio (y opcionalmente de fin). El sistema valida la preparación y puede notificar a interesados.

- En ejecución: Asignación y entrega de precios en vivo. La mayoría de campos deben bloquearse para evitar cambios accidentales durante la prueba.

- Detenido: El experimento deja de asignar nuevos usuarios, y eliges cómo tratar a los existentes.

- Analizado: Resultados finalizados, documentados y compartidos.

- Archivado: Almacenamiento solo lectura para cumplimiento y referencia futura.

Campos requeridos y validación por estado

Para reducir lanzamientos riesgosos, exige campos obligatorios a medida que el experimento progresa:

- Antes de Programar: owner, scope (productos/regiones/planes), variantes y puntos de precio, reparto/exposición, fechas de inicio/fin.

- Antes de En ejecución: hipótesis, métrica(s) primaria(s), salvaguardas (p. ej., churn, reembolsos, tickets), tamaño mínimo de muestra o regla de tiempo mínimo, plan de rollback y confirmación del esquema de tracking/eventos.

- Antes de Analizar: tiempo del snapshot final de datos, notas de análisis y decisión (lanzar/iterar/rechazar).

Puertas de aprobación y overrides

Para precios, añade puertas opcionales para Finanzas y Legal/Compliance. Solo los aprobadores pueden mover Programado → En ejecución. Si permites overrides (p. ej., rollback urgente), registra quién sobreescribió, por qué y cuándo en un log de auditoría.

Qué significa operacionalmente “Detener”

Cuando un experimento está Detenido, define dos comportamientos explícitos:

- Congelar asignaciones: dejar de asignar nuevos usuarios; mantener a los existentes anclados a su última variante asignada.

- Política de serving: o bien seguir sirviendo el último precio visto (estabilidad para usuarios en mitad de flujo) u revertir al baseline (rollback rápido).

Haz que esta sea una elección obligatoria al detener para que el equipo no pueda parar un experimento sin decidir el impacto a clientes.

Asignación de variantes y reparto de tráfico

Hacer la asignación correctamente es la diferencia entre una prueba de precios confiable y ruido confuso. Tu app debe facilitar definir quién recibe un precio y asegurarse de que lo siga viendo de forma consistente.

Asignación consistente (la regla “pegajosa”)

Un cliente debe ver la misma variante entre sesiones, dispositivos (cuando sea posible) y refrescos. Eso significa que la asignación debe ser determinista: dado el mismo assignment key y experimento, el resultado siempre es el mismo.

Enfoques comunes:

- Asignación basada en hash: calcula un hash de

(experiment_id + assignment_key) y mapea a una variante.

- Asignación almacenada: escribe la variante asignada en una tabla para recuperación posterior (útil cuando necesitas auditoría o overrides complejos).

Muchos equipos usan hash-based por defecto y almacenan asignaciones solo cuando es necesario (casos de soporte o gobernanza).

Elegir una clave de asignación

Tu app debería soportar múltiples claves, porque el precio puede ser a nivel de usuario o de cuenta:

- user_id: mejor cuando el precio es individual y los usuarios hacen login de manera fiable.

- account_id / org_id: mejor para B2B para que todos en la misma compañía vean el mismo precio.

- cookie anónima/ID de dispositivo: útil antes del login, con un camino de upgrade para fusionar en

user_id tras el registro/login.

Ese camino de upgrade importa: si alguien navega como anónimo y luego crea una cuenta, debes decidir si conservar su variante original (continuidad) o reasignarle (reglas de identidad más limpias). Hazlo una configuración clara y explícita.

Reparto de tráfico y ramp-ups

Soporta asignación flexible:

- 50/50 para A/B simples

- Repartos ponderados (p. ej., 90/10) para control de riesgo

- Programas de rampa (p. ej., 1% → 5% → 25% → 50%) con fechas/horas

Al rampear, mantén las asignaciones pegajosas: aumentar tráfico debe añadir nuevos usuarios al experimento, no reordenar a los existentes.

Casos límite que debes manejar

Los tests concurrentes pueden colisionar. Construye salvaguardas para:

- Grupos mutuamente exclusivos (solo un experimento de precios activo por usuario/cuenta)

- Reglas de prioridad (si dos experimentos apuntan al mismo cliente, ¿cuál gana?)

- Exclusiones (personal interno, cuentas de soporte/test, regiones, planes, contratos existentes)

Una pantalla clara de “Previsualización de asignación” (dado un usuario/cuenta de ejemplo) ayuda a equipos no técnicos a verificar las reglas antes del lanzamiento.

Integrar precios en tu producto con seguridad

Go from build to deploy

Hospeda tu herramienta interna y itera a medida que tu equipo comienza a ejecutar pruebas reales.

Los experimentos de precios fallan con mayor frecuencia en la capa de integración—no porque la lógica del experimento esté mal, sino porque el producto muestra un precio y cobra otro. Tu app web debe dejar muy explícito “qué es el precio” y “cómo lo usa el producto”.

Separa la definición del precio de la entrega del precio

Trata la definición del precio como la fuente de verdad (las reglas de precio de la variante, fechas efectivas, moneda, manejo de impuestos, etc.). Trata la entrega del precio como un mecanismo sencillo para recuperar el precio elegido mediante un endpoint API o SDK.

Esta separación mantiene limpio el gestor de experimentos: equipos no técnicos editan definiciones, mientras los ingenieros integran un contrato de entrega estable como GET /pricing?sku=....

Decide dónde se calcula el precio

Hay dos patrones comunes:

- Server-side en el checkout (recomendado para el cobro): calcula el importe final pagable en el servidor para evitar inconsistencias y manipulaciones.

- Client-side para visualización: aceptable para mostrar precios estimados, pero debe respaldarse por totales calculados en servidor al comprar.

Un enfoque práctico es “mostrar en cliente, verificar y calcular en servidor”, usando la misma asignación de experimento.

Sé estricto con monedas, impuestos y redondeos

Las variantes deben seguir las mismas reglas para:

- selección de moneda (locale del usuario vs país de facturación)

- inclusión de impuestos (IVA incluido vs agregado)

- redondeo (por ítem vs por factura)

Almacena estas reglas junto al precio para que cada variante sea comparable y amigable para finanzas.

Planes de fallback seguros

Si el servicio de experimentos es lento o cae, tu producto debe devolver un precio por defecto seguro (normalmente el baseline). Define timeouts, caching y una política clara de “fail closed” para que el checkout no se rompa—y registra los fallbacks para poder cuantificar el impacto.

Métricas, eventos y nociones básicas de atribución

Los experimentos de precios viven o mueren por la medición. Tu app debe hacer difícil el “lanzar y esperar” exigiendo métricas primarias claras, eventos limpios y un enfoque de atribución consistente antes de que un experimento pueda arrancar.

Elige métricas primarias (las “métricas de decisión”)

Empieza con una o dos métricas que usarás para decidir el ganador. Elecciones comunes en precios:

- Tasa de conversión (p. ej., visitante → checkout, trial → pago)

- Ingresos por visitante (RPV) (captura precio y conversión juntos)

- ARPA/ARPU (útil para suscripciones)

- Churn / retención (solo si puedes medirlo en una ventana razonable)

Una regla útil: si los equipos discuten el resultado después de la prueba, probablemente no definiste bien la métrica de decisión.

Añade salvaguardas (las métricas “no romper el negocio”)

Las salvaguardas detectan daños que un precio más alto podría causar aunque los ingresos a corto plazo parezcan buenos:

- Tasa de reembolso y contracargos

- Tickets de soporte (facturación, confusión, quejas)

- Fallos de pago (declines, problemas 3DS)

- Caída trial→pago (los cambios de precio pueden afectar la intención)

Tu app puede aplicar salvaguardas exigiendo umbrales (p. ej., “la tasa de reembolso no debe aumentar más de 0.3%”) y resaltando incumplimientos en la página del experimento.

Define un esquema de eventos en el que tu app pueda confiar

Como mínimo, tu tracking debe incluir identificadores estables del experimento y la variante en cada evento relevante.

{

"event": "purchase_completed",

"timestamp": "2025-01-15T12:34:56Z",

"user_id": "u_123",

"experiment_id": "exp_earlybird_2025_01",

"variant_id": "v_price_29",

"currency": "USD",

"amount": 29.00

}

Haz que estas propiedades sean obligatorias en el momento de la ingesta, no “lo mejor posible”. Si llega un evento sin experiment_id/variant_id, enrútalo a una cubeta “no atribuido” y marca problemas de calidad de datos.

Elige ventanas de atribución (y maneja resultados retardados)

Los resultados de precios a menudo se retrasan (renovaciones, upgrades, churn). Define:

- Ventana de atribución: p. ej., “contar compras dentro de 7 días desde la primera exposición”

- Regla de exposición: primera exposición vs última exposición (primera suele ser más segura para precios)

- Métricas retardadas: muestra un “lector preliminar” rápido, pero mantén un estado “final” que se actualice cuando cierre la ventana

Esto mantiene al equipo alineado sobre cuándo un resultado es fiable—y evita decisiones prematuras.

UX y pantallas para equipos no técnicos

Avoid price mismatches

Implementa un endpoint estable de entrega de precios que puedan compartir tu página de precios y el checkout.

Una herramienta de experimentos de precios solo funciona si PMs, marketing y finanzas pueden usarla sin pedir a ingeniería por cada clic. La UI debe responder tres preguntas rápidamente: Qué está en ejecución? Qué cambiará para los clientes? Qué pasó y por qué?

Pantallas principales a incluir

Listado de experimentos debería sentirse como un dashboard operativo. Muestra: nombre, estado (Borrador/Programado/En ejecución/Pausado/Finalizado), fechas, reparto de tráfico, métrica primaria y owner. Añade un “última modificación por” con timestamp para que la gente confíe en lo que ve.

Detalle del experimento es la base. Pon un resumen compacto arriba (estado, fechas, audiencia, reparto, métrica primaria). Debajo, usa pestañas como Variantes, Targeting, Métricas, Registro de cambios y Resultados.

Editor de variantes debe ser sencillo y con opinión. Cada fila de variante debe incluir precio (o regla de precio), moneda, periodo de facturación y una descripción en lenguaje natural (“Anual: $120 → $108”). Haz difícil editar accidentalmente una variante en vivo requiriendo confirmación.

Vista de resultados debe empezar con la decisión, no solo gráficos: “La Variante B aumentó la conversión en checkout un 2.1% (IC 95% …).” Luego ofrece desglose y filtros de soporte.

Diseña para claridad (y confianza)

Usa badges de estado consistentes y muestra una línea de tiempo de fechas clave. Presenta el reparto de tráfico como porcentaje y una pequeña barra. Incluye un panel (o pestaña) “Quién cambió qué” que liste ediciones a variantes, targeting y métricas.

Salvaguardas y validación

Antes de permitir Iniciar, exige: al menos una métrica primaria, al menos dos variantes con precios válidos, un plan de rampa (opcional pero recomendado) y un plan de rollback o precio de fallback. Si falta algo, muestra errores accionables (“Añade una métrica primaria para ver resultados”).

Acciones rápidas que ahorran tiempo

Proporciona acciones seguras y visibles: Pausar, Detener, Aumentar tráfico (p. ej., 10% → 25% → 50%), y Duplicar (copiar configuración a un nuevo Borrador). Para acciones riesgosas, usa confirmaciones que resuman el impacto (“Pausar congela asignaciones y detiene la exposición”).

Prototipar la herramienta interna más rápido

Si quieres validar flujos (Borrador → Programado → En ejecución) antes de invertir en una construcción completa, una plataforma vibe-coding como Koder.ai puede ayudarte a montar una app interna desde una especificación conversacional—luego iteras rápido con pantallas con roles, registros de auditoría y dashboards sencillos. Es especialmente útil para prototipos tempranos donde quieres una UI React funcional y un backend Go/PostgreSQL que luego puedas exportar y endurecer.

Dashboards y reporting que impulsan decisiones

Un dashboard de experimentos de precios debe responder una pregunta rápidamente: “¿Deberíamos mantener este precio, revertirlo o seguir aprendiendo?” El mejor reporting no es el más sofisticado—es el más fácil de confiar y de explicar.

Lo esencial por encima del pliegue

Comienza con un pequeño conjunto de gráficos de tendencia que se actualicen automáticamente:

- Tasa de conversión en el tiempo (con un marcador claro de “inicio del experimento”)

- Ingresos por visitante (o valor medio de pedido, según tu negocio)

- Reembolsos/cancelaciones si el precio afecta la retención

Debajo de los gráficos, incluye una tabla comparativa de variantes: nombre de variante, share de tráfico, visitantes, compras, tasa de conversión, ingresos por visitante y el delta vs control.

Para indicadores de confianza, evita vocabulario académico. Usa etiquetas sencillas como:

- “Lectura temprana” (no hay suficientes datos)

- “Tendencia mejor/peor” (direccional)

- “Alta confianza” (listo para decisión)

Un tooltip corto puede explicar que la confianza aumenta con tamaño de muestra y tiempo.

Desgloses por segmento que evitan malos despliegues

El precio a menudo “gana” en conjunto pero falla en grupos clave. Haz que las pestañas de segmento sean fáciles de cambiar:

- Nuevos vs recurrentes

- Región (país/estado)

- Dispositivo (móvil/escritorio)

- Nivel de plan (o categoría de producto)

Mantén las mismas métricas en todos lados para que las comparaciones sean coherentes.

Alertas de anomalías que puedas actuar

Añade alertas ligeras directamente en el dashboard:

- Bajada súbita de conversión tras un cambio de precio

- Pico de ingresos que puede ser causado por bugs de tracking o eventos puntuales

- Huecos de datos (eventos parados, tráfico inusualmente bajo, ingestión retrasada)

Cuando aparece una alerta, muestra la ventana sospechada y un enlace al estado bruto de eventos.

Exportes y compartir para alineación rápida

Haz que el reporting sea portable: un CSV para la vista actual (incluyendo segmentos) y un enlace interno compartible al reporte del experimento. Si es útil, vincula una explicación corta como /blog/metric-guide para que los interesados entiendan lo que ven sin otra reunión.

Permisos, registros de auditoría y gobernanza

Los experimentos de precios tocan ingresos, confianza del cliente y a menudo reporting regulado. Un modelo de permisos simple y un rastro de auditoría claro reducen lanzamientos accidentales, disputas de “quién cambió esto?” y te ayudan a lanzar más rápido con menos reversiones.

Roles que coincidan con cómo trabajan los equipos

Mantén roles fáciles de explicar y difíciles de malusar:

- Viewer: acceso solo lectura a la configuración, estado y reportes.

- Editor: puede crear borradores (variantes, copy, reglas de elegibilidad) pero no puede iniciar/detener ni cambiar splits en producción.

- Approver: revisa y aprueba borradores, y puede realizar acciones en producción (iniciar, detener, ajustar tráfico) dentro de las salvaguardas.

- Admin: gestiona roles, ajustes globales y controles de emergencia.

Si tienes múltiples productos o regiones, scopea roles por workspace (p. ej., “Precios EU”) para que un editor en un área no pueda impactar otra.

Registros de auditoría en los que puedas confiar

Tu app debe registrar cada cambio con quién, qué, cuándo, idealmente con diffs "antes/después". Eventos mínimos a capturar:

- Definiciones de variantes (precio, moneda, periodo), repartos, inicio/parada y reglas de targeting.

- Acciones de aprobación (solicitado, aprobado, rechazado) y rollbacks.

- Cambios de fuentes de datos (qué stream de ingresos o eventos se está usando).

Haz los logs buscables y exportables (CSV/JSON), y enlázalos directamente desde la página del experimento para que los revisores no tengan que buscarlos. Una vista dedicada /audit-log ayuda a compliance.

Trata identificadores de cliente y datos de ingresos como sensibles por defecto:

- Oculta identificadores crudos (hashing, tokenización) y limita acceso a desgloses de ingresos.

- Restringe reglas de segmentación que puedan revelar atributos protegidos.

- Almacena secretos (API keys, credenciales de warehouse) fuera de la base de datos principal.

Comentarios y notas de decisión

Añade notas ligeras en cada experimento: la hipótesis, impacto esperado, razón de aprobación y un resumen de “por qué lo detuvimos”. Seis meses después, estas notas evitan repetir ideas fallidas—y hacen el reporting mucho más creíble.

Pruebas y chequeos de calidad antes del lanzamiento

Get decision-ready reporting

Crea una vista de resultados amigable para operadores con métricas clave y desgloses por segmento.

Los experimentos de precios fallan de formas sutiles: un split 50/50 deriva a 62/38, una cohorte ve la moneda equivocada o los eventos no llegan a los reportes. Antes de permitir que clientes reales vean un precio nuevo, trata el sistema de experimentos como una funcionalidad de pago—valida comportamiento, datos y modos de fallo.

Consistencia de asignación y precisión del split

Comienza con casos de prueba deterministas para demostrar que la lógica de asignación es estable entre servicios y versiones. Usa inputs fijos (IDs de cliente, claves de experimento, salt) y afirma que la misma variante se devuelve siempre.

customer_id=123, experiment=pro_annual_price_v2 -> variant=B

customer_id=124, experiment=pro_annual_price_v2 -> variant=A

Luego prueba la distribución a escala: genera, por ejemplo, 1M de IDs sintéticos y verifica que el split observado se mantenga dentro de una tolerancia estrecha (p. ej., 50% ± 0.5%). También verifica casos límite como topes de tráfico (solo 10% inscritos) y grupos holdout.

Validar la recolección de eventos end-to-end

No te quedes en “el evento se disparó”. Añade un flujo automatizado que cree una asignación de prueba, dispare un evento de compra o checkout y verifique:

- el evento es aceptado por el colector

- se almacena con los campos de experiment/variant correctos

- aparece en la consulta de reporting con timestamps correctos y deduplicación

Ejecuta esto en staging y en producción con un experimento de prueba limitado a usuarios internos.

Herramientas de QA para comprobaciones no técnicas

Da a QA y PMs una herramienta simple de “previsualización”: introduce un customer ID (o session ID) y muestra la variante asignada y el precio exacto que se renderizaría. Esto detecta redondeos erróneos, moneda equivocada, impuestos y problemas de plan antes del lanzamiento.

Considera una ruta interna segura como /experiments/preview que nunca altera asignaciones reales.

Simular fallos y malas configuraciones

Practica los escenarios feos:

- Pipeline de eventos caído: la UI sigue funcionando; métricas muestran un banner de advertencia y una marca de “datos incompletos”.

- Servicio de experimentos no disponible: el producto vuelve al precio de control (y registra el fallback).

- Configuración mala (experimentos solapados, precio inválido): bloquea la publicación con errores de validación claros.

Si no puedes responder con confianza “qué ocurre cuando X falla”, no estás listo para lanzar.

Lanzamiento, monitoreo y plan de iteración

Lanzar un gestor de experimentos de precios es menos “entregar una pantalla” y más asegurar que puedes controlar el blast radius, observar comportamiento rápidamente y recuperar de forma segura.

Enfoque de despliegue: reducir el riesgo el primer día

Comienza con una ruta de lanzamiento acorde con tu nivel de confianza y las limitaciones del producto:

- Despliegue por etapas: habilita experimentos para un pequeño porcentaje del tráfico elegible y luego expande en pasos (p. ej., 1% → 10% → 50%).

- Feature flag: protege el sistema de experimentos de precios tras una bandera para poder apagarlo sin redeploy. Útil mientras las integraciones se estabilizan.

- Beta interna: restringe experimentos a empleados o cuentas de prueba para validar asignación, renderizado de precio e integridad de checkout antes de exponer clientes reales.

Monitoreo: qué vigilar las primeras horas

Trata el monitoreo como requisito de release, no como "agradable de tener". Configura alertas para:

- Tasas de error: fallos de API, errores en checkout y excepciones del servicio de precios.

- Latencia: p95/p99 para fetch de precio, asignación y páginas de checkout.

- Volumen de eventos: caídas o picos súbitos en eventos clave (ver precio, añadir al carrito, compra).

- Atribución faltante: compras sin experiment/variant IDs, o variant IDs que no coinciden con el log de asignaciones.

Runbooks: pausar y revertir rápidamente

Crea un runbook escrito para operaciones y on-call:

- Un kill switch global para pausar todos los experimentos.

- Un camino de revertir al precio baseline (precios cacheados, valores por defecto).

- Propiedad clara: quién aprueba pausar, quién comunica el impacto y cómo registrar el incidente.

Iteración después del MVP

Tras estabilizar el flujo central, prioriza mejoras que desbloqueen mejores decisiones: reglas de targeting (geo, plan, tipo de cliente), estadísticas y salvaguardas más robustas, e integraciones (data warehouse, facturación, CRM). Si ofreces niveles o empaquetados, considera exponer capacidades de experimento en /pricing para que los equipos entiendan lo soportado.