Por qué importa esta historia para los equipos que ejecutan software

Los equipos no tienen problemas porque no puedan arrancar un contenedor. Los tienen porque deben ejecutar cientos de ellos de forma segura, actualizarlos sin tiempo de inactividad, recuperarse cuando algo falla y, aun así, entregar funcionalidades según lo planeado.

La historia de “cloud-native” de Craig McLuckie importa porque no es una alabanza de demos llamativos. Es un registro de cómo los contenedores se volvieron operables en entornos reales: donde ocurren incidentes, existen requisitos de cumplimiento y el negocio necesita entregas predecibles.

Cloud-native, en términos sencillos

“Cloud-native” no es solo “ejecutarse en la nube”. Es un enfoque para construir y operar software de modo que pueda desplegarse con frecuencia, escalar cuando cambia la demanda y repararse rápidamente cuando partes fallan.

En la práctica, eso suele significar:

- Aplicaciones empaquetadas y distribuidas de forma consistente (a menudo con contenedores)

- Sistemas diseñados como servicios más pequeños, no como un único monolito

- Automatización para despliegues, escalado y rollbacks

- Formas estándar de observar, asegurar y gobernar lo que está en ejecución

La adopción temprana de contenedores a menudo parecía una caja de herramientas: los equipos tomaban Docker, unían scripts y esperaban que Operaciones siguiera el ritmo. El pensamiento de plataforma invierte eso. En lugar de que cada equipo invente su propio camino a producción, construyes “caminos pavimentados” compartidos: una plataforma que hace que la forma segura, conforme y observable sea también la forma fácil.

Ese cambio es el puente entre “podemos ejecutar contenedores” y “podemos ejecutar un negocio con ellos”.

Para quién es este artículo

Esto es para las personas responsables de resultados, no solo de diagramas de arquitectura:

- Líderes de ingeniería que equilibran velocidad y fiabilidad

- Equipos de producto que quieren iterar más rápido sin interrupciones

- Personal de plataforma, DevOps y SRE que intenta reducir el trabajo repetitivo y la fricción

- Desarrolladores que solo quieren que los despliegues sean aburridos y repetibles

Si tu objetivo es una entrega fiable a escala, esta historia ofrece lecciones prácticas.

Quién es Craig McLuckie (y por qué la gente lo menciona)

Craig McLuckie es uno de los nombres más asociados con el movimiento cloud-native temprano. Lo verás referenciado en conversaciones sobre Kubernetes, la Cloud Native Computing Foundation (CNCF) y la idea de que la infraestructura debe tratarse como un producto, no como un montón de tickets y conocimiento tribal.

No “el inventor”, pero sí un constructor clave

Conviene ser preciso. McLuckie no “inventó” cloud-native en solitario, y Kubernetes nunca fue un proyecto de una sola persona. Kubernetes fue creado por un equipo en Google, y McLuckie formó parte de ese esfuerzo inicial.

A menudo se le atribuye haber ayudado a convertir un concepto de ingeniería en algo que la industria más amplia pudiera adoptar: mayor construcción de comunidad, empaquetado más claro y un empuje hacia prácticas operativas repetibles.

A lo largo de Kubernetes y la era CNCF, el mensaje de McLuckie ha sido menos sobre arquitecturas de moda y más sobre hacer la producción predecible. Eso implica:

- Formas estándar de desplegar y hacer rollback

- Entornos consistentes desde el portátil hasta producción

- Guardarraíles operativos que reduzcan las sorpresas

Si has oído palabras como “paved roads”, “golden paths” o “platform as a product”, estás orbitando la misma idea: reducir la carga cognitiva para los equipos haciendo que lo correcto sea lo fácil.

Por qué lo mencionamos aquí

Este post no es una biografía. McLuckie es un punto de referencia útil porque su trabajo se sitúa en la intersección de tres fuerzas que cambiaron la entrega de software: contenedores, orquestación y construcción de ecosistemas. Las lecciones no giran en torno a la personalidad, sino a por qué el pensamiento de plataforma fue la llave para ejecutar contenedores en producción real.

Antes de cloud-native: los contenedores eran reales, la producción era difícil

Los contenedores fueron una idea emocionante mucho antes de que “cloud-native” fuera un término común. En términos sencillos, un contenedor es una forma de empaquetar una aplicación junto con los archivos y librerías que necesita para que se ejecute de la misma manera en distintas máquinas, como enviar un producto en una caja sellada con todas sus piezas dentro.

Por qué el uso temprano de contenedores se mantuvo experimental

Al principio, muchos equipos usaban contenedores para proyectos secundarios, demos y flujos de trabajo de desarrollador. Eran excelentes para probar servicios nuevos rápidamente, crear entornos de prueba y evitar sorpresas del tipo “funciona en mi portátil” durante un traspaso.

Pero pasar de unos pocos contenedores a un sistema de producción que funcione 24/7 es otro trabajo. Las herramientas existían, pero la historia operativa estaba incompleta.

Los bloqueos de producción que enfrentaron los equipos

Los problemas comunes surgieron pronto:

- Actualizaciones y rollbacks: ¿Cómo actualizar docenas (o cientos) de contenedores en ejecución de forma segura, sin tiempo de inactividad? ¿Y cómo revertir cuando algo falla?

- Redes: Los contenedores necesitan encontrarse entre sí de forma fiable. Descubrimiento de servicios, enrutamiento de tráfico, balanceo de carga y “quién puede hablar con quién” no estaban estandarizados.

- Seguridad: Procedencia de imágenes, gestión de secretos, controles de acceso y parcheo de vulnerabilidades se convirtieron en trabajo continuo, no en una configuración única.

- Monitorización y depuración: Cuando un contenedor se reinicia, los logs pueden desaparecer. Métricas, trazabilidad y alertas debían diseñarse para un mundo donde los procesos son efímeros.

De “funciona en mi máquina” a “funciona todos los días a escala”

Los contenedores ayudaron a que el software fuera portable, pero la portabilidad por sí sola no garantizaba fiabilidad. Los equipos aún necesitaban prácticas de despliegue consistentes, propiedad clara y guardarraíles operativos, para que las aplicaciones contenedorizadas no solo funcionaran una vez, sino que funcionaran de forma predecible cada día.

El pensamiento de plataforma es el momento en que una empresa deja de tratar la infraestructura como un proyecto puntual y empieza a tratarla como un producto interno. Los “clientes” son tus desarrolladores, equipos de datos y cualquiera que entregue software. El objetivo del producto no es más servidores ni más YAML: es un camino más fluido desde la idea hasta producción.

Una plataforma real tiene una promesa clara: “Si construyes y despliegas usando estos caminos, obtendrás fiabilidad, seguridad y entrega predecible.” Esa promesa requiere hábitos de producto: documentación, soporte, versionado y bucles de retroalimentación. También exige una experiencia de usuario deliberada: valores por defecto sensatos, caminos pavimentados y una salida cuando los equipos realmente la necesiten.

Por qué la estandarización acelera la entrega (y reduce el riesgo)

La estandarización elimina la fatiga de decisión y previene la complejidad accidental. Cuando los equipos comparten los mismos patrones de despliegue, logging y controles de acceso, los problemas se vuelven repetibles y, por tanto, solucionables. Las rotaciones de on-call mejoran porque los incidentes son familiares. Las revisiones de seguridad son más rápidas porque la plataforma incorpora guardarraíles en lugar de depender de que cada equipo los vuelva a inventar.

No se trata de forzar a todos a encajar en la misma caja. Se trata de ponerse de acuerdo en el 80% que debería ser aburrido, para que los equipos gasten energía en el 20% que diferencia al negocio.

De servidores hechos a mano a patrones repetibles

Antes de los enfoques de plataforma, la infraestructura a menudo dependía de conocimiento especial: unas pocas personas sabían qué servidores estaban parchados, qué ajustes eran seguros y qué scripts eran “los buenos”. El pensamiento de plataforma reemplaza eso con patrones repetibles: plantillas, aprovisionamiento automatizado y entornos consistentes de desarrollo a producción.

Gobernanza sin burocracia

Bien hecha, una plataforma crea mejor gobernanza con menos papeleo. Las políticas se convierten en comprobaciones automatizadas, las aprobaciones en flujos auditable y la evidencia de cumplimiento se genera a medida que los equipos despliegan, de modo que la organización obtiene control sin frenar a todos.

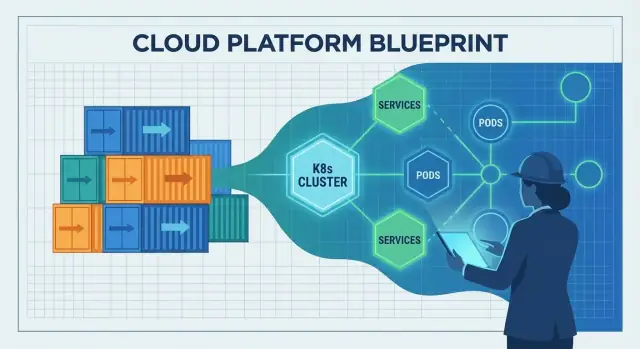

Kubernetes como puente entre contenedores y operaciones

Los contenedores facilitaron empaquetar y enviar una app. La parte difícil era lo que pasaba después de enviarla: elegir dónde correr, mantenerla sana y adaptarla cuando cambia el tráfico o la infraestructura.

Ahí es donde Kubernetes cubrió la brecha. Transformó “un montón de contenedores” en algo que puedes operar día tras día, incluso cuando servidores fallan, ocurren releases y la demanda se dispara.

Lo que la orquestación realmente resuelve

Kubernetes se describe a menudo como “orquestación de contenedores”, pero los problemas prácticos son más específicos:

- Planificación (scheduling): decidir qué máquina debe ejecutar cada contenedor, según CPU/memoria disponibles y reglas de colocación.

- Autocuración: reiniciar contenedores caídos, reubicar si un nodo muere y mantener el número deseado de instancias.

- Escalado: aumentar o disminuir réplicas según demanda y desplegar nuevas versiones sin tumbarlo todo.

Sin orquestador, los equipos acaban scriptando esos comportamientos y gestionando excepciones a mano, hasta que los scripts dejan de reflejar la realidad.

Un plano de control común

Kubernetes popularizó la idea de un plano de control compartido: un único lugar donde declaras lo que quieres (“ejecuta 3 copias de este servicio”) y la plataforma trabaja continuamente para hacer que el mundo real coincida con esa intención.

Esto supone un gran cambio en responsabilidades:

- Desarrolladores despliegan: construyen una imagen, aplican un deployment, fijan requests de recursos y definen health checks.

- La plataforma lo mantiene en marcha: coloca cargas, reemplaza instancias fallidas, gestiona rollouts y mantiene el descubrimiento de servicios.

Construido a partir de patrones operacionales reales

Kubernetes no apareció porque los contenedores fueran tendencia. Creció a partir de lecciones aprendidas operando flotas grandes: trata la infraestructura como un sistema con bucles de retroalimentación, no como un conjunto de tareas puntuales en servidores. Esa mentalidad operativa es la razón por la que se convirtió en el puente entre “podemos ejecutar contenedores” y “podemos ejecutarlos de forma fiable en producción”.

Lo que cambió cloud-native en la entrega diaria

Lanza con reversión disponible

Crea instantáneas mientras iteras para revertir cambios rápidamente.

Cloud-native no introdujo solo herramientas nuevas: cambió el ritmo diario de entrega de software. Los equipos pasaron de “servidores hechos a mano y runbooks manuales” a sistemas diseñados para ser dirigidos por APIs, automatización y configuración declarativa.

De tickets y SSH a APIs y automatización

Un entorno cloud-native asume que la infraestructura es programable. ¿Necesitas una base de datos, un balanceador o un nuevo entorno? En lugar de esperar una configuración manual, los equipos describen lo que quieren y dejan que la automatización lo cree.

El cambio clave es la configuración declarativa: defines el estado deseado (“ejecuta 3 copias de este servicio, expónlo en este puerto, limita memoria a X”) y la plataforma trabaja continuamente para alcanzar ese estado. Esto hace los cambios revisables, repetibles y más fáciles de revertir.

Implementaciones inmutables reducen la deriva

La entrega tradicional a menudo implicaba parchear servidores en vivo. Con el tiempo, cada máquina se volvía un poco distinta: deriva de configuración que solo aparece durante un incidente.

La entrega cloud-native impulsó a los equipos hacia implementaciones inmutables: construye un artefacto una vez (a menudo una imagen de contenedor), despliega esa versión y si necesitas un cambio, despliegas una nueva versión en lugar de modificar lo que está en ejecución. Combinado con rollouts automáticos y health checks, este enfoque tiende a reducir las “caídas misteriosas”.

Microservicios y contenedores: un bucle que se refuerza (con trade-offs)

Los contenedores facilitaron empaquetar y ejecutar muchos servicios pequeños de forma consistente, lo que fomentó arquitecturas de microservicios. A su vez, los microservicios aumentaron la necesidad de despliegue consistente, escalado y descubrimiento de servicios—áreas donde la orquestación de contenedores destaca.

El trade-off: más servicios implican más sobrecarga operativa (monitorización, redes, versionado, respuesta a incidentes). Lo cloud-native ayuda a gestionar esa complejidad, pero no la elimina.

Portabilidad: real, pero no mágica

La portabilidad mejoró porque los equipos se estandarizaron en primitivas y APIs comunes. Aun así, “ejecutar en cualquier lugar” suele requerir trabajo: diferencias en seguridad, almacenamiento, redes y servicios gestionados importan. Cloud-native se entiende mejor como reducir el bloqueo y la fricción, no como eliminarlos.

CNCF y el efecto ecosistema: por qué aceleró la adopción

Kubernetes no se difundió solo porque fuera potente. Se difundió porque obtuvo un hogar neutral, gobernanza clara y un lugar donde empresas competidoras podían cooperar sin que un proveedor “poseyera” las reglas.

Una fundación neutral hace la colaboración más segura

La Cloud Native Computing Foundation (CNCF) creó gobernanza compartida: toma de decisiones abierta, procesos predecibles para proyectos y roadmaps públicos. Eso importa para equipos que apuestan por infraestructura central. Cuando las reglas son transparentes y no están atadas al modelo de negocio de una sola compañía, la adopción se siente menos arriesgada y las contribuciones se vuelven más atractivas.

El rol de la CNCF: más que un logo

Al albergar Kubernetes y proyectos relacionados, la CNCF ayudó a convertir “una herramienta open source popular” en una plataforma a largo plazo con respaldo institucional. Proporcionó:

- Una forma consistente de gestionar mantenedores, releases y prácticas de seguridad

- Un espacio para la coordinación entre compañías

- Una señal al mercado: este proyecto está pensado para sobrevivir a cualquier proveedor

Estándares abiertos y contribuyentes diversos

Con muchos colaboradores (proveedores de nube, startups, empresas y ingenieros independientes), Kubernetes evolucionó más rápido y en direcciones del mundo real: redes, almacenamiento, seguridad y operaciones day-2. APIs abiertas y estándares facilitaron la integración de herramientas, lo que redujo el vendor lock-in y aumentó la confianza para uso en producción.

El efecto ecosistema (y el trade-off)

La CNCF también aceleró una explosión de ecosistemas: service meshes, controladores de ingreso, herramientas CI/CD, motores de políticas, pilas de observabilidad y más. Esa abundancia es una fortaleza, pero crea solapamientos.

Para la mayoría de equipos, el éxito llega al elegir un pequeño conjunto de componentes bien soportados, priorizar la interoperabilidad y definir claramente la propiedad. Intentar usar “lo mejor de todo” suele generar carga de mantenimiento en lugar de mejor entrega.

De herramientas a fiabilidad: la capa operacional que faltaba

Una especificación, web y móvil

Crea una app web y una app móvil en Flutter a partir de los mismos requisitos.

Los contenedores y Kubernetes resolvieron una gran parte del “¿cómo ejecutamos software?”. No resolvieron automáticamente la pregunta más dura: “¿cómo lo mantenemos en funcionamiento cuando llegan usuarios reales?”. La capa que faltaba es la fiabilidad operativa: expectativas claras, prácticas compartidas y un sistema que haga que los comportamientos correctos sean el valor por defecto.

Definir la línea base de producción

Un equipo puede entregar rápido y aun así estar a una mala implementación de la catástrofe si la línea base de producción no está definida. Como mínimo necesitas:

- Observabilidad: la capacidad de ver qué está pasando y por qué (no solo si está “up”).

- Respuesta a incidentes: roles, rotación on-call, rutas de escalado y revisiones post-incident.

- Planificación de capacidad: entender carga, límites y comportamiento bajo estrés.

Sin esa base, cada servicio inventa sus propias reglas y la fiabilidad queda en manos del azar.

DevOps y SRE introdujeron hábitos importantes: propiedad, automatización, fiabilidad medida y aprendizaje tras incidentes. Pero los hábitos solos no escalan entre decenas de equipos y cientos de servicios.

Las plataformas hacen que esas prácticas sean repetibles. SRE fija objetivos (como SLOs) y bucles de retroalimentación; la plataforma proporciona caminos pavimentados para alcanzarlos.

Componentes “mínimos” de fiabilidad

La entrega fiable suele requerir un conjunto consistente de capacidades:

- Logging, métricas, trazas (para depurar y mejorar)

- Alerting ligado al impacto sobre usuarios (para que el on-call no sea ruido)

- Rollbacks seguros y patrones de entrega progresiva (para que las fallas no sean catastróficas)

Una buena plataforma incorpora estos valores por defecto en plantillas, pipelines y políticas de runtime: dashboards estándar, reglas de alerta comunes, guardarraíles de despliegue y mecanismos de rollback. Así la fiabilidad deja de ser opcional y pasa a ser un resultado predecible de entregar software.

Las herramientas cloud-native pueden ser poderosas y aun así sentirse como “demasiado” para la mayoría de equipos de producto. La ingeniería de plataformas existe para cerrar esa brecha. La misión es simple: reducir la carga cognitiva de los equipos de aplicación para que puedan lanzar funcionalidades sin convertirse en expertos en infraestructura a tiempo parcial.

Un equipo de plataforma eficaz trata la infraestructura interna como un producto: usuarios claros (desarrolladores), resultados claros (entrega segura y repetible) y un bucle de retroalimentación. En lugar de entregar un conjunto de primitivas de Kubernetes, la plataforma ofrece formas opinadas de construir, desplegar y operar servicios.

Una mirada práctica: “¿Puede un desarrollador ir de la idea a un servicio en ejecución sin abrir una docena de tickets?” Las herramientas que comprimen ese flujo—preservando guardarraíles—están alineadas con la meta cloud-native de la plataforma.

Bloques de construcción que hacen practicable lo cloud-native

La mayoría de plataformas son un conjunto de “caminos pavimentados” reutilizables que los equipos eligen por defecto:

- Plantillas y scaffolding para nuevos servicios (estructura de repos, CI, observabilidad base)

- Flujos de autoservicio (crear un entorno, pedir una base de datos, rotar secretos)

- Patrones de despliegue estándar (ingress, autoscaling, health checks, canary releases)

La idea no es ocultar Kubernetes; es empaquetarlo en valores por defecto sensatos que prevengan complejidad accidental.

En ese espíritu, Koder.ai puede usarse como una capa “aceleradora de DX” para equipos que quieran prototipar herramientas internas o funcionalidades de producto rápidamente vía chat, y luego exportar código fuente cuando sea momento de integrarlo con una plataforma más formal. Para equipos de plataforma, su modo de planificación y las instantáneas/rollback incorporadas también pueden reflejar la misma postura prioritaria en fiabilidad que buscas en los flujos de trabajo de producción.

Trade-offs: flexibilidad vs consistencia

Cada camino pavimentado implica un trade-off: más consistencia y operaciones más seguras, pero menos opciones puntuales. Los equipos de plataforma tienen mejores resultados cuando ofrecen:

- Un camino dorado para el 80% de los servicios

- Una salida para casos excepcionales legítimos (con propiedad explícita)

Señales de que funciona

El éxito de una plataforma se ve en métricas: incorporación más rápida de ingenieros, menos scripts de despliegue a medida, menos “clusters snowflake” y propiedad clara durante incidentes. Si los equipos pueden responder “¿quién es el dueño de este servicio y cómo lo desplegamos?” sin una reunión, la plataforma está cumpliendo.

Qué sale mal: trampas que ralentizan el progreso cloud-native

Cloud-native puede acelerar la entrega y calmar las operaciones, pero solo cuando los equipos son claros sobre qué quieren mejorar. Muchos retrocesos ocurren cuando Kubernetes y su ecosistema se tratan como el objetivo, no como el medio.

1) Kubernetes primero, resultados después

Un error común es adoptar Kubernetes porque “es lo que hacen los equipos modernos”, sin una meta concreta como reducir lead time, disminuir incidentes o mejorar la consistencia de entornos. El resultado es mucho trabajo de migración sin beneficios visibles.

Si no defines criterios de éxito desde el inicio, cada decisión se vuelve subjetiva: qué herramienta escoger, cuánto estandarizar y cuándo la plataforma está “lista”.

2) Incremento de complejidad por el ecosistema

Kubernetes es una base, no una plataforma completa. Los equipos a menudo añaden complementos rápidamente—service mesh, múltiples ingress controllers, operadores personalizados, motores de políticas—sin límites claros ni responsabilidad.

La sobrepersonalización es otra trampa: patrones YAML hechos a mano, plantillas caseras y excepciones que solo entienden sus autores. La complejidad sube, la incorporación se ralentiza y las actualizaciones se vuelven riesgosas.

3) Costos, proliferación y puntos ciegos de seguridad

Cloud-native facilita crear recursos—y olvidarlos. El crecimiento de clusters, namespaces sin uso y cargas sobredimensionadas inflan costos silenciosamente.

Los riesgos de seguridad son igualmente comunes:

- Permisos que crecen con el tiempo (RBAC amplio, cuentas de servicio compartidas)

- Riesgo en la cadena de suministro (imágenes no verificadas, demasiados charts de terceros)

- Políticas inconsistentes entre clusters y entornos

4) Cómo mitigar (sin detener el progreso)

Empieza pequeño con uno o dos servicios bien acotados. Define estándares temprano (caminos dorados, imágenes base aprobadas, reglas de upgrade) y mantén la superficie de la plataforma intencionadamente limitada.

Mide resultados como frecuencia de despliegue, tiempo medio de recuperación y tiempo hasta primer despliegue del desarrollador; considera cualquier cosa que no mejore esos números como opcional.

Un playbook práctico para aplicar estas lecciones

Convierte ideas en herramientas internas

Diseña paneles y apps de administración rápido, luego exporta el código a tu repositorio.

No "adoptas cloud-native" de un solo golpe. Los equipos que tienen éxito siguen la misma idea central asociada a la era de McLuckie: construir una plataforma que haga que lo correcto sea lo fácil.

Un camino de adopción simple

Empieza pequeño y codifica lo que funciona.

- Piloto: Elige un servicio que duela lo suficiente como para justificar el cambio, pero no crítico para el negocio. Contenedorízalo, automatiza builds y despliega repetidamente hasta que sea rutinario.

- MVP de plataforma: Convierte lo aprendido del piloto en una plataforma interna delgada: plantillas estándar, un camino de despliegue pavimentado, observabilidad básica y un modelo de propiedad claro.

- Expandir: Incorporar más equipos y servicios usando los mismos valores por defecto. Prioriza la consistencia sobre la personalización.

- Optimizar: Añadir políticas, controles de coste, flujos de incidentes y funciones de autoservicio una vez que lo básico sea estable.

Si experimentas con nuevos flujos, un patrón útil es prototipar la experiencia “camino dorado” de extremo a extremo antes de estandarizarla. Por ejemplo, los equipos pueden usar Koder.ai para generar rápidamente una app web (React), un backend (Go) y una base de datos (PostgreSQL) vía chat, y luego tratar ese código como punto de partida para las plantillas y convenciones CI/CD de la plataforma.

Preguntas de decisión para mantener la honestidad

Antes de añadir una herramienta, pregúntate:

- ¿Por qué contenedores? ¿Qué fricción eliminas (deriva de entornos, empaquetado, portabilidad) y qué trabajo nuevo aceptas?

- ¿Por qué orquestación? ¿Necesitas realmente escalado automatizado, rollouts y resiliencia de servicio, o cubriría la necesidad una automatización más simple?

- ¿Por qué ahora? ¿Esto responde a un dolor de entrega, a riesgo de fiabilidad o a una meta de producto clara (no solo presión de tendencia)?

Métricas que muestran progreso real

Mide resultados, no uso de herramientas:

- Frecuencia de despliegue y lead time (velocidad de entrega)

- Fiabilidad (cumplimiento de SLOs, tasa de incidentes, MTTR)

- Satisfacción del desarrollador (encuestas cortas, tiempo de incorporación, “tiempo hasta primer despliegue”)

Si quieres ejemplos de cómo se ven buenos paquetes de “MVP de plataforma”, consulta /blog. Para presupuestos y planificación de despliegue, también puedes revisar /pricing.

El siguiente capítulo de cloud-native (y cómo prepararse)

La gran lección de la última década es simple: los contenedores no “ganaron” porque fueran un empaquetado ingenioso. Ganaron porque el pensamiento de plataforma los hizo dependables: despliegues repetibles, rollouts seguros, controles de seguridad consistentes y operaciones predecibles.

El siguiente capítulo no trata de una herramienta revolucionaria única. Trata de hacer que lo cloud-native sea aburrido en el mejor sentido: menos sorpresas, menos arreglos puntuales y un camino más suave del código a producción.

Qué vigilar próximamente

Policy-as-code se convierte en la norma. En lugar de revisar cada despliegue manualmente, los equipos codifican reglas de seguridad, red y cumplimiento para que los guardarraíles sean automáticos y auditables.

La experiencia del desarrollador (DX) se trata como un producto. Espera más enfoque en caminos pavimentados: plantillas, entornos de autoservicio y caminos dorados que reduzcan la carga cognitiva sin limitar la autonomía.

Operaciones más simples, no más dashboards. Las mejores plataformas ocultarán la complejidad: valores por defecto opinados, menos piezas móviles y patrones de fiabilidad incorporados en lugar de añadidos.

Evita la trampa de “coleccionar herramientas”

El progreso cloud-native se ralentiza cuando los equipos persiguen funcionalidades en lugar de resultados. Si no puedes explicar cómo una nueva herramienta reduce el lead time, baja la tasa de incidentes o mejora la postura de seguridad, probablemente no sea prioritaria.

Un siguiente paso claro

Evalúa los puntos de dolor actuales en tu entrega y asócialos a necesidades de la plataforma:

- ¿Dónde fallan o se ralentizan más los despliegues?

- ¿Qué aprobaciones y comprobaciones deberían convertirse en guardarraíles automáticos?

- ¿Qué reconstruyen los desarrolladores repetidamente (y podría estandarizarse)?

Trata las respuestas como el backlog de tu plataforma y mide el éxito por los resultados que los equipos perciben cada semana.