Define el trabajo del asistente y el alcance del MVP

Una “aplicación de asistente personal” puede ser desde una lista de tareas glorificada hasta una herramienta que negocia conflictos de calendario y escribe correos. Si no defines el trabajo con precisión, acabarás construyendo una demo de chat que impresiona pero no ayuda el lunes por la mañana.

Empieza por nombrar tu audiencia y su dolor recurrente. Un fundador puede necesitar preparación rápida para reuniones y seguimientos; un estudiante puede querer planes de estudio y captura de notas; un gerente de operaciones puede buscar triage de tareas y resúmenes diarios. Cuanto más clara la audiencia, más fácil decidir qué herramientas necesita el asistente —y cuáles definitivamente no.

Elige 1–2 recorridos que prueben valor

Tu MVP debería entregar un resultado útil en una sola sesión breve. Una regla práctica es que el usuario obtenga valor en 60–120 segundos de abrir la app.

Dos recorridos iniciales confiables son:

- Capturar → organizar: Añadir una tarea/nota con contexto, confirmar que se guardó correctamente y verla en una lista simple.

- Resumir → decidir: Generar un plan/resumen diario a partir de elementos guardados y permitir al usuario aceptar, editar o reprogramar.

Fíjate en lo que falta: onboarding largo, ajustes complicados o integraciones profundas. Aun así puedes simular una experiencia de “asistente” haciendo que la interacción se sienta conversacional mientras mantienes acciones deterministas por debajo.

Define non-goals (y escríbelos)

Muchas apps de asistente fracasan por querer hacerlo todo el primer día: voz, sincronización completa de correo, acceso de escritura al calendario, ejecución autónoma multi-paso y configuraciones de agentes complejas. Haz non-goals explícitos para el MVP—sin entrada de voz, sin integración de correo bidireccional, sin ejecución autónoma en segundo plano y sin sincronización entre dispositivos más allá de cuentas básicas. Esto mantiene el producto honesto y reduce el riesgo de seguridad y privacidad temprano.

Elige métricas de éxito que encajen con el trabajo

No midas el MVP por “número de chats.” Mídelo por resultados:

- Tiempo hasta el primer resultado útil: qué tan rápido los usuarios obtienen una tarea guardada o un resumen usable.

- Calidad: cuán a menudo las tareas/fechas extraídas son correctas y con qué frecuencia los usuarios editan.

- Retención: si los usuarios regresan al día siguiente para capturar o revisar.

Si haces vibe-coding en una plataforma como Koder.ai, recorridos y métricas claras también hacen real la velocidad de construcción: puedes dimensionar las primeras pantallas React/Flutter y los endpoints Go/PostgreSQL alrededor de dos bucles centrales, luego iterar usando snapshots y rollback cuando los cambios no mejoren los resultados.

Diseño de Producto: Flujos UX que se sienten como un asistente

Una app de asistente personal gana o pierde por la sensación de la interacción. Los usuarios deben percibir que la app entiende la intención, ofrece el siguiente paso útil y se mantiene fuera del camino cuando solo quieren una respuesta rápida.

Empieza por las acciones cotidianas del asistente

La mayoría de los asistentes ganan confianza haciendo bien unos pocos trabajos: entender solicitudes, almacenar “memoria” (preferencias y hechos de perfil ligeros), gestionar tareas y recordatorios, y generar resúmenes rápidos (notas, reuniones o mensajes largos). El diseño de producto hace estas capacidades obvias sin convertir la app en un laberinto.

Una regla útil: cada capacidad del asistente debe tener (1) un camino conversacional (por ejemplo, “recuérdame mañana a las 9”) y (2) una superficie UI visible para revisión y edición (una lista de recordatorios que puedas escanear).

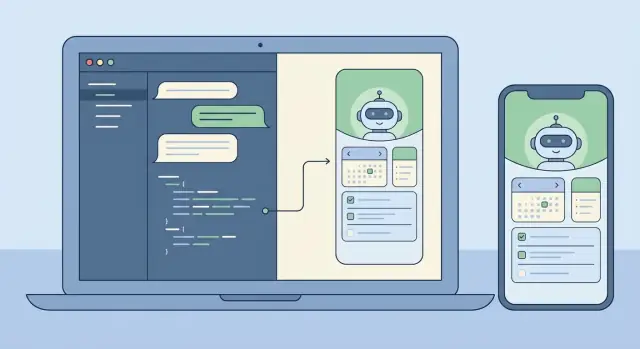

Elige un estilo de interacción: chat-first vs UI-first

Chat-first funciona mejor cuando tu audiencia valora rapidez y flexibilidad: un compositor, historial de mensajes y algunos atajos inteligentes.

UI-first con chat como ayudante funciona mejor cuando los usuarios gestionan muchos ítems y necesitan estructura. En ese modelo, la app se abre en una vista “Tareas” o “Hoy”, y el chat es una herramienta contextual para cambios (por ejemplo, “mueve todo lo que vence hoy a mañana”).

No tienes que elegir para siempre, pero sí deberías decidir una pantalla de inicio y un modelo mental por defecto pronto.

Diseña seguridad en el flujo (confirmar + deshacer)

Los asistentes a menudo realizan acciones que parecen irreversibles: borrar una nota, enviar un mensaje, cancelar algo o editar muchas tareas a la vez. Trata estas acciones como riesgosas. La UX debe usar un paso de confirmación claro con un resumen en lenguaje llano de lo que ocurrirá, más un deshacer inmediato tras la ejecución.

Un patrón fuerte es: previsualizar → confirmar → ejecutar → deshacer. La previsualización es donde los usuarios detectan errores (“¿Enviar a Alex?” “¿Borrar 12 tareas?”).

Esboza el mínimo conjunto de pantallas

Mantén la primera versión pequeña y coherente. Un mínimo práctico es: onboarding (qué puede hacer + permisos), chat, tareas/recordatorios, memoria (qué sabe, con editar/borrar), ajustes (notificaciones, tono, privacidad) y una vista ligera de historial/auditoría.

Si haces vibe-coding (por ejemplo, en Koder.ai), estas pantallas se mapean limpiamente a un MVP que puedes generar rápido y luego refinar probando flujos reales como “capturar una tarea”, “poner un recordatorio” y “deshacer un error”.

Diseño de prompts y comportamiento (sin sobre-ingeniería)

Un buen asistente se siente consistente, predecible y seguro—más como un compañero útil que como un generador aleatorio de texto. Puedes llegar más rápido manteniendo los prompts simples, por capas y comprobables.

Usa una jerarquía clara de mensajes

Trata tus prompts como tres capas, cada una con un propósito distinto:

- Instrucciones del sistema: definen identidad e innegociables (tono, seguridad, postura de privacidad, cómo manejar incertidumbre).

- Reglas de desarrollador: definen comportamiento del producto (características soportadas, reglas de uso de herramientas, contratos de formato de salida, qué registrar).

- Mensajes del usuario: son las solicitudes cambiantes.

Esta separación evita que una petición del usuario (“ignora instrucciones previas”) sobrescriba accidentalmente cómo debe comportarse el asistente.

Define límites de las herramientas (y permisos)

Tu asistente será más confiable si sabe exactamente cuándo puede actuar y cuándo debe preguntar. Decide qué operaciones son solo lectura (seguras para hacer automáticamente, como buscar notas), cuáles son escritura (crear/actualizar tareas, programar recordatorios) y cuáles son irreversibles o costosas (borrar datos, contactar servicios externos, compartir información).

Para acciones de escritura e irreversibles, exige confirmación: el modelo propone un plan de acción y espera aprobación explícita.

Prefiere salidas estructuradas para acciones

Cuando el modelo necesita crear una tarea o recordatorio, el texto plano es frágil. Usa objetos de acción JSON y valídalos antes de ejecutar. Requiere campos como action, title, due_at, priority y timezone, y rechaza o solicita aclaraciones cuando falte algo. Esto mantiene tu backend determinista aun cuando la redacción del modelo varíe.

Añade guardrails ligeros

Los guardrails no tienen que ser complicados. Añade una política corta para solicitudes sensibles (autolesión, actividad ilegal, acceso a datos privados) y define patrones de rechazo que sigan siendo útiles: reconocer, rechazar y ofrecer alternativas seguras. También indica al modelo que diga “No sé” cuando le falte información y que haga una sola pregunta aclaratoria en vez de adivinar.

Construye una pequeña librería de prompts

En lugar de un mega-prompt, mantén un pequeño conjunto de comportamientos reutilizables que el asistente puede “llamar” internamente: resumir una conversación en siguientes acciones, redactar un plan con supuestos y preguntas abiertas, chequear una solicitud por detalles faltantes, reescribir un mensaje en un tono específico y extraer tareas/eventos en JSON. Este es el punto óptimo: comportamiento consistente, pruebas sencillas y nada de spaghetti de prompts.

LLM + Herramientas + Agentes: Una arquitectura práctica

Un asistente se siente “inteligente” cuando sabe hacer dos cosas bien: conversar naturalmente y ejecutar acciones fiables. El camino más rápido es separar conversación (razonamiento LLM) de ejecución (herramientas que llaman a tus sistemas reales).

Dos patrones funcionales

Para un MVP, comienza con un patrón un LLM + herramientas: un modelo recibe el mensaje del usuario, decide si responder en texto o invocar una herramienta y luego devuelve un resultado. Esto es más sencillo de depurar y suele ser suficiente para captura de tareas, búsqueda de notas y recordatorios.

A medida que crezcan las capacidades, un patrón de coordinador + agentes especialistas resulta útil. Un coordinador interpreta la solicitud y delega a especialistas (por ejemplo, un agente de Tareas vs un agente de Notas), cada uno con instrucciones más estrechas y menos herramientas. Esto reduce el uso accidental de herramientas y mejora la consistencia al añadir integraciones.

Herramientas: las manos del asistente

Las herramientas son APIs pequeñas y deterministas que el asistente puede invocar. Mantén las entradas estrictas y las salidas estructuradas para poder validarlas y registrar lo ocurrido.

Herramientas comunes: crear/actualizar/completar tareas, búsqueda de notas (palabra clave + filtros temporales), programación de recordatorios (hora, canal, recurrencia), consulta de preferencias (zona horaria, horario laboral), lectura de agenda opcional (si tienes integración de calendario) y registros de auditoría.

Modo planificación antes de ejecutar

Antes de ejecutar, añade un paso explícito de planificación: el modelo escribe un plan corto y luego selecciona las herramientas para realizarlo. La planificación ayuda en solicitudes multi-paso como “Mueve las tareas del proyecto a la próxima semana y recuérdame el lunes”, donde el asistente debe confirmar supuestos (zona horaria, qué cuenta como “tareas del proyecto”) antes de actuar.

Aprobación de acciones para evitar sorpresas

Cualquier herramienta que cause efectos secundarios (crear tareas, enviar recordatorios, cambiar datos) debe pasar por una puerta de aprobación. En la práctica, el modelo propone un borrador de acción (nombre de herramienta + parámetros + resultado esperado) y tu app pide al usuario confirmar o editar. Este único punto de control reduce drásticamente cambios no intencionados y hace que el asistente sea confiable.

Si usas una plataforma de vibe-coding como Koder.ai, puedes implementar esta arquitectura rápidamente generando interfaces de herramientas, lógica de coordinador y UI de aprobación como componentes separados y comprobables—luego iterar con snapshots y rollback mientras afinas el comportamiento.

Memoria y contexto: qué guardar y qué recuperar

Un asistente parece “inteligente” cuando recuerda lo correcto y olvida lo demás. La clave es separar lo que el modelo necesita para coherencia de lo que guardas para el usuario. Si guardas todo, incrementas riesgo de privacidad y ruido en la recuperación. Si no guardas nada, el asistente se vuelve repetitivo y frágil.

Memoria a corto plazo vs largo plazo

Trata la conversación reciente como memoria de corto plazo: una ventana rodante de los últimos turnos más el objetivo actual. Manténla ajustada—resume agresivamente—para no pagar tokens innecesarios ni amplificar errores previos.

La memoria de largo plazo es para hechos que deben sobrevivir sesiones: preferencias, datos de perfil estables, tareas y notas que el usuario espera revisar. Almacena esto primero como datos estructurados (tablas, campos, timestamps) y usa fragmentos de texto libre solo cuando no puedas representar algo limpiamente.

Qué merece guardarse

Un punto de partida práctico es guardar información que sea autoría del usuario o aprobada por él: perfil y preferencias (zona horaria, horario laboral, tono, recordatorios por defecto), tareas y proyectos (estado, fechas de vencimiento, recurrencia, prioridad), notas y destacados (decisiones, compromisos, contexto clave) y resultados de herramientas junto con una traza de auditoría.

Los highlights de la conversación importan más que transcripciones completas. En lugar de almacenar todo lo dicho, guarda hechos duraderos como: “Usuario prefiere resúmenes concisos”, “Vuelo a NYC el viernes”, “Límite de presupuesto $2,000”.

Recuperación que se siente instantánea (y predecible)

Planea la recuperación según cómo buscan las personas: palabras clave, rangos temporales, etiquetas y “cambios recientes”. Usa filtros deterministas primero (fechas, estado, etiquetas) y luego añade búsqueda semántica en cuerpos de notas cuando la consulta sea difusa.

Para evitar alucinaciones, el asistente debe confiar solo en lo que realmente recuperó (IDs de registro, timestamps) y hacer una pregunta aclaratoria cuando no encuentre nada relevante.

Controles de usuario y confianza

Haz la memoria transparente. Los usuarios deben poder ver qué está guardado, editarlo, exportarlo y eliminarlo—especialmente los hechos de largo plazo. Si construyes con un flujo de vibe-coding como Koder.ai, hacer “Ajustes de Memoria” una pantalla de primera clase temprano modela tanto la UX como tu esquema de datos desde el inicio.

Frontend: Web (React) y Móvil (Flutter)

Despliega en la región adecuada

Despliega tu app y elige una región de hosting que cumpla requisitos de residencia de datos.

Un asistente vive o muere por la interfaz. Elige el stack según dónde la gente lo vaya a usar: web suele ser el camino más rápido hacia utilidad diaria, mientras que móvil gana cuando las notificaciones, la entrada por voz y la captura en movimiento importan.

Un enfoque práctico es empezar con React para la UI web (iteración rápida, despliegue sencillo) y luego reflejar el mismo modelo de interacción en Flutter cuando el bucle central del asistente funcione.

Una UI de chat que se comporte como producto (no como demo)

Trata el chat como una conversación estructurada, no solo burbujas de texto. Gestiona múltiples formas de mensaje para que los usuarios entiendan qué ocurre y qué se espera: mensajes de usuario, respuestas del asistente (incluyendo texto en streaming), acciones de herramientas (“Creando tarea…”), confirmaciones (aprobar/denegar), errores (con opciones de reintento) y avisos del sistema (offline, límites de tasa, capacidad degradada).

En React, las respuestas en streaming hacen que el asistente se sienta responsivo, pero mantén el render eficiente: añade deltas, evita re-renderizar todo el historial y preserva el comportamiento de scroll cuando el usuario lee mensajes antiguos.

Estados de “pensando” sin filtrar internos

Los usuarios necesitan feedback, no tus prompts internos o detalles del chain-of-tools. Usa indicadores neutrales como “Trabajando en ello” o “Revisando tus notas” y muestra solo hitos seguros para el usuario (iniciado, esperando confirmación, hecho). Esto es aún más importante al añadir flujos multi-agente.

Ajustes que hacen el comportamiento controlable

Añade una pantalla de ajustes pronto, aunque sea simple. Permite controlar tono (profesional vs casual), verbosidad (breve vs detallado) y opciones de privacidad (si almacenar historial de chat, duración de retención, si la memoria está habilitada). Estos controles reducen sorpresas y ayudan con requerimientos de cumplimiento.

Si haces vibe-coding con Koder.ai, puedes generar tanto la UI web en React como las pantallas Flutter desde la misma intención de producto y luego iterar rápidamente en componentes de conversación, streaming y ajustes sin atascarte en el plumbing de UI.

Fundamentos del backend: APIs, Auth y ejecución determinista

Un asistente parece mágico en la UI, pero se vuelve confiable en el backend. La meta es hacer el comportamiento guiado por chat predecible: el modelo puede sugerir acciones, pero tu servidor decide qué ocurre realmente.

APIs que mapeen a intención de usuario

Traduce comportamientos del asistente a un conjunto pequeño de endpoints estables. Mantén el chat como punto de entrada y luego expone recursos explícitos para todo lo que el asistente puede gestionar. Por ejemplo, el asistente puede redactar una tarea, pero la llamada final create-task debe ser una petición API normal con un esquema estricto.

Una superficie compacta que escala bien incluye chat (enviar/recibir más solicitudes de herramientas opcionales), ejecución de herramientas (ejecutar herramientas aprobadas y devolver resultados estructurados), CRUD de tareas (con validación en servidor), preferencias y endpoints de jobs/status para trabajos de larga duración.

Auth y sesiones: decide pronto

La autenticación es más fácil agregarla temprano y dolorosa de reinterpretarla después. Define cómo se representa una sesión de usuario (tokens o sesiones servidor) y cómo se acotan las peticiones (user ID, org ID para equipos). Decide qué puede hacer el asistente “silenciosamente” y qué requiere re-autenticación o confirmación.

Si planeas niveles (free/pro/business/enterprise), aplica derechos en la capa API desde el día uno (límites de tasa, disponibilidad de herramientas, permisos de exportación), no dentro de prompts.

Trabajos de larga duración: cola, no bloqueo

Resúmenes de contenido grande, importaciones o flujos multi-paso de agentes deben correr de forma asíncrona. Devuelve rápido con un job ID y proporciona actualizaciones de progreso (queued → running → partial results → completed/failed). Esto mantiene el chat responsivo y evita timeouts.

Ejecución determinista: los modelos proponen, los servidores deciden

Trata las salidas del modelo como input no confiable. Valida y sanea todo: esquemas JSON estrictos para llamadas a herramientas, rechazo por campos desconocidos, enforcement de tipos/rangos, normalización server-side de fecha/zona horaria y registro de solicitudes/resultados de herramientas para auditabilidad.

Plataformas como Koder.ai pueden acelerar el scaffolding (APIs en Go, backing en PostgreSQL, snapshots/rollback), pero el principio es el mismo: el asistente puede ser creativo en la conversación mientras el backend se mantiene aburrido, estricto y fiable.

Modelo de datos en PostgreSQL: Tareas, Notas y Auditabilidad

Construye en el plan gratuito

Prototipa tu app de asistente personal en el plan gratuito y actualiza cuando lo necesites.

Un asistente parece “inteligente” cuando recuerda de forma fiable, explica lo que hizo y permite deshacer errores. Tu esquema PostgreSQL debe soportar eso desde el inicio: entidades núcleo claras, procedencia explícita (de dónde vino cada ítem) y timestamps amigables con auditoría.

Entidades núcleo a modelar (y por qué)

Comienza con un conjunto pequeño de tablas que coincidan con expectativas del usuario: users, conversations/messages, tasks/reminders, notes y (opcional) embeddings si haces retrieval a escala. Mantén tasks/notes separadas de messages: los mensajes son la transcripción; tareas/notas son los resultados estructurados.

Procedencia: “¿Qué mensaje creó esto?”

Trata la procedencia como una característica de primera clase. Cuando el LLM convierte una solicitud en una tarea, guarda un source_message_id en tasks/notes, registra quién lo creó (user, assistant o system) y adjunta un tool_run_id si usas herramientas/agentes. Esto hace el comportamiento explicable (“Creado desde tu mensaje el martes a las 10:14”) y agiliza la depuración.

Campos para auditoría y eliminación suave

Usa columnas consistentes: created_at, updated_at y a menudo deleted_at para borrados suaves. El borrado suave es especialmente útil porque los usuarios frecuentemente quieren deshacer y puede que necesites preservar registros para cumplimiento o troubleshooting.

Considera identificadores inmutables (uuid) y una tabla de audit log append-only para eventos clave (tarea creada, fecha de vencimiento cambiada, recordatorio disparado). Es más simple que reconstruir historial desde filas actualizadas.

Migraciones y evolución de esquema

El comportamiento del asistente cambia rápido. Planea migraciones: versiona tu esquema, evita cambios destructivos y prefiere pasos aditivos (nuevas columnas, tablas). Si haces vibe-coding con Koder.ai, empareja snapshots/rollback con disciplina de migraciones para iterar sin perder integridad de datos.

CREATE TABLE tasks (

id uuid PRIMARY KEY,

user_id uuid NOT NULL,

title text NOT NULL,

status text NOT NULL,

due_at timestamptz,

source_message_id uuid,

created_by text NOT NULL,

created_at timestamptz NOT NULL DEFAULT now(),

updated_at timestamptz NOT NULL DEFAULT now(),

deleted_at timestamptz

);

Pruebas y evaluación: hazlo fiable

La fiabilidad es la diferencia entre una demo interesante y un asistente en el que la gente confía con trabajo real. Lo difícil es que las solicitudes de asistentes rara vez son ordenadas: los usuarios son breves, emocionales, inconsistentes y a menudo omiten detalles clave. Tu estrategia de pruebas debe reflejar esa realidad.

Construye un set de pruebas que parezca vida real

Recolecta (o escribe) un conjunto pequeño pero representativo de solicitudes: mensajes cortos, instrucciones vagas, errores tipográficos, restricciones en conflicto y cambios de última hora. Incluye caminos felices (creación clara de tarea, captura de nota) y caminos límite (fechas faltantes, pronombres ambiguos, varias personas con el mismo nombre, solicitudes que implican permisos).

Mantén estos ejemplos como tu conjunto dorado. ejecútalo cada vez que cambies prompts, herramientas o lógica de agentes.

Define qué significa “bueno” (más allá de respuestas correctas)

Para apps de asistente, la corrección no es solo el texto final. Evalúa si tomó la acción correcta, pidió confirmación cuando hizo falta y evitó inventar resultados de herramientas.

Una rúbrica práctica comprueba: corrección de tareas, comportamiento de confirmación (especialmente antes de borrados/envíos/gastos), alucinaciones de acciones (afirmar ejecución sin llamada a herramienta), disciplina en el uso de herramientas (usar herramientas cuando es necesario; evitar llamadas innecesarias) y recuperación (manejo claro de fallos y reintentos).

Chequeos de regresión para prompts y herramientas

Cada ajuste de prompt puede cambiar el comportamiento de maneras inesperadas. Trata los prompts como código: versionálos, ejecuta el conjunto dorado y compara resultados. Si usas múltiples agentes (planner/executor), prueba cada etapa—muchos fallos empiezan como un error de planificación que se propaga.

Al añadir una herramienta nueva o cambiar un esquema, añade casos de regresión dirigidos (por ejemplo, “crear una tarea para el próximo viernes” debe resolver fechas consistentemente). Si tu flujo soporta snapshots/rollback, úsalos para revertir rápido cuando la evaluación empeore.

Instrumentación sin filtrar secretos

Registra llamadas a herramientas, argumentos redactados, tiempos y razones de fallo para poder responder: “¿Qué intentó hacer el modelo?” y “¿Por qué falló?” Redacta tokens, datos personales y contenido de mensajes por defecto, y guarda solo lo necesario para depurar—a menudo un ID de usuario hasheado, nombre de herramienta, intención de alto nivel y clase de error bastan.

Bien hecho, las pruebas convierten la iteración en un bucle controlado: puedes moverte más rápido sin romper la confianza.

Seguridad, privacidad y cumplimiento

Una app de asistente pronto se convierte en contenedor de material sensible: calendarios, ubicaciones, mensajes, documentos y notas que los usuarios nunca quisieron compartir. Trata la privacidad como una característica de producto, no como una casilla. Minimiza lo que coleccionas y lo que envías al LLM. Si una función no requiere el historial completo de mensajes, no lo almacenes; si una solicitud puede responderse con un resumen corto, envía solo el resumen.

Minimización de datos, retención y controles de usuario

Define la retención desde el inicio: qué guardas (tareas, notas, preferencias), por qué lo guardas y cuánto tiempo permanece. Haz la eliminación real y verificable: los usuarios deben poder borrar una nota, un workspace entero y cualquier archivo subido. Considera un “modo olvidadizo” para conversaciones sensibles donde no persistas contenido—solo metadata mínima para facturación y prevención de abuso.

Secretos, tokens y encriptación

Nunca envíes claves de API al cliente. Mantén claves de proveedor y credenciales de herramientas en el servidor, rótalas y acótalas por ambiente. Encripta datos en tránsito (TLS) y en reposo (base de datos y backups). Para tokens de sesión, usa vidas cortas y flows de refresh; guarda hashes cuando sea posible y evita loguear prompts o salidas de herramientas en crudo por defecto.

Hosting geográfico y cumplimiento

Algunos usuarios requerirán residencia de datos (países/regiones específicos), especialmente para asistentes empresariales. Planea despliegues conscientes de región temprano: mantiene datos de usuario en una base alineada por región y evita pipelines cross-region que copien contenido sin avisar. Koder.ai corre en AWS globalmente y puede hospedar aplicaciones en países específicos, lo que facilita requisitos de residencia y transferencias transfronterizas cuando las necesites.

Protección contra abuso y defensas contra prompt-injection

Los asistentes atraen abuso: scraping, credential stuffing y ataques para “hacer al modelo revelar secretos”. Un baseline práctico incluye límites de tasa y cuotas, detección de actividad sospechosa, permisos estrictos para herramientas (allow-list + validación server-side), higiene contra prompt-injection (trata texto externo como no confiable; aísla de reglas del sistema) y logs de auditoría para ejecución de herramientas y acceso a datos.

La meta es comportamiento predecible: el modelo puede sugerir acciones, pero tu backend decide qué está permitido.

Despliegue, monitorización e iteración segura

Diseña controles de memoria

Crea una pantalla de memoria que los usuarios puedan ver, editar, exportar y eliminar.

Lanzar una app de asistente no es un momento único. Es un ciclo: liberar pequeño, observar uso real, ajustar comportamiento y repetir—sin romper la confianza. Porque los asistentes pueden cambiar con un ajuste de prompt o una nueva integración, necesitas disciplina de despliegue que trate configuración y prompts como código de producción.

Entrega incremental con feature flags

Asume que cada nueva capacidad puede fallar de formas sorprendentes: bugs de zona horaria, memoria guardando datos erróneos o un modelo que se pone demasiado creativo. Los feature flags permiten exponer herramientas nuevas y comportamientos de memoria a una fracción de usuarios (o cuentas internas) antes del lanzamiento general.

Una estrategia simple: poner cada integración de herramienta detrás de una bandera, separar escrituras de memoria de lecturas, habilitar salida en modo planificación solo para testers, añadir un “modo seguro” que deshabilite llamadas a herramientas (solo lectura) y usar rollouts por porcentaje para cambios riesgosos.

Rollback no es opcional: snapshot de prompts y config

El rollback tradicional revierte binarios; las apps de asistente también deben revertir comportamiento. Trata prompts del sistema, esquemas de herramientas, reglas de ruteo, políticas de seguridad y filtros de memoria como artefactos versionados. Mantén snapshots para restaurar rápidamente el último comportamiento conocido bueno.

Esto es especialmente valioso cuando iteras rápido con vibe coding: Koder.ai soporta snapshots y rollback, lo que encaja con asistentes donde pequeños edits de texto pueden tener gran impacto.

Estrategia de despliegue y dominios personalizados

Si ofreces un asistente white-label (para equipos o clientes), planea dominios personalizados temprano. Afecta callbacks de auth, settings de cookies/sesiones, límites por tenant y cómo separas logs y datos. Incluso para un producto de marca única, define ambientes (dev/staging/prod) para probar permisos de herramientas y settings de modelo de forma segura.

Monitoriza lo que importa: fiabilidad, velocidad y coste

La monitorización de asistentes es parte analítica de producto y parte operaciones. Rastrea latencia y errores, pero también señales de comportamiento como coste por conversación, frecuencia de llamadas a herramientas y tasa de fallo de herramientas. Combina métricas con auditorías muestreadas de conversaciones para ver si los cambios mejoraron resultados—no solo throughput.

Construir más rápido con Vibe Coding (Ejemplo: flujo Koder.ai)

Vibe coding es más valioso cuando necesitas un prototipo real—no una presentación. Para un asistente personal, eso suele significar una UI de chat, unas pocas acciones centrales (capturar tarea, guardar nota, programar recordatorio) y un backend que se mantenga determinista aun cuando el LLM sea creativo. Una plataforma de vibe-coding comprime la línea de tiempo del primer-que-funciona convirtiendo tu descripción de producto en pantallas, rutas y servicios operativos.

Un flujo práctico al estilo Koder.ai

Empieza describiendo el asistente en lenguaje natural en chat: para quién es, qué puede hacer y qué significa “hecho” para el MVP. Itera en pasos pequeños.

Genera primero una interfaz web React (vista de conversación, compositor de mensajes, panel ligero de “herramientas usadas” y una página de ajustes simple), luego añade una versión móvil Flutter cuando los flujos se sientan correctos.

Después, genera un backend en Go con PostgreSQL: autenticación, una API mínima para conversaciones y endpoints de herramientas (create task, list tasks, update task). Mantén el comportamiento LLM como una capa fina: instrucciones del sistema, esquema de herramientas y guardrails. A partir de ahí, itera prompts y UI juntos: cuando el asistente haga una suposición errónea, ajusta el texto de comportamiento y añade un paso de confirmación en la UX.

Funciones que importan cuando iteras rápido

Prioriza aceleradores de flujo que mantengan la experimentación segura: modo planificación (proponer antes de aplicar), snapshots y rollback (recuperación rápida de malas iteraciones), despliegue y hosting con dominios personalizados (acceso rápido de stakeholders) y exportación de código fuente (para mantener propiedad completa y migrar a un pipeline más permanente después).

Checklist de siguientes pasos

Antes de escalar más allá del MVP, asegura:

- Una especificación MVP de una página (3–5 trabajos de usuario, non-goals, criterios de éxito)

- Tu lista de herramientas (qué puede hacer el asistente vía APIs)

- Un pequeño set de evaluación (20–50 escenarios + resultados esperados)

- Un plan de despliegue (ambientes, secretos, estrategia de rollback, monitorización)

Con esa estructura, Koder.ai (koder.ai) puede ser una forma práctica de pasar del concepto a un asistente funcional en React/Go/PostgreSQL (y luego Flutter) rápidamente, manteniendo el comportamiento comprobable y reversible.