Aclare el objetivo y la audiencia

Una matriz de comparación solo es tan útil como la decisión que ayuda a tomar alguien. Antes de diseñar tablas, filtros o puntuaciones, sea específico sobre quién usará el sitio y qué intenta decidir. Esto evita un fallo común: construir una cuadrícula bonita que responde preguntas que nadie está haciendo.

Identifique a los usuarios principales (y sus restricciones)

Diferentes audiencias interpretan la misma “comparación de características” de modos muy distintos:

- Compradores / líderes de producto quieren claridad, una lista corta rápido y una justificación defendible.

- Ingenieros quieren detalles de implementación: APIs, SDKs, esfuerzo de integración, límites, rendimiento y advertencias.

- Compras / seguridad se preocupan por el riesgo: cumplimiento, certificaciones, residencia de datos, contratos y estabilidad del proveedor.

Elija una audiencia primaria para la primera versión. Aún puede dar soporte a usuarios secundarios, pero las vistas por defecto, la terminología y las prioridades del sitio deben reflejar al grupo principal.

Enumere las decisiones que su sitio debe soportar

Anote las decisiones concretas que la matriz debe permitir. Ejemplos incluyen:

- Elegir una herramienta para un proyecto nuevo

- Construir una lista corta de proveedores para una RFP

- Reemplazar un sistema existente con riesgo mínimo de migración

- Validar si una solución cumple requisitos no negociables

Estas decisiones informan qué criterios se convierten en filtros de primer nivel, cuáles quedan como “detalles” y cuáles pueden omitirse.

Defina métricas de éxito que coincidan con esas decisiones

Evite objetivos vagos como “incrementar el engagement”. Elija métricas que reflejen el progreso de la decisión:

- Tiempo hasta la lista corta (p. ej., desde la llegada hasta una comparación guardada)

- Acciones de conversión (solicitudes de demo, registros, descargas)

- Tasa de finalización para flujos clave (filtrar → comparar → exportar)

- Señales de calidad (menos preguntas de soporte, puntuaciones de confianza más altas)

Decida qué significa “técnico” para su audiencia

“La evaluación técnica” puede incluir muchas dimensiones. Alinee qué importa más para sus usuarios, como:

- APIs e integraciones (cobertura, límites de tasa, webhooks, conectores)

- Seguridad y cumplimiento (SSO, logs de auditoría, SOC 2, cifrado)

- Precios y empaquetado (niveles, costos por uso, cargos ocultos)

- Operaciones (modelo de despliegue, monitorización, SLAs, soporte)

Documente estas prioridades en lenguaje claro. Esto será su estrella del norte para decisiones posteriores: modelo de datos, reglas de puntuación, UX y SEO.

Diseñe el modelo de datos para las comparaciones

Su modelo de datos determina si la matriz se mantiene consistente, buscable y fácil de actualizar. Antes de diseñar pantallas, decida qué “cosas” va a comparar, qué va a medir y cómo almacenará la evidencia.

Comience con las entidades centrales

La mayoría de sitios de comparación técnica necesitan un pequeño conjunto de bloques de construcción:

- Vendedores/Productos: los ítems comparados (a menudo ambos: un proveedor puede ofrecer varios productos).

- Categorías: agrupaciones como “Seguridad”, “Integraciones” o “Precios”.

- Criterios: filas individuales en la matriz (p. ej., “SAML SSO”, “Formatos de exportación”, “SLA de disponibilidad”).

- Evidencia: lo que respalda un valor (cita de docs, referencia de captura de pantalla, nota de contrato, resultado de prueba).

- Fuentes: de dónde viene la evidencia (documentación pública, correo de ventas, entrevista con cliente, prueba interna).

Modele los criterios como objetos reutilizables y almacene el valor de cada vendedor/producto como un registro separado (a menudo llamado “evaluación” o “resultado de criterio”). Esto le permite añadir nuevos proveedores sin duplicar la lista de criterios.

Elija el tipo de dato adecuado por criterio

Evite forzar todo a texto plano. Elija un tipo que coincida con cómo la gente filtrará y comparará:

- Booleano (Sí/No) para disponibilidad

- Numérico para límites y rendimiento (y almacene unidades)

- Texto para matices (manténgalo corto; agregue notas largas en otro lugar)

- Multi-select para listas como plataformas soportadas o estándares de cumplimiento

También decida cómo representar “Desconocido”, “No aplicable” y “Planeado”, para que los vacíos no se lean como “No”.

Planifique para el cambio: versiones y timestamps

Los criterios evolucionan. Guarde:

- Fechas efectivas (cuándo se verificó un valor)

- Última revisión por criterio resultado

- Opcional versiones de criterios para que renombrar o dividir criterios no rompa el historial

Separe hechos públicos de notas internas

Cree campos (o incluso una tabla separada) para comentarios internos, detalles de negociación y confianza del revisor. Las páginas públicas deben mostrar el valor y la evidencia; las vistas internas pueden incluir contexto franco y tareas de seguimiento.

Planifique la estructura del sitio y las URLs

Un sitio de matriz de comparación tiene éxito cuando los visitantes pueden predecir dónde está cada cosa y cómo llegar. Decida una arquitectura de información que refleje cómo la gente evalúa opciones.

Cree un árbol de categorías consistente

Comience con una taxonomía simple y estable que no cambie cada trimestre. Piense en “áreas de problema” en lugar de nombres de proveedores.

Ejemplos:

- Monitorización

- CI/CD

- IAM

- Almacenamiento de datos

- API Gateways

Mantenga el árbol superficial (normalmente 2 niveles son suficientes). Si necesita más matiz, use etiquetas o filtros (p. ej., “Open-source”, “SOC 2”, “Autoalojado”) en lugar de anidamiento profundo. Esto ayuda a los usuarios a navegar con confianza y evita contenido duplicado más adelante.

Planifique sus tipos de página centrales

Diseñe su sitio alrededor de unas pocas plantillas repetibles:

- Hub de categoría: explica la categoría, lista productos, destaca criterios comunes y ofrece puntos de entrada para “comparar”.

- Página de producto: perfil de un vendor/herramienta con capacidades, limitaciones, notas de precios, integraciones y guía “mejor para”.

- Página de comparación: vista lado a lado de dos o más productos, con filas de criterios, puntuación (si se usa) y notas.

Agregue páginas de apoyo que reduzcan la confusión y generen credibilidad:

- Metodología (cómo puntúa, qué prueba, con qué frecuencia actualiza)

- Glosario (defina criterios y siglas)

- Contacto (correcciones, asociaciones, fuentes de datos)

Elija patrones de URL que escalen

Elija reglas de URL temprano para no crear redirecciones caóticas después. Dos patrones comunes:

- Comparaciones:

/compare/a-vs-b (o /compare/a-vs-b-vs-c para multi-way)

- Categorías:

/category/ci-cd

Mantenga las URLs cortas, en minúsculas y consistentes. Use el nombre canónico del producto (o un slug estable) para que la misma herramienta no acabe como /product/okta y /product/okta-iam.

Finalmente, decida cómo los filtros y orden afectan las URLs. Si desea vistas filtradas compartibles, planifique un enfoque de query-string limpio (por ejemplo, ?deployment=saas&compliance=soc2) y mantenga la página base usable sin parámetros.

Defina criterios, puntuación y reglas de ponderación

Una matriz de comparación solo ayuda si las reglas son consistentes. Antes de añadir más proveedores o criterios, cierre las reglas matemáticas y el significado detrás de cada campo. Esto evita debates interminables después (“¿Qué quisimos decir con soporte SSO?”) y hace que sus resultados sean defendibles.

Estandarice nombres y definiciones de criterios

Comience con una lista canónica de criterios y trátela como una especificación de producto. Cada criterio debe tener:

- Un nombre claro (corto, fácil de escanear y único)

- Una definición que elimine ambigüedad

- El alcance (qué está incluido/excluido)

- La evidencia que espera para respaldar una puntuación (docs, capturas, resultados de pruebas)

Evite casi-duplicados como “Cumplimiento” vs “Certificaciones” a menos que la distinción sea explícita. Si necesita variantes (p. ej., “Encriptación en reposo” y “Encriptación en tránsito”), haga criterios separados con definiciones propias.

Añada guías de puntuación que la gente pueda seguir

Las puntuaciones solo son comparables si todos usan la misma escala. Escriba rúbricas de puntuación que encajen con el criterio:

- Escala 1–5 cuando el soporte parcial importa (común para usabilidad, madurez, integraciones)

- Aprobado/No aprobado cuando es binario (¿soporta SAML? sí/no)

- Valores numéricos cuando la medición es directa (precio, latencia, retención máxima)

Defina qué significa cada punto. Por ejemplo, “3” podría ser “cumple el requisito con limitaciones”, mientras que “5” es “cumple con opciones avanzadas y despliegues probados”. También especifique si se permite “N/A” y cuándo.

Decida ponderaciones (o decida evitarlas)

La ponderación cambia la historia que cuenta su matriz, así que elija con intención:

- Pesos por defecto: buenos para un ranking “editorial”; documente la lógica.

- Pesos personalizados: óptimos para audiencias diversas; permita que los usuarios ajusten y vean totales actualizarse.

- Sin pesos: lo más seguro cuando quiere neutralidad; enfoque en diferencias lado a lado.

Si soporta pesos personalizados, defina lineamientos (p. ej., los pesos deben sumar 100, o use presets bajo/medio/alto).

Maneje desconocidos y datos faltantes

Los datos faltantes son inevitables. Documente su regla y aplíquela en todas partes:

- Use “Desconocido” cuando no pudo confirmar (y manténgalo distinto de “No”).

- Decida si los desconocidos puntúan como 0, neutral o se excluyen de los totales.

- Registre por qué es desconocido (el proveedor no respondió, la característica no está clara, no se probó).

Estas políticas mantienen su matriz justa, repetible y confiable a medida que crece.

Cree un patrón de UX que haga evidentes las diferencias

Su UI de comparación triunfa o falla en una cosa: si el lector puede ver rápidamente qué es lo que difiere de forma significativa. Decida una vista de comparación principal y un conjunto de señales visuales que hagan que los contrastes resalten.

Elija su vista principal (y manténgase consistente)

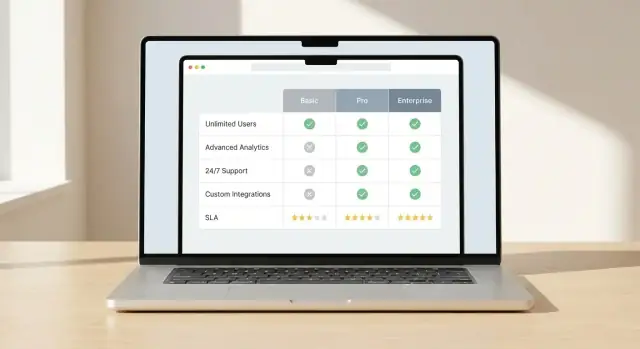

Escoja un patrón y diseñe todo alrededor de él:

- Matriz tabular para comparaciones profundas, fila a fila, entre muchas opciones.

- Comparación por tarjetas para resumir pocas opciones con pros/contras y especificaciones clave.

- Híbrido cuando necesite ambos: tarjetas para la línea superior y una matriz abajo para detalles.

La consistencia importa. Si los usuarios aprenden cómo se muestran las diferencias en un área, las mismas reglas deberían aplicarse en todo el sitio.

Haga que las diferencias sean visualmente obvias

Evite forzar a la gente a escanear cada celda. Use destacados deliberados:

- Enfatice deltas, no la similitud (p. ej., ponga en negrita los valores que difieren).

- Añada indicadores “solo en A” o “faltante en B” para funciones que existen en una opción pero no en otra.

- Use sombreado de fondo sutil para los criterios “más importantes” para que la mirada vaya allí primero.

Mantenga el significado del color simple y accesible: un color para “mejor”, otro para “peor” y un estado neutral. No dependa solo del color: incluya iconos o etiquetas cortas.

Soporte tablas largas sin perder el contexto

Las matrices largas son normales en evaluaciones técnicas. Hágalas usables:

- Headers fijos para que los nombres de columna sigan visibles.

- Primera columna fija para que las etiquetas de criterio no desaparezcan.

- Anclaje de columnas para que el lector pueda bloquear un vendor y desplazar los demás.

Diseñe para móvil desde el día uno

Los usuarios móviles no tolerarán cuadrículas diminutas. Ofrezca:

- Desplazamiento horizontal con señales claras (bordes difuminados, “desliza para comparar”).

- Agrupación de filas (Rendimiento, Seguridad, Precios) con secciones colapsables.

- “Instantáneas de comparación” que muestren primero 5–8 criterios clave y un “ver matriz completa” para profundidad.

Cuando las diferencias son fáciles de detectar, los lectores confían en la matriz y la siguen usando.

Construya filtrado, ordenamiento y comparación lado a lado

Una matriz de comparación solo se siente “rápida” cuando la gente puede reducir la lista y ver diferencias significativas sin desplazarse minutos. Filtrado, ordenamiento y vistas lado a lado son las herramientas de interacción que lo hacen posible.

Filtros que coincidan con cómo la gente decide

Comience con un conjunto pequeño de filtros que reflejen preguntas reales de evaluación, no solo lo fácil de almacenar. Filtros útiles incluyen:

- Categoría (por ejemplo, monitorización, CI/CD, almacén de datos)

- Plataforma (web, móvil, escritorio, solo API)

- Nivel de precios (free, starter, enterprise)

- Modelo de despliegue (SaaS, autoalojado, híbrido)

Diseñe los filtros para que los usuarios puedan combinarlos. Muestre cuántos ítems coinciden a medida que filtran y deje claro cómo limpiar filtros. Si algunos filtros son mutuamente excluyentes, evite combinaciones inválidas en lugar de mostrar “0 resultados” sin explicación.

Ordenamiento que responda “¿por dónde debo empezar?”

El orden debería reflejar prioridades objetivas y específicas de la audiencia. Ofrezca pocas opciones claras como:

- Mejor puntuación (según sus reglas de puntuación)

- Más funciones (conteo de criterios soportados)

- Actualización más reciente (revisión o lanzamiento verificado más reciente)

Si muestra una “mejor puntuación”, explique qué representa (puntuación general vs. por categoría) y permita cambiar la vista de puntuación. Evite defaults ocultos.

Comparación lado a lado (2–5 ítems)

Permita que los usuarios seleccionen un pequeño conjunto (típicamente 2–5) y los compare en un layout de columnas fijas. Mantenga los criterios más importantes anclados cerca de la parte superior y agrupe el resto en secciones colapsables para reducir la sobrecarga.

Haga la comparación compartible con un enlace que preserve selecciones, filtros y orden. Esto permite que equipos revisen la misma lista corta sin recrearla.

Opciones de exportación cuando encajen

Las exportaciones pueden ser valiosas para revisión interna, compras y discusión offline. Si su audiencia lo necesita, ofrezca CSV (para análisis) y PDF (para compartir). Mantenga las exportaciones enfocadas: incluya ítems seleccionados, criterios elegidos, timestamps y notas sobre la puntuación para que el archivo no sea engañoso cuando se vea después.