05 nov 2025·8 min

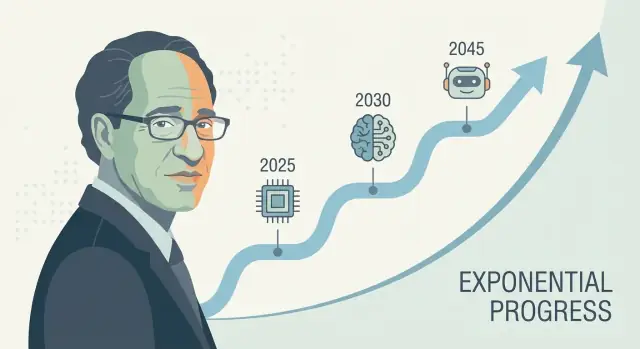

Cronograma de la AGI según Ray Kurzweil: cómo pronostica décadas en el futuro

Explora las predicciones a largo plazo de Ray Kurzweil sobre la AGI: sus cronogramas, enfoque de previsión, aciertos y errores, críticas y qué señales seguir a continuación.

Por qué importan las predicciones de AGI de Kurzweil

Ray Kurzweil es una de las voces más reconocidas en la previsión tecnológica a largo plazo—especialmente en torno a la inteligencia artificial y la singularidad tecnológica. Cuando formula una predicción concreta sobre la AGI (a menudo presentada como una fecha, no un vago “algún día”), tiende a repercutir: inversores la citan, periodistas la debaten y a los investigadores se les pide responder.

Por qué sus previsiones atraen atención

La influencia de Kurzweil no se reduce al optimismo. Se trata de ofrecer una narrativa repetible sobre por qué el progreso debería acelerarse—habitualmente vinculada al crecimiento exponencial en la computación y a la idea de que cada generación de herramientas ayuda a construir la siguiente. Tanto si está de acuerdo como si no, proporciona una forma estructurada de discutir una línea temporal de la inteligencia artificial general en lugar de tratarla como pura ciencia ficción.

Qué significa realmente “predecir décadas por delante”

Un pronóstico a décadas vista es menos adivinar una fecha en el calendario y más proyectar un conjunto de tendencias: cómputo, coste, datos, algoritmos y la capacidad práctica de construir sistemas que generalicen. La apuesta es que estas curvas siguen moviéndose—y que los “pedazos que faltan” de hoy son problemas de ingeniería solucionables que se reducen a medida que mejoran los insumos.

Qué aprenderá en este artículo

Este texto desglosa:

- El método detrás de los métodos de previsión tecnológica de Kurzweil (qué mide y extrapola)

- Qué evidencia apoya la visión de que los indicadores de progreso de la IA se aceleran—y dónde faltan datos

- Las críticas más sólidas a las previsiones de IA que dependen de extrapolaciones en línea recta de crecimiento exponencial

- Conclusiones prácticas para usar previsiones como herramientas de planificación sin tratarlas como certezas

Una nota rápida sobre la incertidumbre

Incluso entre expertos serios, los cronogramas de AGI varían ampliamente porque dependen de supuestos: qué significa “AGI”, qué cuellos de botella importan más y qué tan rápido los avances se traducen en productos fiables. Los cronogramas de Kurzweil son influyentes no porque sean garantizados, sino porque son lo suficientemente específicos como para poder ser puestos a prueba—y lo bastante difíciles como para no poder ignorarlos.

¿Quién es Ray Kurzweil?

Ray Kurzweil es un inventor, autor y futurista estadounidense conocido por hacer previsiones tecnológicas a largo plazo—y por respaldarlas con gráficos, datos históricos y plazos audaces.

Inventor, empresario y “detector de patrones”

Kurzweil se dio a conocer principalmente por inventos prácticos, especialmente en tecnologías de voz y texto. Creó empresas centradas en reconocimiento óptico de caracteres (OCR), síntesis de voz y herramientas musicales, y ha pasado décadas cerca de las limitaciones reales de producto: calidad de datos, costes de hardware y qué adoptan realmente los usuarios. Esa mentalidad de creador da forma a sus previsiones—tiende a tratar el progreso como algo que puede diseñarse, escalarse y gestionarse.

También trabajó en grandes organizaciones tecnológicas (incluida Google), lo que refuerza su visión de que los grandes saltos suelen provenir de inversión sostenida, mejores herramientas y mejoras compuestas—no solo de avances aislados.

Libros e ideas clave que influyen en los debates sobre AGI

El cronograma de AGI de Kurzweil suele discutirse a través de sus libros populares, especialmente The Age of Spiritual Machines (1999) y The Singularity Is Near (2005). Estas obras sostienen que las tecnologías de la información mejoran de forma acelerada y compuesta—y que esa aceleración eventualmente producirá máquinas con capacidades a nivel humano (y luego superiores).

Tenga usted la postura que tenga, su escritura ayudó a fijar los términos de la conversación pública: el progreso de la IA como algo medible, impulsado por tendencias y (al menos en principio) susceptible de previsión.

Definiciones rápidas (para hablar los mismos términos)

AGI (Artificial General Intelligence): un sistema de IA que puede aprender y realizar una amplia variedad de tareas a un nivel cercano al humano, adaptándose a problemas nuevos sin especialización estrecha.

Singularidad: el término de Kurzweil para un periodo en el que el progreso tecnológico se vuelve tan rápido (y la IA tan capaz) que transforma la sociedad de maneras impredecibles y difíciles de modelar.

Cronograma: una previsión con fechas y hitos (por ejemplo, “IA a nivel humano para el año X”), no solo una afirmación general de que el progreso continuará.

Afirmaciones centrales de Kurzweil sobre los cronogramas de la AGI

Kurzweil ha argumentado repetidamente que la AGI a nivel humano es probable dentro de la primera mitad del siglo XXI—más famosamente agrupando las predicciones hacia finales de los años 2020 y los 2030 en charlas públicas y libros. No siempre fija un año único, pero la tesis central es consistente: una vez que el poder de cómputo, los datos y los algoritmos cruzan ciertos umbrales, los sistemas igualarán la amplitud y la adaptabilidad de la cognición humana.

Cómo la AGI se conecta con la “singularidad”

En el marco de Kurzweil, la AGI no es la línea de meta—es un desencadenante. Cuando las máquinas alcanzan (y luego superan) la inteligencia general a nivel humano, el progreso se compone: los sistemas más inteligentes ayudan a diseñar sistemas aún más inteligentes, acelerando el descubrimiento científico, la automatización y la integración humano–máquina. Esa dinámica de composición es lo que enlaza con la idea más amplia de “singularidad tecnológica”: un periodo donde el cambio se vuelve tan rápido que la intuición cotidiana deja de ser guía fiable.

AGI vs. los sistemas de IA actuales

Una matización clave en sus afirmaciones de cronograma es la definición de AGI. Los modelos líderes de hoy pueden ser impresionantes en muchas tareas, pero aún suelen ser:

- frágiles fuera de los patrones de entrenamiento,

- débiles en planificación a largo plazo y en anclaje en el mundo real,

- dependientes de objetivos y evaluaciones controladas por humanos.

La “AGI” de Kurzweil implica un sistema que puede transferir aprendizaje entre dominios, formular y perseguir objetivos en situaciones nuevas y manejar de forma fiable la variedad abierta del mundo real—no solo destacar en benchmarks.

Por qué los hitos son mejores que una sola fecha

Una predicción calendárica es fácil de debatir y difícil de usar. Los hitos son más prácticos: aprendizaje autónomo sostenido, uso y planificación de herramientas fiables, alto rendimiento en entornos reales y desordenados, y sustitución económica clara en muchos tipos de empleo. Aunque discrepe del calendario exacto, estos puntos hacen la previsión comprobable—y más útil que apostar por un único año de titular.

Historial: aciertos, fallos y lo debatible

A Kurzweil a menudo se le describe como un “predicador en serie”, y esa reputación forma parte de por qué su cronograma de AGI atrae atención. Su historial es mixto de forma instructiva para la previsión: algunas predicciones fueron específicas y medibles, otras estuvieron en lo correcto en dirección pero vagas en tiempo, y unas pocas subestimaron limitaciones importantes.

Predicciones notables vinculadas a Kurzweil

A través de libros y charlas, se le asocia con pronósticos como:

- Mejora constante del rendimiento/coste de los ordenadores (continuación de tendencias tipo ley de Moore)

- Reconocimiento de voz volviéndose usable para consumidores

- Computación móvil y siempre conectada convirtiéndose en la norma

- IA superando a humanos en tareas estrechas (por ejemplo, juegos, reconocimiento de patrones)

- Creciente integración humano–máquina (wearables, implantes, tecnología asistencial)

Predicciones comprobables vs. vagas

Predicciones comprobables están vinculadas a una fecha y un resultado medible: “para el año X, la tecnología Y alcanzará el rendimiento Z”, o “la mayoría de los dispositivos tendrán la característica F”. Estas se pueden contrastar con benchmarks públicos (tasas de precisión, ventas/adopción, costes de cómputo).

Predicciones vagas suenan plausibles pero son difíciles de falsar, como “los ordenadores estarán en todas partes”, “la IA transformará la sociedad” o “los humanos se fusionarán con la tecnología”. Estas pueden parecer verdaderas aunque los detalles, el momento o los mecanismos difieran.

Cómo juzgar “acertado”, “parcialmente acertado” y “equivocado” (sin llevar la cuenta)

Una forma práctica de evaluar a cualquier pronosticador es separar dirección, plazo y especificidad.

- Acertado: el resultado coincide con la afirmación y el tiempo es lo bastante cercano como para haber guiado expectativas.

- Parcialmente acertado: la dirección es correcta, pero el tiempo se retrasa, la adopción es más lenta o el resultado llega en forma distinta (p. ej., “funciona en demos” vs. “funciona para la mayoría de la gente la mayor parte del tiempo”).

- Equivocado: se subestimaron limitaciones clave—calidad de datos, regulación, comportamiento de usuarios, coste o la brecha entre rendimiento en laboratorio y fiabilidad en el mundo real.

La idea no es etiquetar pronósticos como “buenos” o “malos”, sino notar cómo predicciones seguras y basadas en datos aún pueden depender de supuestos ocultos—sobre todo cuando involucran adopción social compleja, no solo mejoras en hardware o algoritmos.

La “ley de los rendimientos acelerados” en cristiano

Lánzalo rápidamente

Despliega y hospeda tu app cuando estés listo, sin pasos adicionales de configuración.

La “ley de los rendimientos acelerados” de Kurzweil es la idea de que cuando una tecnología mejora, esas mejoras suelen facilitar nuevas mejoras. Eso crea un bucle de retroalimentación donde el progreso se acelera con el tiempo.

Tendencias exponenciales, sin matemáticas

Una tendencia lineal es como añadir la misma cantidad cada año: 1, 2, 3, 4.

Una tendencia exponencial es como multiplicar: 1, 2, 4, 8. Al principio parece lenta—luego de repente todo parece suceder de golpe. Kurzweil sostiene que muchas tecnologías (especialmente las de la información) siguen este patrón porque cada generación de herramientas ayuda a construir la siguiente.

Por qué importan las curvas coste/rendimiento para sus cronogramas

Kurzweil no solo pregunta “¿Podemos hacer X?”; pregunta “¿A qué coste podemos hacerlo?”. Un patrón común en computación es: el rendimiento sube mientras el coste baja. Cuando el coste de ejecutar un modelo útil cae, más gente puede experimentar, desplegar productos y financiar la siguiente ola—acelerando el progreso.

Por eso presta atención a curvas de largo plazo como “cómputo por dólar”, no solo a demos llamativas.

Dónde encaja la ley de Moore—y dónde no

La ley de Moore es el ejemplo clásico: durante décadas el número de transistores en chips se duplicó en un horario regular, impulsando ordenadores más rápidos y baratos.

El argumento de Kurzweil no es “la ley de Moore seguirá para siempre”. Es más amplio: incluso si un enfoque hardware se ralentiza, otros métodos (mejores chips, GPUs/TPUs, paralelismo, nuevas arquitecturas, eficiencia de software) pueden mantener la mejora global en coste/rendimiento.

Por qué pensar en línea recta engaña

La gente suele predecir el futuro extendiendo el cambio reciente a la misma velocidad. Eso falla en capturar el compuesto. Hace que el progreso temprano parezca poco impresionante—y que el progreso tardío parezca “repentino”, cuando puede haber estado acumulándose de forma predecible en una curva durante años.

Qué datos respaldan (y limitan) estas previsiones

Previsiones como las de Kurzweil suelen comenzar con tendencias medibles—cosas que puede trazarse en un gráfico. Eso es una fortaleza: puede debatirse sobre insumos en lugar de pelear solo por intuiciones. También es donde aparecen las mayores limitaciones.

Las curvas “fáciles de medir”: cómputo, almacenamiento, ancho de banda, coste

Los previsores tecnológicos a menudo siguen:

- Cómputo (cuántas operaciones puede comprarse por dólar)

- Almacenamiento (cuánto dato puede guardarse por dólar)

- Ancho de banda (qué tan rápido se puede mover dato y a qué precio)

- Descensos de coste (para chips, instancias cloud, ejecuciones de entrenamiento y energía por unidad de trabajo)

Estas curvas son convincentes porque son de larga duración y se actualizan con frecuencia. Si su visión de la AGI es “suficiente hardware más software adecuado”, estos datos pueden parecer un fundamento sólido.

El progreso del hardware no es lo mismo que el progreso de capacidades

La principal brecha: más hardware no produce automáticamente sistemas más inteligentes. La capacidad de la IA depende de algoritmos, calidad de datos, recetas de entrenamiento, herramientas y retroalimentación humana—no solo de FLOPs.

Una forma útil de pensarlo: el hardware es un presupuesto, la capacidad es el resultado. La relación entre ambos es real, pero no fija. A veces un pequeño cambio algorítmico desbloquea grandes ganancias; otras veces la escalada choca con rendimientos decrecientes.

Por qué importan los benchmarks y el uso en el mundo real

Para conectar “insumos” (cómputo, dinero) con “resultados” (qué pueden realmente hacer los modelos), los previsores necesitan:

- Benchmarks que midan razonamiento, planificación y generalización—no solo correlación de patrones

- Rendimiento en el mundo real en entornos desordenados: fiabilidad, seguridad, tareas a largo plazo y adaptabilidad

Los benchmarks pueden ser manipulados, así que las señales más convincentes combinan puntuaciones de test con evidencia de utilidad duradera.

Errores comunes: gráficos limpios, cuellos de botella ocultos

Dos errores frecuentes son seleccionar curvas (elegir ventanas temporales que parezcan más exponenciales) e ignorar cuellos de botella como energía, límites de datos, latencia, regulación o la dificultad de convertir competencia estrecha en competencia general. Estos no invalidan la previsión, pero amplían las barras de error.

Suposiciones clave detrás de las previsiones a décadas vista

Prototipa, no solo predigas

Convierte tus ideas de IA en un prototipo funcional sin comprometerte a un desarrollo largo.

Los cronogramas de AGI a largo plazo—incluido el de Kurzweil—dependen menos de un único “momento de ruptura” y más de una pila de suposiciones que deben cumplirse simultáneamente. Si alguna capa flaquea, la fecha puede desplazarse aunque el progreso continúe.

1) Cómputo, algoritmos y datos siguen componiéndose

La mayoría de previsiones a décadas vista asumen que tres curvas suben juntas:

- Escala de cómputo más barata y fácil de desplegar (más chips, clusters más grandes, mejor utilización).

- Progreso algorítmico que entregue importantes ganancias de eficiencia—es decir, cada unidad de cómputo produce más capacidad que antes.

- Disponibilidad de datos suficiente, ya sea por nuevas fuentes (datos multimodales), datos sintéticos, mejores herramientas de etiquetado o mejor auto-supervisión.

Una suposición oculta clave: estos tres impulsores no se substituyen perfectamente. Si la calidad de los datos se estanca, “añadir sólo cómputo” puede ofrecer retornos más pequeños.

2) Las restricciones físicas e industriales no frenan demasiado

Las previsiones suelen tratar el cómputo como una curva suave, pero la realidad pasa por fábricas y redes eléctricas.

Costes energéticos, capacidad de fabricación de chips, controles de exportación, ancho de banda de memoria, equipamiento de redes y choques en la cadena de suministro pueden limitar la rapidez con la que el entrenamiento y el despliegue escalan. Aunque la teoría diga “10× más cómputo”, el camino puede ser accidentado y caro.

3) Los sistemas humanos permiten el despliegue rápido

Las previsiones a décadas vista también asumen que la sociedad no retrasa demasiado la adopción:

Regulación, responsabilidad, confianza pública, integración en el trabajo y retorno de inversión influyen en si los sistemas avanzados se entrenan y usan ampliamente—o se mantienen en entornos estrechos y con alta fricción.

4) Las mejoras de capacidad se traducen en generalidad

Quizá la suposición más importante es que las mejoras de capacidad por escalado (mejor razonamiento, planificación, uso de herramientas) convergen naturalmente hacia la inteligencia general.

“Más cómputo” puede producir modelos más fluidos y útiles, pero no automáticamente más generales en el sentido de transferencia fiable entre dominios, autonomía a largo plazo o objetivos estables. Los cronogramas largos suelen asumir que estas brechas son problemas de ingeniería—no barreras fundamentales.

Qué podría retrasar la AGI (incluso si las tendencias siguen subiendo)

Aunque la potencia de cálculo y los tamaños de modelo sigan aumentando, la AGI podría llegar más tarde de lo previsto por razones que poco tienen que ver con la velocidad bruta. Varias limitaciones se refieren al qué construimos y cómo sabemos que funciona.

1) La definición del problema puede seguir siendo imprecisa

“AGI” no es una única característica que pueda activarse. Una definición útil suele implicar un agente que puede aprender tareas nuevas rápidamente, transferir habilidades entre dominios, planificar a largo plazo y manejar objetivos cambiantes con alta fiabilidad.

Si el objetivo sigue cambiando—asistente conversacional vs. trabajador autónomo vs. razonador al nivel de un científico—el progreso puede parecer impresionante y aun así carecer de capacidades clave como memoria a largo plazo, razonamiento causal o toma de decisiones consistente.

2) Medir la AGI es más difícil que medir GPUs

Los benchmarks pueden manipularse, sobreajustarse o quedarse obsoletos. Los escépticos suelen pedir evidencia de que una IA puede triunfar en tareas no vistas, bajo restricciones nuevas, con bajas tasas de error y resultados repetibles.

Si el campo no acuerda pruebas que separen convincentemente la “completación excelente de patrones” de la “competencia general”, los cronogramas se convierten en conjeturas—y la cautela puede ralentizar el despliegue.

3) La alineación y la seguridad pueden convertirse en el factor que marque el paso

La capacidad puede aumentar más rápido que el control. Si los sistemas se vuelven más agentivos, sube la exigencia para prevenir engaños, deriva de objetivos y efectos secundarios dañinos.

La regulación, auditorías e ingeniería de seguridad pueden añadir tiempo aunque los modelos suban rápidamente—especialmente en usos de alto riesgo.

4) La incorporación al mundo físico y la interacción real siguen siendo preguntas abiertas

Muchas definiciones de AGI suponen competencia en el mundo físico: manipular objetos, realizar experimentos, operar herramientas y adaptarse en tiempo real.

Si el aprendizaje en el mundo real resulta muy demandante de datos, lento o arriesgado, la AGI podría quedarse en un “brillante desempeño en pantalla” mientras la generalidad práctica espera mejores soluciones en robótica, simulación y métodos de entrenamiento seguros.

Principales críticas al enfoque de Kurzweil

Mantén control total del código

Exporta el código fuente en cualquier momento para revisarlo, personalizarlo o integrarlo en tu flujo de trabajo.

Las previsiones de Kurzweil son influyentes en parte porque son claras y cuantitativas—pero esa misma claridad atrae críticas.

1) Extrapolar tendencias pasadas puede ocultar “cambios de régimen”

Una objeción común es que Kurzweil se apoya mucho en extender curvas históricas (cómputo, almacenamiento, ancho de banda) hacia el futuro. Los críticos sostienen que la tecnología no siempre escala de forma suave: el progreso de chips puede ralentizarse, los costes energéticos pueden afectar y los incentivos económicos pueden cambiar. Aunque la dirección a largo plazo pueda ser ascendente, la tasa puede cambiar de maneras que hagan que fechas concretas sean poco fiables.

2) Los sistemas complejos no entregan avances según calendario

La AGI no es solo cuestión de hardware más rápido. Es un problema de sistemas complejos que implica algoritmos, datos, métodos de entrenamiento, evaluación, restricciones de seguridad y adopción humana. Los avances pueden bloquearse por una única idea ausente—algo que no puede “calendariarse” de forma fiable. Los escépticos señalan que la ciencia avanza a menudo por pasos desiguales: largas mesetas seguidas por saltos repentinos.

3) Los efectos de selección hacen que las predicciones audaces parezcan mejores

Otra crítica es psicológica: recordamos más las llamadas dramáticas correctas que los fallos más discretos o los casi-aciertos. Si alguien hace muchas predicciones fuertes, unos pocos aciertos memorables pueden dominar la percepción pública. Eso no significa que el pronosticador esté “equivocado”, pero puede inflar la confianza en la exactitud de los cronogramas.

4) Por qué personas inteligentes discrepan en los cronogramas

Incluso expertos que aceptan un progreso rápido en la IA difieren sobre qué “cuenta” como AGI, qué capacidades deben generalizar y cómo medirlas. Pequeñas diferencias definitorias (amplitud de tareas, autonomía, fiabilidad, aprendizaje en el mundo real) pueden desplazar cronogramas por décadas—sin que nadie cambie su visión subyacente del progreso actual.

Cómo otros expertos pronostican cronogramas de AGI

Kurzweil es una voz ruidosa, pero los cronogramas de AGI son un debate concurrido. Una forma útil de mapearlo es el campo a corto plazo (AGI en años o un par de décadas) versus el campo a largo plazo (varias décadas o “no este siglo”). A menudo miran las mismas tendencias pero discrepan en lo que falta: los optimistas a corto plazo enfatizan la escalada rápida y las capacidades emergentes, mientras que los más prudentes insisten en problemas sin resolver como razonamiento fiable, autonomía y robustez en el mundo real.

Enfoques comunes de previsión (además de extrapolar tendencias)

Encuestas a expertos agregan creencias de investigadores y practicantes (por ejemplo, sondeos que preguntan cuándo hay 50% de probabilidad de “IA a nivel humano”). Pueden revelar el cambio de sentimiento, pero también reflejan a quién se encuesta y cómo se formulan las preguntas.

Planificación por escenarios evita elegir una sola fecha. En su lugar, esboza futuros plausibles (progreso rápido, progreso lento, cuellos regulatorios, limitaciones de hardware) y pregunta qué señales indicarían cada camino.

Previsión basada en benchmarks y capacidades sigue hitos concretos (tareas de codificación, razonamiento científico, fiabilidad de agentes) y estima la tasa de mejora necesaria para alcanzar una competencia más amplia.

Las definiciones cambian la fecha

“AGI” puede significar pasar una suite amplia de pruebas, realizar la mayoría de trabajos, operar como agente autónomo o igualar a humanos en dominios múltiples con mínima supervisión. Una definición más estricta generalmente empuja los cronogramas hacia adelante, y el desacuerdo sobre esto explica gran parte de la dispersión.

Lo más cercano a un consenso: incertidumbre

Incluso los expertos optimistas y los escépticos suelen coincidir en un punto: los cronogramas son altamente inciertos, y las previsiones deberían tratarse como rangos con supuestos—no como compromisos calendáricos.

Preguntas frecuentes

¿Por qué las predicciones de Kurzweil sobre la AGI atraen tanta atención?

Las previsiones de Kurzweil importan porque son lo suficientemente específicas como para poder ser comprobadas y se citan ampliamente, lo que moldea cómo se habla de los cronogramas de la AGI.

En la práctica, influyen en:

- cómo inversores y empresas planifican apuestas a largo plazo,

- cómo los periodistas enmarcan lo “esperado”,

- qué preguntas reciben los investigadores para justificar o refutar esas afirmaciones.

Aunque las fechas puedan estar equivocadas, los hitos y supuestos que destaca pueden ser insumos útiles para la planificación.

¿Qué quiere decir Kurzweil con “AGI” en estas afirmaciones de cronograma?

En este contexto, AGI significa una IA que puede aprender y realizar una amplia gama de tareas a un nivel aproximado al humano, incluyendo adaptarse a problemas nuevos sin estar estrechamente especializada.

Una lista práctica implícita en el artículo incluye:

- fuerte transferencia entre dominios,

- planificación a largo plazo,

- uso fiable de herramientas en entornos reales y desordenados,

- rendimiento consistente más allá de benchmarks curados.

¿Qué cronograma suele sugerir Kurzweil para la AGI a nivel humano?

La visión pública más citada de Kurzweil sitúa la AGI a nivel humano en la segunda mitad de la década de 2020 hasta los 2030, presentada como una ventana probable más que un único año garantizado.

La manera práctica de usar esto es tratarlo como un rango de escenario y seguir si las tendencias previas (coste del cómputo, algoritmos, despliegue) continúan en la dirección necesaria.

¿Qué es la “ley de los rendimientos acelerados” de Kurzweil, en palabras sencillas?

Sostiene que el progreso se acelera porque las mejoras en una tecnología suelen facilitar mejoras posteriores, creando un bucle de retroalimentación compuesto.

En la práctica, señala tendencias como:

- más cómputo por dólar,

- caída de costes de almacenamiento y ancho de banda,

- mejores herramientas que aceleran la siguiente generación de herramientas.

La reivindicación central no es que una sola “ley” lo explique todo, sino que el efecto compuesto puede convertir progresos iniciales lentos en cambios rápidos más adelante.

¿Cuánto de la previsión de AGI se reduce a que el cómputo sea más barato?

El cómputo es una entrada clave, pero el artículo enfatiza que el progreso de hardware ≠ progreso de capacidades.

Más cómputo ayuda cuando se combina con:

- mejoras algorítmicas,

- datos de alta calidad (o formas de generarlos/curarlos),

- recetas de entrenamiento y evaluación eficaces,

- herramientas que convierten capacidad bruta en productos fiables.

Un buen modelo mental: el hardware es el ; la capacidad es el —la relación entre ambos puede cambiar.

¿Qué datos respaldan (y limitan) las previsiones al estilo de Kurzweil?

Los datos útiles de apoyo incluyen curvas medibles a largo plazo:

- cómputo por dólar,

- almacenamiento por dólar,

- mejoras en ancho de banda y latencia,

- tendencias de costes de entrenamiento/inferencia en la nube.

Límites clave:

¿Qué suposiciones tienen que cumplirse para que las predicciones de AGI a décadas vista se cumplan?

Las principales suposiciones señaladas en el artículo incluyen:

- Cómputo, algoritmos y datos siguen compounding (aumentando) en conjunto.

- Las limitaciones físicas/industriales (energía, fábricas, cadenas de suministro) no se vuelven cuellos de botella dominantes.

- La sociedad permite un despliegue rápido (regulación, responsabilidad, confianza no paralizan la adopción).

- Las mejoras de capacidad por escalado se traducen en generalidad (transferencia, autonomía, robustez).

Si alguna de estas capas se debilita, la fecha puede retrasarse aunque el progreso continúe.

¿Qué podría retrasar la AGI incluso si el cómputo y los modelos siguen mejorando?

Varios factores de retraso no requieren que las tendencias se inviertan:

- definiciones poco claras o cambiantes de “AGI”,

- medidas débiles (falta de pruebas acordadas de competencia general),

- la alineación/seguridad convirtiéndose en el factor limitante,

- la incorporación al mundo físico y la interacción real resultando lentas, arriesgadas o que demanden muchos datos,

- fricción en el despliegue (coste, integración, regulación).

Estos factores pueden ralentizar los cronogramas mientras los modelos siguen mejorando en papel.

¿Cuáles son las críticas más fuertes al enfoque de previsión de Kurzweil?

El artículo subraya críticas como:

- las extrapolaciones pueden perder cambios de régimen (ralentización de chips, límites energéticos, cambios económicos),

- los sistemas complejos no producen avances con calendario fijo,

- los aciertos espectaculares de predictores audaces pueden recordarse más que los errores (efectos de selección),

- los expertos discrepan en gran medida porque las definiciones y estándares de evaluación difieren.

Conclusión práctica: trate las fechas precisas como , no como promesas.

¿Cuáles son las señales más prácticas a vigilar en los próximos 5–10 años?

Vigile señales que deberían moverse antes de cualquier “momento AGI”, especialmente:

- Capacidad: planificación en varios pasos, uso robusto de herramientas, agentes que completan tareas de varias horas.

- Fiabilidad: tasas de error menores en flujos de trabajo reales, consistencia entre ejecuciones, rendimiento bajo auditorías.

- Economía: ganancias sostenidas de productividad y caída del coste por tarea útil.

¿Qué conclusiones prácticas se pueden extraer: usar previsiones sin confiar ciegamente en ellas?

Trate las previsiones de AGI como pronósticos meteorológicos para una fecha lejana: útiles para planificar, poco fiables como promesa.

Use los cronogramas para explorar rangos y escenarios, no un único año. Si alguien dice “AGI para 203X”, pregúntese: “¿Qué tendría que pasar para que esto sea verdad, y qué pasa si no ocurre?” Luego planifique múltiples resultados.

Para individuos: desarrolle habilidades duraderas (planteamiento de problemas, experiencia sectorial, comunicación) y mantenga el hábito de aprender nuevas herramientas.

Para empresas: invierta en alfabetización en IA, calidad de datos y pilotos con ROI claro—manteniendo un plan “sin arrepentimientos” que funcione incluso si la AGI llega más tarde.

Una forma pragmática de operacionalizar “vigile señales y itere” es acortar ciclos de construcción: prototipar flujos de trabajo, probar fiabilidad y cuantificar ganancias de productividad antes de hacer grandes apuestas. Plataformas como encajan en este enfoque al permitir a equipos crear apps web, backend y móviles mediante una interfaz de chat (con modo de planificación, snapshots y rollback), de modo que pueda probar procesos asistidos por agentes rápidamente, exportar código fuente y evitar atar la estrategia a una sola previsión.