Qué significan realmente “vibe coding” y “endurecimiento para producción"

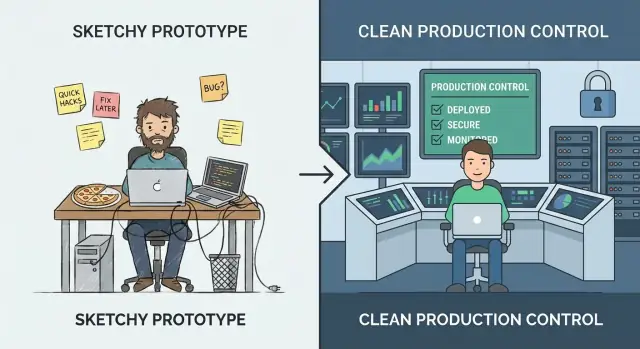

“Vibe coding” es la fase donde la velocidad gana a la precisión. Estás experimentando, aprendiendo qué quieren realmente los usuarios y probando ideas que quizá no sobrevivan la semana. La meta es obtener insights: validar un flujo, demostrar una propuesta de valor o confirmar que existen los datos necesarios. En este modo, los bordes ásperos son normales: pasos manuales, manejo de errores débil y código optimizado para llegar a “funciona” rápido.

“El endurecimiento para producción” es diferente. Es el trabajo de hacer que el comportamiento sea predecible bajo uso real: entradas desordenadas, fallos parciales, tráfico pico y personas haciendo cosas que no preveías. Endurecer no consiste tanto en añadir características como en reducir sorpresas: que el sistema falle de forma segura, se recupere limpiamente y sea entendible para la próxima persona que tenga que operarlo.

Cambiar demasiado pronto vs. demasiado tarde

Si endureces demasiado pronto puedes frenar el aprendizaje. Puedes invertir en escalado, automatización o arquitectura pulida para una dirección de producto que cambie la semana siguiente. Eso es caro y puede hacer que un equipo pequeño se quede atascado.

Si endureces demasiado tarde, creas riesgo. Los mismos atajos que servían para una demo se convierten en incidentes visibles para el cliente: inconsistencia de datos, brechas de seguridad y caídas que dañan la confianza.

No tienes que elegir uno para siempre

Un enfoque práctico es seguir experimentando mientras endureces la “cintura delgada” del sistema: los pocos caminos clave que deben ser confiables (registro, pagos, escrituras de datos, integraciones críticas). Aún puedes iterar rápido en funciones periféricas: solo no permitas que las suposiciones del prototipo gobiernen las partes de las que los usuarios reales dependen cada día.

Aquí también importan las elecciones de herramientas. Plataformas diseñadas para iteración rápida pueden ayudarte a mantener el modo “vibe” sin perder la capacidad de profesionalizar más tarde. Por ejemplo, Koder.ai está diseñado para vibe-coding vía chat para crear apps web, backend y móviles, pero también soporta exportación de código fuente, despliegue/hosting, dominios personalizados y snapshots/rollback: características que encajan con la mentalidad de “cintura delgada” (envía rápido, pero protege caminos críticos y recupérate pronto).

Un modelo de madurez simple: de demo a fiable

El vibe coding brilla cuando intentas aprender rápido: ¿funciona esta idea en absoluto? El error es asumir que los mismos hábitos aguantarán una vez que la gente real (o procesos reales de negocio) dependan del resultado.

Las etapas por las que la mayoría de equipos pasan

Una forma útil de decidir qué endurecer es nombrar la etapa en la que estás:

- Idea: explorar viabilidad; el código desechable está bien.

- Demo: una prueba clicable o ejecutable; el éxito es “muestra el concepto”.

- Piloto: un flujo real y pequeño; el éxito es “ayuda a algunas personas de forma fiable”.

- Beta: acceso más amplio; el éxito es “funciona la mayor parte del tiempo, con soporte”.

- Producción: herramienta predeterminada para un trabajo; el éxito es “es fiable, segura y mantenible”.

Cómo cambian los requisitos cuando importan los resultados

A medida que te mueves a la derecha, la cuestión cambia de “¿Funciona?” a “¿Podemos confiar en ello?”. Eso añade expectativas como rendimiento predecible, manejo claro de errores, auditabilidad y la capacidad de revertir cambios. También te obliga a definir la propiedad: ¿quién responde cuando algo se rompe?

La curva de costes que a nadie le gusta

Los bugs arreglados durante idea/demo son baratos porque cambias código que nadie usa. Después del lanzamiento, el mismo bug puede desencadenar tiempo de soporte, limpieza de datos, pérdida de clientes o plazos incumplidos. Endurecer no es perfeccionismo: es reducir el radio de impacto de errores inevitables.

“Producción” no es solo cara al cliente

Una herramienta interna que genera facturas, enruta leads o controla accesos ya es producción si el negocio depende de ella. Si una falla detendría el trabajo, expondría datos o crearía riesgo financiero, trátala como producción, aunque solo la usen 20 personas.

Señales de que has superado la fase de prototipo

Un prototipo puede ser frágil. Prueba una idea, abre una conversación y te ayuda a aprender rápido. El momento en que la gente real comienza a depender de él, el coste de los “arreglos rápidos” sube—y los riesgos pasan de inconvenientes a impactos de negocio.

Señales más claras a vigilar

Tu audiencia está cambiando. Si el conteo de usuarios sube de forma sostenida, has añadido clientes de pago o has firmado cualquier cosa con expectativas de uptime/respuesta, ya no estás experimentando: estás ofreciendo un servicio.

Los datos se volvieron más sensibles. El día que tu sistema comienza a tocar PII (nombres, emails, direcciones), datos financieros, credenciales o archivos privados, necesitas controles de acceso más fuertes, trazas de auditoría y valores por defecto más seguros. Un prototipo puede ser “suficientemente seguro para una demo”. Los datos reales no.

El uso se vuelve rutinario o crítico. Cuando la herramienta forma parte del flujo diario de alguien—o cuando las fallas bloquean pedidos, informes, onboarding o soporte—el tiempo de inactividad y los casos límite dejan de ser aceptables.

Otros equipos dependen de tus salidas. Si equipos internos construyen procesos alrededor de tus dashboards, exportaciones, webhooks o APIs, cada cambio es un posible breaking change. Sentirás presión para mantener el comportamiento consistente y comunicar cambios.

Las rupturas se vuelven recurrentes. Una corriente constante de mensajes “se rompió”, pings en Slack y tickets de soporte indica que pasas más tiempo reaccionando que aprendiendo. Esa es la señal para invertir en estabilidad en lugar de más características.

Un chequeo rápido por intuición

Si una caída de una hora sería embarazosa, te estás acercando a producción. Si sería caro—pérdida de ingresos, promesas incumplidas o confianza dañada—ya estás en producción.

Decide con base en el riesgo, no en las vibras

Si estás discutiendo si la app está “lista”, ya planteas la pregunta equivocada. La mejor pregunta es: ¿cuál es el coste de estar equivocado? Endurecer para producción no es una insignia de honor—es una respuesta al riesgo.

Empieza definiendo “fallo” en términos sencillos

Anota cómo se ve el fallo para tu sistema. Categorías comunes:

- Downtime: el servicio no puede usarse en absoluto

- Resultados incorrectos: se ejecuta, pero produce salidas equivocadas (a menudo peor que la caída)

- Respuestas lentas: los usuarios abandonan tareas, las automatizaciones expiran, los tickets de soporte se disparan

Sé específico. “La búsqueda tarda 12 segundos para el 20% de usuarios en hora pico” es accionable; “problemas de rendimiento” no lo es.

Estima el impacto en el negocio (aunque sea aproximado)

No necesitas números perfectos—usa rangos.

- Ingresos: ventas perdidas, renovaciones fallidas, penalizaciones por SLA

- Churn y confianza: los usuarios no vuelven tras malas experiencias

- Pérdida de productividad: equipos internos bloqueados, atajos manuales multiplicándose

- Cumplimiento: hallazgos de auditoría, incumplimientos contractuales, obligaciones de reporte

Si el impacto es difícil de cuantificar, pregunta: ¿A quién llaman? ¿Quién se disculpa? ¿Quién paga?

Lista los riesgos principales que cargas

La mayoría de fallos prototipo→producción se agrupan en unos pocos bloques:

- Pérdida o corrupción de datos (sin backups, migraciones inseguras, controles de acceso débiles)

- Brecha de seguridad (tokens filtrados, permisos excesivos, endpoints expuestos)

- Automatizaciones incorrectas (LLMs o scripts que hacen el cambio equivocado a escala)

Ordena los riesgos por probabilidad × impacto. Esto se convierte en tu hoja de ruta de hardening.

Elige un objetivo de fiabilidad “suficiente” para tu etapa

Evita la perfección. Elige un objetivo que coincida con las apuestas actuales—por ejemplo, “disponibilidad en horario laboral”, “99% de éxito en flujos centrales” o “restaurar dentro de 1 hora”. A medida que crezcan el uso y la dependencia, sube la barra deliberadamente en lugar de reaccionar en pánico.

La preparación para producción empieza con propiedad y alcance

“El hardening para producción” suele fallar por una razón simple: nadie puede decir quién es responsable de extremo a extremo, y nadie puede decir qué significa “hecho”.

Antes de añadir límites de tasa, pruebas de carga o una nueva pila de logging, asegúrate de dos básicos: propiedad y alcance. Transforman un proyecto de ingeniería abierto en un conjunto manejable de compromisos.

Nombra un propietario (end-to-end)

Anota quién posee el sistema de extremo a extremo—no solo el código. El propietario es responsable de disponibilidad, calidad de datos, lanzamientos e impacto en usuarios. Eso no significa que haga todo; significa que toma decisiones, coordina el trabajo y asegura que alguien esté al mando cuando algo falle.

Si la propiedad es compartida, aun así nombra un primario: una persona/equipo que pueda decir “sí/no” y mantener las prioridades consistentes.

Define primero los caminos críticos

Identifica los recorridos de usuario primarios y los caminos críticos. Son los flujos donde la falla crea daño real: signup/login, checkout, enviar un mensaje, importar datos, generar un informe, etc.

Una vez que tienes los caminos críticos, puedes endurecer selectivamente:

- Establece objetivos de fiabilidad alrededor de esos caminos primero.

- Decide qué datos nunca deben perderse.

- Elige las pocas métricas que definen “funciona”.

Define el alcance para evitar un endurecimiento sin fin

Documenta qué está en alcance ahora vs. más adelante para evitar un hardening eterno. La preparación para producción no es “software perfecto”; es “suficientemente seguro para esta audiencia, con límites conocidos.” Sé explícito sobre lo que no soportas aún (regiones, navegadores, tráfico pico, integraciones).

Empieza un esqueleto de runbook

Crea un runbook ligero: cómo desplegar, hacer rollback, depurar. Manténlo corto y usable a las 2 a.m.—una checklist, dashboards clave, modos de fallo comunes y a quién contactar. Puedes evolucionarlo con el tiempo, pero no puedes improvisarlo durante tu primer incidente.

Fiabilidad: haz el sistema predecible bajo carga

La fiabilidad no busca hacer los fallos imposibles—sino hacer el comportamiento predecible cuando algo va mal o hay mucha carga. Los prototipos suelen “funcionar en mi máquina” porque el tráfico es bajo, las entradas son amables y nadie golpea el mismo endpoint al mismo tiempo.

Pon salvaguardas en cada petición

Empieza con defensas aburridas y de alto apalancamiento:

- Validación de entradas en los límites (API, formularios UI, payloads de webhooks). Rechaza datos malos temprano con un mensaje de error claro.

- Timeouts en todas las llamadas a cosas lentas o externas (bases de datos, APIs de terceros, colas). Un timeout ausente convierte un pequeño fallo en un efecto dominó.

- Reintentos, con cuidado: reintenta solo operaciones seguras, usa backoff exponencial + jitter y limita intentos. Reintentos ciegos pueden amplificar las caídas.

- Circuit breakers para dejar de llamar a dependencias que fallan y recuperarse automáticamente cuando se estabilicen.

Cuando el sistema no puede hacer el trabajo completo, debería aún hacer lo más seguro. Eso puede significar servir un valor cacheado, deshabilitar una función no crítica o devolver un “intenta de nuevo” con un ID de petición. Prefiere la degradación gradual a escrituras parciales silenciosas o errores genéricos confusos.

Concurrencia e idempotencia no son opcionales

Bajo carga, ocurren solicitudes duplicadas y trabajos solapados (doble click, reintentos de red, redelivery de colas). Diseña para eso:

- Haz acciones clave idempotentes (la misma petición procesada dos veces produce el mismo resultado).

- Usa locks u optimismo de concurrencia donde haga falta para prevenir condiciones de carrera.

Protege la integridad de los datos

La fiabilidad incluye “no corromper datos.” Usa transacciones para escrituras multi-paso, añade constraints (claves únicas, foreign keys) y practica disciplina en migraciones (cambios compatibles hacia atrás, despliegues probados).

Aplica límites de recursos

Define límites en CPU, memoria, pools de conexión, tamaños de cola y payloads de petición. Sin límites, un tenant ruidoso—o una consulta mala—puede dejar sin recursos al resto.

Seguridad: la barrera mínima antes de usuarios reales

Endurecer seguridad no es convertir tu prototipo en una fortaleza. Es alcanzar un estándar mínimo donde un error normal—un enlace expuesto, un token filtrado, un usuario curioso—no se convierta en un incidente con impacto al cliente.

Empieza con separación: dev, staging, prod

Si tienes “un solo entorno”, tienes un solo radio de impacto. Crea setups separados dev/staging/prod con secretos mínimos compartidos. Staging debe parecerse a producción para revelar problemas, pero no debe reutilizar credenciales ni datos sensibles de producción.

Autenticación y autorización (authn/authz)

Muchos prototipos se quedan en “logueo funciona”. Producción necesita mínimo privilegio:

- Define roles claros (p. ej., admin, soporte, usuario estándar) y aplica límites en el servidor.

- Asegura herramientas internas y endpoints admin.

- Mantén trazas de auditoría para acciones sensibles (login, reset de contraseña, cambios de rol, exportaciones, borrados). No necesitas analítica perfecta—solo lo suficiente para responder “¿quién hizo qué y cuándo?”.

Gestión de secretos: saca claves del código y logs

Mueve API keys, contraseñas de BD y secretos de firma a un gestor de secretos o variables de entorno seguras. Luego asegúrate de que no puedan filtrarse:

- No imprimas tokens en los logs de la aplicación.

- Evita enviar secretos al cliente.

- Rota cualquier credencial alguna vez comprometida en un repo.

Amenazas que vale priorizar temprano

Obtendrás más valor abordando unos pocos modos de fallo comunes:

- Inyección (SQL/comandos): usa queries parametrizadas y librerías seguras.

- Control de acceso roto: verifica permisos en cada petición, no solo en la UI.

- Exposición de datos: encripta en tránsito, limita datos devueltos por defecto y evita exportaciones demasiado amplias.

Plan de parcheo para dependencias

Decide quién es responsable de actualizaciones y con qué frecuencia parcheas dependencias e imágenes base. Un plan simple (chequeo semanal + upgrades mensuales, fixes urgentes en 24–72 horas) vence a “lo haremos más tarde”.

Pruebas: atrapa fallos antes que los clientes

Las pruebas convierten “funciona en mi máquina” en “funciona para los clientes.” La meta no es cobertura perfecta—es confianza en los comportamientos que serían más caros de romper: facturación, integridad de datos, permisos, flujos clave y cualquier cosa difícil de depurar una vez desplegada.

Una pirámide de tests que refleje la realidad

Una pirámide práctica suele verse así:

- Unit tests para lógica pura (rápidos, muchos)

- Integration tests para límites (BD, colas, APIs de terceros detrás de mocks)

- E2E tests para algunos recorridos de usuario críticos (lentos, manténlos mínimos)

Si tu app es mayormente API+BD, apóyate más en tests de integración. Si es UI-heavy, mantén un pequeño conjunto de E2E que reflejen cómo los usuarios triunfan (y fallan).

Tests de regresión donde más duele

Cuando un bug cuesta tiempo, dinero o confianza, añade un test de regresión de inmediato. Prioriza comportamientos como “un cliente no puede completar compra”, “un job cobra doble” o “una actualización corrompe registros”. Así creas una red de seguridad creciente alrededor de las áreas de mayor riesgo en vez de dispersar tests por todas partes.

Tests de integración repetibles con datos seed

Los integration tests deben ser deterministas. Usa fixtures y datos seed para que las ejecuciones no dependan de lo que haya en la BD local de un dev. Resetea el estado entre tests y mantiene los datos pequeños pero representativos.

Pruebas de humo de rendimiento

No necesitas un programa completo de load testing aún, pero deberías tener chequeos rápidos de rendimiento para endpoints clave y jobs en background. Un test de humo basado en umbrales (p. ej., p95 bajo X ms con pequeña concurrencia) detecta regresiones obvias temprano.

Automatiza las comprobaciones en CI

Cada cambio debería ejecutar puertas automáticas:

- linting y formateo

- comprobaciones de tipos (si aplica)

- suite de unit + integración

- escaneos básicos de seguridad (vulnerabilidades de dependencias)

Si las pruebas no se ejecutan automáticamente, son opcionales—y la producción lo demostrará eventualmente.

Observabilidad: saber qué pasa sin adivinar

Cuando un prototipo falla, usualmente puedes “intentar otra vez.” En producción, esa adivinanza se convierte en downtime, churn y noches largas. La observabilidad acorta el tiempo entre “algo se siente mal” y “aquí está exactamente qué cambió, dónde y quién se ve afectado”.

Empieza con logs que respondan preguntas reales

Loguea lo que importa, no todo. Quieres suficiente contexto para reproducir un problema sin volcar datos sensibles.

- Incluye un request ID en cada petición y llévalo por el sistema.

- Añade identificadores de usuario/sesión de forma segura (hashes o IDs internos; nunca contraseñas, datos de pago o secretos en claro).

- Registra resultados: éxito/fallo, códigos de estado y razones de error significativas.

Una buena regla: cada log de error debería dejar claro qué falló y qué revisar a continuación.

Mide las “señales doradas”

Las métricas te dan un pulso en vivo. Como mínimo, monitoriza las señales doradas:

- Latencia (qué tan lento)

- Errores (qué tan roto)

- Tráfico (qué tanto)

- Saturación (qué tan cerca de la capacidad)

Estas métricas ayudan a diferenciar entre “más usuarios” y “algo anda mal”.

Añade tracing cuando las solicitudes cruzan límites

Si una acción de usuario dispara múltiples servicios, colas o llamadas de terceros, el tracing convierte un misterio en una línea de tiempo. Incluso un tracing distribuido básico muestra dónde se gasta el tiempo y qué dependencia falla.

Las alertas deben ser accionables, no ruidosas

El spam de alertas hace que la gente las ignore. Define:

- Qué condiciones merecen paging (impacto visible al usuario)

- Quién está de guardia y tiempos de respuesta esperados

- Cómo se ve “bien” (umbrales vinculados a SLAs/SLOs)

Un tablero que responda las tres grandes

Construye un dashboard simple que responda al instante: ¿Está caído? ¿Está lento? ¿Por qué? Si no puede responder eso, es decoración, no operaciones.

Lanzamientos y operaciones: entregar cambios sin drama

Endurecer no es solo calidad de código—es también cómo CAMBIAS el sistema cuando la gente depende de él. Los prototipos toleran “push a main y confiar”. Producción no. Las prácticas de release y operaciones convierten desplegar en una actividad rutinaria en vez de un evento de alto riesgo.

Estandariza builds y despliegues (CI/CD)

Haz builds y despliegues repetibles, scriptados y aburridos. Un pipeline CI/CD sencillo debería: ejecutar checks, construir el artefacto de la misma manera cada vez, desplegar a un entorno conocido y registrar exactamente qué cambió.

La ganancia es consistencia: puedes reproducir un release, comparar versiones y evitar sorpresas de “funciona en mi máquina”.

Usa feature flags para desplegar con seguridad

Los feature flags separan desplegar (llevar código a producción) de liberar (activarlo para usuarios). Así puedes enviar cambios pequeños con frecuencia, activarlos gradualmente y apagarlos rápido si algo va mal.

Mantén disciplina con flags: nómbralas claramente, asigna propietarios y elimínalas cuando termine el experimento. Los “flags misterio” permanentes se convierten en riesgo operacional.

Define rollback—y prácticalo

Una estrategia de rollback solo es real si la has probado. Decide qué significa “rollback” para tu sistema:

- ¿Re-desplegar la versión anterior?

- ¿Desactivar un feature flag?

- ¿Avanzar con un fix?

- ¿Restaurar datos desde backups (lento, riesgoso, a veces necesario)?

Luego ensaya en un entorno seguro. Cronometra cuánto toma y documenta los pasos exactos. Si el rollback requiere un experto que está de vacaciones, no es una estrategia.

Si usas una plataforma con reversión segura, aprovéchala. Por ejemplo, los snapshots y el workflow de rollback de Koder.ai pueden convertir “detener la hemorragia” en una acción repetible mientras mantienes la iteración rápida.

Versiona APIs y registra cambios en datos

Cuando otros sistemas o clientes dependen de tus interfaces, los cambios necesitan guardarraíles.

Para APIs: introduce versionado (aunque sea /v1) y publica un changelog para que los consumidores sepan qué cambió y cuándo.

Para cambios de datos/esquema: trátalos como releases de primera clase. Prefiere migraciones retrocompatibles (añadir campos antes de eliminar los antiguos) y documenta junto con los releases de la aplicación.

Básicos de capacidad: cuotas, límites de tasa, umbrales de escalado

“Todo funcionó ayer” suele romperse porque el tráfico, jobs por lotes o uso del cliente crecieron.

Establece protección y expectativas básicas:

- Cuotas y rate limits para evitar que un tenant/usuario sature el sistema

- Umbrales de escalado claros (CPU, profundidad de cola, latencia) que disparen acción

- Un plan ligero para cuando alcanzas límites (throttle, shedding o scale)

Bien hecho, la disciplina de releases y operaciones hace que desplegar sea seguro incluso cuando te mueves rápido.

Incidentes: prepárate para el primer mal día

Los incidentes son inevitables cuando usuarios reales dependen del sistema. La diferencia entre “un mal día” y “un día que amenaza el negocio” es haber decidido—antes—quién hace qué, cómo comunicar y cómo aprender.

Una checklist ligera de incidentes

Mantén esto como un doc corto y accesible (pínchalo en Slack, enlázalo en tu README o ponlo en /runbooks). Una checklist práctica suele cubrir:

- Identificar: confirmar impacto, hora de inicio, usuarios afectados y síntomas actuales.

- Mitigar: primero detener la hemorragia (rollback, desactivar flag, escalar, failover).

- Comunicar: un dueño publica actualizaciones con cadencia (p. ej., cada 15–30 minutos) a stakeholders internos y, si hace falta, a clientes.

- Aprender: capturar qué pasó mientras está fresco; programar un postmortem.

Postmortems sin culpa

Escribe postmortems que se enfoquen en arreglos, no culpas. Los buenos postmortems producen seguimientos concretos: alerta faltante → añadir alerta; propiedad poco clara → asignar on-call; deploy riesgoso → añadir un paso canario. Mantén el tono factual y facilita contribuir.

Convierte problemas recurrentes en trabajo de ingeniería

Registra repeticiones explícitamente: el mismo timeout cada semana no es “mala suerte”, es un item de backlog. Mantén una lista de problemas recurrentes y convierte los peores en trabajo planificado con propietarios y fechas límite.

Ten cuidado con SLAs/SLOs

Define SLAs/SLOs solo cuando estés listo para medir y mantenerlos. Si aún no tienes monitorización consistente y alguien responsable de la respuesta, empieza con objetivos internos y alertas básicas; formaliza promesas después.

Una checklist práctica y pasos siguientes

No necesitas endurecer todo a la vez. Necesitas endurecer las partes que pueden dañar usuarios, dinero o reputación—y mantener el resto flexible para seguir aprendiendo.

Debe endurecerse ahora (caminos críticos)

Si alguno de estos está en el viaje del usuario, trátalo como “ruta de producción” y endurece antes de expandir el acceso:

- Auth y permisos: login, resets, comprobaciones de roles, eliminación de cuentas.

- Dinero y compromisos: facturación, reembolsos, cambios de plan, checkout, facturas.

- Integridad de datos: escrituras a registros primarios, idempotencia, migraciones, backups/restore.

- Fiabilidad visible al usuario: timeouts, reintentos, rate limits, degradación gradual.

- Básicos de seguridad: manejo de secretos, mínimo privilegio, validación de entradas, auditoría de acciones sensibles.

- Básicos operacionales: monitorización de SLIs clave (tasa de error, latencia, saturación), alertas que paginen a una persona, runbooks para modos de fallo top.

Puede seguir vibey (por ahora)

Mantén esto ligero mientras buscas product–market fit:

- Herramientas internas usadas por un equipo pequeño y entrenado.

- Experimentos y prototipos desechables detrás de feature flags.

- Pulido de UI que no cambie flujos centrales.

- Automatizaciones no críticas con fallback manual fácil.

Ejecuta un sprint de hardening con límite de tiempo

Prueba 1–2 semanas enfocadas solo en el camino crítico. Los criterios de salida deben ser concretos:

- Los flujos principales tienen tests básicos y una ejecución de pruebas repetible.

- Dashboards + alertas existen para los flujos que importan.

- Rollback o despliegue seguro probado (aunque sea manual).

- Riesgos conocidos están documentados con un propietario y un plan de mitigación.

Puertas simples de go/no-go

- Puerta de lanzamiento (acceso limitado): “Podemos detectar fallos rápido, detener la hemorragia y proteger datos.”

- Puerta de expansión (más usuarios/tráfico): “Podemos manejar aumentos previsibles de carga y recuperarnos de un mal deploy sin heroísmos.”

Una cadencia sostenible

Para evitar alternar entre caos y sobreingeniería, alterna:

- Semanas de experimentación: envía cambios orientados a aprendizaje rápido.

- Semanas de estabilización: paga deuda de fiabilidad/seguridad/pruebas descubierta durante experimentos.

Si quieres una versión de una página de esto, convierte los bullets anteriores en una checklist y revísala en cada lanzamiento o expansión de acceso.