Por qué C sigue importando

C es una de esas tecnologías que la mayoría de la gente nunca toca directamente, pero de las que casi todos dependen. Si usas un teléfono, un portátil, un router, un coche, un reloj inteligente o incluso una cafetera con pantalla, hay muchas posibilidades de que C esté involucrado en alguna parte de la pila: haciendo que el dispositivo arranque, hable con el hardware o funcione lo bastante rápido como para parecer “instantáneo”.

Para los constructores, C sigue siendo una herramienta práctica porque ofrece una combinación rara de control y portabilidad. Puede ejecutarse muy cerca de la máquina (así puedes gestionar memoria y hardware directamente), pero también trasladarse entre diferentes CPUs y sistemas operativos con relativamente poco reescrito. Esa combinación es difícil de reemplazar.

Los tres sitios donde C todavía domina

La mayor huella de C aparece en tres áreas:

- Sistemas operativos: núcleos, bibliotecas centrales, drivers y utilidades de bajo nivel de las que depende todo lo demás.

- Dispositivos embebidos: sistemas pequeños con límites estrictos de memoria, energía y almacenamiento, donde el comportamiento predecible importa.

- Puntos críticos de rendimiento: las partes sensibles al rendimiento de programas más grandes: caminos de código donde unos milisegundos o unos vatios marcan la diferencia.

Incluso cuando una app está escrita en lenguajes de más alto nivel, partes de su base (o sus módulos sensibles al rendimiento) a menudo se remontan a C.

Lo que aprenderás en este artículo

Este texto conecta los puntos entre Dennis Ritchie, los objetivos originales detrás de C y las razones por las que sigue apareciendo en productos modernos. Cubriremos:

- una porción breve y legible de la historia (incluida la influencia de Unix),

- las decisiones de diseño que hacen a C pequeño pero potente,

- dónde encaja C hoy: tanto sus fortalezas como sus retos de seguridad.

Nota de alcance

Esto trata sobre C específicamente, no sobre “todos los lenguajes de bajo nivel”. C++ y Rust pueden aparecer para comparar, pero el foco está en qué es C, por qué se diseñó así y por qué los equipos siguen eligiéndolo para sistemas reales.

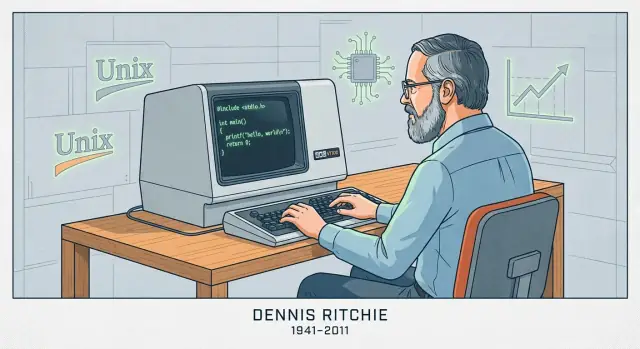

Dennis Ritchie en breve

Dennis Ritchie (1941–2011) fue un informático estadounidense conocido por su trabajo en Bell Labs de AT&T, una organización de investigación que jugó un papel central en la computación y telecomunicaciones tempranas.

Bell Labs, Unix y un nuevo tipo de software de sistema

En Bell Labs, a finales de los 60 y en los 70, Ritchie trabajó con Ken Thompson y otros en investigación de sistemas operativos que condujo a Unix. Thompson creó una versión temprana de Unix; Ritchie se convirtió en un co-creador clave a medida que el sistema evolucionaba hacia algo que podía mantenerse, mejorarse y compartirse ampliamente en la academia y la industria.

Crear C para construir sistemas reales

Ritchie también creó el lenguaje de programación C, basándose en ideas de lenguajes anteriores usados en Bell Labs. C fue diseñado para ser práctico al escribir software de sistema: da a los programadores control directo sobre memoria y representación de datos, y a la vez es más legible y portable que escribirlo todo en ensamblador.

Esa combinación importó porque Unix fue reescrito eventualmente en C. No fue una reescritura por estilo: hizo que Unix fuera mucho más fácil de mover a nuevo hardware y de ampliar con el tiempo. El resultado fue un bucle de retroalimentación potente: Unix proporcionó un caso de uso serio y exigente para C, y C facilitó que Unix se adoptara más allá de una sola máquina.

Por qué el emparejamiento Unix + C se volvió influyente

Juntos, Unix y C ayudaron a definir la “programación de sistemas” tal como la conocemos: construir sistemas operativos, bibliotecas centrales y herramientas en un lenguaje que está cerca de la máquina pero no atado a un procesador. Su influencia aparece en sistemas operativos posteriores, herramientas de desarrollo y en las convenciones que muchos ingenieros aún aprenden hoy, menos por mitología y más porque el enfoque funcionó a escala.

Cómo se diseñó C: pequeño, portable, cerca de la máquina

Los sistemas operativos tempranos se escribían mayormente en ensamblador. Eso daba a los ingenieros control total sobre el hardware, pero también significaba que cada cambio era lento, propenso a errores y fuertemente ligado a un procesador específico. Incluso características pequeñas podían requerir páginas de código de bajo nivel, y mover el sistema a una máquina distinta a menudo implicaba reescribir grandes porciones desde cero.

De BCPL a B a C (versión corta)

Dennis Ritchie no inventó C en el vacío. Creció a partir de lenguajes de sistemas anteriores usados en Bell Labs.

- BCPL ofrecía un estilo compacto para escribir herramientas y software de sistema.

- B (creado por Ken Thompson) adaptó ideas de BCPL para el trabajo temprano en Unix, pero carecía de los tipos de datos y la estructura necesarios para sistemas mayores y más exigentes.

- C mantuvo el espíritu de “lenguaje pequeño”, añadiendo las características que hicieron práctico construir y mantener Unix en hardware real.

El objetivo de diseño: una capa delgada sobre la máquina

C se construyó para mapear de forma limpia a lo que las computadoras realmente hacen: bytes en memoria, aritmética en registros y saltos en el código. Por eso los tipos de datos simples, el acceso explícito a memoria y operadores que coinciden con instrucciones de CPU son centrales en el lenguaje. Puedes escribir código suficientemente de alto nivel para manejar una gran base de código, pero lo bastante directo para controlar el layout en memoria y el rendimiento.

Qué significa “portable” en términos sencillos

“Portable” significa que puedes mover la misma fuente C a otra computadora y, con cambios mínimos, compilarla allí y obtener el mismo comportamiento. En lugar de reescribir el sistema operativo para cada procesador nuevo, los equipos podían mantener la mayor parte del código y solo cambiar las pequeñas partes dependientes del hardware. Esa mezcla —código mayormente compartido y bordes dependientes de la máquina reducidos— fue el avance que ayudó a que Unix se difundiera.

Las ideas centrales que hacen a C rápido

La velocidad de C no es magia: es principalmente resultado de cómo se mapea directamente a lo que la máquina hace y de cuánto “trabajo extra” se inserta entre tu código y la CPU.

Qué produce la compilación

C se suele compilar. Eso significa que escribes código fuente legible y luego un compilador lo traduce a código de máquina: las instrucciones crudas que ejecuta tu procesador.

En la práctica, un compilador produce un ejecutable (o archivos objeto que luego se enlazan en uno). El punto clave es que el resultado final no se interpreta línea por línea en tiempo de ejecución: ya está en la forma que el CPU entiende, lo que reduce overhead.

Control predecible, bajo overhead

C te da bloques de construcción simples: funciones, bucles, enteros, arreglos y punteros. Como el lenguaje es pequeño y explícito, el compilador a menudo puede generar código de máquina directo.

Normalmente no hay un runtime obligatorio que haga trabajo en segundo plano como rastrear cada objeto, insertar comprobaciones ocultas o gestionar metadatos complejos. Cuando escribes un bucle, generalmente obtienes un bucle. Cuando accedes a un elemento de un arreglo, generalmente obtienes un acceso directo a memoria. Esta previsibilidad es una gran parte de por qué C rinde bien en partes del software sensibles al rendimiento.

Gestión manual de memoria: control con consecuencias

C usa gestión manual de memoria, lo que significa que tu programa solicita memoria explícitamente (por ejemplo, con malloc) y la libera explícitamente (con free). Esto existe porque el software a nivel de sistemas a menudo necesita un control fino sobre cuándo se asigna memoria, cuánta y por cuánto tiempo, con un overhead oculto mínimo.

La compensación es directa: más control puede significar más velocidad y eficiencia, pero también más responsabilidad. Si olvidas liberar memoria, la liberas dos veces o usas memoria después de liberarla, los errores pueden ser severos y, a veces, críticos para la seguridad.

C en sistemas operativos: núcleos, drivers y bibliotecas centrales

Los sistemas operativos están en el límite entre software y hardware. El núcleo tiene que gestionar memoria, planificar la CPU, manejar interrupciones, hablar con dispositivos y proporcionar llamadas al sistema en las que todo lo demás confía. Esas tareas no son abstractas: tratan de leer y escribir ubicaciones de memoria específicas, trabajar con registros de CPU y reaccionar a eventos que llegan en momentos inconvenientes.

Por qué los núcleos y drivers necesitan acceso de bajo nivel

Los controladores de dispositivos y los núcleos necesitan un lenguaje que pueda expresar “haz exactamente esto” sin trabajo oculto. En la práctica eso significa:

- Control preciso del layout de memoria (estructuras que coinciden con formatos definidos por hardware)

- Manipulación directa de punteros al mapear memoria de dispositivos o construir tablas de páginas

- Capacidad de interactuar con interrupciones y primitivas de concurrencia

- Convenciones de llamada predecibles y requisitos de runtime mínimos

C encaja bien porque su modelo central está cerca de la máquina: bytes, direcciones y flujo de control simple. No hay un runtime obligatorio, recolector de basura o sistema de objetos que el kernel tenga que hospedar antes de poder arrancar.

C como elección por defecto para núcleos y bibliotecas centrales

Unix y los trabajos tempranos popularizaron el enfoque que Ritchie ayudó a moldear: implementar gran parte del SO en un lenguaje portable, pero mantener delgada la “barrera de hardware”. Muchos núcleos modernos siguen ese patrón. Incluso cuando se requiere ensamblador (código de arranque, cambios de contexto), C suele llevar la mayor parte de la implementación.

C también domina las bibliotecas centrales del sistema: componentes como las bibliotecas estándar de C, código fundamental de red y piezas de runtime de bajo nivel de las que dependen lenguajes de más alto nivel. Si has usado Linux, BSD, macOS, Windows o un RTOS, casi con seguridad has dependido de código en C aunque no lo supieras.

Por qué los equipos siguen confiando en C aquí

El atractivo de C en trabajo de SO no es nostalgia sino economía de ingeniería:

- Toolchains estables: compiladores, enlazadores, depuradores y perfiles maduros y bien entendidos

- Portabilidad: la misma base de código en C puede llevarse a nuevas CPUs y placas con esfuerzo manejable

- Modelo mental de hardware claro: es más fácil razonar sobre lo que el compilador generará y cómo se comportará el código bajo restricciones estrictas

Otros lenguajes existen—pero C sigue siendo la referencia

Rust, C++ y otros lenguajes se usan en partes de sistemas operativos y pueden aportar ventajas reales. Aun así, C sigue siendo el denominador común: el lenguaje en el que muchos núcleos están escritos, el que la mayoría de interfaces de bajo nivel asumen y la referencia con la que deben interoperar otros lenguajes de sistemas.

C en dispositivos embebidos: huella pequeña, control predecible

Itera sin miedo

Usa instantáneas y reversiones para probar cambios de forma segura mientras iteras.

“Embebido” suele significar computadoras que no consideras computadoras: microcontroladores dentro de termostatos, altavoces inteligentes, routers, coches, dispositivos médicos, sensores de fábrica y un sinfín de electrodomésticos. Estos sistemas a menudo ejecutan una sola función durante años, discretamente, con límites estrictos de coste, energía y memoria.

Las restricciones con las que viven los equipos embebidos

Muchos objetivos embebidos disponen de kilobytes (no gigabytes) de RAM y almacenamiento flash limitado para código. Algunos funcionan con baterías y deben dormir la mayor parte del tiempo. Otros tienen plazos de tiempo real: si un bucle de control de motor llega tarde por unos milisegundos, el hardware puede comportarse mal.

Esas restricciones moldean cada decisión: cuánto ocupa el programa, con qué frecuencia despierta y si su temporización es predecible.

Por qué C encaja tan bien

C tiende a producir binarios pequeños con overhead mínimo de runtime. No hay una máquina virtual requerida y a menudo puedes evitar la asignación dinámica por completo. Esto importa cuando intentas ajustar un firmware a un tamaño fijo de flash o garantizar que el dispositivo no “se pause” inesperadamente.

Igualmente importante, C facilita hablar con el hardware. Los chips embebidos exponen periféricos —pines GPIO, temporizadores, buses UART/SPI/I2C— mediante registros mapeados en memoria. El modelo de C se mapea de forma natural a esto: puedes leer y escribir direcciones específicas, controlar bits individuales y hacerlo con poca abstracción que interfiera.

Patrones comunes en proyectos reales

Mucho del C embebido es o bien:

- Bare-metal: sin sistema operativo, solo código de arranque, un bucle principal y manejadores de interrupción.

- Basado en RTOS: un pequeño sistema operativo en tiempo real donde tareas en C se coordinan con colas, semáforos y temporizadores.

En ambos casos verás código construido alrededor de registros de hardware (a menudo marcados volatile), búferes de tamaño fijo y temporización cuidadosa. Ese estilo “cerca de la máquina” es exactamente por qué C sigue siendo la opción por defecto para firmware que debe ser pequeño, eficiente en energía y fiable bajo plazos.

C en software crítico para el rendimiento: donde la velocidad compensa

“Crítico para el rendimiento” es cualquier situación donde el tiempo y los recursos forman parte del producto: milisegundos afectan la experiencia del usuario, ciclos de CPU afectan el coste de servidores y el uso de memoria decide si un programa cabe o no. En esos sitios, C sigue siendo una opción por defecto porque permite a los equipos controlar cómo se dispone la información en memoria, cómo se programa el trabajo y qué puede optimizar el compilador.

Dónde importa la velocidad de C en el mundo real

Suele encontrarse C en el núcleo de sistemas donde el trabajo ocurre en gran volumen o con presupuestos de latencia apretados:

- Bases de datos y motores de almacenamiento (indexado, cachés, compresión, ejecución de consultas)

- Codecs de audio/video y procesamiento de imágenes (bucles de codificación/decodificación que se ejecutan miles de millones de veces)

- Redes (procesamiento de paquetes, proxies, primitivas TLS, bucles de eventos)

- Motores de juego (presupuestos de frame, física, streaming de activos)

- Piezas HPC (núcleos numéricos, rutinas vectorizadas, allocadores de memoria personalizados)

Estos dominios no son “rápidos” en todas partes. Normalmente tienen bucles internos específicos que dominan el tiempo de ejecución.

El “camino caliente”: optimiza el 5% que cuesta el 95%

Los equipos rara vez reescriben un producto entero en C sólo para hacerlo más rápido. En su lugar perfilan, encuentran el camino caliente (la porción pequeña de código donde se gasta la mayor parte del tiempo) y lo optimizan.

C ayuda porque los caminos calientes suelen estar limitados por detalles de bajo nivel: patrones de acceso a memoria, comportamiento de caché, predicción de ramas y overhead de asignación. Cuando puedes afinar estructuras de datos, evitar copias innecesarias y controlar la asignación, las mejoras pueden ser drásticas sin tocar el resto de la aplicación.

Trabajar con lenguajes de más alto nivel: extensiones y FFI

Los productos modernos suelen ser “multilenguaje”: Python, Java, JavaScript o Rust para la mayor parte, y C para el núcleo crítico. Enfoques de integración comunes incluyen:

- Extensiones nativas (p. ej., extensiones C para Python, addons Node-API)

- FFI (Foreign Function Interface) donde un lenguaje invoca funciones C compiladas mediante un ABI estable

- Librerías C como dependencias compartidas usadas por muchos runtimes (una implementación rápida, muchos llamantes)

Este modelo mantiene el desarrollo práctico: iteración rápida en un lenguaje de alto nivel y rendimiento predecible donde importa. La contrapartida es el cuidado en las fronteras: conversiones de datos, reglas de propiedad y manejo de errores, porque cruzar la línea FFI debe ser eficiente y seguro.

Portabilidad y estándares: qué hace que C viaje bien

Despliega un prototipo hoy

Aloja tu nueva app y despliega actualizaciones sin reconstruir todo tu flujo.

Una razón por la que C se difundió rápidamente es que viaja: el mismo núcleo del lenguaje puede implementarse en máquinas muy distintas, desde microcontroladores hasta supercomputadores. Esa portabilidad no es mágica: es resultado de estándares compartidos y de una cultura de programar conforme a ellos.

Cómo los estándares hicieron que “C” signifique lo mismo en todas partes

Las primeras implementaciones de C variaban por proveedor, lo que dificultaba compartir código. El gran cambio vino con ANSI C (a menudo llamado C89/C90) y después ISO C (revisiones posteriores como C99, C11, C17 y C23). No hace falta memorizar números de versión; el punto importante es que un estándar es un acuerdo público sobre qué hace el lenguaje y la biblioteca estándar.

Qué te da realmente un estándar de C

Un estándar proporciona:

- Reglas consistentes para el lenguaje (tipos, operadores, control de flujo)

- Una biblioteca estándar con comportamiento predecible (I/O, cadenas, matemáticas, asignación de memoria)

- Una base que los autores de compiladores pueden implementar y en la que los equipos pueden confiar

Por eso el código escrito con la norma en mente puede moverse entre compiladores y plataformas con sorprendentemente pocos cambios.

Dónde falla la portabilidad en la práctica

Los problemas de portabilidad suelen venir de depender de cosas que el estándar no garantiza, incluyendo:

- Comportamiento indefinido: código que el compilador puede manejar de cualquier forma (incluido “parece bien” hasta que una compilación rompe). Ejemplos clásicos: leer fuera de los límites de un arreglo o usar un valor no inicializado.

- Suposiciones sobre tamaños:

int no está garantizado que sea de 32 bits y los tamaños de puntero varían. Si un programa asume tamaños exactos, puede fallar al cambiar de objetivo.

- APIs específicas de plataforma: llamar a funciones del SO puede ser necesario, pero limita dónde puede ejecutarse el código.

Consejo práctico: escribe “estándar primero” y luego ajusta

Un buen valor por defecto es preferir la biblioteca estándar y mantener el código no portable detrás de pequeños envoltorios claramente nombrados.

Además, compila con flags que te empujen hacia un C portátil y bien definido. Opciones comunes incluyen:

- Seleccionar el modo estándar (por ejemplo:

-std=c11)

- Activar advertencias (

-Wall -Wextra) y tomarlas en serio

Esa combinación —código centrado en el estándar más builds estrictos— hace más por la portabilidad que cualquier truco “ingenioso”.

La parte difícil: punteros, memoria y clases comunes de bugs

El poder de C es también su filo: te deja trabajar cercano a la memoria. Eso es una gran razón por la que C es rápido y flexible, y también por la que principiantes (y expertos cansados) pueden cometer errores que otros lenguajes previenen.

Punteros, explicado con “direcciones a buzones”

Imagina la memoria de tu programa como una calle larga de buzones numerados. Una variable es un buzón que contiene algo (como un entero). Un puntero no es la cosa: es la dirección escrita en un papelito que te dice qué buzón abrir.

Eso es útil: puedes pasar la dirección en lugar de copiar lo que hay dentro del buzón, y puedes apuntar a arreglos, búferes, structs o incluso funciones. Pero si la dirección es incorrecta, abres el buzón equivocado.

Riesgos comunes que oirás mencionar

- Desbordamientos de búfer: escribir más allá del final de un búfer (como meter cartas extra en el buzón #10 y derramarlas en el #11). Esto puede hacer que el programa falle o ser explotado.

- Uso tras liberar (use-after-free): liberar un bloque de memoria y luego usar un puntero que aún “recuerda” su antigua dirección, aunque ese buzón haya sido reasignado.

- Desbordamientos enteros: aritmética que envuelve (p. ej., un cálculo de tamaño se hace más pequeño de lo esperado), lo que puede llevar a asignar menos memoria y luego desbordar un búfer.

Por qué importan estos bugs

Estos problemas aparecen como crashes, corrupción silenciosa de datos y vulnerabilidades de seguridad. En código de sistemas —donde se usa mucho C— esas fallas pueden afectar todo lo que se ejecuta encima.

Una visión equilibrada

C no es “inseguro por defecto”. Es permisivo: el compilador asume que quieres lo que escribes. Eso es genial para rendimiento y control de bajo nivel, pero también significa que C es fácil de usar mal a menos que lo acompañes con hábitos cuidadosos, revisiones y buen tooling.

Hacer C más seguro en la práctica

C te da control directo, pero rara vez perdona errores. La buena noticia es que “C seguro” tiene menos que ver con trucos mágicos y más con hábitos disciplinados, APIs claras y dejar que las herramientas hagan las comprobaciones tediosas.

Técnicas defensivas que escalan

Empieza diseñando APIs que dificulten el uso incorrecto. Prefiere funciones que reciban tamaños de búfer junto a punteros, devuelvan códigos de estado explícitos y documenten quién posee la memoria asignada.

La comprobación de límites debería ser rutinaria, no excepcional. Si una función escribe en un búfer, debe validar longitudes por adelantado y fallar rápido. Para la propiedad de memoria, mantenlo simple: un asignador y una ruta correspondiente de liberación, y una regla clara sobre si el llamante o el llamado libera recursos.

Herramientas: atrapa bugs antes que los usuarios los vean

Los compiladores modernos pueden advertir sobre patrones riesgosos: trata las advertencias como errores en CI. Añade comprobaciones en tiempo de ejecución durante el desarrollo con sanitizadores (address, undefined behavior, leak) para descubrir escrituras fuera de límites, use-after-free, desbordamientos enteros y otros peligros específicos de C.

El análisis estático y los linters ayudan a encontrar problemas que no aparezcan en pruebas. El fuzzing es especialmente eficaz para parsers y manejadores de protocolos: genera entradas inesperadas que a menudo revelan búferes y errores en máquinas de estado.

Prácticas de revisión y pruebas

La revisión de código debe buscar explícitamente modos de fallo comunes en C: índices off-by-one, terminadores NUL faltantes, mezclas signed/unsigned, valores de retorno no comprobados y caminos de error que filtran memoria.

Las pruebas importan más cuando el lenguaje no te protegerá. Las pruebas unitarias son buenas; las de integración son mejores; y las pruebas de regresión para bugs ya encontrados son las mejores.

Subconjuntos más seguros y guías

Si tu proyecto tiene necesidades estrictas de fiabilidad o seguridad, considera adoptar un “subconjunto” restringido de C y un conjunto escrito de reglas (por ejemplo, limitar aritmética de punteros, prohibir ciertas llamadas de biblioteca o requerir envoltorios). La clave es la consistencia: elige directrices que tu equipo pueda aplicar con herramientas y revisiones, no ideales que queden solo en una diapositiva.

C vs otros lenguajes: por qué los equipos aún lo eligen

Crea una app compañera para el dispositivo

Crea una app en Flutter para diagnóstico, comprobación de estado y soporte en campo.

C se sitúa en una intersección inusual: es lo bastante pequeño como para entenderlo de punta a punta, y lo bastante cercano al hardware y a los límites del SO para ser el “pegamento” de lo que depende todo lo demás. Esa combinación hace que los equipos lo usen a menudo, aun cuando lenguajes más nuevos parezcan mejores en el papel.

C vs C++: objetivos distintos, compatibilidad compleja, mezcla práctica

C++ se construyó para añadir mecanismos de abstracción más fuertes (clases, plantillas, RAII) manteniendo mucha compatibilidad de fuente con C. Pero “compatible” no es “idéntico”. C++ tiene reglas diferentes para conversiones implícitas, resolución de sobrecargas e incluso qué cuenta como declaración válida en casos límite.

En productos reales es común mezclarlos:

- Módulos de bajo nivel permanecen en C para ABIs estables y convenciones de llamada sencillas.

- Capas superiores usan C++ para estructura y gestión más segura de recursos.

El puente suele ser una API C. El código C++ exporta funciones con extern "C" para evitar name mangling, y ambas partes acuerdan estructuras de datos planas. Esto permite modernizar de forma incremental sin reescribirlo todo.

C vs Rust (a alto nivel): la seguridad gana, pero hay restricciones

La gran promesa de Rust es seguridad de memoria sin recogedor de basura, respaldada por tooling fuerte y un ecosistema de paquetes. En muchos proyectos nuevos de sistemas puede reducir clases enteras de bugs (use-after-free, condiciones de carrera).

Pero adoptar Rust no es gratis. Los equipos pueden verse limitados por:

- Librerías C existentes, drivers o SDKs de proveedores

- Compiladores y depuradores validados para objetivos específicos

- Regímenes de certificación donde la madurez de las herramientas y la evidencia son importantes

- Ingenieros que deben mantener el código durante décadas

Rust puede interoperar con C, pero la frontera añade complejidad y no todos los objetivos embebidos o entornos de build están igualmente soportados.

Mucho del código fundacional del mundo está en C y reescribirlo es arriesgado y caro. C también encaja en entornos donde necesitas binarios predecibles, suposiciones mínimas de runtime y amplia disponibilidad de compiladores: desde microcontroladores hasta CPUs convencionales.

Elige según restricciones, no según modas

Si necesitas máximo alcance, interfaces estables y toolchains probados, C sigue siendo una elección racional. Si tus restricciones lo permiten y la seguridad es la prioridad, un lenguaje más nuevo puede merecer la pena. La mejor decisión suele comenzar con el hardware objetivo, las herramientas y el plan de mantenimiento a largo plazo, no con lo que está de moda este año.

Cómo será el futuro (y cómo aprender C hoy)

C no va a “desaparecer”, pero su centro de gravedad se hace más claro. Seguirá prosperando donde el control directo sobre memoria, tiempo y binarios importa, y perderá terreno donde la seguridad y la velocidad de iteración pesen más que exprimir el último microsegundo.

Dónde C sigue fuerte

C probablemente seguirá siendo la elección por defecto para:

- Núcleos y trabajo de SO de bajo nivel (planificadores, gestores de memoria, sistemas de archivos), donde necesitas rendimiento predecible y suposiciones mínimas de runtime.

- Drivers y código cercano al hardware, donde mapeas registros, manejas interrupciones y trabajas con restricciones estrictas.

- Sistemas embebidos con presupuestos de RAM/flash y requisitos de tiempo real.

- Bibliotecas y runtimes centrales (compresión, primitivas criptográficas, VMs de lenguajes, codecs multimedia), donde ABIs estables y amplia portabilidad son valiosos.

Estas áreas evolucionan despacio, tienen enormes bases de código heredadas y recompensan a ingenieros que pueden razonar sobre bytes, convenciones de llamada y modos de fallo.

Dónde C puede disminuir (y por qué)

Para desarrollo de nuevas aplicaciones, muchos equipos prefieren lenguajes con garantías de seguridad más fuertes y ecosistemas más ricos. Los bugs de seguridad por memoria (use-after-free, desbordamientos) son caros, y los productos modernos suelen priorizar entrega rápida, concurrencia y valores por defecto seguros. Incluso en programación de sistemas, algunos componentes nuevos se están moviendo a lenguajes más seguros, mientras C permanece como la “capa base” con la que siguen interactuando.

Nota moderna de flujo de trabajo: C en el producto más amplio

Incluso cuando el núcleo de bajo nivel es C, los equipos suelen necesitar software periférico: un panel web, un servicio API, un portal de gestión de dispositivos, herramientas internas o una pequeña app móvil para diagnóstico. Esa capa superior suele ser donde la velocidad de iteración importa más.

Si quieres avanzar rápido en esas capas sin rehacer toda la tubería, Koder.ai puede ayudar: es una plataforma de "vibe-coding" donde puedes crear apps web (React), backends (Go + PostgreSQL) y apps móviles (Flutter) mediante chat—útil para montar un panel de administración, un visor de logs o un servicio de gestión de flotas que se integre con un sistema basado en C. El modo de planificación y la exportación de código hacen práctico prototipar y luego llevar la base de código donde necesites.

Cómo aprender C hoy (camino práctico)

Empieza por lo fundamental, pero apréndelo como lo usan los profesionales en C:

- Sintaxis + modelo de datos: enteros, arreglos, structs, conceptos básicos de punteros y cómo se mapean a memoria.

- Herramientas de construcción: compilación y enlace, organización de headers y un Makefile simple (luego, CMake).

- Depuración: recorrer el código con gdb/lldb; aprender a leer backtraces.

- Hábitos de seguridad: compilar con advertencias, usar AddressSanitizer/UBSan y escribir pruebas pequeñas.

Si quieres más artículos y rutas de aprendizaje sobre sistemas, consulta /blog.