26 sept 2025·8 min

Crear una app web para detectar caídas de uso y riesgo de churn

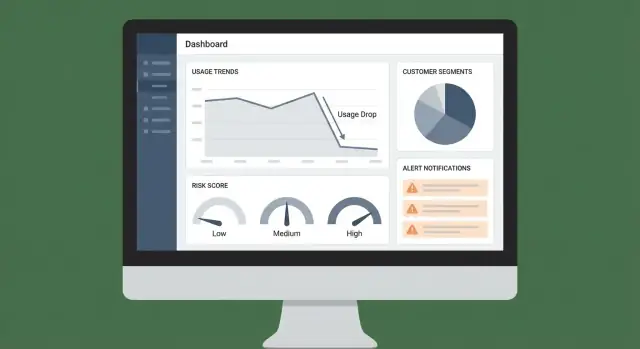

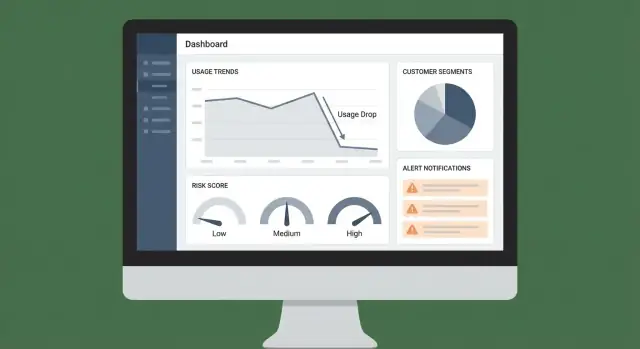

Aprende a construir una app web que detecta caídas de uso de clientes, marca señales de riesgo de churn y dispara alertas, paneles y flujos de seguimiento.

Aprende a construir una app web que detecta caídas de uso de clientes, marca señales de riesgo de churn y dispara alertas, paneles y flujos de seguimiento.

Este proyecto es una app web que te ayuda a detectar caídas significativas en el uso de clientes con antelación—antes de que se conviertan en churn. En lugar de esperar a una conversación de renovación para descubrir un problema, la app muestra una señal clara (qué cambió, cuándo y cuánto) y dirige al equipo adecuado para responder.

Los descensos de uso suelen aparecer semanas antes de una solicitud de cancelación. Tu app debe hacer esas caídas visibles, explicables y accionables. El objetivo práctico es simple: reducir el churn detectando el riesgo antes y respondiendo de forma consistente.

Diferentes equipos buscan distintas “verdades” en los mismos datos. Diseñar pensando en estos usuarios evita que la app se convierta en otro panel más.

Como mínimo, la app debería producir:

Esta es la diferencia entre “datos disponibles en algún lugar” y “un flujo de trabajo que la gente realmente sigue”.

Define el éxito como un producto: con métricas.

Si la app mejora las decisiones y acelera la acción, obtendrá adopción—y se pagará sola.

Antes de detectar una “caída de uso”, necesitas una definición precisa de uso y una unidad de medida consistente. Esto no es tanto jerga analítica como evitar falsas alarmas (o perder riesgo real de churn).

Elige una métrica primaria de uso que refleje valor real entregado. Buenos candidatos dependen de tu producto:

Apunta a una métrica que sea difícil de “manipular” y esté estrechamente ligada a la intención de renovar. Puedes rastrear múltiples métricas más adelante, pero empieza con una que puedas explicar en una frase.

Define la entidad que puntuarás y sobre la que alertarás:

Esta elección afecta todo: agregación, paneles, propiedad y enrutamiento de alertas al equipo correcto.

Fija umbrales que coincidan con el comportamiento del cliente:

También decide tu ventana temporal (diaria vs. semanal) y cuánto retraso de reporte toleras (p. ej., “alertas antes de las 9am del día siguiente” vs. tiempo real). Definiciones claras previenen fatiga de alertas y hacen las puntuaciones confiables.

Tu app es tan confiable como las entradas que supervisa. Antes de construir paneles o puntuar riesgos, decide qué sistemas definen “uso”, “valor” y “contexto del cliente” para tu negocio.

Empieza con un conjunto cerrado de fuentes que puedas mantener precisas:

Si dudas, prioriza eventos de producto + facturación primero; puedes añadir CRM/soporte cuando el monitoreo central funcione.

Hay tres métodos comunes de ingestión, y muchos equipos usan una mezcla:

Ajusta la cadencia a las decisiones que automatizarás. Si planeas alertar CSMs dentro de una hora tras una caída súbita, la ingestión de eventos no puede ser “una vez al día”.

Las caídas de uso se detectan por unidad de cliente (cuenta/tenant). Define y persiste los mappings temprano:

Crea una sola tabla/servicio de mapeo de identidad para que cada integración resuelva a la misma cuenta.

Anota quién posee cada conjunto de datos, cómo se actualiza y quién puede verlo. Esto evita lanzamientos bloqueados más tarde cuando añades campos sensibles (detalles de facturación, notas de soporte) o necesitas explicar métricas a stakeholders.

Un buen modelo de datos mantiene la app rápida, explicable y fácil de extender. No solo estás almacenando eventos—estás guardando decisiones, evidencias y un rastro de lo que pasó.

Empieza con unas pocas tablas estables que todo lo demás referencie:

Mantén IDs consistentes entre sistemas (CRM, facturación, producto) para poder unir datos sin conjeturas.

Consultar eventos crudos para cada vista de panel sale caro rápidamente. En su lugar, pre-computa snapshots como:

Esta estructura soporta tanto vistas de salud de alto nivel como investigación a nivel de característica (“el uso cayó—¿dónde exactamente?”).

Trata la detección de riesgo como un producto independiente. Crea una tabla risk_signals con:

usage_drop_30d, no_admin_activity)Esto mantiene el scoring transparente: puedes mostrar por qué la app marcó una cuenta.

Añade tablas append-only:

Con el historial puedes responder: “¿Cuándo subió el riesgo?”, “¿Qué alertas fueron ignoradas?” y “¿Qué playbooks realmente redujeron churn?”.

Tu app no puede detectar caídas si los eventos subyacentes son inconsistentes o incompletos. Esta sección trata de hacer los datos de eventos lo suficientemente fiables para alimentar paneles, alertas y señales de riesgo.

Empieza con una lista corta de comportamientos que representen valor:

Manténlo práctico: si un evento no alimentará una métrica, una alerta o un flujo de trabajo, no lo rastrees todavía.

La consistencia supera a la creatividad. Usa un esquema compartido para cada evento:

report_exported)Documenta las propiedades requeridas por evento en una spec ligera de tracking que el equipo pueda revisar en pull requests.

El tracking del lado del cliente es útil, pero puede bloquearse, perderse o duplicarse. Para eventos de alto valor (cambios de facturación, exportaciones exitosas, workflows completados), emite eventos desde el backend después de confirmar la acción.

Trata los problemas de datos como bugs de producto. Agrega checks y alertas para:

Un pequeño dashboard de calidad de datos más un informe diario al equipo evitarán fallos silenciosos que minen la detección de riesgo de churn.

Una buena puntuación de salud se preocupa menos por “predecir churn perfectamente” y más por ayudar a humanos a decidir el siguiente paso. Empieza simple, hazla explicable y evoluciona según aprendas qué señales se correlacionan realmente con la retención.

Empieza con un conjunto pequeño de reglas claras que cualquiera en CS, Ventas o Soporte pueda entender y depurar.

Por ejemplo: “Si el uso activo semanal cae un 40% vs el promedio de las 4 semanas previas, suma puntos de riesgo.” Este enfoque hace los desacuerdos productivos porque puedes señalar la regla exacta y el umbral.

Cuando las reglas básicas funcionen, combina múltiples señales con pesos. Entradas comunes incluyen:

Los pesos deben reflejar impacto de negocio y confianza. Un fallo de pago puede tener más peso que una ligera caída de uso.

Trata los indicadores líderes (cambio reciente) diferente de los rezagados (riesgo de movimiento lento):

Esto ayuda a la app a responder tanto “¿Qué cambió esta semana?” como “¿Quién está estructuralmente en riesgo?”.

Convierte la puntuación numérica en bandas con definiciones en lenguaje claro:

Vincula cada banda a un siguiente paso por defecto (propietario, SLA y playbook), de modo que la puntuación impulse un seguimiento consistente en lugar de solo una insignia roja en un panel.

La detección de anomalías solo es útil si refleja cómo los clientes realmente usan tu producto. El objetivo no es marcar cualquier fluctuación—es capturar cambios que predigan churn y merezcan seguimiento humano.

Usa más de un baseline para no sobreactuar:

Estos baselines ayudan a separar “normal para ellos” de “algo cambió”.

Trata estos casos de forma distinta porque las soluciones difieren:

Tu web app debería etiquetar el patrón, pues los playbooks y propietarios serán distintos.

Las falsas alarmas destruyen confianza rápido. Añade salvaguardas:

Cada señal de riesgo debe traer evidencia: “por qué se marcó” y “qué cambió”. Adjunta:

Esto convierte las alertas en decisiones, no en ruido.

Una buena UI convierte telemetría desordenada en un flujo de trabajo diario: “Quién necesita atención, por qué y qué hacemos después”. Mantén las primeras pantallas con opinión y rápidas—la mayoría de equipos vivirá en ellas.

Tu panel debe responder tres preguntas de un vistazo:

Haz cada fila clicable hacia la vista de cuenta. Prefiere patrones de tabla familiares: columnas ordenables, columnas de riesgo fijadas y un timestamp claro de última vez vista.

Diseña la vista de cuenta alrededor de una línea temporal para que un CSM entienda el contexto en segundos:

Incluye un patrón de deep link interno como /accounts/{id} para que las alertas lleven a la vista exacta.

El filtrado es donde los paneles se vuelven accionables. Proporciona filtros globales por plan, segmento, industria, dueño CSM, región y etapa del ciclo de vida, y persiste las selecciones en la URL para vistas compartibles.

Para exportación, permite descarga CSV desde tablas (respetando filtros) y añade “Copiar enlace” para handoffs internos—especialmente desde la lista de cuentas en riesgo y el feed de alertas.

Las alertas solo son útiles si llegan a la persona correcta en el momento correcto—y no enseñan a todos a ignorarlas. Trata las notificaciones como parte de tu producto, no como un añadido.

Empieza con un conjunto pequeño de triggers que mapeen a acciones claras:

Usa reglas simples primero y luego introduce lógica más inteligente (detección de anomalías) cuando confíes en lo básico.

Escoge un canal primario y uno secundario:

Si dudas, empieza con Slack + notificaciones in-app. El email puede volverse ruidoso rápido.

Enruta alertas según propiedad de cuenta y segmento:

Deduplica agrupando alertas repetidas en un único hilo o ticket (por ejemplo, “la caída persiste 3 días”). Añade ventanas de cooldown para no enviar la misma alerta cada hora.

Toda alerta debe responder: qué cambió, por qué importa, qué hacer después. Incluye:

/accounts/{account_id}Cuando las alertas llevan directo a una acción clara, el equipo confiará en ellas—y las usará.

Detectar solo sirve si desencadena de forma fiable la siguiente mejor acción. Automatizar los flujos de seguimiento convierte “vimos una caída” en una respuesta consistente y rastreable que mejora la retención con el tiempo.

Comienza mapeando cada señal a un playbook sencillo. Mantén los playbooks con opinión y ligeros para que los equipos los usen.

Ejemplos:

Almacena playbooks como plantillas: pasos, mensajes recomendados, campos requeridos (p. ej., “causa raíz”) y criterios de salida (p. ej., “uso de vuelta al baseline por 7 días”).

Cuando una señal se dispare, crea automáticamente una tarea con:

Añade un paquete de contexto corto a cada tarea: qué métrica cambió, cuándo empezó, último periodo conocido saludable y eventos de producto recientes. Esto reduce idas y venidas y acelera el primer contacto.

No obligues a todos a usar una nueva pestaña para ejecutar. Empuja tareas y notas a sistemas existentes, y trae resultados de vuelta a tu app.

Destinos comunes incluyen CRM y tooling de soporte (ver /integrations/crm). Mantén el flujo bidireccional: si una tarea se completa en el CRM, refléjalo en el panel de salud.

La automatización debe mejorar la calidad de la respuesta, no solo el volumen. Rastrea:

Revisa estas métricas mensualmente para afinar playbooks, ajustar reglas de enrutamiento e identificar qué acciones realmente se correlacionan con recuperación de uso.

Si quieres pasar de spec a una herramienta interna funcionando rápido, una plataforma vibe-coding como Koder.ai puede ayudar a prototipar el panel, las vistas de cuenta y el flujo de alertas vía chat—luego iterar el comportamiento real del producto con menos overhead. Porque Koder.ai puede generar apps full-stack (React en web, servicios Go con PostgreSQL) y soporta snapshots/rollback además de exportación de código, es una forma práctica de validar tu modelo de datos, reglas de enrutamiento y flujo de UI antes de invertir en un ciclo de construcción más largo.

Las decisiones de seguridad y privacidad son más fáciles de acertar al principio—especialmente cuando tu app junta eventos de producto, contexto de cuenta y alertas sobre riesgo de churn. El objetivo es simple: reducir riesgo dando a los equipos la suficiente data para actuar.

Empieza definiendo qué requiere el monitoreo. Si tu detección de caídas funciona con conteos, tendencias y timestamps, probablemente no necesitas contenido raw de mensajes, IPs completas o notas de texto libre.

Un enfoque práctico es almacenar:

Mantener el dataset estrecho reduce la carga de cumplimiento, limita el radio de exposición y facilita las políticas de retención.

Los paneles de caída de uso suelen convertirse en una herramienta cross-functional (CS, soporte, producto, liderazgo). No todos deben ver el mismo nivel de detalle. Implementa RBAC con reglas claras:

Añade logs de auditoría para acciones sensibles (exportar datos, cambiar umbrales de alerta, ver detalles a nivel de cuenta). Los logs también sirven para depurar “quién cambió qué” cuando las alertas se vuelven ruidosas.

Trata la PII (nombres, emails, teléfonos) como opcional. Si la necesitas para notificaciones, prefiere obtenerla bajo demanda desde el CRM en vez de copiarla a la base de monitoreo.

Si almacenas PII:

Documenta qué recoges, por qué lo recoges (monitoreo de uso y soporte al cliente) y cuánto tiempo lo retienes. Redacta el lenguaje con precisión—evita afirmaciones como “totalmente compliant” a menos que hayas completado una revisión formal.

Como mínimo, prepárate para dar soporte a:

Si publicas docs orientadas al cliente, enlaza internamente a tus políticas (p. ej., /privacy, /security) y mantenlas alineadas con cómo funciona realmente el sistema.

Lanzar una app de riesgo de churn no es solo “funciona?” Es si los equipos confían en las señales lo suficiente como para actuar—y si el sistema se mantiene fiable mientras tu producto y datos evolucionan.

Antes de alertar a nadie, reproduce el modelo o las reglas sobre semanas/meses pasados donde ya conoces los resultados (renovó, downgraded, churn). Esto te ayuda a ajustar umbrales y evitar alertas ruidosas.

Una forma simple de evaluar es una matriz de confusión:

Desde ahí, concéntrate en lo que importa operacionalmente: reducir falsos positivos para que los CSMs no ignoren alertas, manteniendo falsos negativos lo suficientemente bajos para captar riesgo real a tiempo.

Muchas “caídas de uso” son realmente problemas de datos. Añade monitorización ligera a cada paso del pipeline:

Muestra estos problemas en una vista de estado interna para que los usuarios distingan “el cliente dejó de usar” de “no llegaron datos”.

Empieza con usuarios internos (datos/ops + algunos CSMs) y compara alertas con lo que ya saben. Luego expande a un grupo más amplio una vez que la precisión y el flujo de trabajo sean estables.

Durante el rollout, mide señales de adopción: alertas abiertas, tiempo hasta triage y si los usuarios hacen click hacia la vista de cuenta.

Da a los usuarios una forma de un clic para marcar una alerta como false positive, issue conocido o acción tomada. Almacena ese feedback y revísalo semanalmente para refinar reglas, ajustar pesos del scoring o añadir exclusiones (p. ej., clientes estacionales, downtime planificado).

Con el tiempo, esto convierte la app de un dashboard estático en un sistema que aprende de la realidad de tu equipo.

Empieza con una métrica de valor primaria que sea difícil de manipular y esté fuertemente relacionada con la intención de renovación (p. ej., acciones clave completadas, llamadas API, asientos activos). Hazla explicable en una sola frase y añade métricas secundarias después para diagnóstico (uso por característica, sesiones, tiempo en producto).

La alerta funciona mejor con una unidad de cliente consistente—normalmente cuenta/espacio de trabajo en B2B. Usa suscripción si una misma compañía tiene varios planes, o una subcohorte (departamento/equipo) si la adopción varía mucho dentro de una cuenta grande. Esta elección determina agregación, enrutamiento de propiedad y cómo se interpretan los paneles.

Un punto de partida práctico es un umbral claro y basado en reglas, como cambio semana a semana (p. ej., -40% vs prior 4-week average). Luego añade salvaguardas:

Empieza con eventos de producto + facturación/suscripciones porque definen la entrega de valor y el riesgo de renovación. Añade CRM para contexto de propiedad/segmento y soporte/historial de incidentes para explicar caídas (picos de tickets, cortes). Mantén el conjunto inicial pequeño para garantizar calidad de datos.

Usa una clave primaria de agrupación como account_id/tenant_id en todas partes y mantiene una capa/tabla de mapeo de identidad que enlace:

Si los identificadores no son consistentes, los joins fallan y las alertas pierden confianza rápidamente.

Pre-computa snapshots diarios para que los paneles y el scoring no consulten eventos crudos constantemente. Tablas comunes:

account_daily_metrics (usuarios activos, sesiones, acciones clave)account_feature_daily (feature_key, usage_count)Esto mejora el rendimiento, reduce costes y acelera el análisis de “¿qué cambió?”.

Crea un almacén dedicado risk_signals con:

Esto hace que cada bandera sea auditable y ayuda a los equipos a actuar porque pueden ver por qué se marcó una cuenta.

Empieza con scoring basado en reglas porque es depurable y más fácil de alinear entre CS/Ventas/Producto. Combina señales ponderadas (caída de uso, fallos de pago, reducción de asientos, picos de tickets) y separa:

Traduce puntuaciones numéricas en bandas (Healthy/Watch/At risk) con acciones y SLAs por defecto.

Implementa enrutamiento + deduplicación desde el día uno:

Incluye contexto (métrica, baseline, delta) y un enlace directo como /accounts/{account_id} para que la alerta sea inmediatamente accionable.

Usa minimización de datos y control de acceso basado en roles:

También prepárate para solicitudes de eliminación/anónimo y mantiene políticas internas alineadas (p. ej., , ).

/privacy/security