18 may 2025·8 min

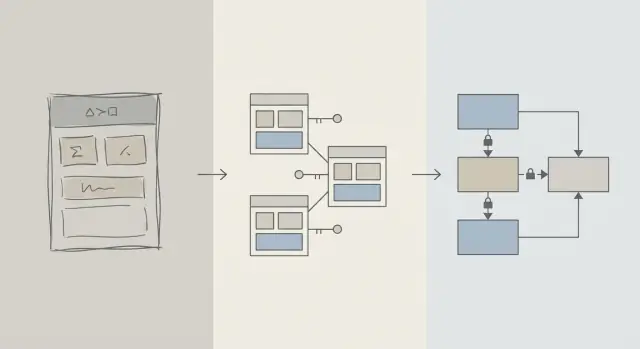

Diseño del esquema primero: aplicaciones más rápidas que el ajuste temprano de consultas

Las mejoras tempranas de rendimiento suelen venir del diseño del esquema: las tablas, claves y restricciones adecuadas evitan consultas lentas y reescrituras costosas más adelante.

Esquema vs Optimización de Consultas: Qué Queremos Decir

Cuando una app se siente lenta, el primer instinto suele ser “arreglar el SQL”. Tiene sentido: una consulta es visible, medible y fácil de culpar. Puedes ejecutar EXPLAIN, añadir un índice, ajustar un JOIN y a veces ver una mejora inmediata.

Pero en las etapas iniciales de un producto, los problemas de velocidad tienen tanta probabilidad de venir de la forma de los datos como del texto específico de la consulta. Si el esquema te obliga a pelear con la base de datos, el ajuste de consultas se convierte en un ciclo de golpear-mole.

Diseño del esquema (en palabras sencillas)

Diseño del esquema es cómo organizas tus datos: tablas, columnas, relaciones y reglas. Incluye decisiones como:

- Qué “cosas” merecen su propia tabla (usuarios, pedidos, eventos)

- Cómo se relacionan las tablas (uno-a-muchos, muchos-a-muchos)

- Qué debe ser único o requerido (restricciones)

- Cómo representas estados e historial (timestamps, campos de estado, registros de auditoría)

Un buen diseño de esquema hace que la forma natural de hacer preguntas sea también la forma rápida.

Optimización de consultas (en palabras sencillas)

Optimización de consultas es mejorar cómo obtienes o actualizas datos: reescribir consultas, añadir índices, reducir trabajo innecesario y evitar patrones que provocan escaneos masivos.

Ambos importan—el orden importa más

Este artículo no es “esquema bueno, consultas malas”. Trata sobre el orden de operaciones: corrige primero los fundamentos del esquema de la base de datos y luego afina las consultas que realmente lo necesiten.

Aprenderás por qué las decisiones de esquema dominan el rendimiento temprano, cómo detectar cuándo el esquema es el verdadero cuello de botella y cómo evolucionarlo de forma segura a medida que la app crece. Está escrito para equipos de producto, fundadores y desarrolladores que construyen apps del mundo real—no para especialistas en bases de datos.

Por qué el diseño del esquema impulsa la mayor parte del rendimiento temprano

El rendimiento temprano normalmente no se trata de SQL ingenioso: se trata de cuánto datos se ve forzada a tocar la base de datos.

La estructura determina cuánto escaneas

Una consulta solo puede ser tan selectiva como lo permita el modelo de datos. Si almacenas "status", "type" u "owner" en campos poco estructurados (o repartidos en tablas inconsistentes), la base de datos a menudo tiene que escanear muchas más filas para encontrar coincidencias.

Un buen esquema reduce el espacio de búsqueda de forma natural: columnas claras, tipos de datos consistentes y tablas bien acotadas hacen que las consultas filtren antes y lean menos páginas del disco o de la memoria.

La ausencia de claves crea trabajo costoso

Cuando faltan claves primarias y foráneas (o no se hacen cumplir), las relaciones se convierten en conjeturas. Eso empuja trabajo a la capa de consulta:

- Los

JOINcrecen porque no hay una ruta de unión fiable e indexada. - Los filtros se vuelven más complejos porque compensas duplicados, nulos y valores que "casi coinciden".

Sin restricciones, se acumulan datos malos—y las consultas siguen volviéndose más lentas a medida que añades filas.

Los índices siguen al esquema (y no lo arreglan todo)

Los índices son más útiles cuando coinciden con rutas de acceso predecibles: unir por claves foráneas, filtrar por columnas bien definidas, ordenar por campos comunes. Si el esquema guarda atributos críticos en la tabla equivocada, mezcla significados en una columna o depende de parseo de texto, los índices no te salvarán—sigues escaneando y transformando demasiado.

Rápido por defecto

Con relaciones claras, identificadores estables y límites de tabla sensatos, muchas consultas cotidianas se vuelven “rápidas por defecto” porque tocan menos datos y usan predicados simples y amigables para índices. El ajuste de consultas se convierte entonces en un paso final—no en una pelea constante.

La realidad en etapa temprana: el cambio es constante

Los productos en etapas tempranas no tienen “requisitos estables”—tienen experimentos. Se lanzan funciones, se reescriben o desaparecen. Un equipo pequeño equilibra presión del roadmap, soporte e infraestructura con tiempo limitado para revisar decisiones previas.

Qué cambia con más frecuencia

Rara vez cambia primero el texto SQL. Cambia el significado de los datos: nuevos estados, nuevas relaciones, nuevos campos de “ah, también tenemos que rastrear…”, y flujos completos que no se imaginaron en el lanzamiento. Ese cambio es normal—y es exactamente por lo que las elecciones de esquema importan tanto al principio.

Por qué arreglar el esquema más tarde es más difícil que arreglar una consulta

Reescribir una consulta suele ser reversible y local: puedes desplegar una mejora, medirla y revertir si hace falta.

Reescribir un esquema es diferente. Una vez que has guardado datos reales de clientes, cada cambio estructural se vuelve un proyecto:

- Migraciones que bloquean tablas o ralentizan escrituras en horas pico

- Backfills para poblar nuevas columnas o reconstruir datos derivados

- Escrituras duales o tablas sombra para mantener la app en funcionamiento durante una transición

- Riesgo de downtime si un cambio no puede hacerse online

Incluso con buenas herramientas, los cambios de esquema introducen costos de coordinación: actualizaciones de código de la app, secuencia de despliegues y validación de datos.

Cómo se agrupan las decisiones tempranas

Cuando la base de datos es pequeña, un esquema torpe puede parecer “aceptable”. A medida que las filas crecen de miles a millones, el mismo diseño provoca escaneos mayores, índices más pesados y joins más caros—y cada nueva característica se construye sobre esa base.

El objetivo en etapa temprana no es la perfección. Es elegir un esquema que absorba el cambio sin forzar migraciones arriesgadas cada vez que el producto aprende algo nuevo.

Fundamentos de diseño que previenen consultas lentas

La mayoría de los problemas de “consulta lenta” al principio no se deben a trucos SQL: se deben a ambigüedad en el modelo de datos. Si el esquema hace poco claro qué representa un registro o cómo se relacionan los registros, cada consulta se vuelve más cara de escribir, ejecutar y mantener.

Empieza con un pequeño conjunto de entidades centrales

Empieza nombrando las pocas cosas sin las cuales tu producto no puede funcionar: usuarios, cuentas, pedidos, suscripciones, eventos, facturas—lo que sea verdaderamente central. Luego define relaciones explícitamente: uno-a-muchos, muchos-a-muchos (habitualmente con una tabla intermedia), y propiedad (quién “contiene” qué).

Una comprobación práctica: para cada tabla, deberías poder completar la frase “Una fila en esta tabla representa ___.” Si no puedes, la tabla probablemente mezcla conceptos, lo que más tarde fuerza filtros y joins complejos.

Haz que nombres y propiedad sean aburridamente consistentes

La consistencia evita joins accidentales y comportamientos de API confusos. Elige convenciones (snake_case vs camelCase, *_id, created_at/updated_at) y cúmplelas.

También decide quién posee un campo. Por ejemplo, ¿"billing_address" pertenece a un pedido (instantánea en el tiempo) o a un usuario (predeterminado actual)? Ambos pueden ser válidos—pero mezclarlos sin intención clara crea consultas lentas y propensas a errores para “averiguar la verdad”.

Elige tipos de datos que coincidan con la realidad

Usa tipos que eviten conversiones en tiempo de ejecución:

- Usa timestamps con reglas de zona horaria que entiendas.

- Usa decimals para dinero (no floats).

- Usa enums/tablas de referencia para categorías conocidas.

Cuando los tipos están mal, las bases de datos no pueden comparar eficientemente, los índices son menos útiles y las consultas suelen necesitar castings.

No dupliques hechos sin un plan

Almacenar el mismo hecho en varios lugares (por ejemplo, order_total y sum(line_items)) crea deriva. Si cacheas un valor derivado, documéntalo, define la fuente de la verdad y asegura actualizaciones consistentes (a menudo mediante lógica de aplicación más restricciones).

Claves y restricciones: la velocidad empieza con la integridad de datos

Una base de datos rápida suele ser una base de datos predecible. Claves y restricciones hacen tus datos predecibles al impedir estados “imposibles”: relaciones faltantes, identidades duplicadas o valores que no significan lo que la app cree. Esa limpieza afecta directamente al rendimiento porque la base de datos puede hacer mejores suposiciones al planificar consultas.

Claves primarias: cada tabla necesita un identificador estable

Cada tabla debería tener una clave primaria (PK): una columna (o pequeño conjunto) que identifique única y permanentemente una fila. Esto no es solo una regla teórica: permite unir tablas eficientemente, cachear con seguridad y referenciar registros sin conjeturas.

Una PK estable también evita soluciones costosas. Si una tabla carece de un verdadero identificador, las aplicaciones empiezan a “identificar” filas por email, nombre, timestamp o un conjunto de columnas—llevando a índices más anchos, joins más lentos y casos límite cuando esos valores cambian.

Claves foráneas: integridad que ayuda al optimizador

Las claves foráneas (FKs) refuerzan relaciones: un orders.user_id debe apuntar a un users.id existente. Sin FKs, aparecen referencias inválidas (pedidos para usuarios borrados, comentarios para posts inexistentes) y entonces cada consulta tiene que filtrar defensivamente, hacer left-join y manejar nulos.

Con FKs, el planificador de consultas puede optimizar joins con más confianza porque la relación es explícita y garantizada. También es menos probable que acumules filas huérfanas que inflen tablas e índices con el tiempo.

Restricciones como guías para datos limpios y rápidos

Las restricciones no son burocracia—son guías:

- UNIQUE evita duplicados que obligan a la app a hacer búsquedas y limpiezas extra. Ejemplo: un

users.emailcanónico. - NOT NULL evita lógica tri-estatal y ramas sorpresa de manejo de nulos en consultas.

- CHECK mantiene valores dentro de un conjunto conocido (por ejemplo,

status IN ('pending','paid','canceled')).

Datos más limpios significan consultas más simples, menos condiciones de reserva y menos joins “por si acaso”.

Anti-patrones comunes que te ralentizan

- Sin claves foráneas: pagarás después con trabajos de limpieza de huérfanos y lógica de consulta complicada.

- Duplicar campos “email” (por ejemplo,

users.emailycustomers.email): obtienes identidades conflictivas e índices duplicados. - Cadenas de estado en formato libre: errores tipográficos como "Cancelled" vs "canceled" crean segmentos ocultos que rompen filtros e informes.

Si quieres velocidad temprana, dificulta almacenar datos malos. La base de datos te recompensará con planes más simples, índices más pequeños y menos sorpresas de rendimiento.

Normalización vs Desnormalización: un equilibrio práctico

Prototipa un modelo de datos limpio

Bosqueja las entidades y relaciones principales, luego genera tablas y migraciones.

La normalización es una idea simple: almacena cada “hecho” en un solo lugar para no duplicar datos por toda la base. Cuando el mismo valor se copia en varias tablas o columnas, las actualizaciones se vuelven riesgosas—una copia cambia, otra no, y tu app muestra respuestas contradictorias.

Normalización (por defecto): un hecho, un hogar

En la práctica, normalizar significa separar entidades para que las actualizaciones sean limpias y predecibles. Por ejemplo, el nombre y precio de un producto pertenecen a products, no repetidos dentro de cada fila de pedido. Un nombre de categoría pertenece a categories, referenciado por un ID.

Esto reduce:

- datos duplicados (menos almacenamiento, menos inconsistencias)

- errores de actualización (cambia una vez, se refleja en todas partes)

- confusos bugs de “¿qué valor es correcto?”

Cuando la sobre-normalización duele

La normalización puede llevarse demasiado lejos cuando separas datos en tablas tan pequeñas que hay que unirlas constantemente para pantallas cotidianas. La base de datos puede devolver resultados correctos, pero las lecturas comunes se vuelven más lentas y complejas porque cada petición necesita múltiples joins.

Un síntoma típico en etapa temprana: una página “simple” (como el historial de pedidos) requiere unir 6–10 tablas, y el rendimiento varía según el tráfico y el calentamiento de la caché.

Un enfoque práctico: normaliza hechos centrales, desnormaliza lecturas críticas

Un equilibrio sensato es:

- Normaliza hechos y propiedad (fuente de la verdad). Mantén atributos de producto en

products, nombres de categoría encategoriesy relaciones vía claves foráneas. - Desnormaliza con cuidado para las lecturas más calientes—pero solo cuando puedas explicar el beneficio y cómo se mantendrá correcto.

Desnormalizar significa duplicar intencionadamente un pequeño fragmento de datos para hacer una consulta frecuente más barata (menos joins, listas más rápidas). La palabra clave es con cuidado: cada campo duplicado necesita un plan para mantenerlo actualizado.

Ejemplo: productos, categorías y elementos de pedido

Una configuración normalizada podría verse así:

products(id, name, price, category_id)categories(id, name)orders(id, customer_id, created_at)order_items(id, order_id, product_id, quantity, unit_price_at_purchase)

Nota la victoria sutil: order_items almacena unit_price_at_purchase (una forma de desnormalización) porque necesitas precisión histórica aunque el precio del producto cambie después. Esa duplicación es intencional y estable.

Si tu pantalla más común es “pedidos con resumen de ítems”, quizá también desnormalices product_name en order_items para evitar unir products en cada lista—pero solo si estás preparado para mantenerlo sincronizado (o aceptar que es una instantánea en el momento de la compra).

La estrategia de índices sigue al esquema, no al revés

Los índices a menudo se tratan como un botón mágico de velocidad, pero solo funcionan bien cuando la estructura subyacente tiene sentido. Si todavía renombrás columnas, dividís tablas o cambiás cómo se relacionan los registros, tu conjunto de índices también cambiará. Los índices funcionan mejor cuando las columnas (y la forma en que la app filtra/ordena por ellas) son lo bastante estables como para no reconstruirlos cada semana.

Empieza por las preguntas que tu app hace más

No necesitas predecirlo todo, pero sí una lista corta de las consultas que importan más:

- “Encontrar un usuario por email.”

- “Mostrar pedidos recientes de un cliente.”

- “Listar facturas por estado, las más nuevas primero.”

Esas frases se traducen directamente en qué columnas merecen un índice. Si no puedes decirlas en voz alta, suele ser un problema de claridad del esquema—no de indexación.

Índices compuestos, explicado de forma sencilla

Un índice compuesto cubre más de una columna. El orden de las columnas importa porque la base de datos puede usar el índice eficientemente de izquierda a derecha.

Por ejemplo, si filtras con frecuencia por customer_id y luego ordenas por created_at, un índice en (customer_id, created_at) suele ser útil. El inverso (created_at, customer_id) puede no ayudar tanto la misma consulta.

No indexar todo

Cada índice extra tiene un costo:

- Escrituras más lentas: los inserts/updates deben actualizar cada índice.

- Más almacenamiento: los índices pueden ser gran parte del tamaño de la base.

- Más complejidad: índices extra hacen el mantenimiento y ajuste más difíciles.

Un esquema limpio reduce el conjunto “correcto” de índices a un pequeño número que coincida con patrones reales de acceso—sin pagar siempre el impuesto de escritura y almacenamiento.

Rendimiento de escritura: el costo oculto de un esquema desordenado

Genera índices para consultas reales

Describe tus endpoints más usados y recibe ideas de índices que se ajusten a tus filtros y ordenaciones.

Las apps lentas no siempre se ralentizan por lecturas. Muchos problemas tempranos de rendimiento aparecen durante inserts y updates—registros de usuario, flujos de checkout, jobs en background—porque un esquema desordenado hace que cada escritura haga trabajo extra.

Por qué las escrituras se vuelven caras

Algunas elecciones de esquema multiplican silenciosamente el costo de cada cambio:

- Filas anchas: meter docenas (o cientos) de columnas en una tabla suele significar filas más grandes, más I/O y más churn de caché—aunque la mayoría de columnas se usen raramente.

- Demasiados índices: los índices aceleran lecturas, pero cada insert/update también debe actualizar cada índice.

- Triggers y cascadas: los triggers pueden ocultar trabajo (inserts/updates extra) detrás de un simple

INSERT. Las claves foráneas con cascada pueden ser correctas y útiles, pero también añaden trabajo en tiempo de escritura que crece con los datos relacionados.

Read-heavy vs write-heavy: elige tu dolor deliberadamente

Si tu carga es read-heavy (feeds, páginas de búsqueda), puedes permitir más indexación y a veces desnormalización selectiva. Si es write-heavy (ingesta de eventos, telemetría, pedidos de alto volumen), prioriza un esquema que mantenga las escrituras simples y predecibles, y añade optimizaciones de lectura solo donde sean necesarias.

Patrones comunes en etapa temprana que perjudican las escrituras

- Registros de auditoría: geniales para cumplimiento, pero evita registrar enormes snapshots en cada actualización.

- Tablas de eventos: append-only escala bien, pero pueden hincharse si almacenas payloads redundantes.

- Borrados lógicos (soft deletes): convenientes, pero aumentan el tamaño del índice y pueden ralentizar updates y queries a menos que se planifiquen con cuidado.

Mantén escrituras simples mientras preservas historial

Un enfoque práctico:

- Almacena el “estado actual” en una tabla, y el historial en una tabla append-only separada.

- Mantén las filas de historial estrechas (solo lo que realmente necesitas: quién/cuándo/qué cambió).

- Añade índices al historial según patrones reales de acceso (habitualmente

entity_id,created_at). - Evita triggers para auditoría al principio; prefiere escrituras explícitas desde la aplicación para que el costo sea visible y testeable.

Rutas de escritura limpias te dan margen—y facilitan enormemente la optimización de consultas posterior.

Cómo los ORMs y APIs amplifican las decisiones de esquema

Los ORMs hacen que trabajar con bases de datos parezca sin esfuerzo: defines modelos, llamas métodos y los datos aparecen. El truco es que un ORM también puede ocultar SQL caro hasta que duela.

ORMs: conveniencia que puede enmascarar patrones lentos

Dos trampas comunes:

- Joins ineficientes: un

.include()o un serializador anidado puede convertirse en joins anchos, filas duplicadas o ordenamientos grandes—especialmente si las relaciones no están claramente definidas. - N+1 queries: traes 50 registros y el ORM silenciosamente hace 50 consultas más para cargar datos relacionados. Suele funcionar en desarrollo y colapsa bajo tráfico real.

Un esquema bien diseñado reduce la probabilidad de que surjan estos patrones y los hace más fáciles de detectar cuando aparecen.

Relaciones claras hacen el uso del ORM más seguro

Cuando las tablas tienen claves foráneas, restricciones de unicidad y reglas NOT NULL, el ORM puede generar consultas más seguras y tu código puede confiar en suposiciones consistentes.

Por ejemplo, hacer cumplir que orders.user_id exista (FK) y que users.email sea único previene clases enteras de casos límite que de otro modo se vuelven cheques a nivel de aplicación y trabajo de consultas extra.

Las APIs convierten elecciones de esquema en comportamiento de producto

Tu diseño de API es downstream de tu esquema:

- IDs estables (y tipos de clave consistentes) facilitan URLs, caching y estado cliente.

- Paginación funciona mejor cuando puedes ordenar por una columna monotónica indexada (a menudo

created_at+id). - Filtrado es predecible cuando las columnas representan atributos reales (no cadenas sobrecargadas o blobs JSON) y las restricciones mantienen valores limpios.

Hazlo un flujo de trabajo, no una misión de rescate

Trata las decisiones de esquema como ingeniería de primera clase:

- Usa migraciones para cada cambio, revisadas como código (/blog/migrations).

- Añade “revisiones de esquema” ligeras para nuevos endpoints: qué tablas, qué claves, qué restricciones, qué forma de consulta.

- En staging, registra consultas del ORM y marca patrones N+1 antes de producción (/blog/orm-performance-checks).

Si construyes rápido con un flujo de trabajo guiado por conversaciones (por ejemplo, generando una app React más un backend Go/PostgreSQL en Koder.ai), ayuda convertir la “revisión de esquema” en parte de la conversación temprana. Puedes iterar rápido, pero aun así quieres restricciones, claves y un plan de migración deliberado—especialmente antes de que llegue tráfico.

Señales tempranas de que tu esquema es el cuello de botella

Algunos problemas de rendimiento no son “SQL malo” tanto como la base de datos peleando con la forma de tus datos. Si ves los mismos problemas en muchos endpoints e informes, suele ser una señal de esquema, no una oportunidad de afinado de consultas.

Síntomas comunes a vigilar

Filtros lentos son un indicador clásico. Si condiciones simples como “encontrar pedidos por cliente” o “filtrar por fecha de creación” son consistentemente lentas, el problema puede ser relaciones faltantes, tipos que no coinciden o columnas que no se pueden indexar eficazmente.

Otra señal es el aumento explosivo del número de joins: una consulta que debería unir 2–3 tablas termina encadenando 6–10 tablas solo para responder una pregunta básica (a menudo por búsquedas excesivas, patrones polimórficos o diseños de “todo en una tabla”).

También vigila valores inconsistentes en columnas que se comportan como enums—especialmente campos de estado (“active”, “ACTIVE”, “enabled”, “on”). La inconsistencia obliga a consultas defensivas (LOWER(), COALESCE(), cadenas de OR) que se mantienen lentas sin importar cuánto optimices.

Lista rápida de comprobación de esquema (rápida de verificar)

- Índices faltantes en claves foráneas (los joins se vuelven escaneos completos a medida que crecen las tablas).

- Tipos de datos equivocados (por ejemplo, IDs almacenados como strings, fechas como texto, dinero como floats).

- Tablas EAV (Entity–Attribute–Value) usadas para datos centrales: flexibles al principio, pero filtros/ordenamientos se vuelven muchos joins y predicados difíciles de indexar.

Diagnósticos simples y agnósticos a herramientas

Empieza con comprobaciones de realidad: recuentos de filas por tabla y cardinalidad para columnas clave (cuántos valores distintos). Si una columna “status” debería tener 4 valores pero encuentras 40, el esquema ya está filtrando complejidad.

Luego mira planes de consulta para tus endpoints lentos. Si ves repetidamente escaneos secuenciales en columnas de join o grandes conjuntos intermedios, el esquema y la indexación son la raíz probable.

Finalmente, habilita y revisa logs de consultas lentas. Cuando muchas consultas diferentes son lentas de formas similares (mismas tablas, mismos predicados), suele ser un problema estructural que merece arreglo a nivel de modelo.

Evolucionar el esquema de forma segura a medida que creces

Despliega con hosting incluido

Despliega y hospeda tu app sin configurar infraestructura previamente.

Las elecciones de esquema tempranas rara vez sobreviven al primer contacto con usuarios reales. El objetivo no es “lograr la perfección”: es cambiarlo sin romper producción, perder datos o paralizar al equipo por una semana.

Un proceso de cambio ligero y repetible

Un flujo de trabajo práctico que escala de una app de una persona a un equipo más grande:

- Modelar: Anota la nueva forma (tablas/columnas, relaciones y qué se convierte en fuente de la verdad). Incluye registros de ejemplo y casos límite.

- Migrar: Añade nuevas estructuras de forma compatible con versiones anteriores (columnas/tablas nuevas primero; evita eliminar o renombrar inmediatamente).

- Backfill: Pobla campos nuevos desde datos existentes en lotes. Rastrea progreso para poder reanudar.

- Validar: Añade restricciones solo después de que los datos estén limpios (por ejemplo, NOT NULL, claves foráneas). Ejecuta comprobaciones que comparen salidas viejas y nuevas.

Feature flags y escrituras duales (úsalos con moderación)

La mayoría de cambios de esquema no necesitan patrones de rollout complejos. Prefiere “expandir y contraer”: escribe código que pueda leer tanto lo viejo como lo nuevo, luego cambia las escrituras cuando estés confiado.

Usa feature flags o escrituras duales solo cuando realmente necesites un corte gradual (alto tráfico, backfills largos o múltiples servicios). Si haces escrituras duales, añade monitorización para detectar deriva y define qué lado gana en conflicto.

Rollbacks y pruebas de migraciones que reflejen la realidad

Los rollbacks seguros empiezan con migraciones reversibles. Practica la ruta de “deshacer”: eliminar una columna es fácil; recuperar datos sobrescritos no lo es.

Prueba migraciones con volúmenes de datos realistas. Una migración que termina en 2 segundos en un portátil puede bloquear tablas durante minutos en producción. Usa conteos de filas e índices semejantes a producción y mide el tiempo de ejecución.

Aquí es donde las herramientas de plataforma reducen el riesgo: tener despliegues fiables más snapshots/rollback (y la capacidad de exportar tu código si hace falta) hace más seguro iterar en esquema y lógica de app juntos. Si usas Koder.ai, apóyate en snapshots y modo planificación cuando estés a punto de introducir migraciones que puedan requerir secuenciación cuidadosa.

Documenta decisiones para la próxima persona (incluyéndote a ti)

Mantén un registro corto del esquema: qué cambió, por qué y qué compensaciones se aceptaron. Enlázalo desde /docs o el README del repo. Incluye notas como “esta columna está intencionalmente desnormalizada” o “clave foránea añadida tras backfill el 2025-01-10” para que futuros cambios no repitan errores antiguos.

Cuándo optimizar consultas (y un orden sensato de operaciones)

La optimización de consultas importa—pero rinde más cuando tu esquema no te está peleando. Si faltan claves claras, las relaciones son inconsistentes o “una fila por cosa” está violado, puedes pasar horas afinando consultas que se reescribirán la próxima semana.

Un orden de prioridad práctico

-

Arregla primero los bloqueos de esquema. Empieza con cualquier cosa que haga difícil consultar correctamente: claves primarias faltantes, claves foráneas inconsistentes, columnas que mezclan varios significados, fuentes de verdad duplicadas o tipos que no coinciden con la realidad (por ejemplo, fechas como strings).

-

Estabiliza los patrones de acceso. Una vez que el modelo de datos refleje cómo se comporta la app (y probablemente se comporte en los próximos sprints), afinar consultas será duradero.

-

Optimiza las consultas principales—no todas. Usa logs/APM para identificar las consultas más lentas y frecuentes. Un endpoint con 10.000 hits al día suele valer más que un informe administrativo raro.

El 80/20 del afinado de consultas temprano

La mayoría de las ganancias tempranas vienen de un pequeño conjunto de movimientos:

- Añadir el índice correcto para tus filtros y joins más comunes (y verificar que realmente se use).

- Devolver menos columnas (evitar

SELECT *, especialmente en tablas anchas). - Evitar joins innecesarios—a veces un join existe solo porque el esquema te obliga a “descubrir” atributos básicos.

Poner expectativas: es continuo, pero las bases van primero

El trabajo de rendimiento nunca termina, pero la meta es hacerlo predecible. Con un esquema limpio, cada nueva función añade carga incremental; con un esquema desordenado, cada función añade confusión compuesta.

Lista de comprobación para esta semana

- Lista las 5 consultas más lentas y las 5 más frecuentes.

- Para cada una, confirma: clave primaria presente, los joins son clave-a-clave, y los tipos son correctos.

- Añade un índice que coincida con el filtro/orden dominante.

- Reemplaza

SELECT *en un camino caliente. - Re-mide y deja una nota simple de “antes/después” para el próximo sprint.